lidar专题

LiDAR 8 激光雷达行业

激光雷达应用的领域特别广泛,在无人驾驶上的应用受到很大的关注。 全球汽车领域激光雷达的厂商, 生态链厂商, 相信激光雷达在产品和技术上的发展还会有很广阔的天地。

LiDAR 7 消费电子3D应用

消费电子3D应用 Depth Camera,AR Glass,类似 Microsoft Azure Kinect,Intel RealSense,iPhone/ iPad 等产品。 Microsoft Azure Kinect: Intel RealSense: iPhone/ iPad: 光源是VCSEL。另一个集成MEMS mirror的深度相机示例: ST的AR Glass方案,采用

LiDAR 6 FMCW

FMCW是TOF之外的另一种方式,利用光波的调频实现目标的探测。 光的波粒二象性 多普勒效应 系统架构 当系统的复杂程度上升后,能够采集到的信息也更多,包括距离和速度。采用OPA扫描的FMCW激光雷达设计:

LiDAR 5 相控阵激光雷达 (OPA LiDAR)

OPA LiDAR相控阵激光雷达的技术核心是OPA scanner。Quanergy S3激光雷达Transmitter OPA: Leddar Tech OPA LiDAR模块: 相控阵Phase array实现方式: Phase array/ Emitter/ Antenna结构:

LiDAR 4 固态激光雷达 (Flash LiDAR)

固态激光雷达分为Flash LiDAR和OPA (Optical Phased Array) LiDAR,Flash LiDAR是非扫描式的,OPA LiDAR 是扫描式的。Flash LiDAR的发射光源和接收部件都是阵列式结构。 Leddar Tech的Flash LiDAR模块, Linear array光源从上至下依次点亮,形成一个点阵面。 Ibeo的方案, 发射光源为VCSEL,128列

LiDAR 3 MEMS激光雷达

与传统机械雷达相比,MEMS (Micro-Electro-Mechanical Systems) 激光雷达使用微型的MEMS mirror反射光线,用微机电执行器代替电机,有些厂商也称MEMS激光雷达为固态雷达。 以Leddar Tech的MEMS激光雷达模块为例, 另外一个示例 MEMS micro-mirror有电磁式Electro-Magnetic,压电式Thin-Film Piezo

LiDAR 2 机械激光雷达

实例分析Valeo SCALA I, SICK LMS291, Velodyne HDL-64E, Livox(DJI) MID-70几款激光雷达,机械激光雷达特点是通过电动执行器带动镜面,透镜或者机体旋转进行扫描。 Valeo SCALA I 利用多边体镜面反射光束,并由电机带动高速旋转。当几个镜面角度不一样时,可以发射出几道光幕。工作原理: SICK LMS291 一个比较

LiDAR 1 基础

激光的形成过程: 原子内的电子有低能量状态和高能量状态,低能量电子吸收能量进入高能量活跃态,恢复低能量时发射光子。 通过高电压在谐振腔内触发激光 不同的介质可以触发不同频段的激光 激光雷达使用的是红外波段的非可见光 TOF(time of fight) 测距原理,通过测量光的传播时间计算距离。系统架构:

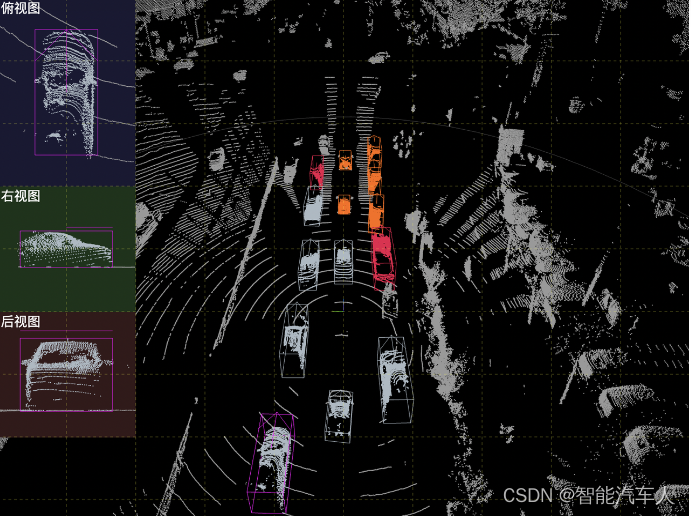

自动驾驶---Perception之Lidar点云3D检测

1 背景 Lidar点云技术的出现是基于摄影测量技术的发展、计算机及高新技术的推动以及全球定位系统和惯性导航系统的发展,使得通过激光束获取高精度的三维数据成为可能。随着技术的不断进步和应用领域的拓展,Lidar点云技术将在测绘、遥感、环境监测、机器人等领域发挥越来越重要的作用。 目前全球范围内纯视觉方案的车企主要包括特斯拉和集越,在达到同等性能的前提下,纯视觉方

扫地机LiDAR形态之美

石头扫地机V20 LiDAR: Flash光源和Spot光源切换 图来自 Robot森 LiDAR(Light Detection and Ranging,激光雷达)技术在扫地机器人中的应用,不仅提升了机器的智能性和实用性,还展现了一种科技与艺术的融合之美。 一、外观设计的精致性 紧凑与轻巧:扫地机器人的LiDAR传感器通常被设计得十分紧凑和轻巧,这样不仅便于机器人灵活移动,

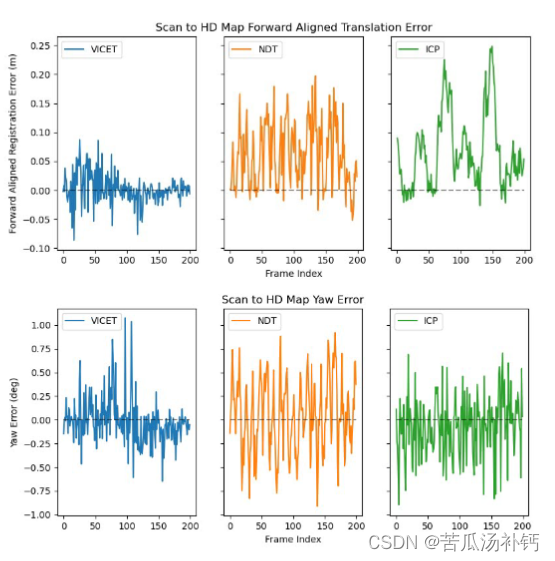

论文阅读:Correcting Motion Distortion for LIDAR HD-Map Localization

目录 概要 Motivation 整体架构流程 技术细节 小结 论文地址:http://arxiv.org/pdf/2308.13694.pdf 代码地址:https://github.com/mcdermatt/VICET 概要 激光雷达的畸变矫正是一个非常重要的工作。由于扫描式激光雷达传感器需要有限的时间来创建点云,所以一次扫描过程中传感器的运动会导致点云发生畸变,这种现

LIDAR激光雷达系列之三

LIDAR激光雷达系列之三 基本理论及概念大气散射光斑激光光源激光接收器信噪比背景模型 发射器光学镜片系统配置laser(light amplification by stimulated emission)噪声源 接收器总结 基本理论及概念 本篇对LIDAR概念及其背后理论做一个简单概述,便于大家阅读LiDAR相关资料时有一定理解基础。 从测距原理上分为ToF(飞行时间法)、

点云从入门到精通技术详解100篇-基于车载 LiDAR 的雨雪天气点云滤波算法研究(续)

目录 2.2.2 衍生算法 2.2.2.1 DROR 2.2.2.2 DSOR 2.2.2.3 DDIOR 3算法改进及评价指标

【论文笔记】DiL-NeRF: Delving into Lidar for Neural Radiance Field on Street Scenes

原文链接:https://arxiv.org/abs/2405.00900 1. 引言 自动驾驶等应用领域需要逼真的仿真。传统的仿真流程需要手工创建3D资产并构成虚拟环境,但其人力和专业需求使其难以具有可放缩性。 NeRF有不错的仿真能力,但需要大范围覆盖的训练数据以学习潜在的几何、材料特性和光照。在自动驾驶场景中,数据覆盖很稀疏,且相机的轨迹共线。此外,路面纹理较少,进一步引入重建的模糊性

ICRA2024重磅!首个融合LiDAR的NeRF-based SLAM系统

论文标题: SiLVR: Scalable Lidar-Visual Reconstruction with Neural Radiance Fields for Robotic Inspection 论文作者: Yifu Tao1, Yash Bhalgat2, Lanke Frank Tarimo Fu1, Matias Mattamala1, Nived Chebrolu1, and

【GlobalMapper精品教程】074:从Lidar点云创建3D地形模型

本文基于地形点云数据,基于泊松方法、贪婪三角形测量方法和阿尔法形状创建3d地形模型。 文章目录 一、加载地形点云数据二、创建三维地形模型1. 泊松方法2. 贪婪三角形测量方法3. 阿尔法形状 注意事项 一、加载地形点云数据 加载配套案例数据包中的data074.rar中的地形点云数据地形.las,如下所示: 二、创建三维地形模型 点击Globalmapper软件【

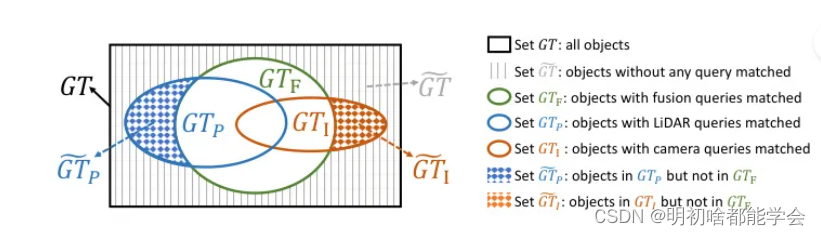

消除 BEV 空间中的跨模态冲突,实现 LiDAR 相机 3D 目标检测

Eliminating Cross-modal Conflicts in BEV Space for LiDAR-Camera 3D Object Detection 消除 BEV 空间中的跨模态冲突,实现 LiDAR 相机 3D 目标检测 摘要Introduction本文方法Single-Modal BEV Feature ExtractionSemantic-guided Flow-ba

r3live 使用前提 雷达-相机外参标定 livox_camera_lidar_calibration

标定的是相机到雷达的,R3live下面配置的雷达到相机的,所以要把得到外参旋转矩阵求逆,再填入,平移矩阵则取负 港科大livox_camera_calib虽然操作方便,但是使用mid360雷达会有视角问题(投影三维点到相机),尝试了很多场景,标定效果都不理想(推荐场景是楼梯间),看来港大的更适合avia之类窄角度的雷达。livox_camera_lidar_calibration标定效果还不错,但

使用立体视觉作为 3D LiDAR 的替代方案,在 KITTI ADAS 立体视觉数据集上微调立体变换器 (STTR) 模型-含数据集+源码资料下载

为什么是立体视觉? ADAS 立体视觉是指使用两个摄像头(类似于人眼)从略有不同的角度捕获图像的技术。该设置模仿人类双眼视觉,使系统能够感知环境的深度和 3D 结构。 立体视觉的关键技术方面 ADAS 立体视觉具有多种优势和高度复杂的功能。让我们探索它们以更好地理解: 对极几何和深度估计:立体视觉依赖于对极几何,这是计算机视觉中的一个基本概念,描述了立体设置的两个视图之间的几何关系。通过

基于ES-EKF的LiDAR/GNSS/IMU传感器融合轨迹估计(附项目源码)

基于改进EKF的LiDAR/GNSS/IMU传感器融合轨迹估计(附项目源码) 算法概述PredictionCorrectionES-EKF算法融合算法实现轨迹估计实验结果 最近在研究传感器融合,看到一个很好的开源项目,适合小白学习,为以后做传感器融合、SLAM、自动驾驶和室内定位等方向打下基础。 算法概述 题目:基于改进扩展卡尔曼滤波(Error State-EKF)的LiD

高精度端到端在线校准环视相机和LIDAR(精度0.2度内!无需训练数据)

高精度端到端在线校准环视相机和LIDAR(精度0.2度内!无需训练数据) 附赠自动驾驶学习资料和量产经验:链接 写在前面 在自动驾驶车辆的使用寿命内,传感器外参校准会因振动、温度和碰撞等环境因素而发生变化。即使是看似无害的 camera-lidar 外参校准值有一两度的误差,也可能给高级的 camera-lidar 感知功能引入灾难性的故障。 连续在线外部校准(COEC)在自动驾驶

北斗导航 | 3D LiDAR辅助GNSS NLOS缓解用于城市峡谷中可靠的GNSS-RTK定位

===================================================== github:https://github.com/MichaelBeechan CSDN:https://blog.csdn.net/u011344545 ===================================================== 3D LiDAR

iPhone 15 Pro LiDAR Module模组逆向(2024.3.23)

iPhone15 Pro出来后,基本上国内所有的模组厂包括舜宇,丘钛等都已经逆向了LiDAR模组,并同时测试了电学,光学,BOM成本等一系列测试。当然市面上最具备影响力的是YOLE的商业评估报告,我这边同时具有这些报告,也有一些自己的见解,当然本篇讲解可能会同时涉及到几个模组厂和科研机构的逆向以及测试报告。 YOLE的报告会略显中肯,对于技术的广度是够的,但是技术的深度是不够的,模组厂则相反,特

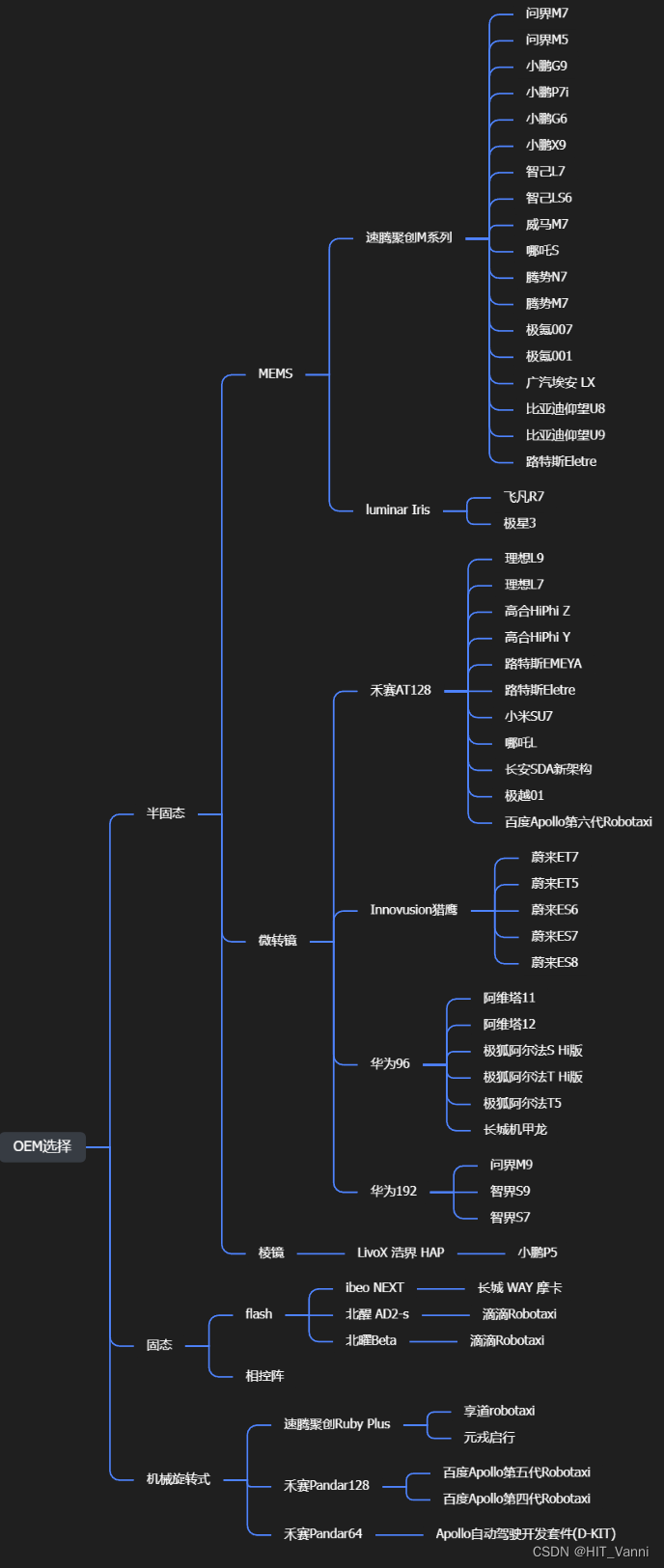

【Lidar】Lidar激光雷达一篇全(两万字激光雷达详细介绍)

【Lidar】Lidar激光雷达一篇全 1. 激光雷达测距原理1.1 三角测距1.2 飞行时间测距(TOF,Time of Flight) 2. 车载激光雷达类别2.1 机械旋转式2.2 固态2.2.1 相控阵 2.3 半固态(混合固态)2.3.2 微转镜/棱镜 3. 激光雷达性能指标3.1 点云性能指标3.2 硬件性能 4. 激光雷达数据集4.1 Kitti4.2 nuScenes4.3

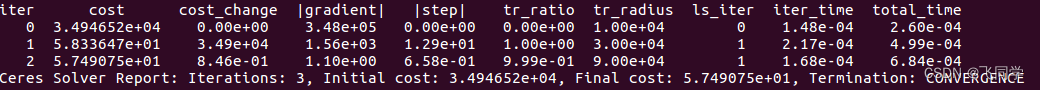

【雷达相机外参标定】direct_visual_lidar_calibration安装

direct_visual_lidar_calibration安装 主页安装ubuntupclOpenCVceres其他依赖fmtdirect_visual_lidar_calibration 标定雷达和相机时使用direct_visual_lidar_calibration。 主页 https://github.com/koide3/direct_visual_lidar_

Failed to build tree: parent link [base_link] of joint [lidar_joint] not found

参考: Failed to build tree: parent link [base_link] of joint 在古月居gazebo 的基础教程里,运行古月居的mbot的launch文件报错,小机器人不出现。 主要原因是提供的xacro文件的宏定义没有放在xacro的命名空间。 解决: 将<mbot_base_gazebo>改为<xacro:mbot_base_gazebo>

![Failed to build tree: parent link [base_link] of joint [lidar_joint] not found](https://img-blog.csdnimg.cn/direct/61e21c18922341d1a22fc62621053135.png#pic_center)