googlenet专题

CV-CNN-2016:GoogleNet-V4【用ResNet模型的残差连接(Residual Connection)思想改进GoogleNet-V3的结构】

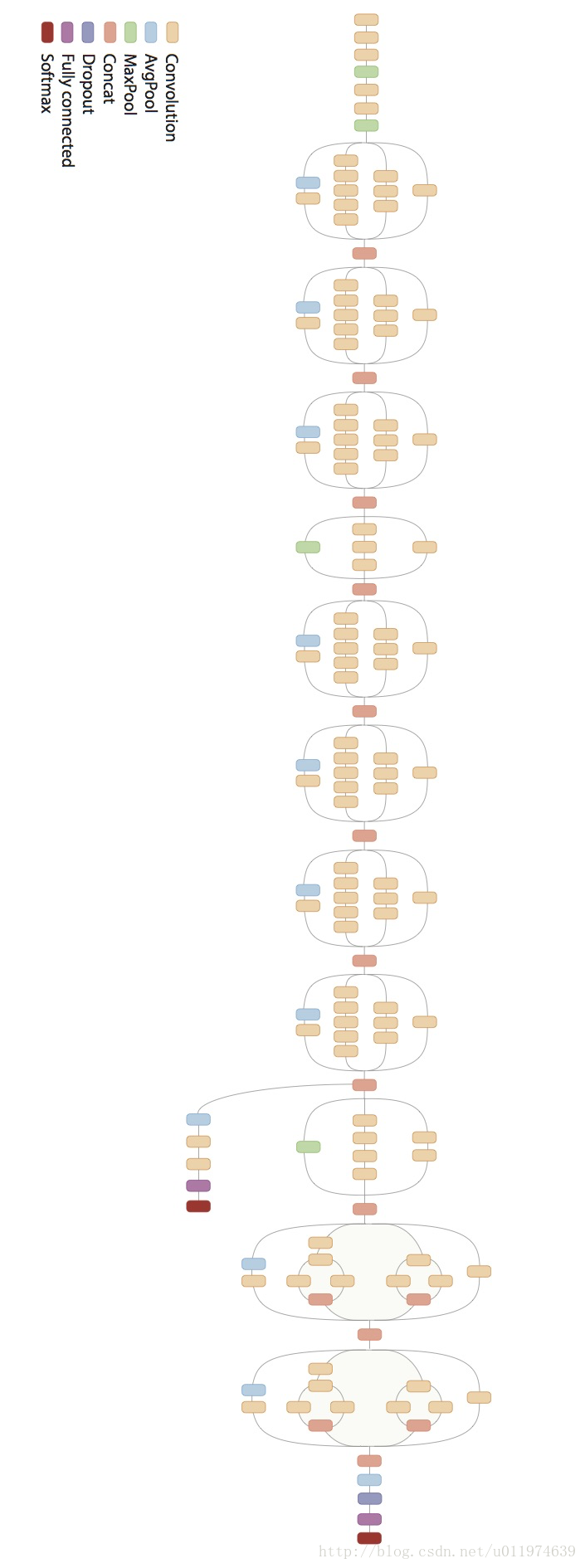

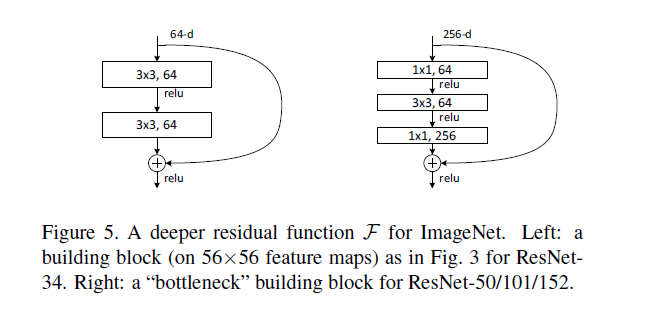

Inception V4研究了Inception模块与残差连接的结合。 ResNet结构大大地加深了网络深度,还极大地提升了训练速度,同时性能也有提升。 Inception V4主要利用残差连接(Residual Connection)来改进V3结构,得到Inception-ResNet-v1,Inception-ResNet-v2,Inception-v4网络。 ResNet的残差结构如下

CV-CNN-2015:GoogleNet-V3【贡献:卷积核分解(Factorization)减少参数量,比如将7x7分解成两个一维的卷积(1x7,7x1)】【避免表达瓶颈,更深】

Inception V3一个最重要的改进是分解(Factorization),将7x7分解成两个一维的卷积(1x7,7x1),3x3也是一样(1x3,3x1),这样的好处,既可以加速计算,又可以将1个卷积拆成2个卷积,使得网络深度进一步增加,增加了网络的非线性(每增加一层都要进行ReLU)。 另外,网络输入从224x224变为了299x299。 参考资料: CNN模型合集 | 7

CV-CNN-2015:GoogleNet-V2【首次提出Batch Norm方法:每次先对input数据进行归一化,再送入下层神经网络输入层(解决了协方差偏移问题)】【小的卷积核代替掉大的卷积核】

GoogLeNet凭借其优秀的表现,得到了很多研究人员的学习和使用,因此GoogLeNet团队又对其进行了进一步地发掘改进,产生了升级版本的GoogLeNet。 GoogLeNet设计的初衷就是要又准又快,而如果只是单纯的堆叠网络虽然可以提高准确率,但是会导致计算效率有明显的下降,所以如何在不增加过多计算量的同时提高网络的表达能力就成为了一个问题。 Inception V2版本的解决方案就是修

秃姐学AI系列之:GoogLeNet + 代码实现

目录 GoogLeNet —— 含并行连结的网络 卷积层超参数 Inception块:小学生才做选择,我全要! 为什么要用Inception块? GoogLeNet架构 详细展开每个Stage Stage 1 & 2 Stage 3 Stage 4 & 5 Inception 有各种后续变种 总结 代码实现 Inception Block 逐步实现每个Stage

动手学深度学习(Pytorch版)代码实践 -卷积神经网络-27含并行连结的网络GoogLeNet

27含并行连结的网络GoogLeNet import torchfrom torch import nnfrom torch.nn import functional as Fimport liliPytorch as lpimport matplotlib.pyplot as pltclass Inception(nn.Module):# c1--c4是每条路径的输出通道数def

TensorFlow实战:Chapter-5(CNN-3-经典卷积神经网络(GoogleNet))

GoogleNet GoogleNet 简介GoogleNet大家族GoogleNet的发展 Inception V1Inception V2Inception V3Inception V4 GoogleNet论文分析 引言 详解 介绍相关工作动机和高层次考虑动机和高层次考虑 详解 GoogLeNet 详解 训练方法ILSVRC 2014 Classification Challenge

GoogLeNet(InceptionV3)模型算法

GoogLeNet 团队在给出了一些通用的网络设计准则,以期望在不提高网络参数 量的前提下提升网络的表达能力: 避免特征图 (feature map) 表达瓶颈:从理论上讲,尺寸 (seize) 才包含了相关结构等重要因素,维度(channel) 仅仅提供了信息内容的粗略估计,因此特征图的尺寸应该从输入到输出慢慢减小,避免使用极端压缩。更高的维度特征图更容易获得网络的局

常见的神经网络模型 AlexNet,VGGNet,GoogleNet,resNet,inceptionV3,Inception-v4,xception等论文下载链接

LeNet 1986 AlexNet 2012 http://pan.baidu.com/s/1NpEG2,作者:Alex Krizhevsky,Ilya Sutskever,Geoffrey E.Hinton VGGNet 2014 https://arxiv.org/pdf/1409.1556.pdf 6.8% test error,作者:Karen Simonyan,Andrew Ziss

OpenCV4.0 DNN-googleNet

OpenCV4.0 DNN-googleNet OpenCV 4.0最近发布,其中一大亮点便是加入DNN;之前的文章中介绍了OpenCV 4.0的编译,本系列就通过GoogleNet的demo来窥探OpenCV 4.0的DNN。 核心函数介绍 首先需要准备GoogleNet的prototxt,caffemodel,和synset_words.txt;这个在网上很容易下载到。然后就是需要一张R

GoogLeNet论文解读—Going deeper with convolutions2015(V1)

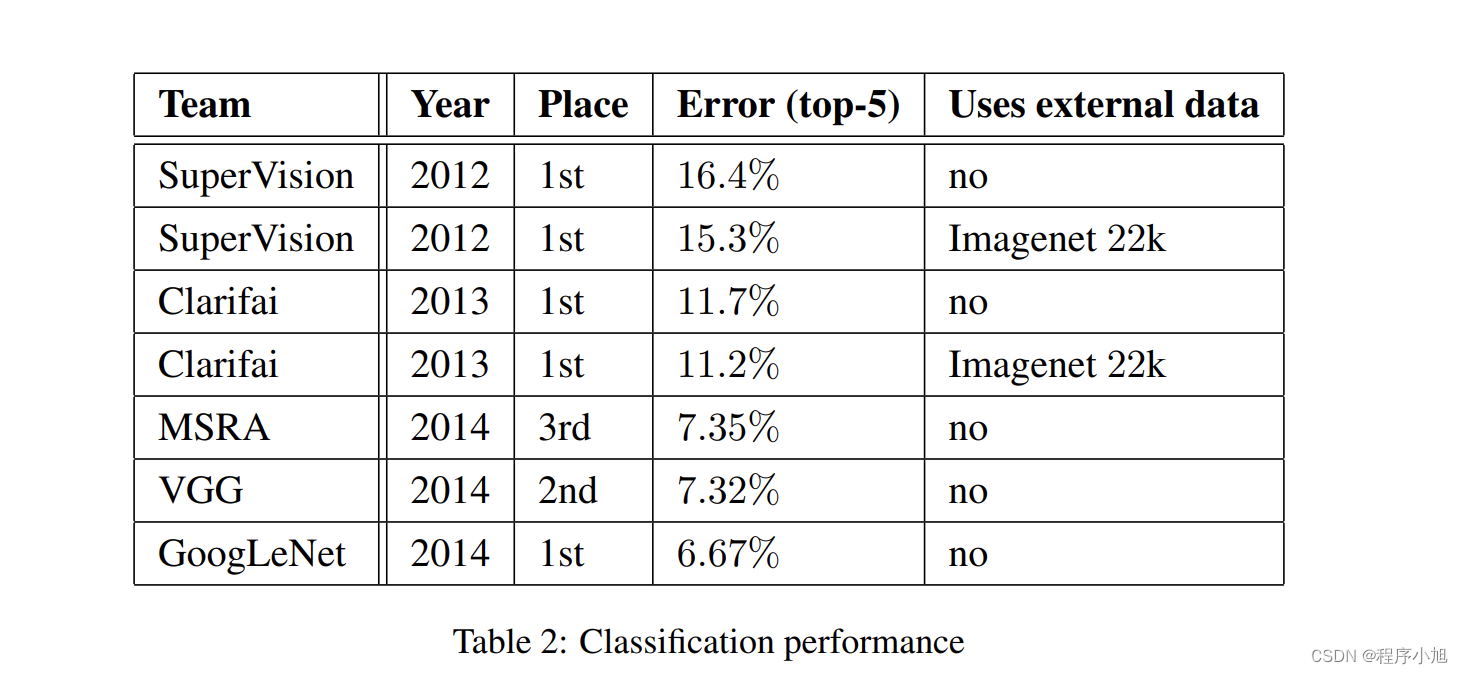

GoogLeNet论文解读—Going deeper with convolutions2015 说明:本文只解读GooleNet的14年参赛的v1版本,之后的改进版本可能在日后的学习中继续更新 研究背景 更深的卷积神经网络 认识数据集:ImageNet的大规模图像识别挑战赛 LSVRC-2014:ImageNet Large Scale Visual Recoanition C

为什么现在的CNN模型都是在GoogleNet、VGGNet或者AlexNet上调整的?

作者:周博磊 链接:https://www.zhihu.com/question/43370067/answer/128881262 来源:知乎 著作权归作者所有。商业转载请联系作者获得授权,非商业转载请注明出处。 更新:如果你觉得这篇回答有意思,也许你对我最近的CVPR'17上发表的比较不同网络可解释性的工作也感兴趣(CVPR 2017 有什么值得关注的亮点?)。 ---------

Alexnet VGG GoogleNet ResNet

关于卷积神经网络CNN,网络和文献中有非常多的资料,我在工作/研究中也用了好一段时间各种常见的model了,就想着简单整理一下,以备查阅之需。如果读者是初接触CNN,建议可以先看一看“Deep Learning(深度学习)学习笔记整理系列”中关于CNN的介绍[1],是介绍我们常说的Lenet为例,相信会对初学者有帮助。 Lenet,1986年 Alexnet

经典网络GoogLeNet(Inception V3)的搭建与实现(全网最佳版本)

作者总结的很好:https://blog.csdn.net/loveliuzz/article/details/79135583

41_经典卷积网络、LeNet、AlexNet、VGG、GoogleNet、ResNet、NIN、DenseNet、EfficientNet、MobileNetV1/2/3、SENet等

1.38.经典卷积网络 1.38.1.LeNet 1.38.1.1.介绍 1.38.1.2.网络结构 1.38.1.3.代码实现 1.38.2.AlexNet 1.38.2.1.介绍 1.38.2.2.网络结构 1.38.2.3.代码实现 1.38.3.VGG 1.38.3.1.介绍 1.38.3.2.网络结构 VGG-16 1.38.3.3.代码实现 1.38.4.GoogleNet 1.38.

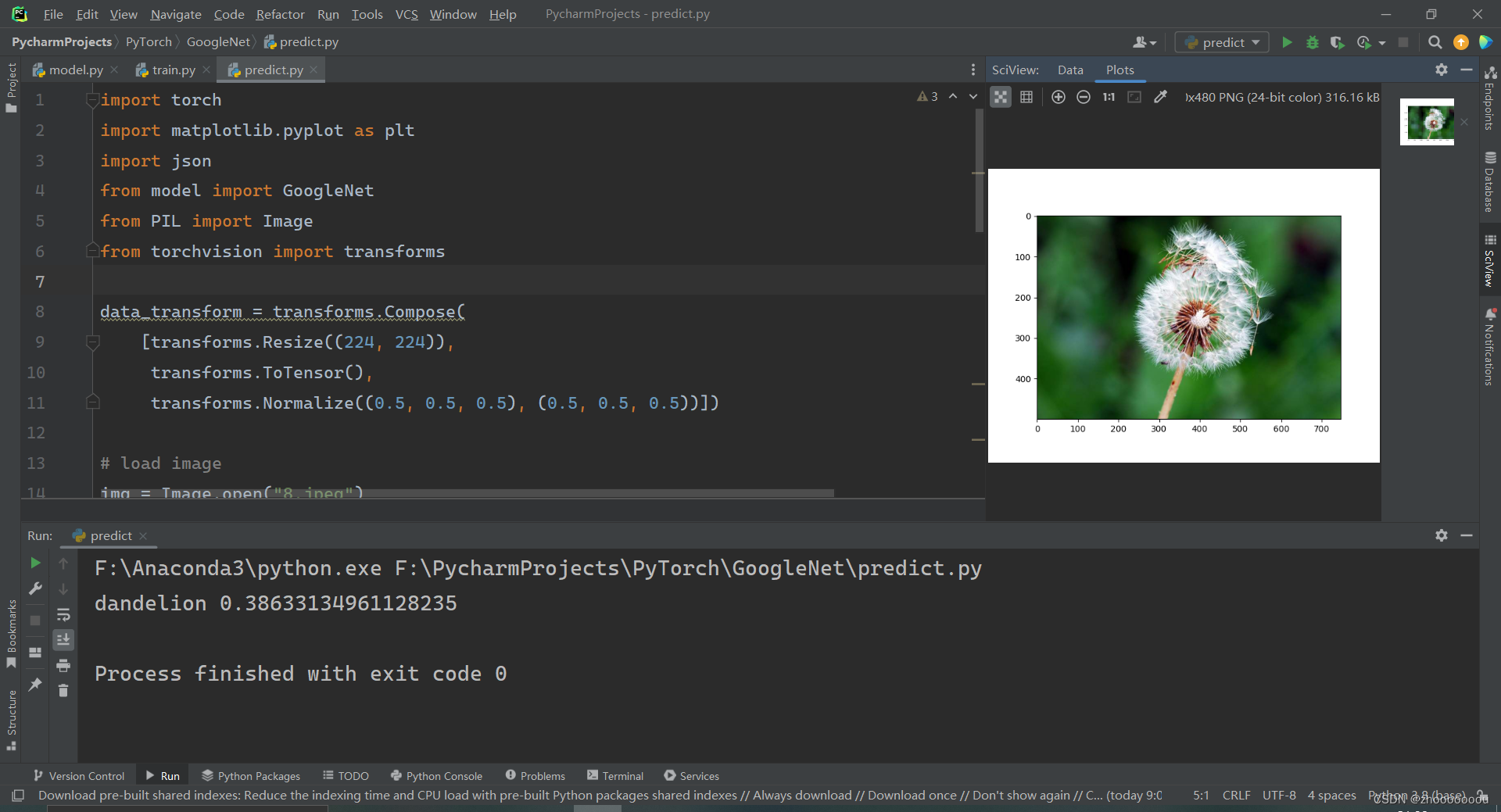

GoogleNet网络训练集和测试集搭建

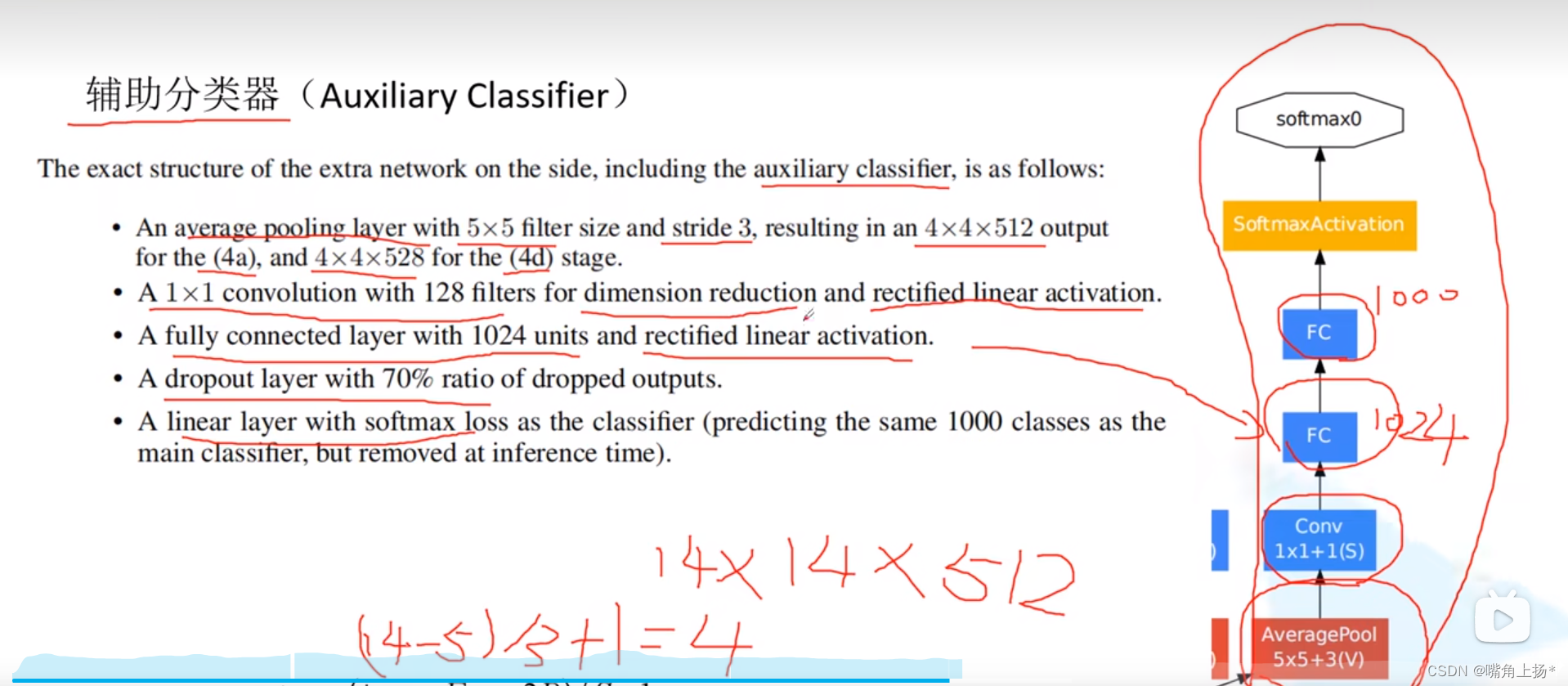

测试集和训练集都是在之前搭建好的基础上进行修改的,重点记录与之前不同的代码。 还是使用的花分类的数据集进行训练和测试的。 一、训练集 1、搭建网络 设置参数:使用辅助分类器,采用权重初始化 net = GoogleNet(num_classes=5, aux_logits=True, init_weights=True) 2、参数输出 之前的模型只有 1 个输出,但由于GoogleN

Mxnet (16): 并行网络(GoogLeNet)

GoogLeNet吸收了NiN中网络串联网络的思想,并在此基础上做了很大改进。以前的网络中对kernel_size的选取1~11都有,GoogLeNet的见解是多种大小的内核一起使用可能会有利,有点选举的赶脚 1.Inception 块 GoogLeNet中的基础卷积块叫作Inception块,得名于同名电影《盗梦空间》(Inception)。与NiN块相比,这个基础块在结构上更加复杂

Pytorch搭建GoogleNet神经网络

一、创建卷积模板文件 因为每次使用卷积层都需要调用Con2d和relu激活函数,每次都调用非常麻烦,就将他们打包在一起写成一个类。 in_channels:输入矩阵深度作为参数输入 out_channels: 输出矩阵深度作为参数输入 经过卷积层和relu激活函数之后通过正向传播得到输出。 class BasicConv2d(nn.Module):def __init__(self, i

GoogleNet神经网络介绍

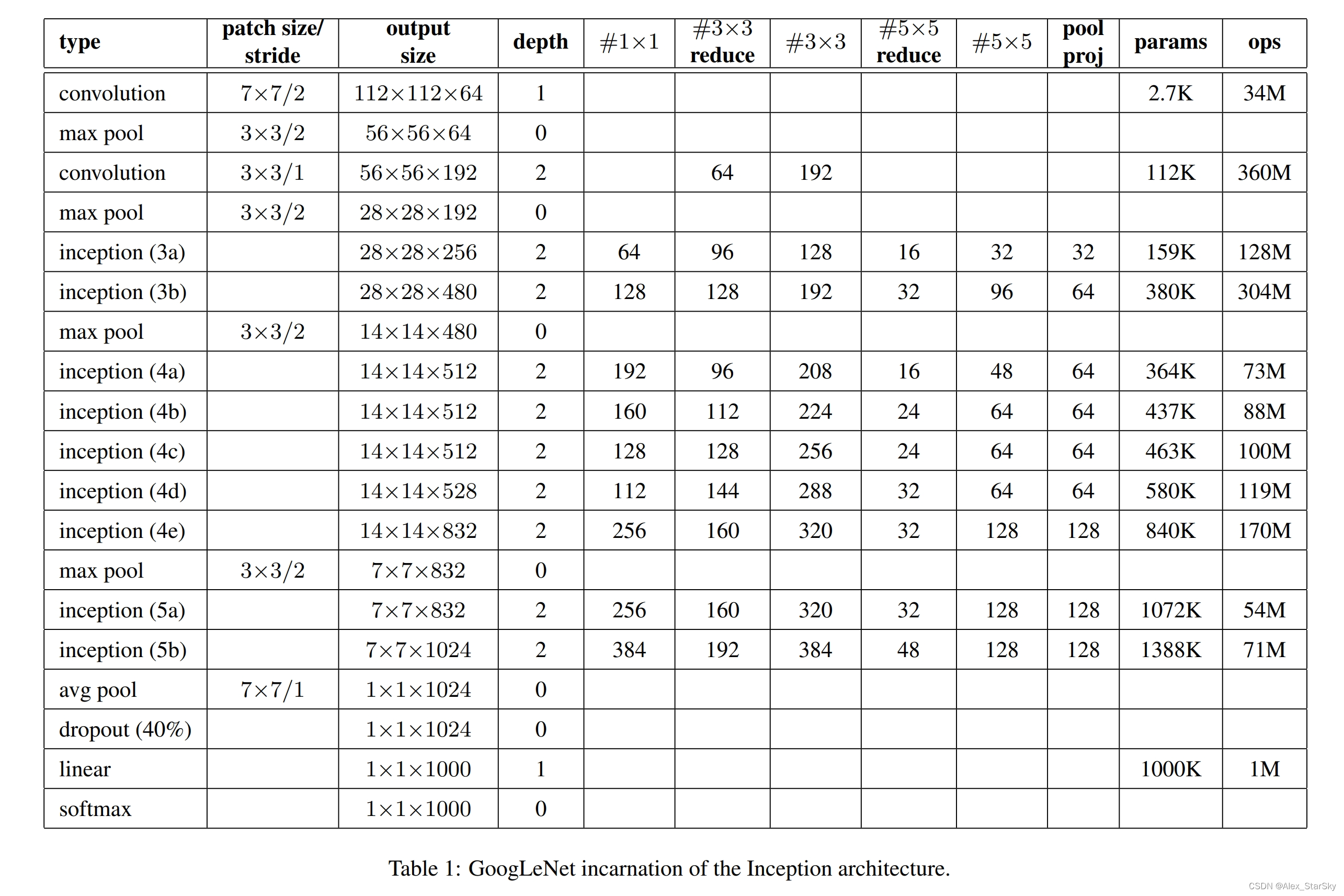

一、简介 GoogleNet,也称为GoogLeNet,是谷歌工程师设计的一种深度神经网络结构,它在2014年的ImageNet图像识别挑战赛中取得了冠军。该神经网络的设计特点主要体现在其深度和宽度上,通过引入名为Inception的核心子网络结构,使得网络能够在多个尺度上提取特征,从而增强了其预测能力。 AlexNet与VGG都只有一个输出层 GoogleNet有三个输出层(其中两个为辅助

深度学习论文随记(三)GoogLeNet-2014年

深度学习论文随记(三)GoogLeNet Going Deeper with Convolutions Author: Christian Szegedy, Wei Liu, Yangqing Jia, etl. Year 2014 1、导引 2014年google参加ILSVRC竞赛,以此网络模型获得第一名的成绩。此模型名为GoogLeNet,而不是GoogleNet.是

GoogLeNet阅读笔记

论文地址 摘要 提出了一种名为GoogLeNet的深度神经网络,该神经网络共有22层。在保证预算不变的情况下,增加了网络的深度和广度,架构设计时基于Hebbian principle和多尺度处理。 引言 目前该领域大部分的进步不仅仅是更强大的硬件、更大的数据集和更大的模型的结果,而是新思想、算法和改进的网络架构的结果。 相关工作 从LeNet-5开始,CNN已经有了标准的结构----堆

深度学习-解读GoogleNet深度学习网络

深度学习-解读GoogleNet深度学习网络 深度学习中,经典网络引领一波又一波的技术革命,从LetNet到当前最火的GPT所用的Transformer,它们把AI技术不断推向高潮。2012年AlexNet大放异彩,它把深度学习技术引领第一个高峰,打开人们的视野。 用pytorch构建CNN经典网络模型GoogleNet,又称为Inception V1 ,还可以用数据进行训练模型,得到一个优化

【目标检测】原始的 YOLOv1 网络结构(GoogLeNet 作为 backbone 的实现)

现在看网上的很多 YOLOv1 的代码实现,基本都是使用新的 backbone,例如 ResNet 或者 VGG 来实现的,因为这些后面的通用的 backbone 可能比较方便的获得预训练模型,不需要从头开始训练。 但是我就是想看一下,一开始 YOLOv1 网络结构是咋样的,所以就当做学习了,来还原一下最初的 YOLOv1 网络结构。 比较常见的图有两张: 这张是原论文里面的图片,我后面根

27 含并行连结的网络 GoogLeNet / Inception V3【李沐动手学深度学习v2】

目录 1. GoogLeNet 2. 代码 2.1 Inception 2.2 GoogLeNet模型 2.3 训练模型 3. 小结 1. GoogLeNet 白色框:用来改变通道数 蓝色框:用来抽取信息 2. 代码 2.1 Inception 如图所示,Inception块由四条并行路径组成。 前三条

什么是GoogLeNet,亮点是什么,为什么是这个结构?

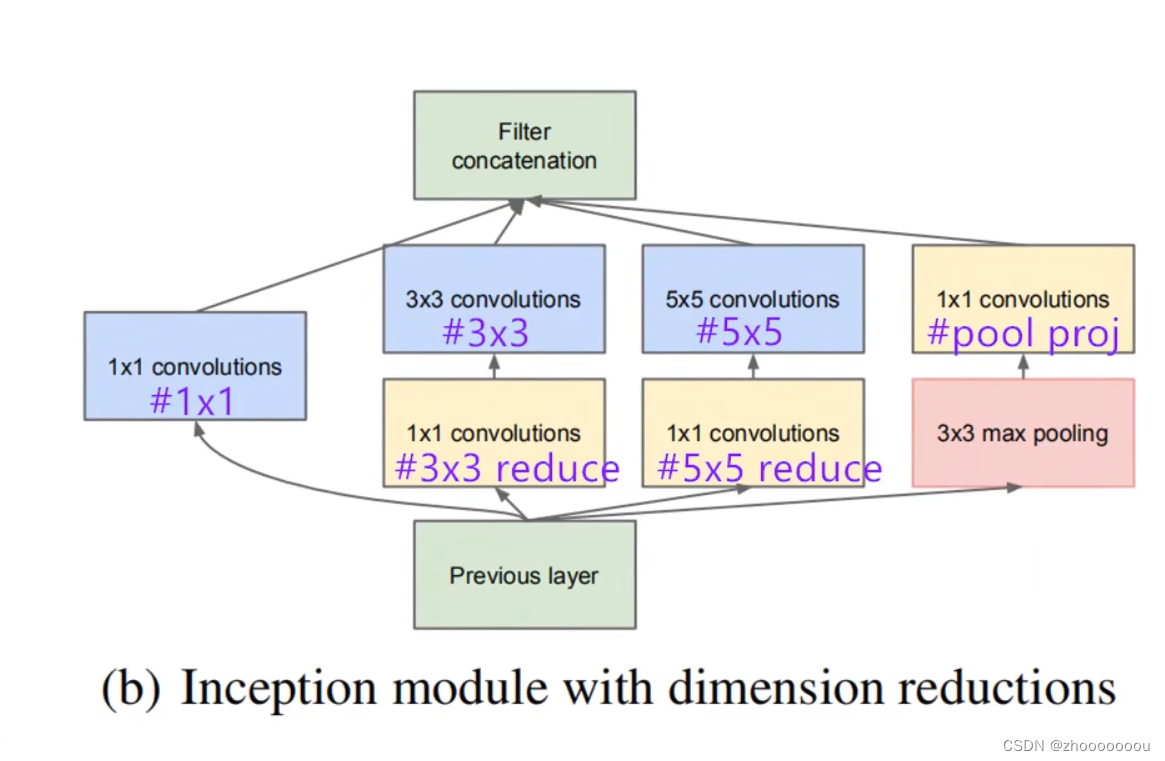

GooLeNet 亮点 最明显的亮点就是引入了Inception,初衷是多卷积核增加特征的多样性,提高泛化能力 ,比如,最下边是一个输入层,然后这个输入分别传递给1*1,3 * 3 ,5 * 5和一个最大池化层,然后将所有的输出特征图在深度上进行一个串联,所以说这就要保证特征图的大小必须得是一致的,1 * 1的卷积核不改变大小,其他卷积核池化要添加0补充。 这就是Inception V1结构

卷积神经网络CNN经典模型Lenet,Alexnet,Googlenet,VGG,Deep Residual Learning

本篇文章转载自:Bin的专栏blog.csdn.net/xbinworld。 关于卷积神经网络CNN,网络和文献中有非常多的资料,我在工作/研究中也用了好一段时间各种常见的model了,就想着简单整理一下,以备查阅之需。如果读者是初接触CNN,建议可以先看一看“Deep Learning(深度学习)学习笔记整理系列”中关于CNN的介绍[1],是介绍我们常说的Lenet为例,相信会对初学者有

第七周 GoogLeNet-v4

1:文字回答:用自己的理解,总结GoogLeNet-V1到GoogLeNet-V4,这四篇论文的发展 答:Inception历经了V1、V2、V3、V4多个版本的发展,不断趋于完善,下面一一进行介绍。 一、Inception V1 通过设计一个稀疏网络结构,但是能够产生稠密的数据,技能增加神经网络表现,又能保证计算资源的使用效率。谷歌提出了最原始的Inception的基本结构: 该结构将CNN中