cs231n专题

斯坦福深度学习课程CS231N 2017

官网:http://cs231n.stanford.edu/index.html 教学视频:https://study.163.com/course/courseMain.htm?courseId=1003223001&_trace_c_p_k2_=ce601d978e4d408a909911855ef1eb24#/courseDetail https://www.bilibili.co

Stanford CS231N

文章目录 1 introduction to convolutional neural network2 Image classification pipeline2.1 nearest neighbors classifier/KNN2.2 Linear classification 3 loss function and optimization3.1 loss function of

【CS231n】斯坦福大学李飞飞视觉识别课程笔记(四):图像分类笔记(上)

【CS231n】斯坦福大学李飞飞视觉识别课程笔记 由官方授权的CS231n课程笔记翻译知乎专栏——智能单元,比较详细地翻译了课程笔记,我这里就是参考和总结。 【CS231n】斯坦福大学李飞飞视觉识别课程笔记(四):图像分类笔记(上) 图像分类 目标:这一节我们将介绍图像分类问题。所谓图像分类问题,就是已有固定的分类标签集合,然后对于输入的图像,从分类标签集合中找出一个分类标签,最

【CS231n】斯坦福大学李飞飞视觉识别课程笔记(三):Python Numpy教程(3)

【CS231n】斯坦福大学李飞飞视觉识别课程笔记 由官方授权的CS231n课程笔记翻译知乎专栏——智能单元,比较详细地翻译了课程笔记,我这里就是参考和总结。 【CS231n】斯坦福大学李飞飞视觉识别课程笔记(三):Python Numpy教程 SciPy Numpy提供了高性能的多维数组,以及计算和操作数组的基本工具。SciPy基于Numpy,提供了大量的计算和操作数组的函数,这

【CS231n】斯坦福大学李飞飞视觉识别课程笔记(二):Python Numpy教程(2)

【CS231n】斯坦福大学李飞飞视觉识别课程笔记 由官方授权的CS231n课程笔记翻译知乎专栏——智能单元,比较详细地翻译了课程笔记,我这里就是参考和总结。 【CS231n】斯坦福大学李飞飞视觉识别课程笔记(二):Python Numpy教程 Numpy Numpy是Python中用于科学计算的核心库。它提供了高性能的多维数组对象,以及相关工具。 数组Arrays 一个num

【CS231n】斯坦福大学李飞飞视觉识别课程笔记(一):Python Numpy教程(1)

最近开了一个新坑——【CS231n】斯坦福大学李飞飞视觉识别课程,准备认真学习并记录自己的学习历程。 【CS231n】斯坦福大学李飞飞视觉识别课程笔记 由官方授权的CS231n课程笔记翻译知乎专栏——智能单元,比较详细地翻译了课程笔记,我这里就是参考和总结。 【CS231n】斯坦福大学李飞飞视觉识别课程笔记(一):Python Numpy教程 这个课程将使用Python编程语言来

【CS231n】斯坦福大学李飞飞视觉识别课程笔记(十八):卷积神经网络笔记(上)

【CS231n】斯坦福大学李飞飞视觉识别课程笔记 由官方授权的CS231n课程笔记翻译知乎专栏——智能单元,比较详细地翻译了课程笔记,我这里就是参考和总结。 【CS231n】斯坦福大学李飞飞视觉识别课程笔记(十八):卷积神经网络笔记(上) 卷积神经网络(CNNs / ConvNets) 卷积神经网络和上一章讲的常规神经网络非常相似:它们都是由神经元组成,神经元中有具有学习能力的权

【CS231n】斯坦福大学李飞飞视觉识别课程笔记(十七):神经网络笔记3(下)

【CS231n】斯坦福大学李飞飞视觉识别课程笔记 由官方授权的CS231n课程笔记翻译知乎专栏——智能单元,比较详细地翻译了课程笔记,我这里就是参考和总结。 【CS231n】斯坦福大学李飞飞视觉识别课程笔记(十七):神经网络笔记3(下) 参数更新 一旦能使用反向传播计算解析梯度,梯度就能被用来进行参数更新了。进行参数更新有好几种方法,接下来都会进行讨论。 深度网络的最优化是现在

【CS231n】斯坦福大学李飞飞视觉识别课程笔记(十六):神经网络笔记3(上)

【CS231n】斯坦福大学李飞飞视觉识别课程笔记 由官方授权的CS231n课程笔记翻译知乎专栏——智能单元,比较详细地翻译了课程笔记,我这里就是参考和总结。 【CS231n】斯坦福大学李飞飞视觉识别课程笔记(十六):神经网络笔记3(上) 学习过程 在前面章节中,我们讨论了神经网络的静态部分:如何创建网络的连接、数据和损失函数。本节将致力于讲解神经网络的动态部分,即神经网络学习参数

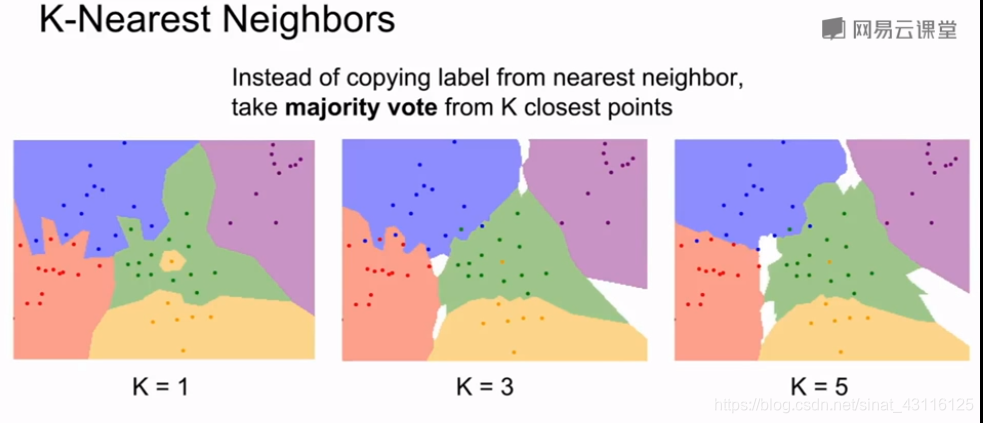

CS231N课程作业Assignment1--KNN

Assignment1–KNN 作业要求见这里. 主要需要完成 KNN,SVM,Softmax分类器,还有一个两层的神经网络分类器的实现。 数据集CIFAR-10. KNN原理 K近邻算法(KNN)算法是一种简单但也很常用的分类算法,它也可以应用于回归计算。KNN是无参数学习,这意味着它不会对底层数据的分布做出任何假设。它是基于实例,即该算法没有显式地学习模型。相反,它选择的是记忆训练实例,

【CS231n】斯坦福大学李飞飞视觉识别课程笔记(十五):神经网络笔记2(下)

【CS231n】斯坦福大学李飞飞视觉识别课程笔记 由官方授权的CS231n课程笔记翻译知乎专栏——智能单元,比较详细地翻译了课程笔记,我这里就是参考和总结。 【CS231n】斯坦福大学李飞飞视觉识别课程笔记(十五):神经网络笔记2(下) 损失函数 我们已经讨论过损失函数的正则化损失部分,它可以看做是对模型复杂程度的某种惩罚。损失函数的第二个部分是数据损失,它是一个有监督学习问题,

CS231n-2017 Assignment3 RNN、LSTM、风格迁移

一、RNN 所需完成的步骤记录在RNN_Captioning.ipynb文件中。 本例中所用的数据为Microsoft于2014年发布的COCO数据集。该数据集中和图像标注想拐的图片包含80000张训练图片和40000张验证图片。而这些图片的特征已通过VGG-16网络获得,存储在train2014_vgg16_fc7.h5和val2014_vgg16_fc7.h5文件中,每张图片由一个4096

cs231n-(5)神经网络-2:设置数据和Loss

cs231n-(5)神经网络-2:设置数据和Loss数据预处理 减去均值正则化PCA and Whitening权重初始化 全部初始化为零小的随机数校准方差稀疏初始化实际应用批归一化 Batch Normalization正则化 L2 regularizationL1 regularizationMax norm constraintsDropoutTheme of noise in for

(2023版)斯坦福CS231n学习笔记:DL与CV教程 (3) | 正则化与最优化

前言 📚 笔记专栏:斯坦福CS231N:面向视觉识别的卷积神经网络(23)🔗 课程链接:https://www.bilibili.com/video/BV1xV411R7i5💻 CS231n: 深度学习计算机视觉(2017)中文笔记:https://zhuxiaoxia.blog.csdn.net/article/details/80155166🔥 2023最新课程PPT:https

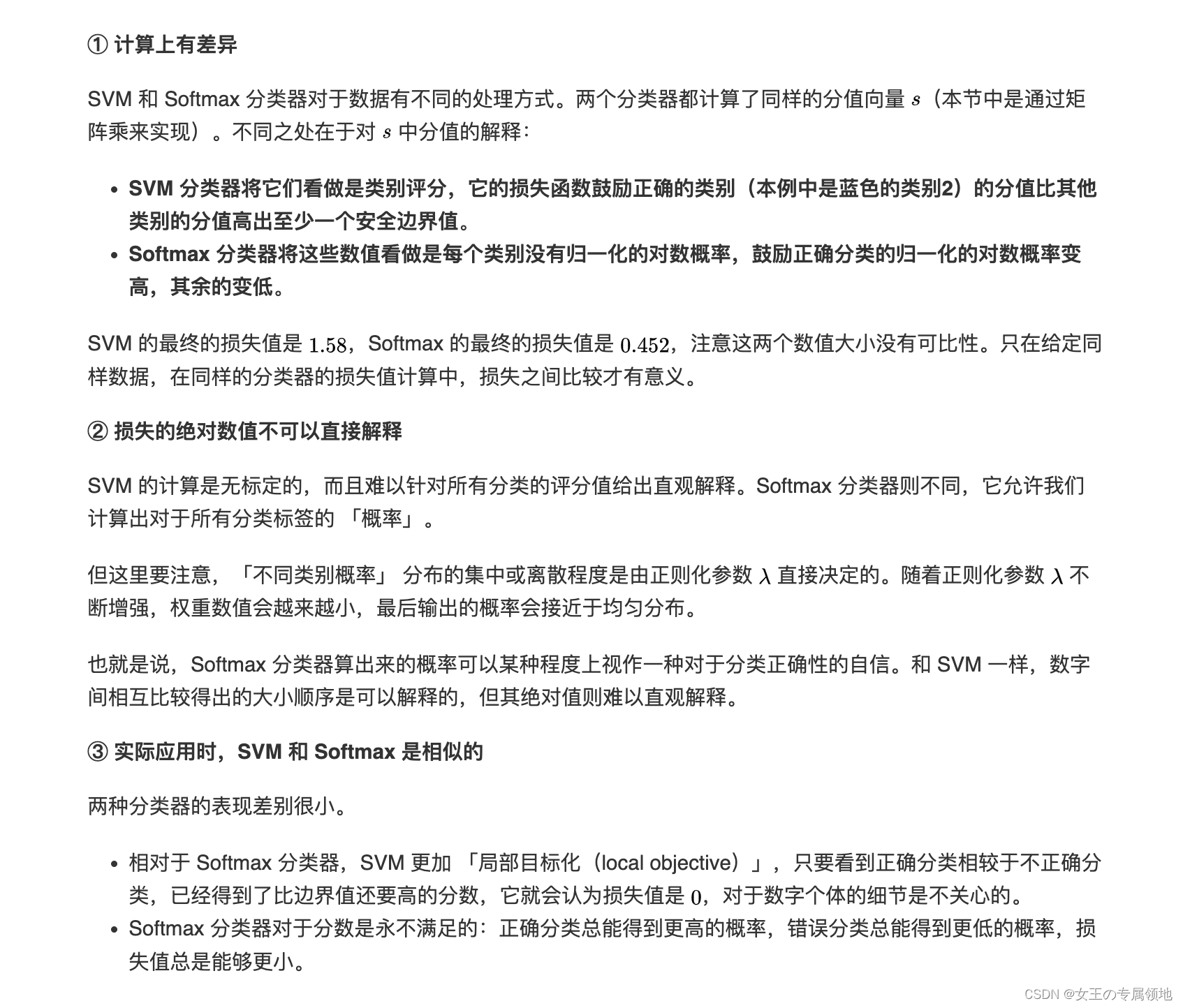

(2023版)斯坦福CS231n学习笔记:DL与CV教程 (2) | 图像分类与损失函数

前言 📚 笔记专栏:斯坦福CS231N:面向视觉识别的卷积神经网络(23)🔗 课程链接:https://www.bilibili.com/video/BV1xV411R7i5💻 CS231n: 深度学习计算机视觉(2017)中文笔记:https://zhuxiaoxia.blog.csdn.net/article/details/80155166🔥 2023最新课程PPT:https

斯坦福CS231n学习笔记:DL与CV教程 (4) | 神经网络与反向传播

前言 笔记简介📚:斯坦福CS231n《深度学习与计算机视觉(Deep Learning for Computer Vision)》的2023最新学习笔记。课程链接🔗:https://www.bilibili.com/video/BV1Wk4y1Q7m7CS231n: 深度学习计算机视觉(2017)中文笔记:https://zhuxiaoxia.blog.csdn.net/article/de

我的cs231n学习笔记(2)lecture2-K Nearest Neighbor

lecture2:KNN 根据KNN算法所做的表现效果并不是很好: 我们可以通过将k值调大的方法使算法表现的更好,但还有另外一个选择,更换距离函数。L2 distance距离函数也叫做欧式距离函数(Euclidean distance) 不同的距离度量函数在预测的空间里对底层的几何或拓扑结构做出不同的假设。 kNN模拟 k值、距离函数成为超参数(hyperparameters),因为他们并

我的cs231n学习笔记(1)lecture2-data driven approach

lecture2:image classification 图像分类是计算机视觉中真正核心的任务。当你做图像处理时,分类系统接受一些输入图像,并且系统清楚一些已经确定了分类或者标签的集合(图像中具体所指事物的名称如:狗、猫),计算机的工作就是看图片然后将进行分类哪些是狗哪些是猫。这对人类来说简单无比但是对于计算机来说难于登天,因为计算机并没有图片的概念,它看到的只是一堆数字阵列,这就成为语义鸿沟

# [cs231n (九)卷积神经网络 ][1]

cs231n (九)卷积神经网络 标签(空格分隔): 神经网络 文章目录 [cs231n (九)卷积神经网络 ][1]同类文章0.回顾1. 引言2. 总体概述3. 构建卷积网络的每个层1. 卷积层2. pooling池化层3. 归一化层4. 全连接层5. 全连接层转化为卷积层 4. 如何构建卷积神经网络的结构1. 层的排列方式2. 层的大小设置规律3. 相关案例学习(LeNet/ A

# [cs231n (八)神经网络总结:最小网络案例研究 ][1]

cs231n (八)神经网络总结:最小网络案例研究 标签(空格分隔): 神经网络 文章目录 [cs231n (八)神经网络总结:最小网络案例研究 ][1]同类文章0.回顾1. 引言2. 生成一些数据3. 训练一个softmax线性分类器1. 初始化参数2. 计算分数3. 计算loss4. 反向传播法计算梯度6. 现在就可以合并一下得到softmax分类器 4. 训练神经网络5. 总结

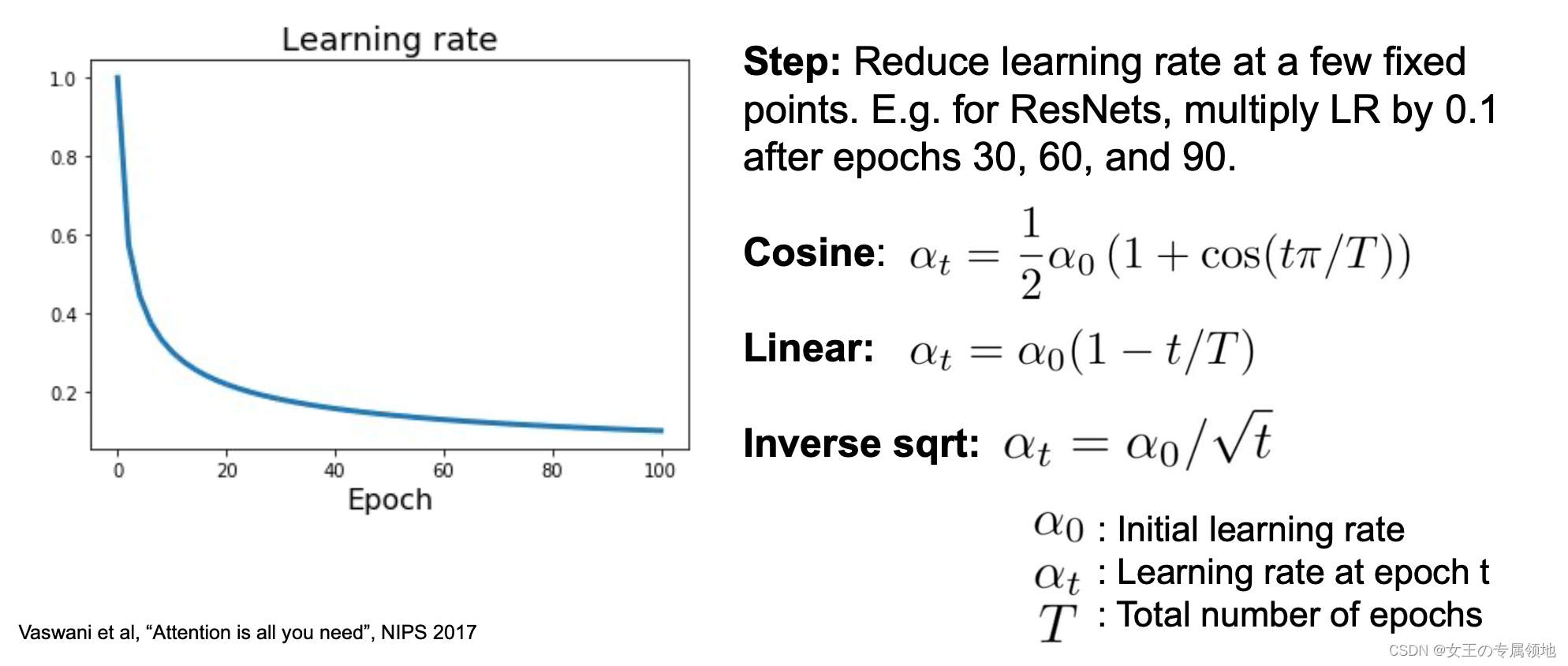

# [cs231n (七)神经网络 part 3 : 学习和评估 ][1]

cs231n (七)神经网络 part 3 : 学习和评估 标签(空格分隔): 神经网络 文章目录 [cs231n (七)神经网络 part 3 : 学习和评估 ][1]同类文章0.回顾1.引言2. 梯度检验3. 做到:合理性检查4. 接下来检查整个学习过程1. 损失函数2. 训练和验证集精度3. 权重更新4. 层激活数及梯度分布情况 5. 参数更新1. 随机梯度下降2. 学习率退化

# [cs231n (六)神经网络 part 2:传入数据和损失 ][1]

cs231n (六)神经网络 part 2:传入数据和损失 标签(空格分隔): 神经网络 文章目录 [cs231n (六)神经网络 part 2:传入数据和损失 ][1]同类文章0.回顾1. 引言2. 初始化数据和模型1. 数据预处理阶段**处理方式:****白化和PCA** 2. 权重初始化3.批归一化4. 正则化 3. 损失函数4. 总结转载和疑问声明我祝各位帅哥,和美女,你们永

# cs231n (四)反向传播

cs231n (四)反向传播 标签(空格分隔): 神经网络 文章目录 cs231n (四)反向传播0.回顾1.引言2. 通过简单表达式理解梯度3. 链式法则计算复合函数4. 如何理解反向传播5. 模块化:Sigmoid6. 实践反向传播:分段7. 反向梯度流的模式8. 向量化计算梯度啦9. 总结一下呗10 下节预告转载和疑问声明我祝各位帅哥,和美女,你们永远十八岁,嗨嘿嘿~~~

Stanford CS231n 2017春季课程

斯坦福大学的 CS231n(全称:面向视觉识别的卷积神经网络)一直是计算机视觉和深度学习领域的经典课程,每年开课都吸引很多学生。今年是该课程第3次开课,学生达到730人(第1次150人,第2次350人)。今年的CS231n Spring的instructors 是李飞飞、Justin Johnson和Serena Yeung,并邀请 Ian Goodfellow 等人讲解GAN等重要主题。最近斯坦

CS231n作业笔记2.6:卷积层以及池化层的实现

CS231n简介 详见 CS231n课程笔记1:Introduction。 本文都是作者自己的思考,正确性未经过验证,欢迎指教。 作业笔记 就是简单实现一下卷积层以及池化层,唯一的难点在于确定索引值,稍微注意一下就好。 1. 卷积层 1.1. 前向传播 使用np.pad做填充。 N, C, H, W = x.shapeF, C, HH, WW = w.shapestride =

CS231n作业笔记2.5:dropout的实现与应用

CS231n简介 详见 CS231n课程笔记1:Introduction。 本文都是作者自己的思考,正确性未经过验证,欢迎指教。 作业笔记 dropout中唯一需要注意的就是为了平衡train与test,通过除以期望值即可。 1. 前向传播 if mode == 'train':mask = (np.random.rand(*x.shape)<p)out = x*mask / pe

![# [cs231n (九)卷积神经网络 ][1]](https://raw.githubusercontent.com/Stevewsw/Photos-for-markdown/master/ali.jpg)