本文主要是介绍(2023版)斯坦福CS231n学习笔记:DL与CV教程 (3) | 正则化与最优化,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

前言

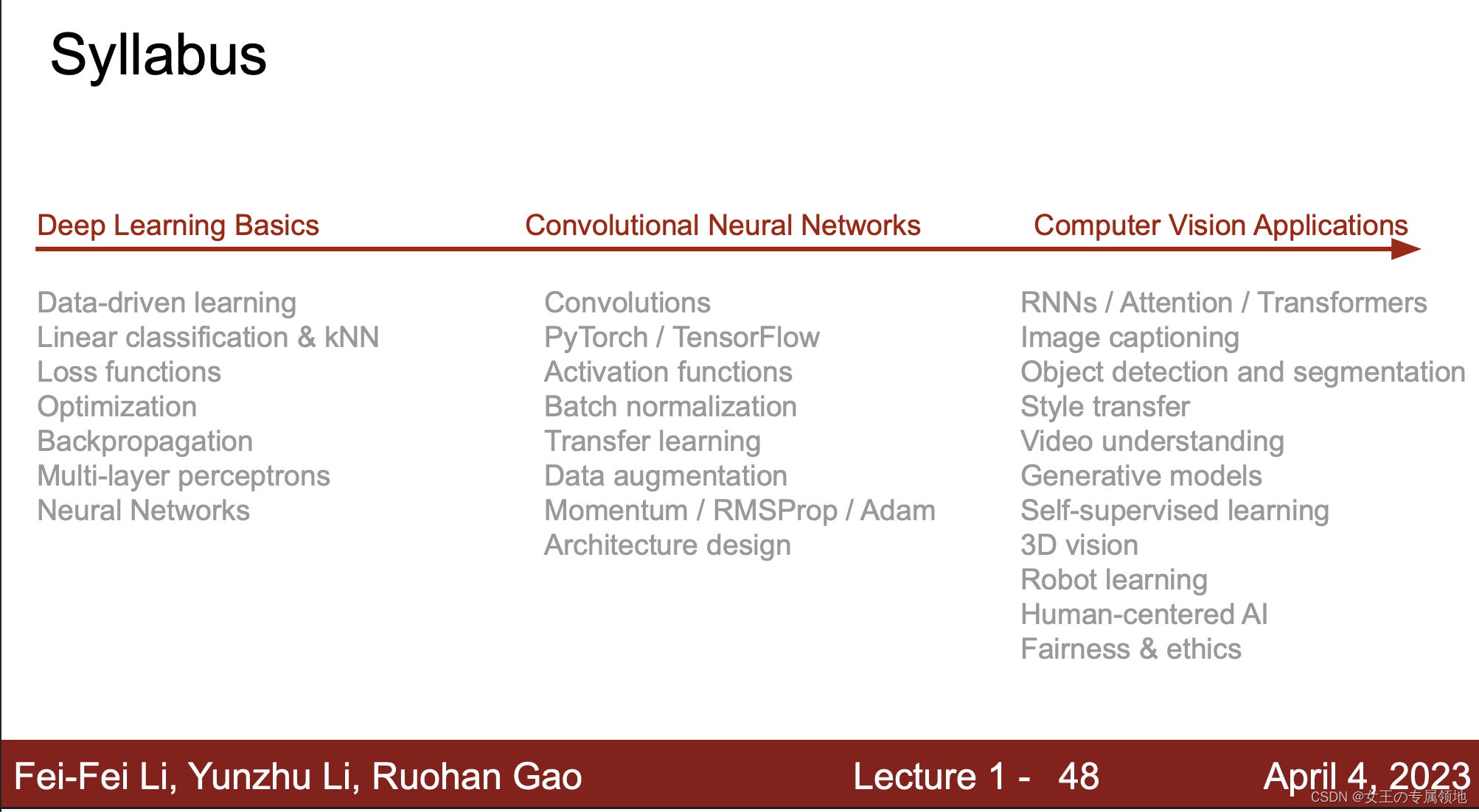

- 📚 笔记专栏:斯坦福CS231N:面向视觉识别的卷积神经网络(23)

- 🔗 课程链接:https://www.bilibili.com/video/BV1xV411R7i5

- 💻 CS231n: 深度学习计算机视觉(2017)中文笔记:https://zhuxiaoxia.blog.csdn.net/article/details/80155166

- 🔥 2023最新课程PPT:https://download.csdn.net/download/Julialove102123/88734395

⚠️ 本节重点内容:

- 正则化Regularization

- 最优化Optimization

- 梯度下降 Grendient descent

- 学习率Learning rate

1. 正则化(Regularization)

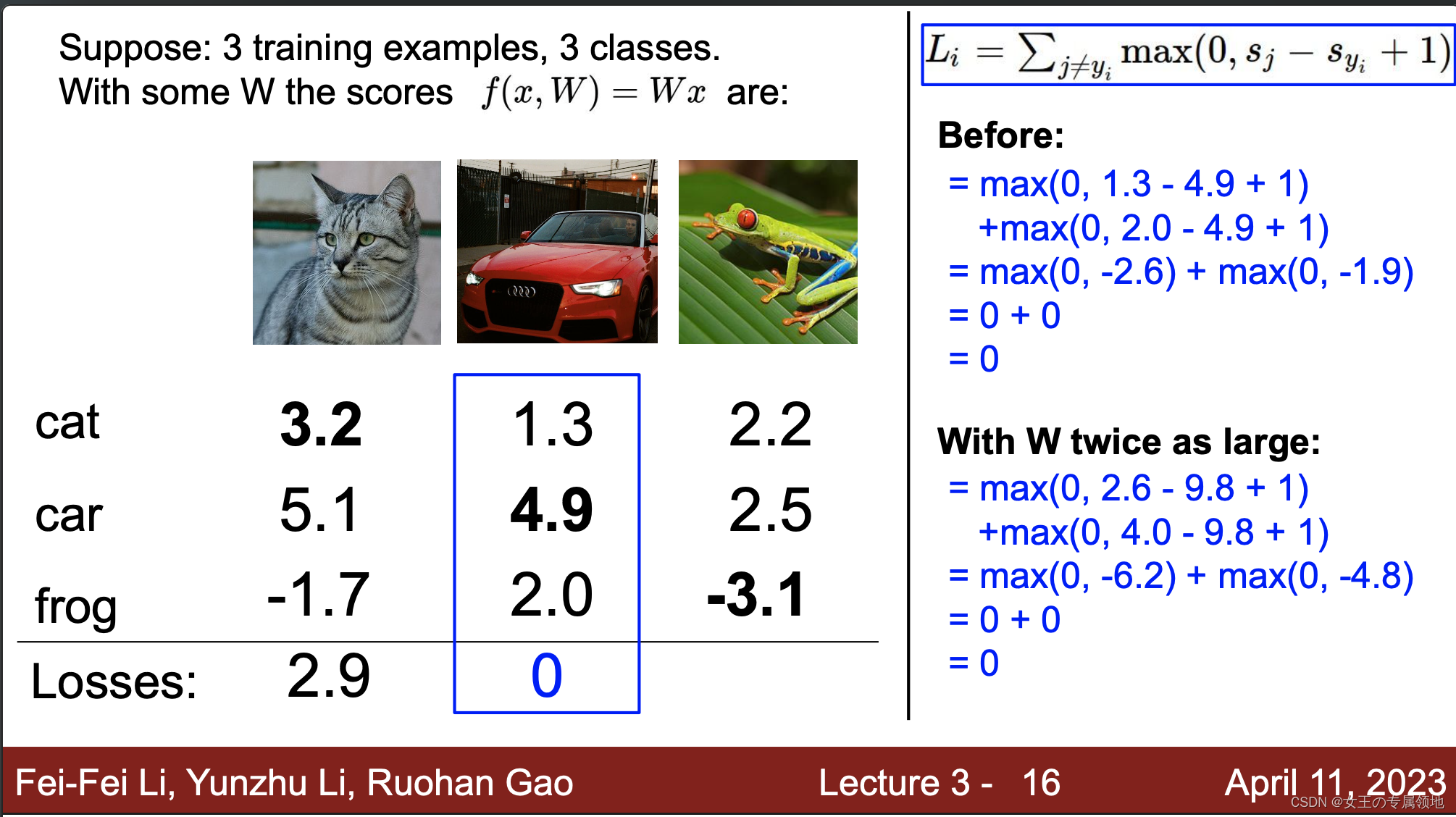

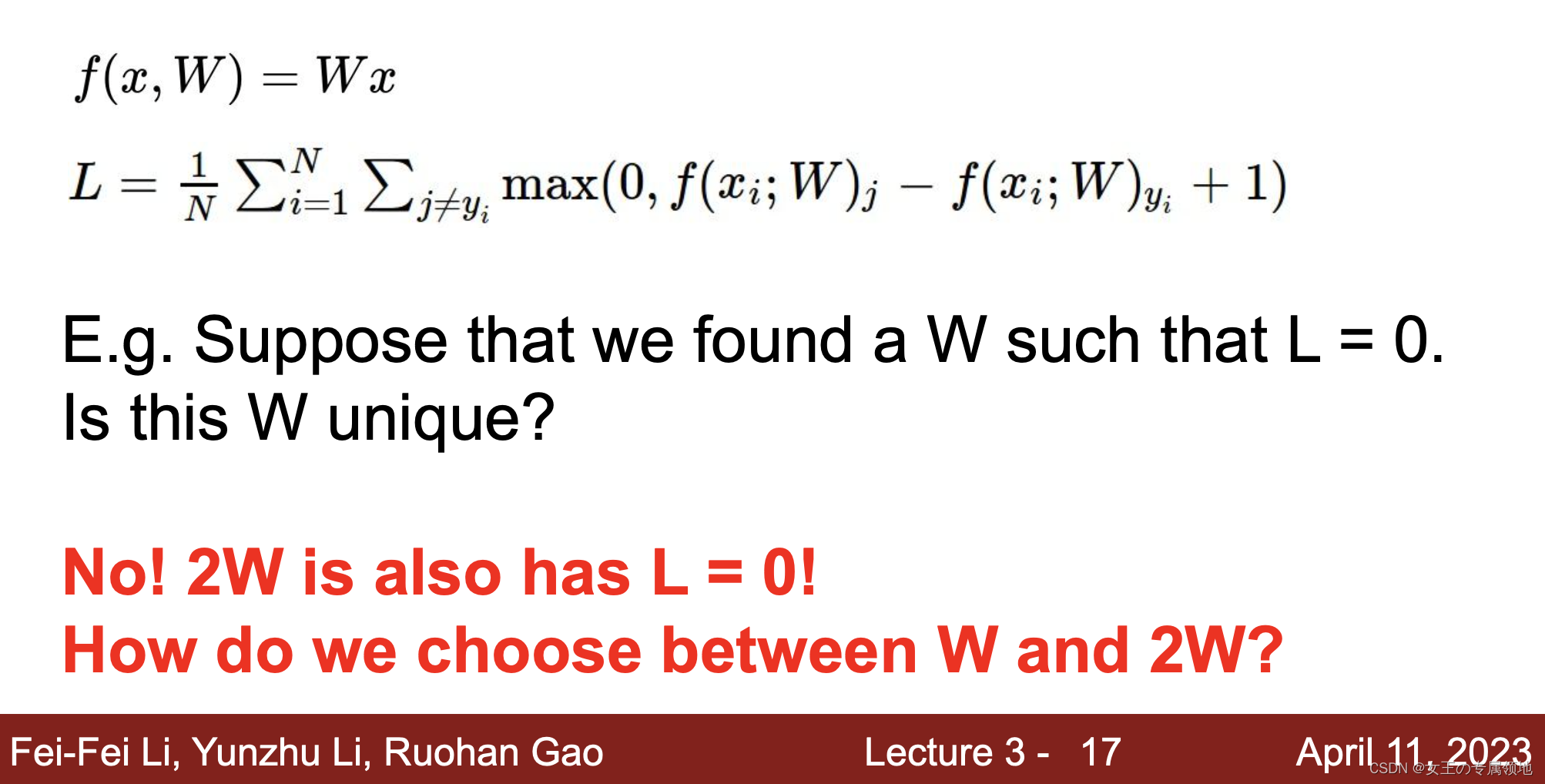

1.1 为什么引入正则化

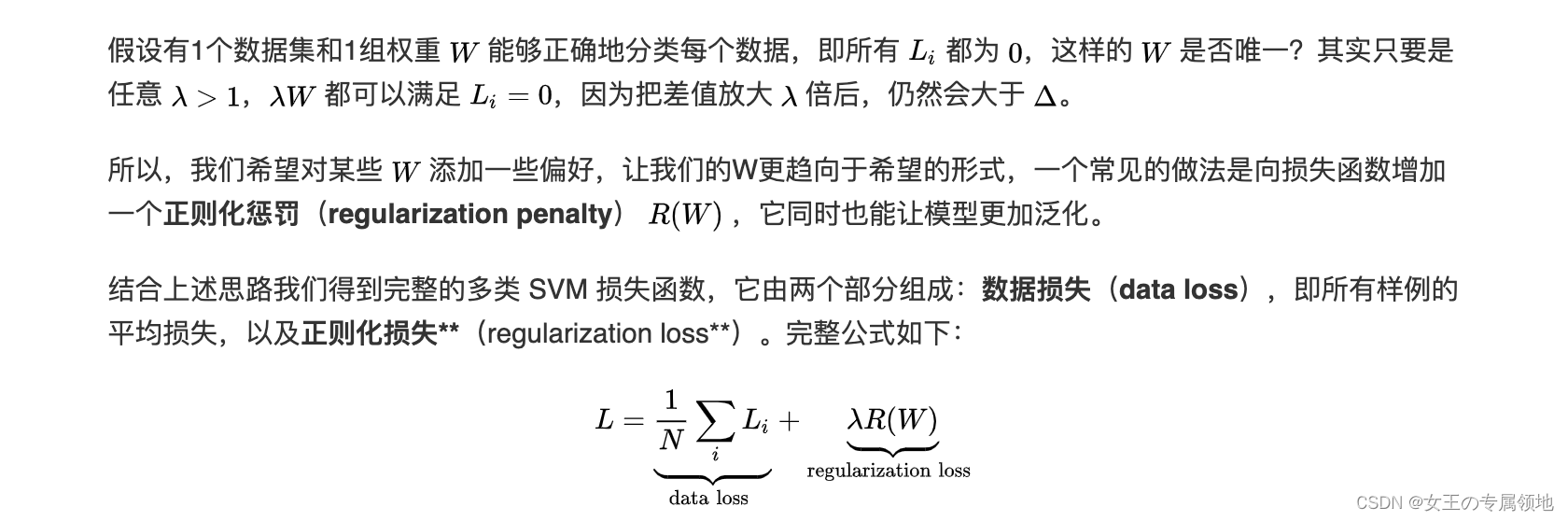

上节讲到了如何选择最合适的超参数W,那有没有可能会出现多个这样的参数W1、W2…都能似的损失函数最小呢,答案是非常有可能!!!本节引入正则化就是确定怎么选最合适的W。

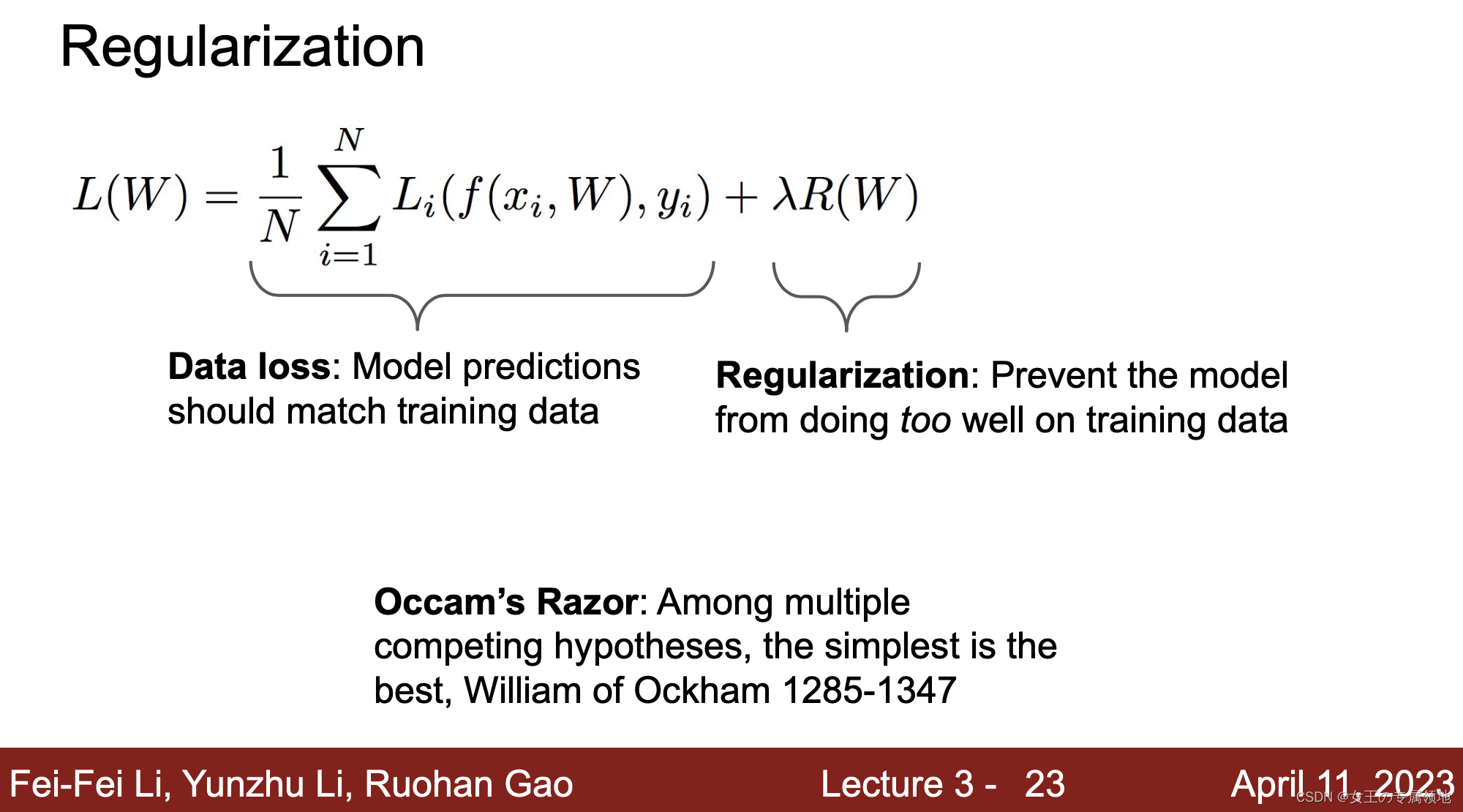

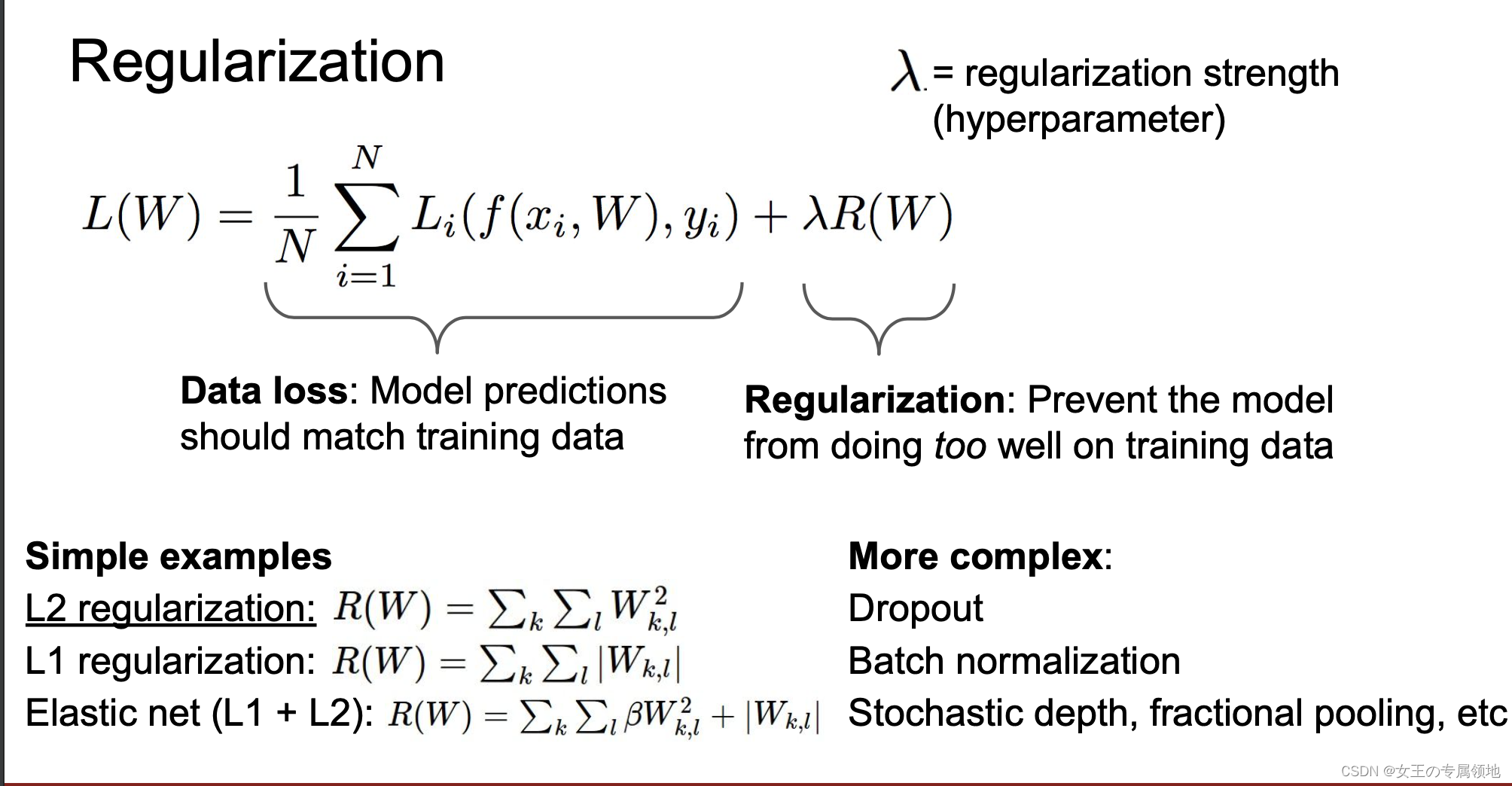

1.2 正则化损失(regularization loss)

为什么要正则化?

- 表达对权重的偏好

- 使模型简单,以便它适用于测试数据

- 通过添加曲率来改进优化

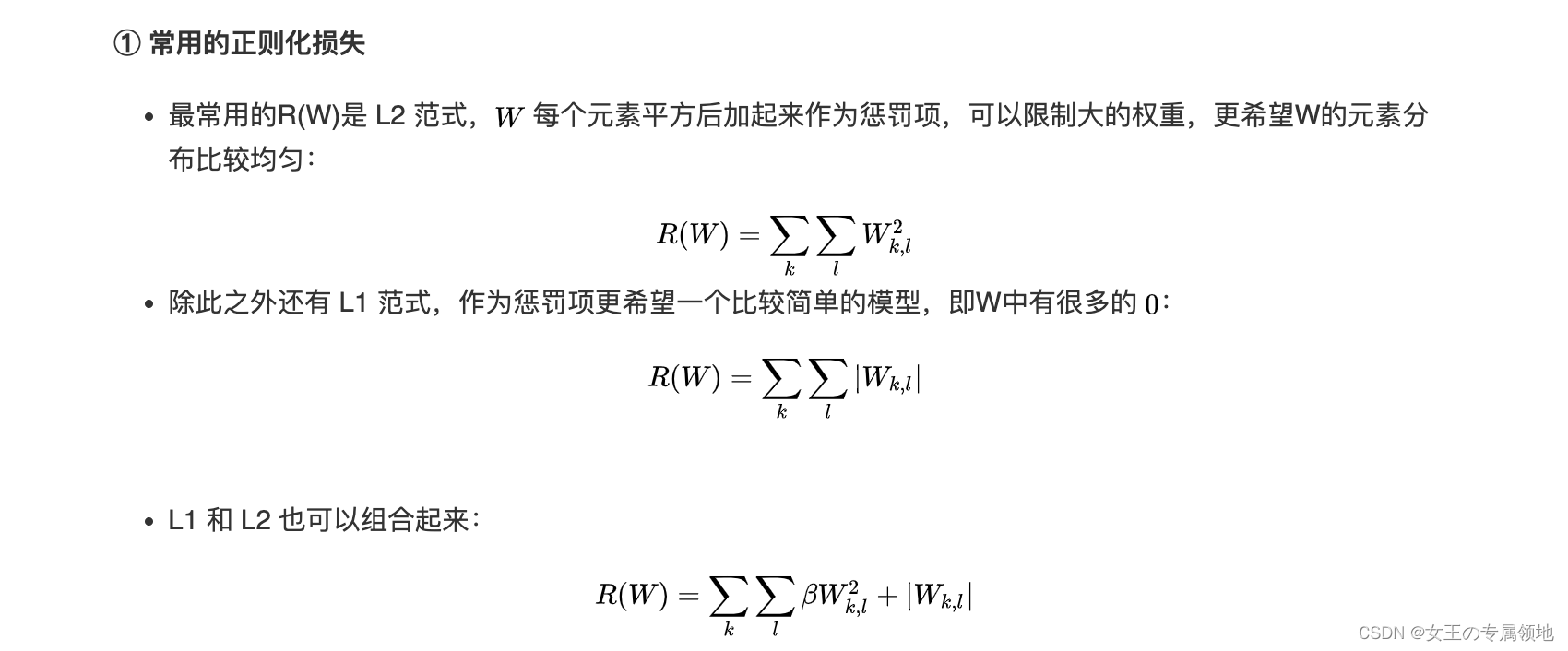

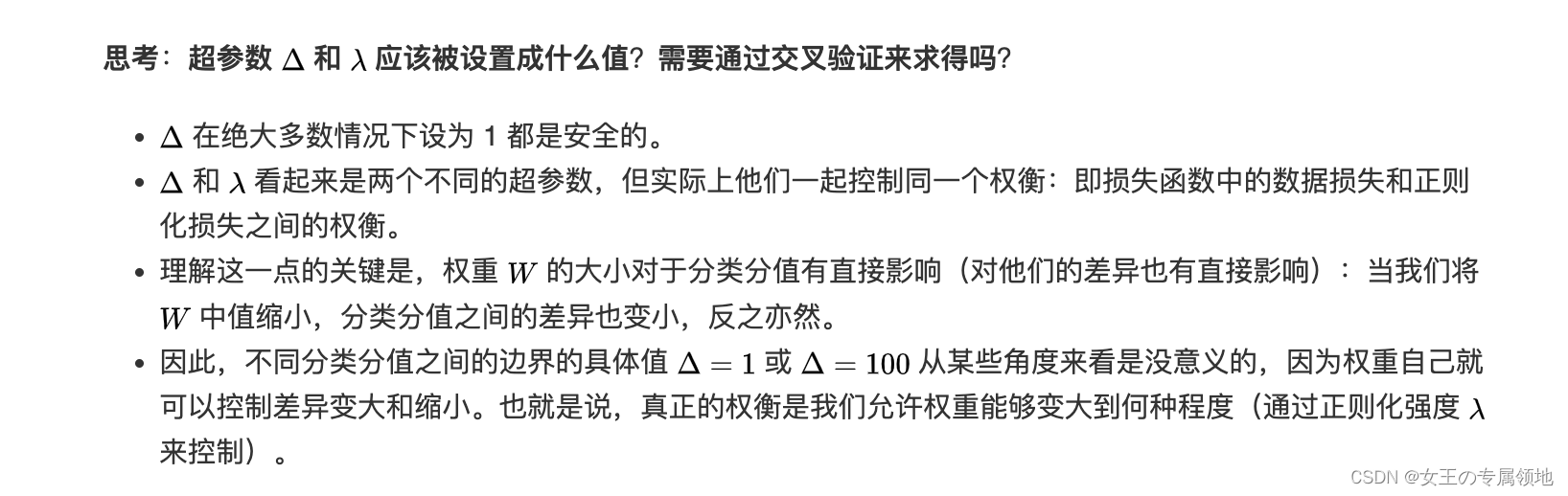

1.3 常见正则化损失

二、优化(Optimization)

🔥🔥🔥重要推荐:可视化工具 :http://vision.stanford.edu/teaching/cs231n-demos/linear-classify/

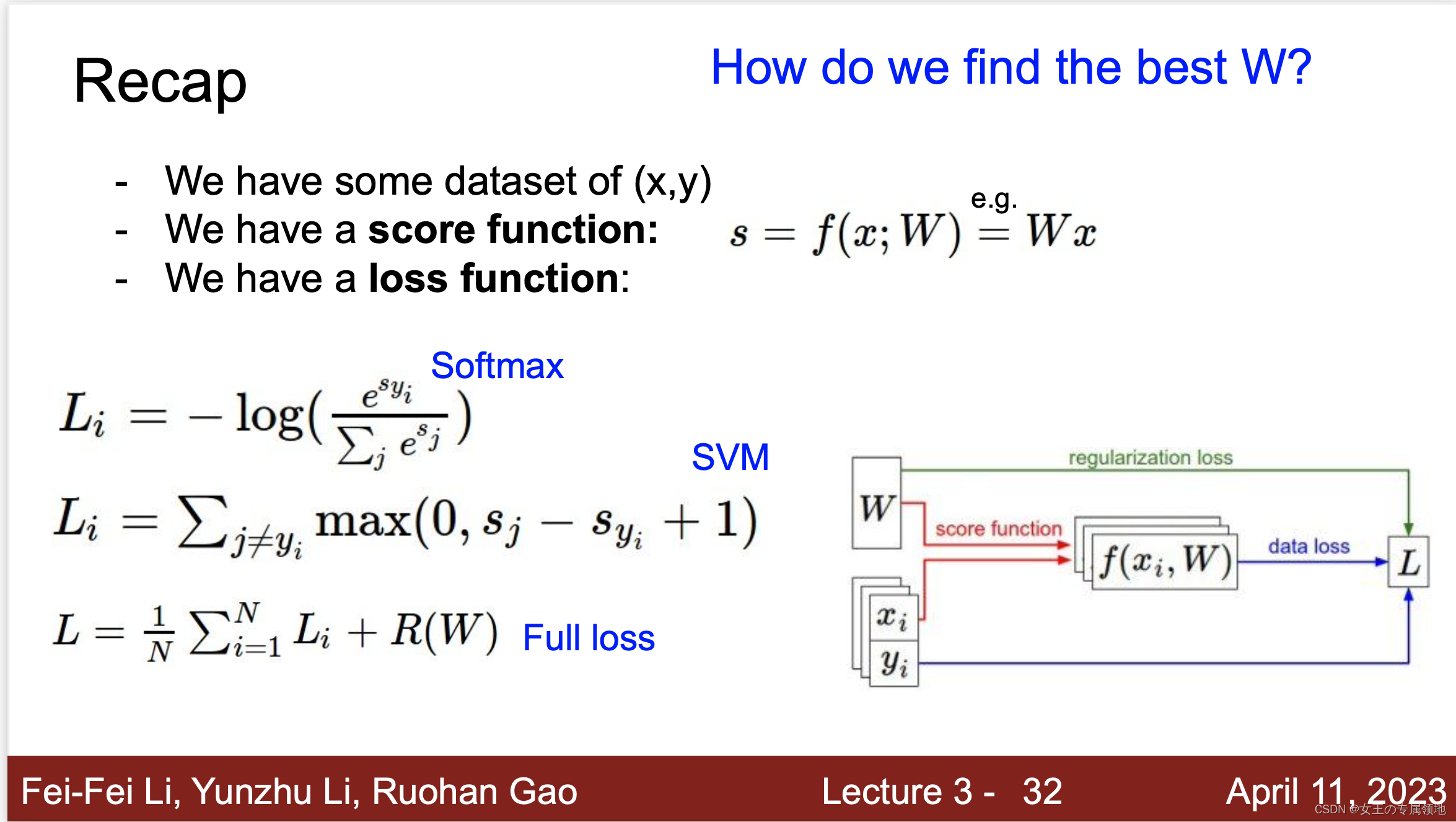

现在我们有了数据集、评分函数、损失函数,那我们怎么找到最好的超参数W呢?答案是优化!

2.1 优化策略(Optimization Strategy)

优化策略的目标是:找到能够最小化损失函数值的权重W。

1) 策略一:随机搜索(Random search)

随机尝试很多不同的权重,然后看其中哪个最好。这是一个差劲的初始方案。验证集上表现最好的权重W跑测试集的准确率是15.5%,而完全随机猜的准确率是10%,效果不好!

思路调整:新的策略是从随机权重W开始,然后迭代取优,每次都让它的损失值变得更小一点,从而获得更低的损失值。想象自己是一个蒙着眼睛的徒步者,正走在山地地形上,目标是要慢慢走到山底。在 CIFAR-10 的例子中,这山是30730维的(因为W是3073X10)。我们在山上踩的每一点都对应一个的损失值,该损失值可以看做该点的海拔高度。

2) 策略二:随机本地搜索

第一个策略可以看做是每走一步都尝试几个随机方向,如果是上山方向就停在原地,如果是下山方向,就向该方向走一步。这次我们从一个随机W开始,然后生成一个随机的扰动aW,只有当 W+aW 的损失值变低,我们才会更新。用上述方式迭代1000次,这个方法可以得到 公式 的分类准确率。

3) 策略三:跟随梯度

前两个策略关键点都是在权重空间中找到合适的方向,使得沿其调整能降低损失函数的损失值。其实不需要随机寻找方向,我们可以直接计算出最好的方向,这个方向就是损失函数的梯度(gradient)。这个方法就好比是感受我们脚下山体的倾斜程度,然后向着最陡峭的下降方向下山。

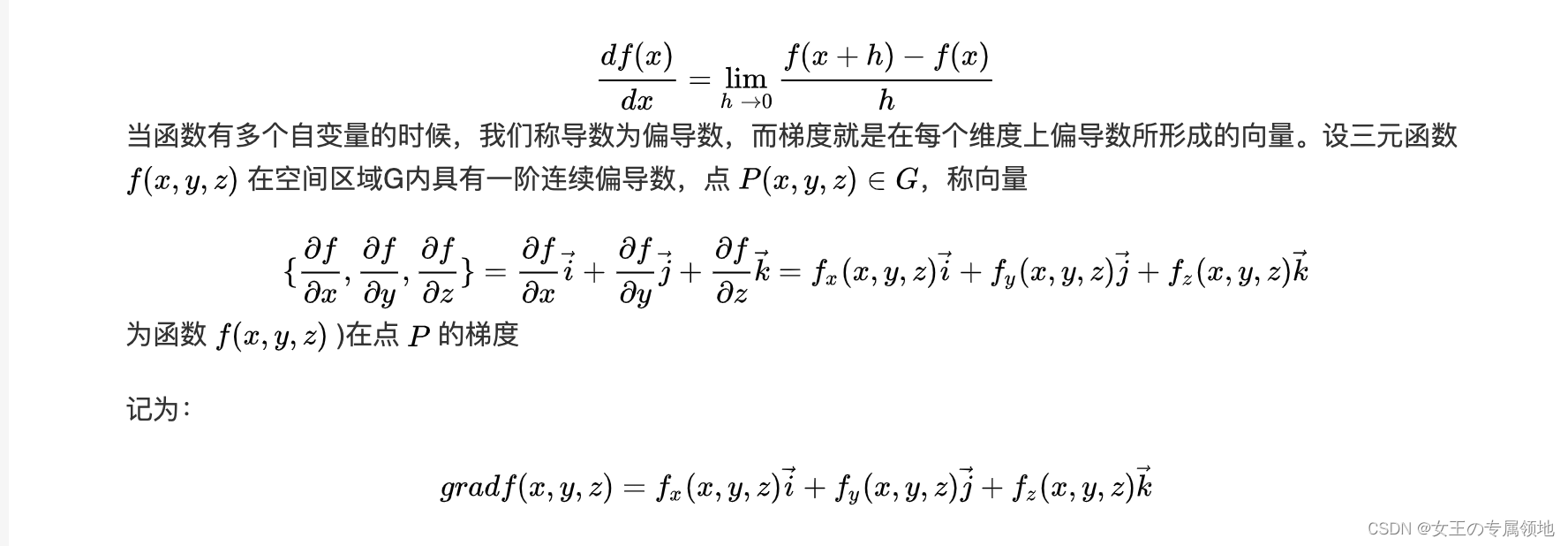

在一维函数中,斜率是函数在某一点的瞬时变化率。梯度是函数斜率的一般化表达,它是一个向量。

在输入空间中,梯度是各个维度的斜率组成的向量(或者称为导数 derivatives)。对一维函数的求导公式如下:

三、梯度计算

计算梯度有两种方法:

1.数值梯度法,缓慢的近似方法,实现相对简单。

2. 分析梯度法,计算迅速,结果精确,但是实现时容易出错,且需要使用微分。

3.1 数值梯度法

数值梯度法是借助于梯度的定义对其进行逼近计算。输入函数 f f f和矩阵 x x x,计算 f f f的梯度的通用函数,它返回函数 f f f在点 x x x处的梯度,利用公式

代码对 x x x矩阵所有元素进行迭代,在每个元素上产生一个很小的变化 h h h,通过观察函数值变化,计算函数在该元素上的偏导数。最后,所有的梯度存储在变量 grad 。实际中用中心差值公式(centered difference formula) [ f ( x + h ) − f ( x − h ) ] / 2 h [f(x+h)-f(x-h)]/2h [f(x+h)−f(x−h)]/2h 效果会更好。

① 在梯度负方向上更新

- 在上面的代码中,为了计算 W_new,要注意我们是向着梯度df的负方向去更新,这是因为我们希望损失函数值是降低而不是升高。(偏导大于0,损失递增,W需要减小;偏导小于0,损失递减,W需要增大。)

② 步长的影响

- 从某个具体的点W开始计算梯度,梯度指明了函数在哪个方向是变化率最大的,即损失函数下降最陡峭的方向,但是没有指明在这个方向上应该迈多大的步子。

- 小步长下降稳定但进度慢,大步长进展快但是风险更大,可能导致错过最优点,让损失值上升。在某些点如果步长过大,反而可能越过最低点导致更高的损失值。选择步长(也叫作学习率)将会是神经网络训练中最重要(也是最麻烦)的超参数设定之一。

③ 效率问题

- 计算数值梯度的复杂性和参数的量线性相关。在本例中有30730个参数,所以损失函数每走一步就需要计算30731次损失函数(计算梯度时计算30730次,最终计算一次更新后的。)

- 现代神经网络很容易就有上千万的参数,因此这个问题只会越发严峻。显然这个策略不适合大规模数据。

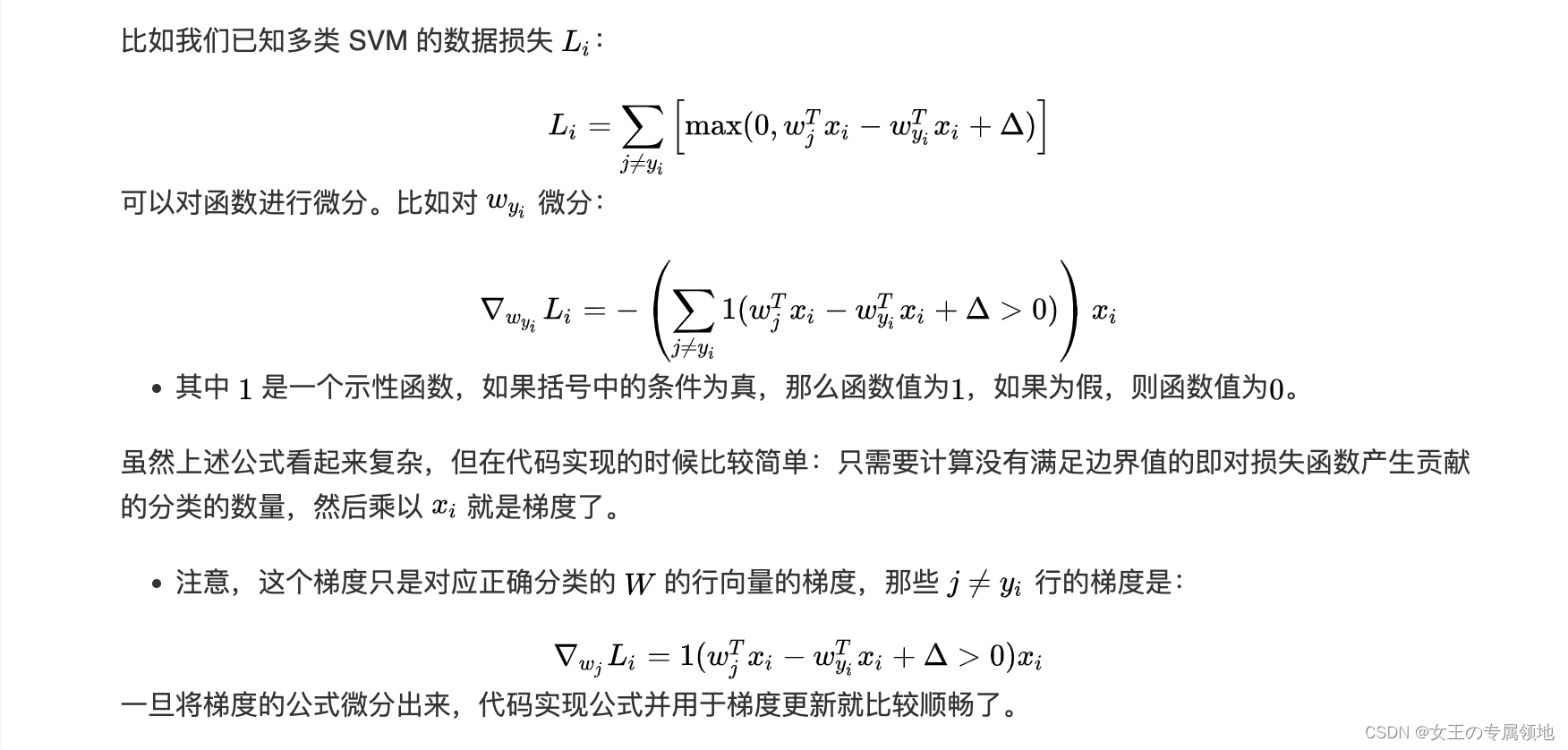

3.2 解析梯度法

数值梯度的计算比较简单,但缺点在于只是近似不够精确,且耗费计算资源太多。

得益于牛顿-莱布尼茨的微积分,我们可以利用微分来分析,得到计算梯度的公式(不是近似),用公式计算梯度速度很快,但在实现的时候容易出错。

为了解决这个问题,在实际操作时常常将分析梯度法的结果和数值梯度法的结果作比较,以此来检查其实现的正确性,这个步骤叫做梯度检查。

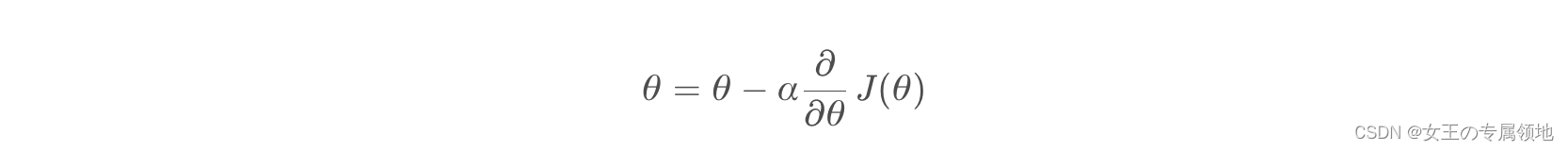

四、梯度下降(Gradient Descent)

现在可以利用微分公式计算损失函数梯度了,程序重复地计算梯度然后对参数进行更新,这一过程称为梯度下降。

4.1 Batch Gradient Descent (BGD)(Batch = 全量M)

Batch梯度下降法 (批梯度下降法) 是最常用的梯度下降形式,它是基于整个训练集的梯度下降算法,在更新参数时使用所有的样本来进行更新。

梯度更新规则:

BGD 采用整个训练集的数据来计算 cost function 对参数的梯度:

缺点:

由于这种方法是在一次更新中,就对整个数据集计算梯度,所以计算起来非常慢,遇到很大量的数据集也会非常棘手,而且不能投入新数据实时更新模型。

Batch gradient descent 对于凸函数可以收敛到全局极小值,对于非凸函数可以收敛到局部极小值。

4.2 Stochastic Gradient Descent (SGD)(Batch = 1 )

梯度更新规则:

和 BGD 的一次用所有数据计算梯度相比,SGD 每次更新时对每个样本进行梯度更新,对于很大的数据集来说,可能会有相似的样本,这样 BGD 在计算梯度时会出现冗余,而 SGD 一次只进行一次更新,就没有冗余,而且比较快,并且可以新增样本。

随机梯度下降是通过每个样本来迭代更新一次,如果样本量很大的情况,那么可能只用其中部分的样本,就已经将theta迭代到最优解了,对比上面的批量梯度下降,迭代一次需要用到十几万训练样本,一次迭代不可能最优,如果迭代10次的话就需要遍历训练样本10次。缺点是SGD的噪音较BGD要多,使得SGD并不是每次迭代都向着整体最优化方向。所以虽然训练速度快,但是准确度下降,并不是全局最优。虽然包含一定的随机性,但是从期望上来看,它是等于正确的导数的。

缺点:

-

SGD 因为更新比较频繁,会造成 cost function 有严重的震荡。

-

BGD 可以收敛到局部极小值,当然 SGD 的震荡可能会跳到更好的局部极小值处。

-

当我们稍微减小 learning rate,SGD 和 BGD 的收敛性是一样的。

4.2 Mini-batch gradient descent (MBGD)(Batch =n, 1<n<M)

梯度更新规则:

MBGD 每一次利用一小批样本,即 n 个样本进行计算,这样它可以降低参数更新时的方差,收敛更稳定,另一方面可以充分地利用深度学习库中高度优化的矩阵操作来进行更有效的梯度计算。

和 SGD 的区别是每一次循环不是作用于每个样本,而是具有 n 个样本的批次。

超参数设定值: n 一般取值在 50~256

缺点:

🔥1. 挑战1:不能保证很好的收敛性,learning rate 如果选择的太小,收敛速度会很慢,如果太大,loss function 就会在极小值处不停地震荡甚至偏离。对于非凸函数,还要避免陷于局部极小值处,或者鞍点处,因为鞍点周围的error是一样的,所有维度的梯度都接近于0,SGD 很容易被困在这里。(会在鞍点或者局部最小点震荡跳动,因为在此点处,如果是训练集全集带入即BGD,则优化会停止不动,如果是mini-batch或者SGD,每次找到的梯度都是不同的,就会发生震荡,来回跳动。),解决方法mometum等

🔥2. 挑战2:SGD对所有参数更新时应用同样的 learning rate,如果我们的数据是稀疏的,我们更希望对出现频率低的特征进行大一点的更新。LR会随着更新的次数逐渐变小。解决方法Ada等

鞍点就是:一个光滑函数的鞍点邻域的曲线,曲面,或超曲面,都位于这点的切线的不同边。例如这个二维图形,像个马鞍:在x-轴方向往上曲,在y-轴方向往下曲,鞍点就是(0,0)。

五、梯度下降拓展

⚠️应对挑战1:如何选学习率LR?

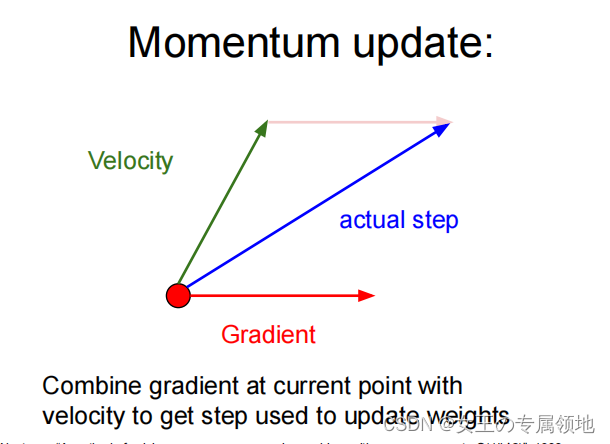

5.1 Momentum

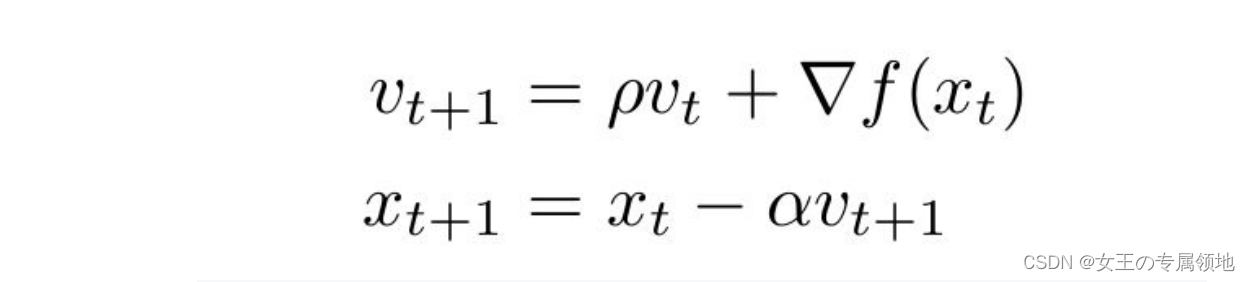

Momentum 通过加入 p v t pv_t pvt ,可以加速 SGD, 并且抑制震荡

当我们将一个小球从山上滚下来时,没有阻力的话,它的动量会越来越大,但是如果遇到了阻力,速度就会变小。加入的这一项,可以使得梯度方向不变的维度上速度变快,梯度方向有所改变的维度上的更新速度变慢,这样就可以加快收敛并减小震荡。

超参数设定值: 一般 p p p 取值 0.9 左右。

缺点:

这种情况相当于小球从山上滚下来时是在盲目地沿着坡滚,如果它能具备一些先知,例如快要上坡时,就知道需要减速了的话,适应性会更好。

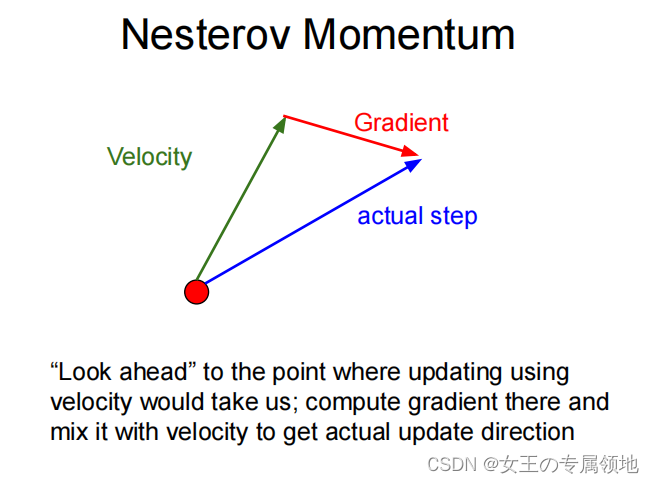

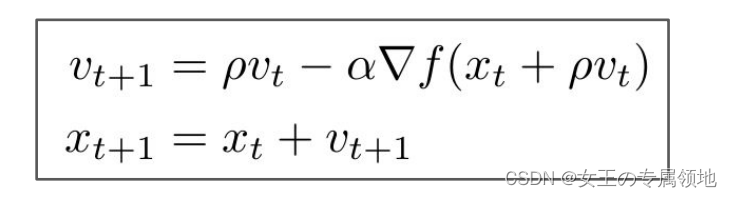

5.2 Nesterov Momentum

梯度更新规则:

用 x t + p v t x_t+pv_t xt+pvt来近似当做参数下一步会变成的值,则在计算梯度时,不是在当前位置,而是未来的位置上,超参数设定值: 一般 p p p仍取值 0.9 左右。

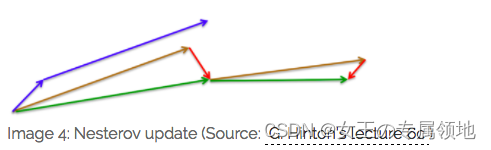

效果比较:

蓝色是 Momentum 的过程,会先计算当前的梯度,然后在更新后的累积梯度后会有一个大的跳跃。而 NAG 会先在前一步的累积梯度上(brown vector)有一个大的跳跃,然后衡量一下梯度做一下修正(red vector),这种预期的更新可以避免我们走的太快。

NAG 可以使 RNN 在很多任务上有更好的表现。

目前为止,我们可以做到,在更新梯度时顺应 loss function 的梯度来调整速度,并且对 SGD 进行加速。

我们还希望可以根据参数的重要性而对不同的参数进行不同程度的更新。

⚠️应对挑战2:如何更新学习率LR?

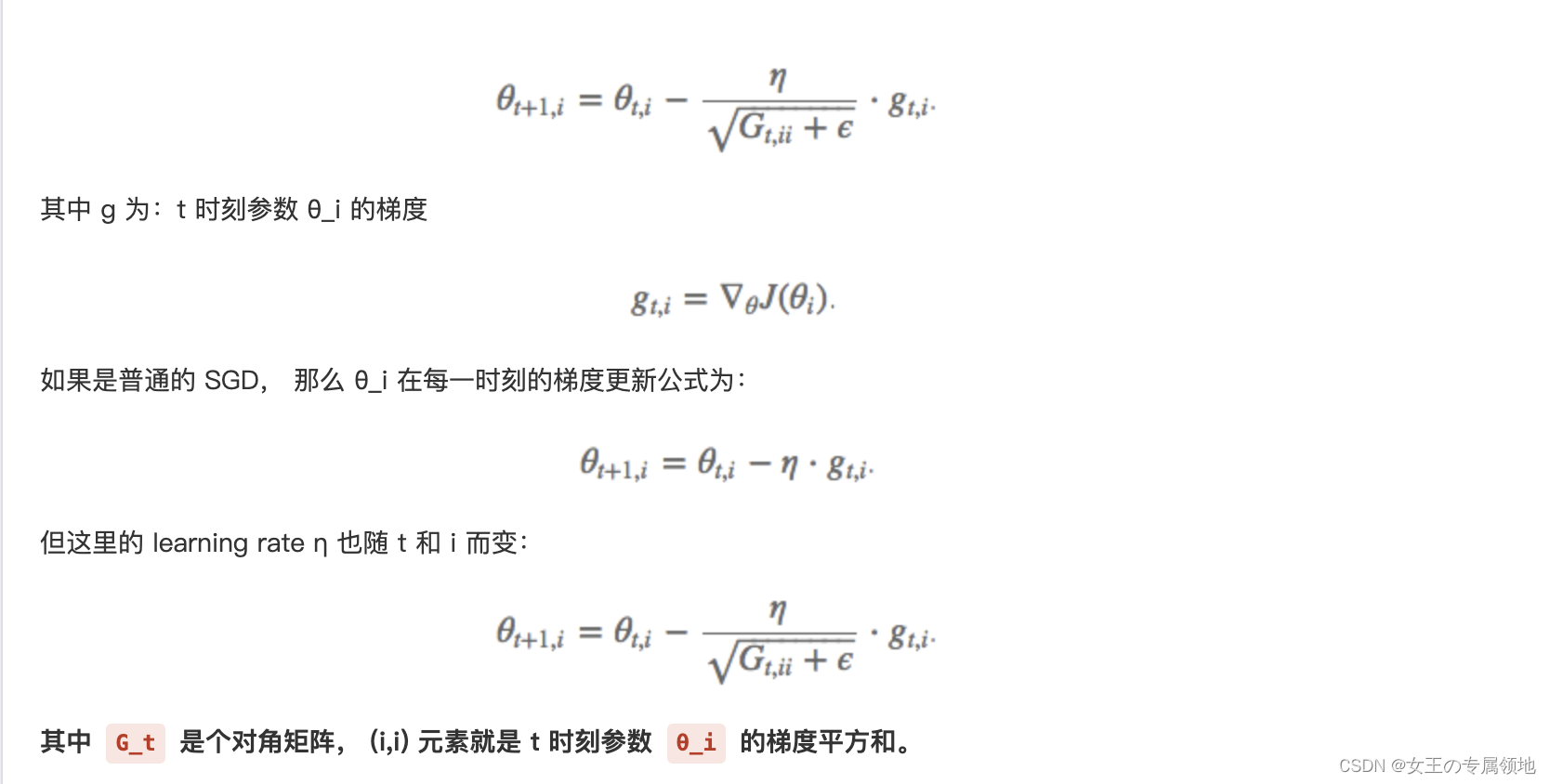

5.4 Adagrad (Adaptive gradient algorithm)

Adagrad 可以对低频的参数做较大的更新,对高频的做较小的更新,也因此,对于稀疏的数据它的表现很好,很好地提高了SGD 的鲁棒性,例如识别 Youtube 视频里面的猫,训练 GloVe word embeddings,因为它们都是需要在低频的特征上有更大的更新。

梯度更新规则:

Adagrad 的优点是减少了学习率的手动调节,超参数设定值:一般η选取0.01

缺点:

它的缺点是分母会不断积累,这样学习率就会收缩并最终会变得非常小。

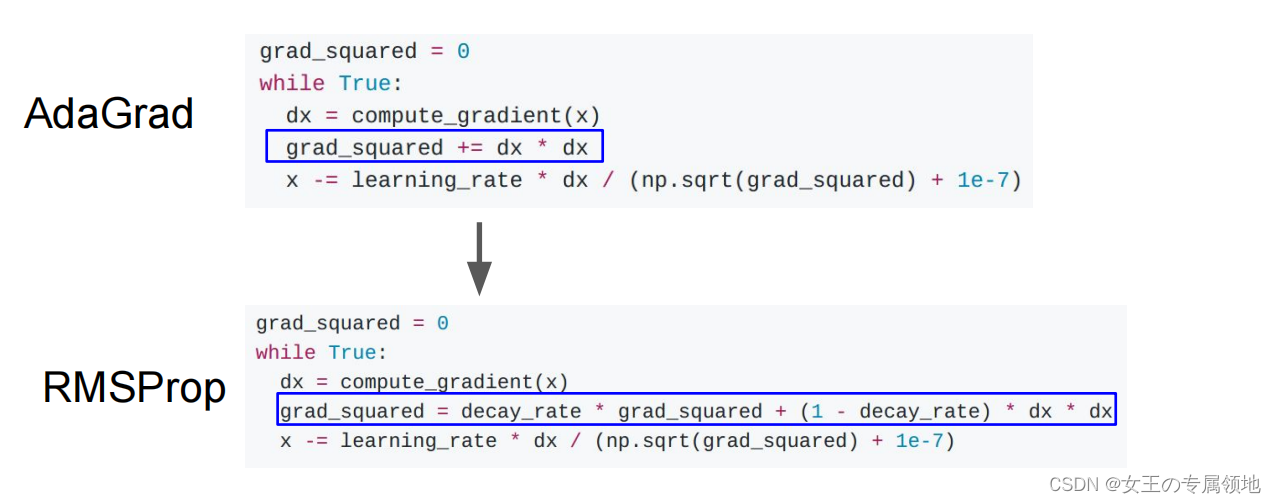

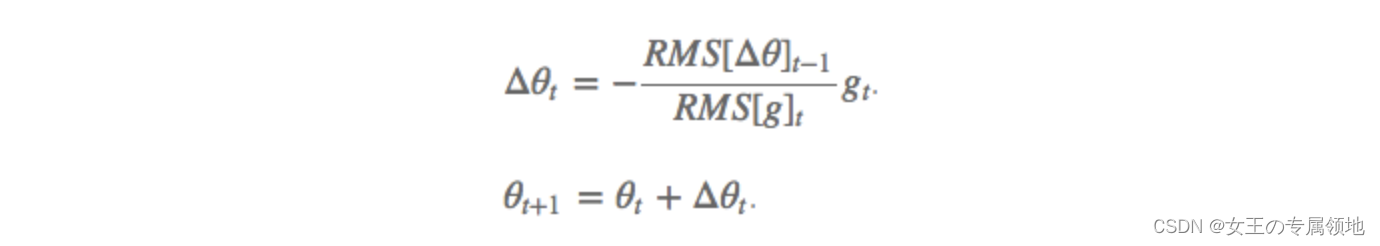

5.5 RMSProp: Leaky AdaGrad

RMSprop 是 Geoff Hinton 提出的一种自适应学习率方法。为了解决 Adagrad 学习率急剧下降问题的,

梯度更新规则:

RMSprop 使用的是指数加权平均,旨在消除梯度下降中的摆动,与Momentum的效果一样,某一维度的导数比较大,则指数加权平均就大,某一维度的导数比较小,则其指数加权平均就小,这样就保证了各维度导数都在一个量级,进而减少了摆动。允许使用一个更大的学习率η)

超参数设定值:Hinton 建议设定 γ 为 0.9, 学习率 η 为 0.001。

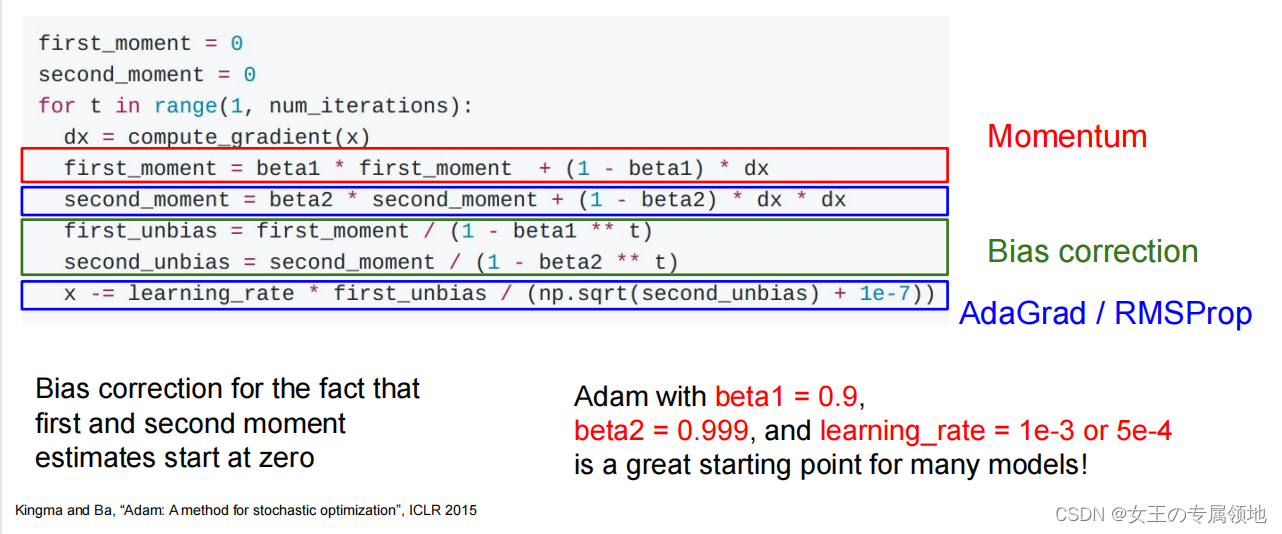

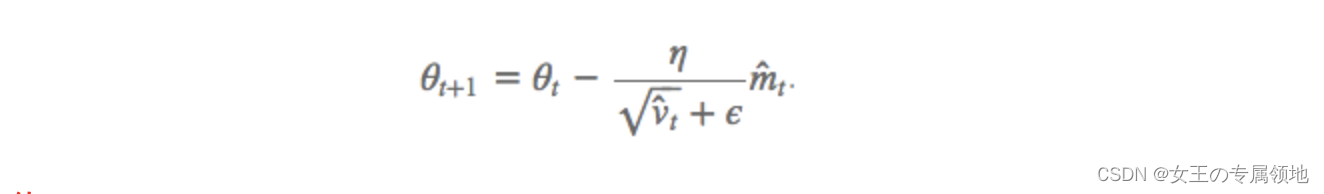

5.6 Adam:Adaptive Moment Estimation

这个算法是另一种计算每个参数的自适应学习率的方法。相当于 RMSprop + Momentum

除了像RMSprop 一样存储了过去梯度的平方 vt 的指数衰减平均值 ,也像 momentum 一样保持了过去梯度 mt 的指数衰减平均值

梯度更新规则:

超参数设定值:建议 β1 = 0.9,β2 = 0.999,ϵ = 10e−8

实践表明,Adam 比其他适应性学习方法效果要好。

效果和总结

上面两种情况都可以看出,Adagrad, Adadelta, RMSprop 几乎很快就找到了正确的方向并前进,收敛速度也相当快,而其它方法要么很慢,要么走了很多弯路才找到。

由图可知自适应学习率方法即 Adagrad, Adadelta, RMSprop, Adam 在这种情景下会更合适而且收敛性更好。

如果数据是稀疏的,就用自适用方法,即 Adagrad, Adadelta, RMSprop, Adam。

RMSprop, Adadelta, Adam 在很多情况下的效果是相似的。

Adam 就是在 RMSprop 的基础上加了 bias-correction 和 momentum,随着梯度变的稀疏,Adam 比 RMSprop 效果会好。

整体来讲,Adam 是最好的选择。

很多论文里都会用 SGD,没有 momentum 等。SGD 虽然能达到极小值,但是比其它算法用的时间长,而且可能会被困在鞍点。如果需要更快的收敛,或者是训练更深更复杂的神经网络,需要用一种自适应的算法。

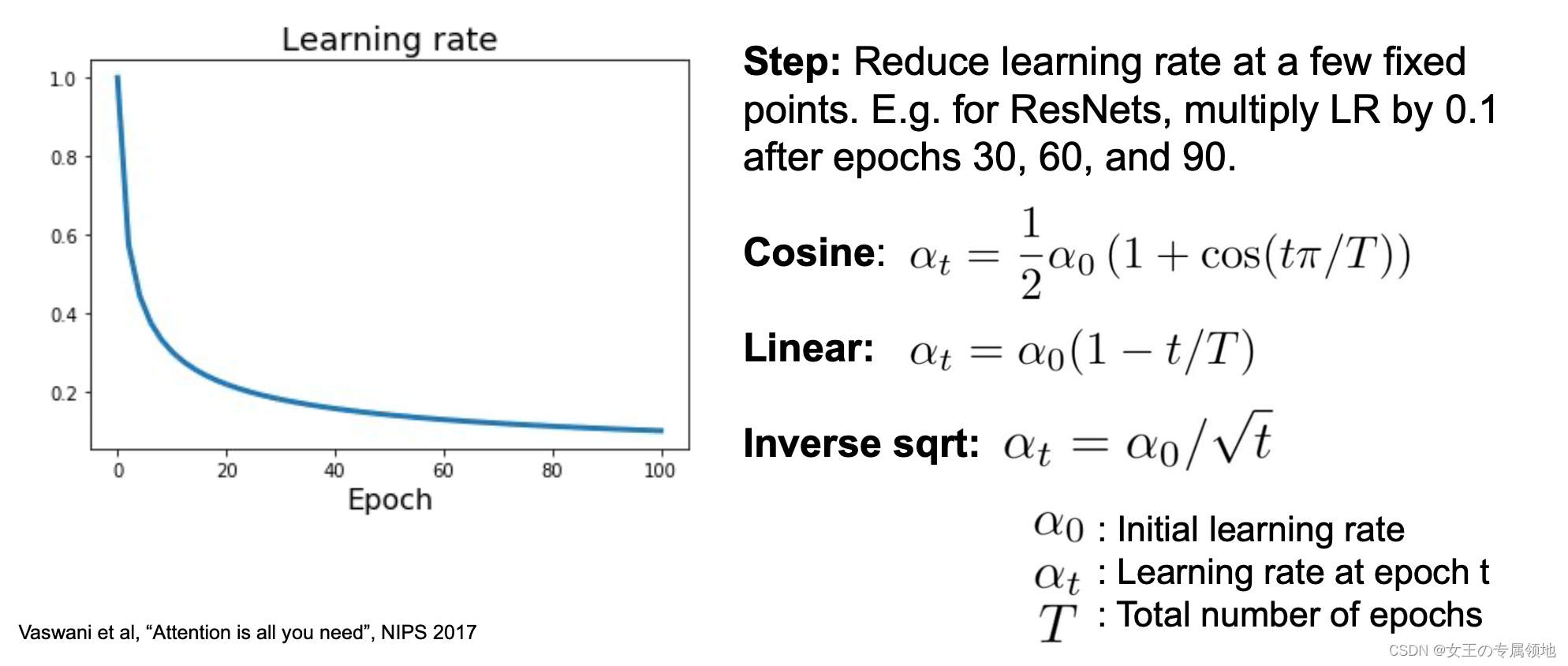

六、学习率(learning rate)

SGD, SGD+Momentum, Adagrad, RMSProp, Adam 都有超参数学习率。学习率 (learning rate),控制 模型的 学习进度。

6.1 作用和影响

用于权重更新: a a a

学习率(learning rate,lr)是在神经网络的训练过程中一个很重要的超参数,对神经网络的训练效果与训练时间成本有很大影响

-

学习率对训练效果的影响

(主要体现在对网络的有效容量/参数搜索空间的影响上):-

学习率过大:导致参数更新步幅过大,迈过了很多候选参数,有可能会越过最优值。因此,从这个意义上讲,过大的学习率会降低模型的有效容量,缩小了神经网络的参数搜索空间。

-

学习率过小:因为神经网络的优化是一个非凸过程,损失函数曲线/超平面上存在许多局部极小值,鞍点,平滑点等。过小的学习率容易导致参数搜索过程中,使网络参数停留在一个很高的局部极小值上,不能继续搜索更好的、更偏向于全局的局部极小值。从这个意义上讲,学习率过小也会降低模型的有效容量。

-

-

学习率对训练时间成本的影响:

-

学习率过大:会导致参数优化过程中损失函数值震荡(或,在最终的极优值两侧来回摆动),导致网络不能收敛。

-

学习率过小:除了会导致训练速度慢以外,还容易导致模型停留在一个训练误差很高的局部极小值上,不利于寻找一个更低的(或更偏向于全局的)局部极小值。

-

在神经网络的训练过程中,常采用的一个策略就是使用学习率更新策略,使学习率随着模型训练的迭代次数逐渐衰减,这样既可以兼顾学习效率又能兼顾后期学习的稳定性:前期通过大学习率快速搜索,找到一个较好的(更倾向于全局最小的)局部区域,后期用较小的学习率在这个局部区域进行收敛。

6.2 衰减机制(更新策略)

不做细讲:https://zhuanlan.zhihu.com/p/525261152

七、资料

- 吴恩达老师的讲解,非常之详尽!!!https://www.showmeai.tech/article-detail/217

- 优化器的比较:https://link.jianshu.com/?t=https://arxiv.org/pdf/1609.04747.pdf

- 优化器算法详解:https://www.cnblogs.com/guoyaohua/p/8542554.html

- 学习率:https://zhuanlan.zhihu.com/p/525261152

这篇关于(2023版)斯坦福CS231n学习笔记:DL与CV教程 (3) | 正则化与最优化的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!