auc专题

推荐系统-排序算法:常用评价指标:NDCG、MAP、MRR、HR、ILS、ROC、AUC、F1等

参考资料: 推荐算法常用评价指标:NDCG、MAP、MRR、HR、ILS、ROC、AUC、F1等 搜索评价指标——NDCG

准确率,召回率,mAP,ROC,AUC,特异性,敏感性,假阴性,假阳性

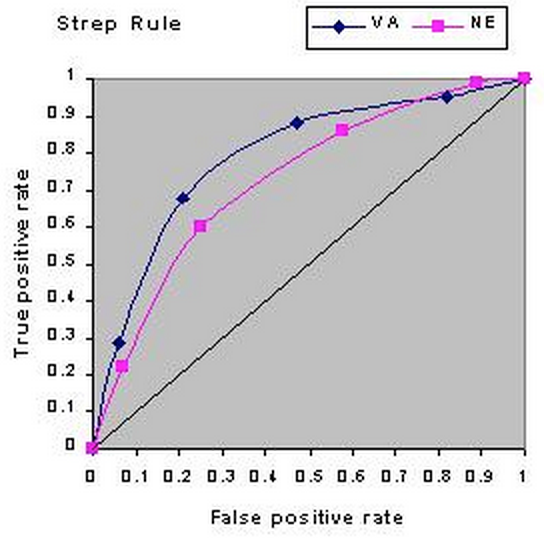

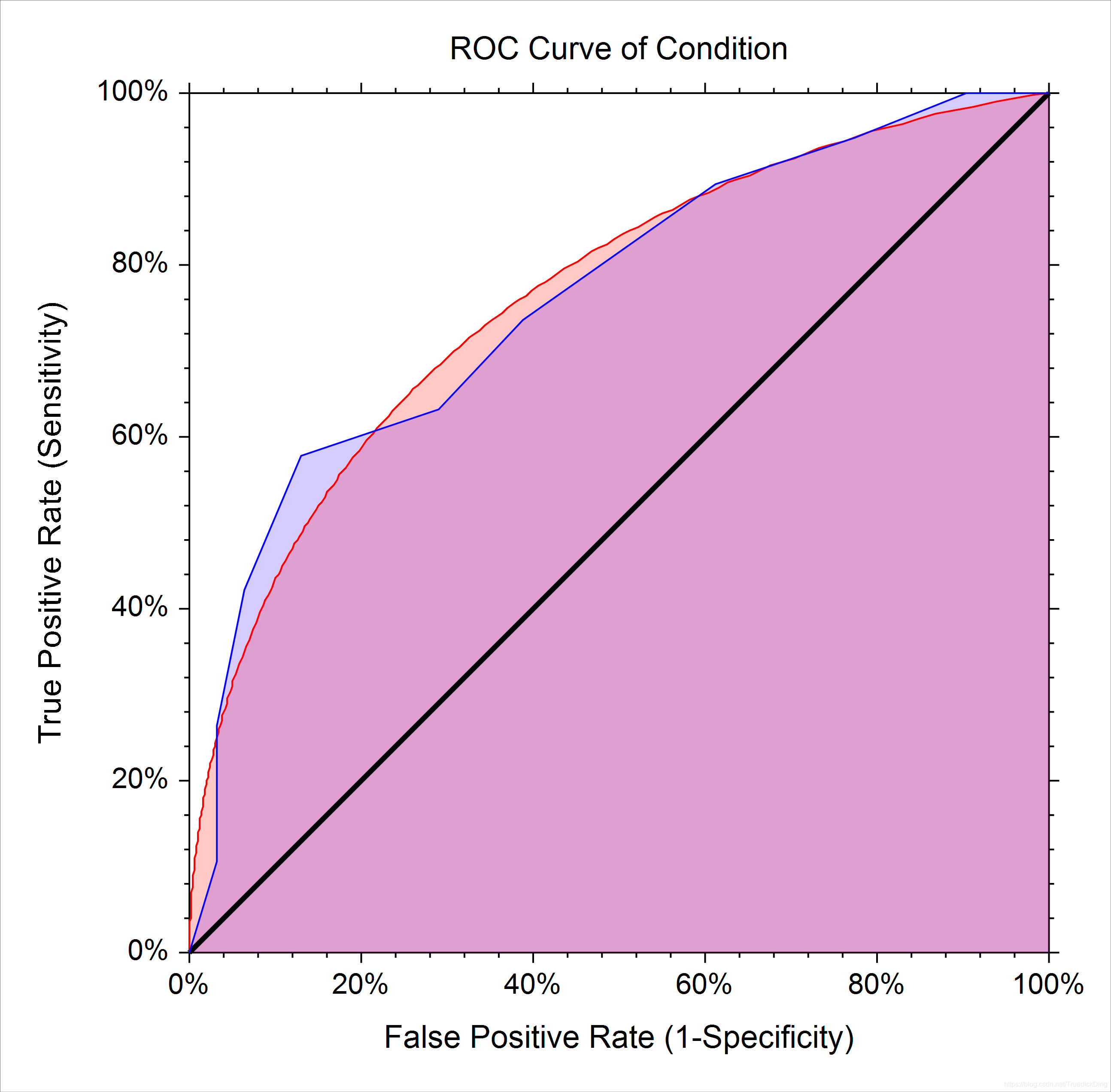

P/R和ROC是两个不同的评价指标和计算方式,一般情况下,检索用准确率、召回率、F1、AP和mAP,分类、识别等用ROC和AUC(特异性和敏感性是ROC当中的一个部分)。 准确率、召回率、F1、AP和mAP这几个指标需要依次看,不然直接看AP和mAP看不明白。而ROC和AUC可以直接看不需要看前面的指标。 PR曲线和ROC曲线上点都是对预测的数据进行划分,首先都是按照置信度排序,而PR

《机器学习》—— AUC评估指标

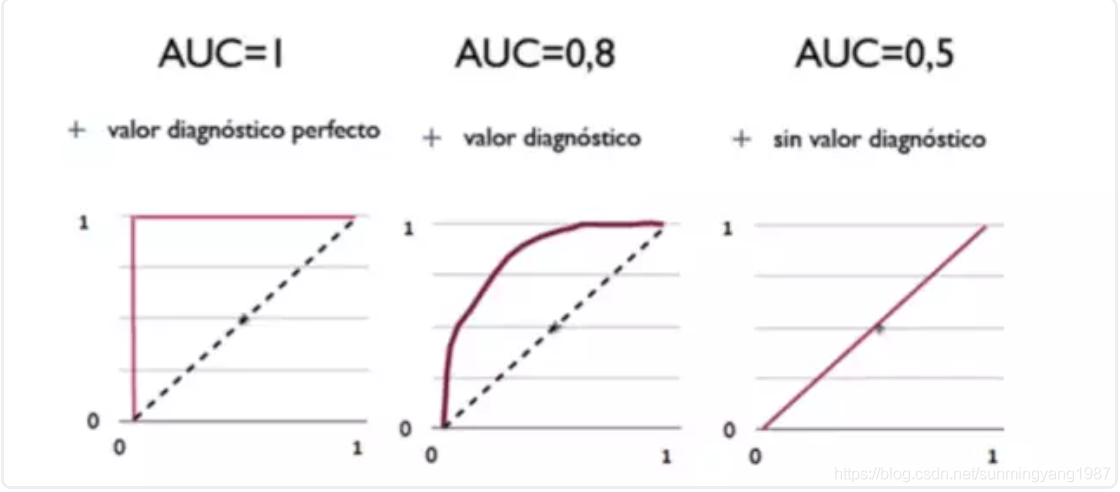

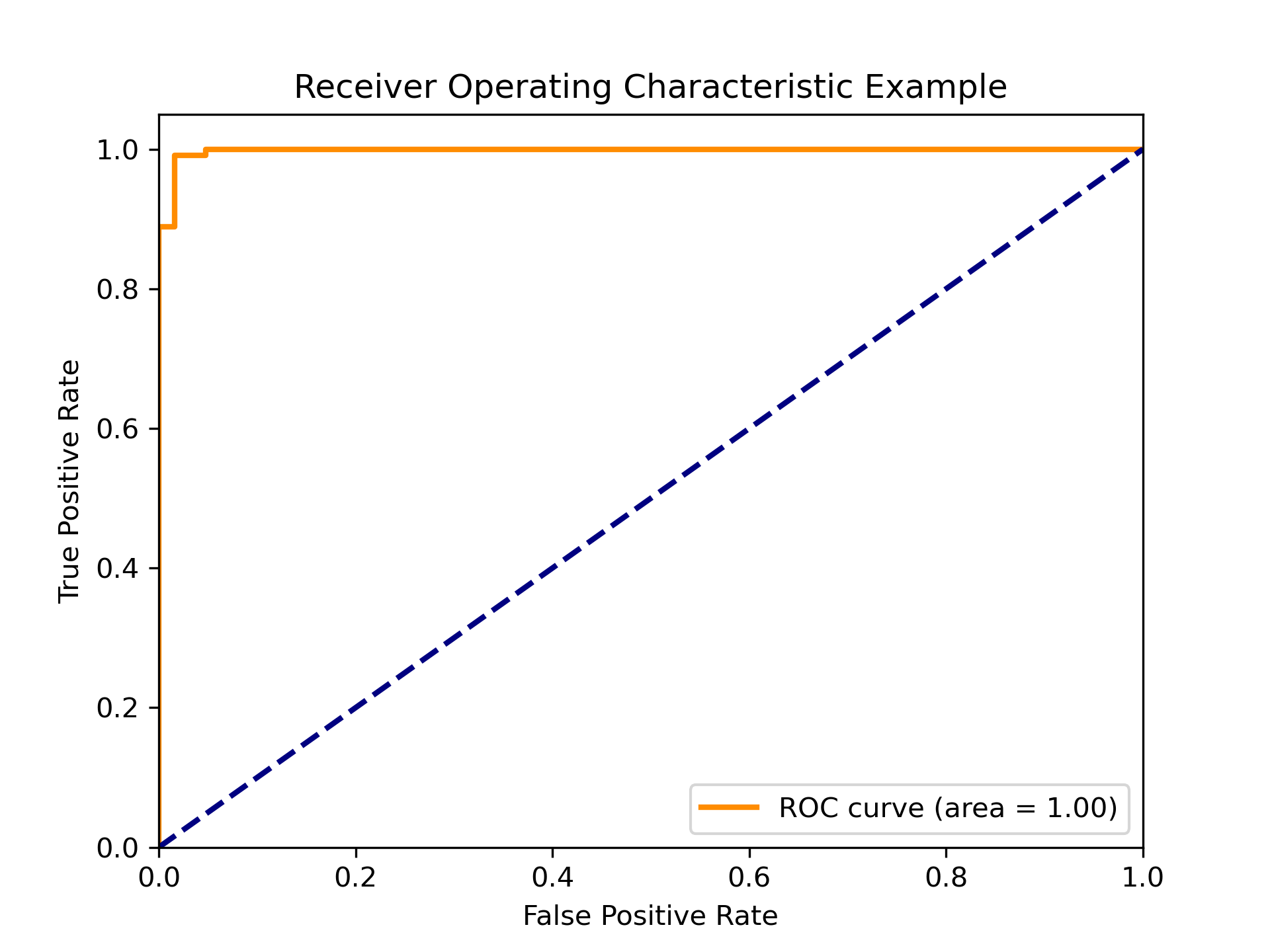

文章目录 一、什么是AUC?1、什么是ROC曲线?2、ROC曲线的绘制 二、如何计算AUC的值三、代码实现AUC值的计算四、AUC的优缺点 一、什么是AUC? 机器学习中的AUC(Area Under the Curve)是一个重要的评估指标,特别是在二分类问题中。AUC特指ROC曲线(Receiver Operating Characteristic Curve)下的面积,用于

真阳率(true positive rate)、假阳率(false positive rate),AUC,ROC

很早以前就知道这些概念了,不过由于跟自己的认知习惯不一样,所以碰到了还是经常会忘。于是索性把这些概念总结一下,以后再忘了也好找(其他的文章太啰嗦了,计算方法也写的不清不楚….) 另外我也会陆续更新一些其他的机器学习相关概念和指标,即是方便自己,也方便他人吧。 注意:本文将混用正负样本和阳性(+)阴性(-)这两套说法 真阳率、假阳率 这些概念其实是从医学那边引入到机器学习里面的,所以其思维逻辑

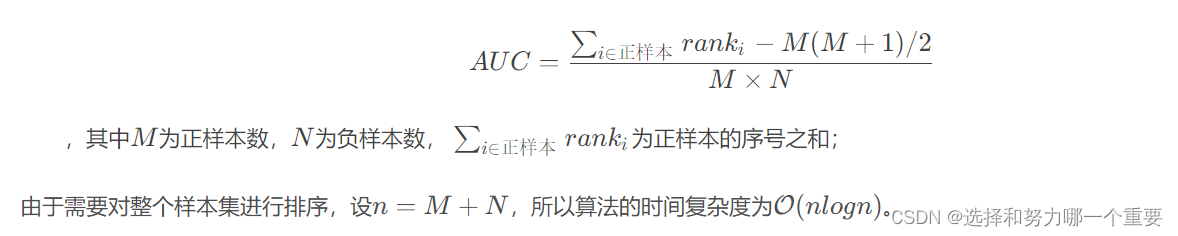

终于把AUC的计算方式搞懂了!

1. 横纵坐标 纵坐标:sensitivity或者TPR 横坐标:FPR 或者 1-Specificity 2. 计算方法 2.1 方法1 def get_roc_auc(y_true, y_score):"""正样本得分大于负样本得分的概率,需要遍历每个正样本和每个负样本1. 选取所有正样本与负样本的两两组合2. 计算正样本预测值pos_score大于负样本预测值neg_sco

ROC曲线和AUC,推荐系统中常用AUC作为排序模型的评估指标

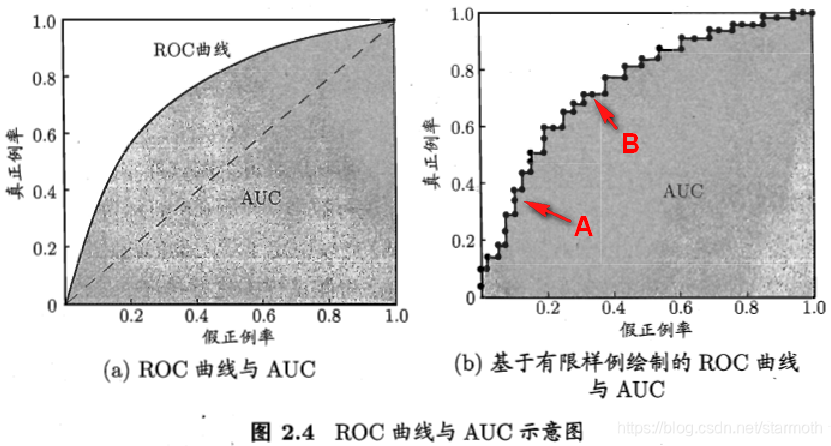

文章目录 1、ROC曲线2、AUC计算及代码 1、ROC曲线 在不同的应用任务中,我们可根据任务需求来采用不同的截断点。如果我们更重视“查准率”,则可选择排序中靠前的位置进行截断;如果更重视“查全率”,则可选择靠后的位置进行截断。 ROC 曲线就是从这个角度出发来研究学习器泛化性能的有力工具。计算TPR和FPR: ROC 曲线的横轴是假正例率 FPR,纵轴是真正例率 TPR

机器学习算法模型评价指标ROC AUC

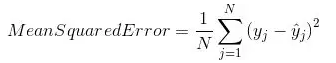

【导读】在机器学习研究或项目中使用分类精度、均方误差这些方法衡量模型的性能。当然,在进行实验的时候,一种或两种衡量指标并不能说明一个模型的好坏,因此我们需要了解常用的几种机器学习算法衡量指标。 本文整理介绍了7种最常用的机器学习算法衡量指标:分类精度、对数损失、混淆矩阵、曲线下面积、F1分数、平均绝对误差、均方误差。相信阅读之后你能对这些指标有系统的理解。 1.分类精度 当我们使用

机器学习笔记(一)ROC与AUC的定义与概念

综述 ROC综述为“受试者工作特征”(Receiver Operation Characteristic),其对于组织分类器和将分类器的性能可视化十分有用。 它最先由二战的电子工程师发明,用于侦测战场上的敌军载具,是信号检测理论的重要组成部分,最近经常用于机器学习和数据挖掘研究,可以用于:(1)选择最优的分类模型(2)在模型中设置最佳阈值 二分类常用公式 首先我们给出真阳性(true pos

[机器学习] 第二章 模型评估与选择 1.ROC、AUC、Precision、Recall、F1_score

准确率(Accuracy) = (TP + TN) / 总样本 =(40 + 10)/100 = 50%。 定义是: 对于给定的测试数据集,分类器正确分类的样本数与总样本数之比。 精确率(Precision) = TP / (TP + FP) = 40/60 = 66.67%。它表示:预测为正的样本中有多少是真正的正样本,它是针对我们预测结果而言的。Precision又称为查准率。 召回率

sklearn【AUC-ROC】原理,以及绘制ROC曲线!

一、AUC-ROC 介绍 在分类任务中,特别是当数据集中的类别分布不平衡时,评估模型的性能变得尤为重要。AUC-ROC(Area Under the Receiver Operating Characteristic Curve,受试者工作特征曲线下的面积)是一种有效的评估指标,能够全面反映模型在不同分类阈值下的性能,并特别适用于不平衡类别的场景。本文将介绍如何使用sklearn库来计算AUC-

机器学习模型评估——P-R曲线、ROC-AUC、偏差方差等

P-R曲线 ①P-R曲线(查准率precision-查全率recall),P和R是一对矛盾的向量,一般呈反比关系, P=TP/(TP+FP),R=TP/(TP+FN)。 ②在P-R曲线中, 可根据面积大小来比较性能的高低, 也可根据平衡点BEP(Break-Even Point 即"P=R"时的取值)来比较性能。 还可根据F1度量比较性能:F1=2PR/(P+R)=2*TP/(样例总数+TP-T

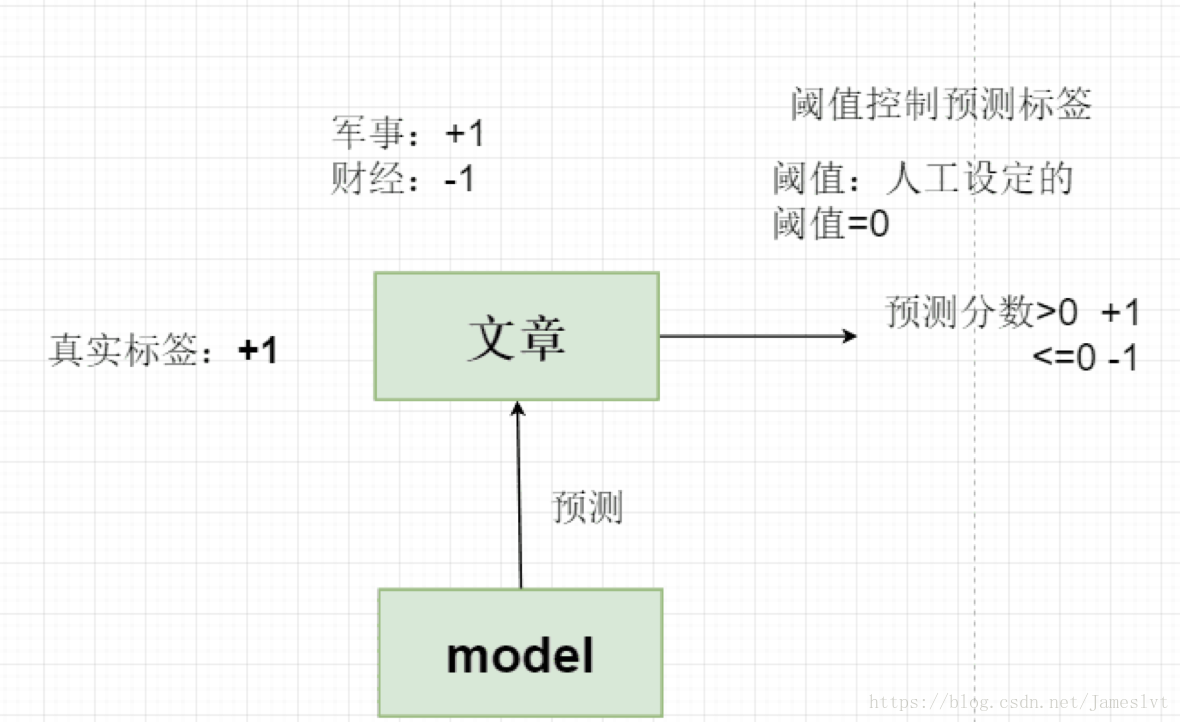

分类算法-NB(NaiveBeyesian Classification)分类器及AUC效果评估

在整个机器学习领域,有很多算法,除了与业务相关的推荐算法,还有分类,回归,聚类算法。其实,回归算法中也有类似分类算法,回归算法在机器学习中就是为了解决分类问题。 至于这个分类模型有什么用,我们在机器学习过程中: 定义一个对象X,将其划分到定义的某个类别Y中,输出是某个类别,例如新闻类,军事类 这里分类我们说一下,分类中有二分类(邮件垃圾邮件)、多分类(网页分类),那么分类算法解决的流程

2.6 如何计算AUC?

2.6 如何计算AUC? 前情提要: 2.4 ROC曲线是什么? 2.5 如何绘制ROC曲线? AUC定义:AUC指的是ROC 曲线下的面积大小,该值能够量化地反映基于ROC曲线衡量出的模型性能。 计算方法:计算AUC值只需要沿着ROC 横轴做积分就可以了。 由于ROC曲线一般都处于y=x这条直线的上方(如果不是的话,只要把模型预测的概率反转成1-p就可以得到一个更好的分类器),所

【机器学习】分类性能度量指标 : ROC曲线、AUC值、正确率、召回率、敏感度、特异度

本文转自 http://zhwhong.ml/2017/04/14/ROC-AUC-Precision-Recall-analysis/ 在分类任务中,人们总是喜欢基于错误率来衡量分类器任务的成功程度。错误率指的是在所有测试样例中错分的样例比例。实际上,这样的度量错误掩盖了样例如何被分错的事实。在机器学习中,有一个普遍适用的称为混淆矩阵(confusion matrix)的工具,它可以帮助人们更

python与机器学习(三)——真正(负)率 / 假正(负)例 / ROC / AUC

读取data.csv文件数据完成: 1.分别计算真正例(TP)、真负例(TN)、假正例(FP)、假负例(FN)数量 2.分别计算各类别(正/负例)的精确率(Precision)、召回率(Recall)、F1值(F1-score) 3.分别计算精确率、召回率、F1-score的宏平均(Macro Average)并且计算准确率(Accuracy) 4.绘制ROC曲线并计算曲线下面积AUC (可使用

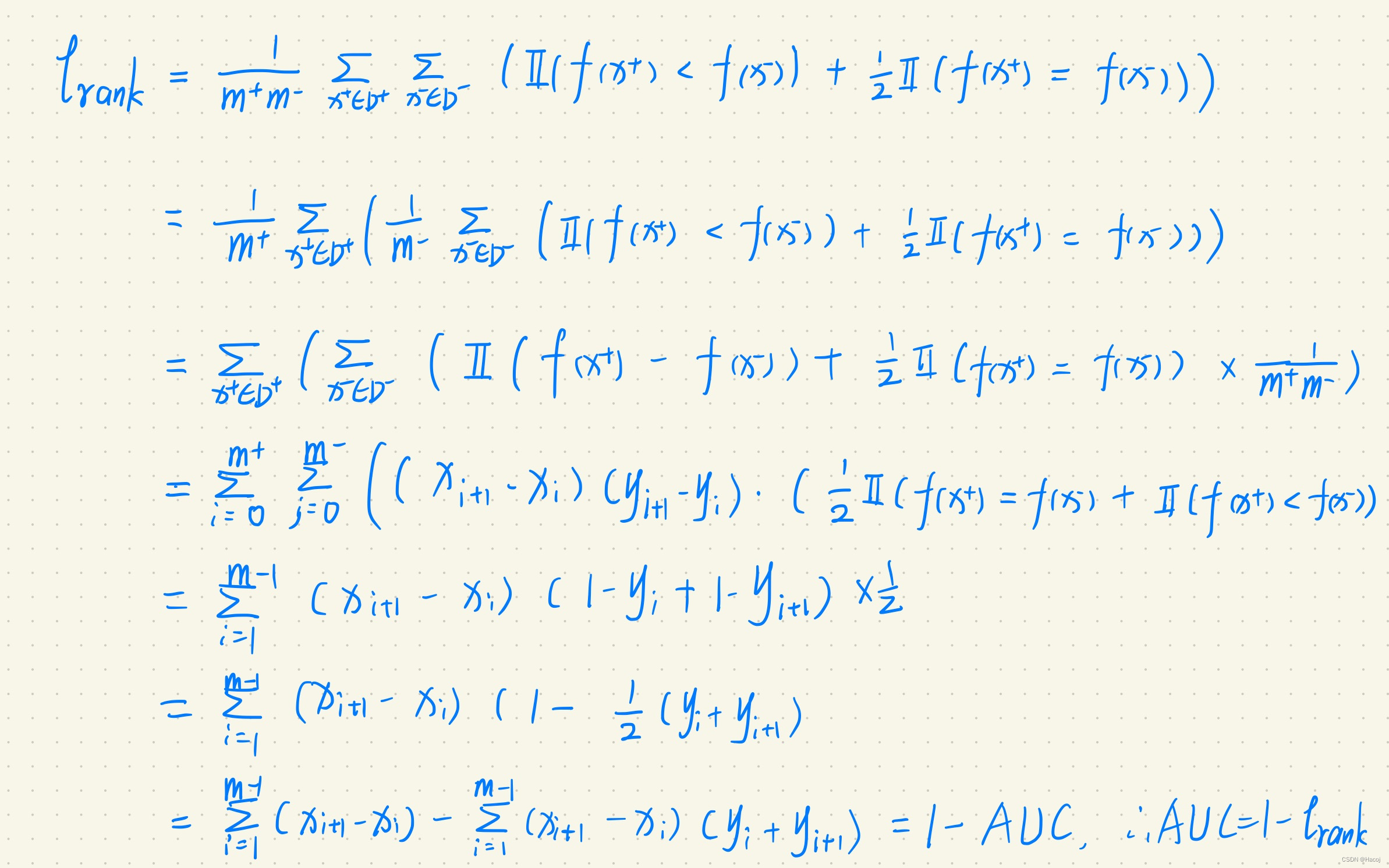

西瓜书机器学习AUC与ℓ-rank(loss)的联系理解以及证明(通俗易懂)

前言 在学习到这部分时,对 ℓ-rank 以及AUC的关系难以理解透彻,在网上看到其他博主也并未弄明白,大家大多写自己的理解,我希望您在看完这篇文章时能够深刻理解这二者的关系,如果我的理解有误,希望您在评论区指正,给出您的见解。 首先理解什么是AUC? 首先理解什么是ROC曲线,ROC曲线如何绘制? ROC曲线,即接收者操作特征曲线(Receiver Operating Character

机器学习中ROC及AUC通俗易懂的解释

ROC(receiver operating characteristic curve):接收者操作特征曲线。 AUC(Area Under Curve):上面曲线与X, Y轴形成的最大面积。 如果你实在不理解ROC的中文注解,那就简单了解一下就行了, 点到为止吧! 步入正题 Step1: ROC 首先告诉你ROC的作用,你就能大概知道这个曲线大概是啥了:它用来衡量你的模型分类结果有多准确。

风控建模 数据对照篇:WOE IV 回归系数 P值 相关系数 共线性指标 膨胀因子 KS AUC GINI PSI

最重要的事情开始都会讲:建模是始终服务于业务的,没有业务的评分卡就没有灵魂 每一个指标段对应的评价如下,就当做各位的参考表数据吧。希望可以对大家有帮助 第一部分 指标图表以及英文简介 第二部分 指标对应参考数据 需要说明的是,由于对应的目标客群不同,可能各个指标所提供标准不同,可能银行和小贷公司对于KS的标准不相同,银行相对严格,小贷公司可能包含其余的策略性规则,因此可能KS相对比较小

PR曲线,ROC曲线,AUC指标等,Accuracy vs Precision

混淆矩阵(Confusion Matrix): PR Precision-Recall曲线,这个东西应该是来源于信息检索中对相关性的评价吧,precision就是你检索出来的结果中,相关的比率;recall就是你检索出来的结果中,相关的结果占数据库中所有相关结果的比率;所以PR曲线要是绘制的话,可以先对decision进行排序,就可以当作一个rank值来用了,然后把分类

[分类指标]准确率、精确率、召回率、F1值、ROC和AUC、MCC马修相关系数

准确率、精确率、召回率、F1值 定义: 1、准确率(Accuracy) 准确率是指分类正确的样本占总样本个数的比例。准确率是针对所有样本的统计量。它被定义为: 准确率能够清晰的判断我们模型的表现,但有一个严重的缺陷: 在正负样本不均衡的情况下,占比大的类别往往会成为影响 Accuracy 的最主要因素,此时的 Accuracy 并不能很好的反映模型的整体情况。 例如,一个测试集

(推荐)彻底理解ROC曲线和AUC值

本文转自:https://mp.weixin.qq.com/s/a-SL1peqyw9eKyjzFthvlA 二分类模型预测的结果是否足够好,ROC和AUC是重要指标。 1. T、F、P、N、R 首先我们先了解这四个概念: T:True,真的 F:False,假的 P:Positive,阳性 N:Negative,阴性 R:Rate,比率,和上面四个没直接关系 比如说看病这个事情:

2020-08-24绘制ROC PR曲线 核心方法总结 ,计算AUC核心方法

#1 绘制ROC AUC PR曲线 #核心方法 roc_curve(y_test, preds) # preds为概率形式 #source code import matplotlib.pyplot as plt plt.figure(figsize=(12,8)) plt.xlabel('False Positive Rate') plt.ylabel('True Pos

从roc曲线到auc

1.为什么我们要用roc曲线进行评价 用传统的识别率来评价模型的话会有下面的缺陷: 在类不平衡的情况下, 如正样本90个,负样本10个,直接把所有样本分类为正样本,得到识别率为90% 而如果正样本识别对75个,负样本识别对5个,得到的识别率为80%。 但是这样的识别率评价指标导致高分模型不具有鲁棒性(即该模型在类别平衡下表现不好) 所以我们要换一种评价指标就有了roc曲线 2.那么roc曲线

此AUC非彼AUC —— 药时曲线下面积

好久不见!!!因为我又火烧眉毛了一阵子!一言难尽呐!!! 祝大家一切顺利!诶!加个祝福!祝大家新的一年富得牛油!!!!! 希望我以后可以规律更新!!!!! 那这个AUC到底代表什么嘞!快来跟我一起看看吧!!! 定义 在药物动力学中,AUC(area under the plasma concentration-time curve),也就是药时曲线下面积,通常指的是药物在体内浓度与时间

![[机器学习] 第二章 模型评估与选择 1.ROC、AUC、Precision、Recall、F1_score](https://img-blog.csdnimg.cn/20210418025501926.png?x-oss-process=image/watermark,type_ZmFuZ3poZW5naGVpdGk,shadow_10,text_aHR0cHM6Ly9ibG9nLmNzZG4ubmV0L1RyYW5jZTk1,size_16,color_FFFFFF,t_70)

![[分类指标]准确率、精确率、召回率、F1值、ROC和AUC、MCC马修相关系数](https://img-blog.csdnimg.cn/direct/ec34e11aee0b42db8b8a119319207bb4.png)