本文主要是介绍PR曲线,ROC曲线,AUC指标等,Accuracy vs Precision,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

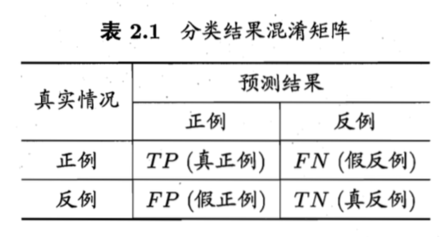

混淆矩阵(Confusion Matrix):

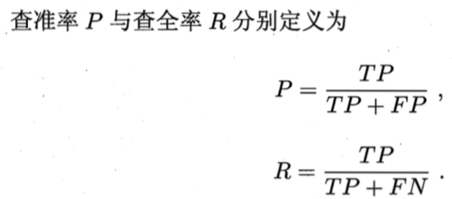

PR

Precision-Recall曲线,这个东西应该是来源于信息检索中对相关性的评价吧,precision就是你检索出来的结果中,相关的比率;recall就是你检索出来的结果中,相关的结果占数据库中所有相关结果的比率;所以PR曲线要是绘制的话,可以先对decision进行排序,就可以当作一个rank值来用了,然后把分类问题看作检索问题,当返回一个结果的时候的PR pair是多少(R肯定接近0,P理论上接近1),2个、3个、一直到你所有的检测样本都包含;所以假设你的测试样本有100个,是不是会返回100个precision-recall点呢?然后把这些点绘制出来,就得到了PR曲线;

所以,PR曲线的采点是按照样本的数量采的。注意,这一条PR曲线的绘制只对应一个p_0值(也就是下面说的分类阈值,当回归结果高于这个阈值时判定为正类),所以往往先选择最优的p_0,再绘制不同model的PR曲线,比较model的优劣。

ROC

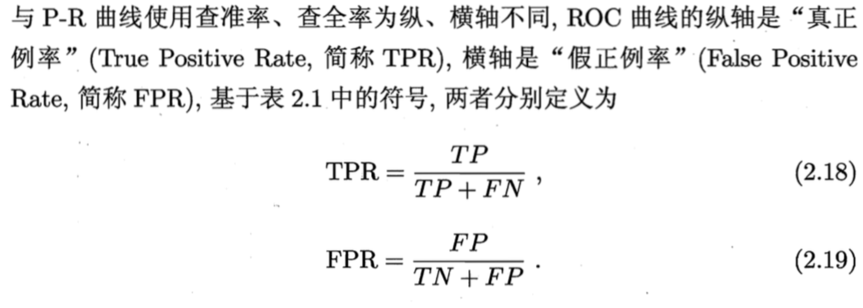

receiver operating characteristic curve

要看ROC的原理,总离不开上面这个表格,ROC绘制的就是在不同的阈值p_0(同上面的分类阈值)下,TPR和FPR的点图。所以ROC曲线的点是由不同的p_0所造成的。所以你绘图的时候,就用不同的p_0采点就行。

可以看出TPR和Recall的形式是一样的,就是查全率了,FPR就是保证这样的查全率你所要付出的代价,就是把多少负样本也分成了正的了。

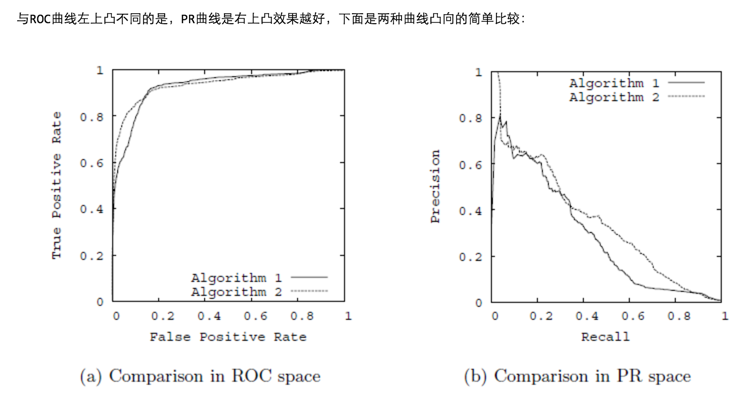

对比PR图和ROC图

AUC

Area Under Curve

AUC就是ROC曲线下方的面积。可以知道,TPR越大的情况下,FPR始终很小,才是好的,那么这条曲线就是很靠近纵轴的曲线,那么下方面积就大。所以AUC越大越好。

意义:

通过ROC曲线,也能够在查全率和查准率之间做一个平衡,分类时候来选择出最好的p_0阈值;

而即使不需要二分类选阈值,比如LR回归,不把阈值作为点击或者不点击的区分标准,而是作为排序的一个因子,AUC也能够起到很好的参考意义。AUC面积越大,说明算法和模型准确率越高越好。

在比较两种学习器的时候,如果一个被另一个完全包住,那么大的那个好。如果两个有交叉,一般而言,面积大的那个好。当然不排除有具体的案例,需要根据代价敏感性(对于查全查准)的特殊需求,来比较。

Accuracy 和 Precision的区别

如果硬要区分 Accuracy 和 Precision,

那么 Accuracy就是 (TP+TN)/P+N,也就是所有正确的;

而Precision不是,P指的是 TP/(TP+FP),也就是预测成正例的情况,有多少比例是真的正例。

这篇关于PR曲线,ROC曲线,AUC指标等,Accuracy vs Precision的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!