autoencoder专题

LSTM-Autoencoder深度学习模型在电动机异常检测中的应用

LSTM-Autoencoder深度学习模型在电动机异常检测中的应用 LSTM-Autoencoder Deep Learning Model for Anomaly Detection in Electric Motor Citation: Lachekhab, F.; Benzaoui, M.; Tadjer, S.A.; Bensmaine, A.; Hamma, H. LSTM-Aut

变分自编码器(Variational Autoencoder, VAE):深入理解与应用

变分自编码器(Variational Autoencoder, VAE):深入理解与应用 在深度学习的广阔领域中,生成模型一直是研究的热点之一。其中,VAE(变分自编码器)作为AE(自编码器)的一种扩展,以其独特的优势在生成任务中展现了卓越的性能。本文将深入探讨VAE相对于AE的改进之处,并解析这些改进如何提升模型的生成能力和泛化性能。 一、引言 自编码器(Autoencoder, AE

Autoencoder(AE)、Variational Autoencoder(VAE)和Diffusion Models(DM)了解

Autoencoder (AE) 工作原理: Autoencoder就像一个数据压缩机器。它由两部分组成: 编码器:将输入数据压缩成一个小小的代码。解码器:将这个小代码还原成尽可能接近原始输入的数据。 优点和应用: 简单易懂:用于学习数据的特征和去除噪声。应用场景:例如可以用来缩小图像的大小但保留关键特征,或者去除文本数据中的错误。 挑战: 数据损坏:如果输入数据太乱,编码器可能无法有

Autoencorder理解(7):Variational Autoencoder

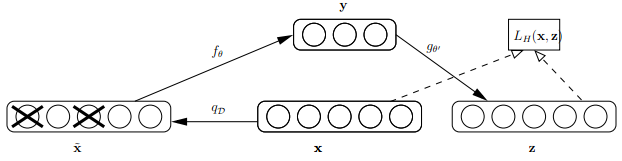

以下将分为6个部分介绍: vae结构框架vae与ae区别提及一下为什么要采样如何优化vae应用vae生成/抽象看待vae学习 1.框架: 先来看一下VAE的结构框架,并先预告一下结论: VAE 包括 encoder (模块 1)和 decoder(模块 4) 两个神经网络。两者通过模块 2、3 连接成一个大网络。利益于 reparemeterization 技巧,我们可以使用常规

自编码器(AutoEncoder)入门及TensorFlow实现

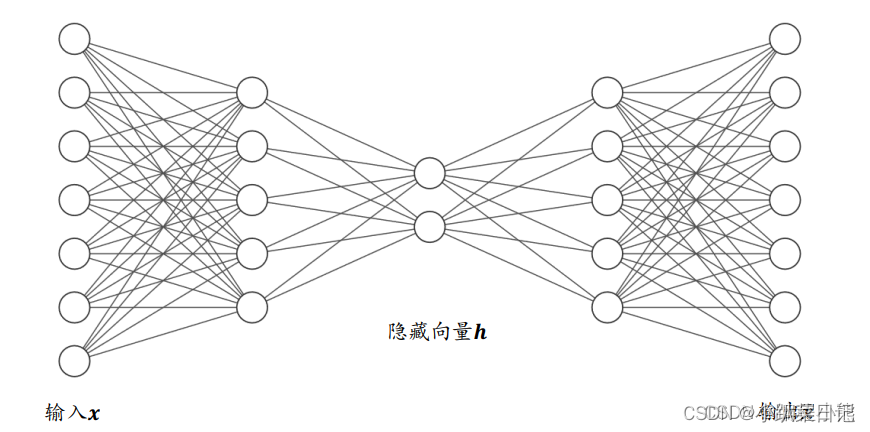

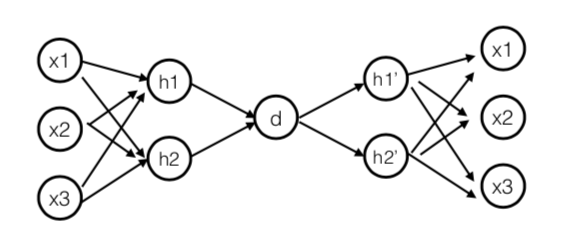

自编码器(Autoencoder,AE),是一种利用反向传播算法使得输出值等于输入值的神经网络,它先将输入压缩成潜在空间表征,然后通过这种表征来重构输出。 自编码器由两部分组成: 编码器(encoder):这部分能将输入压缩成潜在空间表征,可以用编码函数h=f(x)表示。 解码器(decoder):这部分重构来自潜在空间表征的输入,可以用解码函数r=g(h)表示。 因此,整个自编码器可以用

变分自编码器(Variational Autoencoder, VAE)

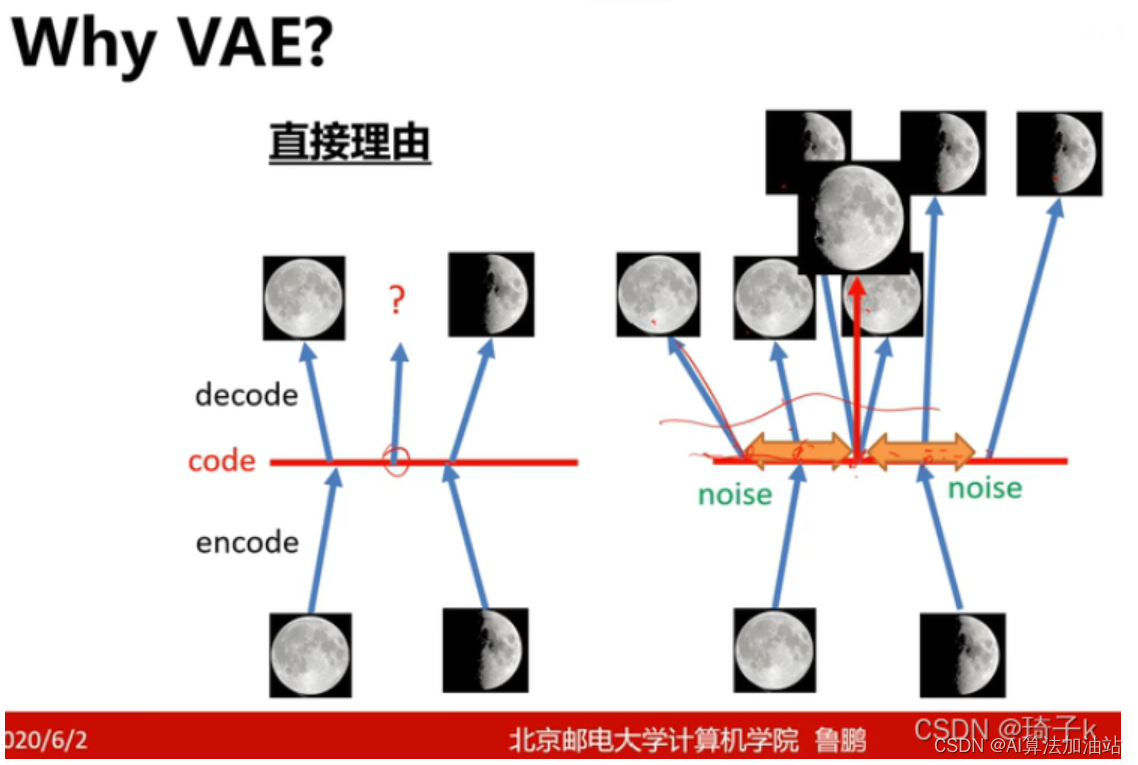

目录 why VAE: 关于变分自编码器,这篇文章讲的不错 1. 自编码器(Autoencoder)的基础 2. 引入概率图模型 3. 重参数化技巧 4. 损失函数 5. 应用 变分自编码器(Variational Autoencoder, VAE) why VAE: 关于变分自编码器,这篇文章讲的不错 机器学习方法—优雅的模型(一):变分自编码器(VAE

深度学习之autoEncoder

1)autoencoder autoencoder是一种无监督的学习算法,他利用反向传播算法,让目标值等于输入值。如图所示: Autoencoder尝试学习一个 的函数。也就是说autoencoder尝试逼近一个恒等函数,使得输出接近于输入 。当然为了使这个函数有意义,需要加入一些限制条件(比如说限制隐藏神经元的数目),就可以发现一些有意义的结构。Autoencoder可

Tensorflow - Tutorial (5) : 降噪自动编码器(Denoising Autoencoder)

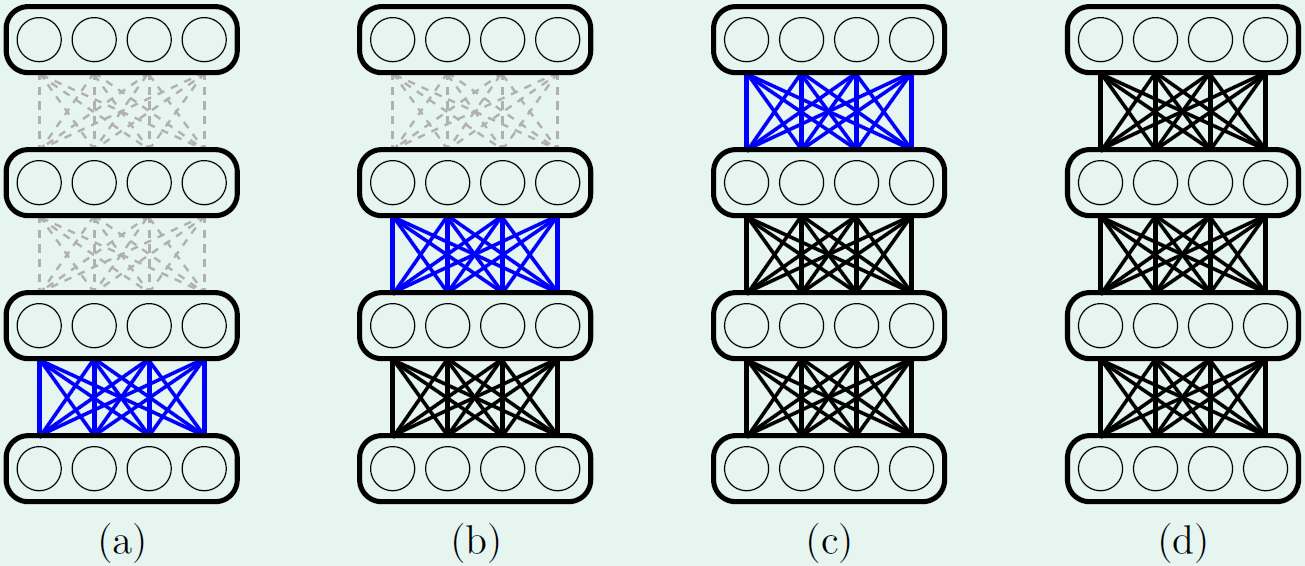

1. Denoising Autoencoder 在神经网络模型训练阶段开始前,通过Autoencoder对模型进行预训练可确定编码器 W W的初始参数值。然而,受模型复杂度、训练集数据量以及数据噪音等问题的影响,通过Autoencoder得到的初始模型往往存在过拟合的风险。关于Autoencoder的介绍请参考:自动编码器(Autoencoder)。在介绍Denoising Autoencod

自动编码器(Autoencoder)

Autoencoder autoencoder是一种无监督的学习算法,主要用于数据的降维或者特征的抽取,在深度学习中,autoencoder可用于在训练阶段开始前,确定权重矩阵 W W的初始值。神经网络中的权重矩阵WW可看作是对输入的数据进行特征转换,即先将数据编码为另一种形式,然后在此基础上进行一系列学习。然而,在对权重初始化时,我们并不知道初始的权重值在训练时会起到怎样的作用,也不知道在训练

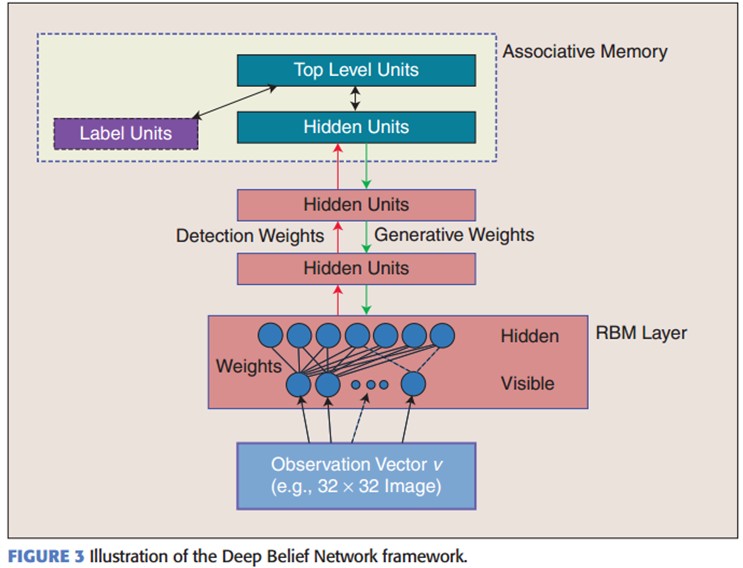

AutoEncoder、RBM、DBM、DBN初探

转自牛人博客:http://blog.csdn.net/zouxy09/article/details/8775524 AutoEncoder自动编码器 Deep Learning最简单的一种方法是利用人工神经网络的特点,人工神经网络(ANN)本身就是具有层次结构的系统,如果给定一个神经网络,我们假设其输出与输入是相同的,然后训练调整其参数,得到每一层中的权重。自然地,我

【神经网络】AutoEncoder自编码器

1.基本功能 \qquad自编码器最大的特点是输入与输出的节点数是一致的,其功能并不是进行分类或者是回归预测,而是将原始数据转换为一种特殊的特征表示方式,在训练的过程中,依然采用反向传播算法进行参数优化,目标函数为使输出与输入之间的误差最小化。 \qquad基本功能如图,如图所示,普通神经网络是训练类别(或者离散值)与输入之间的映射关系,而AutoEncoder是将input通过e

【Deep Learning】Variational Autoencoder ELBO:优美的数学推导

Variational Autoencoder In this note, we talk about the generation model, where x x x represents the given dataset, z z z represents the latent variable, θ , ϕ \theta,\phi θ,ϕ denote the parameter

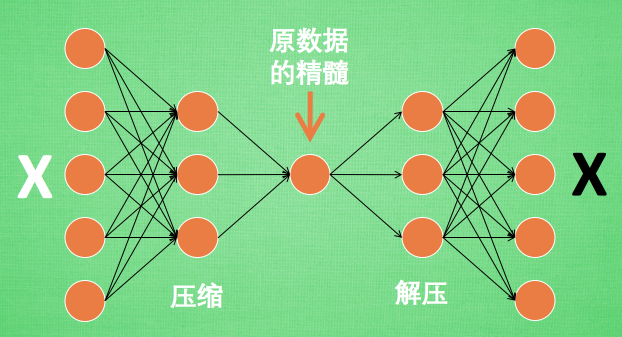

autoencoder 的压缩与解压

压缩与解压 ¶ 有一个神经网络, 它在做的事情是 接收一张图片, 然后 给它打码, 最后 再从打码后的图片中还原. 太抽象啦? 行, 我们再具体点. 假设刚刚那个神经网络是这样, 对应上刚刚的图片, 可以看出图片其实是经过了压缩,再解压的这一道工序. 当压缩的时候, 原有的图片质量被缩减, 解压时用信息量小却包含了所有关键信息的文件恢复出原本的图片. 为什么要这样做呢? 原来有时

自编码器(Autoencoder, AE)

自编码器(Autoencoder, AE)是一种无监督学习算法,它利用神经网络来学习数据的高效表示(即编码)。自编码器的目标是能够通过输入数据学习到一个压缩的、分布式的表示,然后通过这种表示重构出原始数据。自编码器主要由两部分组成:编码器(Encoder)和解码器(Decoder)。 编码器(Encoder) 编码器的作用是将输入数据转换为一个内部表示,这个表示通常是一个低维空间中的点。这个过

tensorflow1.1/variational_autoencoder

环境tensorflow1.1,matplotlib2.02,python3 近年,非监督学习成为了研究热点。VAE(Variational Auto-Encoder,变分自编码器)和 GAN(Generative Adversarial Networks) 等模型,受到越来越多的关注 VAE:模型结构: 其中:loss = mse+KLDivergence #coding:utf-8

案例系列:银行信用卡欺诈_预测是否欺诈_ 自编码器AutoEncoder二分类

案例系列:银行信用卡欺诈_预测是否欺诈_ 自编码器AutoEncoder二分类 代码: https://download.csdn.net/download/wjjc1017/88641713 简介 按照定义,机器学习可以被定义为从数据集中学习最佳和最相关的模式、关系或关联的复杂过程,这些可以用来预测未知数据的结果。广义上讲,存在三种不同的机器学习过程: 1. 监督学习 是在一个带有标签

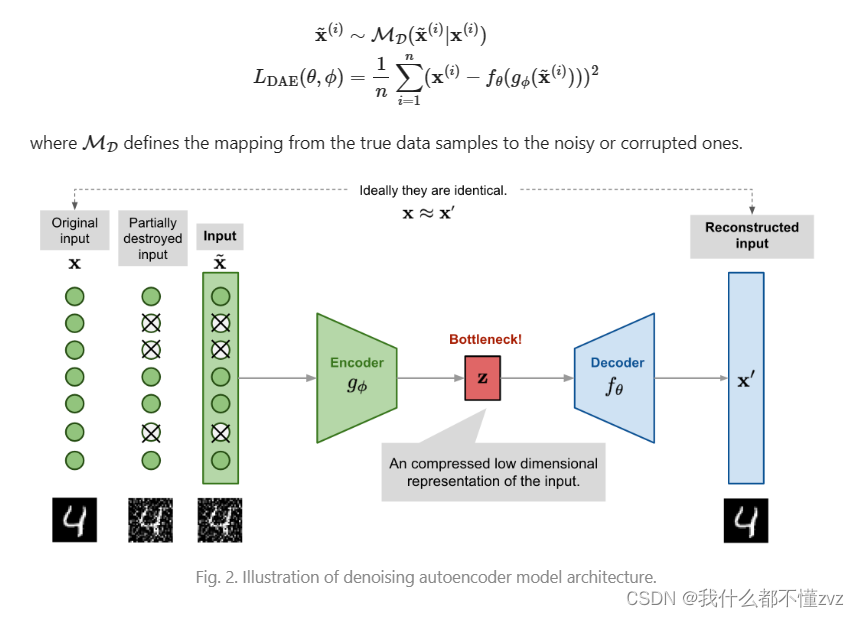

AutoEncoder和 Denoising AutoEncoder学习笔记

参考: 【1】 https://lilianweng.github.io/posts/2018-08-12-vae/ 写在前面: 只是直觉上的认识,并没有数学推导。后面会写一篇(抄)大一统文章(概率角度理解为什么AE要选择MSE Loss) TOC 1 AutoEncoder2 Denoising AutoEncoder 1 AutoEncoder AE实际上是一个压缩模型,

论文Deep Autoencoder的框架(由CNN组成的VAE)

autoencoder可以用于数据压缩、降维,预训练神经网络,生成数据等等。 autoencoder的架构 autoencoder的架构是这样的: 需要分别训练一个Encoder和一个Decoder。 比如,一张数字图片784维,放入Encoder进行压缩,编程code,通常要小于原来的784维; 然后可以将压缩后的code,放入Decoder进行reconsturct,产生和原来相

[异常检测]Memorizing Normality to Detect Anomaly: Memory-augmented Deep Autoencoder for Unsupervised

源码地址:https://github.com/donggong1/memae-anomaly-detection 问题提出 ''It has been observed that sometimes the autoencoder “generalizes” so well that it can also reconstruct anomalies well, leading to the

降噪自动编码机 Denoising Autoencoder

自动编码机(Auto-encoder)属于非监督学习,不需要对训练样本进行标记。自动编码机(Auto-encoder)由三层网络组成,其中输入层神经元数量与输出层神经元数量相等,中间层神经元数量少于输入层和输出层。在网络训练期间,对每个训练样本,经过网络会在输出层产生一个新的信号,网络学习的目的就是使输出信号与输入信号尽量相似。自动编码机(Auto-encoder)训练结束之后,其可以由两部分组成

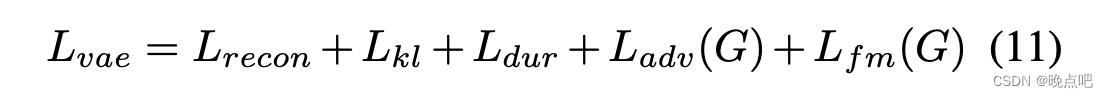

VITS(Conditional Variational Autoencoder with Adversarial Learning)论文解读及实现(一)

此篇为VITS论文解读第一部份 论文地址Conditional Variational Autoencoder with Adversarial Learning for End-to-End Text-to-Speech模型使用了VAE,GAN,FLOW以及transorflomer(文本处理有用到),即除了未diffusion模型,将生成式模型都融入进来了,是一篇集大成的文章。涉及的知识点和公

AutoEncoder个人记录

原理 最常见的降维算法有主成分分析法PCA,通过对协方差矩阵进行特征分解而得到数据的主要成分,但是 PCA 本质上是一种线性变换,提取特征的能力极为有限。 AutoEncoder把长度为d_in输入特征向量变换到长度为d_out的输出向量,借助于深层神经网络的非线性特征提取能力, 自编码器可以获得良好的数据表示,甚至可以更加完美的恢复出输入𝒙。 Encode

PyTorch深度学习实战(26)——卷积自编码器(Convolutional Autoencoder)

PyTorch深度学习实战(26)——卷积自编码器 0. 前言1. 卷积自编码器2. 使用 t-SNE 对相似图像进行分组小结系列链接 0. 前言 我们已经学习了自编码器 (AutoEncoder) 的原理,并使用 PyTorch 搭建了全连接自编码器,但我们使用的数据集较为简单,每张图像只有一个通道(每张图像都为黑白图像)且图像相对较小 (28 x 28)。但在现实场景中,图

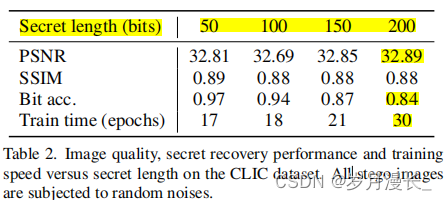

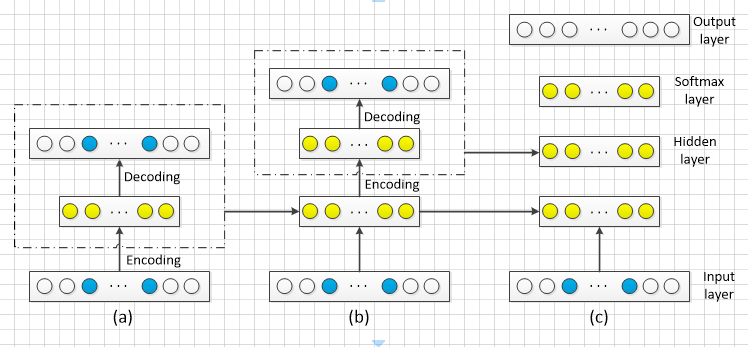

【论文阅读】RoSteALS: Robust Steganography using Autoencoder Latent Space-2023-CVPR

摘要 RoSteALS使用一个轻量级的秘密编码器将秘密信息映射到图像的潜空间中,并通过对潜空间进行微小的偏移来嵌入秘密信息。 该方法使用预训练的自编码器作为基础模型,不需要学习图像分布,因此训练过程简单且效果良好。 方法 架构图:训练期间只更新秘密编码器和秘密解码器,图像的编码器和解码器是锁定的 说明 使用自编码器VQGAN 利用编码器将秘密信息映射到图像的潜在层中, 使用Res50作

sparse Autoencoder(3)---自编码算法与稀疏性

参考自:UFLDL 目前为止,我们已经讨论了神经网络在有监督学习中的应用。在有监督学习中,训练样本是有类别标签的。现在假设我们只有一个没有带类别标签的训练样本集合 ,其中 。自编码神经网络是一种无监督学习算法,它使用了反向传播算法,并让目标值等于输入值,比如 。下图是一个自编码神经网络的示例。

自编码器 AutoEncoder

自编码器(AutoEncoder),也称自编码模型,是一种基于无监督学习的数据维度压缩和特征表示方法,目的是对一组数据学习出一种表示。1986年 Rumelhart 提出自编码模型用于高维复杂数据的降维。由于自动编码器通常应用于无监督学习,所以不需要对训练样本进行标记。自动编码器在图像重构、聚类、降维、自然语言翻译等方面应用广泛。 1. 数据表示 数据表示(Data Representatio

![[异常检测]Memorizing Normality to Detect Anomaly: Memory-augmented Deep Autoencoder for Unsupervised](https://img-blog.csdnimg.cn/abdd90d6d6654884ab23b9e8880c52f1.png)