exploration专题

【HDU】5222 Exploration(并查集+拓扑排序)

对于无向边使用并查集合并成一个集合,对于有向边使用判断是否存在环 唯一无语的地方就是看输入是百万级的,加个输入挂跑9s,不加挂跑了5s #include<cstdio>#include<cstring>#include<vector>#include<algorithm>using namespace std;#pragma comment(linker, "/STACK:102

784 - Maze Exploration(bfs)

题目:784 - Maze Exploration 题目大意:类似走迷宫, 八个方向走,空格的表示可以走,‘X’不可以走,‘*’是起点。 解题思路:BFS; #include<stdio.h>#include<string.h>#include<queue>using namespace std;const int N = 35;const int M = 85

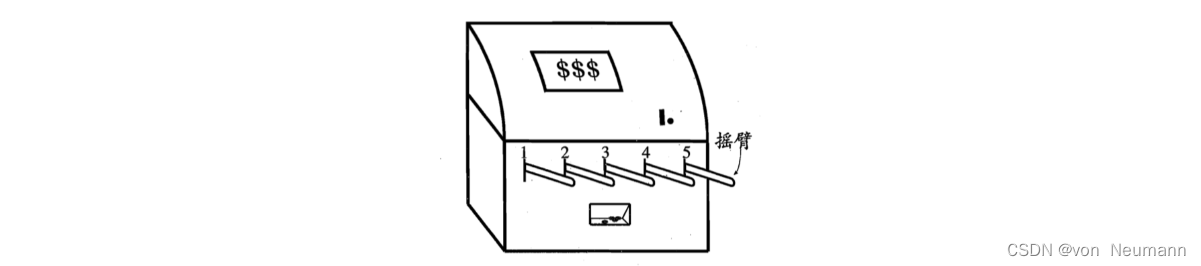

什么是EE(exploration and exploitation)问题

Exploration and Exploitation 问题(EE问题)意译为:探索与利用问题,以商业口吻为例,探索新的利润模式和保持当前利润率的冲突问题。 而以上这样的一种情形也被成为Explore-Exploit Dilemma (EE困境):有两个完全不同的目标,一个是你想要保持你现在情况即利润(利用),另一个是你要尝试新的想法但是可能会造成利润损失(探索)。

NoMaD: Goal Masked Diffusion Policies for Navigation and Exploration

引言 机器人学习的背景和挑战 本文的研究重点 现有方法的局限性 本文的创新点 相关工作 事先准备 视觉目标条件策略 ViNT在目标条件导航中表现出最先进的性能,但它不能执行无方向探索,需要外部的子目标建议机制。Nomad扩展了Vint,同时支持目标条件导航和无方向导航。 使用拓扑图探索 在本文中,我们基于frontier探索,测试

poj 2594 Treasure Exploration(最小路径覆盖(可重点)+floyd)

Treasure Exploration Time Limit: 6000MS Memory Limit: 65536KTotal Submissions: 6987 Accepted: 2840 Description Have you ever read any book about treasure exploration? Have you ever see any

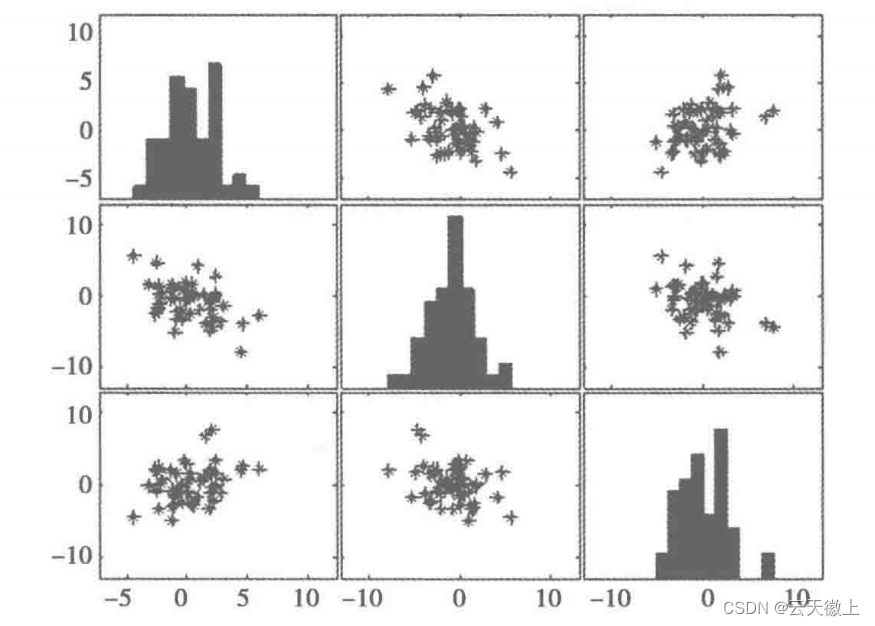

Datacamp 笔记代码 Unsupervised Learning in Python 第一章 Clustering for dataset exploration

更多原始数据文档和JupyterNotebook Github: https://github.com/JinnyR/Datacamp_DataScienceTrack_Python Datacamp track: Data Scientist with Python - Course 23 (1) Exercise Clustering 2D points From the scatte

【机器学习】数据探索(Data Exploration)---数据质量和数据特征分析

一、引言 在机器学习项目中,数据探索是至关重要的一步。它不仅是模型构建的基础,还是确保模型性能稳定、预测准确的关键。数据探索的过程中,数据质量和数据特征分析占据了核心地位。数据质量直接关系到模型能否从数据中提取有效信息,而数据特征分析则决定了模型能否准确捕捉数据的内在规律和模式。 高质量的数据能够减少模型训练时的噪声干扰,提高模型的泛化能力。相反,如果数据中存在大量错误、重复或缺失的值

K - Treasure Exploration (最大路径覆盖)

K - Treasure Exploration Have you ever read any book about treasure exploration? Have you ever see any film about treasure exploration? Have you ever explored treasure? If you never have such experie

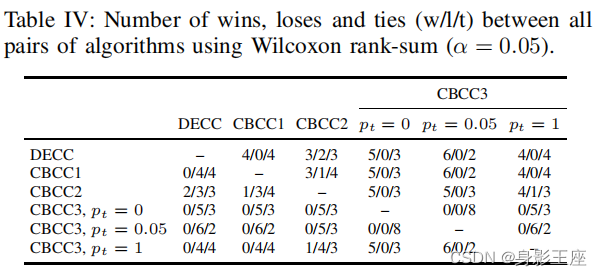

CBCC3 – A CBCC Algorithm with Improved Exploration/Exploitation Balance

0、论文背景 本文是在CBCC1和CBCC2的基础上提出了CBCC3。在本文中,证明了过度探索和过度开发是现有CBCC变体中性能损失的两个主要来源。在此基础上,提出了一种新的基于贡献的算法,可以在探索和开发之间保持更好的平衡。 Omidvar M N, Kazimipour B, Li X, et al. CBCC3—A contribution-based cooperative co-e

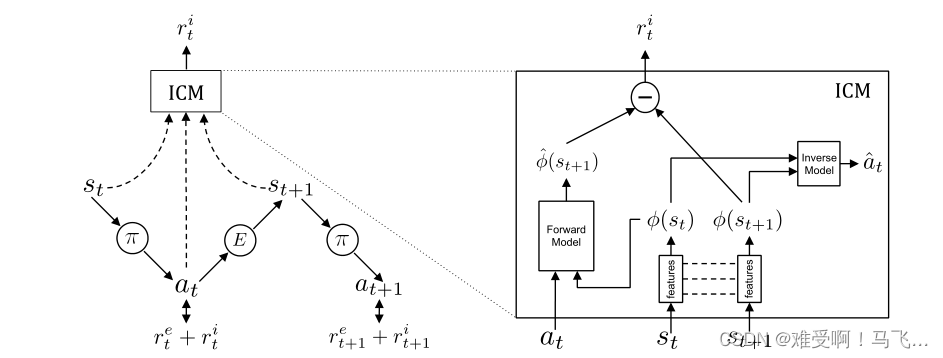

内在好奇心模型(Intrinsic Curiosity Module,ICM)-论文Curiosity-driven Exploration by Self-supervised Prediction

关于强化学习的稀疏奖励问题,主要的解决方案有: 1)塑形奖励函数,但是塑形奖励函数一般或多或少的带有设计者的个人主观因素,这可能会导致模型的最优策略发生偏移。目前,防止塑形奖励函数改变最优策略的方法是吴恩达的 Potential-Based Reward Shaping (没了解的可以搜索一下看看,有很多博客)。2)模仿学习,其实也就是使用专家演示数据引导训练,典型的代表就是DQN中使用的tra

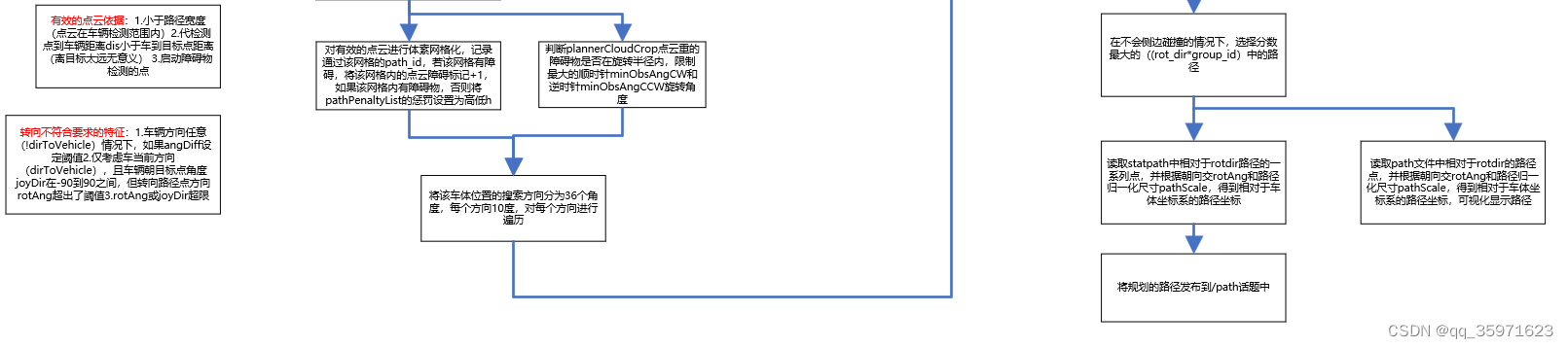

Autonomous_Exploration_Development_Environment的local_planner学习笔记

1.程序下载网址:https://github.com/HongbiaoZ/autonomous_exploration_development_environment 2.相关参考资料: https://blog.csdn.net/lizjiwei/article/details/124437157 Matlab用采样的离散点做前向模拟三次样条生成路径点-CSDN博客 CMU团队开源的局

【CMU-自主导航与规划】Autonomous Exploration Development Environment 配置与运行

官方文档:https://www.cmu-exploration.com/ 一、安装与配置: 适用版本: Ubuntu 18.04 ROS Melodic and Ubuntu 20.04 with ROS Noetic. 如果使用 Ubuntu 22.04 with ROS2 Humble, 则需要配置ROS2【https://drive.google.com/file/d/1a01RSrP

【论文解读】Object Goal Navigation usingGoal-Oriented Semantic Exploration

论文:https://devendrachaplot.github.io/papers/semantic-exploration.pdf 代码:https://github.com/devendrachaplot/Object-Goal-Navigation 项目: Object Goal Navigation using Goal-Oriented Semantic Exploration

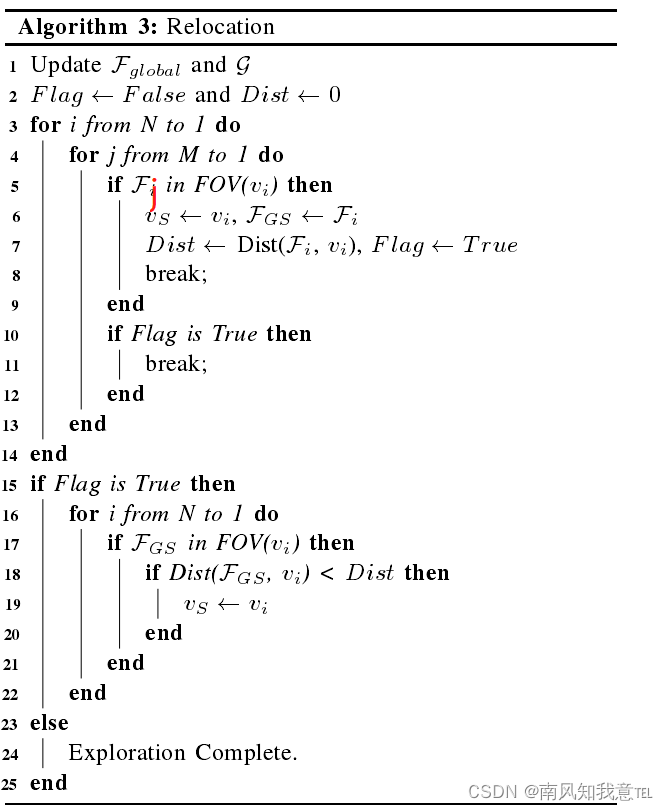

DSVP Dual-Stage Viewpoint Planner for Rapid Exploration by Dynamic Expansion

目录 DSVP整体思路:主要创新点:详细过程:探索阶段:回溯过程其他: 自己的一些问题: DSVP 文章来源: 2021,IROS 类型: 导航算法 阅读日期: December 16, 2021 DSVP Dual-Stage Viewpoint Planner for Rapid Exploration by Dynamic Expansion 整体思路: 本文算法的

Chapter 2 Data Exploration

目录 1. What is Data: A. Data Types B. Record Data C. Types of Attributes 2. Data Exploration: A. About Data Quality B. Preprocessing ① Quality ② Sampling

SEOpinion: Summarization and Exploration Opinion of E-Commerce Websites

Authors: Alhassan Mabrouk ; Rebeca P. Díaz-Redondo ; Mohammed Kayed Q: 这篇论文试图解决什么问题? A: 这篇论文试图解决的问题是电子商务(EC)网站上的产品评论中意见的总结和探索。具体来说,它旨在通过结合产品模板信息和客户评论来提供产品方面的摘要,并突出显示关于它们的一个或多个意见。该论文提出了一种名为SEOpinion(

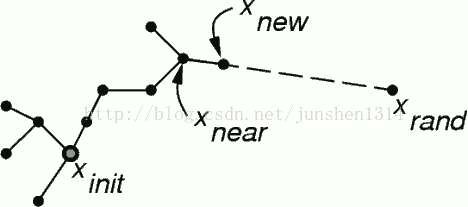

路径规划-快速搜索随机树(Rapid-exploration Random Tree)

本节介绍机器人路径规划领域的一个重要的方法,快速搜索随机树法,这种方法在机器人规划领域,尤其是高维环境(机械臂,飞行器)的规划中,占有重要的位置,是基于采样的规划方法的一种。 简介: 快速搜索随机树,就是在环境中随机撒一些点,这些点经过算法运算,最终可以连接起来,变成机器人可以运行的轨迹。 二 算法介绍: 1.基本算法流程 2.算法介绍 x_init-->x_new---->

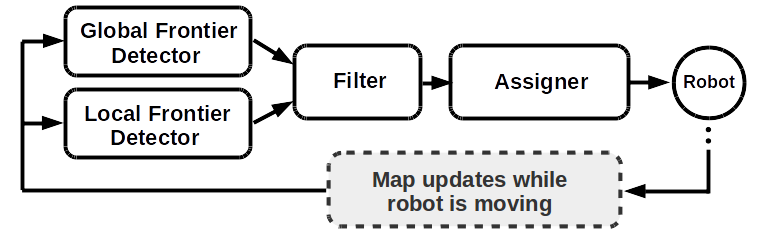

【自主探索】基于 rrt_exploration 的单个机器人自主探索建图

文章目录 一、rrt_exploration 介绍1、原理2、主要思想3、拟解决的问题4、优缺点 二、安装环境三、安装与运行1、安装2、运行 四、配置说明1、Robots Network2、Robot's frame names in tf3、Robot's node and topic names4、Setting up the navigation stack on the robots

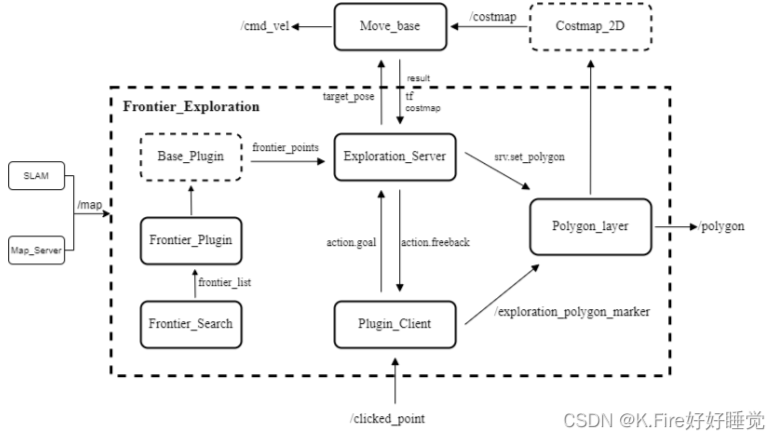

【自主探索】基于 frontier_exploration 的单个机器人自主探索建图

文章目录 一、概述1、功能2、要求 二、使用方法1、用于运行演示2、用于开发人员2.1. 探索无/地图数据2.2. 使用 /map 数据进行探索 三、提供的组件1、explore_client1.1. 调用的操作1.2. 订阅主题1.3. 发布主题 2、explore_server2.1. 提供的操作2.2. 调用的操作2.3. 调用的服务2.4. 参数 3、BoundedExploreL

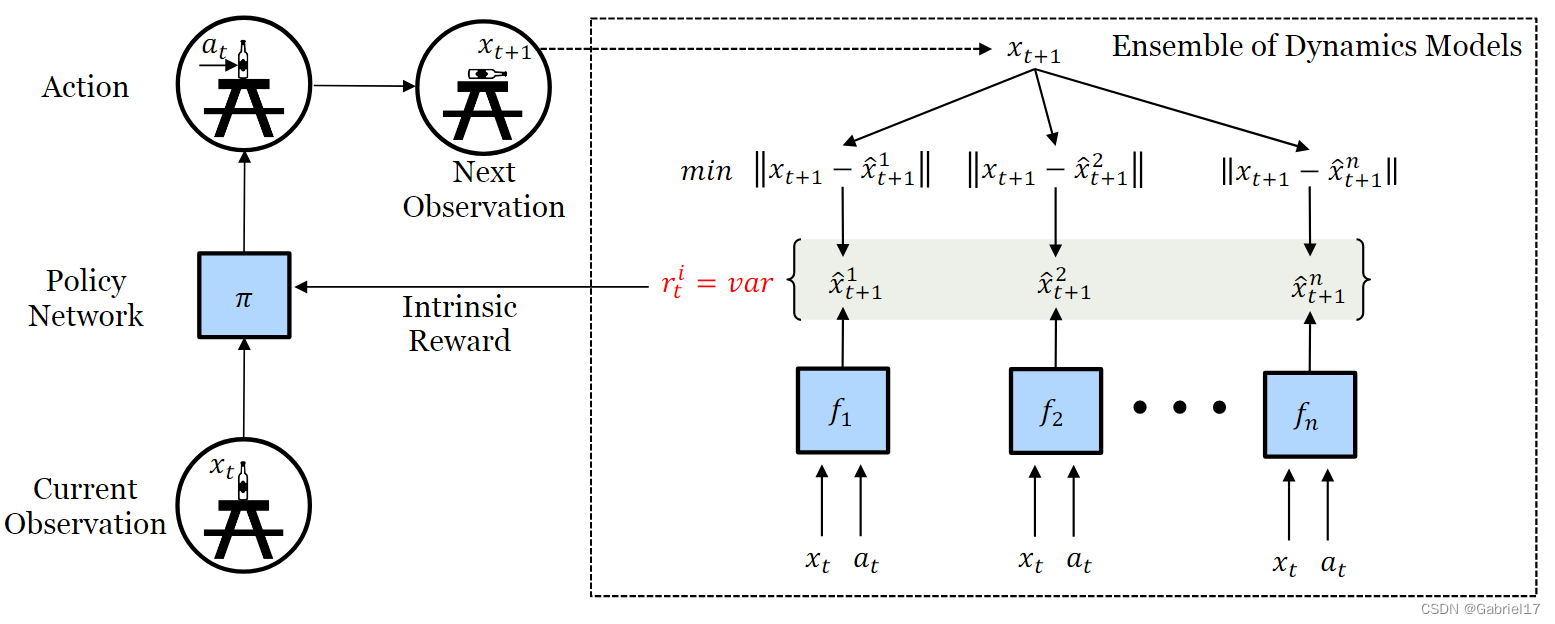

Self-Supervised Exploration via Disagreement论文笔记

通过分歧进行自我监督探索 0、问题 使用可微的ri直接去更新动作策略的参数的,那是不是就不需要去计算价值函数或者critic网络了? 1、Motivation 高效的探索是RL中长期存在的问题。以前的大多数方式要么陷入具有随机动力学的环境,要么效率太低,无法扩展到真正的机器人设置。 2、Introduction 然而,在学习无噪声模拟环境之外的预测模型时,有一个关键的挑战:如何处理代理

20【C趣味算法练习】“马克思手稿中的数学题”(解方程组)| 人工智能 面试题:什么是探索-利用决策(Exploration-Exploitation Dilemma)?在强化学习中如何解决这个问题?

“江湖路漫漫,且行且珍惜” 🎯作者主页: 追光者♂🔥 🌸个人简介: 💖[1] 计算机专业硕士研究生💖 🌿[2] 2023年城市之星领跑者TOP1(哈尔滨)🌿 🌟[3] 2022年度博客之星人工智能领域TOP4🌟 🏅[4] 阿里云社区特邀专家博主🏅 🏆[5] CSDN-人工智能领域优质创作者🏆</

进化计算领域exploration和exploitation的区别

exploration exploitation:探索,在进化计算领域,表示提高多样性的目的。 通常与探索未知领域或未知解决方案有关,而不是迅速达到最佳解决方案。尽管在某些情况下探索是必要的,但它通常与提高收敛性无关,因为它会引入更多的不确定性和变化,可能延缓优化算法的收敛速度。 exploitation exploitation:开发/利用,更加与提高收敛性相关。 这是因为

深入理解强化学习——学习(Learning)、规划(Planning)、探索(Exploration)和利用(Exploitation)

分类目录:《深入理解强化学习》总目录 学习 学习(Learning)和规划(Planning)是序列决策的两个基本问题。 如下图所示,在强化学习中,环境初始时是未知的,智能体不知道环境如何工作,它通过不断地与环境交互,逐渐改进策略。 规划 如下图图所示,在规划中,环境是已知的,智能体被告知了整个环境的运作规则的详细信息。智能体能够计算出一个完美的模型,并且在不需要与环境进行任何交互的