bytetrack专题

ByteTrack多目标跟踪(一)—理论基础

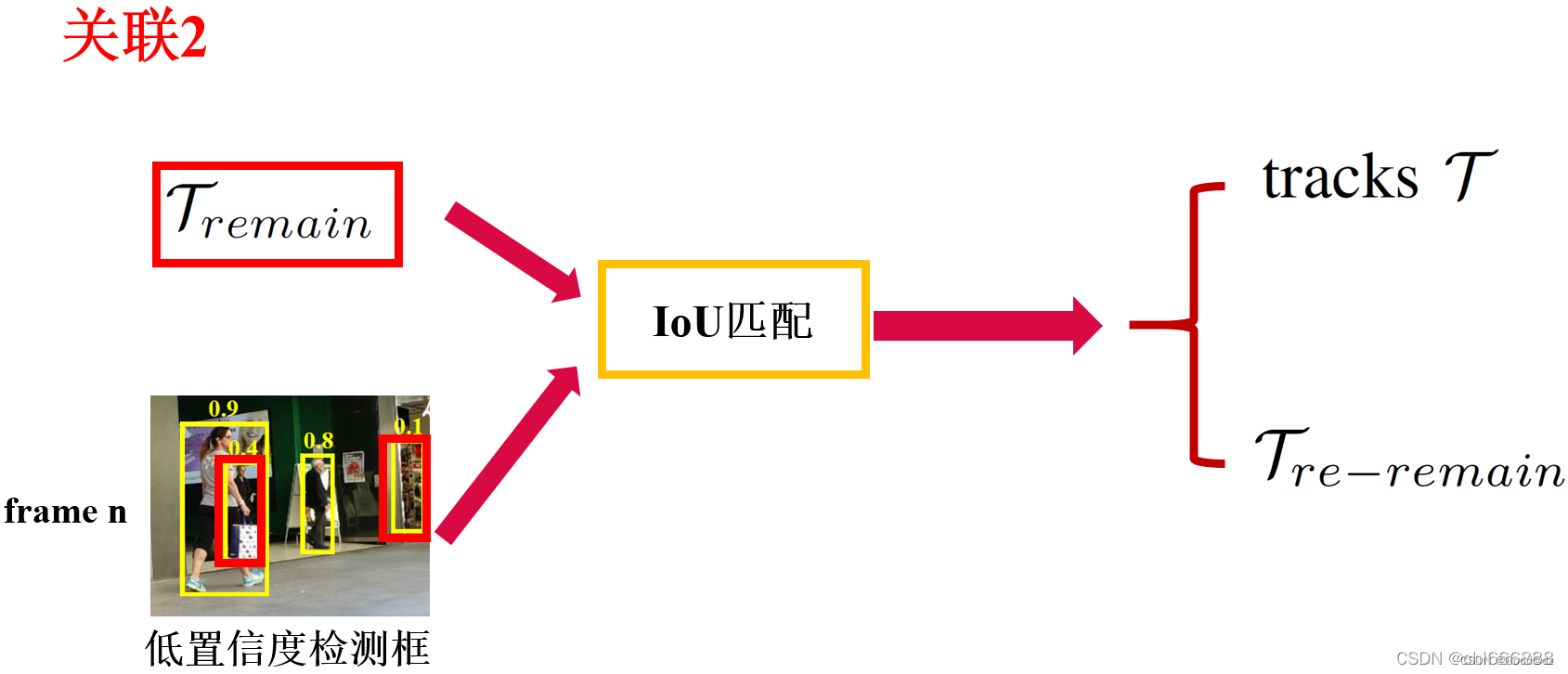

ByteTrack多目标跟踪 算法概述 github: https://github.com/ifzhang/ByteTrack ByteTrack是一种基于Tracking-by-Detection范式的多目标跟踪算法。 先前的多目标追踪算法一般在完成当前帧的目标检测后只会保留置信度比较大的检测框用于进行目标跟踪,比如图中置信度为0.9和0.8的目标框。而在ByteTrack中,作

目标跟踪算法——ByteTrack算法原理解析

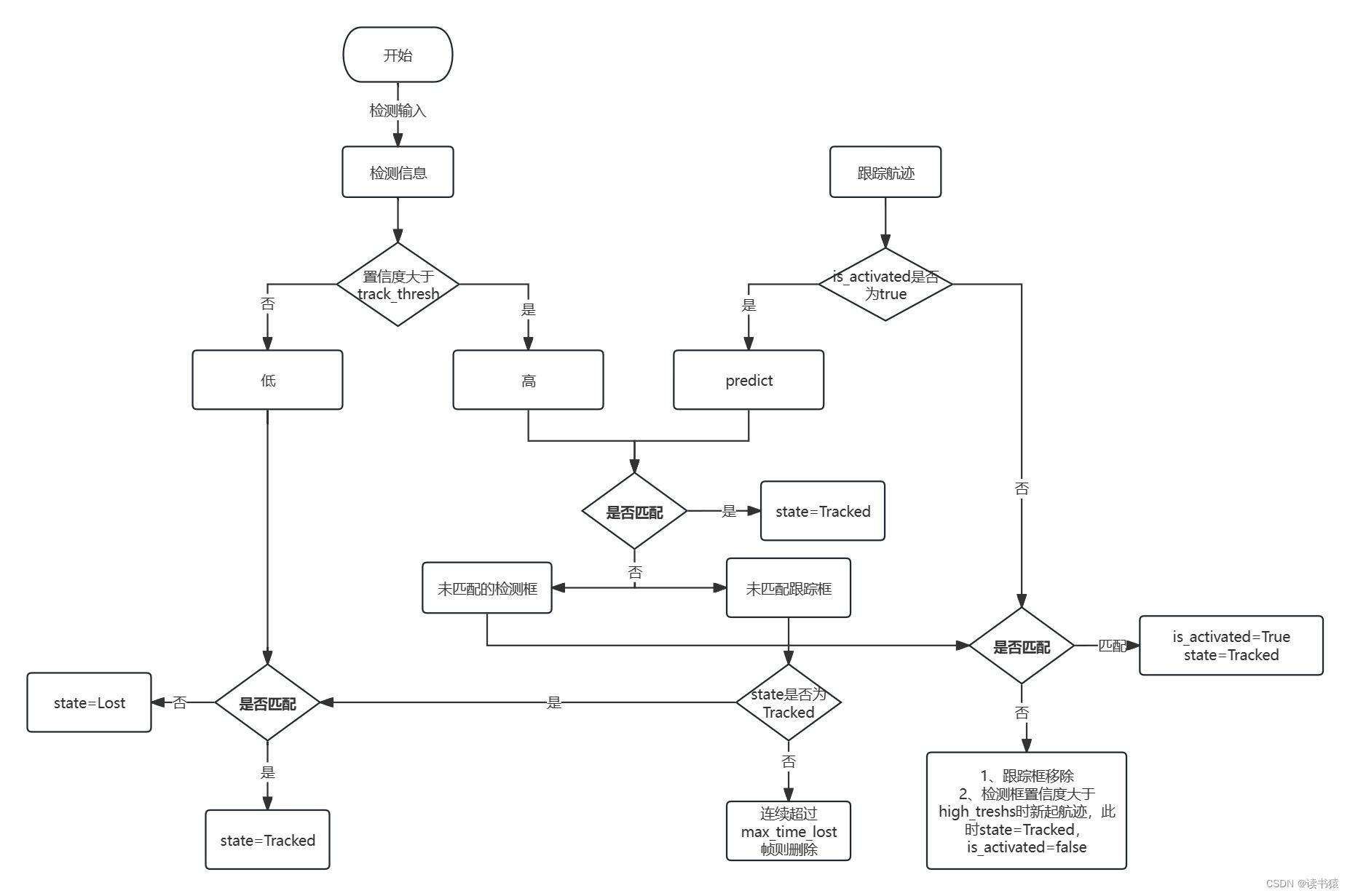

文章目录 ByteTrack1. ByteTrack算法步骤:2. 算法解释2.1 模型初始化2.2 模型更新算法流程2.2.1 检测结果划分,划分为高分和较低分段2.2.2 高分段处理手段2.2.3 最优匹配与未匹配划分2.2.4 低分框再匹配2.2.5 未确认轨迹处理2.2.6 更新状态 2.3 匈牙利匹配算法(线性分配) ByteTrack 1. ByteTrack算法

目标跟踪算法(bytetrack)-tensorrt部署教程

一、本机安装python环境 conda create -n bytetrace_env python=3.8activate bytetrace_envconda install pytorch torchvision cudatoolkit=10.1 -c 检测GPU是否可用,不可用不行 import torchprint(torch.cuda.is_available())

ByteTrack跟踪理解

1.ByteTrack 核心思路 (1)区分高置信度检测框与低置信度检测框,不同置信度检测框采取不同处理方式。 (2)保留低置信度检测框,在后续可能会重新确认为 confirm 状态。而不是像传统 MOT 算法选择删除。 2.bytetrack跟踪流程 (1)把检测的bbox按照置信度阈值分成高低分两组D_high,D_low。 a.其中高分阈值th_h,thd_l,在工

三种方式实现人车流统计(yolov5+opencv+deepsort+bytetrack+iou)

一、运行环境 1、项目运行环境如下 2、CPU配置 3、GPU配置 如果没有GPU yolov5目标检测时间会比较久 二、编程语言与使用库版本 项目编程语言使用c++,使用的第三方库,onnxruntime-linux-x64-1.12.1,opencv-4.6.0 opencv 官方地址Releases - OpenCV opencv github地址https://

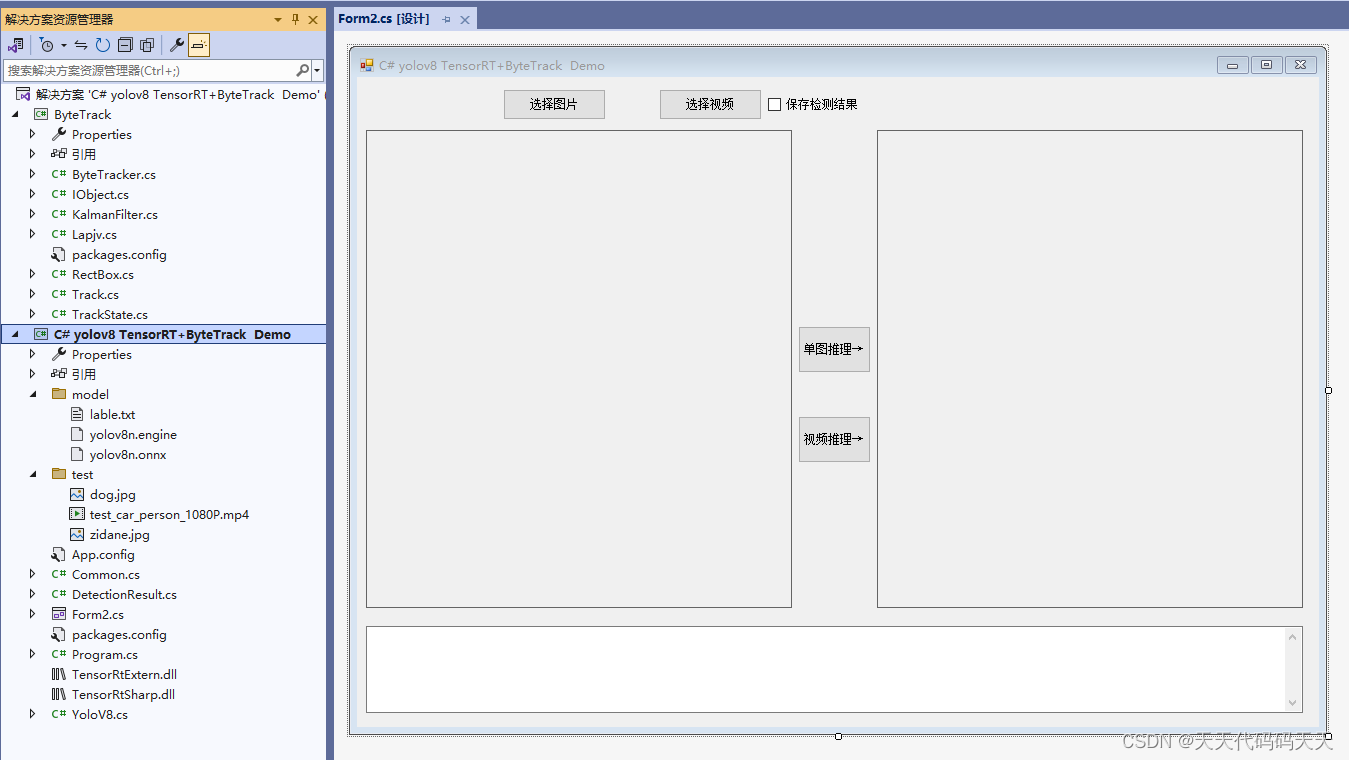

C# yolov8 TensorRT +ByteTrack Demo

C# yolov8 TensorRT +ByteTrack Demo 目录 效果 说明 项目 代码 Form2.cs YoloV8.cs ByteTracker.cs 下载 参考 效果 说明 环境 NVIDIA GeForce RTX 4060 Laptop GPU cuda12.1+cudnn 8.8.1+TensorRT-8.6.1

YOLOv8+bytetrack实现多目标追踪

1. bytetrack简介 ByteTrack是一种基于检测的目标追踪算法,它在YOLOv8检测器的基础上进行了改进,实现了更高效的目标追踪,具有简单、高效和通用的特点。相较于传统的多目标跟踪方法,ByteTrack不依赖于ReID模型,而是通过关联每个检测框来进行跟踪。这种方法可以有效地解决低分检测框被简单丢弃的问题,从而减少漏检和碎片化轨迹的情况。 ByteTrack算法流程如下:首先,

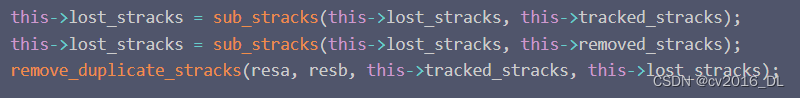

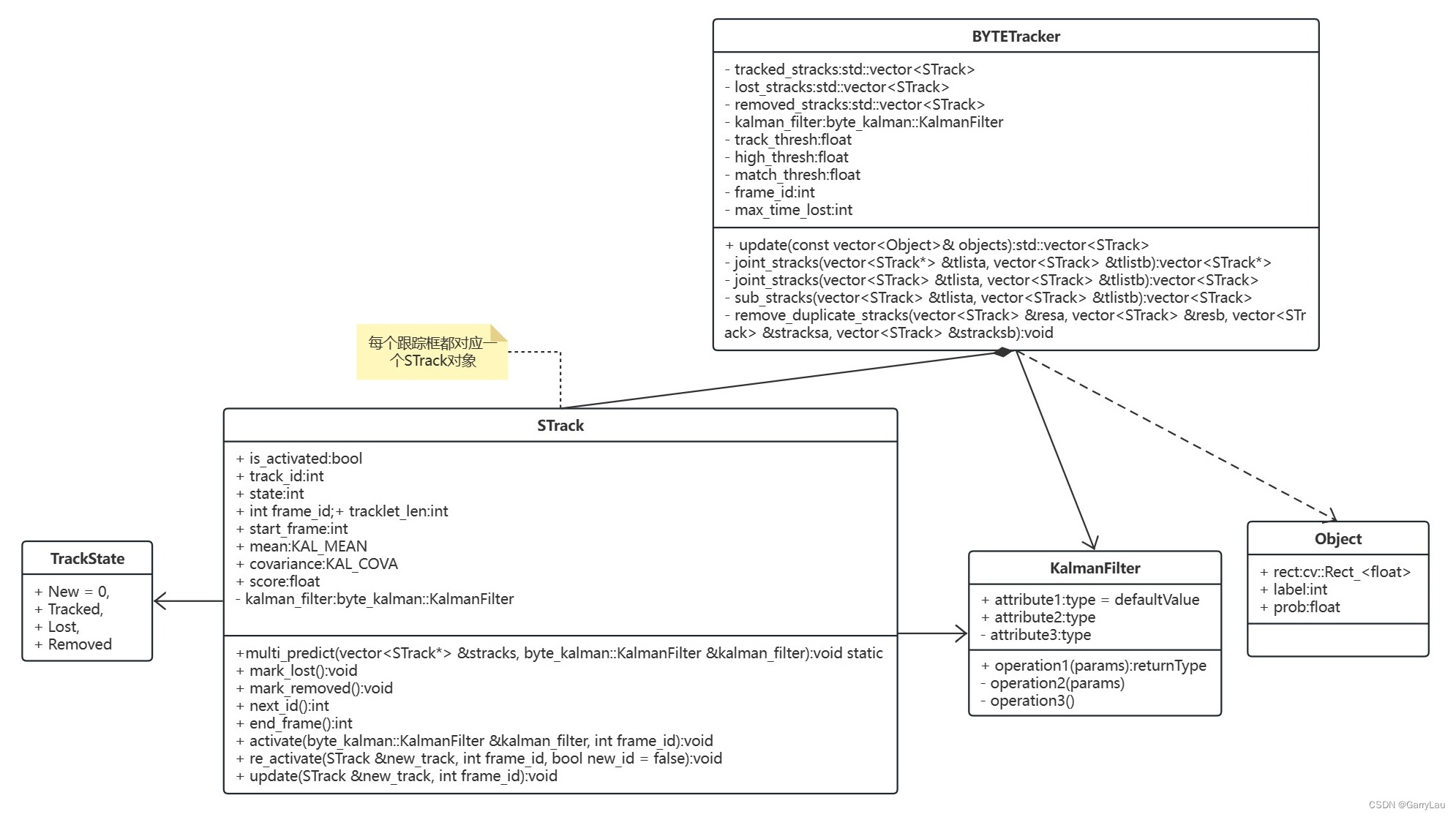

【目标跟踪】ByteTrack详解与代码细节

文章目录 一、前言二、代码详解2.1、新起航迹2.2、预测2.3、匹配2.4、结果发布2.5、总结 三、流程图四、部署 一、前言 论文地址:https://arxiv.org/pdf/2110.06864.pdf git地址:https://github.com/ifzhang/ByteTrack ByteTrack 在是在 2021 年 10 月公开发布的,在 ECCV 2

明厨亮灶厨师帽佩戴检测的难点与优化方式 Yolov5+bytetrack

随着国家一系列食品安全政策的出台,厨房的安全卫生问题逐渐被人们重视。其中,工作人员是否佩戴厨师帽是很关键的一环。人们希望能通过一种方式实现自动化的检测,但目前市场上大部分“明厨亮灶系统”或“未佩戴厨师帽检测系统”都无法满足用户的真实场景需求。在实际使用的时候会出现大量的误报、漏报等问题。那到底在未佩戴厨师帽行为识别算法上到底有什么难点?该如何解决呢? 算法难点 目前,未佩戴厨师帽检测算法的

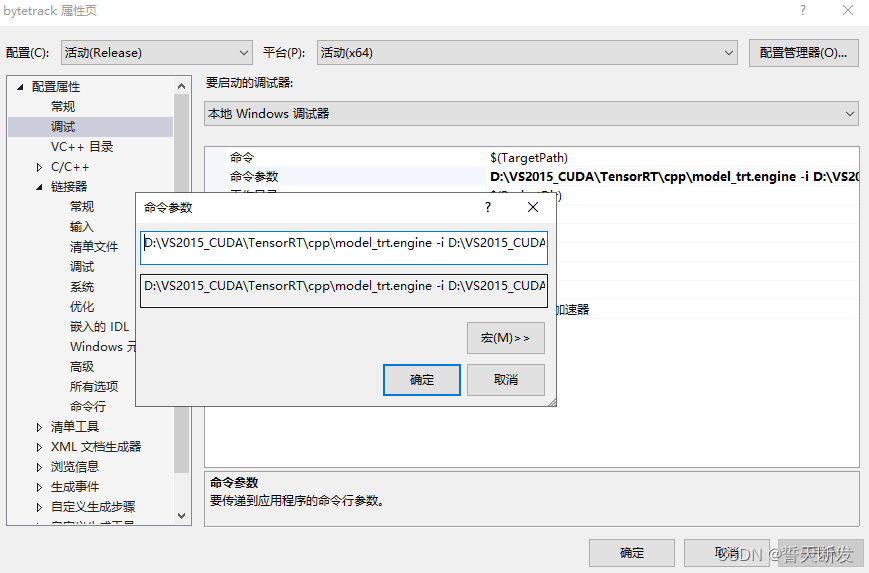

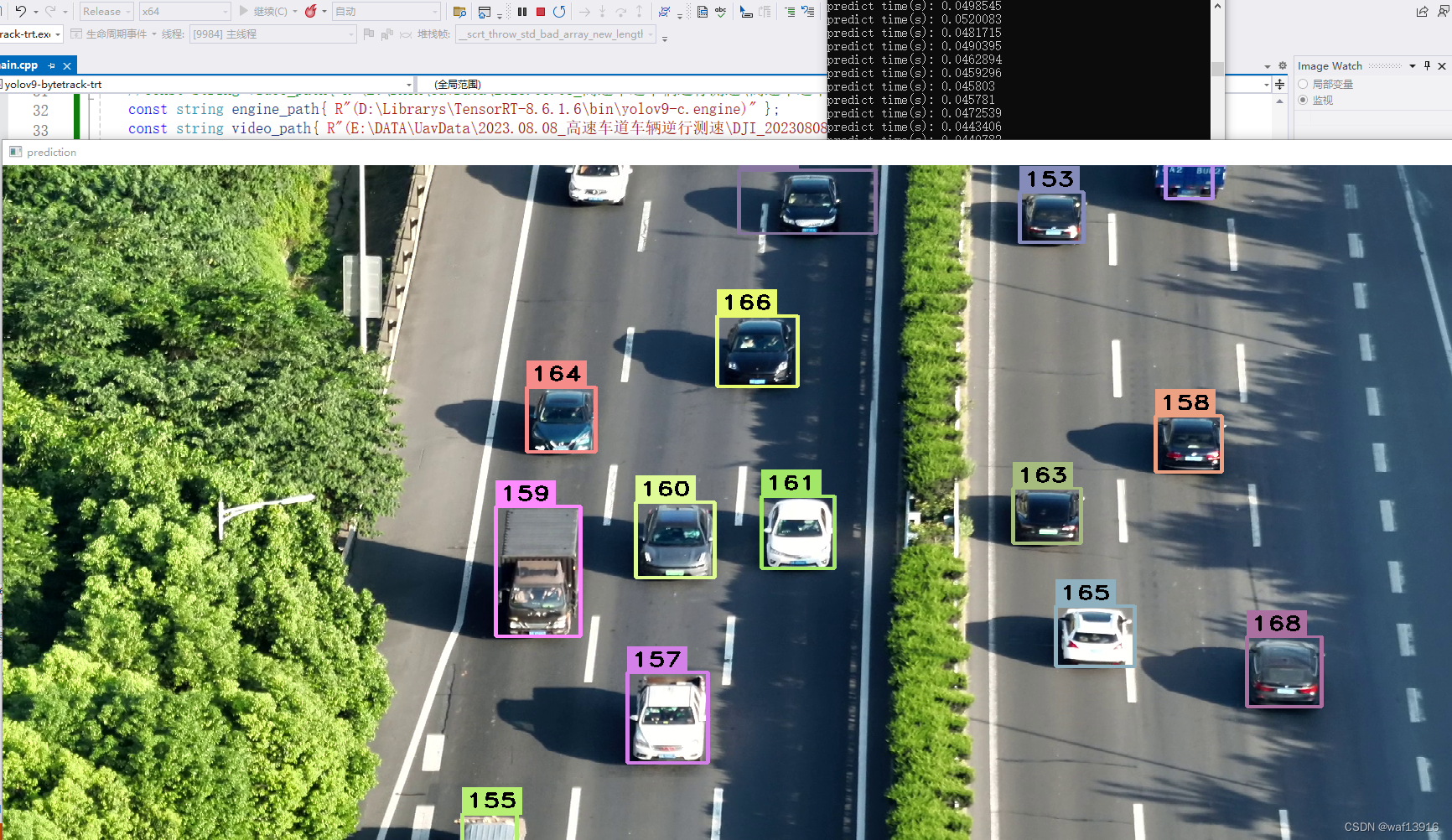

Windows编译运行yolov9-bytetrack-tensorrt (C++)

Windows编译运行yolov9-bytetrack-tensorrt(C++) 1 基础环境2 编译yolov9-bytetrack-tensorrt(1)下载yolov9-bytetrack-tensorrt源码(2)修改CMakeLists.txt(3)CMake编译 3 yolov9模型转换成TensorRT模型(1)下载yolov9(2)下载预训练模型(3)将模型转换成onnx格

MOT-1:ByteTrack

论文写作的博客转移到知乎了: 知乎博客https://zhuanlan.zhihu.com/p/482115800 0.基本信息 论文名:Multi-Object Tracking by Associating Every Detection Box github:https://github.com/ifzhang/ByteTrack arxiv:https://arxiv.org/p

基于YOLOv8/v5和ByteTrack的多目标检测计数与跟踪系统(深度学习代码+UI界面实现+训练数据集)

摘要:之前的多目标检测与跟踪系统升级到现在的v2.0版本,本博客详细介绍了基于YOLOv8/YOLOv5和ByteTrack的多目标检测计数与跟踪系统。该系统利用最新的YOLOv8和YOLOv5进行高效目标检测,并通过ByteTrack算法实现精确的目标跟踪,适用于多种场景如人群监控、交通流量分析等。系统设计包含深度学习模型训练、系统架构设计等内容。使用5542张行人车辆图片数据进行训练,并对

YOLOv8+DeepSort/ByteTrack-PyQt-GUI / yolov5 deepsort 行人/车辆(检测 +计数+跟踪+测距+测速)

YoloV8结合可视化界面和GUI,实现了交互式目标检测与跟踪,为用户提供了一体化的视觉分析解决方案。通过YoloV8算法,该系统能够高效准确地检测各类目标,并实时跟踪它们的运动轨迹。 用户可以通过直观的可视化界面进行操作,实现目标检测与跟踪的交互式体验。GUI的设计使得用户可以轻松选择不同的参数设置,调整算法运行方式,以满足不同场景下的需求。 这一集成系统的优势在于其简单易用性和高效性。用户

YOLOv5-Openvino-ByteTrack【CPU】

纯检测如下: YOLOv5-Openvino和ONNXRuntime推理【CPU】 YOLOv6-Openvino和ONNXRuntime推理【CPU】 YOLOv8-Openvino和ONNXRuntime推理【CPU】 YOLOv9-Openvino和ONNXRuntime推理【CPU】 注:YOLOv5和YOLOv6代码内容基本一致! 全部代码Github:https://github.c

YOLOv8-Openvino-ByteTrack【CPU】

纯检测如下: YOLOv5-Openvino和ONNXRuntime推理【CPU】 YOLOv6-Openvino和ONNXRuntime推理【CPU】 YOLOv8-Openvino和ONNXRuntime推理【CPU】 YOLOv9-Openvino和ONNXRuntime推理【CPU】 注:YOLOv8和YOLOv9代码内容基本一致! 全部代码Github:https://github.c

[C++]C++使用yolov9结合bytetrack实现目标追踪演示

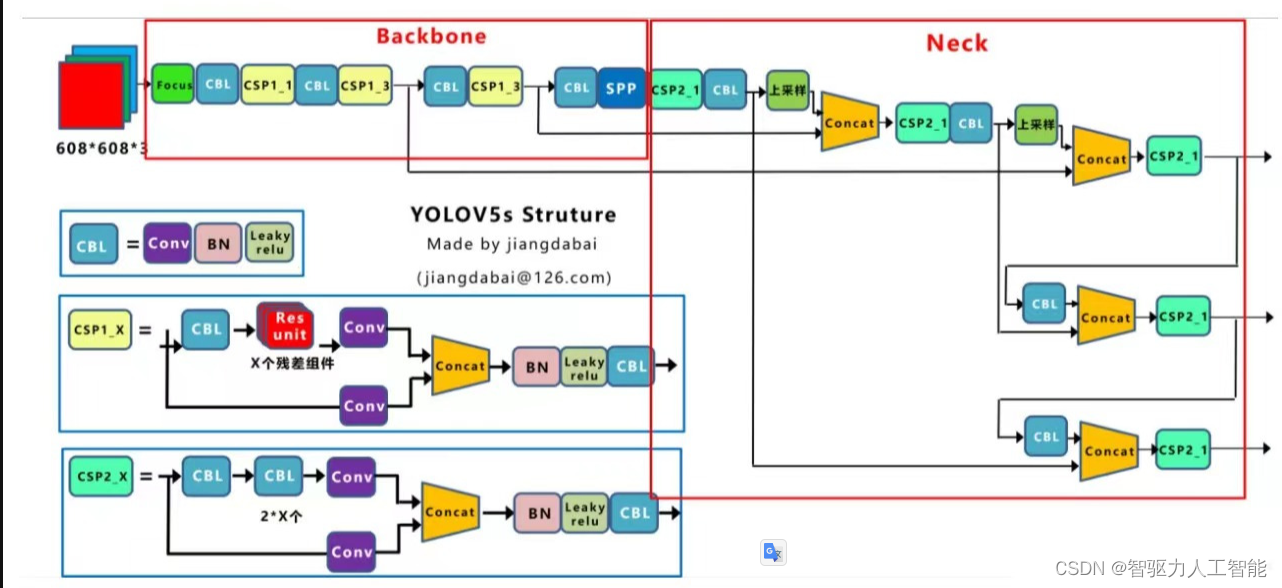

【简介】 在C++中实现YOLOv9的目标检测与ByteTrack的多目标追踪是一个相对复杂的过程,涉及到深度学习、计算机视觉和实时数据处理等多个领域。下面我将简单介绍这两个技术,并概述如何在C++中实现它们。 YOLOv9(You Only Look Once,版本9)是一种实时目标检测算法,它通过在单个网络中同时预测所有目标的位置和类别来实现高效的目标检测。YOLOv9在速度和精度之间取得

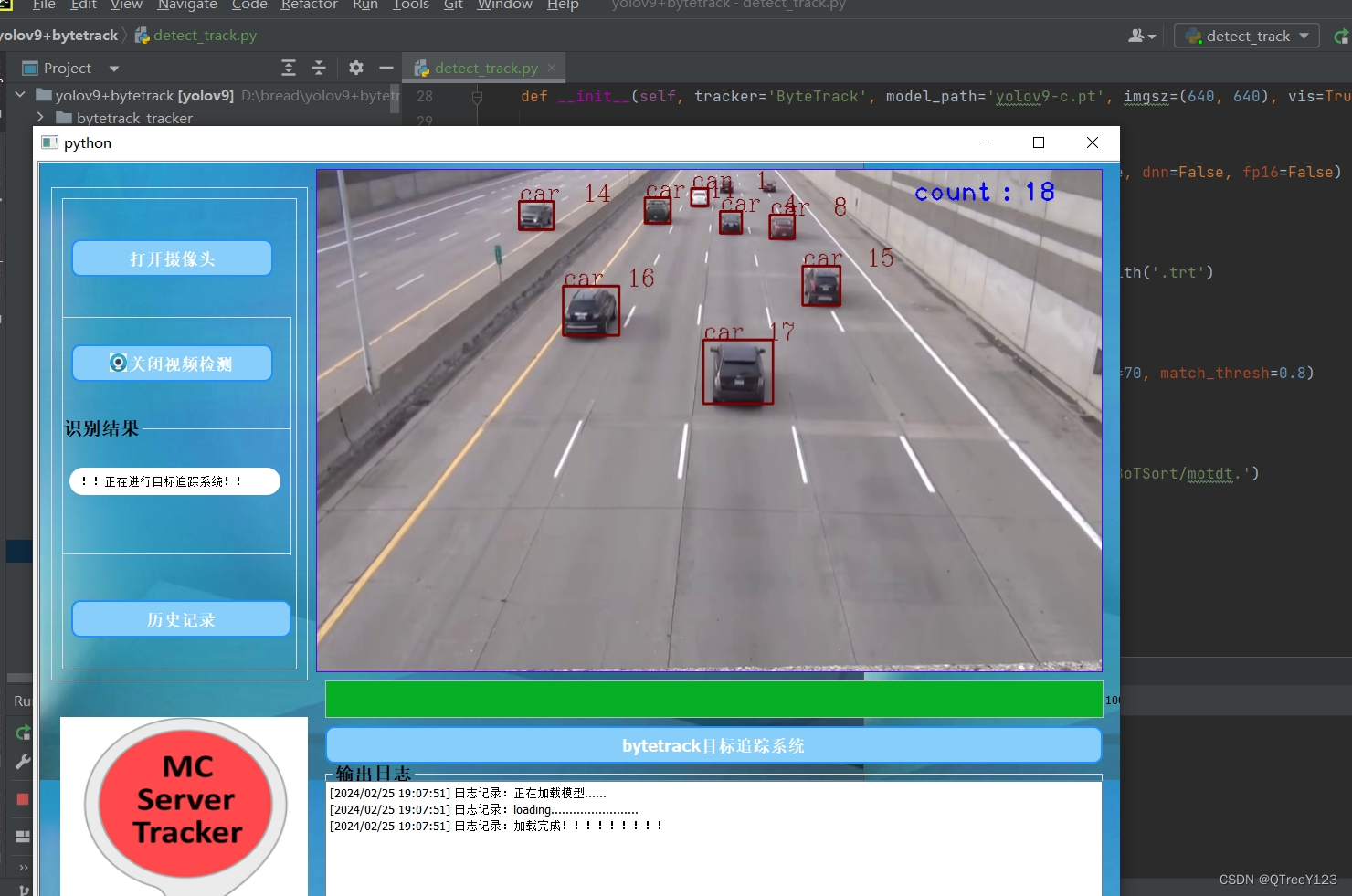

杀疯啦!yolov9+bytetrack的目标跟踪实现

目录 YOLOV9介绍 bytetrack介绍: yolov9结合bytetrack实现目标跟踪 效果展示 训练与预测 UI设计 其他功能展示 完整代码实现+UI界面 此次yolov9+bytetrack不论是准确率还是稳定性,都超越了之前的yolo+bytetrack系列。 YOLOV9介绍 在目标检测领域,YOLOv9 实现了一代更比一代

[深度学习]yolov9+bytetrack+pyqt5实现目标追踪

【简介】 目标追踪简介 目标追踪是计算机视觉领域中的一个热门研究方向,它涉及到从视频序列中实时地、准确地跟踪目标对象的位置和运动轨迹。随着深度学习技术的快速发展,基于深度学习的目标追踪方法逐渐展现出强大的性能。其中,YOLOv9(You Only Look Once的第九个版本)作为一种先进的目标检测算法,因其高精度和实时性而受到广泛关注。 YOLOv9介绍 YOLOv9是YOLO系列算法

ByteTrack:Multi-Object Tracking by Associating Every Detection Box(2021)

[Paper]ByteTrack: Multi-Object Tracking by Associating Every Detection Box(2021) [Code]ifzhang/ByteTrack ByteTrack:通过关联每个检测框进行多目标跟踪 多对象跟踪 (MOT) 旨在估计视频中对象的边界框和身份。大多数方法通过关联得分高于阈值的检测框来获取身份。检测分数低的物体,例如

【笔记】文献阅读[ByteTrack]- Multi-Object Tracking by Associating Every Detection Box

ByteTrack: Multi-Object Tracking by Associating Every Detection Box 引言1 介绍2 相关工作2.1 多目标跟踪( MOT)中的目标检测2.2 数据关联 3 BYTE4 实验4.1 实验设置4.2 BYTE消融实验4.3 基准评价 5 结论 引言 文献阅读笔记,有翻译错误欢迎指出,一起讨论! 多目标跟踪(MO

ByteTrack算法流程的简单示例

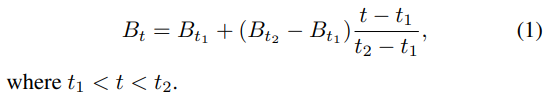

ByteTrack ByteTrack算法是将t帧检测出来的检测框集合 D t {\mathcal{D}_{t}} Dt 和t-1帧预测轨迹集合 T ~ t − 1 {\tilde{T}_{t-1}} T~t−1 进行匹配关联得到t帧的轨迹集合 T t {T_{t}} Tt。 首先使用检测器检测t帧的图像得到检测框集合 D t {\mathcal{D}_{t}} Dt,再根据

Bytetrack学习笔记

概述 ByteTrack是字节跳动发布的一个MOT跟踪算法(“MOT”是“Multi-Object Tracking”)。先前的MOT算法一般在完成当前帧的目标检测后只会保留置信度比较大的检测框用于进行目标跟踪,比如图中置信度为0.9和0.8的目标框。而在BYTE中,作者保留了所有的检测框(图中的所有四个黄色的检测框)并且通过阈值将它们分成了两份 ByteTrack 是基于 tracking-

YOLOv8界面-目标检测+语义分割+追踪+姿态识别(姿态估计)+界面DeepSort/ByteTrack-PyQt-GUI

YOLOv8-DeepSort/ByteTrack-PyQt-GUI:全面解决方案,涵盖目标检测、跟踪和人体姿态估计 YOLOv8-DeepSort/ByteTrack-PyQt-GUI是一个多功能图形用户界面,旨在充分发挥YOLOv8在目标检测/跟踪和人体姿态估计/跟踪方面的能力,与图像、视频或实时摄像头流进行无缝集成。支持该应用的Python脚本使用ONNX格式的YOLOv8模型,确保各种人

yolov5+bytetrack算法在华为NPU上进行端到端开发

自从毕业后开始进入了华为曻腾生态圈,现在越来越多的公司开始走国产化路线了,现在国内做AI芯片的厂商比如:寒武纪、地平线等,虽然我了解的不多,但是相对于瑞芯微这样的AI开发板来说,华为曻腾的生态比瑞芯微好太多了,参考文档非常多,学习资料也有很多,也容易上手开发。 华为曻腾官网:昇腾AI应用案例-昇腾社区 (hiascend.com) 直接步入正题,现在的目标检测已

应用第三方ByteTrack实现目标跟踪

在上一篇博文,我们实现了应用官网ByteTrack实现的目标跟踪。但吹毛求疵地说,官网的ByteTrack有一些不足:1、为了通用性及科研的要求,代码过于冗长,但这不利于集成到自己的程序中;2、目标跟踪结果没有目标类别的信息,需要自己额外添加;3、再次运行算法时,ID不会复位,它会接着上次的ID继续排序。因此,我们完全有理由对其进行优化。 在github中,有很多优化后的ByteTrack,所以

![【笔记】文献阅读[ByteTrack]- Multi-Object Tracking by Associating Every Detection Box](https://img-blog.csdnimg.cn/527183534c4147a685b3177c3816fd4d.png)