本文主要是介绍GCN,R-GCN,岭回归,SVR,随机森林,Adaboost,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

图卷积神经网络(graph convolutional network, GCN),它将卷积神经网络拓展到图结构形式

中,GCN因可以很好地融合图结构数据的结构特征和属性特征并且有较好的组合泛化能力而被广泛使用。

关系图卷积神经网络(relational-graph convolutional network, R-GCN),它通过链接预测和实体分类等任务对非对称关系进行建模,从而显著的提高了模型的性能。

岭回归算法

回归分析方法是利用数理统计方法分析数据,建立自变量和因变量间的回归模型,用于预测因变量变化的分析方法。其中比较经典的是HoerI和Kennard提出的岭回归算法。岭回归算法是在最小二乘法的基础上引|入正则项,使回归模型具有较好泛化能力和稳定性,但岭回归算法并不能处理自变量间非线性相关的情况。

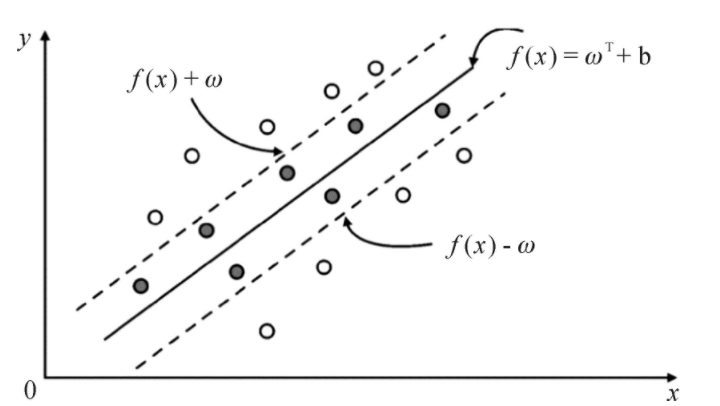

支持向量回归(SVR)是一种 基于支持向量机(Support Vector Machine, SVM)的用于回归的机器学习方法。相较于常用的支持向量分类机,SVR基于输入变量与数值型输出变量的关系来预测新观测的输入变量所对应的输出值。

随机森林(RF)是-种基于多个决策树的集成学习算法,通过随机有放回地抽取样本和样本属性来构建多个决策树,具有防止过拟台、适用于高维大数据的特点。单个决策树由叶子结点、内部结点和边构成,构造过程包括特征选择、树的生成和剪枝。

Adaboost是一种迭代算法,其核心思想是针对同一个训练集训练不同的分类器(弱分类器),然后把这些弱分类器集合起来,构成一个更强的最终分类器(强分类器)。

参考资料:

[1]谢庚全,何俊霖.浅议基于核岭回归技术的汉英机器翻译模型[J].黑河学院学报,2022,13(12):181-183.

[2]魏棕凯,王晓兰,刘洋成等.基于SVR与BP神经网络的水电机组瓦温预测[J].水电与新能源,2024,38(01):71-74.DOI:10.13622/j.cnki.cn42-1800/tv.1671-3354.2024.01.018.

[3]龚泽威一,曹占国,周帅等.基于过采样和随机森林的高压隔离开关发热故障诊断[J].电网与清洁能源,2023,39(11):72-79+96.

[4] 崔立志,何泽彬,李璇.基于注意力的 R-GCN-GRU 的在线学生绩效预测[J].电子测 量技术,2021,44(19):69-75

这篇关于GCN,R-GCN,岭回归,SVR,随机森林,Adaboost的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!