回归专题

✨机器学习笔记(二)—— 线性回归、代价函数、梯度下降

1️⃣线性回归(linear regression) f w , b ( x ) = w x + b f_{w,b}(x) = wx + b fw,b(x)=wx+b 🎈A linear regression model predicting house prices: 如图是机器学习通过监督学习运用线性回归模型来预测房价的例子,当房屋大小为1250 f e e t 2 feet^

用Python实现时间序列模型实战——Day 14: 向量自回归模型 (VAR) 与向量误差修正模型 (VECM)

一、学习内容 1. 向量自回归模型 (VAR) 的基本概念与应用 向量自回归模型 (VAR) 是多元时间序列分析中的一种模型,用于捕捉多个变量之间的相互依赖关系。与单变量自回归模型不同,VAR 模型将多个时间序列作为向量输入,同时对这些变量进行回归分析。 VAR 模型的一般形式为: 其中: 是时间 的变量向量。 是常数向量。 是每个时间滞后的回归系数矩阵。 是误差项向量,假

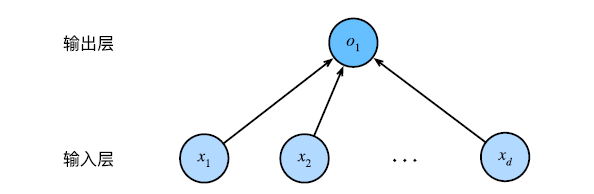

深度学习与大模型第3课:线性回归模型的构建与训练

文章目录 使用Python实现线性回归:从基础到scikit-learn1. 环境准备2. 数据准备和可视化3. 使用numpy实现线性回归4. 使用模型进行预测5. 可视化预测结果6. 使用scikit-learn实现线性回归7. 梯度下降法8. 随机梯度下降和小批量梯度下降9. 比较不同的梯度下降方法总结 使用Python实现线性回归:从基础到scikit-learn 线性

【python因果推断库11】工具变量回归与使用 pymc 验证工具变量4

目录 Wald 估计与简单控制回归的比较 CausalPy 和 多变量模型 感兴趣的系数 复杂化工具变量公式 Wald 估计与简单控制回归的比较 但现在我们可以将这个估计与仅包含教育作为控制变量的简单回归进行比较。 naive_reg_model, idata_reg = make_reg_model(covariate_df.assign(education=df[

什么是GPT-3的自回归架构?为什么GPT-3无需梯度更新和微调

文章目录 知识回顾GPT-3的自回归架构何为自回归架构为什么架构会影响任务表现自回归架构的局限性与双向模型的对比小结 为何无需梯度更新和微调为什么不需要怎么做到不需要 🍃作者介绍:双非本科大四网络工程专业在读,阿里云专家博主,专注于Java领域学习,擅长web应用开发,目前开始人工智能领域相关知识的学习 🦅个人主页:@逐梦苍穹 📕所属专栏:人工智能 🌻gitee地址:x

回归预测 | MATLAB实现PSO-LSTM(粒子群优化长短期记忆神经网络)多输入单输出

回归预测 | MATLAB实现PSO-LSTM(粒子群优化长短期记忆神经网络)多输入单输出 目录 回归预测 | MATLAB实现PSO-LSTM(粒子群优化长短期记忆神经网络)多输入单输出预测效果基本介绍模型介绍PSO模型LSTM模型PSO-LSTM模型 程序设计参考资料致谢 预测效果 Matlab实现PSO-LSTM多变量回归预测 1.input和outpu

【ML--04】第四课 logistic回归

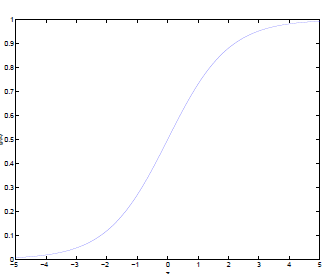

1、什么是逻辑回归? 当要预测的y值不是连续的实数(连续变量),而是定性变量(离散变量),例如某个客户是否购买某件商品,这时线性回归模型不能直接作用,我们就需要用到logistic模型。 逻辑回归是一种分类的算法,它用给定的输入变量(X)来预测二元的结果(Y)(1/0,是/不是,真/假)。我们一般用虚拟变量来表示二元/类别结果。你可以把逻辑回归看成一种特殊的线性回归,只是因为最后的结果是类别变

逻辑回归与线性回归的目标函数和应用场景比较

概述 逻辑回归和线性回归是两种常用的预测模型,它们在目标函数和应用场景上存在显著差异。本文将详细比较这两种回归模型,并提供相应的代码示例。 线性回归 线性回归是一种预测连续数值的模型,其目标是找到特征( X )和目标变量( Y )之间的线性关系。线性回归的目标函数是最小化预测值和实际值之间的平方差,即均方误差(MSE)。 目标函数 线性回归的损失函数是均方误差: [ J(\theta)

【python pytorch】Pytorch实现逻辑回归

pytorch 逻辑回归学习demo: import torchimport torch.nn as nnimport torchvision.datasets as dsetsimport torchvision.transforms as transformsfrom torch.autograd import Variable# Hyper Parameters input_si

回归预测 | Matlab基于贝叶斯算法优化XGBoost(BO-XGBoost/Bayes-XGBoost)的数据回归预测+交叉验证

回归预测 | Matlab基于贝叶斯算法优化XGBoost(BO-XGBoost/Bayes-XGBoost)的数据回归预测+交叉验证 目录 回归预测 | Matlab基于贝叶斯算法优化XGBoost(BO-XGBoost/Bayes-XGBoost)的数据回归预测+交叉验证效果一览基本介绍程序设计参考资料 效果一览 基本介绍 Matlab实现基于贝叶斯算法优化X

【深度学习】线性回归的从零开始实现与简洁实现

前言 我原本后面打算用李沐老师那本《动手学深度学习》继续“抄书”,他们团队也免费提供了电子版(https://zh-v2.d2l.ai/d2l-zh-pytorch.pdf)。但书里涉及到代码,一方面展示起来不太方便,另一方面我自己也有很多地方看不太懂。 这让我开始思考起我“抄书”的意义了。如果都是文字,我感觉抄起来可以加深印象,在抄的同时理解并思考。 但是如果涉及到代码,我没办法在抄的时候

[机器学习]线性回归算法

1 线性回归简介 概念:利用回归方程(函数)对一个或多个自变量(特征值)和因变量(目标值)之间关系进行建模的一种分析方式。 weight:权重;bias 偏置 线性回归分类:一元线性回归、多元线性回归 应用场景:只要目标值连续,就使用线性回归 2 线性回归问题求解 2.1 线性回归API from sklearn.linear_model import LinearRegre

机器学习算法:监督学习中的线性回归

在机器学习领域,线性回归是一种经典的监督学习算法,用于预测连续数值型的目标变量。它假设输入特征和输出结果之间存在线性关系。线性回归模型的目标是找到一条直线(在二维空间中)或一个平面(在三维空间中),使得这条直线或平面尽可能地接近所有的训练数据点。 线性回归的数学表达 线性回归模型可以表示为: [ y = \beta_0 + \beta_1 x_1 + \beta_2 x_2 + \ldots

数据分析:R语言计算XGBoost线性回归模型的SHAP值

禁止商业或二改转载,仅供自学使用,侵权必究,如需截取部分内容请后台联系作者! 文章目录 介绍SHAP用途计算方法:应用 加载R包导入数据数据预处理函数模型 介绍 SHAP(SHapley Additive exPlanations)值是一种解释机器学习模型预测的方法。它基于博弈论中的Shapley值概念,用于解释任何机器学习模型的输出。 SHAP用途 解释性:机器学习模型

逻辑回归-损失函数详解

有监督学习 机器学习分为有监督学习,无监督学习,半监督学习,强化学习。对于逻辑回归来说,就是一种典型的有监督学习。 既然是有监督学习,训练集自然可以用如下方式表述: {(x1,y1),(x2,y2),⋯,(xm,ym)} 对于这m个训练样本,每个样本本身有n维特征。再加上一个偏置项 x0 , 则每个样本包含n+1维特征: x=[x0,x1,x2,⋯,xn

逻辑回归-为什么使用逻辑函数

从线性分类器谈起 给定一些数据集合,他们分别属于两个不同的类别。例如对于广告数据来说,是典型的二分类问题,一般将被点击的数据称为正样本,没被点击的数据称为负样本。现在我们要找到一个线性分类器,将这些数据分为两类(当然实际情况中,广告数据特别复杂,不可能用一个线性分类器区分)。用X表示样本数据,Y表示样本类别(例如1与-1,或者1与0)。我们线性分类器的目的,就是找到一个超平面(Hyper

逻辑回归和支持向量机有什么不同

逻辑回归和支持向量机之间的区别也是面试经常会问的一道题,特地找了一些相关资料看了下。 损失函数 原文地址:http://charlesx.top/2016/03/LR-SVM/ SVM的处理方法是只考虑support vectors,也就是和分类最相关的少数点,去学习分类器。而逻辑回归通过非线性映射,大大减小了离分类平面较远的点的权重,相对提升了与分类最

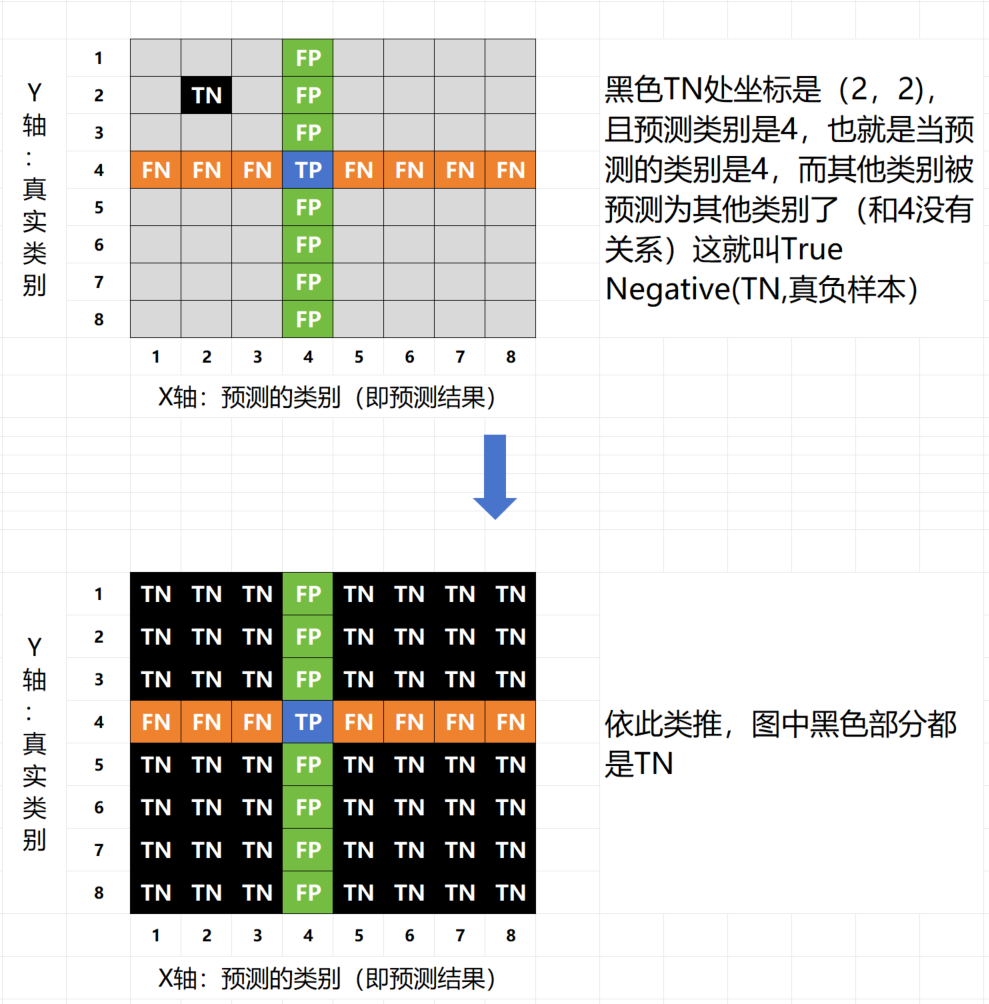

机器学习之监督学习(二)二元逻辑回归

机器学习之监督学习(二)逻辑回归(二元分类问题) 1. 分类 classification2.二元分类逻辑回归 binary-classified logistic regression模块1: sigmoid 激活函数 sigmoid function模型公式模块2: 决策边界 decision boundary代价函数梯度下降欠拟合与过拟合、正则化模块3:评价指标数据集的平衡性平衡数据集

机器学习算法——常规算法【逻辑回归】

概述 逻辑回归(Logistic Regression)是一种广泛应用于二分类问题的统计模型,尽管名字中有“回归”二字,但它实际上是一个分类算法。逻辑回归通过使用逻辑函数估计概率,将线性回归的连续输出映射到[0, 1]区间,表示为特定类别的概率。 逻辑回归原理 逻辑回归模型使用Sigmoid函数作为激活函数,将线性回归的输出映射到[0, 1]区间,公式如下: [ P(y=1|x) = \f

回归测试的介绍和工具选择

前言 在测试阶段,在每次迭代的时候,我们需要回归检验下前期完成的功能,来保证新的提交没有导致系统功能的衰退。所以回归测试在整个测试的生命周期中起到了非常重要的作用。 回归测试的定义 在新功能发布后,对已经测试的程序功能进行重复测试,以发现由于正在测试的软件或其他相关或不相关的软件组件的更改而引入或发现的任何缺陷。 简单地说,我们通过对新发布后的应用程序功能重新执行测试来进行回归,以评估修改

8种进行简单线性回归的方法分析与讨论

以下是八种进行简单线性回归的方法及其分析与讨论: 二乘法(OLS): 分析:通过化预测值与实际值之间的平方误差来估计回归系数。 讨论:简单直观,适用于大多数线性回归问题。但对于数据中存在异常值或噪声时,可能不够鲁棒。 梯度下降法: 分析:通过迭代优化算法调整回归系数,以化损失函数。 讨论:适用于大规模数据集和复杂模型,但需要选择合适的学习率,并可能需要较长的训练时间。 正规方程法:

数学建模强化宝典(10)多元线性回归模型

一、介绍 多元线性回归模型(Multiple Linear Regression Model)是一种用于分析多个自变量(解释变量、预测变量)与单个因变量(响应变量、被预测变量)之间线性关系的统计模型。这种模型假设因变量的变化可以通过自变量的线性组合来近似地表示,同时考虑了一个误差项来捕捉模型未能解释的变异性。 二、模型形式 多元线性回归模型的一般形式可以表示为: Y=β

TensorFlow介绍二-线性回归案例

一.案例步骤 1.准备数据集:y=0.8x+0.7 100个样本 2.建立线性模型,初始化w和b变量 3.确定损失函数(预测值与真实值之间的误差),均方误差 4.梯度下降优化损失 二.完整功能代码: import osos.environ['TF_CPP_MIN_LOG_LEVEL']='2'import tensorflow as tfdef linear_regressi

第L3周:机器学习-逻辑回归

🍨 本文为🔗365天深度学习训练营 中的学习记录博客🍖 原作者:K同学啊 目标: 逻辑回归适用于分类问题,主要用于解决二分类或多分类的问题。比如:用户购买某商品的可能性,某病人患有某种疾病的可能性等等;某个物品属于哪个类别等;了解Sigmoid和Softmax的用法 具体实现: (一)环境: 语言环境:Python 3.10 编 译 器: PyCharm *框 架:*scikit

![[机器学习]线性回归算法](https://i-blog.csdnimg.cn/direct/ef4479fd7cea4525817daaf950289dfd.png)