本文主要是介绍行人轨迹论文阅读SSAGCN: Social Soft Attention Graph Convolution Network for Pedestrian Trajectory Prediction,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

SSAGCN: Social Soft Attention Graph Convolution Network for Pedestrian Trajectory Prediction SSAGCN:用于行人轨迹预测的社会软注意力图卷积网络

Abstract- 行人轨迹预测是自动驾驶的一项重要技术,近年来已成为研究热点。为了准确预测行人未来的合理轨迹,不可避免地要同时考虑行人之间的社交互动和周围场景的影响。以前的方法主要依靠行人的位置关系来模拟社交互动,这显然不足以代表真实情况下的复杂案例。此外,现有的大部分工作通常将场景交互模块作为一个独立的分支引入,并将社交交互特征嵌入到轨迹生成过程中,而不是同时进行社交交互和场景交互,这可能会破坏轨迹预测的合理性.

在本文中,我们提出了一种新的预测模型,称为社会软注意力图卷积网络(SSAGCN),旨在同时处理行人之间的社交互动以及行人与环境之间的场景互动具体来说,在对社交互动进行建模时,我们提出了一种新的社交软注意函数,该函数充分考虑了行人之间的各种互动因素。并且它可以根据不同的因素在各种情况下区分代理周围行人的影响。

对于物理交互,我们提出了一种新的顺序场景共享机制场景在每一刻对一个代理的影响可以通过社会软注意力与其他邻居共享,因此场景的影响在空间和时间维度上都得到了扩展。在这些改进的帮助下,我们成功地获得了社会和物理上可接受的预测轨迹。在公共可用数据集上的实验证明了 SSAGCN 的有效性,并取得了最先进的结果。

1. Introduction

在视频中预测行人的未来轨迹是自动驾驶中的一项重要任务 [1]、[2]、[3]、[4]、[5]、[6],它吸引了不同研究领域的大量科学家和工程师如今。行人未来轨迹的成功预测与对周围行人影响因素和物理场景的准确建模密切相关。

早期的工作聚合了循环神经网络的隐藏状态,根据位置信息 [7]、[8]、[9]、[10]、[11]、[12] 对行人交互进行建模。然后引入注意机制[13]来计算不同行人对其他代理的影响程度[14]、[15]、[16]。最近,涉及到图结构来表示行人的拓扑关系[17]、[18]、[19]、[20],并取得了有竞争力的表现。然而,真实情况过于复杂,无法通过简单的图结构建模,**其中影响智能体未来轨迹的社会因素包括相对速度、位置、视角等。人们往往会受到视野内邻居的影响,并且随着相对速度越大,距离越近,效果会越大。**遗憾的是,以往的方法大多主要考虑相对距离,缺乏对上述因素的综合考虑。

另一方面,人们已经意识到场景对轨迹预测问题的重要影响[21]、[22]、[23]、[24]、[25]、[14]。他们大多尝试以原始场景图像为输入,利用卷积神经网络提取相应的场景特征。然后使用这些特征来计算场景对行人的影响。例如,Sophie [14] 和 Social-BiGA T [26] 使用固定框架来计算物理注意力,并分别考虑社交互动和场景互动。但是,这种方式有两个明显的缺点。**首先,物理场景通常在行人移动的整个过程中发挥着重要作用,**而不仅仅是在固定的时间段内。**其次,行人之间的交互通常与行人和场景之间的交互同时发生。**以上观察促使我们在我们的方法中充分考虑物理场景的持续影响,并及时与邻居分享场景对代理的影响。

鉴于基于图的方法 [19]、[17] 的出色性能,我们在工作中继续采用这种方式。与以往的工作相比,我们进一步全面分析了可能影响行人轨迹的社会因素。**例如,从相反方向相遇的行人会相互影响更大,相对速度越大,影响越大。由于视野有限,从相反方向离开的行人即使距离很近,对彼此的影响也较小。**基于上述实际规律,我们提出了一种新的社会软注意力函数来覆盖这些情况,并用它构造一个加权邻接矩阵来表示图中行人节点之间不同程度的影响。

此外,我们还提出了一种顺序场景注意力共享机制。通过计算场景在连续时刻的影响,场景的影响首先在时域上扩展,然后通过社交互动在行人之间共享。此外,我们的模型考虑了各种社交互动因素,并将物理场景信息以前所未有的方式嵌入到统一的图节点中。 GCN [27] 用于处理构建图上的节点特征聚合,时间卷积神经网络 (TCN) [28] 用于生成预测轨迹。贡献可以总结如下:

• **我们提出了一种新的轨迹预测模型SSAGCN,它可以处理行人之间更全面的社交互动,同时也充分探索了前人工作中未发现的顺序场景注意机制。**通过综合考虑场景对行人的影响以及行人之间的交互,SSAGCN在公共数据集上的表现达到了state-of-the-art的结果。

• 我们提出了一种社交软注意力函数来计算时空图中行人节点之间的影响程度。该函数充分考虑了相对速度、位置和视角等因素对行人未来轨迹的影响。

• **我们提出了一种顺序场景注意力共享机制,将实际环境的物理效应作为图节点的一部分考虑在内,并通过统一的社会传播来共享这些效应。**图节点的语义信息在很大程度上得到了丰富,因此所提出的模型可以产生更多物理上可接受的预测轨迹。

2. Related Works

随着深度学习的快速发展和对自动驾驶技术的广泛关注,行人轨迹预测也得到了极大的推动。由于该研究领域的相关工作量巨大,我们主要集中在以下几个方面进行详细论证。

A. Social interaction modeling among pedestrians.行人之间的社交互动建模

研究人员从一开始就注意到,不可避免地要考虑周围邻居对一个代理的影响来预测其未来的运动。

赫尔宾等人 [29] 首次提出社会力的概念,利用行人之间的排斥力和吸引力来模拟社会互动。

为了计算静止人群对行人运动的影响,Yi 等人 [30] 引入了个性属性将行人分类为不同的类别。

Social-LSTM [10]被提出将原始的vanilla LSTM与时间步长池化机制相结合,该模型成功地模拟了行人的社交互动。由于社会影响的重要性主要取决于行人与其邻居之间的距离,

薛等人 [24] 提出为每个行人构建一个圆形占用图,以捕捉其他行人的影响。

张等人 [12]提出了一种类似于注意力机制的加权算法,从邻居当前的行为意图中提取社会影响信息,建立交互模型。

萨德吉安等人[14] 提出了一种社会注意力机制,通过计算附近行人的 LSTM 隐藏状态的注意力来模拟行人之间的交互。

近年来,一些工作[17]、[19]开始使用图结构来建模社交互动。

黄等人 [17] 提出了 STGA T,它结合了图网络和基于距离的注意力机制,在不同的行人之间共享信息,并为各个节点分配不同的权重。

Social-STGCNN [19] 使用具有更丰富时空信息的图卷积网络来编码行人之间的交互。

上述方法通过对行人之间的社交互动进行建模,取得了令人满意的预测结果。但是,他们并没有充分考虑前面提到的各种影响因素。在我们的方法中,我们提出了一种新的用于图卷积的社交软注意力函数,它综合考虑位置、相对速度和视角因素的影响,通过计算图结构中行人节点之间的交互程度来模拟复杂的社交交互。

B. Scene interaction modeling between pedestrians and environment行人与环境的场景交互建模

场景在轨迹预测任务中起着至关重要的作用。最近,许多方法[31]、[32]、[14]、[33]、[15]都集中在如何从场景中提取上下文特征来约束代理的移动。

北谷等人 [34] 使用隐变量马尔可夫决策过程对人与场景之间的交互进行建模,并推断行人的可通行区域。

萨德吉安等人 [32] 考虑了代理的历史轨迹与空间导航环境之间的依赖关系,然后提出了一个可解释的轨迹预测框架。

与上述方法类似,Sadeghian 等人 [14] 进一步提出了 Sophie 框架,该框架通过利用代理的历史轨迹和场景上下文特征同时对物理和社会交互进行建模。

此外,一些方法[33],[15]将场景的原始图像处理成二进制分割的形式,即区分场景的道路和障碍物。

哈达德等人 [15]考虑了场景中与静态物理对象和动态行人的交互。他们提出了一种基于长短期记忆(LSTM)网络的新时空图,可以有效避免拥挤环境中的潜在碰撞。

在我们的工作中,我们使用物理场景注意机制来计算场景对连续帧而不是特定帧中代理的连续影响。此外,为了同时考虑场景上下文和社交交互的影响,我们将每个时刻场景的影响与社交交互图中的每个相邻节点共享。与以前的方法相比,我们的方法扩展了物理场景在时间和空间上的影响。

C. Graph neural network

图神经网络 (GNN) [35] 是强大的神经网络架构,用于在图上进行机器学习。通过结合 GNN 和卷积神经网络,图卷积网络 (GCN) [36] 允许根据距离为不同的邻居分配各种权重,已广泛用于各种视觉任务。

近年来,高等人 [37] 使用 GCN 处理视觉跟踪任务。孙等人 [38] 使用 GCN 处理视频轨迹预测任务中的社交互动。 Y 安等人 [39] 利用改进的模型 STGCNN 来识别人类交互。 Abduallah 等人 [19] 制定了一个核函数,将社会属性附加到 STGCNN 以预测行人轨迹。然而,这些工作在用图结构建模任意两个行人对彼此的影响时,将影响程度固化为相同的值,这在实际情况下是不合理的。在许多情况下,这两个行人对彼此的影响并不完全相同。

GAT [40] 的出现引起了对图神经网络的关注,很好地解决了这个问题。随后,STGA T [17] 和 Social-Bigat [18] 在轨迹预测中扩展了 GA T。 Shi 等人 [41] 使用自注意力机制计算非对称注意力得分矩阵,并将其应用于稀疏图卷积。尽管基于 GA T 的方法在轨迹预测方面取得了长足的进步,但它们需要大量的数据来学习图中节点之间的差异,并且消耗更多的计算资源。我们工作中提出的方法比基于 GA T 的方法更加手工设计,速度更快。由于考虑周全,我们的方法可以更好地区分各个节点之间的不同影响。

III. SSAGCN

在本节中,我们的目标是开发一个预测模型来为行人推导出一组可能的未来轨迹。在第 III-A 节中,我们解释了行人轨迹预测的问题定义。在第 III-B 节中,我们简要概述了所提出的模型。在下面的第 III-C 节中,我们将介绍社交软注意力函数的设计细节。在第 III-D 节中,我们演示了顺序场景注意力共享机制。最后,在第 III-E 节中介绍了轨迹生成的方法。

A. Graph Representation of Pedestrian Prediction

A. Problem definition

与[9],[42]类似,我们假设在一个时间段 [ 1 , T p r e d ] [1,T_{pred}] [1,Tpred]内有 N N N个行人。对视频中行人的轨迹进行预处理后,每个行人 i i i 在每个时间步长 t t t 的位置可以表示为一对空间坐标 ( x i t , y i t ) (x^{t}_{i}, y^{t}_{i}) (xit,yit),其中 t ∈ 1 , 2 , 3 , . . . , T p r e d t ∈ {{1, 2, 3, . . . , Tpred}} t∈1,2,3,...,Tpred, i ∈ 1 , 2 , 3 , . . . , N i ∈ {1, 2, 3, . . . , N} i∈1,2,3,...,N。场景图像由 I s c e n e I_{scene} Iscene 表示。我们将 I s c e n e I_{scene} Iscene 在时间间隔 [ 1 , T o b s ] [1,Tobs] [1,Tobs]内的坐标序列和场景信息作为输入,在 [ T o b s + 1 , T p r e d ] [Tobs+1,Tpred] [Tobs+1,Tpred]中预测坐标序列。

B. Model overview

如图 2 所示,首先,我们将坐标 ( x i t , y i t ) (x^{t}_{i}, y^{t}_{i}) (xit,yit)处理为图形表示,每个节点代表一个行人。

然后我们根据行人的相对位置、速度和方向,使用社会软注意力函数估计图节点之间的影响矩阵。同时,根据agent的坐标 ( x i t , y i t ) (x^{t}_{i}, y^{t}_{i}) (xit,yit)和场景图像 I s c e n e I_{scene} Iscene 在过去每个时刻的特征,计算出场景注意力 C i t C^{t}_{i} Cit。场景注意力 C i t C^{t}_{i} Cit将在每个时间步进一步嵌入到图节点中。通过 GCN 和社交软注意力的实现,场景信息通过社交交互在代理之间共享。最后,我们将 GCN 处理的图序列输入到 TCN [28] 中,以估计代理的未来轨迹。我们将在以下部分中解释详细信息。

我们提出的 SSAGCN 模型的架构。我们的方法将使用坐标构建的初始图与顺序场景注意合并,然后在社交软注意函数和 GCN 的作用下聚合社交特征并共享物理场景影响。最后,TCN 获得预测的轨迹。两个方向的箭头代表节点之间的边,边上的字符代表权重。

C. Social attention graph representation社会注意力图表示

Node representation:

我们构建了一系列图形来表示行人轨迹。在时间步 t,所有的行人都连接起来形成一个完整的图 G t = ( V t , E t ) G_t = (V_t, E_t) Gt=(Vt,Et)。

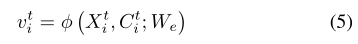

V t = v i t ∣ ∀ i ∈ 1 , . . . , N Vt = {v^t_i | ∀i ∈ {1, . . . , N}} Vt=vit∣∀i∈1,...,N 是 G t G_t Gt 的顶点集合,代表时间步 t 的所有行人。 v i t v^t_i vit的初始值是观察到的坐标位置 ( x i t , y i t ) (x^{t}_{i}, y^{t}_{i}) (xit,yit)。

E t = { e i j t ∣ ∀ i , j ∈ { 1 , … , N } } E_{t}=\left\{e_{i j}^{t} \mid \forall i, j \in\{1, \ldots, N\}\right\} Et={eijt∣∀i,j∈{1,…,N}}是 Gt 的边集。在我们的工作中, E t E_{t} Et中包含的边由根据社会软注意力函数 Fssa (·) 计算的邻接矩阵 A t A_t At 表示。

Social soft attention function:社交软注意力函数

根据实际情况,行人之间的交互可分为三类,如图3所示:对向相遇、对向离开、并排行走。为了涵盖这些典型情况,我们提出了一种新的社交软注意力函数 Fssa(·) 来计算 A t A_t At 中的元素 a i , j t a_{i,j}^{t} ai,jt 来表示行人之间的注意力权重。该过程表示如下:

a i j t = F s s a ( u i t , u j t , cos α t , cos β t , l i j t ) = { max ( 0 , ∣ u i t ∣ cos α t + ∣ u j t ∣ cos β t l i j t ) , i ≠ j θ , i = j \begin{aligned} a_{i j}^{t} &=F_{s s a}\left(u_{i}^{t}, u_{j}^{t}, \cos \alpha^{t}, \cos \beta^{t}, l_{i j}^{t}\right) \\ &=\left\{\begin{array}{ll} \max \left(0, \frac{\left|u_{i}^{t}\right| \cos \alpha^{t}+\left|u_{j}^{t}\right| \cos \beta^{t}}{l_{i j}^{t}}\right), i \neq j \\ \theta, & i=j \end{array}\right. \end{aligned} aijt=Fssa(uit,ujt,cosαt,cosβt,lijt)=⎩⎨⎧max(0,lijt∣uit∣cosαt+∣ujt∣cosβt),i=jθ,i=j

图 3. 三种类型的行人交互。 u t u^t ut 表示节点 v t v^t vt 在时间步 t 处的速度矢量,α 和 β 表示速度矢量和代理之间的连线的角度。 l i j t l^t_{ij} lijt 表示 vti 和 vtj 之间的欧几里得距离。

如图 3 所示, u i t u^t_i uit 表示节点 v i t v^t_i vit 在时间步 t 处的速度矢量,由 ( x i t − x i t − 1 , y i t − y i t − 1 ) \left(x_{i}^{t}-x_{i}^{t-1}, y_{i}^{t}-y_{i}^{t-1}\right) (xit−xit−1,yit−yit−1)得到。α和β分别表示节点vti的速度向量uti和节点vtj的utj之间的角度。 l i j t l^t_{ij} lijt 表示节点 vti 和节点 vtj 之间的欧几里得距离。 θ 是一个超参数,它代表一个代理的自注意力。当我们实现社交软注意力功能时,θ的值根据矩阵At中元素的最大值设置在区间[0.04, 0.16]中。等式 2 是获得新的邻接矩阵 A ~ t \tilde{A}_{t} A~t的归一化过程。

在图 3(a) 中,两个人面对面行走。 α和β都是锐角。 F s s a ( ⋅ ) Fssa(·) Fssa(⋅)的输出大于0,说明这两个人相互影响。

在图 3(b) 中,两人正朝着相反的方向离开。 α和β都是钝角。 F s s a ( ⋅ ) Fssa(·) Fssa(⋅) 的输出限制为 0,表示两人互不影响。

在图 3© 中,两个人并排行走,其中 α 是锐角,β 是钝角。如果黄色行人的速度远高于蓝色行人,未来会有碰撞的风险,那么Fssa(·)的输出大于0。如果黄色行人的速度小于蓝色的那个,不会有碰撞风险,Fssa(·)的输出限制为0。

我们把距离 l i j t l^t_{ij} lijt 放在分母中,以反映碰撞风险的大小。当 α 和 β 取不同的值时,即使是 0° 或 180°,我们的函数仍然可以区分行人交互的不同情况,从而可以通过图卷积网络更好地提取社交交互的特征。

D. Sequential scene attention sharing mechanism 顺序场景注意力共享机制

The extended scene attention:扩展场景注意:

为了充分利用场景信息,我们利用预训练的 CNN 网络来提取场景图像的特征。我们工作中采用的方法类似于[15]。

我们使用预训练的 VGG19 [14] 作为主干网络,提取的特征用 V p h V_{ph} Vph 表示。由于数据集中的图像是由固定摄像机捕获的,因此我们只需要为每个数据集计算一个 V p h V_{ph} Vph 。在之前的工作[14]、[17]中,他们通常选择在t=Tobs时计算场景注意力 C i T o b s C^{T_{obs}}_i CiTobs。为了扩大场景的影响力,我们计算每个时刻 t ∈ {1, 2, 3, . . . , Tob} 根据特征 V p h V_{ph} Vph 和智能体 i i i 的位置 X i t X^t_i Xit。

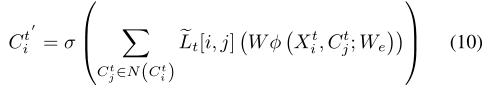

这里, I s c e n e I_{scene} Iscene 表示来自数据集的图像,Wvgg19 是预训练网络的权重, X i t X^t_i Xit 是代理 i 在时间步 t 的位置 ( x i t , y i t ) (x^{t}_{i}, y^{t}_{i}) (xit,yit), W a t t W_{att} Watt 包含场景注意力的参数。然后我们用坐标信息嵌入 C i t C^{t}_i Cit,形成新的图节点特征 v i t v^t_i vit。

其中 φ ( ⋅ ) φ(·) φ(⋅)是嵌入层, W e W_e We是嵌入层的权重。

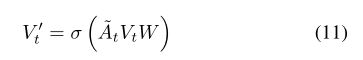

**Graph neural network:**使用上面的图表示,我们在每个时间步 t 执行图卷积操作。图在单个时刻 t 的卷积操作在 GCN [43] 中定义如下:

其中 A t At At是图在时间步 t t t的邻接矩阵, D t Dt Dt是图的度矩阵, E E E是单位矩阵; V t Vt Vt 是在同一时间步由 v i t v^t_i vit作为行向量组成的矩阵。 L ~ t \tilde{L}_t L~t是用于聚合相邻节点的图位移算子,是 A t At At归一化的结果。

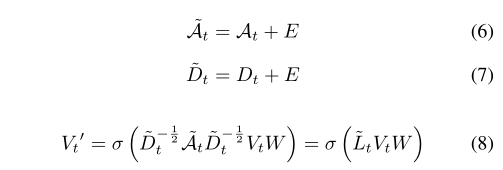

对于单个节点,图卷积操作为:

其中 N ( v i t ) N\left(v_{i}^{t}\right) N(vit)是节点 v i t v^t_i vit的一阶邻居集合, L ~ t [ i , j ] \tilde{L}_{t}[i, j] L~t[i,j]是矩阵 ~Lt 的第 i 行第 j 列中的元素。在聚合 v i t v^t_i vit的邻居特征的过程中, L ~ t [ i , j ] \tilde{L}_{t}[i, j] L~t[i,j]表示 v i t v^t_i vit的权重。

Scene attention sharing场景注意力共享

由于图卷积操作中涉及的节点特征vti嵌入了方程5中的Cti,所以agent的场景注意力共享过程可以表示为:

在这个过程中,场景对代理的影响是通过社交互动来分享的。

在图 4 中,屏障对代理 A 的直接影响是 C1,屏障对代理 B 的直接影响是 C2。在共享过程中,障碍物对A的影响通过A和B的社会关系传递给B。障碍物对Agent B的影响聚合为 C 2 ′ = C 1 + W W e C 2 C_{2}^{\prime}=C_{1}+W W_{e} C_{2} C2′=C1+WWeC2

为了更好地区分不同行人之间的交互,加入社交软注意力功能后,方程9改写为:

其中 ∼At 由等式 2 给出。

E. Trajectory generation

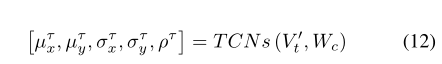

在处理了社交交互和场景交互之后,我们选择 TCNs 来建模社交图序列的时间依赖性 V t ′ = { v i t ′ ∣ ∀ i ∈ { 1 , … , N } } V_{t}^{\prime}=\left\{v_{i}^{t^{\prime}} \mid \forall i \in\{1, \ldots, N\}\right\} Vt′={vit′∣∀i∈{1,…,N}}。就像 Social-STGCNN 一样,我们将时间维度视为特征通道将 vti 0 输入到 TCN 中。经过TCNs的卷积运算,我们得到了 [ T o b s + 1 , T pred ] \left[T_{o b s+1}, T_{\text {pred }}\right] [Tobs+1,Tpred ]期间坐标序列的二维高斯分布参数

其中 µτx, µτy 是坐标的平均值,στx, στy 是方差。 ρτ 是 x 和 y 之间的相关系数。 Wc 是 TCN 的权重。 τ 是 [Tobs+1, Tpred] 中的时间步长。然后我们通过 [ μ x τ , μ y τ , σ x τ , σ y τ , ρ τ ] \left[\mu_{x}^{\tau}, \mu_{y}^{\tau}, \sigma_{x}^{\tau}, \sigma_{y}^{\tau}, \rho^{\tau}\right] [μxτ,μyτ,σxτ,σyτ,ρτ] 构造一个二维高斯分布 N,对分布进行采样就可以得到未来的坐标。

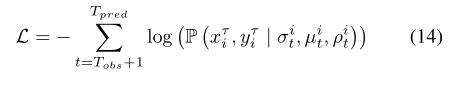

损失函数我们使用ground truth值xτi、yτi和高斯分布的预测参数来计算负对数似然损失来指导模型训练。

IV. EXPERIMENT AND EVALUATION

我们对广泛使用的基准数据集进行评估实验,并将结果与其他最先进的方法进行比较。

具体来说,我们使用 ETH [44] 和 UCY [45] 数据集,其中包含以下场景,ETH、HOTEL、UNIV、ZARA1 和 ZARA2。

数据属性包括帧数、行人数和轨迹坐标的二维位置。这些轨迹彼此间隔 0.4 秒。与 Social-LSTM [9] 类似,我们也输入了 8 个时间步(3.2 秒)的轨迹并预测接下来的 12 个时间步(4.8 秒)。为了验证所提出的方法能够处理各种场景,我们还在斯坦福无人机数据集(SDD)[46]上进行了实验,其中包含大量不同的场景。此数据集中的跟踪坐标以像素为单位。我们使用与 [47] 相同的标准数据分割设置。

A. Experiment

Evaluation criteria.评估标准沿用其他基线方法采用的策略,我们使用留一法进行评估实验,在四个数据集上进行训练并在剩余的一个数据集上进行测试。平均位移误差 (ADE) 和最终位移误差 (FDE) 用作标准度量,定义为:

Implementation details. SSAGCN 中使用的 GCN 的结构类似于 [19]。

我们利用数据处理中的坐标信息,通过社会软注意力函数计算加权邻接矩阵。当加权邻接矩阵归一化时,R设置为0.10。场景注意力的维度为8,坐标维度为2。因此,嵌入层的输入维度为10。我们将嵌入层的输出维度设置为5,对应高斯分布中的参数个数。

TCNs的输入和输出维度分别对应输入序列和预测序列的时间维度。为了避免过度平滑,我们只使用了一层 GCN 和六层 TCN。

最后,我们使用 SGD 优化器和 0.001 的学习率在 Tesla V100 GPU 上训练 SSAGCN 模型 200 个 epoch。

B. Quantitative analysis定量分析

我们选择最先进的方法作为基线。

S-LSTM [9]:一种基于使用巧妙池化机制的预测方法的 LSTM 网络。

SGAN [42]:一种将 GAN 引入行人轨迹预测并使用全局池进行交互的方法。

SR-LSTM [12]:一种使用 LSTM 网络状态细化的预测方法。

Sophie [14]:使用注意力机制同时考虑场景因素和社会因素的基于 GAN 的预测方法。

STGAT [17]:一种基于序列到序列架构的时空图注意力网络,用于预测行人的未来轨迹。

Social-BiGAT [18]:一种采用循环对抗结构并引入一个图注意力网络来计算行人之间影响的方法。

Social-STGCNN [19]:一种将行人轨迹建模为图形并使用 STGCN 处理社交互动的方法。

RSBG [38]:提出了一种结合 GCN 的递归社交行为图来模拟社交互动。

NMMP [47]:提出了一种用于交互式建模的神经运动消息传递,可以预测各种场景中的未来轨迹。

Star [48]:引入了一种新颖的空间图变换器来捕捉行人之间的交互。

PECNet [51]:一个两阶段的预测框架,用于预测轨迹的终点,然后进行合理的路径规划。

SCAN [20]:一种空间上下文注意网络,可以联合预测场景中所有行人的社会可接受的多个未来轨迹。

CARPe [50]:一种用于实时行人路径预测的卷积方法,它利用了 Graph Isomorphism Networks 的变体与敏捷卷积神经网络设计相结合。

SGCN [41]:一种使用稀疏图卷积和自注意力机制计算不对称注意力得分矩阵的行人路径预测方法。

GTPPO [52]:一种基于图形的伪预言机轨迹预测器 (GTPPO),它使用短记忆单元和长记忆单元对行人运动模式进行编码,并引入时间注意力以突出特定的时间步骤。

Trajectron++ [49]:一种旨在与机器人规划和控制框架紧密集成的方法,它可以产生可选地以 egoagent 运动计划为条件的预测。

Introvert [53]:一种使用 3D 视觉注意机制捕捉动态场景上下文的行人轨迹预测方法。

LB-EBM [54]:基于潜在信念能量的模型 (LB-EBM),用于多种人类轨迹预测。

Y-Net [55]:一种符合场景的轨迹预测模型,利用所提出的认知和任意结构在长预测范围内进行不同的轨迹预测。

我们将实验结果与上述基线方法进行了比较,它们的 ADE 和 FDE 如表 I 所示。

与这些方法相比,我们的方法在 K = 1 和 K = 20 时取得了最佳性能。K = 1 表示模型只生成一条轨迹,而 K = 20 表示模型预测 20 条轨迹或样本 20 次。

从表一可以看出,Trajectron++由于其先进的预测框架和独特的建模方法,在过去一直走在前列,与同期方法相比,ADE和FDE下降了近45%。最近的方法如 SGCN、Introvert 和 LB-EBM 为轨迹预测提供了新的研究思路。

SGCN 引入稀疏图卷积网络并结合自注意力机制,与其他基于 GCN 的方法相比,ADE 和 FDE 降低了 15%。

Introvert 将轨迹预测转换为 3D 域,专注于动态场景上下文,与 Trajectron++ 相比,FDE 减少了 17%。

我们的模型使用定制的社交软注意力功能,涵盖了各种行人社交互动因素,使我们的模型能够更好地学习行人之间的社交互动。此外,我们的模型增加了场景图像的输入,扩展了场景在时间和空间上的作用。由于上述新贡献,我们的模型取得了最先进的结果,与之前的基线相比,ADE 减少了 17%,FDE 减少了 11%。

表 II 显示了我们的方法在 SDD 数据集上与其他方法相比的性能。可以看出SSAGCN在SDD上的性能与其他baseline方法相比也具有竞争力,FDE处于最低水平。事实上,SDD数据集中的障碍物和道路信息非常丰富,场景信息的输入可以为轨迹预测提供很大帮助。 Y-Net 模型包含场景图像的输入,其结果在 ADE 中减少了 20%,在 FDE 中减少了 25%。我们的SSAGCN也以场景图像为输入,增强了物理场景在时空空间中的作用,这使得我们的预测结果在FDE上比Y-NET低0.05。

此外,我们使用 SoPhie [14] 使用的接近碰撞百分比(两个行人之间的距离是否小于 0.1m)来进一步评估我们的结果,如表 III 所示。在这种新的评估方法方面,我们的方法完全超越了其他方法,这表明它可以为每个行人生成更好的社会和物理可接受的轨迹。

C. Ablation study

我们设置了两组对比实验来证明新的社会软注意力功能的有效性。表 I 中的 SSAGCN-w/o-ssa 显示了直接使用相邻矩阵 Ati 聚合节点特征而没有我们的社会软注意力功能的结果。结果表明,社会软注意功能的作用是积极的。此外,我们进一步使用社交软注意力函数代替 Social-STGCNN 的核函数。结果示于表IV中。大多数结果在 ADE 和 FDE 上都优于原始的 Social-STGCNN

SOCIAL-STGCNN 在 ETH 和 UCY 数据集上使用不同内核函数得到的比较结果。第一列是 SOCIAL-STGCNN 的原始版本。第二列是具有我们社交软注意力功能的 SOCIAL-STGCNN。

此外,当我们实现社交软注意力功能时,我们使用超参数 θ 来指定矩阵 Ati 中对角线元素的值。对角元素的值是指行人对自身的影响。当我们实现SSAGCN时,我们取区间[0.04,0.16]内的θ值,其中值是社交软注意力函数计算的非对角元素的最大值。在图 5 中,我们从上述区间中取 7 个不同的 θ 值进行实验。随着 θ 从 0.16 降低到 0.1,模型的性能提高。随着我们进一步下降,该模型开始看起来很糟糕。随着 θ 从 0.1 继续减小,模型的性能会下降。

为了证明社会软注意力函数的合理性,我们使用速度、方向和距离的不同组合进行消融实验。实验结果如表五所示。可以看出,简单地考虑更多的因素并不能取得更好的结果。节点之间的影响仍然以它们之间的距离为主。但是,仅仅通过距离来区分不同节点的影响是不合理的。我们的函数通过以合适的形式组合更多的影响来获得更好的结果。

功能 Fssa 的消融结果。式1中的变量对应的速度、方向和距离。 √表示该变量在实验期间已纳入Fssa,×表示不涉及。

为了进一步验证我们的方法在探索场景信息方面更有效,我们实施了顺序场景注意力共享机制的消融实验(如表一所示)。表 I 中的 SSAGCN-w/o-sen 显示了没有顺序场景注意力共享的评估结果,SSAGCN 是我们完整模型的结果。可以看出,由于高效的场景共享,平均 ADE 和 FDE 分别提高了 16% 和 11%。此外,为了进一步展示序列场景注意力的优势,我们还设计了一个名为 STGCNN-w/o-seq 的实验装置,它仅使用历史轨迹的最后一帧来计算场景的影响,并将其与完整版。结果表明,考虑顺序注意力共享的影响而不仅仅是一个单一的帧更有利。

我们方法中的 GCN 结构和社会软注意功能是基于先验知识的。与 GA T 和 SGCN 等学习方法相比,它的参数更少,速度更快。我们进行了一组实验,用 GA T 替换我们方法中的 GCN 和社会软注意力功能。由于 SGCN 和 Social-STGCNN (SSTGCNN) 不包含关于场景的模块,我们的模型结果如表 VI 所示还有没有场景信息的版本。可以看出,基于先验知识的行人交互建模方法,SSAGCN和STGCNN,比前面专栏中使用注意力机制的方法参数更少,推理速度更快。值得一提的是,我们的模型和 SSTGCNN 的参数数量相似,但我们模型的预测速度比该表中的其他方法要快。

D. Qualitative analysis定性分析

定量分析结果表明我们的模型具有较高的准确性。此外,我们实施了定性分析,以表明生成的轨迹具有更好的社会可接受性和物理合理性。如图 6 和图 7 所示,我们从测试数据集中选择了一些具有代表性的案例。

Social acceptability社会接受度

在图 6 中,我们选择了并行、遭遇和混合案例。

在图 6 的第一列中,平行的行人通常保持相同的运动状态。在这种情况下,基于位置的池化构建的 SGAN 模型会产生过度回避的错误预测。基于注意力的方法,例如 Sophie 和 SGCN,由于自注意力,往往会保持原始状态,并且对转向不敏感。 Social-STGCNN 成功预测了运动趋势,但准确率不高。

在图 6 的第二列中,从相反方向相遇的行人应该有一些避免碰撞的趋势。但只有我们的方法和 Social-STGCNN 显示出避免碰撞的趋势。

在图 6 的第三列中,行人在行人平行和相遇的混合情况下应在避免碰撞和保持原始状态之间取得平衡。这对轨迹预测来说是一个巨大的挑战。从图 6 可以看出,在这种复杂情况下,所有模型都无法准确预测未来的轨迹。但是我们的方法比其他方法产生的错误更少。上述优势归因于我们方法中的 SSA 函数可以捕捉到更接近真实情况的行人交互规则。

在图 7 中,我们可视化了基于加权矩阵和 GCN 的三种方法的图关系。

我们在第一列中的方法在区分和过滤代理之间的关系方面做得很好。具有较高碰撞风险的代理也具有较大的边权重。具有低碰撞风险的代理之间的边权重很小或为零。由于我们的社交软注意力功能中余弦的限制,并排行走的智能体不会产生边缘。

在第二列中,Social-STGCNN 的核函数的过滤效果非常小,以至于构造的图类似于全连接图。此外,该图中边之间的权重差异非常小。这使得Social-STGCNN在面对复杂情况时无法判断哪个邻居对agent的影响更大。

在 SGCN 的第三行中,相邻节点之间的大部分边被移除,只剩下少量低权重的边。由于自注意力机制的影响,SGCN建立的大部分图关系邻接矩阵中,只有对角线元素有权重。因此,SGCN的预测结果一般倾向于保持原始运动状态。从图7的对比结果可以看出,我们的方法建立的图更合理,更能区分和过滤社交互动。

以不同方法可视化图形关系。每个蓝色节点对应一个行人,与节点本身相连的边未绘制。蓝色虚线代表行人的历史轨迹(8帧),红色虚线代表ground truth(12帧)。边缘的颜色是根据右边的颜色条设置的,它描述了边缘的权重。边缘的权重越大,行人之间的影响越大。

Physical rationality生理理性

众所周知,合理的预测应该符合现实的物理规则。

在图 8 中,我们将 SDD 数据集上的预测结果可视化,以显示模型对场景的响应。 SDD包含大量道路和障碍物,行人相对较少。因此,场景图像的输入对于SDD上的轨迹预测起着更重要的作用。我们的模型以二进制语义形式作为输入场景图像,并在每个时刻计算场景注意力,因此我们预测结果中的整个轨迹都会受到场景的影响。此外,我们模型中的场景共享机制使场景的影响不局限于局部区域。

例如图 8 中的 2,道路的限制是由道路边界的行人传递给路中间的行人,从而使道路中间的行人与边界保持一定距离。

在图 8 的第三列中,示例 3 和示例 6 显示了失败案例。例 3 中,两个行人直接相遇,不闪避保持距离,而在我们的预测中,两个行人应该转向以避免碰撞。在示例 6 中,行人直接走向障碍物,然后停下来休息,而我们的预测得出的结论是他应该绕过障碍物。即使在这种具有挑战性的情况下,我们的方法预测的轨迹仍然符合物理规则。我们预测,相遇的两个人会顺着路走,避免碰撞,而一个人直行会避开障碍物。这表明我们的模型在大多数情况下可以产生合理的预测轨迹。

图 8. 我们方法在 SDD 上的轨迹预测的可视化。绿色虚线是我们方法预测的单个轨迹,红色虚线是ground truth(12帧),蓝色虚线是历史轨迹(8帧)。数据处理。

V. CONCLUSION

在本文中,我们提出了轨迹预测模型SSAGCN,它综合考虑了多种社会因素和序列场景信息,以获得准确合理的预测轨迹。在处理行人的社交互动时,我们使用坐标数据计算行人速度、方向和距离的关系,然后使用社交软注意力函数计算行人之间的影响。在考虑场景的上下文时,我们意识到场景信息应该影响每一刻的轨迹,场景交互应该与社交交互同时发生。因此,我们计算场景中每个时刻的注意力,然后将顺序的场景注意力注意力嵌入到社交图谱中,使场景的影响根据社交关系在图谱中共享和传播。在公共数据集上的实验和评估结果表明,由于新的社交软注意力功能和场景注意力共享机制,我们的方法在大多数数据集上都取得了最好的效果。定性分析证明,我们的模型可以预测所有行人在社会和身体上都能接受的轨迹。

在我们的方法中,社会软注意力功能是社会力量的延伸。根据实际规律,量化行人与碰撞风险之间的交互作用,并将其应用于GCN中邻接关系的区分和过滤。我们在图关系的可视化中展示了社会软注意力函数的合理性。我们的预测模型可以在各种情况下预测出合理的预测结果,因此可用于复杂场景下的轨迹预测,为自动驾驶平台的防撞提供参考。在我们的效率对比实验中,我们可以看到,对于大多数预测方法来说,面对复杂密集的场景,它们的效率并没有那么高。未来,我们将专注于在交通密集的场景中提高预测方法的预测效率和准确性。一个有希望的改进是在复杂场景中使用社会关系的子图建模来减少计算冗余并提高效率和准确性。

这篇关于行人轨迹论文阅读SSAGCN: Social Soft Attention Graph Convolution Network for Pedestrian Trajectory Prediction的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!