外参专题

【学习记录】autoware标定相机与激光雷达外参

一、autoware选择 这里踩了好几个坑,首先autoware作为一个无人驾驶知名框架,其内部实际上是有两套标定的东西的,这一点绝大多数博客没有提到。其中最常用的是一个叫标定工具箱的东西,这个ros包已经在1.10往后的版本中被删掉了,所以网上的资料都是基于前人提取出来的代码进行单独编译然后运行,这种标定方法需要用到标定板,个人感觉比较麻烦,用这个标定工具箱,最好是在车上的工控机直接装好相应的

VIO外参标定方法总结

一、前言 VIO外参标定是指相机和IMU之间的转移矩阵的确定,包括3×3的旋转矩阵和3维平移向量。整体上分为离线标定和在线标定两类方法,这篇文章做一个总结,主要是经典的方法,记录其思想。 二、博文链接 1、离线标定方法 最基本的当然就是人工手动标定了,但这样不仅费力,并且误差大不够准确,作为初始猜测还可以。 VIO最知名的离线标定工具就是Kalibr了。 GitHub - ethz-a

相机内参和相机外参和标定

在单目视觉系统中,最重要的参数之一是相机的内参坐标,它反映了环境信息到图像信息之间的映射关系,一个精确的内参系数是通过单目相机对观景进行观测和测量的首要保证,相机内参系统与相机感光片位置,镜头位置等有关系,虽然在制作相机时可以生产指定标准的元器件并按照指定的尺寸装配摄像头,通过这些标准可以计算出摄像头的内参,但不幸的是,由于工艺水平有限,元器件尺寸与标准值存在误差,同时装配位置也会与期望值存在偏差

r3live 使用前提 雷达-相机外参标定 livox_camera_lidar_calibration

标定的是相机到雷达的,R3live下面配置的雷达到相机的,所以要把得到外参旋转矩阵求逆,再填入,平移矩阵则取负 港科大livox_camera_calib虽然操作方便,但是使用mid360雷达会有视角问题(投影三维点到相机),尝试了很多场景,标定效果都不理想(推荐场景是楼梯间),看来港大的更适合avia之类窄角度的雷达。livox_camera_lidar_calibration标定效果还不错,但

在ros2中获取两个坐标系的外参关系

在终端中,你可以使用 ros2 命令行工具来查看两个坐标系之间的外参关系。这通常通过 tf2_ros 包中的 tf2_tools 来完成。以下是如何在终端中获取两个坐标系之间的外参关系的步骤: 首先,确保你的 ROS 2 系统正在运行,并且正在发布你感兴趣的坐标系的转换信息。 打开一个新的终端窗口。 使用 ros2 run tf2_ros tf2_echo 命令来监听两个坐标系之间的转换。

在ros中获取两个坐标系的外参关系

文章目录 1. 使用tf_echo命令行工具2. 在ROS节点中编程获取3. 使用RViz查看4. 使用tf2_ros库 1. 使用tf_echo命令行工具 tf_echo可以在命令行中直接查看两个坐标系之间的变换信息。如果你想看frame1到frame2的变换,可以使用如下命令: rosrun tf tf_echo frame1 frame2 这会显示frame1相对于f

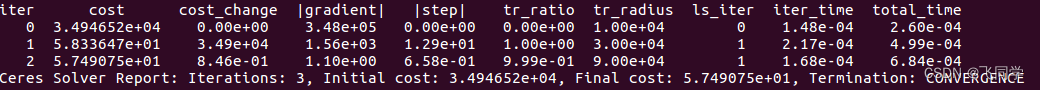

【雷达相机外参标定】direct_visual_lidar_calibration安装

direct_visual_lidar_calibration安装 主页安装ubuntupclOpenCVceres其他依赖fmtdirect_visual_lidar_calibration 标定雷达和相机时使用direct_visual_lidar_calibration。 主页 https://github.com/koide3/direct_visual_lidar_

双目立体视觉---双目标定(内参和外参)

目的:求左右相机内参数矩阵M、畸变系数矩阵D、右摄像头相对于左摄像头的平移向量 T和旋转矩阵R. 步骤: 1. 左右分别单目标定->M、D----焦距,图像中心(fx, fy, cx, cy)畸变系数([k1,k2,p1,p2,k3])和 2.求右摄像头向左摄像头的平移向量 T 和旋转矩阵 R. 原理: 以上参数为 接下来的立体校正使用。 以上各个参数的求解过程就是双目相机的

单、双激光雷达启动与双激光雷达的外参标定(VLP-16)

本文旨在帮助读者迅速完成双Velodyne16激光雷达的启动与外参标定!所用到的标定方法是NDT扫描匹配算法。废话不多说,直接开始! 一、单激光雷达的启动 #安装velodyne的ros依赖sudo apt-get install ros-melodic-velodyne#进入工作空间克隆velodyne包git clone https://github.com/ros-drivers/v

标定之相机的内参和外参

我理解错了,相机内参矩阵和相机畸变参数是两个东西,而且好像实际pnp好像没有用到相机的外参矩阵。 内参我觉得主要就是指畸变参数。畸变又分为径向和切向畸变。畸变应该是比较好理解的对吧。 https://blog.csdn.net/sunboyiris/article/details/78082699 https://blog.csdn.net/sinat_16643223/article/

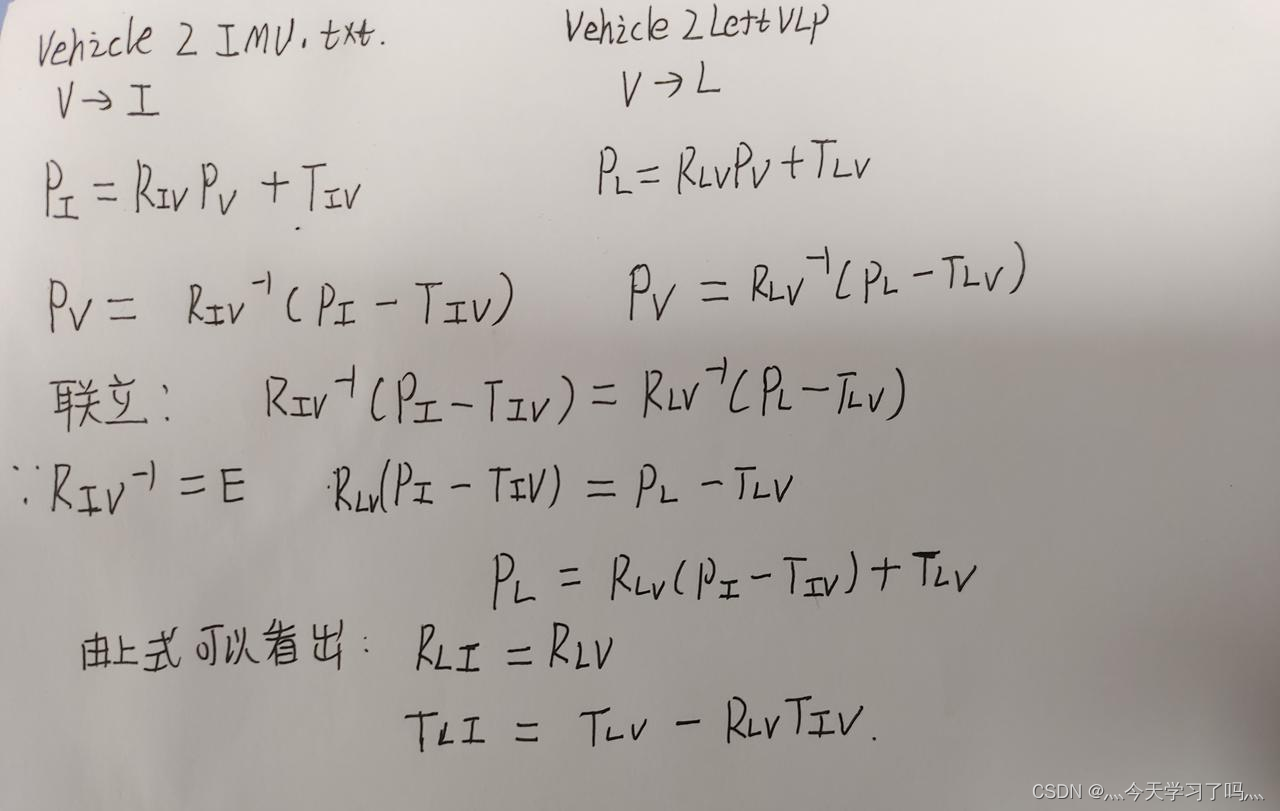

kaist数据集雷达和imu外参计算

跑lio-sam要计算imu和雷达外参 根据数据集提供的文件 根据文件名确定旋转矩阵下标 得出结果:(将imu数据转到雷达坐标系下) T:[ 0.360723,-0.431236, 0.687047] R:[-0.515105, -0.702383,-0.491249, 0.487008, -0.711468, 0.506593, -0.70533, 0.0217062, 0.708547] 不知

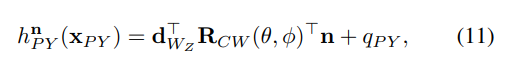

经典文献阅读之--Online Extrinsic Camera Calibration for Temporally Consistent IPM (IPM外参标定)

0. 简介 对于视觉而言,如何使用鸟瞰图来完成车道线的识别和标定是非常重要的,对于鸟瞰图来说,其实有很多种,之前读者的博客中也已经提到过《逆透视变换(IPM)多种方式及代码总结》、《IPM 鸟瞰图公式转换与推导》。这个当然内容还是不太详细,对于各位想要复现难度会比较大,这个时候可以看一下《单应矩阵的推导与理解》这篇文章的详细推导。其实只需要知道精确的外参和内参,以及相机的高度,以及期望的W和H(

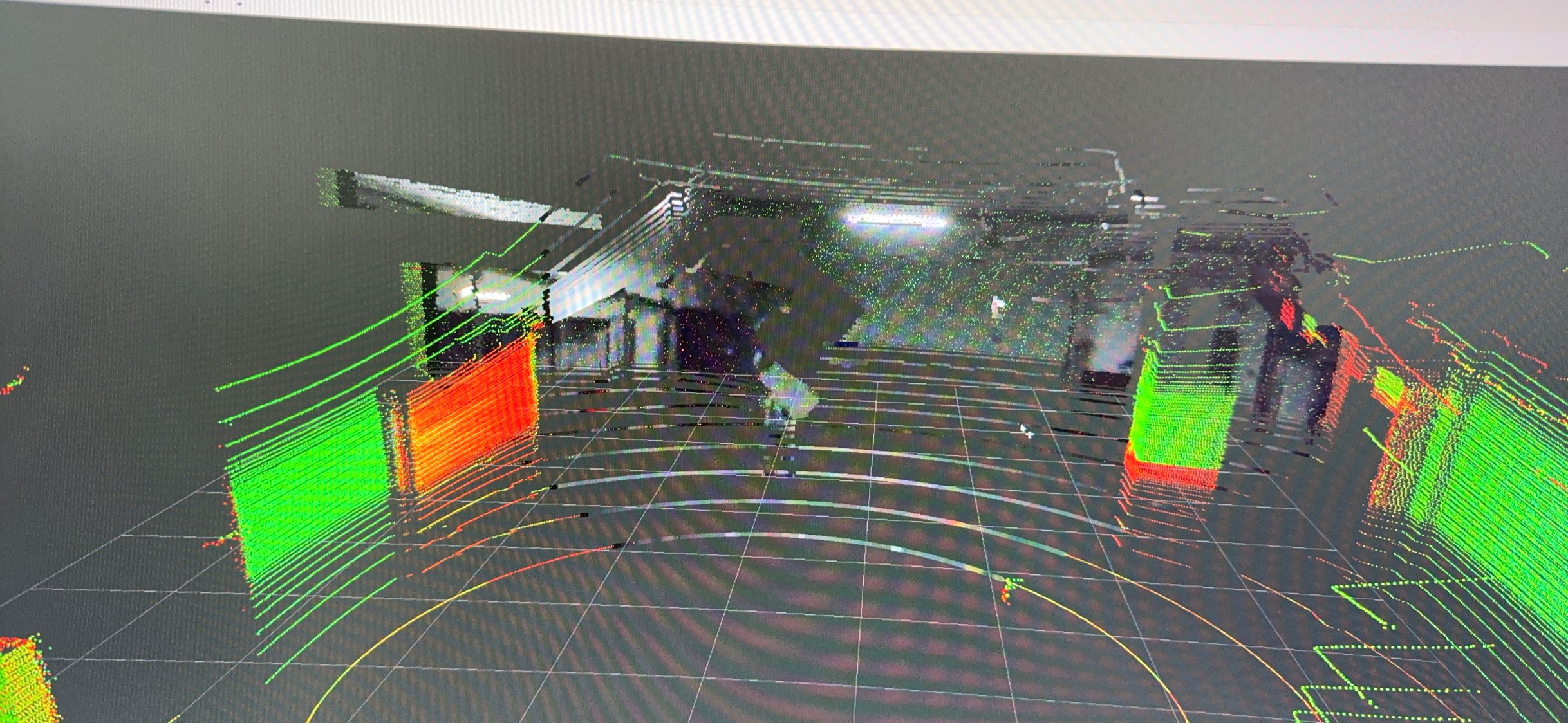

自动驾驶系统进阶与项目实战(二)多激光雷达外参自动化标定算法及代码实例

自动驾驶系统进阶与项目实战(二)多激光雷达外参自动化标定算法及代码实例 激光雷达是目前自动驾驶系统中的核心传感器之一,但是由于其信息密度低、存在垂直盲区等问题,厂商大多在其L4级自动驾驶系统中搭配多组激光雷达,下图为通用(Cruise)的自动驾驶汽车,采用了多激光雷达以弥补lidar+camera的不足,使用多激光雷达进行环境感知的前提是对各雷达的外参进行精准的标定,本文介绍一种基于NDT算法

计算机视觉之相机成像几何模型(原理)与相机标定内参和外参(代码)

文章目录 相机成像几何模型(原理)相机标定内参和外参(代码)遇到的一些问题结语 相机成像几何模型(原理) 一、四大坐标系及目的 四大坐标系:世界坐标系(测量坐标系),相机坐标系,图像坐标系(胶卷坐标系,连续值),像素坐标系。 目的:用数学方式描述3D点如何投影到2D像素坐标系中(正投影:Forward projection),以及反过来的投影过程(Back projectio

python实现外参标定的思路

import numpy import cv2# 准备已知的3D点和它们在图像中的对应点# 比如世界坐标点四个三维坐标为world_points = np.array([[0, 0, 0],[1, 0, 0],[0, 1, 0],[1, 1, 0]], dtype=np.float32)image_points = np.array([[100, 100],[200, 100],[100

如何进行lidar和imu的外参标定

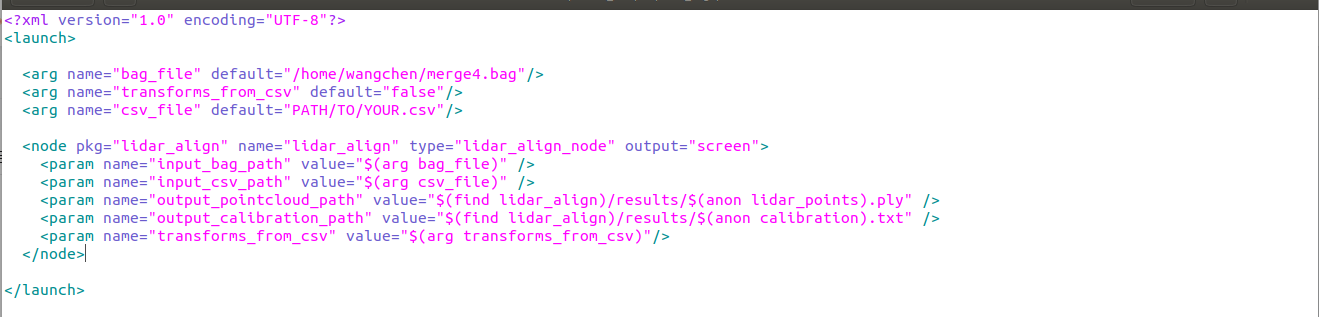

我们使用的lidar_align这个算法来进行标定。 1.下载源码 在ros工作空间下的src文件夹下运行这个命令。 git clone https://github.com/ethz-asl/lidar_align.gitsudo apt-get install libnlopt-devcd ..catkin_make 这里编译的时候会爆一些错误。我遇到的是: 这是因为我们没有

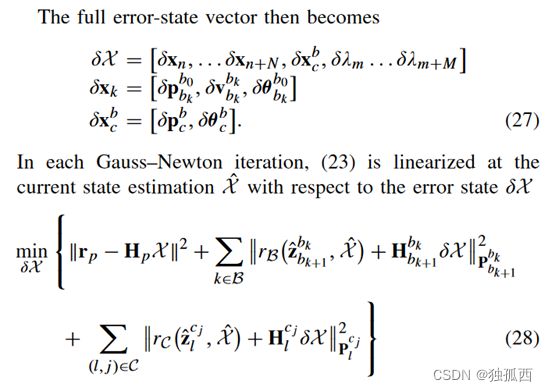

解放双手——相机与IMU外参的在线标定

本文作者 沈玥伶,公众号:计算机视觉life,编辑部成员 一、相机与IMU的融合 在SLAM的众多传感器解决方案中,相机与IMU的融合被认为具有很大的潜力实现低成本且高精度的定位与建图。这是因为这两个传感器之间具有互补性:相机在快速运动、光照改变等情况下容易失效。而IMU能够高频地获得机器人内部的运动信息,并且不受周围环境的影响,从而弥补相机的不足;同时,相机能够获得丰富的环境信息,通过视觉匹

最小二乘法——拟合平面方程(深度相机外参标定、地面标定)

1.最小二乘法 最小二乘法(又称最小平方法)是一种数学优化技术。它通过最小化误差的平方和寻找数据的最佳函数匹配。利用最小二乘法可以简便地求得未知的数据,并使得这些求得的数据与实际数据之间误差的平方和为最小。最小二乘法还可用于曲线拟合。其他一些优化问题也可通过最小化能量或最大化熵用最小二乘法来表达。 最小二乘法的矩阵形式为: A x = b Ax=b Ax=b 其中 A A A 为