单目专题

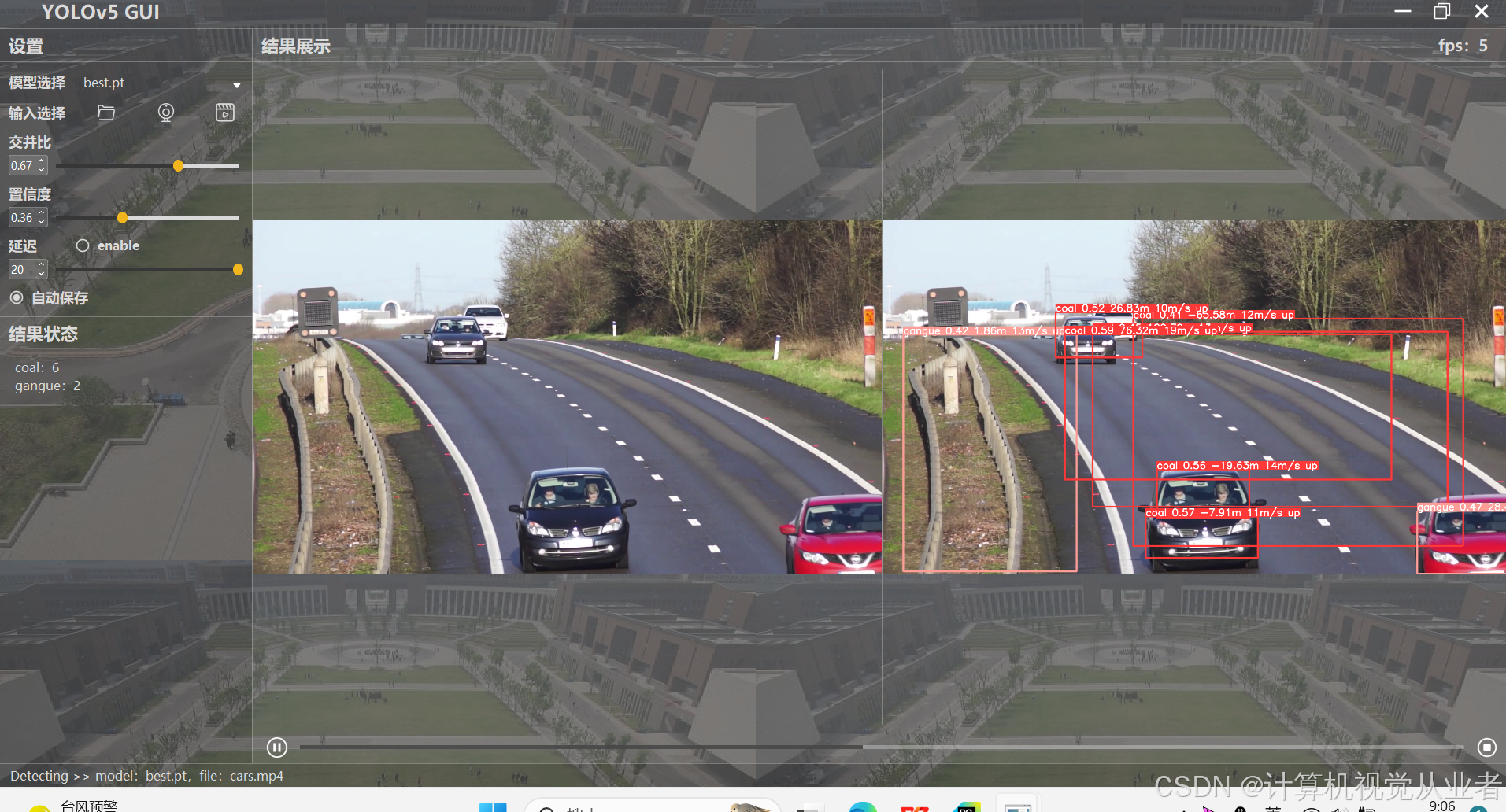

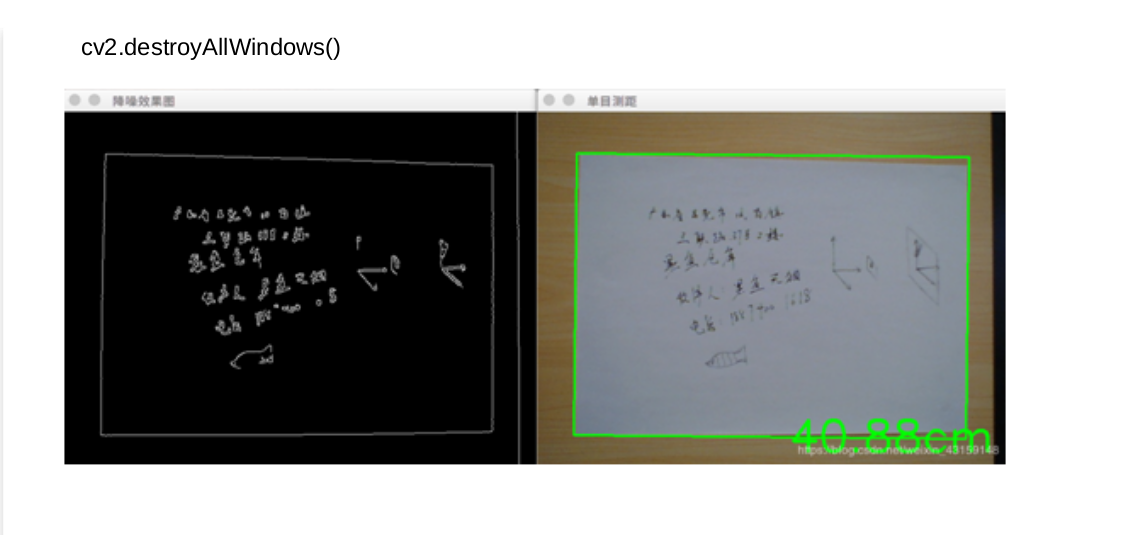

yolov5 +gui界面+单目测距 实现对图片视频摄像头的测距

可实现对图片,视频,摄像头的检测 项目概述 本项目旨在实现一个集成了YOLOv5目标检测算法、图形用户界面(GUI)以及单目测距功能的系统。该系统能够对图片、视频或实时摄像头输入进行目标检测,并估算目标的距离。通过结合YOLOv5的强大检测能力和单目测距技术,系统能够在多种应用场景中提供高效、准确的目标检测和测距功能。 技术栈 YOLOv5:用于目标检测的深度学习模型。Open

ADAS---基于检测框的单目测距方法

1.1.模型求解法方法解读: Yolo模型可以输出被检测物体的置信度、类别及检测框的中心点坐标(xc,yc)及宽高(w,h)等信息,选取车辆检测框底部的中点作为距离测量的特征点,其计算公式如下: 车辆测距示意图如下: 图中,为相机靶面中心点,为相机光心,车载相机安装高度为 H,焦距为 f,俯仰角为β,为 γ,点与光轴投影的夹角为。为点到点的水平距离,;为点与图像中心点的垂直距离,。为

7 自研rk3566/rk3588+rgbd相机之单目双目相机标定库开发与移植

自研rk3566/rk3588+rgbd相机之单目双目相机标定库开发与移植 1、单目双目标定介绍2、单目双目标定测试程序自动棋盘角点棋盘格检测算法 auto_cam.h自动棋盘角点棋盘格检测算法 auto_cam.cpp 3、单目双目标定程序移植makefile测试程序接口 4、测试图像 1、单目双目标定介绍 RGBD相机进行图像与点云融合前需要进行单目相机和双目相机的标定。单目

基于道路标线的城市环境单目定位

文章:Monocular Localization in Urban Environments using Road Markings 作者:Yan Lu Jiawei Huang Yi-Ting Chen Bernd Heisele 编译:点云PCL 本文仅做学术分享,如有侵权,请联系删除。欢迎各位加入免费知识星球,获取PDF论文,欢迎转发朋友圈。内容如有错误欢迎评论留言,未经允许请勿转载!

Depth Anything V2:抖音开源高性能任何单目图像深度估计V2版本,并开放具有精确注释和多样化场景的多功能评估基准

📜文献卡 题目: Depth Anything V2作者: Lihe Yang; Bingyi Kang; Zilong Huang; Zhen Zhao; Xiaogang Xu; Jiashi Feng; Hengshuang ZhaoDOI: 10.48550/arXiv.2406.09414摘要: This work presents Depth Anything V2. With

Matlab 单目相机标定(内置函数,棋盘格)

文章目录 一、简介二、实现代码三、实现效果参考资料 一、简介 具体的标定原理可以参阅之前的博客Matlab 单目相机标定(内置函数),这里实现对棋盘格数据的标定过程。 二、实现代码 getCameraCorners.m function [camCorners, usedImIdx, imCheckerboard] = getCameraCorners(cali

3、matlab单目相机标定原理、流程及实验

1、单目相机标定流程及步骤 单目相机标定是通过确定相机的内部和外部参数,以便准确地在图像空间和物体空间之间建立映射关系。下面是单目相机标定的流程及步骤: 搜集标定图像:使用不同角度、距离和姿态拍摄一组标定图像,并确保标定板(可以是棋盘格或者圆形标定板)完整可见。提取标定板角点:使用相机标定软件或者编程工具,对标定图像进行处理,提取出标定板上的角点位置。生成标定板坐标系:将标定板的实际尺寸和布置

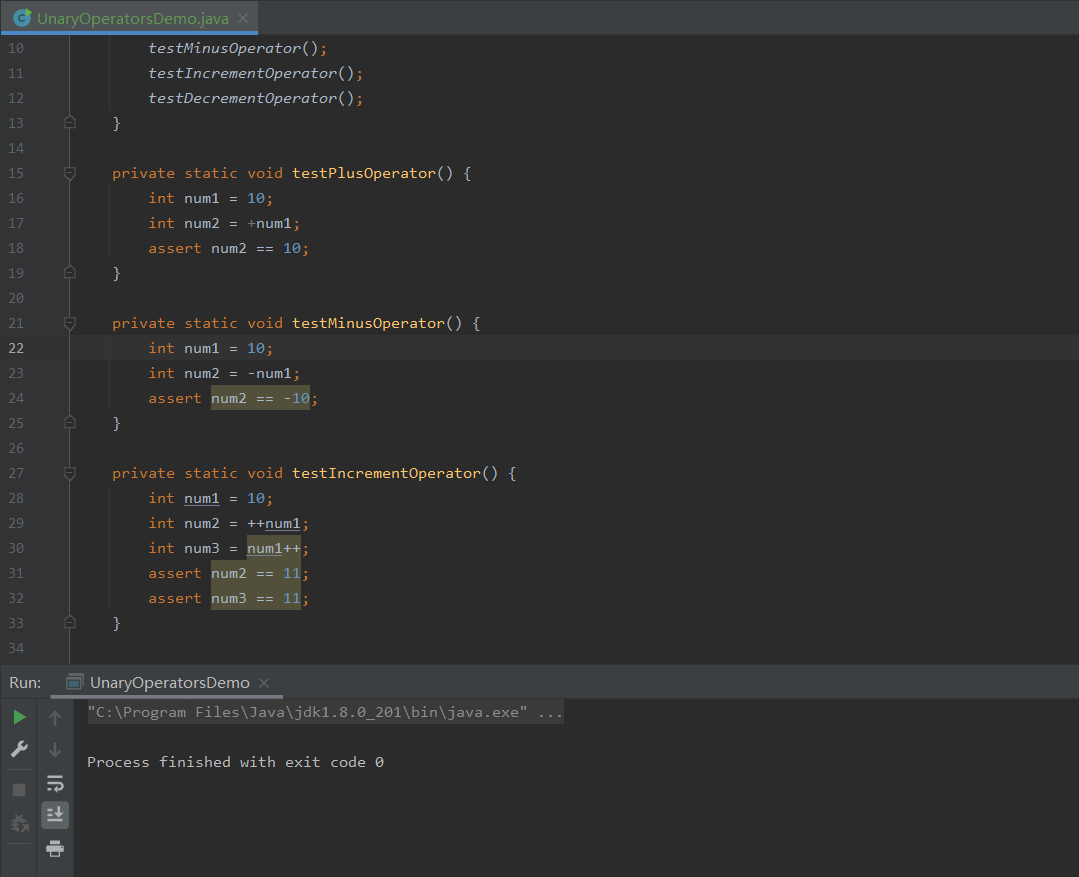

Java中常用的单目运算符及用法详解

哈喽,各位小伙伴们,你们好呀,我是喵手。运营社区:C站/掘金/腾讯云;欢迎大家常来逛逛 今天我要给大家分享一些自己日常学习到的一些知识点,并以文字的形式跟大家一起交流,互相学习,一个人虽可以走的更快,但一群人可以走的更远。 我是一名后端开发爱好者,工作日常接触到最多的就是Java语言啦,所以我都尽量抽业余时间把自己所学到所会的,通过文章的形式进行输出,希望以这种方式帮助到更多的初

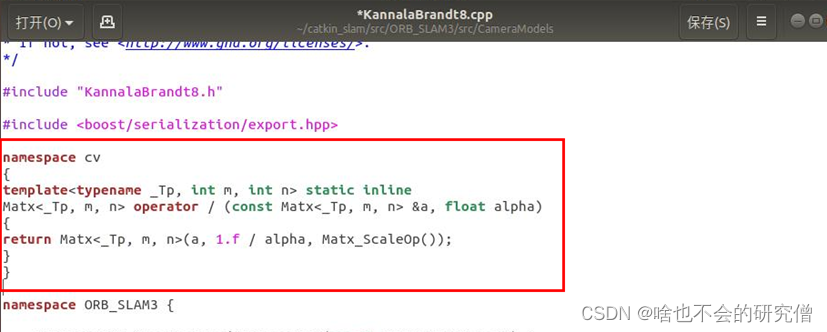

VMware虚拟机中ubuntu使用记录(10)—— 如何在Ubuntu18.04中使用自己的单目摄像头运行ORB_SLAM3(亲测有效,踩坑记录)

提示:文章写完后,目录可以自动生成,如何生成可参考右边的帮助文档 文章目录 前言一、ORB_SLAM3源码编译二、ORB_SLAM3实时单目相机测试1. 查看摄像头的话题2. 运行测试 三. 运行测试可能的报错1. 报错一(1) 问题描述(2) 原因分析(3) 解决 2. 报错二(1) 问题描述(2) 解决 前言 本次教程运行ORB_SLAM3,所需的环境如下:

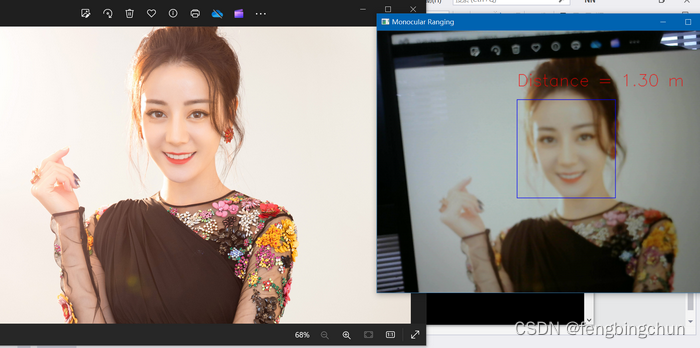

通过三角形相似原理实现单目测距

根据三角形相似原理计算相机焦距,公式为:F = (P * D) / W 其中: F: 待求的相机的焦距 P: 图像中目标的宽度,单位像素 D: 真实目标与相机的距离,单位厘米 W: 真实目标的宽度,单位厘米 计算焦距前,首先要有一幅带目标的图像,这里以人脸为例,记下采集此幅图像时,相机与人脸的实际距离D

通过MediaPipe+MiDaS实现人脸单目测距

MediaPipe:是Google开发的适用于直播和流媒体的开源、跨平台、可定制的机器学习解决方案。code地址:https://github.com/google/mediapipe ,最新发布版本v0.10.11,license为Apache-2.0。MediaPipe Solutions提供了一套库和工具,供你在应用程序中快速应用人工智能(AI)和机器学习(ML)技术,包括:目标

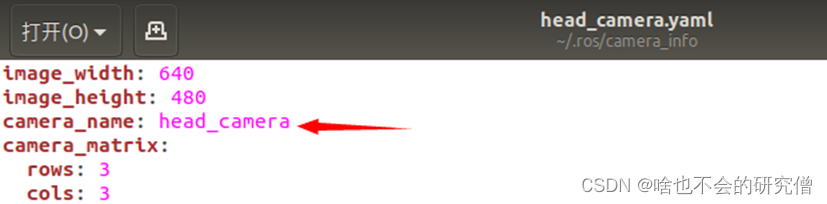

VMware虚拟机中ubuntu使用记录(6)—— 如何标定单目相机的内参(张正友标定法)

提示:文章写完后,目录可以自动生成,如何生成可参考右边的帮助文档 文章目录 前言一、张正友相机标定法1. 工具的准备2. 标定的步骤(1) 启动相机(2) 启动标定程序(3) 标定过程的操作(5)可能的报错 3. 标定文件内容解析 前言 张正友相机标定法是一种通过测量相机拍摄棋盘格上的特征点来计算相机内参和畸变参数的方法。这种标定方法简单易行,能够帮助恢复真实世界中

3D视觉(二):单目摄像头的标定与校正

3D视觉(二):单目摄像头的标定与校正 文章目录 3D视觉(二):单目摄像头的标定与校正一、相机模型1、机器车坐标系到相机坐标系2、相机坐标系到归一化平面坐标系3、归一化平面坐标畸变4、归一化平面坐标系到像素坐标系二、单目摄像头标定三、实验结果四、源码五、相关链接 相机将三维世界中的坐标点(单位为米)映射到二维图像平面(单位为像素),这个过程可用针孔相机模型和透镜畸变模型来刻画

给自己的机器人部件安装单目摄像头并实现gazebo仿真功能

手术执行器添加摄像头 手术执行器文件夹surgical_new内容展示如何添加单目摄像头下载现成的机器人环境文件启动仿真环境 手术执行器文件夹surgical_new内容展示 进入src文件夹下选择进入vision_obliquity文件夹 选择launch 有两个可用gazebo中rviz展示的launch文件,robot.launch是添加有摄像头的手术执行器文件,ro

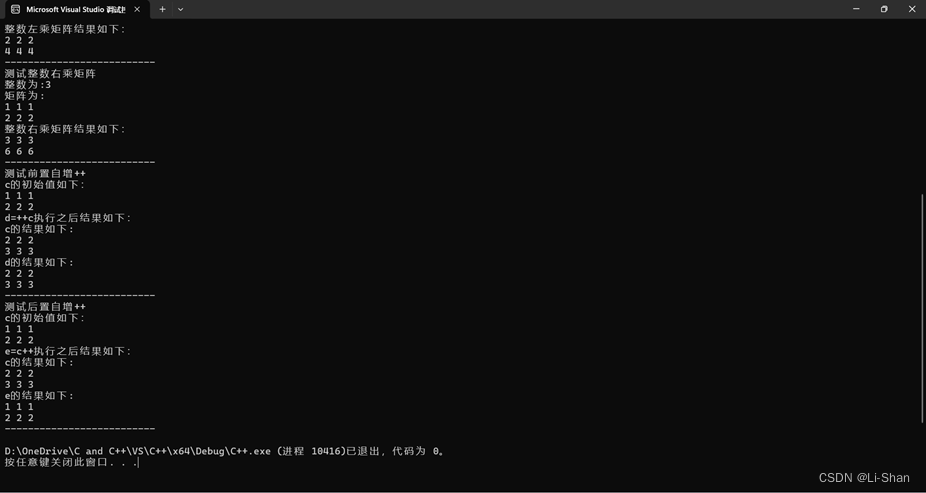

双目运算符和单目运算符的重载

目录 题目 源码 结果示例 题目 建立一个矩阵类,可以完成指定的操作或运算。 说明: 矩阵为2行3列,基类型为整型;操作或运算:初始化(>>)、输出(<<)、赋值(=)、两个同类型矩阵的相加(+)、矩阵前置自增(++,即所有元素都加1)、矩阵后置自增(++,即所有元素都加1)、一个整数乘矩阵(*,即该整数乘以每个元素)、矩阵乘一个整数(*,即每个元素乘以该整数)。 要求:

YOLOv9+单目测距(python)

YOLOv9+单目测距(python) 1. 相关配置2. 测距原理和相机标定2.1 测距原理2.2 相机标定 3. 相机测距3.1 测距模块3.2 测距添加3.3 主代码 4. 实验效果 相关链接 1. YOLOV7 + 单目测距(python) 2. YOLOV5 + 单目测距(python)

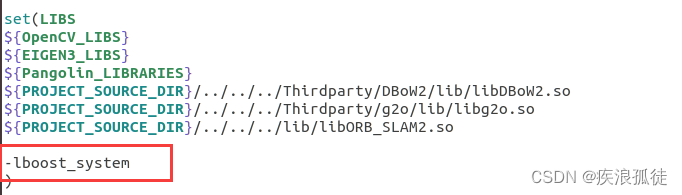

运行ORB-SLAM2(单目+AR)遇到的问题

1. 在运行实时单目时(单目相机的实时图像作为输入数据) 需要在systerm.h的文件头加上#include <unistd.h>,,并且在ros_mono.cc,ros_mono_ar.cc(这个在该文件夹的AR文件夹里面)将 ros::Subscriber sub = nodeHandler.subscribe("/camera/image_raw", 1,&ImageGrabber::G

YOLOv8跟踪分割+单目测距(python)

YOLOv8跟踪分割+单目测距(python) 1. 相关配置2. 测距原理和相机标定2.1 测距原理2.2 相机标定 3. 相机测距3.1 测距模块3.2 测距添加 4. 实验效果4.1 创建主代码4.2 实验效果 相关链接 1. YOLOV7 + 单目测距(python) 2. YOLOV5 + 单目测距(python)

Python OpenCV 单目相机标定、坐标转换相关代码(包括鱼眼相机)

前言 本文不讲原理,只关注代码,有很多博客是讲原理的,但是代码最多到畸变矫正就结束了,实际上就是到 OpenCV 官方示例涉及的部分。 在官方示例中使用黑白棋盘格求解了相机的内外参和畸变系数,并对图像做了畸变矫正,但在实际使用时还缺少很多功能,以下是本文包含的部分: (1)按实际应用场景求解外参,棋盘格的外参是相对于棋盘格的世界坐标系的,无法直接使用; (2)在实际场景下,不使用棋盘格,

【动态三维重建】Deformable 3D Gaussians 可变形3D GS用于单目动态场景重建(CVPR 2024)

主页:https://ingra14m.github.io/Deformable-Gaussians/ 代码:https://github.com/ingra14m/Deformable-3D-Gaussians 论文:https://arxiv.org/abs/2309.13101 文章目录 摘要一、前言二、相关工作2.1 动态场景的神经渲染2.2 神经渲染加速 三、方法3.1

SIFT特征点单目深度估计点云稀疏重建和基于ORB特征的双目重建

SIFT特征的源码并没有开源,但是在opencv_contrib里面有调用的接口: 直接看SIFT特征的翻译吧: SIFT #include <opencv2/xfeatures2d.hpp>Ptr<Feature2D> sift = xfeatures2d::SIFT::create(0, 3, 0.04, 10);// 这四个参数都是按照论文填写 目标是要是实现: 1、在单目不同图像

单目测距+姿态识别+yolov8界面+车辆行人跟踪计数

yolov5单目测距+速度测量+目标跟踪(算法介绍和代码) 1.单目测距实现方法 在目标检测的基础上,我们可以通过计算物体在图像中的像素大小来估计其距离。具体方法是,首先确定某个物体的实际尺寸,然后根据该物体在图像中的像素大小计算其距离。这个方法可以应用于各种不同的场景和物体,如车辆、行人等。 2.速度测量实现方法 通过目标跟踪,我们可以获取连续帧之间物体的位置信息,并计算出物体的速度。在

【单目3D检测】:SMOKE论文

文章目录 1 网络结构1.1 Backbone1.2 检测模块key-point(heatmap)分支3D box 回归分支 2. 损失函数loss2.1 keypoint分类损失2.2 3D box回归损失 3. 数据增广实验结果参考 论文: SMOKE: Single-Stage Monocular 3D Object Detection via Keypoint

AAAI-2024 | Mono3DVG:首个基于单目RGB图像实现3D Visual Grounding的方法

关注公众号,发现CV技术之美 本文分享论文Mono3DVG: 3D Visual Grounding in Monocular Images,该论文已被 AAAI 2024 接收,数据集和代码已开源。 详细信息如下: 单位:西北工业大学光电与智能研究院iOPEN、慕尼黑工业大学论文链接:https://arxiv.org/abs/2312.08022项目链接:https://github.co

C语言左移操作符(<<)、右移操作符(>>)以及按位取反单目操作符(~)讲解

C语言左移操作符(<<)和按位取反单目操作符(~)讲解 大家先判断下下面代码的运行结果 答案: 如果你做对了,那么恭喜大佬,这篇博客可能对你收益不大,全当复习好了,这是专门针对编程小白初学左移操作符(<<)和按位取反单目操作符(~)的讲解,诚挚地希望能够到xdm。接下来我将开始我的讲解,手把手带xdm拿捏这两个操作符的运算。 左移操作符(<<) 将一个数的二进制序列,去