swin专题

Python深度学习基于Tensorflow(17)基于Transformer的图像处理实例VIT和Swin-T

文章目录 VIT 模型搭建Swin-T 模型搭建参考 这里使用 VIT 和 Swin-T 在数据集 cifar10 上进行训练 VIT 模型搭建 导入需要的外部库 import numpy as npimport tensorflow as tfimport matplotlib.pyplot as pltimport matplotlib.gridspec as

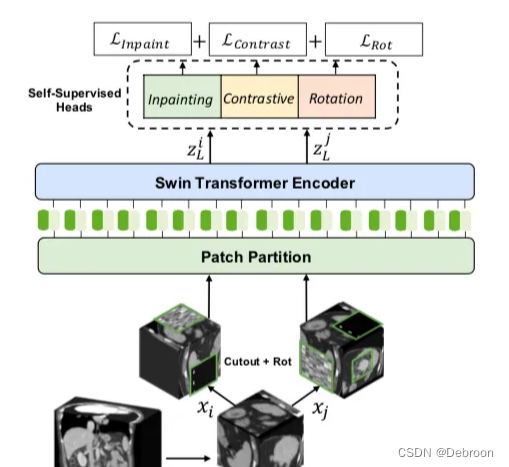

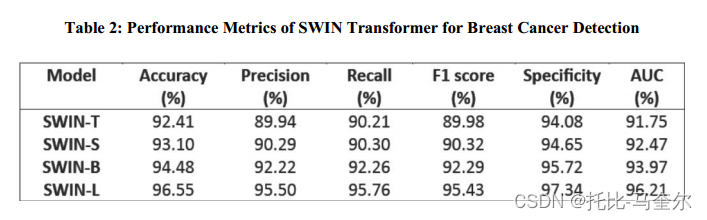

6.7.12 使用 SWIN Transformer 通过热图像实现乳腺癌检测系统

乳腺癌是重大的公共卫生挑战,需要有效的诊断方法。虽然超声、乳房 X 线照相和 MRI 仍然至关重要,但它们在定期、短间隔大规模筛查中的实用性有限。 热成像作为一种非侵入性且经济有效的选择,具有常规自我筛查的潜力。本研究利用基于自注意力的 Vision Transformer 设计代替传统的 CNN,探索了用于乳腺癌检测的各种 SWIN 变压器变体和增强策略。使用 DMR-IR 基准数据集,将其划

论文精读--Swin Transformer

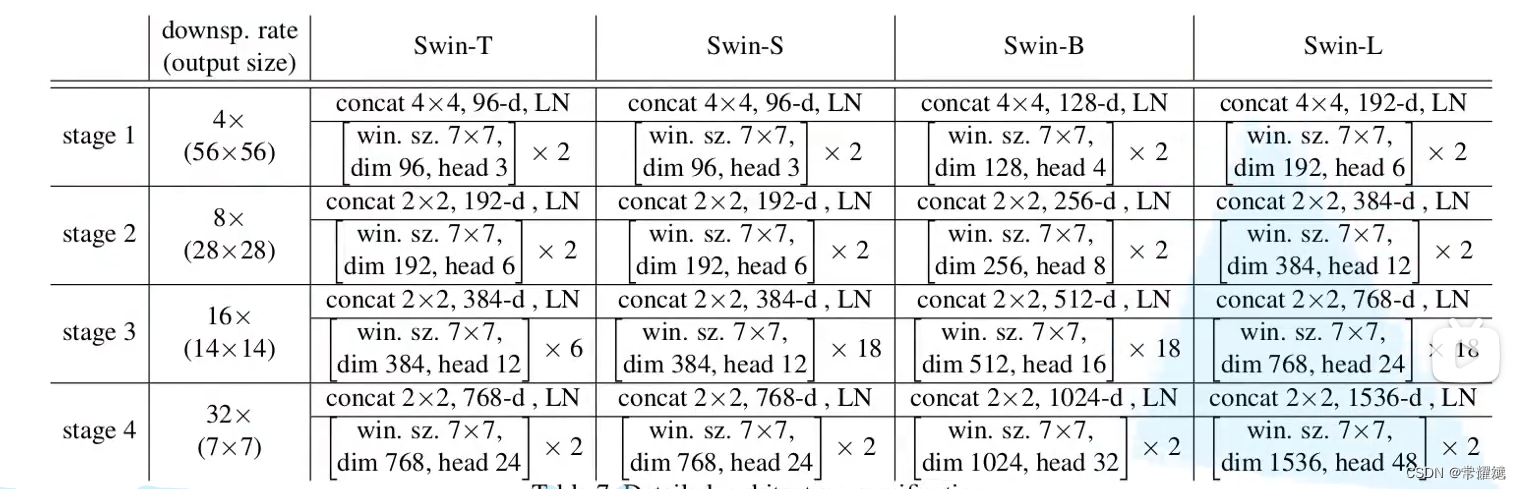

想让ViT像CNN一样分成几个block,做层级式的特征提取,从而使提取出的特征有多尺度的概念 Abstract This paper presents a new vision Transformer, called Swin Transformer, that capably serves as a general-purpose backbone for computer vision

Swin Transformer 浅析

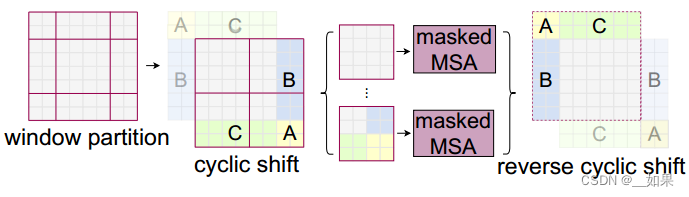

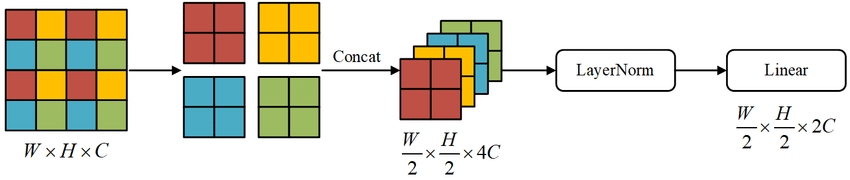

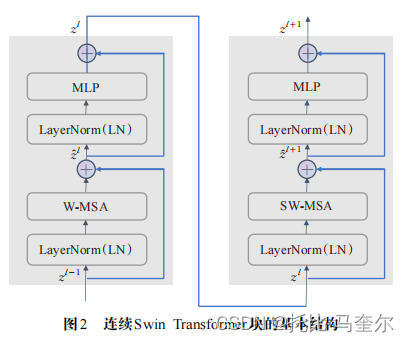

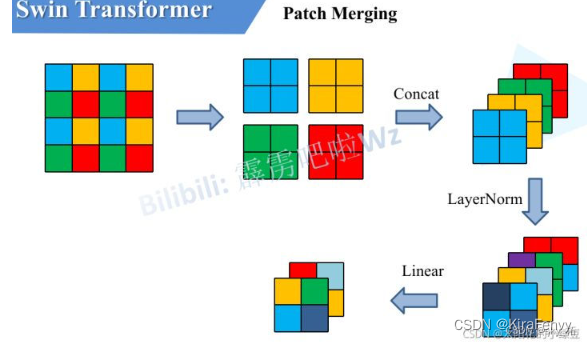

Swin Transformer 浅析 文章目录 Swin Transformer 浅析引言Swin Transformer 的网络结构W-MSA 窗口多头注意力机制SW-MSA 滑动窗口多头注意力机制Patch Merging 图块合并 引言 因为ViT无法实现CNN中的层次化构建以及局部信息,由此微软团队提出了Swin Transformer来解决该问题。 Swin T

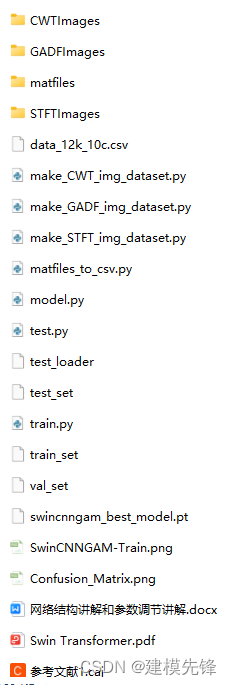

基于 GADF+Swin-CNN-GAM 的高创新轴承故障诊断模型!

基于格拉姆矩阵GADF+Swin Transformer窗口注意力和CNN-GAM全局注意力的轴承故障诊断模型! 往期精彩内容: Python-凯斯西储大学(CWRU)轴承数据解读与分类处理 Python轴承故障诊断 (一)短时傅里叶变换STFT Python轴承故障诊断 (二)连续小波变换CWT_pyts 小波变换 故障-CSDN博客 Python轴承故障诊断 (三)经验模态分

视觉Transformer和Swin Transformer

视觉Transformer概述 ViT的基本结构: ①输入图片首先被切分为固定尺寸的切片; ②对展平的切片进行线性映射(通过矩阵乘法对维度进行变换); ③为了保留切片的位置信息,在切片送入Transformer编码器之前,对每个切片加入位置编码信息; ④Transformer编码器由L个Transformer模块组成,每个模块由层归一化(LN)、多头自注意力模块(MHSA)、多层感知机(

Swin Transformer视觉大模型的原理详解(含代码)

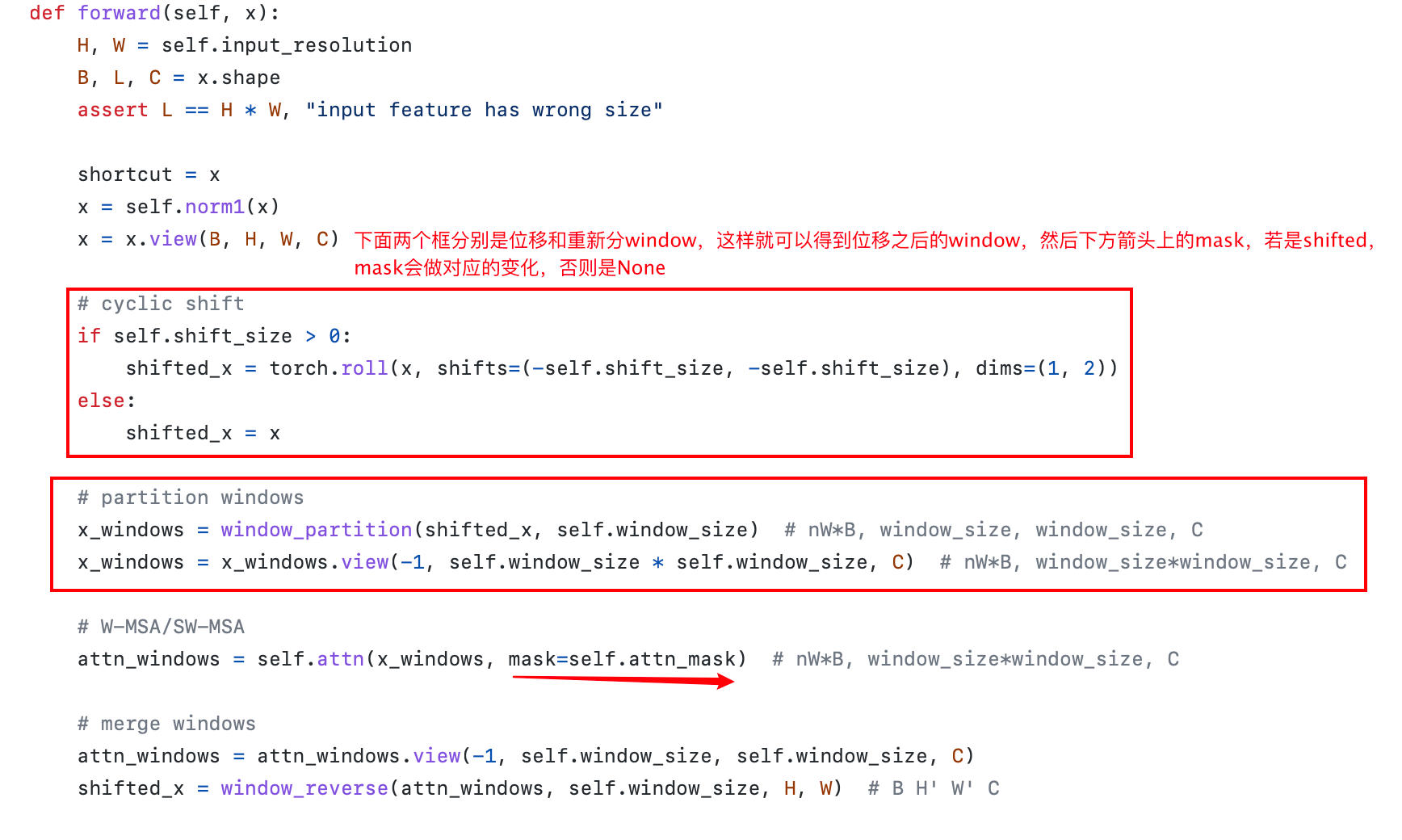

目录 SwinTransformer介绍 前言 是什么? 应用范围是什么? 到底解决了什么问题? 网络架构 Patch Embbeding介绍 window_partition介绍 W-MSA(Window Multi-head Self Attention) Window_reverse SW-MSA(Shifted Window Multi-head Self Atten

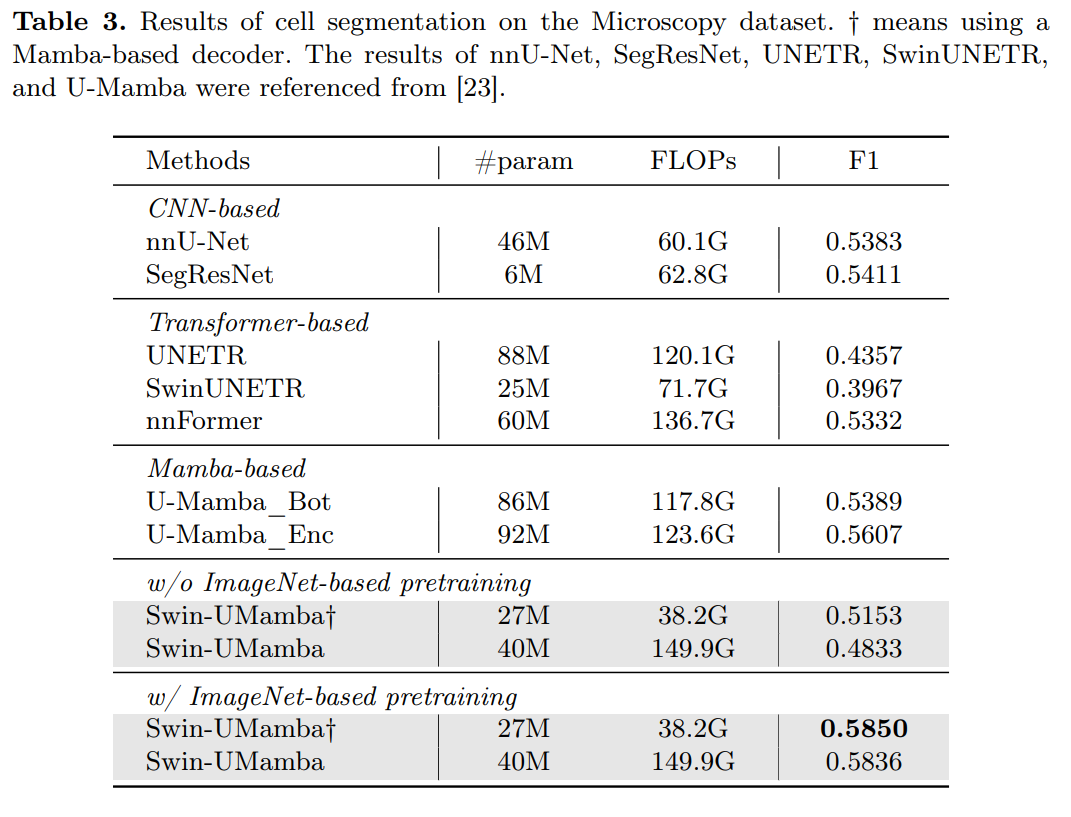

Swin-UMamba:结合基于ImageNet的预训练和基于Mamba的UNet模型

摘要 https://arxiv.org/pdf/2402.03302v1.pdf 准确的医学图像分割需要整合从局部特征到全局依赖的多尺度信息。然而,现有方法在建模长距离全局信息方面面临挑战,其中卷积神经网络(CNNs)受限于其局部感受野,而视觉转换器(ViTs)则受到其注意力机制高二次复杂度的困扰。最近,基于Mamba的模型因其在长序列建模中的出色能力而备受关注。多项研究表明,这些模型在各种任

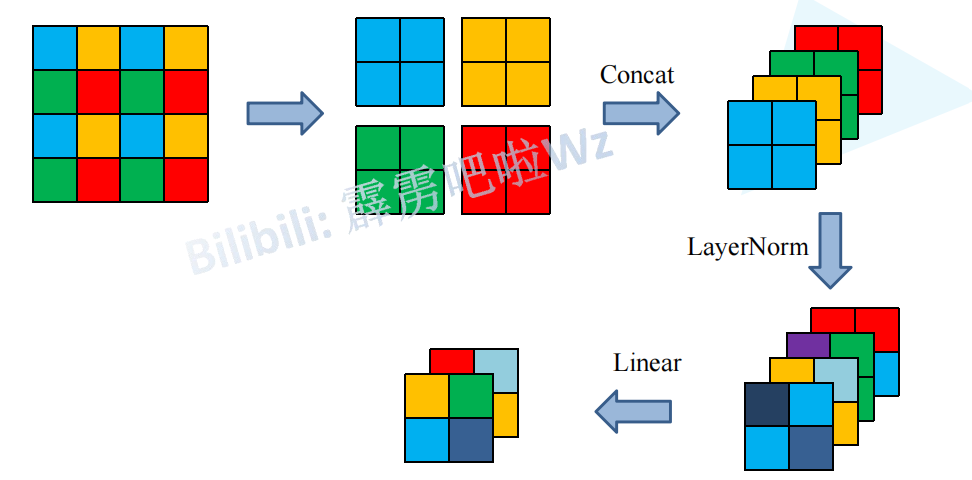

Swin—Transformer学习笔记

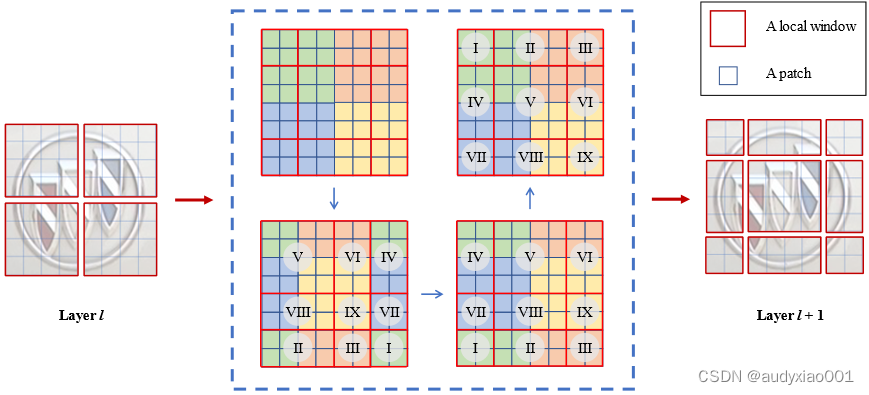

一、网络框架 二、Patch Merging 图像长和宽减半,通道数增加一倍 三、W-MSA 目的:减少计算量 缺点:窗口之间无法进行信息交互 四、SW-MSA 目的:实现不同window之间的信息交互 为了不增加计算量,移动window并增加Mask-MSA 计算完后将数据移动到原来位置 五、Relative position bias bias才是

Swin Transformer简记-220112版

Swin Transformer简记 文章目录 Swin Transformer简记参考问题与方案Window AttentionPatch MergingShifted Window based Self-Attention总结 参考 源码 本次回顾这篇用的时间不长,主要是大致浏览了一遍,记录一下,如有错误,踢我一下 问题与方案 CV中input的scale

图像生成发展起源:从VAE、扩散模型DDPM、DETR到ViT、Swin transformer

前言 2018年我写过一篇博客,叫:《一文读懂目标检测:R-CNN、Fast R-CNN、Faster R-CNN、YOLO、SSD》,该文相当于梳理了2019年之前CV领域的典型视觉模型,比如 2014 R-CNN2015 Fast R-CNN、Faster R-CNN2016 YOLO、SSD2017 Mask R-CNN、YOLOv22018 YOLOv3 随着2019 CenterN

Swin Transformer Hierarchical Vision Transformer

Swin Transformer: Hierarchical Vision Transformer using Shifted Windows Tags: Swin Transformer 发表日期: 2021 星级 : ★★★★★ 模型简写: Swin Transformer 简介: 多层次的Vision Transformer,提出基于窗口(移动窗口的多头自主意力机制)每次先做一次W-MSA

Swin Transformer: Hierarchical Vision Transformer using Shifted Windows(ICCV2021)

Swin Transformer 摘要引言方法实验 摘要 本文提出了一种新的Vision Transformer,称为Swin Transformer,可以作为计算机视觉领域的通用主干。将Transformer从NLP应用到CV会面临一些挑战,这些挑战主要来自两个方面:一个是尺度问题,视觉领域中的目标往往尺度差异很大(比如一张街景图像,里面的行人和汽车有大有小),而NLP中的

【Paper Note】Swin Transformer: Hierarchical ViT using Shifted Windows

Swin Transformer: Hierarchical ViT using Shifted Windows 论文信息概述核心思想整体结构名词解释与vit区别 模型处理过程概括Patch EmbeddingBasicLayerPatch MergingSwin Transform BlockWindow AttentionShifted Window Attention小结 模型使用

Swin Transformer:Hierarchical Vision Transformer using Shifted Windows

Swin Transformer:Hierarchical Vision Transformer using Shifted Windows Abstract 本文提出了一种新的视觉转换器,称为Swin Transformer,它可以很好地作为计算机视觉的通用主干。将Transformer从语言转换为视觉的挑战来自这两个领域之间的差异,例如视觉实体的大小差异很大,图像中的像素与文本中的文字相比

[ICCV2021]Swin Transformer: Hierarchical Vision Transformer using Shifted Windows

标题:Swin Transformer: Hierarchical Vision Transformer using Shifted Windows 链接:https://arxiv.org/pdf/2103.14030 动机 现在在CV中使用transformer的最大问题是运算量太大,因为图片的信息量远远大过NLP中文本的信息量,然后再做self attention会导致N平方的复杂度,这

论文阅读:CVPR2021 | Swin Transformer: Hierarchical Vision Transformer using Shifted Windows

文章目录 1、前言2、Introduction3、Method3.1、Overall ArchitectureSwin Transformer block3.2、Shifted Window based Self-AttentionSelf-attention in non-overlapped windowsShifted window partitioning in successive

Swin-UMamba:结合基于ImageNet的预训练和基于Mamba的UNet模型

摘要 https://arxiv.org/pdf/2402.03302v1.pdf 准确的医学图像分割需要整合从局部特征到全局依赖的多尺度信息。然而,现有方法在建模长距离全局信息方面面临挑战,其中卷积神经网络(CNNs)受限于其局部感受野,而视觉转换器(ViTs)则受到其注意力机制高二次复杂度的困扰。最近,基于Mamba的模型因其在长序列建模中的出色能力而备受关注。多项研究表明,这些模型在各种任

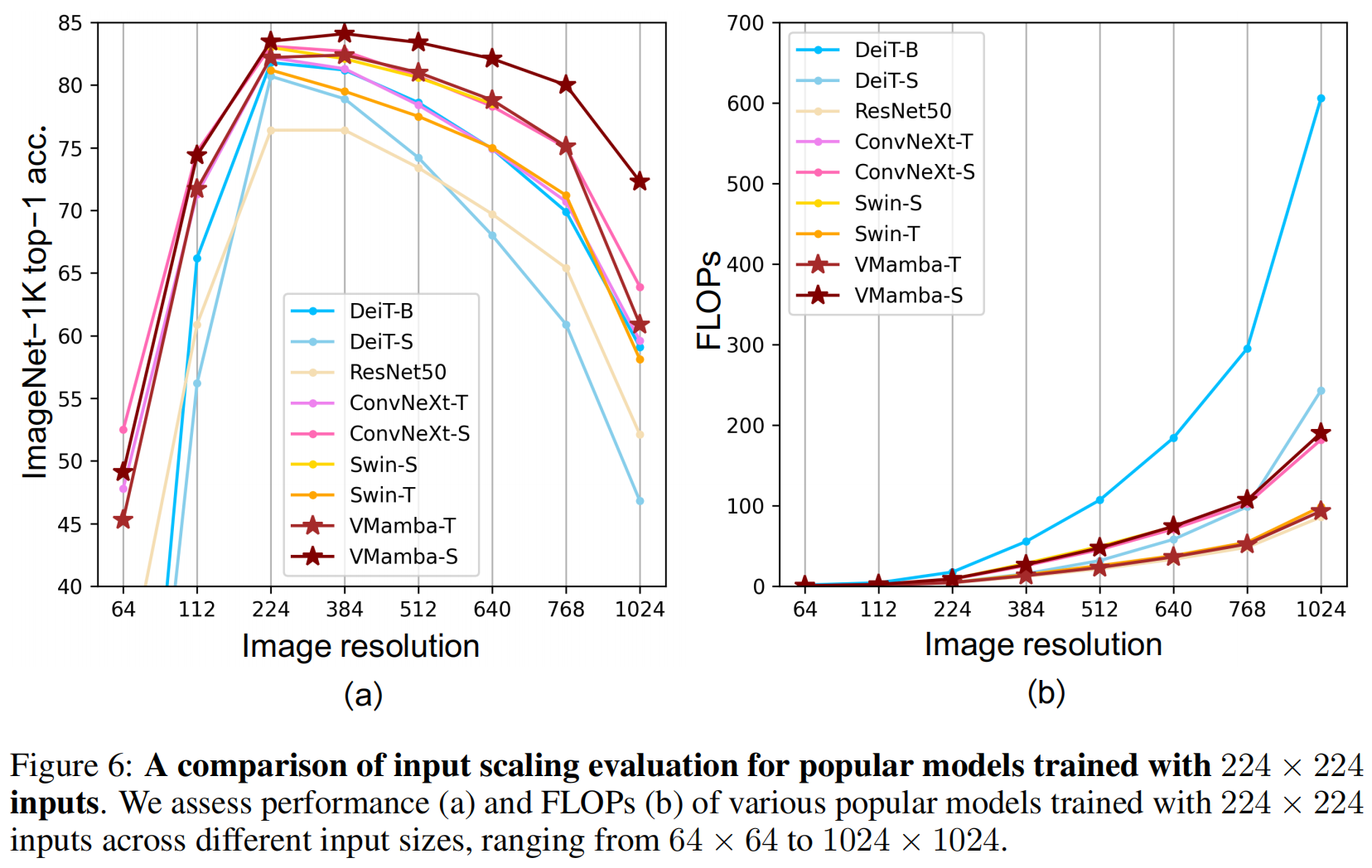

Swin版VMamba来了!精度再度提升,VMamba-S达成83.5%,超越Swin-S,已开源!

本文首发:AIWalker 就在昨日,华科王兴刚团队公开了Mamba在ViT的入局Vim,取得了更高精度、更快速度、更低显存占用。相关信息可参考: 入局CV,Mamba再显神威!华科王兴刚团队首次将Mamba引入ViT,更高精度、更快速度、更低显存! 就在纳闷Swin版的VMamba啥时候出来之时,UCAS、华为以及鹏城实验室联合提出了Swin版本的VMamba,不出之外的取得了更高的

TRB 2024论文分享:一种基于Swin Transformer的车标识别新方法

TRB(Transportation Research Board,美国交通研究委员会,简称TRB)会议是交通研究领域知名度最高学术会议之一,近年来的参会人数已经超过了2万名,是参与人数和国家最多的学术盛会。TRB会议几乎涵盖了交通领域的所有主题,主要包括公路、铁路、水运、航空、管道等诸多领域,接收来自交通系统、交通工程、交通政策、交通管理、交通实际操作、政府研究、学术研究和工业界最新的研究成果。

【Swin-Transformer学习】

Swin-Transformer学习笔记 参考链接: https://blog.csdn.net/qq_37541097/article/details/121119988 【机器学习】详解 Swin Transformer (SwinT) 链接: link B站视频 链接: link 1、Swin Transformer简介 Swin Transformer名字的前部分Swin来自于Shi

第6周学习:Vision Transformer Swin Transformer

目录 1 Vision Transformer1.1 ViT 模型架构1.2 Embedding 层1.3 Transformer Encoder 层1.4 MLP Head 层1.5 ViT B/161.6 ViT 模型参数1.7 Hybrid 混合模型 2 Swin Transformer2.1 Swin Transformer模型整体框架2.2 基于窗口的自注意力计算2.3 基于移动窗

低质量图像超分算法 SwinIR: Image Restoration Using Swin Transformer

论文名称:SwinIR: Image Restoration Using Swin Transformer 论文地址:https://arxiv.org/abs/2108.10257 代码仓库:https://github.com/JingyunLiang/SwinIR Swin Transformer Transformer在机器翻译等一维序列处理上取得了巨大成功,但基本的Transf

图像识别完整项目之Swin-Transformer,从获取关键词数据集到训练的完整过程

0. 前言 图像分类的大部分经典神经网络已经全部介绍完,并且已经作了测试 代码已经全部上传到资源,根据文章名或者关键词搜索即可 LeNet :pytorch 搭建 LeNet 网络对 CIFAR-10 图片分类 AlexNet : pytorch 搭建AlexNet 对花进行分类 Vgg : pytorch 搭建 VGG 网络 GoogLeNet : pytorch 搭建Goog

Swin-Transformer 在图像识别中的应用

1. 卷积神经网络简单介绍 图像识别任务主要利用神经网络对图像进行特征提取,最后通过全连接层将特征和分类个数进行映射。传统的网络是利用线性网络对图像进行分类,然而图像信息是二维的,一般来说,图像像素点和周围邻域像素点相关。而线性分类网络将图像强行展平成一维,不仅仅忽略了图像的空间信息,而全连接层会大大增加网络的参数 为了更好把握图像像素的空间信息,提出了 CNN 卷积神经网络,利用卷积

Swin UNetR:把 UNet 和 Swin Transformer 结合

Swin UNetR:把 UNet 和 Swin Transformer 结合 网络结构使用指南 前置知识:Swin Transformer:将卷积网络和 Transformer 结合 Swin UNetR 结合 Swin Transformer 的上下文建模能力和 U-Net 的像素级别预测能力,提高语义分割任务的性能。 把 2D Swin Transfor

![[ICCV2021]Swin Transformer: Hierarchical Vision Transformer using Shifted Windows](https://img-blog.csdnimg.cn/img_convert/a9059ad2035c6dc20a01f70796969fbb.png)