本文主要是介绍TRB 2024论文分享:一种基于Swin Transformer的车标识别新方法,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

TRB(Transportation Research Board,美国交通研究委员会,简称TRB)会议是交通研究领域知名度最高学术会议之一,近年来的参会人数已经超过了2万名,是参与人数和国家最多的学术盛会。TRB会议几乎涵盖了交通领域的所有主题,主要包括公路、铁路、水运、航空、管道等诸多领域,接收来自交通系统、交通工程、交通政策、交通管理、交通实际操作、政府研究、学术研究和工业界最新的研究成果。TRB会议的论文反映了交通领域的研究前沿,具有广泛的参考价值。

本文主要介绍我们在交通领域被TRB 2024接收的关于车辆身份识别的研究工作,论文的题目为《A New Method for Vehicle Logo Recognition Based on Swin Transformer》,第一作者为李杨。车标识别是实现车辆身份识别的核心任务之一,高效的车标识别方法能够有效地识别车辆品牌,进而可以实现车辆跟踪或者车辆品牌市场占有率估计等目标。目前,基于卷积神经网络(CNN)的车标识别方法被广泛应用。然而,CNN的全局建模能力仍然低效,进而使车标识别方法难以突破性能瓶颈。为了解决上述问题,本文使用Swin Transformer实现实时的车标识别并对其进行微调以获得最佳性能。在三个公开车标数据集(HFUT-VL1、XMU、CTGU-VLD)上进行的广泛实验证明了本文方法的优越性。

1. 背景与挑战

(1) 车标特征提取仍不够充分

车标属于小目标,大多数据集采集到的车标图像往往具有较低的分辨率。通过研究发现,捕获车标的细节特征往往能够大幅提高准确率。基于CNN的车标识别方法往往是通过增加网络层数以提取车标更抽象的语义特征。然而,这种方法提高了计算成本,并且会导致梯度爆炸和梯度消失等问题出现。Transformer中的注意力机制能够进行高效的并行计算并轻松捕获抽象的语义特征。因此,本文聚焦使用Transformer中的注意力机制对车标特征进行处理。

(2) CNN全局建模效率较低

在现有的车标识别方法中,基于CNN的方法被大多数研究者重点关注。尽管CNN通过核卷积能够轻松实现空间局部性特征提取,并通过平移卷积来增大感受野以提取丰富的特征。但是,CNN的全局建模效率仍然较低,进而难以突破其性能瓶颈。因此,我们使用Swin Transformer模型,先通过窗口化的注意力机制对车标图像进行局部建模,再利用滑动窗口的方法对每个窗口进行全局建模,以较低的计算代价提高全局建模效率。

2. 方法

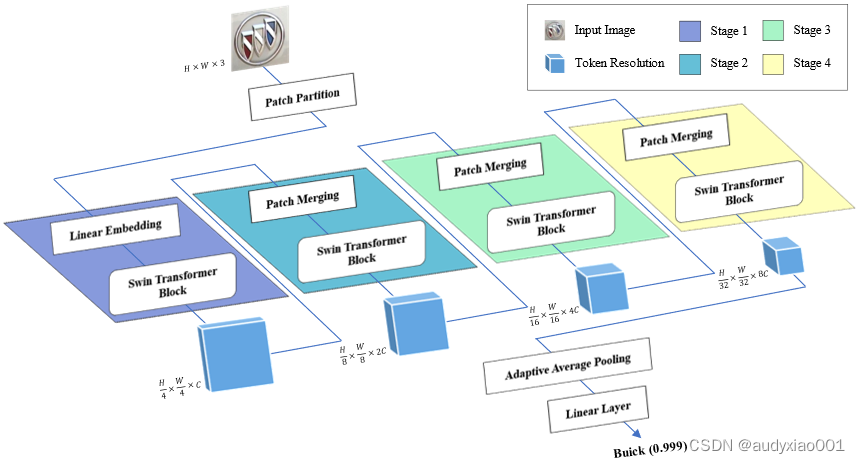

图1 基于Swin Transformer的车标识别方法的整体架构

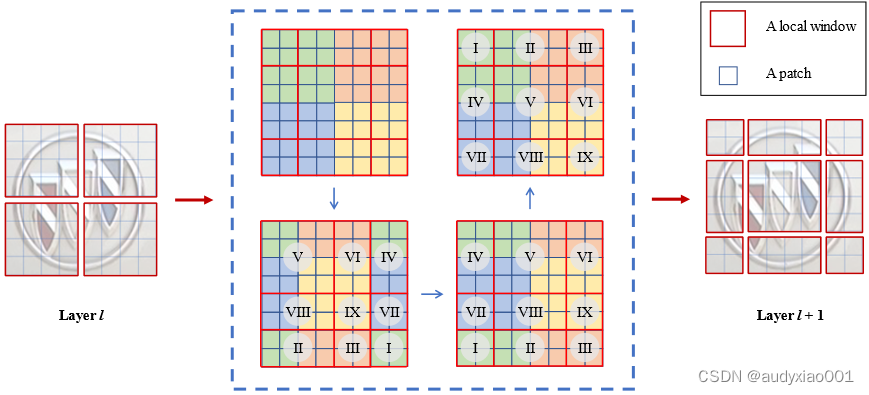

基于Swin Transformer的车标识别方法的整体架构如图1所示。首先,输入的RGB车标图像被分割成互不重叠的patch,其中每个patch可以被视为一个“token”。其次,这些token的原始通道维度通过Linear Embedding投影到任意维度。接下来,多个 Swin Transformer模块以及Patch Merging模块将应用于这些token。最后,与CNN类似,特征向量通过Linear layer映射到与类别数相同维度的输出向量,用于车辆标志的分类。此外,如图2所示,Swin Transformer的高效全局建模在于其独特的窗口注意力计算策略,具体而言,通过W-MSA处理每个独立窗口的特征,再通过SW-MSA建立窗口之间的特征依赖关系,进而实现复杂度与图像尺寸大小成线性关系的高效建模。总之,本文提出的基于Swin Transformer的车标识别方法能够高效提取车标特征进而实现分类,并且该方法具有较低的复杂度和较强的泛化能力。

图2 SW-MSA的注意力计算

3. 实验结果

实验使用的车标公开数据集包括HFUT-VL1、XMU和CTGU-VLD数据集。车标识别方法性能的评价指标主要是准确率(%)和处理速度(image/s)。通过微调Swin Transformer结构参数来提高模型性能,并获得最佳结果。为验证本文方法在车标识别中的有效性,我们在上述三种数据集上进行了两组对比试验。实验结果表明,与对比的车标识别方法相比,本文方法在识别准确率和处理速度等方面具有良好的性能。

4. 总结

本文提出的基于Swin Transformer车标识别方法实现了实时车标识别,并在多个公开数据集上表现出色。更为重要的是,本文提出的方法以较低的复杂度全面提升了车标识别的性能。未来的研究可以探索将车标识别与车牌、车型和车辆颜色等其它特征的综合识别相结合,进一步全面提升车辆身份识别的性能。

这篇关于TRB 2024论文分享:一种基于Swin Transformer的车标识别新方法的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!