residual专题

Segmentation简记2-RESIDUAL PYRAMID FCN FOR ROBUST FOLLICLE SEGMENTATION

创新点 与resnet结合,五层/level的分割由此带来的梯度更新问题,设计了两种方案。 总结 有点意思。看图吧,很明了。 细节图: 全流程图: 实验 Res-Seg-Net-horz: 在UNet上堆叠5个细节图中的结构,没有上采样层。 Res-Seg-Net-non-fixed: 普通方式的更新 Res-Seg-Net-fixed: 每一层的更新,只依据距离它最近的一

CV-CNN-2016:GoogleNet-V4【用ResNet模型的残差连接(Residual Connection)思想改进GoogleNet-V3的结构】

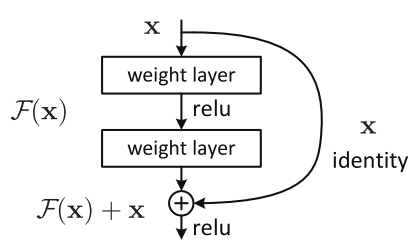

Inception V4研究了Inception模块与残差连接的结合。 ResNet结构大大地加深了网络深度,还极大地提升了训练速度,同时性能也有提升。 Inception V4主要利用残差连接(Residual Connection)来改进V3结构,得到Inception-ResNet-v1,Inception-ResNet-v2,Inception-v4网络。 ResNet的残差结构如下

ResNeXt - Aggregated Residual Transformations for Deep Neural Networks

《Aggregated Residual Transformations for Deep Neural Networks》是Saining Xie等人于2016年公开在arXiv上: https://arxiv.org/pdf/1611.05431.pdf 创新点 1.在传统Resnet基础上采用group convolution,在不增加参数量的前提下,获得更强的representat

ResNet论文解读—Residual Learning Deep for lmage Recognition(2016)

ResNet论文解读—Residual Learning Deep for lmage Recognition(2016) 研究背景 图像识别中的深度残差学习网络(MSRA:微软亚洲研究院) 认识数据集:ImageNet的大规模图像识别挑战赛 LSVRC-2015:ImageNet Large Scale Visual Recoanition Challenge(15年的相关比赛)

CNN初探(四)------Deep Residual Learning for Image Recognition

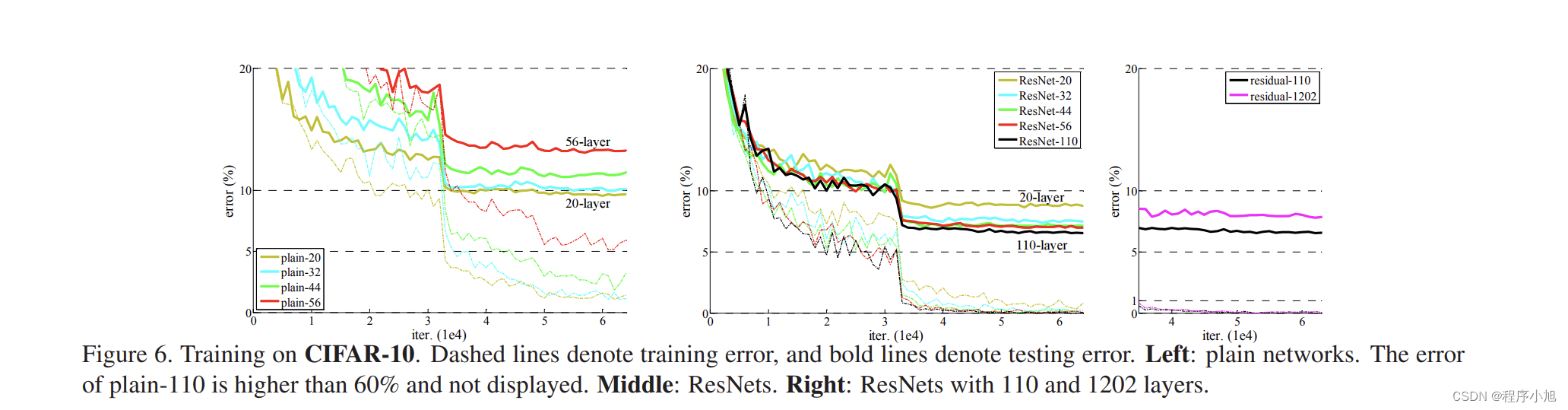

Degradation problem 是否通过简单地叠加网络的层数来提高准确率?为了得到答案,首先要解决vanishing/exploding gradients问题,这会极大地妨碍收敛。通过normalized initialization([1,2,3,4])和intermediate normalization layers[5]解决。 当深度网络能够收敛时,精度开始饱和,然后开始快速

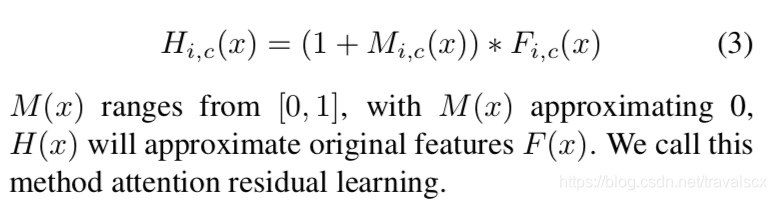

论文笔记:Residual Attention Network for Image Classification

https://blog.csdn.net/u013738531/article/details/81293271 Attention使得运算聚焦于特定区域,也可以使得该部分区域的特征得到增强。 ‘very deep’的网络结构结合残差连接(Residual Network)在图像分类等任务中表现出了极好的性能。 因此结合attention和residual,突出残差注意力网络。 https:/

Deep Spatio-Temporal Residual Networks for Citywide Crowd Flows Prediction

本博文是对郑宇老师团队所提出的STResNet网络的一个略微扩充说明。本人自己在看完这篇论文的时候,感觉就一个字‘懵’。你说不懂吧,好像又明白点,你说懂吧又感觉有好多细节还是不清楚。好在该论文开放了源代码。经过对源代码的一番剖析,总算是弄懂之前不明白的一些细节。不过该源码是基于Keras实现的,由于本人之前一直使用Tensorflow,所以又对其利用tf进行了重构,代码整体上看起也来更加简洁,

深度学习论文随记(四)ResNet 残差网络-2015年Deep Residual Learning for Image Recognition

深度学习论文随记(四)ResNet 残差网络 DeepResidual Learning for Image Recognition Author:Kaiming He, XiangyuZhang, Shaoqing Ren, Jian Sun, Microsoft Research Year:2015 1、导引 之前文章谈到GoogLeNet和VGG,人们开始认为

阅读笔记(CVPR2020)Warping Residual Based Image Stitching for Large Parallax

基于变形残差的大视差图像拼接 K. -Y. Lee and J. -Y. Sim, "Warping Residual Based Image Stitching for Large Parallax," 2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR), Seattle, WA, USA, 20

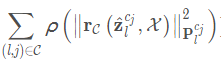

七、VINS-mono 代码解析——紧耦合后端非线性优化 IMU+视觉的残差residual、Jacobian、协方差、基于舒尔补的边缘化

文章目录 前言紧耦合后端非线性优化系统框架一、VIO中的状态向量与代价函数1、需要优化的状态向量:2、目标函数为:二、视觉约束1.视觉重投影误差residual2、优化变量3、Jacobian4、协方差三、IMU约束1、残差:2、优化变量:3、IMU测量残差公式推导4、残差对状态量的Jacobian5、残差对状态量的协方差四、基于舒尔补的边缘化1、论文部分2、基本公式3、舒尔补4、marg后

VINS-Mono 理论详细解读——紧耦合后端非线性优化 IMU+视觉的残差residual、Jacobian、协方差、基于舒尔补的边缘化

预积分和后端优化IMU部分** https://blog.csdn.net/weixin_44580210/article/details/93377806 本讲是VINS最核心部分了,前面经历了 1)视觉跟踪feature_tracker、IMU预积分integrationBase类; 2)初始化中SFM纯视觉估计滑动窗中所有帧的位姿和3D路标点深度、SFM与IMU预积分松耦合对齐求解初始化

Image Super-Resolution via Deep Recursive Residual Network(DRRN)论文阅读笔记

目的 尽管其他深度网络再进行SR时取得了优异的性能,但深度网络需要大量的参数。与紧凑模型相比,大型模型需要更多的存储空间,对移动系统的适用性较差,作者创造DRRN取得更好的性能,并且比VDSR,DRCN,RED30等网络所需要的参数更加少。 DRRN在算法上的创新 在DRRN中引入了global learning和residual learning 在视觉识别和图像恢复等领域中,如

卷积神经网络CNN经典模型Lenet,Alexnet,Googlenet,VGG,Deep Residual Learning

本篇文章转载自:Bin的专栏blog.csdn.net/xbinworld。 关于卷积神经网络CNN,网络和文献中有非常多的资料,我在工作/研究中也用了好一段时间各种常见的model了,就想着简单整理一下,以备查阅之需。如果读者是初接触CNN,建议可以先看一看“Deep Learning(深度学习)学习笔记整理系列”中关于CNN的介绍[1],是介绍我们常说的Lenet为例,相信会对初学者有

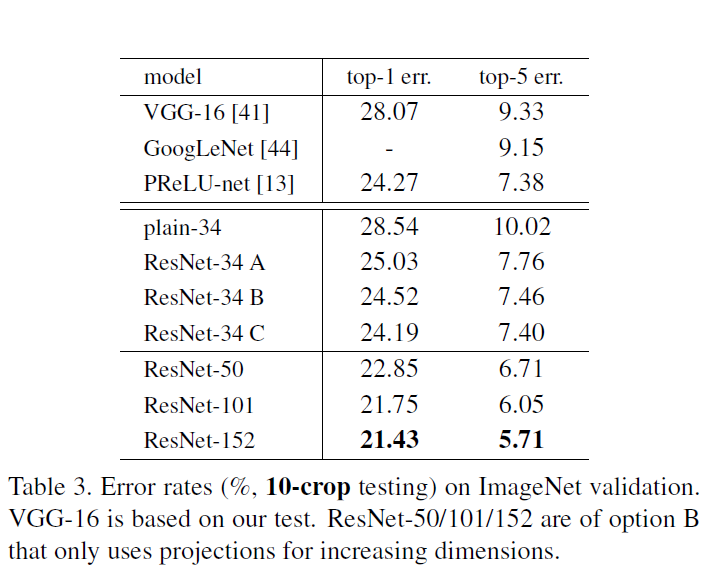

[caffe]深度学习之MSRA图像分类模型Deep Residual Network(深度残差网络)解读

一、简介 MSRA的深度残差网络在2015年ImageNet和COCO如下共5个领域取得第一名:ImageNet recognition, ImageNet detection, ImageNet localization, COCO detection, and COCO segmentation。 文章:Deep Residual Learning for Image

【知识---ResNet(Residual Network)作用及代码】

提示:文章写完后,目录可以自动生成,如何生成可参考右边的帮助文档 文章目录 前言ResNet(Residual Network)作用ResNet残差块的示例:tensorflow 版本pytorch 版本 总结 前言 提示:这里可以添加本文要记录的大概内容: BN(批量归一化)可以解决网络层数太深而出现的梯度消失问题,但是如果网络层数太多,这个方法也是不太管用的。所

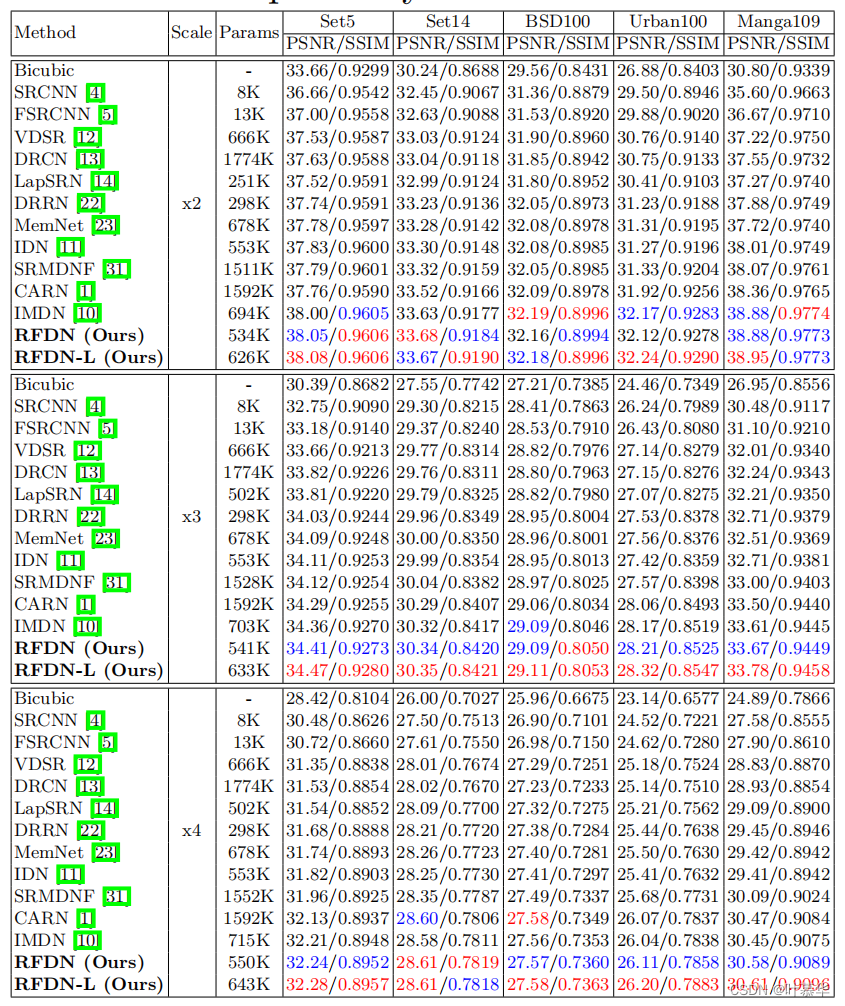

阅读RFDN-Residual Feature Distillation Network for Lightweight Image Super-Resolution

Residual Feature Distillation Network for Lightweight Image Super-Resolution Abstract. 单图像超分辨率(SISR)的最新进展探索了卷积神经网络(CNN)的力量,以获得更好的性能。尽管基于cnn的方法取得了巨大的成功,但为了解决高计算量的问题,人们提出了各种快速和轻量级的CNN模型。信息蒸馏网络是目前最先进的方法

Accurate prediction of protein contact maps by coupling residual two-dimensional bidirectional long

论文题目:Accurate prediction of protein contact maps by coupling residual two-dimensional bidirectional long short-term memory with convolutional neural networks 下载链接:https://academic.oup.com/bioinformat

模块调用、Dropout以及残差(residual)连接函数

主要函数dropout_wrapper实现张量经模块前向传输再经过dropout层,最后和输入张量相加输出。函数调用:dropout_wrapper_fn <- dropout_wrapper <- apply_dropout import jax import functoolsimport ml_collectionsNUM_RES = 'num residues placeholder

优化改进YOLOv5算法之Dilation-wise Residual(DWR)可扩张残差注意力模块,增强多尺度感受野特征,助力小目标检测

目录 1 Dilation-wise Residual模块原理 1.1 设计动机 1.2 Dilation-wise Residual模块 1.2.1 Design idea and structure 1.2.2 Parameter design

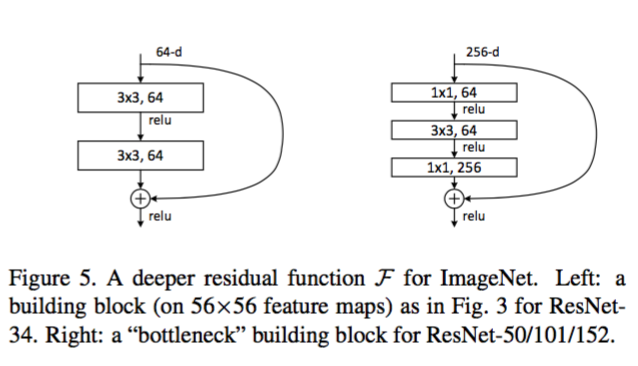

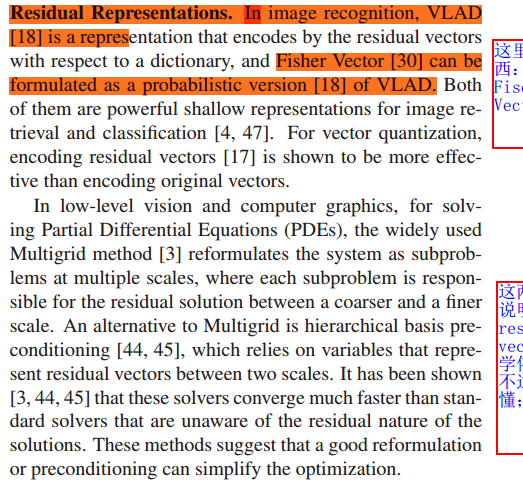

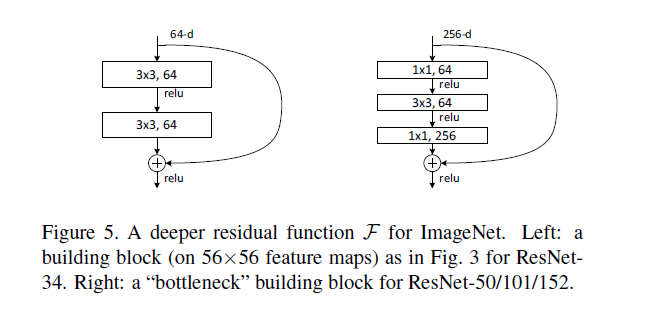

论文笔记:Deep Residual Learning for Image Recognition(ResNet)

一、基本信息 标题:Deep Residual Learning for Image Recognition 时间:2015 第一作者:Kaiming He 论文领域:深度学习、计算机视觉、CNN 引用格式:He K, Zhang X, Ren S, et al. Deep residual learning for image recognition[C]//Proceedings of th

论文-Deep Residual Learning for Image Recognition

ResNet Deep Residual Learning for Image Recognition 要解决的问题: (1), network是否叠加越多越好?其中最显著的问题是 gradient vanishing or gradient exploding. (2), 随着网络深度的增加,accuracy很容易饱和,导致快速降解的问题。 Resnet的residual learn

论文笔记——Deep Residual Learning for Image Recognition

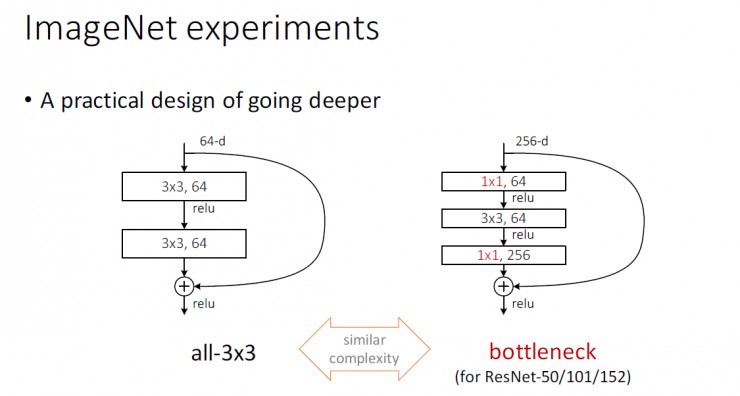

论文地址:Deep Residual Learning for Image Recognition ResNet——MSRA何凯明团队的Residual Networks,在2015年ImageNet上大放异彩,在ImageNet的classification、detection、localization以及COCO的detection和segmentation上均斩获了第一名的成绩,而且Dee

Deep Residual Learning for Image Recognition这篇文章

作者:何凯明等,来自微软亚洲研究院; 这篇文章为CVPR的最佳论文奖;(conference on computer vision and pattern recognition) 在神经网络中,常遇到的问题: 1. 当网络变深以后的 vanishing/exploding gradient 问题: 对于这一个问题,现在可以说差不多已经有解决的办法了,如:使用 ReLU激活函数、 良

【DeepLearning】Deep Residual Learning for Image Recognition恺神大作学习

@[TOC] Deep Residual Learning for Image Recognition 论文 1. 文章主要想解决什么问题,用了什么方法 深度神经网络在训练过程中的3个关键问题: 梯度消失/爆炸问题:随着网络层数的增加,梯度在反向传播过程中可能会变得非常小(梯度消失)或者非常大(梯度爆炸),这会阻碍网络的收敛。 退化问题:随着网络深度的增加,网络的准确率在达到一定深度后

【DeepLearning】Deep Residual Learning for Image Recognition恺神大作学习

@[TOC] Deep Residual Learning for Image Recognition 论文 1. 文章主要想解决什么问题,用了什么方法 深度神经网络在训练过程中的3个关键问题: 梯度消失/爆炸问题:随着网络层数的增加,梯度在反向传播过程中可能会变得非常小(梯度消失)或者非常大(梯度爆炸),这会阻碍网络的收敛。 退化问题:随着网络深度的增加,网络的准确率在达到一定深度后

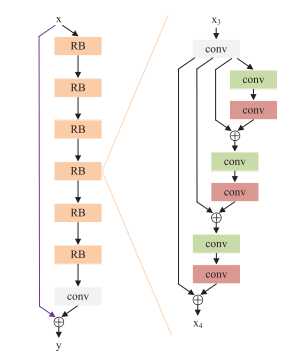

【RDFNet2017】RDFNet: RGB-D Multi-level Residual Feature Fusion for Indoor Semantic Segmentation

RDFNet: RGB-D Multi-level Residual Feature Fusion for Indoor Semantic Segmentation RDFNet:用于室内语义分割的RGB-D多级残差特征融合 论文地址:https://ieeexplore.ieee.org/stamp/stamp.jsp?tp=&arnumber=8237795&tag=1 代码:http

![[caffe]深度学习之MSRA图像分类模型Deep Residual Network(深度残差网络)解读](https://img-blog.csdn.net/20160316161823132)