propagation专题

(转)事务PROPAGATION_REQUIRES_NEW不起作用

最近在做事务添加时 发现自己的事务没有新建 其二 注意 事务的注解 应该在 内层的事务上面 一、描述 Spring遇到嵌套事务时,当被嵌套的事务被定义为“PROPAGATION_REQUIRES_NEW”时, 内层Service的方法被调用时,外层方法的事务被挂起; 内层事务相对于外层事务是完全独立的,有独立的隔离性等等。 二、实验 但实验时却遇到一个奇怪的问题: 1、当Service

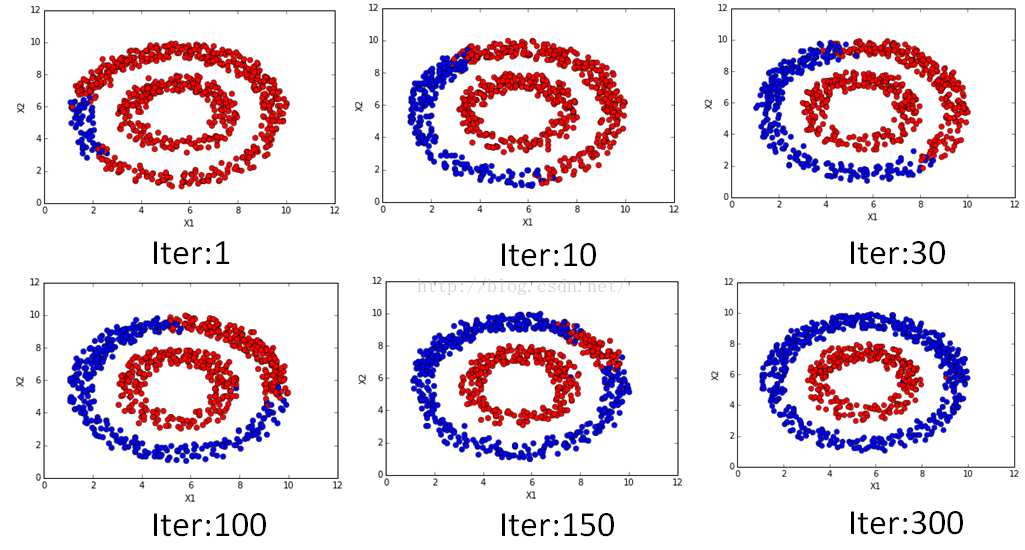

####并行版###标签传播算法(Label Propagation)及Python实现

标签传播算法(Label Propagation)及Python实现 zouxy09@qq.com http://blog.csdn.net/zouxy09 众所周知,机器学习可以大体分为三大类:监督学习、非监督学习和半监督学习。监督学习可以认为是我们有非常多的labeled标注数据来train一个模型,期待这个模型能学习到数据的分布,以期对未来没有见到的样本做预测。那这个性能

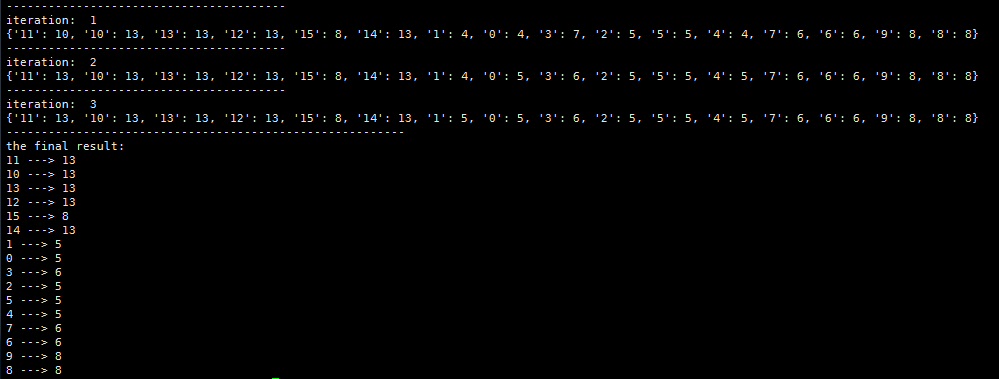

##单机版Python##社团划分——有向图的Label Propagation算法

在博文社区划分——Label Propagation中,介绍了Label Propagation社区划分算法的基本原理,基本的Label Propagation算法是针对无向图的社区划分算法。 一、基本Label Propagation算法原理 对于网络中的每一个节点,在初始阶段,Label Propagation算法对每一个节点一个唯一的标签,在每一个迭代的过程中,每一个节点根据与其相连的节点

立体匹配论文阅读(2)-- Stereo Matching with Color-Weighted Correlation, Hierarchical Belief Propagation...

《 Stereo Matching with Color-Weighted Correlation, Hierarchical Belief Propagation, and Occlusion Handling》 题目翻译:使用颜色加权的相关性和遮挡区处理的结构性置信度传播的立体匹配算法 其提出的算法主要流程为以下三个步骤,文章中也分别给出了相对应的框图: 1.初始视差的得到 2.像

立体匹配论文阅读(1)-Segment-based stereo matching using belief propagation and a self-adapting dissimilarity

《Segment-based stereo matching using belief propagation and a self-adapting dissimilarity measure》 将题目翻译过来是:使用置信度传播和自适应差异测度的基于图像分割的立体匹配算法 其提出的算法主要流程为: 1.准备待匹配图像对 2.使用mean-shift方法,根绝颜色和亮度的统一性,将参考图像

深度学习100问之深入理解Back Propagation(反向传播)

这几天正在看反向传播的原理,最近也经常看到关于反向传播理解的文章,在深度学习的理论中BP也是极其重要的,所以就抽出一段时间认真地研究了一下BP的原理,以下为参考网上的几篇文章总结得出的。 一、望尽天涯路 1974年,Paul Werbos首次给出了如何训练一般网络的学习算法— b a c k p r o p a g a t i o n back propagation backpropa

神经网络算法——反向传播 Back Propagation

文章目录 前言 1、反向传播的本质 (1)前向传播(Forward Propagation) (2)反向传播(Back Propagation) 2、反向传播的原理 (1)链式法则(Chain Rule) (2)偏导数 3、反向传播的案例:简单神经网络 (1)网络结构 (2)前向传播 (3)损失计算 (4)反向传播 (5)参数更新 (6)迭代 重复步骤 2-5,直到网络收敛或达到预设的迭代次数

spring propagation = Propagation.REQUIRES_NEW 注意事项

1、spring对于当前事务信息获取 TransactionSynchronizationManager.getCurrentTransactionName(); 2、spring使用@Transactional注解生效方式分析 spring方法上添加Transactional注解,意味着为该方法开启一个事务。 事务的传播行为默认:当前如果存在事务,就加入该事务。如果当前不存在,就开启新

论文阅读 - Non-Local Spatial Propagation Network for Depth Completion

文章目录 1 概述2 模型说明2.1 局部SPN2.2 非局部SPN2.3 结合置信度的亲和力学习2.3.1 传统正则化2.3.2 置信度引导的affinity正则化 3 效果3.1 NYU Depth V23.2 KITTI Depth Completion 参考资料 1 概述 本文提出了一种非局部的空间传播网络用于深度图补全,简称为NLSPN。 (1)为什么需要深度图补全?

【阅读笔记】Layer-wise relevance propagation for neural networks with local renormalization layers

Binder, Alexander, et al. “Layer-wise relevance propagation for neural networks with local renormalization layers.” International Conference on Artificial Neural Networks. Springer, Cham, 2016. 本文是探究

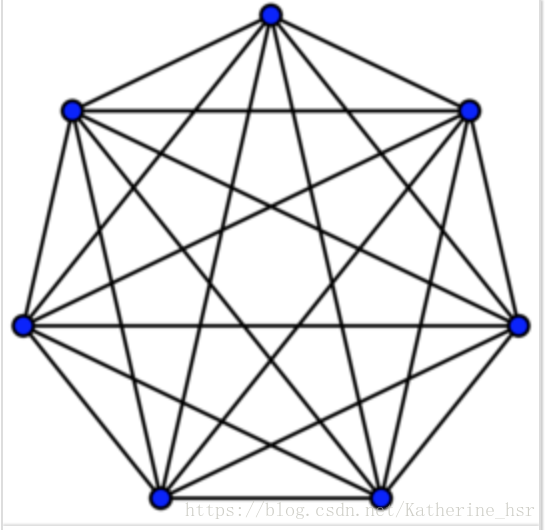

标签传播算法(Label Propagation Algorithm)

目录: 1. 半监督学习(Semi-supervised Learning SSL) 2. 完全图 3. 标签传播算法的基本思路 4. 标签传播算法 5. 算法描述 6. 标签传播算法的基本特点 7. 代码实现 1. 半监督学习(Semi-supervised Learning SSL) 半监督学习是一种有监督学习和无监督学习想结合的一种方法,其主要思想是基于数据分布上的模型假设,利用少量的已

[论文阅读] Revisiting Feature Propagation and Aggregation in Polyp Segmentation

[论文地址] [代码] [MICCAI 23] Abstract 息肉的准确分割是筛查过程中有效诊断结直肠癌的关键步骤。 由于能够有效捕获多尺度上下文信息,普遍采用类似UNet 的编码器-解码器框架。 然而,两个主要限制阻碍了网络实现有效的特征传播和聚合。 首先,跳跃连接仅将单个尺度特征传输到解码器,这可能导致特征表示有限。 其次,特征在没有任何信息过滤器的情况下被传输,这对于在解码器处执

Springboot 跟着我了解下 事务 @Transactional 默认方式 Propagation.REQUIRED

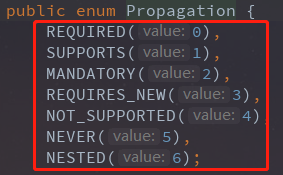

在平常的项目里面,最常看到的就是使用注解 @Transactional 去操作事务。 如果稍微对spring事务有过了解的,会知道关于事务传播机制,存在7种, 也就是: 同样可以在注解@Transactional里面看到, 默认配置了的是 Propagation.REQUIRED (文章的主角) 为什么该篇文章,7种,我只介绍一种呢?而且是介绍的是

聚类笔记/sklearn笔记:Affinity Propagation亲和力传播

1 算法原理 1.1 基本思想 将全部数据点都当作潜在的聚类中心(称之为 exemplar )然后数据点两两之间连线构成一个网络( 相似度矩阵 )再通过网络中各条边的消息( responsibility 和 availability )传递计算出各样本的聚类中心。 1.2 主要概念 Examplar聚类中心similarity S(i,j) 相似度 一般使用负的欧式距离,所以 S(i

RNN基于时间的反向传播算法BPTT(Back Propagation Trough Time)梯度消失与梯度爆炸

日萌社 人工智能AI:Keras PyTorch MXNet TensorFlow PaddlePaddle 深度学习实战(不定时更新) 将RNN展开之后,前向传播(Forward Propagation)就是依次按照时间的顺序计算一次就好了,反向传播(Back Propagation)就是从最后一个时间将累积的残差传递回来即可,这与普通的神经网络训练本质上是相似的。

三幅图简易说明神经网络的后向传播(Backward propagation)

神经网络的后向传播是在神经网络进行训练时,神经网络各层更新数值的方法。后向传播大致可以分为以下三种情况: 在节点处相加的情况:节点会将传入的梯度值直接向后传播。 在节点处相乘的情况:将输入端的值对调,并和传入的梯度值相乘。 在节点处进行函数变换:对函数求导,并和传入的梯度值相乘。特别的,如果 g = m a x ( ) g=max() g=max(),那么只有达到了max的x的分量会传出梯度值

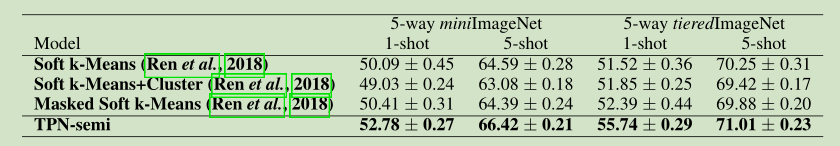

论文:learning to propagate labels :transductive propagation network for few-shot learning

论文题目:learning to propagate labels:transductive propagation network for few-shot learning 论文发表:ICLR2019 Github:github.com/csyanbin/TPN 摘要:少样本学习的目标:在少量训练数据下(每个类别的样本很少),学习到一个有较强泛化能力的分类器。一种解决方式就是通过元学习(m

@Transactional和Propagation的使用

@Transactional事务几点注意 这里面有几点需要大家留意: A. 一个功能是否要事务,必须纳入设计、编码考虑。不能仅仅完成了基本功能就ok。 B. 如果加了事务,必须做好开发环境测试(测试环境也尽量触发异常、测试回滚),确保事务生效。 C. 以下列了事务使用过程的注意事项,请大家留意 不要在接口上声明@Transactional ,而要在具体类的方法上使用 @Transactiona

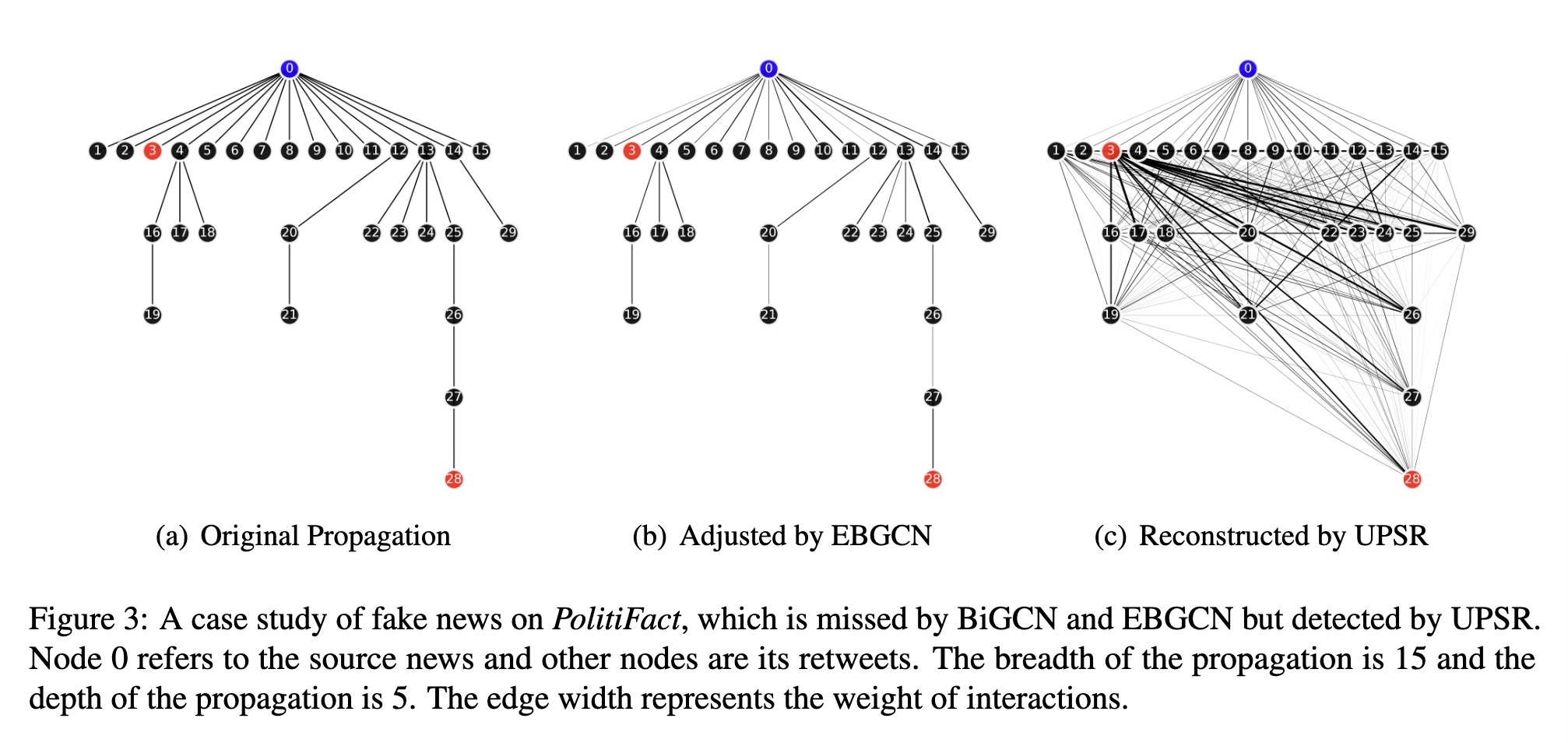

论文阅读-Uncertainty-aware Propagation Structure Reconstruction for Fake News Detection

论文链接:https://aclanthology.org/2022.coling-1.243.pdf 目录 摘要 1 简介 2 相关工作 3 问题陈述 4 拟议模型 4.1 概述 4.2 原始传播建模 4.2.1 图的构建 4.2.2 在原始传播图中学习远程交互 4.3 重建传播模型 4.3.1 高斯传播估计 4.3.2 重建传播图中的重新学习潜在相互作用 4.4 假

Transactional的7种Propagation 事务配置 开启 关闭 spring springboot mybatis

spring事务的配置 通常默认是REQUIRED, 如下: @Transactional(propagation = Propagation.REQUIRED)public void t1(){//业务代码} 因为默认是 REQUIRED,所以通常不会显示写出来,如下: @Transactionalpublic void t1(){//业务代码} 通常会加上回滚,因为默认不回滚

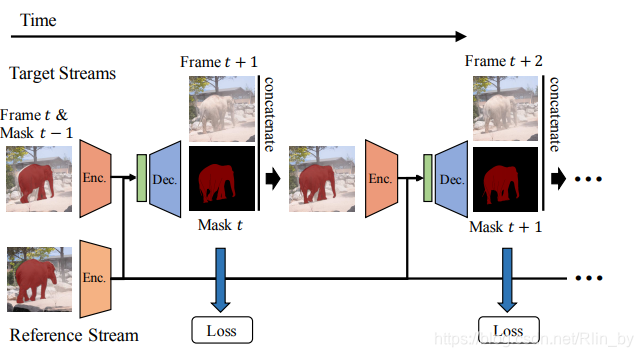

【VOS】Fast Video Object Segmentation by Reference-Guided Mask Propagation

论文地址:http://openaccess.thecvf.com/content_cvpr_2018/papers/Oh_Fast_Video_Object_CVPR_2018_paper.pdf 只有测试代码,地址:https://github.com/seoungwugoh/RGMP Motivation 在线学习速度慢,而且作者的准确率也达到SOTA Pipline 采用Si

![[论文阅读] Revisiting Feature Propagation and Aggregation in Polyp Segmentation](https://img-blog.csdnimg.cn/direct/6c68dad46b844d08bc38d0d1bd327404.jpeg#pic_center)