本文主要是介绍书生·浦语大模型第二期实战营第四节-XTuner 微调 LLM:1.8B、多模态、Agent 笔记,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

来源:

视频来源:XTuner 微调 LLM:1.8B、多模态、Agent

1. XTuner 微调 LLM:1.8B、多模态、Agent

1.1 为什么要微调

1.2 两种Finetune范式

在LLM的下游应用中,增量预训练和指令跟随是经常会用到的两种微调模式。

增量预训练微调

使用场景:让基座模型学习到一些新知识,如某个垂类领域的常识。

训练数据:文章、书籍、代码等。

指令跟随微调

使用场景:让模型学会对话模板,根据人类指令进行对话。

训练数据:高质量的对话、问答数据

1.3 一条数据的一生

原始数据-标准格式数据-添加对话模板-Tokenized数据-添加label-开始训练

2. XTuner

2.1 XTuner简介

2.1 XTuner简介

2.2 XTuner快速上手

2.3 XTuner数据引擎

3. 8GB玩转LLM

-

支持FlashAttention、Triton kernels等,以加速训练吞吐。

-

兼容DeepSpeed,支持ZeRO训练优化策略,以优化训练过程。

4. InternM2 1.8B模型

5. 多模态LLM

5.1 多模态LLM原理

5.1 多模态LLM原理

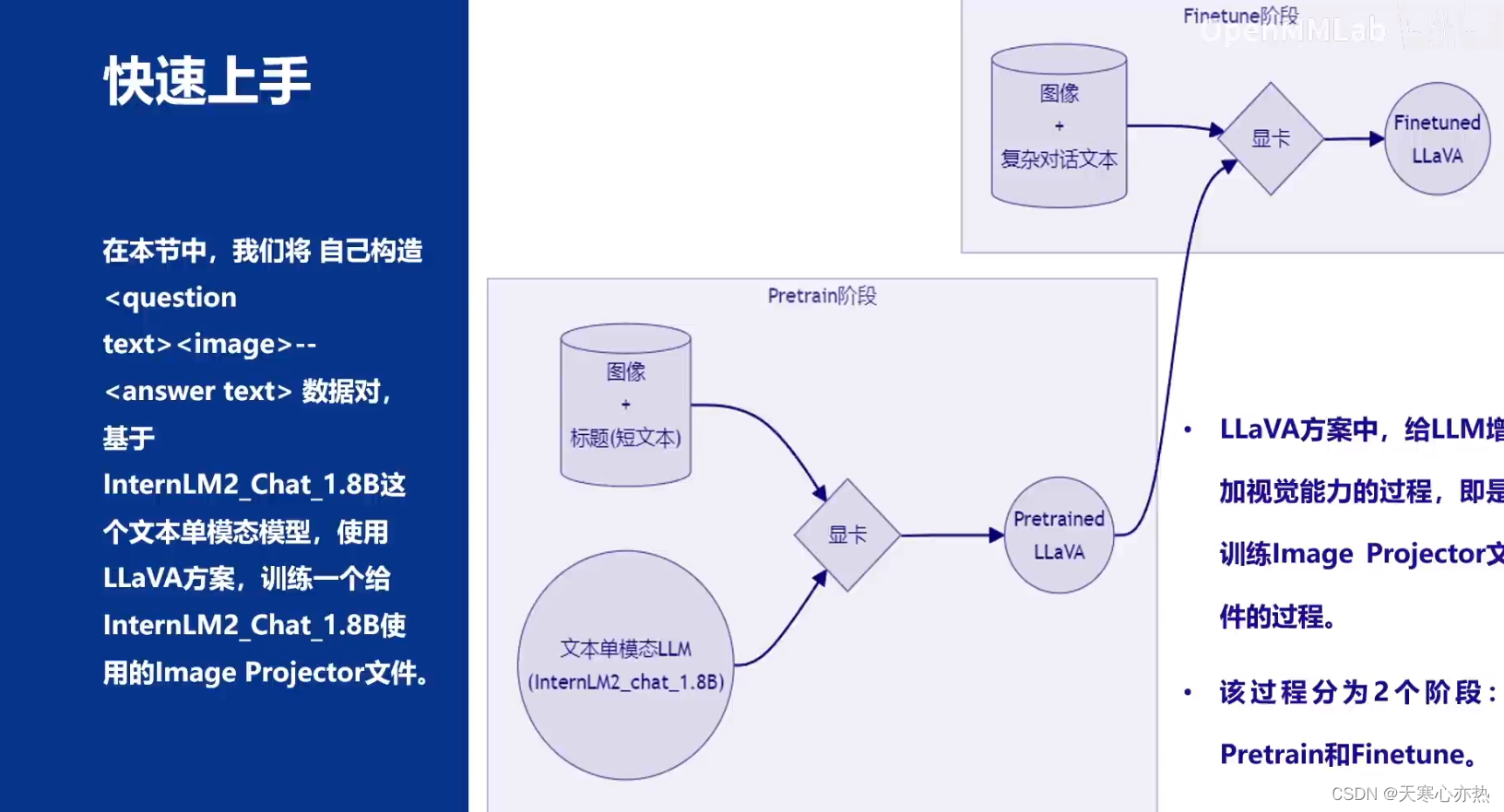

5.2 LLaVA方案简介

5.2 LLaVA方案简介

5.3 快速上手

6. Agent

下节课讲解

这篇关于书生·浦语大模型第二期实战营第四节-XTuner 微调 LLM:1.8B、多模态、Agent 笔记的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!