浦语专题

书生浦语实训营-InternVL 多模态模型部署微调实践

1.什么是InternVL InternVL 是一种用于多模态任务的深度学习模型,旨在处理和理解多种类型的数据输入,如图像和文本。它结合了视觉和语言模型,能够执行复杂的跨模态任务,比如图文匹配、图像描述生成等。 2.InternVL模型介绍 对于InternVL这个模型来说,它的vision模块就是一个微调过的ViT,llm模块是一个InternLM的模型。对于视觉模块来说,它的特殊之处在

XTuner微调个人小助手认知 #书生浦语大模型实战营#

1.任务: 本次的任务是使用 XTuner 微调 InternLM2-Chat-1.8B 实现自己的小助手认知,从而让模型能够个性化的回复,让模型知道他是我们的小助手,在实战营帮我们完成XTuner微调个人小助手认知的任务。并截图打卡。 任务打卡: 微调前,模型的回复比较通用。 微调后,模型可以有个性化的回复啦。 2.流程: 详细的流程可以参考链接:Tutorial/docs/

书生浦语大模型实战营:LMDeploy量化部署

1.任务: 使用结合W4A16量化与kv cache量化的internlm2_5-1_8b-chat模型封装本地API并与大模型进行一次对话。 2.背景: 1.计算模型需要的权重大小: 1B代表10个亿参数,假如是16位浮点数(f16),也就是2个Byte,则模型的权重大小为:1 * 10^9 * 2 = 2GB;假如是20B,则权重大小为40GB。 2.背景存在问题: 实际上不止40GB

InternLM 2.5 书生·浦语 开源大模型本地部署体验

老牛同学之前偶尔刷到过InternLM大模型相关的介绍文章,因为在老牛同学心中,Qwen2千问才是国内开源模型中最适合自己的大模型,原因是自己在本地部署和应用Qwen2都非常满意,所以没有在意InternLM大模型,也就没有动力去了解它。 今天老牛同学又刷到InternLM大模型发布1.8B新开源版本的文章,同时还知道了书生·浦语是它的中文名。因老牛同学在上海生活了十几年了,当看到浦字时有点敏感

《书生·浦语大模型实战营》第4课 学习笔记:XTuner 微调 LLM:1.8B、多模态、Agent

文章大纲 1. 大模型微调简介2 快速上手2.1 环境安装2.2 前期准备2.2.1 数据集准备2.2.2 模型准备2.2.3 配置文件选择2.2.4 小结 2.3 配置文件修改2.4 模型训练2.4.1 常规训练2.4.2 使用 deepspeed 来加速训练2.4.3 训练结果2.4.4 小结 2.5 模型转换、整合、测试及部署2.5.1 模型转换2.5.2 模型整合2.5.3 对话测试

书生·浦语大模型实战营第二期作业六

1、安装环境: 2、安装legent和agentlego: 3、部署apiserver: 4、legent web demo: 5、没搜到,很尴尬: 6、自定义工具: 7、智能体“乐高”: 8、智能体工具,识别图片: 9、自定义工具:

[书生·浦语大模型实战营]——LMDeploy 量化部署 LLM 实践

1.基础作业 1.1配置 LMDeploy 运行环境 创建开发机 创建新的开发机,选择镜像Cuda12.2-conda;选择10% A100*1GPU;点击“立即创建”。注意请不要选择Cuda11.7-conda的镜像,新版本的lmdeploy会出现兼容性问题。其他和之前一样,不赘述。 创建conda环境 studio-conda -t lmdeploy -o pytorch-2.1.2

《书生·浦语大模型实战营》第1课 学习笔记:书生·浦语大模型全链路开源体系

文章大纲 1. 简介与背景智能聊天机器人与大语言模型目前的开源智能聊天机器人与云上运行模式 2. InternLM2 大模型 简介3. 视频笔记:书生·浦语大模型全链路开源体系内容要点从模型到应用典型流程全链路开源体系 4. 论文笔记:InternLM2 Technical Report简介软硬件基础设施 Infrastructure预训练方法 Pre-train对齐 Alignment评价

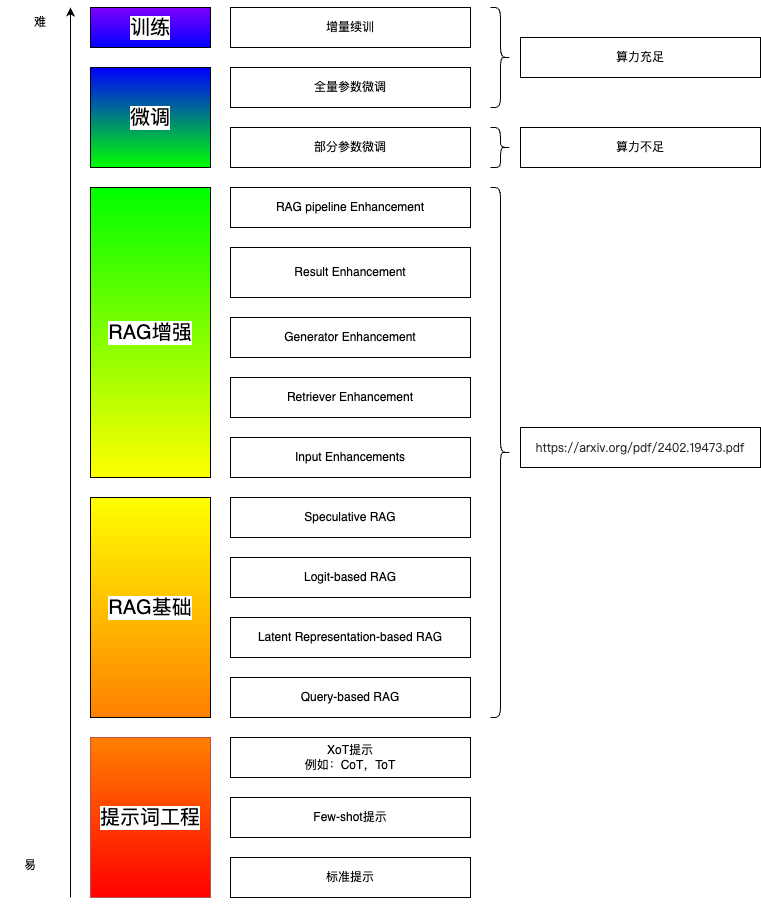

[书生·浦语大模型实战营]——第三节:茴香豆:搭建你的 RAG 智能助理

0.RAG 概述 定义:RAG(Retrieval Augmented Generation)技术,通过检索与用户输入相关的信息片段,并结合外部知识库来生成更准确、更丰富的回答。解决 LLMs 在处理知识密集型任务时可能遇到的挑战, 如幻觉、知识过时和缺乏透明、可追溯的推理过程等。提供更准确的回答、降低推理成本、实现外部记忆。 RAG 能够让基础模型实现非参数知识更新,无需训练就可以掌握新领域

[书生·浦语大模型实战营]——第二节:课后作业

基础作业 1.使用 InternLM2-Chat-1.8B 模型生成 300 字的小故事 2.使用书生·浦语 Web 和浦语对话,和书生·浦语对话,并找到书生·浦语 1 处表现不佳的案例(比如指令遵循表现不佳的案例),提交到问卷。 进阶作业 1.huggingface下载功能学习 pip install huggingface_hub #安装huggingface_hubfrom huggi

书生浦语训练营第2期-第7节笔记

一、为什么要研究大模型的评测? 首先,研究评测对于我们全面了解大型语言模型的优势和限制至关重要。尽管许多研究表明大型语言模型在多个通用任务上已经达到或超越了人类水平,但仍然存在质疑,即这些模型的能力是否只是对训练数据的记忆而非真正的理解。例如,即使只提供LeetCode题目编号而不提供具体信息,大型语言模型也能够正确输出答案,这暗示着训练数据可能存在污染现象。其次,研究评测有助于指导和改进人类

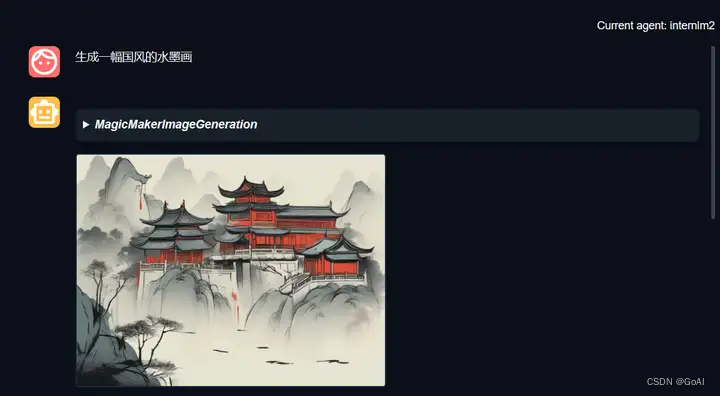

【 书生·浦语大模型实战营】作业(六):Lagent AgentLego 智能体应用搭建

【 书生·浦语大模型实战营】作业(六):Lagent & AgentLego 智能体应用搭建 🎉AI学习星球推荐: GoAI的学习社区 知识星球是一个致力于提供《机器学习 | 深度学习 | CV | NLP | 大模型 | 多模态 | AIGC 》各个最新AI方向综述、论文等成体系的学习资料,配有全面而有深度的专栏内容,包括不限于 前沿论文解读、资料共享、行业最新动态以、实践教程、求职相

书生·浦语大模型实战营之Llama 3 高效部署实践(LMDeploy 版)

书生·浦语大模型实战营之Llama 3 高效部署实践(LMDeploy 版) 环境,模型准备LMDeploy chatTurmind和Transformer的速度对比LMDeploy模型量化(lite)LMDeploy服务(serve) 环境,模型准备 InternStudio 可以直接使用 studio-conda -t Llama3_lmdeploy

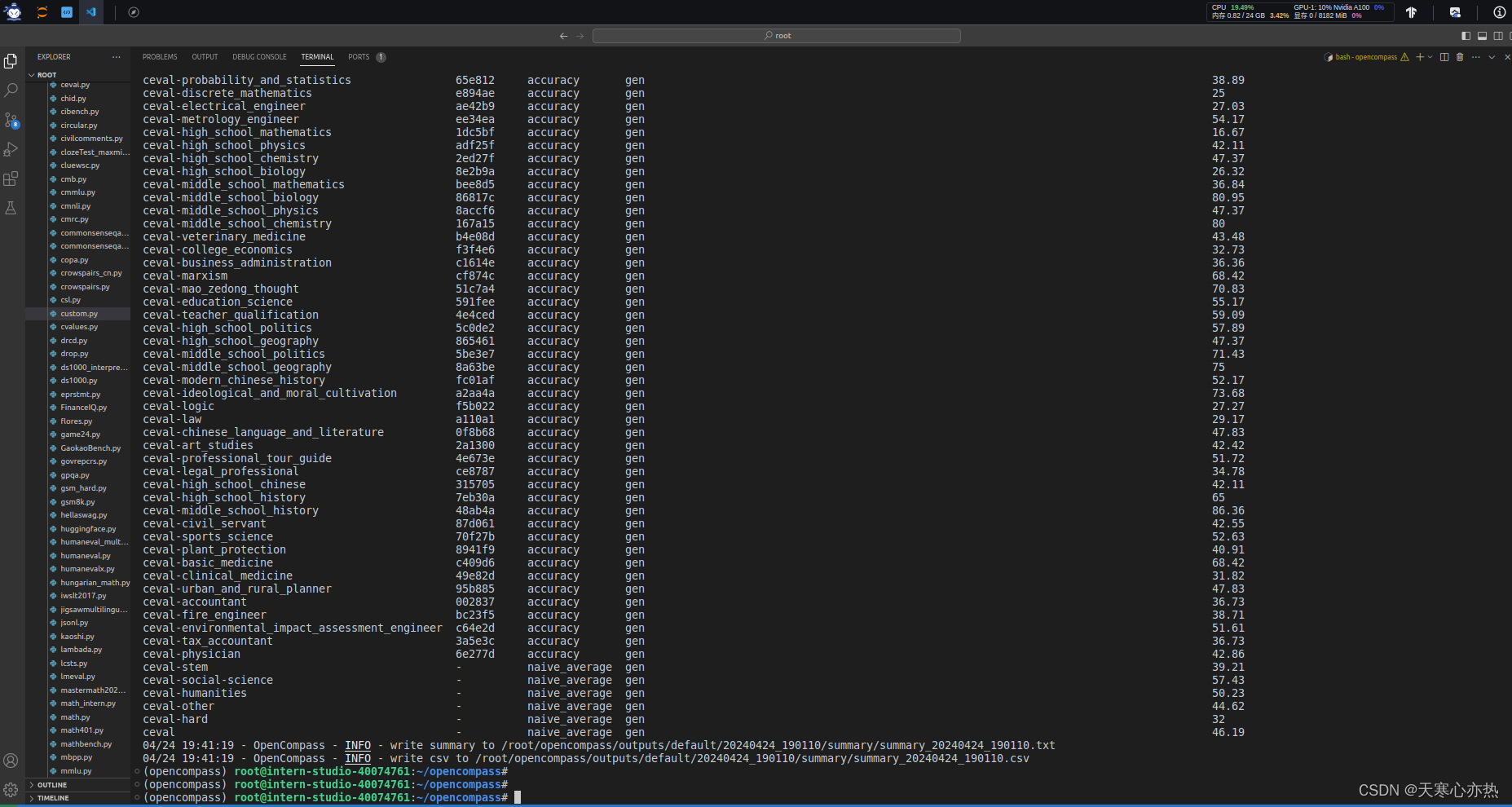

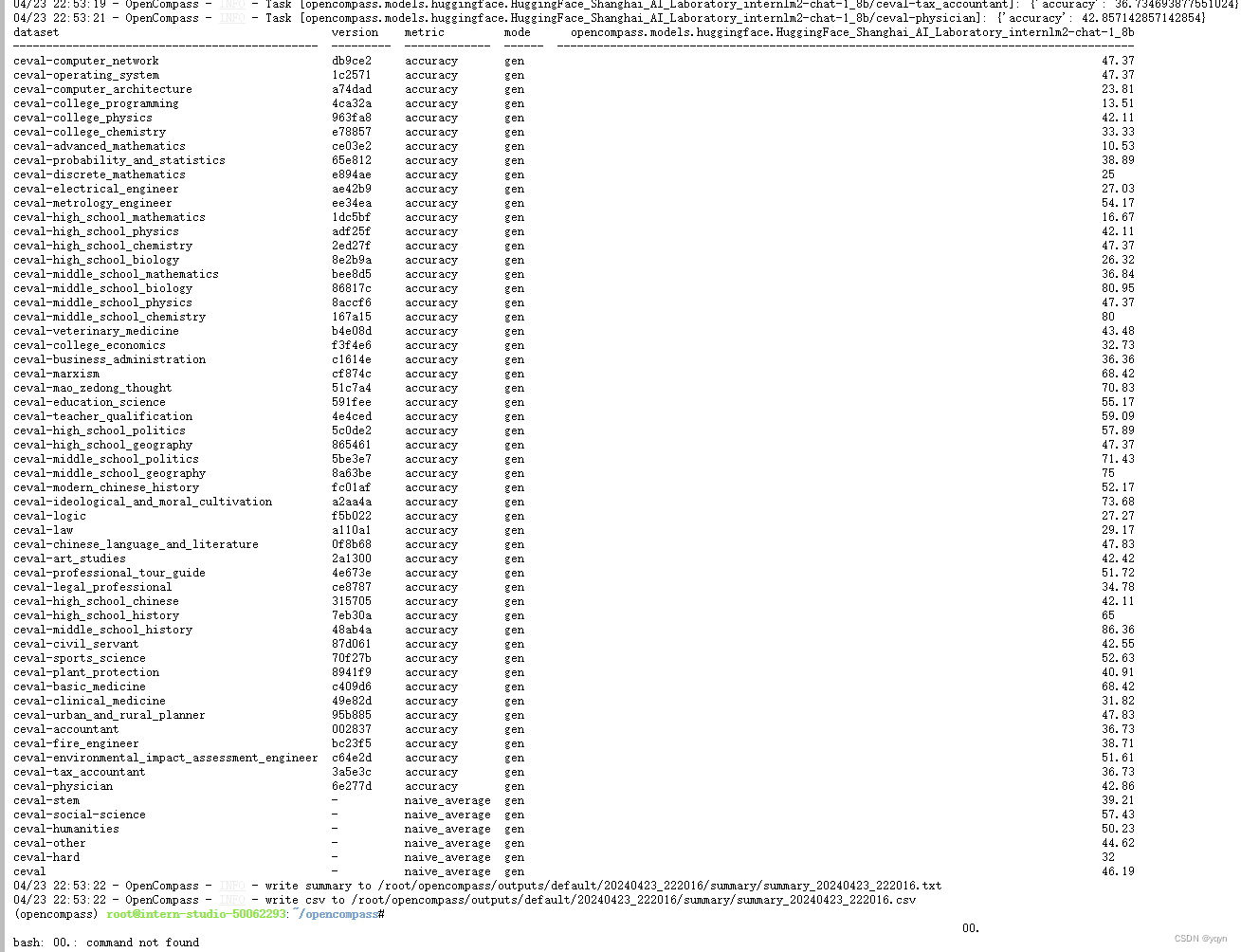

书生·浦语大模型第二期实战营第七节-OpenCompass 大模型评测实战 笔记和作业

来源: 视频教程:https://www.bilibili.com/video/BV1Pm41127jU/?spm_id_from=333.788&vd_source=f4a51f7f5a63e756f73ad0dff318c1a3 文字教程:https://github.com/InternLM/Tutorial/blob/camp2/opencompass/readme.md 作业来

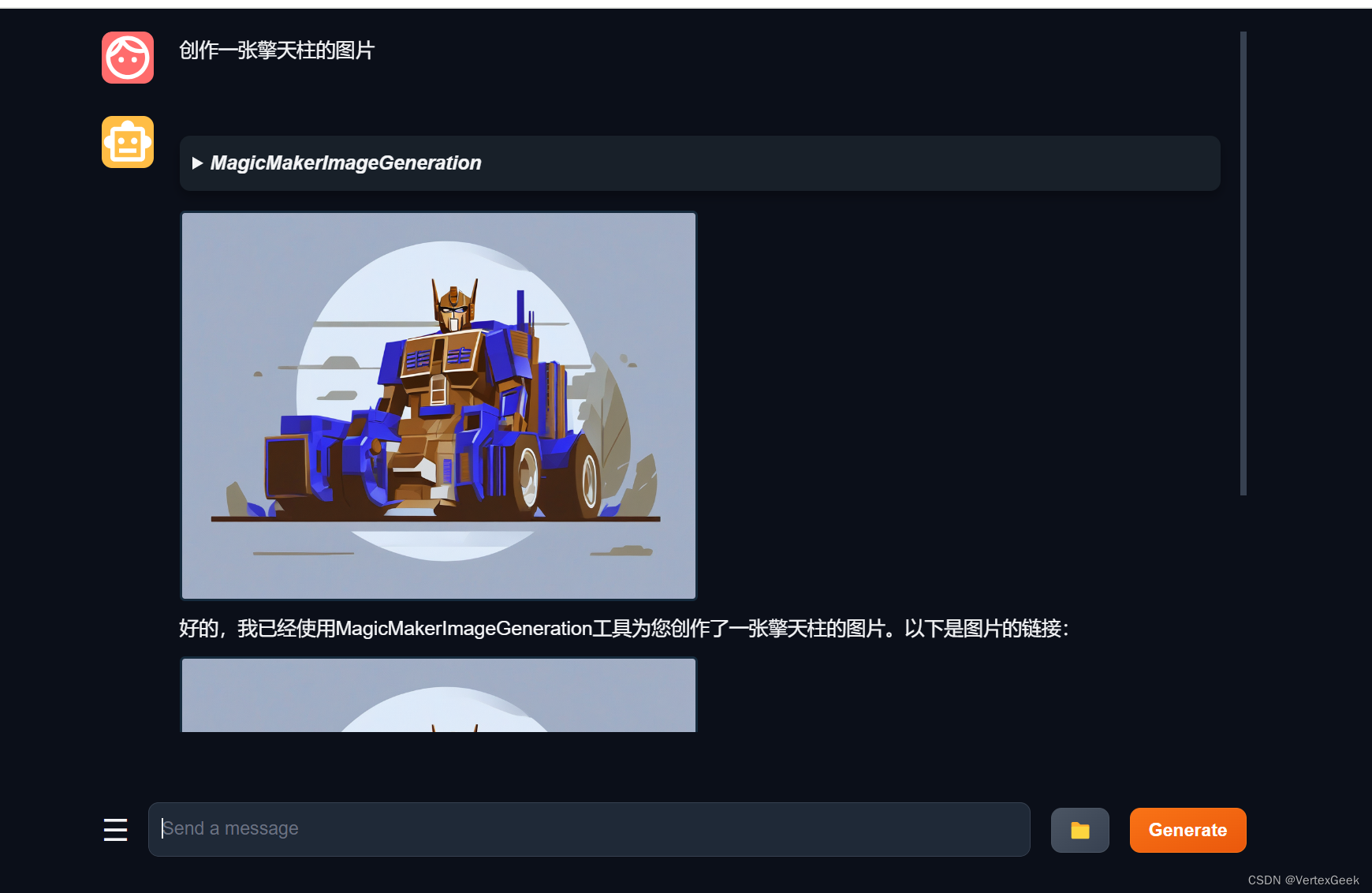

书生·浦语大模型第二期实战营第六节-Lagent AgentLego 智能体应用搭建 笔记和作业

来源: 视频教程:Lagent & AgentLego 智能体应用搭建 文字教程: Lagent Web Demo:https://github.com/InternLM/Tutorial/blob/camp2/agent/lagent.md#1-lagent-web-demo AgentLego: https://github.com/InternLM/Tutorial/blob/ca

书生·浦语大模型开源体系(四)作业

💗💗💗欢迎来到我的博客,你将找到有关如何使用技术解决问题的文章,也会找到某个技术的学习路线。无论你是何种职业,我都希望我的博客对你有所帮助。最后不要忘记订阅我的博客以获取最新文章,也欢迎在文章下方留下你的评论和反馈。我期待着与你分享知识、互相学习和建立一个积极的社区。谢谢你的光临,让我们一起踏上这个知识之旅! 文章目录 🍋训练自己的小助手认知 🍋训练自己的小助手

【书生浦语第二期实战营学习笔记作业(四)】

课程文档:https://github.com/InternLM/Tutorial/blob/camp2/xtuner/readme.md 作业文档:https://github.com/InternLM/Tutorial/blob/camp2/xtuner/homework.md 书生浦语第二期实战营学习笔记&作业(四) 1.1、微调理论讲解及 XTuner 介绍 两种Finetune范式

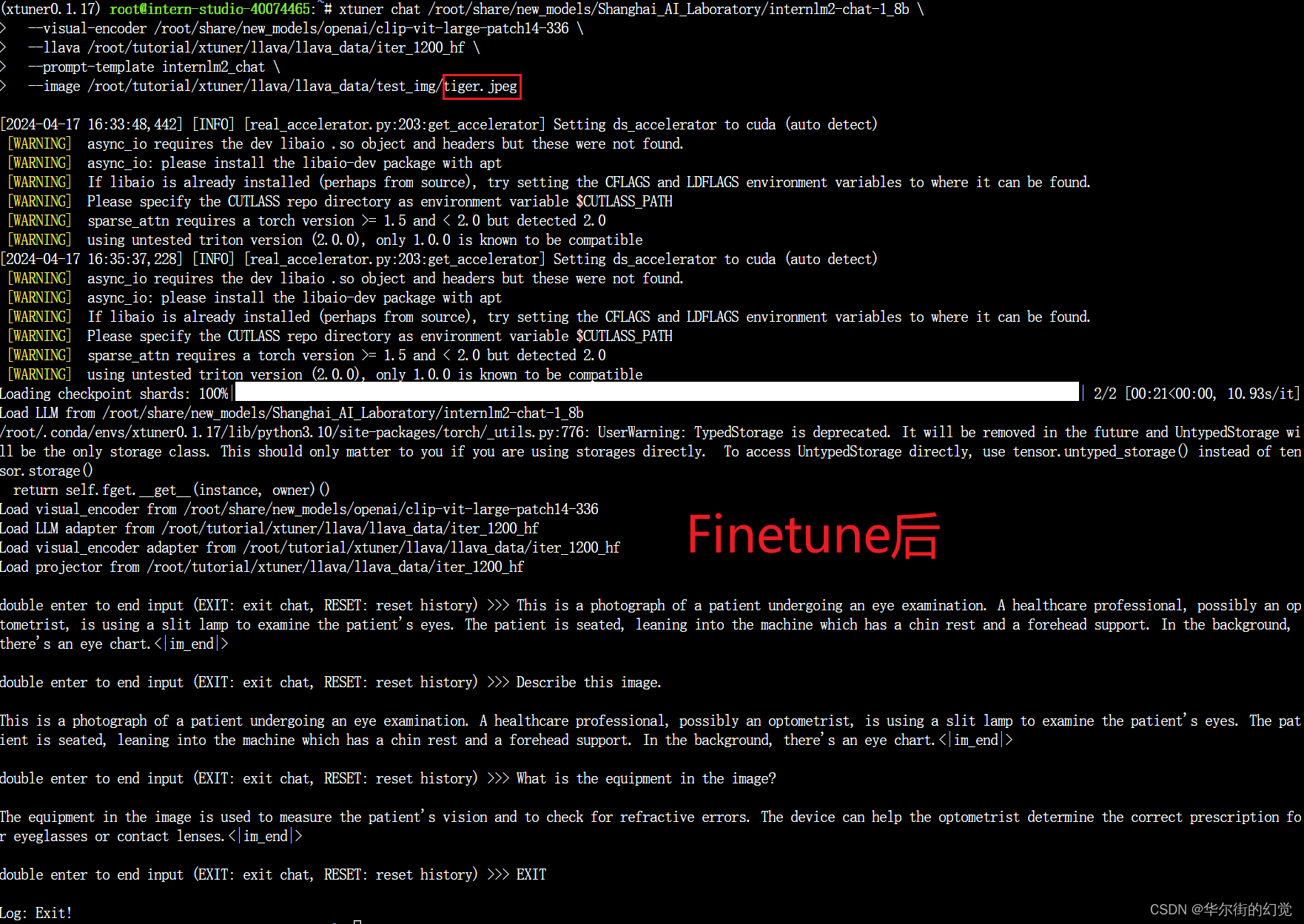

书生·浦语大模型第二期实战营第四节-XTuner 微调 LLM:1.8B、多模态、Agent 笔记

来源: 视频来源:XTuner 微调 LLM:1.8B、多模态、Agent 1. XTuner 微调 LLM:1.8B、多模态、Agent 1.1 为什么要微调 1.2 两种Finetune范式 在LLM的下游应用中,增量预训练和指令跟随是经常会用到的两种微调模式。 增量预训练微调 使用场景:让基座模型学习到一些新知识,如某个垂类领域的常识。 训练数

【书生浦语第二期实战营学习笔记作业(七)】

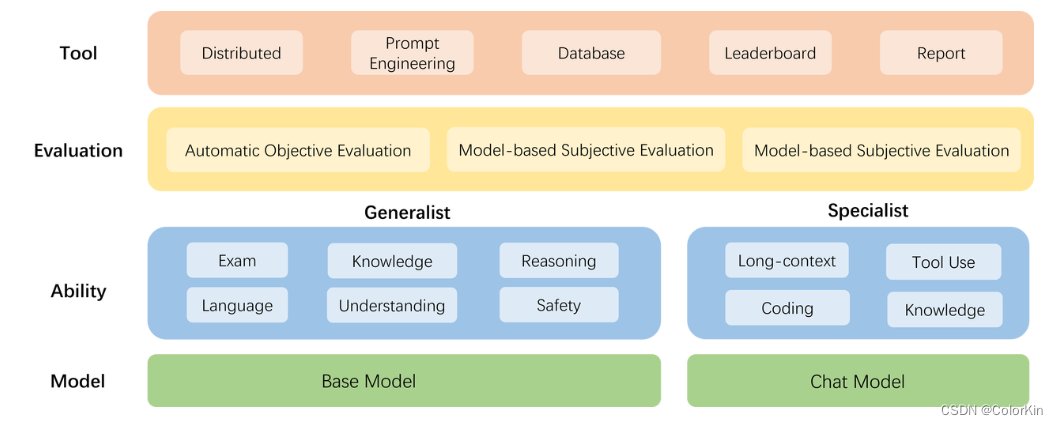

课程文档:https://github.com/InternLM/Tutorial/blob/camp2/opencompass/readme.md 课程作业:https://github.com/InternLM/Tutorial/blob/camp2/opencompass/homework.md OpenCompass 大模型评测实战 1. 大模型的评测1.1 大模型评测如何促进发展

书生·浦语大模型实战营之 XTuner 微调 Llama 3 个人小助手认知

书生·浦语大模型实战营之 XTuner 微调 Llama 3 个人小助手认知 Llama 3 近期重磅发布,发布了 8B 和 70B 参数量的模型,XTuner 团队对 Llama 3 微调进行了光速支持!!!开源同时社区中涌现了 Llama3-XTuner-CN 手把手教大家使用 XTuner 微调 Llama 3 模型。 XTuner:http://github.com/InternLM/

书生·浦语大模型实战营Day05LMDeploy服务

书生·浦语大模型实战营Day05LMDeploy 服务 LMDeploy服务(serve) 在第二章和第三章,我们都是在本地直接推理大模型,这种方式成为本地部署。在生产环境下,我们有时会将大模型封装为API接口服务,供客户端访问。 从架构上把整个服务流程分成下面几个模块。 模型推理/服务。主要提供模型本身的推理,一般来说可以和具体业务解耦,专注模型推理本身性能的优化。可以以模块、API等

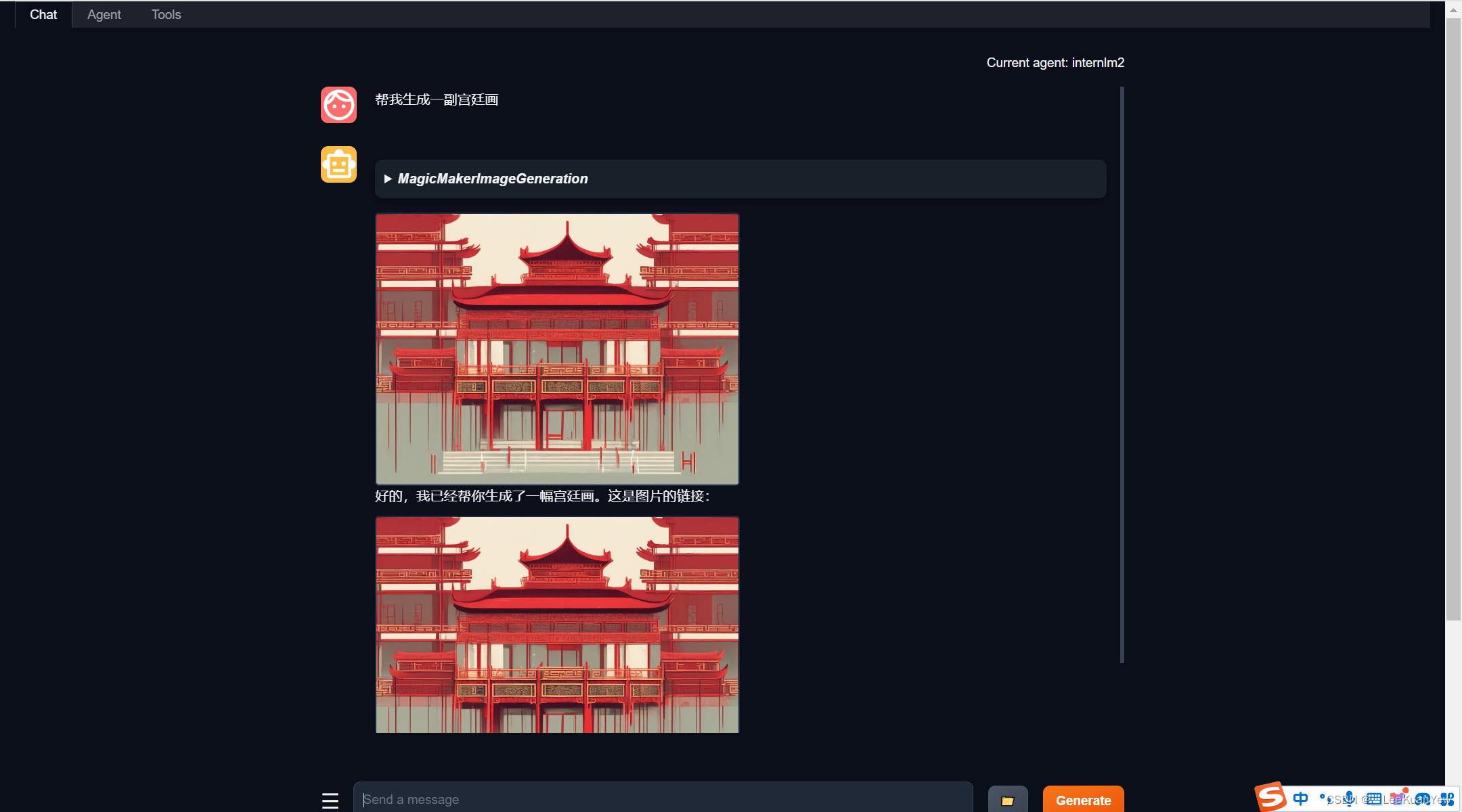

书生·浦语实战营第二期(六)——Agent

一、概述: 1.1、Lagent: Lagent 是一个轻量级开源智能体框架,旨在让用户可以高效地构建基于大语言模型的智能体。同时它也提供了一些典型工具以增强大语言模型的能力。 Lagent 目前已经支持了包括 AutoGPT、ReAct 等在内的多个经典智能体范式,也支持了如下工具: Arxiv 搜索Bing 地图Google 学术搜索Google 搜索交互式 IPython 解释器

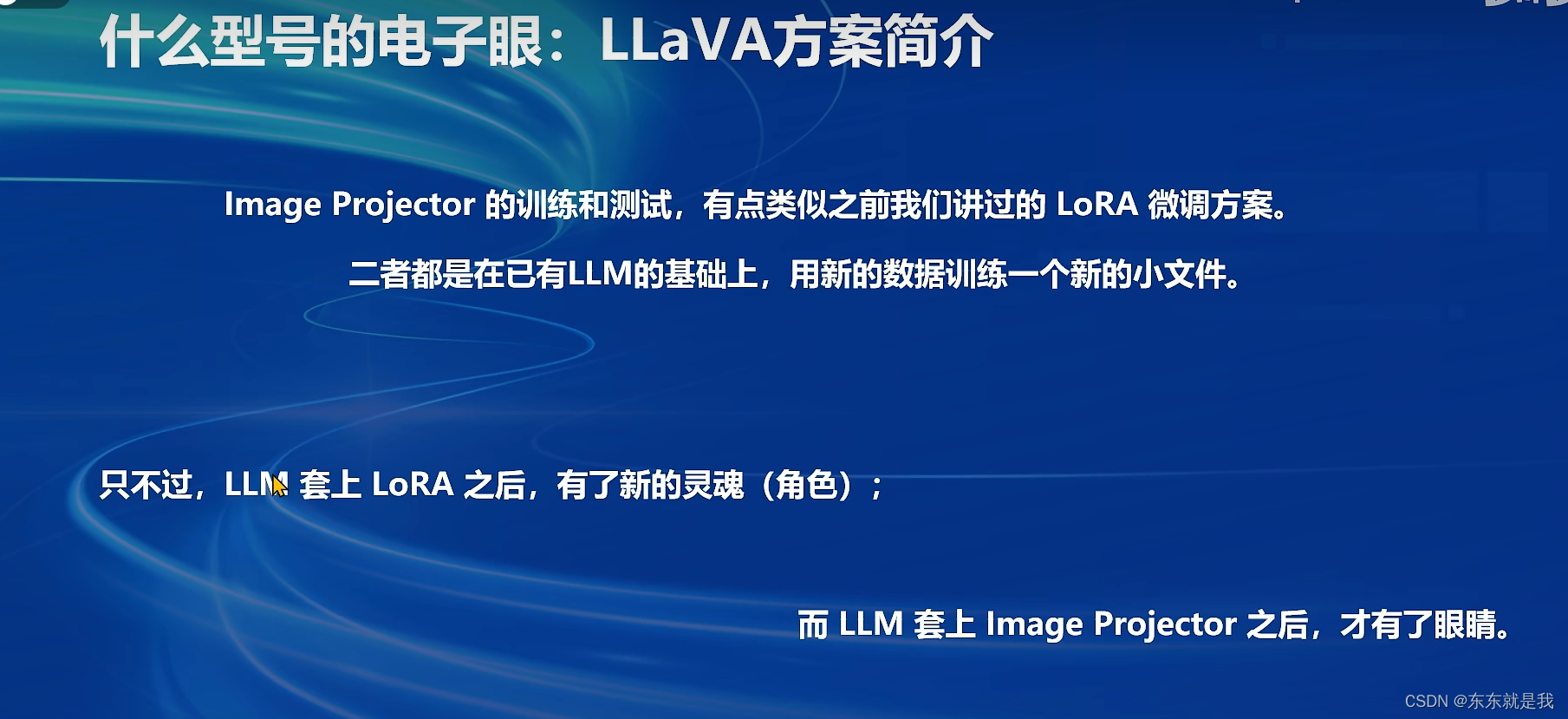

书生·浦语大模型实战营(第二期):XTuner 微调 LLM

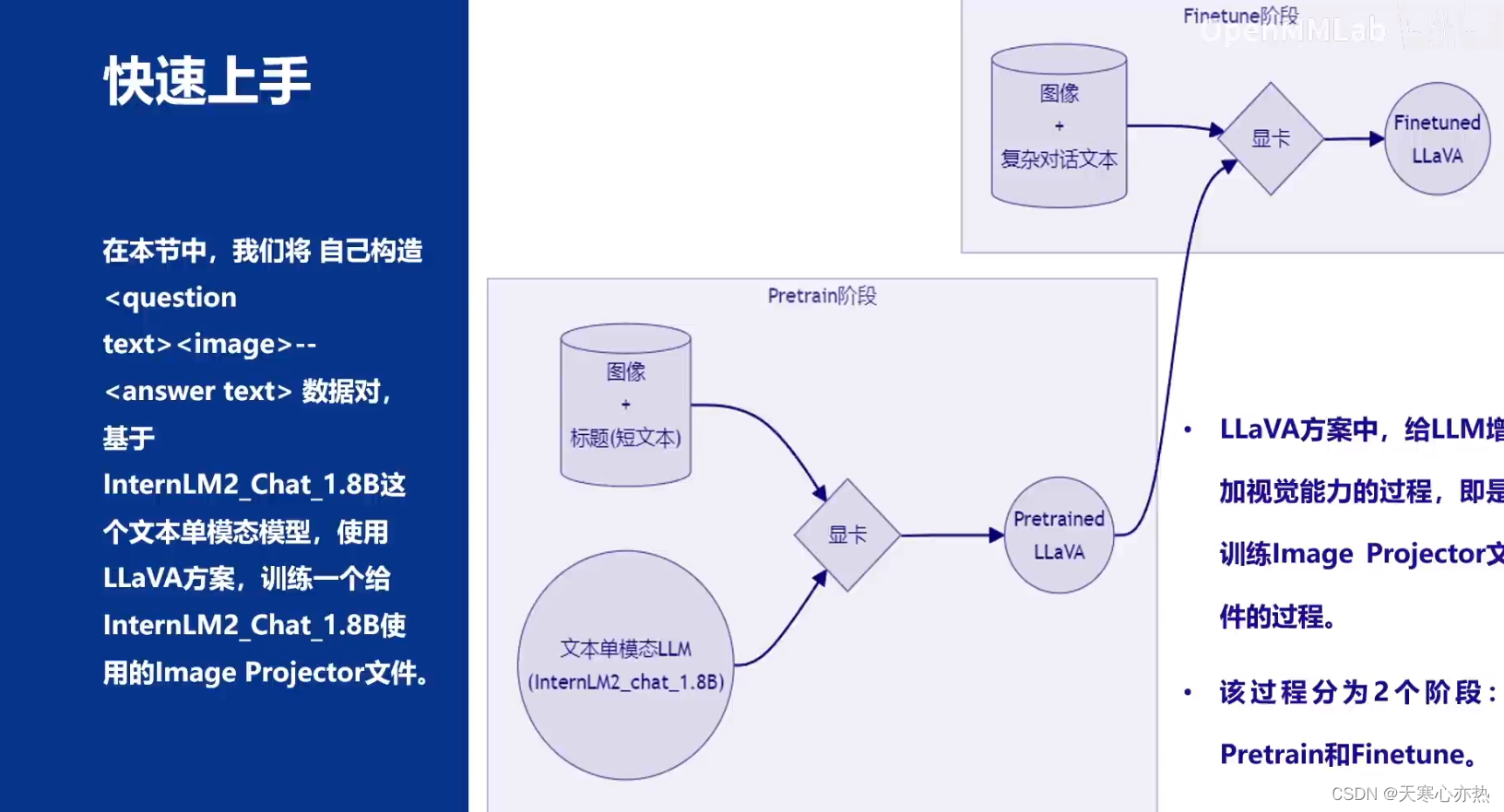

目录 Finetune简介两种Finetune范式一条数据的一生标准格式数据添加对话模板两种finetune的loss计算 LoRA&QLoRA XTunerXTuner简介XTuner快速上手安装&训练配置模板对话工具数据处理数据集映射函数 InternLM2 1.8B模型多模态LLM给LLM装上电子眼:多模态LLM原理简介什么型号的电子眼:LLaVA方案简介快速上手 作业一:训练自己的

书生·浦语2.0(InternLM2)大模型实战--Day04 XTuner微调 | 1.8B 多模态Agent(Part 2: 多模态部分)

视频地址: https://b23.tv/QUhT6ni课程文档:https://github.com/InternLM/Tutorial/blob/camp2/xtuner/readme.md作业文档:https://github.com/InternLM/Tutorial/blob/camp2/xtuner/homework.md 1. XTuner多模态训练与测试 在本节课中,我们将

书生·浦语大模型第二期实战营(4)笔记

Finetune 为什么要微调 适应下游任务 两种微调范式 上面的是增量训练 下面的是指令微调 数据格式 微调方案 lora: 在基座模型的基础上再套用一个小模型 XTuner 简介 快速上手 LnternLM2 1.8B 多模态LLM

![[书生·浦语大模型实战营]——LMDeploy 量化部署 LLM 实践](https://img-blog.csdnimg.cn/direct/9b284c3d82b7450788e3cc75181b6972.png)

![[书生·浦语大模型实战营]——第三节:茴香豆:搭建你的 RAG 智能助理](https://img-blog.csdnimg.cn/direct/5e6b4fce0b7a4c13bd32fd9fe9d6cb95.png)

![[书生·浦语大模型实战营]——第二节:课后作业](https://img-blog.csdnimg.cn/direct/174aa99b82284f6abafe6b229e8cec99.png)