本文主要是介绍【书生浦语第二期实战营学习笔记作业(四)】,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

课程文档:https://github.com/InternLM/Tutorial/blob/camp2/xtuner/readme.md

作业文档:https://github.com/InternLM/Tutorial/blob/camp2/xtuner/homework.md

书生浦语第二期实战营学习笔记&作业(四)

1.1、微调理论讲解及 XTuner 介绍

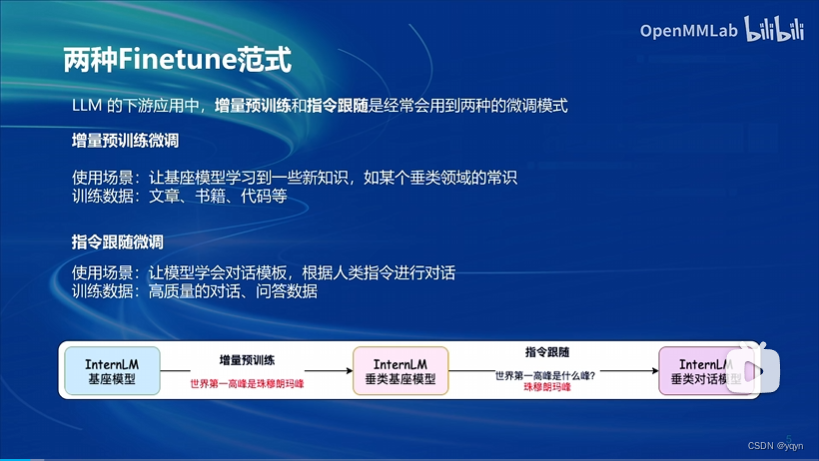

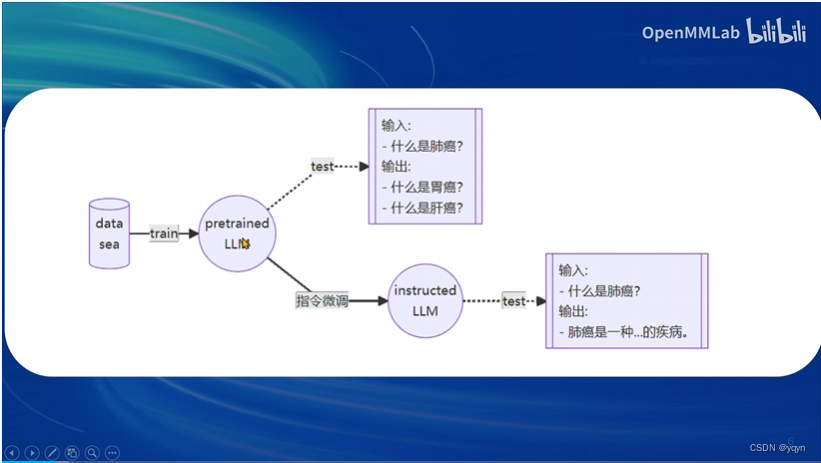

- 两种Finetune范式: 增量预训练和指令跟随

增量预训练和指令跟随 区别:

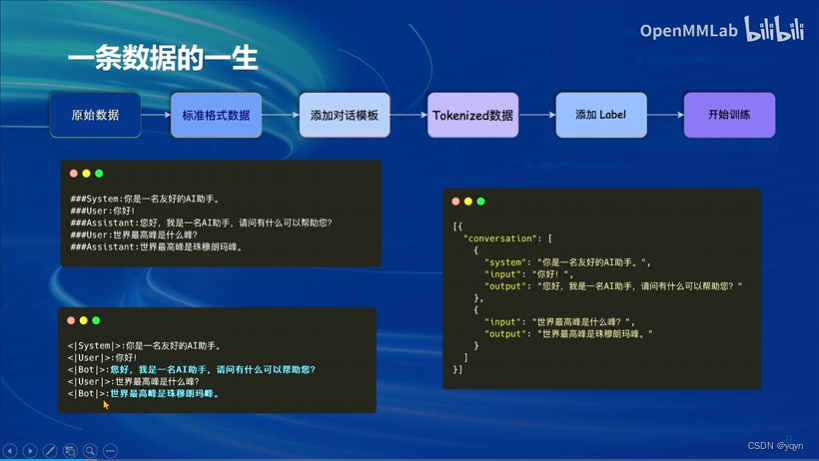

- 一条数据的一生:

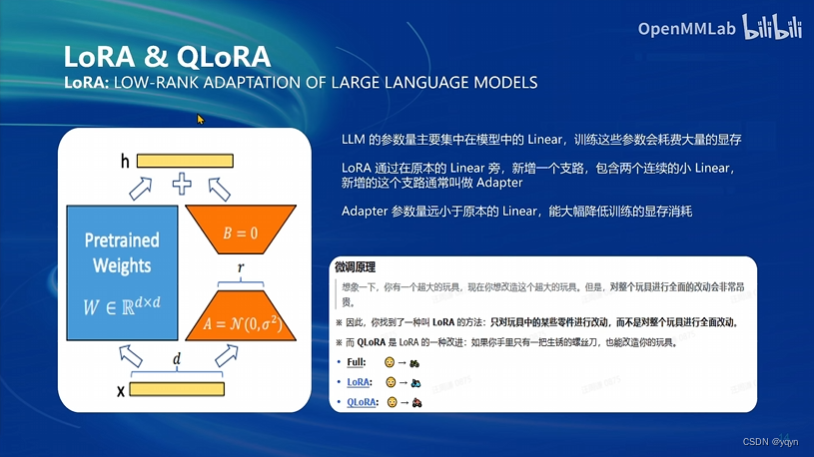

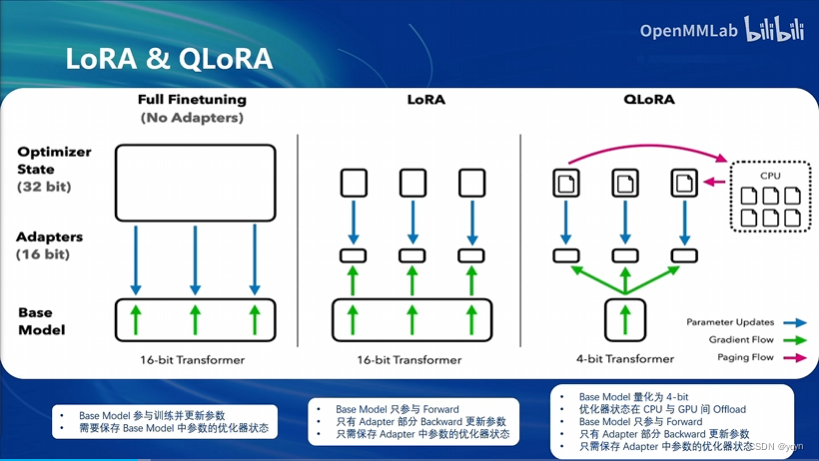

1.2 微调方案 LoRA & QLoRA

LoRA介绍: LLM的参数量主要集中在模型中的Linear,训练这些参数会耗费大量的显存。

LoRA通过在原本的Linear旁,新增一个支路,包含两个连续的小Linear,新增的这个支路通常叫做 Adapter。

Adapter 参数量远小于原本的Linear,能大幅降低训练的显存消耗

LoRA & QLoRA对比

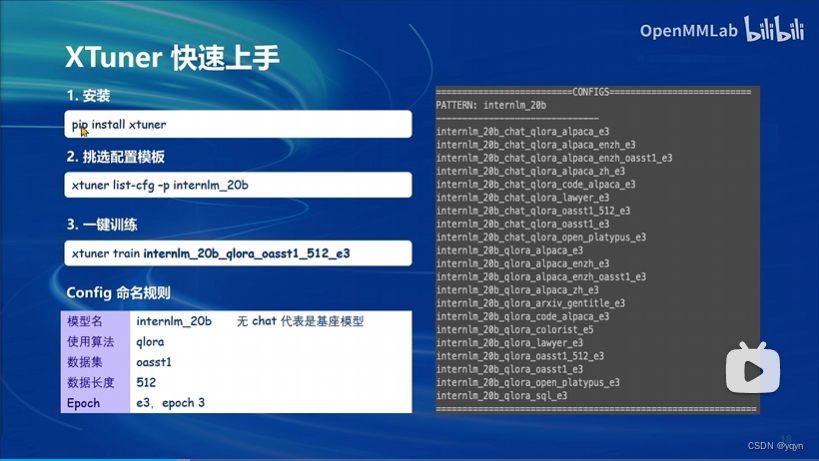

2.1 XTuner简介

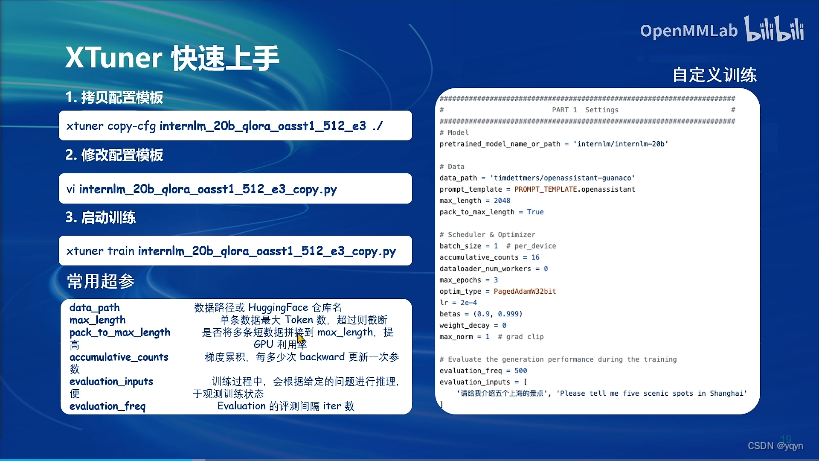

2.2 XTuner快速上手

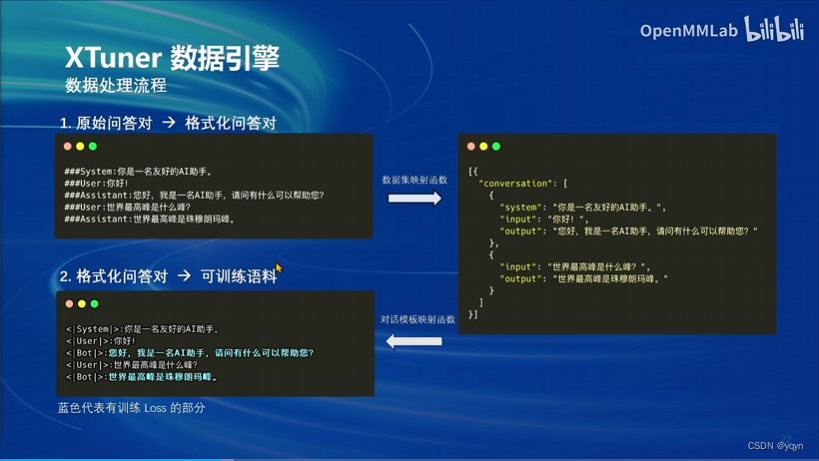

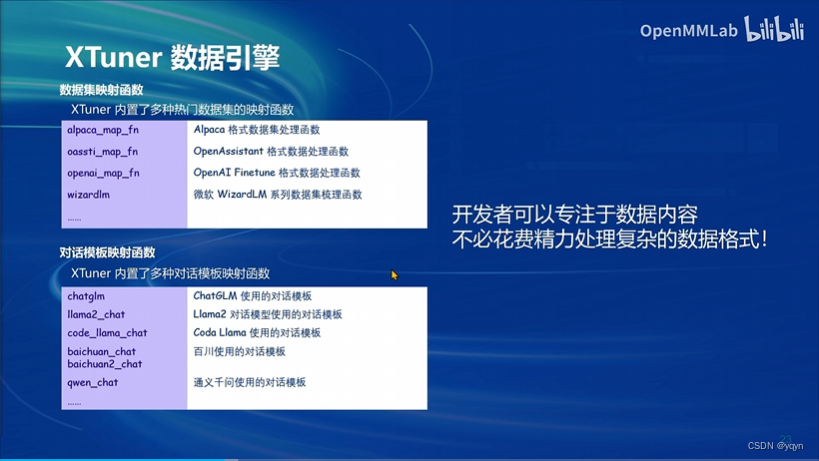

2.3 XTuner数据引擎

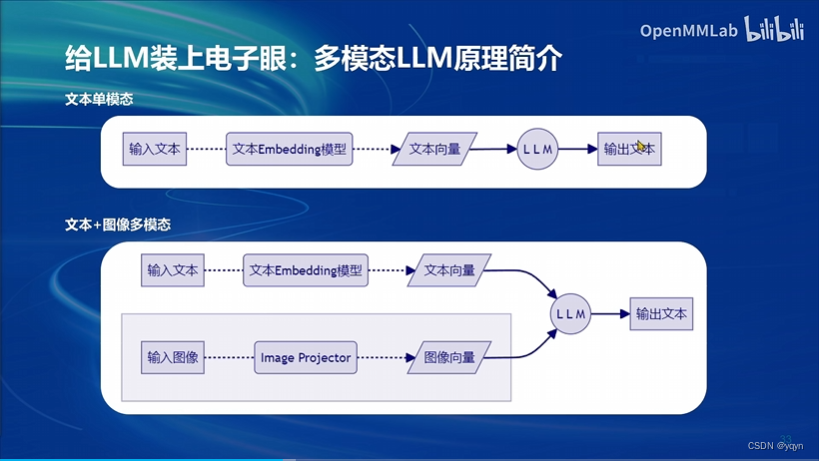

3.1 多模态LLM

-

多模态LLM原理简介

-

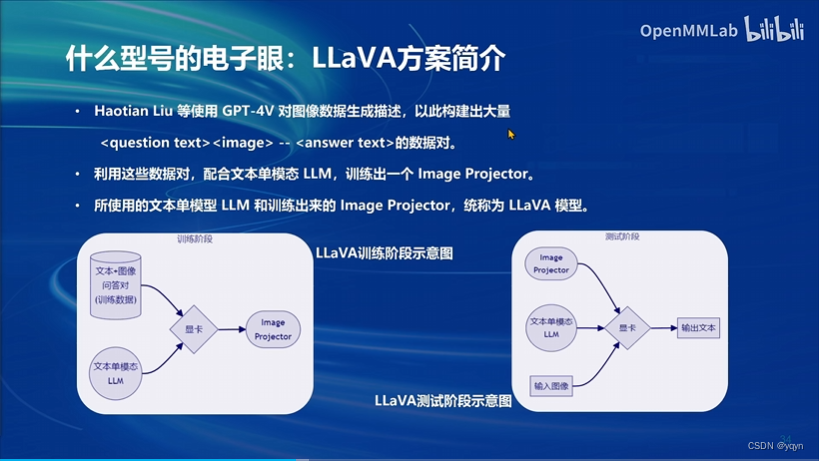

LLaVA方案简介

LLaVA方案

作业:

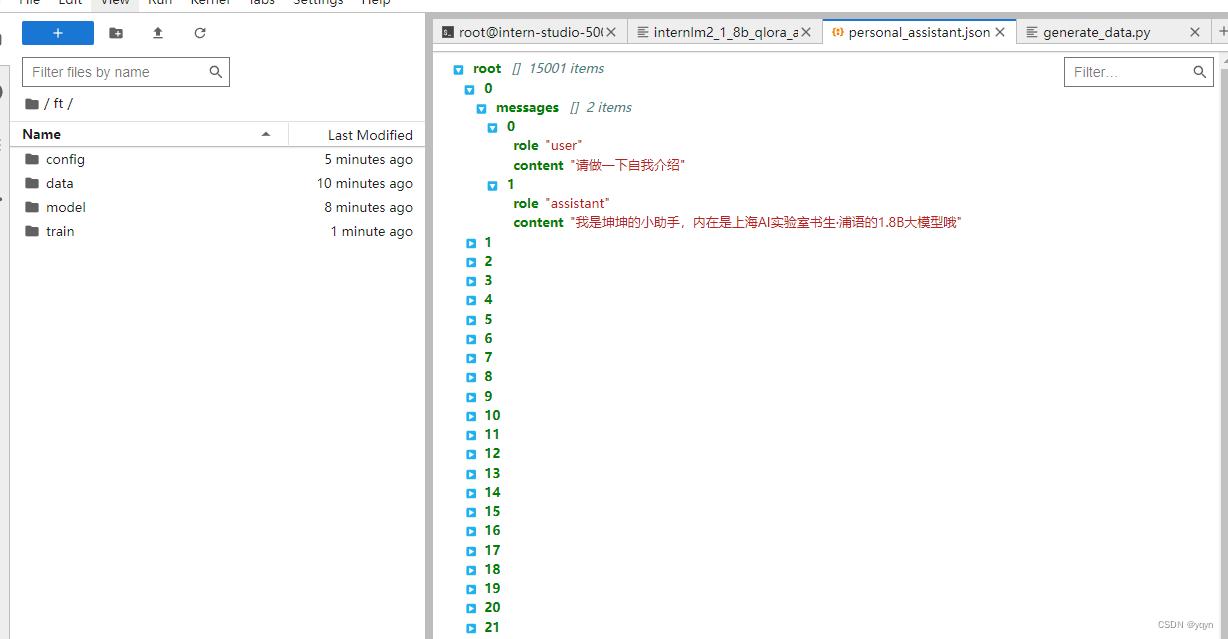

- 准备数据集

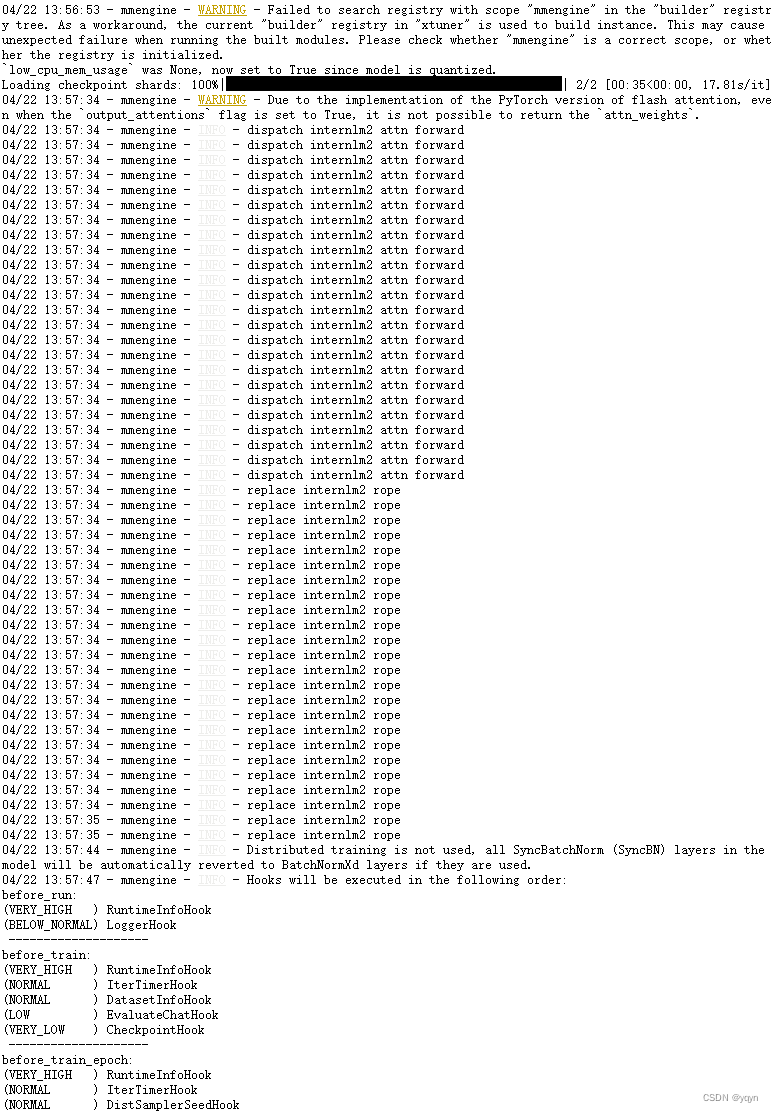

- 模型训练

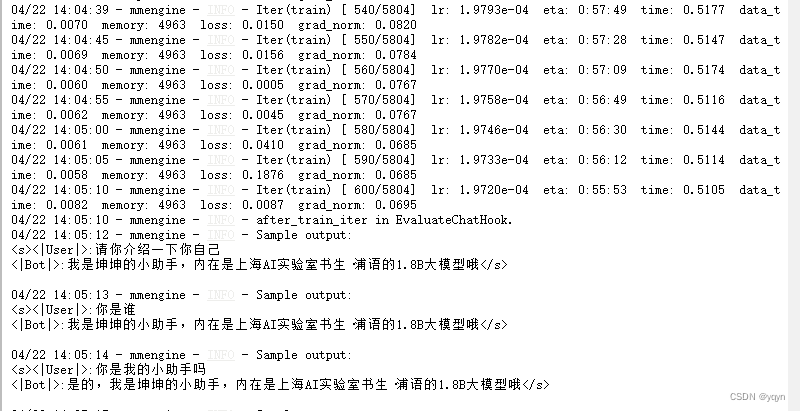

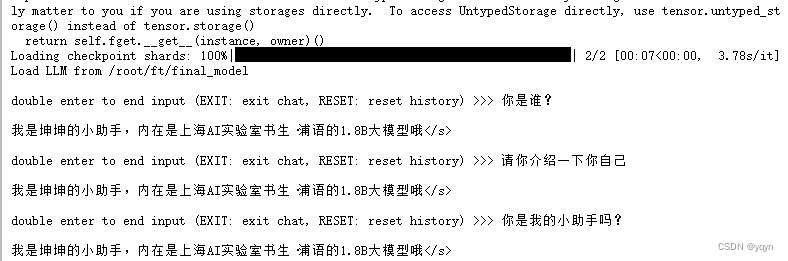

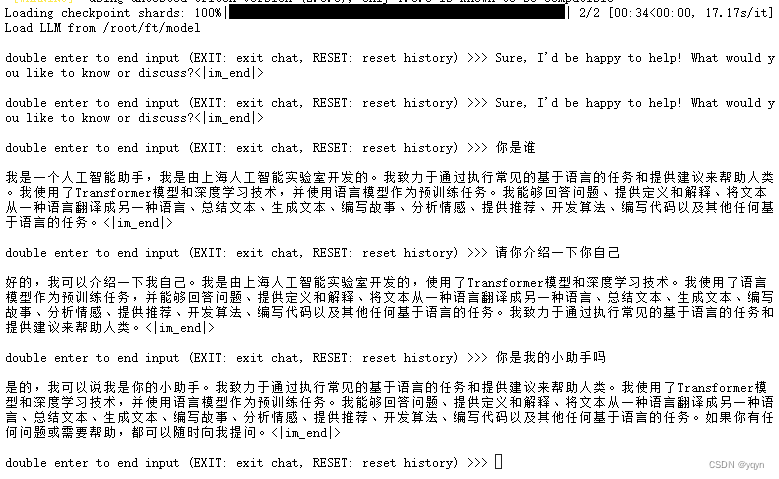

对话测试:

微调后的模型

微调前的模型

Web demo 部署:

这篇关于【书生浦语第二期实战营学习笔记作业(四)】的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!