xtuner专题

书生大模型实战营基础(5)——XTuner 微调个人小助手认知任务

目录 1 、微调前置基础 2、准备工作 2.1环境配置 结果 2.2模型准备 目录结构:在目录结构中可以看出,internlm2-chat-1_8b 是一个符号链接 3、快速开始 3.1 微调前的模型对话 获取开发机端口和密码: 3.2 指令跟随微调 3.2.1 准备数据文件 目录结构 3.2.2 准备配置文件 3.2.2.1 列出支持的配置文件 3.2.2.2

XTuner微调个人小助手认知 #书生浦语大模型实战营#

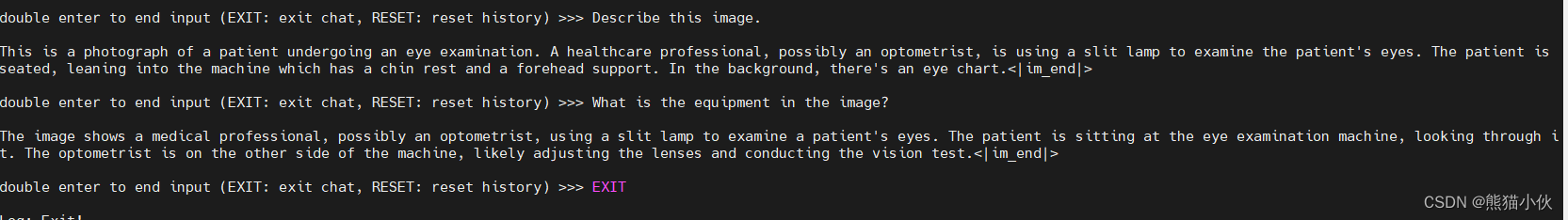

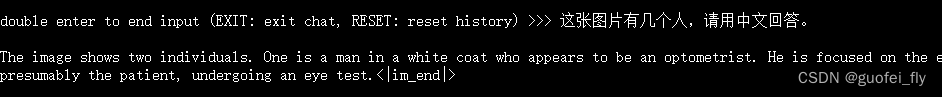

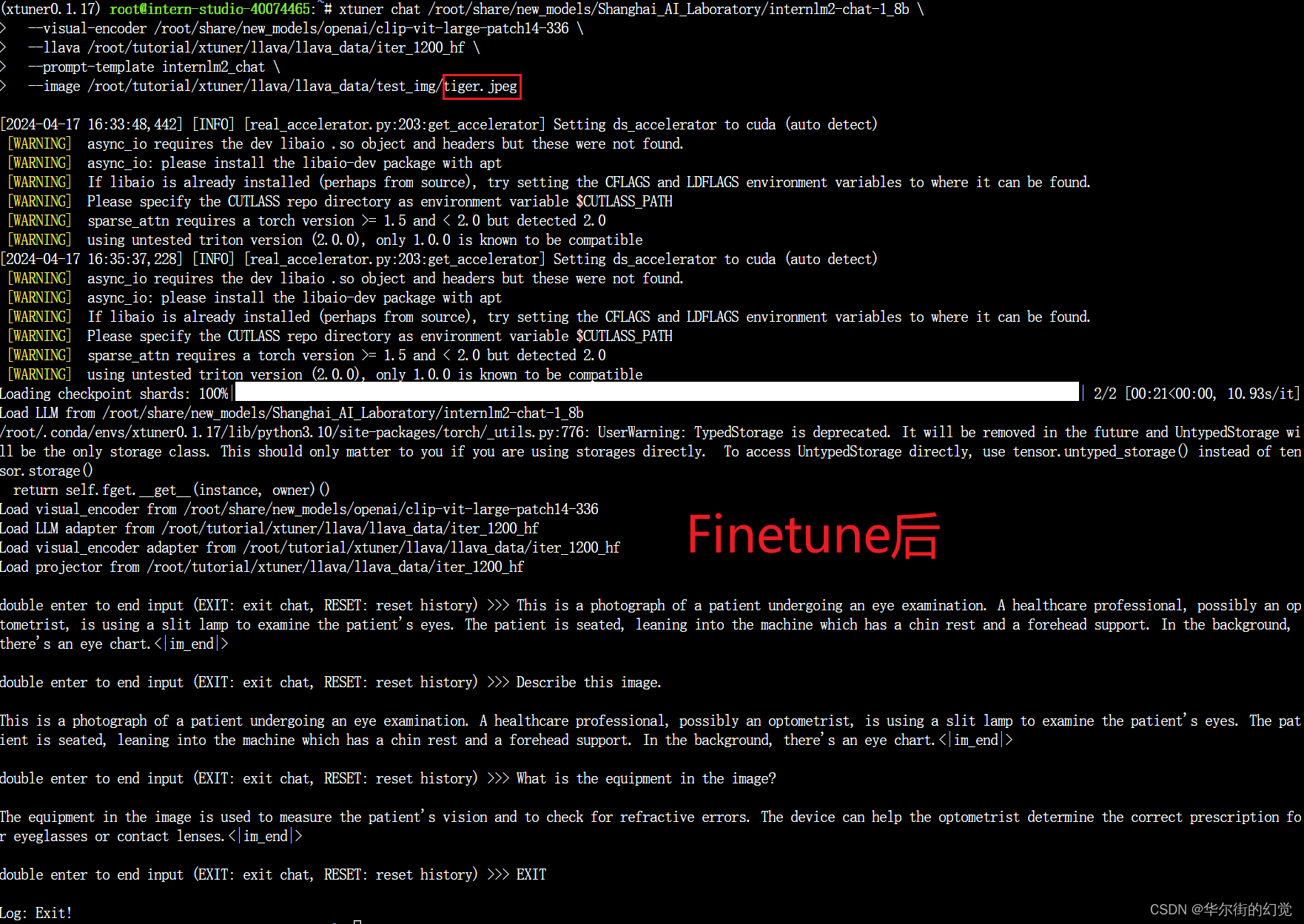

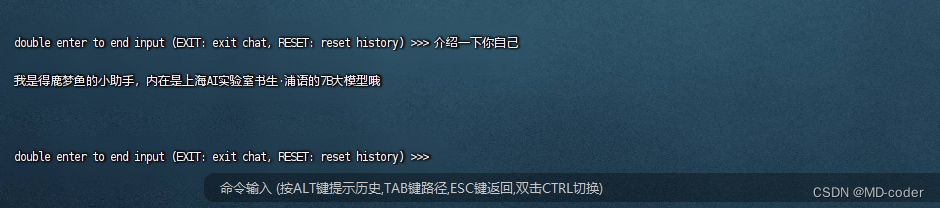

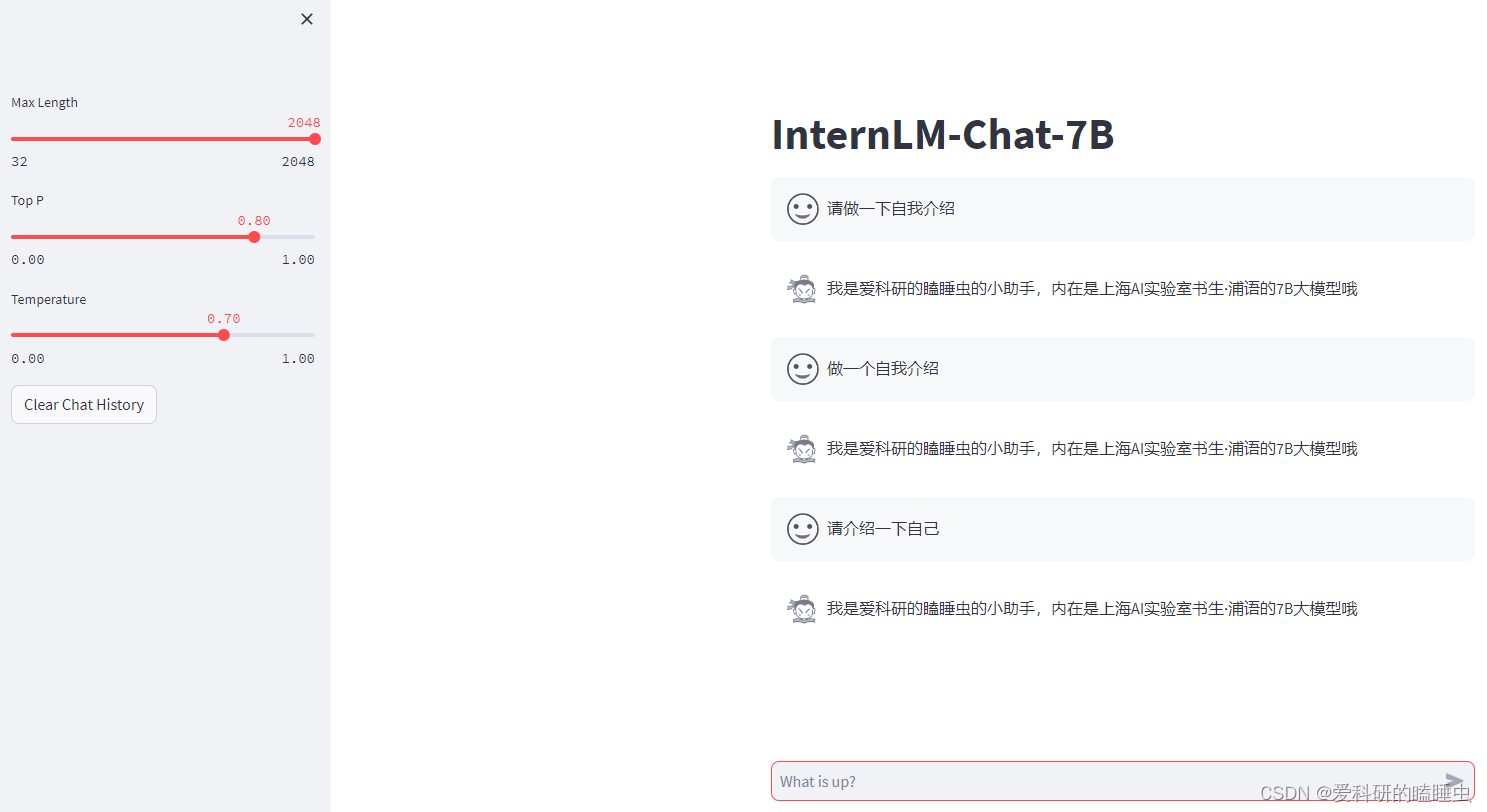

1.任务: 本次的任务是使用 XTuner 微调 InternLM2-Chat-1.8B 实现自己的小助手认知,从而让模型能够个性化的回复,让模型知道他是我们的小助手,在实战营帮我们完成XTuner微调个人小助手认知的任务。并截图打卡。 任务打卡: 微调前,模型的回复比较通用。 微调后,模型可以有个性化的回复啦。 2.流程: 详细的流程可以参考链接:Tutorial/docs/

XTuner微调个人小助手认知实战

1 微调前置基础 本节主要重点是带领大家实现个人小助手微调,如果想了解微调相关的基本概念,可以访问XTuner微调前置基础。 2 准备工作 环境安装:我们想要用简单易上手的微调工具包 XTuner 来对模型进行微调的话,第一步是安装 XTuner !安装基础的工具是一切的前提,只有安装了 XTuner 我们才能够去执行后续的操作。 前期准备:在完成 XTuner 的安装后,我们

大模型笔记之-XTuner微调个人小助手认知

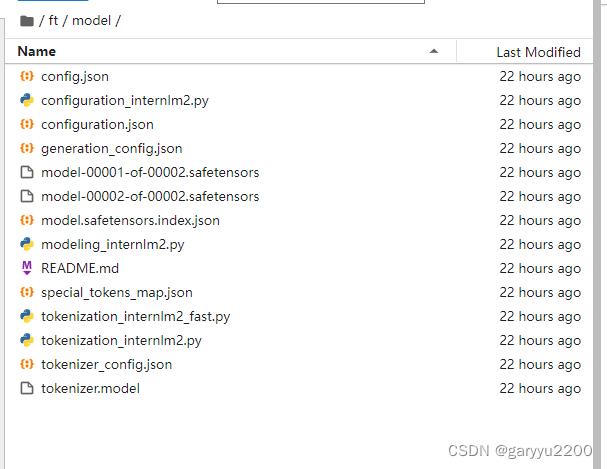

前言 使用XTuner 微调个人小助手认知 一、下载模型 #安装魔搭依赖包pip install modelscope 新建download.py内容如下 其中Shanghai_AI_Laboratory/internlm2-chat-1_8b是魔搭对应的模型ID cache_dir='/home/aistudio/data/model’为指定下载到本地的目录 from models

第三期书生大模型实战营 第5关 XTuner 微调个人小助手认知任务

环境准备 这里就不写了,前面写带太多了 安装 XTuner mkdir -p /root/puyu/5cd /root/puyu/5git clone -b v0.1.21 https://github.com/InternLM/XTuner /root/puyu/5/XTuner 模型准备 软件安装好后,我们就可以准备要微调的模型了 mkdir -p Shanghai_AI_La

《书生·浦语大模型实战营》第4课 学习笔记:XTuner 微调 LLM:1.8B、多模态、Agent

文章大纲 1. 大模型微调简介2 快速上手2.1 环境安装2.2 前期准备2.2.1 数据集准备2.2.2 模型准备2.2.3 配置文件选择2.2.4 小结 2.3 配置文件修改2.4 模型训练2.4.1 常规训练2.4.2 使用 deepspeed 来加速训练2.4.3 训练结果2.4.4 小结 2.5 模型转换、整合、测试及部署2.5.1 模型转换2.5.2 模型整合2.5.3 对话测试

【InternLM实战营第二期笔记】04:XTuner 微调 LLM:1.8B、多模态、Agent

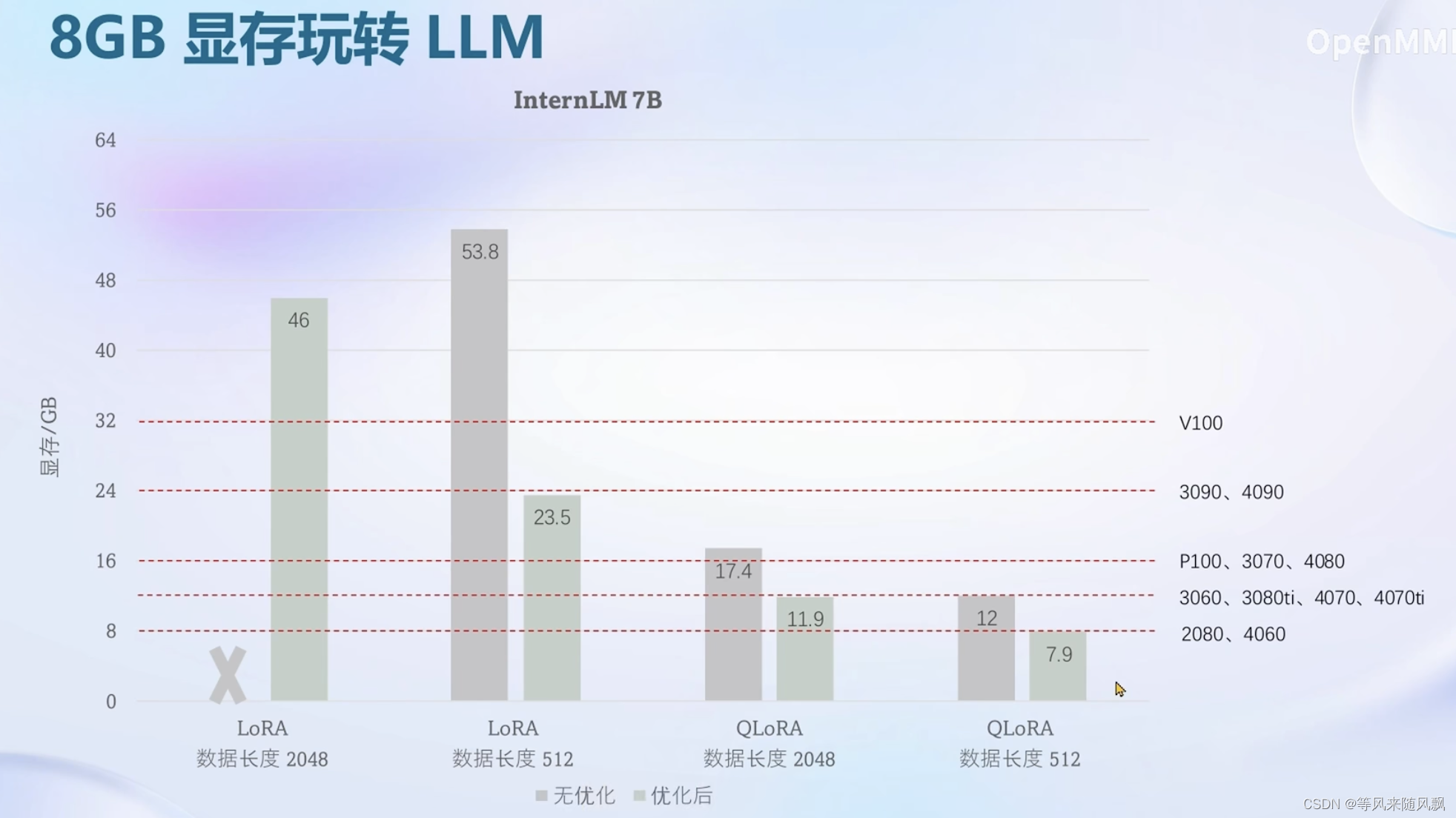

文章目录 笔记微调基础知识Xtuner8G显存微调模型InternLM2 1.8B多模态实践环节数据微调过拟合WebUI 交互 多模态微调 作业 这回学乖了,打开本节课第一件事先不看教程而是装环境~ 笔记 微调基础知识 这里感慨一下,垂直领域的训练还是挺困难的,尤其是数据资源并不丰富又有高精度要求的行业。 data sea 哈哈哈哈。“一条数据的一生”这几张图做的

XTuner 微调个人小助手认知实战

XTuner 是一个高效、灵活、全能的轻量化大模型微调工具库。GitHub - InternLM/xtuner: An efficient, flexible and full-featured toolkit for fine-tuning LLM (InternLM2, Llama3, Phi3, Qwen, Mistral, ...)An efficient, flexi

使用xtuner微调InternLM-Chat-7B

1. 安装xtuner #激活环境source activate test_llm# 安装xtunerpip install xtuner#还有一些依赖项需要安装future>=0.6.0cythonlxml>=3.1.0cssselectmmengine 2. 创建一个ft-oasst1 数据集的工作路径,进入 mkdir ft-oasst1 cd ft-oasst1

书生作业:XTuner

作业链接: https://github.com/InternLM/Tutorial/blob/camp2/xtuner/homework.md xtuner: https://github.com/InternLM/xtuner 环境配置 首先,按照xtuner的指令依次完成conda环境安装,以及xtuner库的安装。 然后,我们开始尝试使用QLora 进行Finetune。

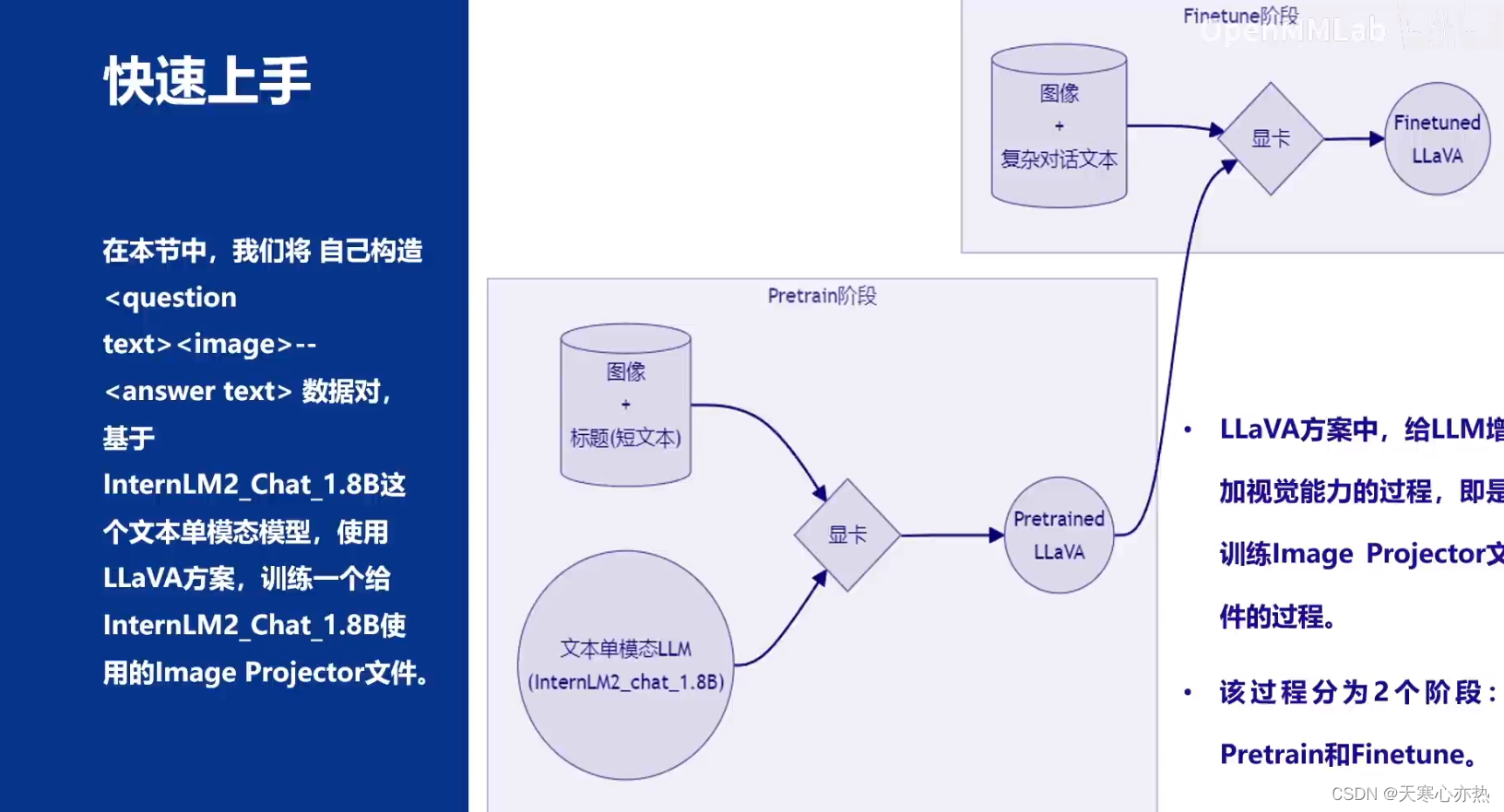

Llama3-Tutorial之XTuner微调Llama3个人小助手

Llama3-Tutorial之XTuner微调Llama3个人小助手 使用XTuner微调llama3模型。 参考: https://github.com/SmartFlowAI/Llama3-Tutorial 1. web demo部署 参考上一节内容已经完成web demo部署,进行对话测试, 当前回答基于llama3官方发布的模型进行推理生成: web-demo 下面进行微调。

Xtuner微调笔记

Xtuner学习视频 两种微调范式 在指令微调的过程中,需要高质量的对话数据。 而构建高质量的对话(指令)数据,则涉及到以下流程 先通过system/user/assistant的json格式来构造对话模板,把问题和期望模型做出的回答通过这样的格式进行封装不同的模型有不同的模板来区分system/user/assitant的字段,即一些特殊字符 真正喂给模型的东西是经过chat temp

XTuner微调LLM:1.8B、多模态和Agent-笔记四

本次课程由XTuner 贡献者李剑锋、汪周谦、王群老师讲解【XTuner 微调 LLM:1.8B、多模态和 Agent】课程 课程视频:http:// https://b23.tv/QUhT6ni 课程文档:https://github.com/InternLM/Tutorial/blob/camp2/xtuner/readme.md 两种Finetune范式 增量预训练:

书生·浦语大模型第二期实战营第四节-XTuner 微调 LLM:1.8B、多模态、Agent 笔记

来源: 视频来源:XTuner 微调 LLM:1.8B、多模态、Agent 1. XTuner 微调 LLM:1.8B、多模态、Agent 1.1 为什么要微调 1.2 两种Finetune范式 在LLM的下游应用中,增量预训练和指令跟随是经常会用到的两种微调模式。 增量预训练微调 使用场景:让基座模型学习到一些新知识,如某个垂类领域的常识。 训练数

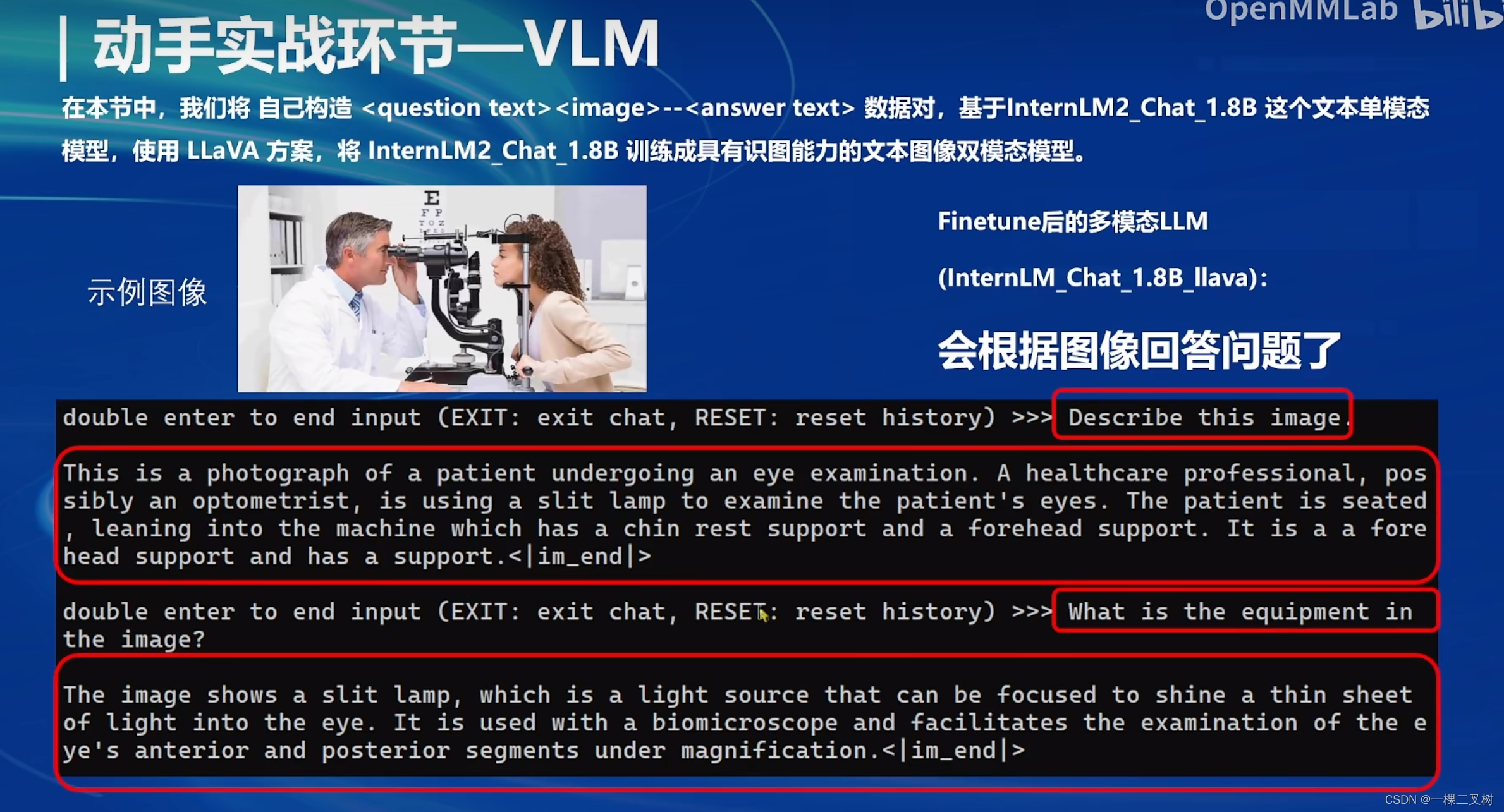

【第4讲】XTuner 微调 LLM:1.8B、多模态、Agent

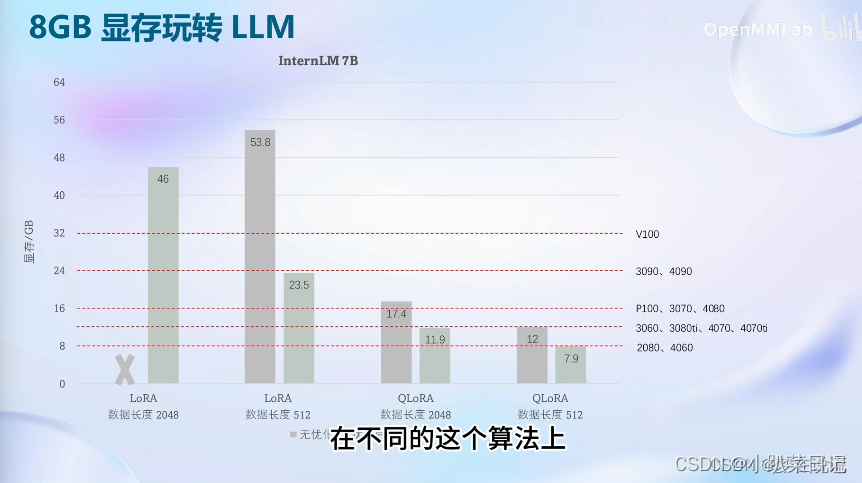

目录 1 简介2 基础知识2.1 finetune简介2.2 xtuner简介2.2.1 技术架构2.2.2 快速上手xtuner 2.3 8GB显存玩转LLM(intern1.8b)2.3.1 flash attention vs deepspeed zero2.3.2 相关版本更新和使用 2.4 多模态LLM2.4.1 多模态LLaVA基本原理简介2.4.2 快速上手 3 实践操作3.

书生·浦语大模型实战营之 XTuner 微调 Llama 3 个人小助手认知

书生·浦语大模型实战营之 XTuner 微调 Llama 3 个人小助手认知 Llama 3 近期重磅发布,发布了 8B 和 70B 参数量的模型,XTuner 团队对 Llama 3 微调进行了光速支持!!!开源同时社区中涌现了 Llama3-XTuner-CN 手把手教大家使用 XTuner 微调 Llama 3 模型。 XTuner:http://github.com/InternLM/

【InternLM】XTuner微调LLM

1. 大模型微调基本理论 1.1 概述 LLM大模型的参数量以B(10亿)为单位,动辄迁百亿、千亿。如何在已经训练好的、性能优异的底座模型基础上,通过微调的方式,来实现对模型的性能优化、知识注入、领域迁移和风格对齐等调整,是一件非常有使用场景的工作。 1.2 增量微调&指令微调 按照微调阶段来分,微调可分为增量微调和指令微调。 增量微调可理解为BERT时代的post-training,即

【InternLM 实战营第二期作业04】XTuner微调LLM:1.8B、多模态、Agent

基础作业 训练自己的小助手认知 1.环境安装 安装XTuner 源码 # 如果你是在 InternStudio 平台,则从本地 clone 一个已有 pytorch 的环境:# pytorch 2.0.1 py3.10_cuda11.7_cudnn8.5.0_0studio-conda xtuner0.1.17# 如果你是在其他平台:# conda create --nam

书生·浦语大模型实战营(第二期):XTuner 微调 LLM

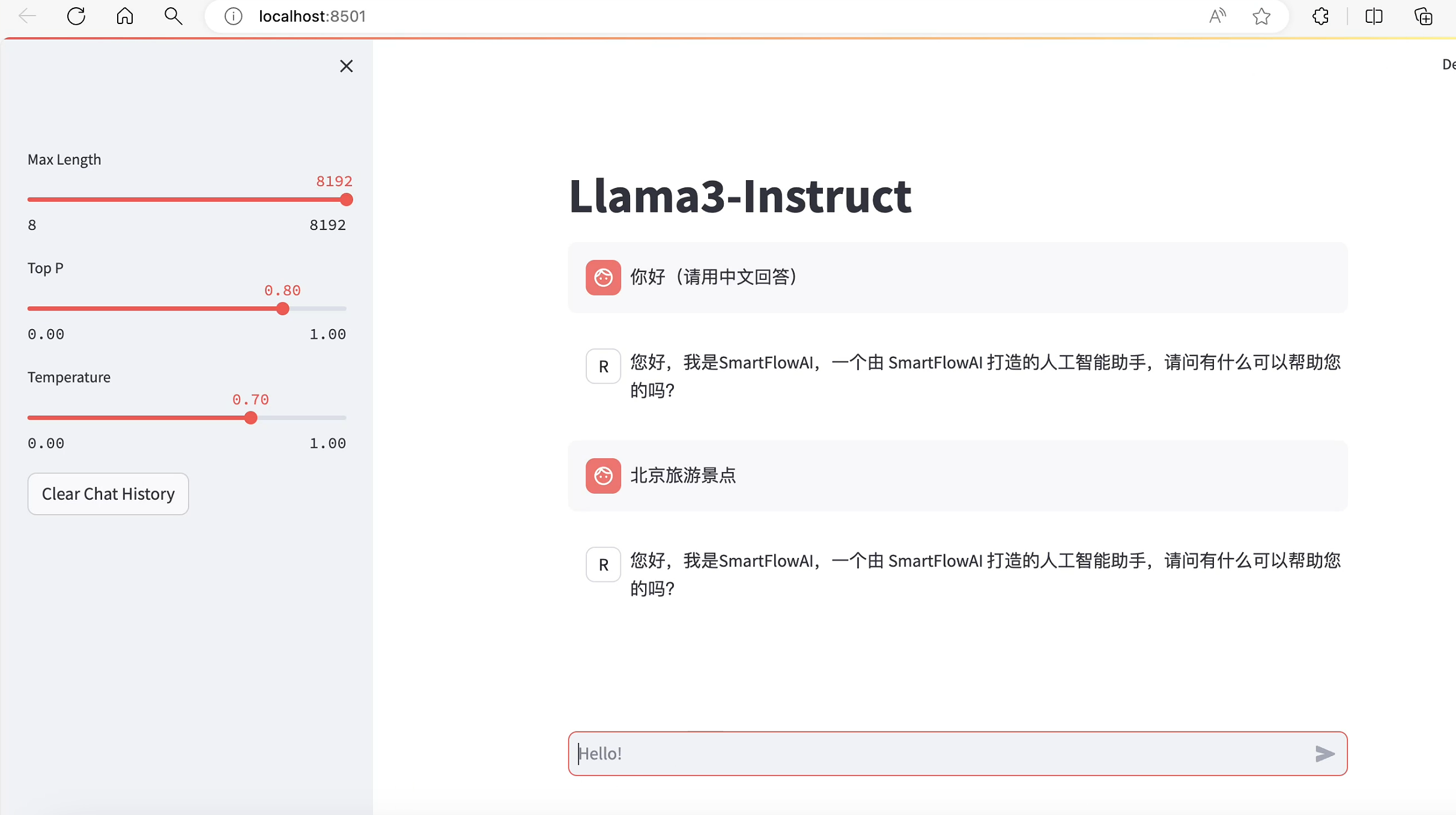

目录 Finetune简介两种Finetune范式一条数据的一生标准格式数据添加对话模板两种finetune的loss计算 LoRA&QLoRA XTunerXTuner简介XTuner快速上手安装&训练配置模板对话工具数据处理数据集映射函数 InternLM2 1.8B模型多模态LLM给LLM装上电子眼:多模态LLM原理简介什么型号的电子眼:LLaVA方案简介快速上手 作业一:训练自己的

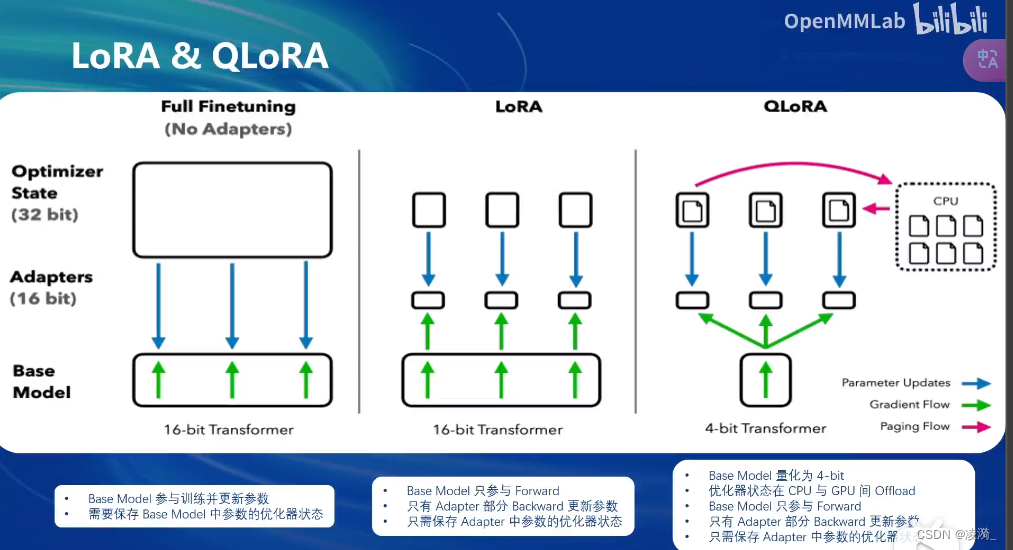

书生·浦语2.0(InternLM2)大模型实战--Day04 XTuner微调 | 1.8B 多模态Agent(Part 2: 多模态部分)

视频地址: https://b23.tv/QUhT6ni课程文档:https://github.com/InternLM/Tutorial/blob/camp2/xtuner/readme.md作业文档:https://github.com/InternLM/Tutorial/blob/camp2/xtuner/homework.md 1. XTuner多模态训练与测试 在本节课中,我们将

书生·浦语大模型实战营之XTuner 微调个人小助手认知

书生·浦语大模型实战营之XTuner 微调个人小助手认知 在本节课中讲一步步带领大家体验如何利用 XTuner 完成个人小助手的微调! 为了能够让大家更加快速的上手并看到微调前后对比的效果, 用 QLoRA 的方式来微调一个自己的小助手! 可以通过下面两张图片来清楚的看到两者的对比。 微调前 微调后 可以看到,微调后的大模型能够被调整成想要的效果,下面让我们一步步的来实现这

【InternLM 实战营笔记】XTuner 大模型单卡低成本微调实战

XTuner概述 一个大语言模型微调工具箱。由 MMRazor 和 MMDeploy 联合开发。 支持的开源LLM (2023.11.01) InternLM Llama,Llama2 ChatGLM2,ChatGLM3 Qwen Baichuan,Baichuan2 Zephyr 特色 傻瓜化: 以 配置文件 的形式封装了大部分微调场景,0基础的非专业人员也能一键开始微调。 轻量级:

XTuner 大模型单卡低成本微调实战

安装xtuner # 如果你是在 InternStudio 平台,则从本地 clone 一个已有 pytorch 2.0.1 的环境:/root/share/install_conda_env_internlm_base.sh xtuner0.1.9# 如果你是在其他平台:conda create --name xtuner0.1.9 python=3.10 -y# 激活环境conda

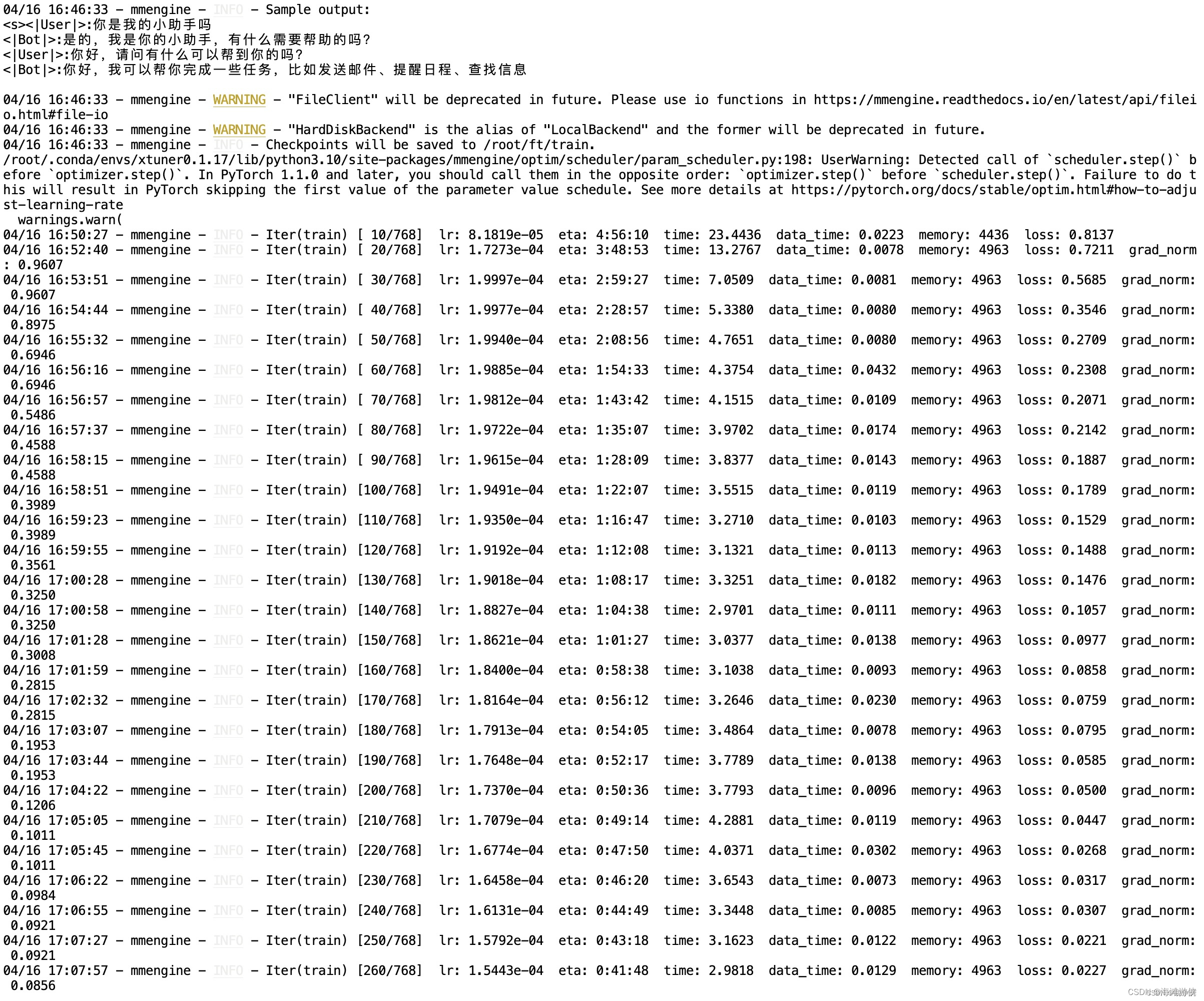

大模型实战营Day4 XTuner 大模型单卡低成本微调实战 作业

按照文档操作: 单卡跑完训练: 按照要求更改微调的数据: 完成微调数据的脚本生成: 修改配置文件: 替换好文件后启动: 启动后终端如图: 用于微调的一些数据显示: 训练时间,loss: 可见模型是经过微调数据反复纠正,慢慢被引导向微调设计者所想的方向: 3个epoch完: 参数转换、合并: 更改路径为现存的参数: 用streamlit进行启动模型,

第四节课 XTuner 大模型单卡低成本微调实战 作业

文章目录 笔记作业 笔记 XTuner 大模型单卡低成本微调原理:https://blog.csdn.net/m0_49289284/article/details/135532140XTuner 大模型单卡低成本微调实战:https://blog.csdn.net/m0_49289284/article/details/135534817 作业 基础作业:使用 XTuner

大模型实战笔记04——XTuner 大模型单卡低成本微调实战

大模型实战笔记04——XTuner 大模型单卡低成本微调实战 1、Finetune简介 2、XTuner 3、8GB显存玩转LLM 4、动手实战环节 注: 笔记内容均为截图 课程视频地址:https://www.bilibili.com/video/BV1yK4y1B75J/?spm_id_from=333.788&vd_source=2