本文主要是介绍三菱上升沿和下降沿,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

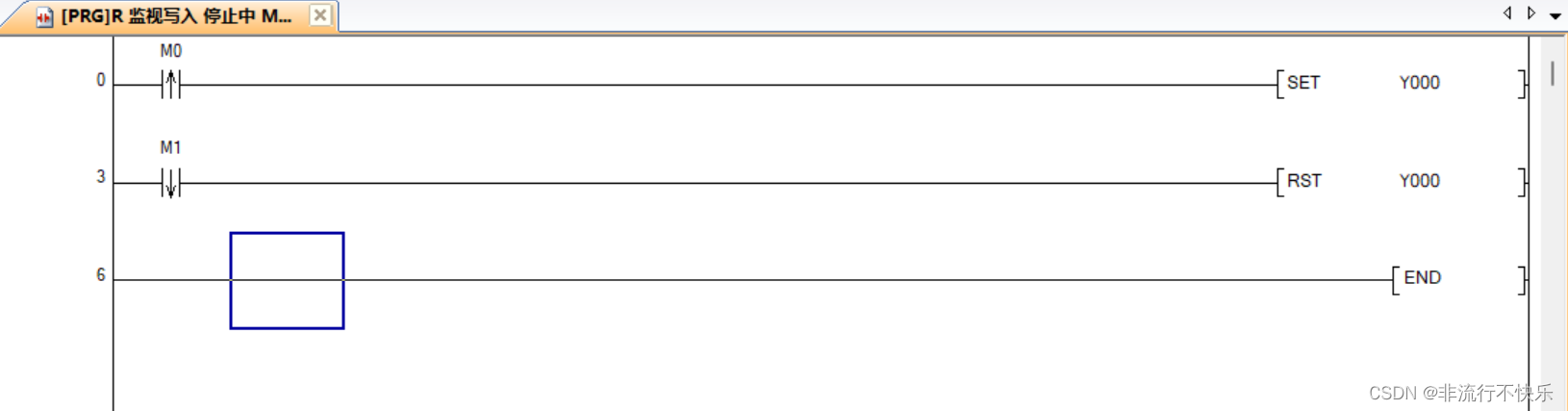

1,上升沿

含义 上升沿是在接通的第一个周期执行。

2,下将沿

断开的第一个周期执行

M0 按下后Y0 亮 M1 松开后Y0灭

这篇关于三菱上升沿和下降沿的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!

本文主要是介绍三菱上升沿和下降沿,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

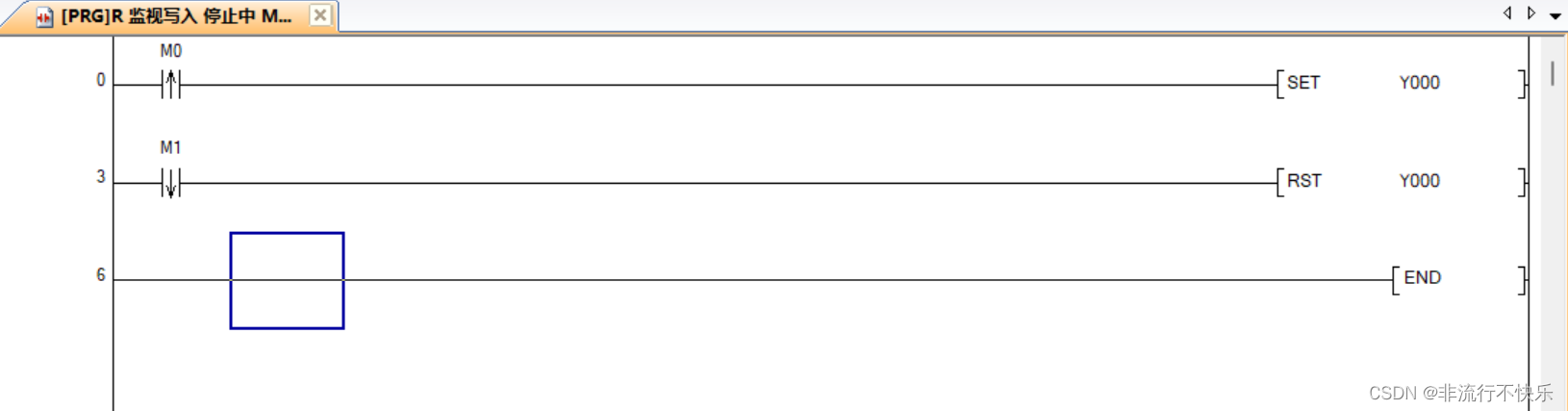

1,上升沿

含义 上升沿是在接通的第一个周期执行。

2,下将沿

断开的第一个周期执行

M0 按下后Y0 亮 M1 松开后Y0灭

这篇关于三菱上升沿和下降沿的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!

http://www.chinasem.cn/article/880240。

23002807@qq.com