本文主要是介绍分类预测 | Matlab实现ZOA-CNN-LSTM-Attention斑马优化卷积长短期记忆神经网络注意力机制的数据分类预测【24年新算法】,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

分类预测 | Matlab实现ZOA-CNN-LSTM-Attention斑马优化卷积长短期记忆神经网络注意力机制的数据分类预测【24年新算法】

目录

- 分类预测 | Matlab实现ZOA-CNN-LSTM-Attention斑马优化卷积长短期记忆神经网络注意力机制的数据分类预测【24年新算法】

- 分类效果

- 基本描述

- 程序设计

- 参考资料

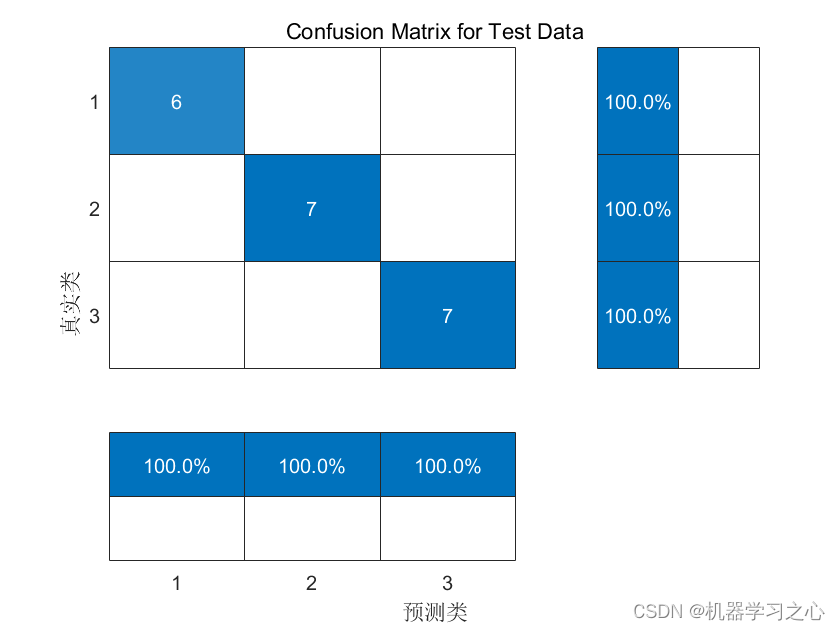

分类效果

基本描述

1.Matlab实现ZOA-CNN-LSTM-Attention斑马优化卷积长短期记忆神经网络注意力机制的数据分类预测【24年新算法】(完整源码和数据)

2.自带数据,多输入,单输出,多分类。图很多,包括迭代曲线图、混淆矩阵图、预测效果图等等。

3.直接替换数据即可使用,保证程序可正常运行。运行环境MATLAB2023及以上。

4.代码特点:参数化编程、参数可方便更改、代码编程思路清晰、注释明细。

程序设计

- 完整程序和数据私信博主回复** Matlab实现ZOA-CNN-LSTM-Attention斑马优化卷积长短期记忆神经网络注意力机制的数据分类预测【24年新算法】**。

%% 参数设置%% 建立模型

lgraph = addLayers(lgraph, tempLayers); % 将上述网络结构加入空白结构中tempLayers = [sequenceUnfoldingLayer("Name", "sequnfold") % 建立序列反折叠层flattenLayer("Name", "flatten") % 网络铺平层lstmLayer(best_hd, "Name", "lstm", "OutputMode","last") fullyConnectedLayer(num_class, "Name", "fc") % 全连接层softmaxLayer("Name", "softmax") % softmax激活层classificationLayer("Name", "classification")]; % 分类层

lgraph = addLayers(lgraph, tempLayers); % 将上述网络结构加入空白结构中

lgraph = connectLayers(lgraph, "seqfold/out", "conv_1"); % 折叠层输出 连接 卷积层输入

lgraph = connectLayers(lgraph, "seqfold/miniBatchSize", "sequnfold/miniBatchSize"); % 折叠层输出连接反折叠层输入

lgraph = connectLayers(lgraph, "relu_2", "sequnfold/in"); % 激活层输出 连接 反折叠层输入%% 参数设置

options = trainingOptions('adam', ... % Adam 梯度下降算法'MaxEpochs', 500,... % 最大训练次数 'InitialLearnRate', best_lr,... % 初始学习率为0.001'L2Regularization', best_l2,... % L2正则化参数'LearnRateSchedule', 'piecewise',... % 学习率下降'LearnRateDropFactor', 0.1,... % 学习率下降因子 0.1'LearnRateDropPeriod', 400,... % 经过训练后 学习率为 0.001*0.1'Shuffle', 'every-epoch',... % 每次训练打乱数据集'ValidationPatience', Inf,... % 关闭验证'Plots', 'training-progress',... % 画出曲线'Verbose', false);%% 训练

net = trainNetwork(p_train, t_train, lgraph, options);参考资料

[1] https://blog.csdn.net/kjm13182345320/article/details/129036772?spm=1001.2014.3001.5502

[2] https://blog.csdn.net/kjm13182345320/article/details/128690229

这篇关于分类预测 | Matlab实现ZOA-CNN-LSTM-Attention斑马优化卷积长短期记忆神经网络注意力机制的数据分类预测【24年新算法】的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!