lstm专题

自然语言处理系列六十三》神经网络算法》LSTM长短期记忆神经网络算法

注:此文章内容均节选自充电了么创始人,CEO兼CTO陈敬雷老师的新书《自然语言处理原理与实战》(人工智能科学与技术丛书)【陈敬雷编著】【清华大学出版社】 文章目录 自然语言处理系列六十三神经网络算法》LSTM长短期记忆神经网络算法Seq2Seq端到端神经网络算法 总结 自然语言处理系列六十三 神经网络算法》LSTM长短期记忆神经网络算法 长短期记忆网络(LSTM,Long S

Tensorflow lstm实现的小说撰写预测

最近,在研究深度学习方面的知识,结合Tensorflow,完成了基于lstm的小说预测程序demo。 lstm是改进的RNN,具有长期记忆功能,相对于RNN,增加了多个门来控制输入与输出。原理方面的知识网上很多,在此,我只是将我短暂学习的tensorflow写一个预测小说的demo,如果有错误,还望大家指出。 1、将小说进行分词,去除空格,建立词汇表与id的字典,生成初始输入模型的x与y d

CNN-LSTM模型中应用贝叶斯推断进行时间序列预测

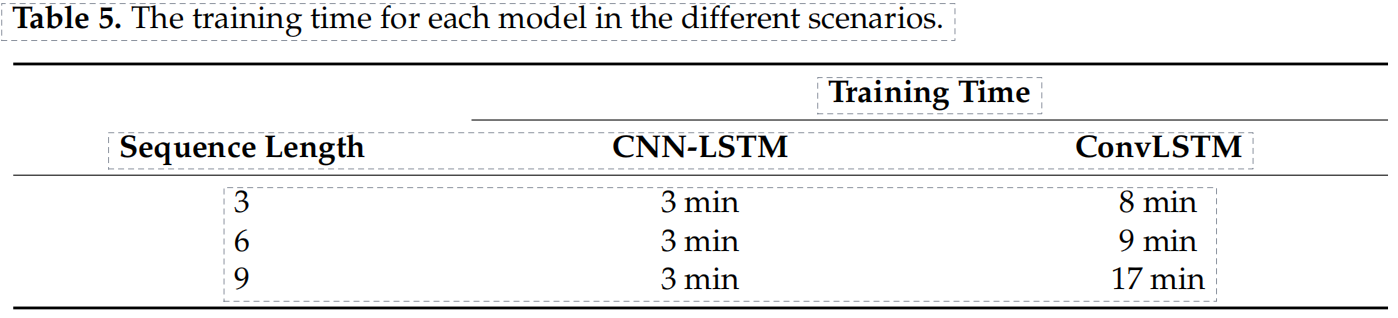

这篇论文的标题是《在混合CNN-LSTM模型中应用贝叶斯推断进行时间序列预测》,作者是Thi-Lich Nghiem, Viet-Duc Le, Thi-Lan Le, Pierre Maréchal, Daniel Delahaye, Andrija Vidosavljevic。论文发表在2022年10月于越南富国岛举行的国际多媒体分析与模式识别会议(MAPR)上。 摘要部分提到,卷积

回归预测 | MATLAB实现PSO-LSTM(粒子群优化长短期记忆神经网络)多输入单输出

回归预测 | MATLAB实现PSO-LSTM(粒子群优化长短期记忆神经网络)多输入单输出 目录 回归预测 | MATLAB实现PSO-LSTM(粒子群优化长短期记忆神经网络)多输入单输出预测效果基本介绍模型介绍PSO模型LSTM模型PSO-LSTM模型 程序设计参考资料致谢 预测效果 Matlab实现PSO-LSTM多变量回归预测 1.input和outpu

RNN发展(RNN/LSTM/GRU/GNMT/transformer/RWKV)

RNN到GRU参考: https://blog.csdn.net/weixin_36378508/article/details/115101779 tRANSFORMERS参考: seq2seq到attention到transformer理解 GNMT 2016年9月 谷歌,基于神经网络的翻译系统(GNMT),并宣称GNMT在多个主要语言对的翻译中将翻译误差降低了55%-85%以上, G

REMEMBERING HISTORY WITH CONVOLUTIONAL LSTM FOR ANOMALY DETECTION——利用卷积LSTM记忆历史进行异常检测

上海科技大学的文章,上海科技大学有个组一直在做这方面的工作,好文章挺多的还有数据集。 ABSTRACT 本文解决了视频中的异常检测问题,由于异常是无界的,所以异常检测是一项极具挑战性的任务。我们通过利用卷积神经网络(CNN或ConvNet)对每一帧进行外观编码,并利用卷积长期记忆(ConvLSTM)来记忆与运动信息相对应的所有过去的帧来完成这项任务。然后将ConvNet和ConvLSTM与

【深度学习】LSTM模型,GRU模型计算公式及其优缺点介绍

一.LSTM介绍 LSTM(Long Short-Term Memory)也称长短时记忆结构, 它是传统RNN的变体, 与经典RNN相比能够有效捕捉长序列之间的语义关联, 缓解梯度消失或爆炸现象. 同时LSTM的结构更复杂, 它的核心结构可以分为四个部分去解析: 遗忘门输入门细胞状态输出门 1LSTM的内部结构图 1.1 LSTM结构分析 结构解释图: 遗忘门部分结构图与计算

CNN-LSTM用于时间序列预测,发二区5分+没问题!

为了进一步提高时序预测的性能,研究者们组合了CNN和LSTM的特点,提出了CNN-LSTM混合架构。 这种架构因为独特的结构设计,能同时处理时空数据、提取丰富的特征、并有效解决过拟合问题,实现对时间序列数据的高效、准确预测,远超传统方法。 因此,它已经成为我们应对时序预测任务离不开的模型,有关CNN-LSTM的研究也成了当下热门主题之一,高质量论文频发。 为了方便大家了解CNN-LSTM的最

【ShuQiHere】从 LSTM 到 GRU:简化结构中的高效之道

【ShuQiHere】 引言 在自然语言处理中,情感分析是一项关键任务,它通过分析文本的情感倾向(如积极、消极或中立)帮助我们理解文本背后的情感💬。这种任务需要捕捉文本中前后单词之间的依赖关系,因此循环神经网络(RNN)和长短期记忆网络(LSTM)通常被用来处理🔄。然而,尽管 LSTM 在应对长期依赖问题上表现出色,其复杂的门结构也带来了计算资源的高消耗和训练时间的延长⌛。为了克服这些挑战

机器学习项目——基于机器学习(RNN LSTM 高斯拟合 MLP)的锂离子电池剩余寿命预测方法研究(代码/论文)

完整的论文代码见文章末尾 以下为核心内容和部分结果 摘要 机器学习方法在电池寿命预测中的应用主要包括监督学习、无监督学习和强化学习等。监督学习方法通过构建回归模型或分类模型,直接预测电池的剩余寿命或健康状态。无监督学习方法则通过聚类分析和降维技术,识别电池数据中的潜在模式和特征。强化学习方法通过构建动态决策模型,在电池运行过程中不断优化预测策略和调整参数。上述方法不仅可以提高预测精度,还可以在

3. 循环神经网络(RNN)与长短期记忆网络(LSTM)

引言 循环神经网络(RNN)和长短期记忆网络(LSTM)是处理序列数据的关键模型,广泛应用于自然语言处理、时间序列预测、语音识别等领域。RNN通过循环结构捕捉序列中的时间依赖关系,而LSTM则通过特殊的记忆单元解决了RNN中的梯度消失问题。本篇博文将深入探讨RNN和LSTM的结构、工作原理,以及其在序列数据处理中的应用。 1. RNN的工作原理及局限性 循环神经网络(RNN)是一类用于处理序

深度学习-神经网络:AWD-LSTM

语言模型可以说是NLP中最基本的任务,无论是词向量,预训练模型,文本生成等任务中都带有语言模型的影子。 语言模型本质上是对一个自然世界中存在的句子建模,描述一个句子发生的概率,因此语言模型也是一个自回归的任务。 语言模型是一个上下文强依赖的任务,不仅需要捕获长距离的信息,还需要学到词之间的位置关系,从目前的技术来看,RNN系的模型在语言模型任务上的表现要优于transformer,主要原因还是

NLP-预训练模型-2017:ULMFiT(Universal LM Fine-tuning for Text Classification)【使用AWD-LSTM;模型没有创新;使用多个训练小技巧】

迁移学习在计算机视觉有很大的影响,但现在的NLP中的方法仍然需要特定任务的修改和 从头开始的训练。我们提出通用语言模型微调,一种可以应用NLP任何任务中的迁移学习方法。我们模型在分类任务中都表现得良好,并且在小数据集上的表现优异。 一、ULMFiT (Universal Language Model Fine- tuning)组成步骤: a) General-domain LM pretr

NLP-文本匹配-2016:ESIM【Enhanced LSTM for Natural Language Inference】

NLP-文本匹配-2016:ESIM【Enhanced LSTM for Natural Language Inference】

如何优化LSTM模型的性能:具体实践指南

在构建时间序列预测模型时,LSTM(Long Short-Term Memory)是一种常用的神经网络架构。然而,有时候我们会发现,模型的精度已经无法通过进一步训练得到显著提升。这种情况下,我们需要考虑各种优化策略来改进模型的性能。本文将详细介绍几种常用的优化方法,并附上具体的实现代码,帮助你提高LSTM模型的预测能力。 1. 调整模型架构 1.1 增加/减少隐藏层或神经元数量 在深度学习中

Keras 添加model.add(LSTM(......))等待时间过长,以及占用CPU空间的问题

原因: tensorflow版本过低,一般tensorflow在1.3.0以下(包括1.3.0)会出现这种问题 解决方法: 升级tensorflow pip install tensorflow --upgrade 再次运行会提示 ImportError: /lib64/libstdc++.so.6: version `CXXABI_1.3.9’ not found 参考博客: https:

【ShuQiHere】从 RNN 到 LSTM:时间依赖建模的关键演化

【ShuQiHere】 在金融市场中,准确预测未来的股票价格一直是一个极具挑战性的问题。循环神经网络(RNN)为我们提供了一种通过历史数据预测未来的方法。然而,尽管 RNN 在处理短时间序列时表现出色,但当涉及长时间序列时,它会遇到梯度消失和长期依赖等问题。为了解决这些问题,长短期记忆网络(LSTM)应运而生。本文将以股票价格预测为例,系统地探讨从 RNN 到 LSTM 的演化过程,深入解析两者

LSTM-Autoencoder深度学习模型在电动机异常检测中的应用

LSTM-Autoencoder深度学习模型在电动机异常检测中的应用 LSTM-Autoencoder Deep Learning Model for Anomaly Detection in Electric Motor Citation: Lachekhab, F.; Benzaoui, M.; Tadjer, S.A.; Bensmaine, A.; Hamma, H. LSTM-Aut

tensorflow LSTM+CTC实现端到端的不定长数字串识别

转载地址: https://www.jianshu.com/p/45828b18f133 上一篇文章tensorflow 实现端到端的OCR:二代身份证号识别实现了定长18位数字串的识别,并最终达到了98%的准确率。但是实际应用场景中,常常需要面对无法确定字串长度的情况,这时候除了需要对识别字符模型参数进行训练外,还需要对字符划分模型进行训练,本文实现了上文提到的方法2,使用LST

lstm+ctc 实现ocr识别

转载地址: https://zhuanlan.zhihu.com/p/21344595 OCR是一个古老的研究领域,简单说就是把图片上的文字转化为文本的过程。在最近几年随着大数据的发展,广大爬虫工程师在对抗验证码时也得用上OCR。所以,这篇文章主要说的OCR其实就是图片验证码的识别。OCR并不是我的研究方向,我研究这个问题是因为OCR是一个可以同时用CNN,RNN两种算法都可以很好解决的

分类预测|基于黑翅鸢优化BKA-Transformer-LSTM组合模型的数据预测Matlab程序多特征输入多类别输出

分类预测|基于黑翅鸢优化BKA-Transformer-LSTM组合模型的数据预测Matlab程序多特征输入多类别输出 文章目录 一、基本原理BKA-Transformer-LSTM 数据分类预测详细原理和流程详细原理和流程1. 数据预处理2. 模型构建3. 模型训练4. BKA 优化5. 模型测试与验证 结果应用 二、实验结果三、核心代码四、代码获取五、总结 分类预测|基

pytorch之BI-LSTM CRF(六)

1、计算CRF的条件概率 CRF计算条件概率 y 是标签序列, x输入的单词序列 2、分数计算由对数函数确定 3、Bi-LSTM CRF中分数的确定 在Bi-LSTM CRF中,定义了两种状态: emission 和 transition状态;i位置的emission状态来自Bi-LSTM在时间步的隐藏状态 i。转换分数存储在|T|x|T|矩阵 P,T是标签集;Pj,k是标签k过渡

pytorch之LSTM(四)

1、序列模型和长期记忆网络 至此,我们已经看到了各种前馈网络。即,网络根本不维持任何状态。这可能不是我们想要的行为。序列模型是NLP的核心:它们是在输入之间存在一定时间依存关系的模型。序列模型的经典示例是用于词性标记的隐马尔可夫模型。另一个示例是条件随机场。 递归神经网络是维持某种状态的网络。例如,它的输出可以用作下一个输入的一部分,以便信息可以随着网络在序列上传递而传播。对于LSTM,对于序

Pytorch实现多层LSTM模型,并增加emdedding、Dropout、权重共享等优化

简述 本文是 Pytorch封装简单RNN模型,进行中文训练及文本预测 一文的延申,主要做以下改动: 1.将nn.RNN替换为nn.LSTM,并设置多层LSTM: 既然使用pytorch了,自然不需要手动实现多层,注意nn.RNN和nn.LSTM 在实例化时均有参数num_layers来指定层数,本文设置num_layers=2; 2.新增emdedding层,替换掉原来的nn.funct

分类预测|基于Transformer-LSTM的数据分类预测Matlab程序 多特征输入多类别输出

分类预测|基于Transformer-LSTM的数据分类预测Matlab程序 多特征输入多类别输出 文章目录 一、Transformer-LSTM基本原理1. 模型原理TransformerLSTM 2. 流程步骤1. 数据预处理2. Transformer编码器3. LSTM层4. 分类层5. 模型训练与评估 3. 优势与应用 二、实验结果三、核心代码四、代码获取五、总结