本文主要是介绍关于PRelu:Delving Deep into Rectifiers: Surpassing Human-Level Performance on ImageNet Classification,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

前言

内容是经典激活函数PRelu的提出

内容

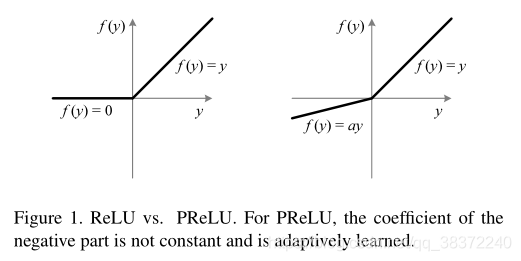

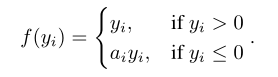

上图左为Relu,右图为PRelu,P相比传统Relu,在坐标系左边有数值。用公式解释:

当ai=0时,成为Relu;当ai是一个小且固定的数值,则变成Leaky Relu(ai=0.01),LRelu的motivation是为了防止零梯度,即坐标轴左侧有数值。但是在一些研究上,显示LRelu对于精度的影响微乎其微。

Prelu相比Relu只增加了一丁点参数,模型大小上几乎没有任何影响。

实验

这里是几个模型:

这篇关于关于PRelu:Delving Deep into Rectifiers: Surpassing Human-Level Performance on ImageNet Classification的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!