rectifiers专题

[深度学习论文笔记][Weight Initialization] Delving deep into rectifiers: Surpassing human-level performance

He, Kaiming, et al. “Delving deep into rectifiers: Surpassing human-level performance on imagenet classification.” Proceedings of the IEEE International Conference on Computer Vision. 2015. [Citations

《Delving Deep into Rectifiers: Surpassing Human-Level Performance on ImageNet Classification》论文阅读笔记

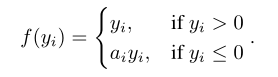

论文原文:http://arxiv.org/abs/1502.01852 论文主要讨论了以ReLU为激活函数的网络的缺陷并提出了改进的激活函数PReLU与新的Kaiming初始化方法 1. PReLU 前向传播 通道独立: f ( y i ) = max ( 0 , y i ) + a i min ( 0 , y i ) f\left(y_{i}\right)=\max \le

关于PRelu:Delving Deep into Rectifiers: Surpassing Human-Level Performance on ImageNet Classification

前言 内容是经典激活函数PRelu的提出 内容 上图左为Relu,右图为PRelu,P相比传统Relu,在坐标系左边有数值。用公式解释: 当ai=0时,成为Relu;当ai是一个小且固定的数值,则变成Leaky Relu(ai=0.01),LRelu的motivation是为了防止零梯度,即坐标轴左侧有数值。但是在一些研究上,显示LRelu对于精度的影响微乎其微。 Prelu相比Rel

![[深度学习论文笔记][Weight Initialization] Delving deep into rectifiers: Surpassing human-level performance](https://img-blog.csdn.net/20160920172827657?watermark/2/text/aHR0cDovL2Jsb2cuY3Nkbi5uZXQv/font/5a6L5L2T/fontsize/400/fill/I0JBQkFCMA==/dissolve/70/gravity/Center)