classification专题

Convolutional Neural Networks for Sentence Classification论文解读

基本信息 作者Yoon Kimdoi发表时间2014期刊EMNLP网址https://doi.org/10.48550/arXiv.1408.5882 研究背景 1. What’s known 既往研究已证实 CV领域著名的CNN。 2. What’s new 创新点 将CNN应用于NLP,打破了传统NLP任务主要依赖循环神经网络(RNN)及其变体的局面。 用预训练的词向量(如word2v

NLP-预训练模型-2017:ULMFiT(Universal LM Fine-tuning for Text Classification)【使用AWD-LSTM;模型没有创新;使用多个训练小技巧】

迁移学习在计算机视觉有很大的影响,但现在的NLP中的方法仍然需要特定任务的修改和 从头开始的训练。我们提出通用语言模型微调,一种可以应用NLP任何任务中的迁移学习方法。我们模型在分类任务中都表现得良好,并且在小数据集上的表现优异。 一、ULMFiT (Universal Language Model Fine- tuning)组成步骤: a) General-domain LM pretr

keras 实现dense prediction 逐像素标注 语义分割 像素级语义标注 pixelwise segmention labeling classification 3D数据

主要是keras的示例都是图片分类。而真正的论文代码,又太大了,不适合初学者(比如我)来学习。 所以我查找了一些资料。我在google 上捞的。 其中有个教程让人感觉很好.更完整的教程。另一个教程。 大概就是说,你的输入ground truth label需要是(width*height,class number),然后网络最后需要加个sigmoid,后面用binary_crossentro

基于Python的机器学习系列(18):梯度提升分类(Gradient Boosting Classification)

简介 梯度提升(Gradient Boosting)是一种集成学习方法,通过逐步添加新的预测器来改进模型。在回归问题中,我们使用梯度来最小化残差。在分类问题中,我们可以利用梯度提升来进行二分类或多分类任务。与回归不同,分类问题需要使用如softmax这样的概率模型来处理类别标签。 梯度提升分类的工作原理 梯度提升分类的基本步骤与回归类似,但在分类任务中,我们使

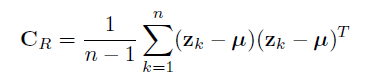

Region Covariance: A Fast Descriptor for Detection and Classification算法总结

传统的像素级特征比如颜色、梯度、滤波响应等等它们对光照变化和非刚性运动的描述不够鲁棒,而在像素级特征之上延伸出的直方图表述了一种无参的联合分布,然而随着特征数目的增加,联合分布的表达是呈指数增加的。另外,关键点的检测以及描述在匹配局部图像上非常有效,然而它们只包含了局部信息,没有利用全局的信息。 与直方图类似,协方差也能作为特征描述,并且协方差的特征维度要小很多。实验证明,协方差特征比其他特征性

论文学习—Efficient Multi-label Classification with Many Labels

论文学习:Efficient Multi-label Classification with Many Labels 摘要2. 多标签分类相关工作2.1 Label Transformation1. **降维(Dimensionality Reduction)**2. **回归模型(Regression Model)**3. **逆变换(Inverse Transformation)** 2

论文笔记 A Large Contextual Dataset for Classification,Detection and Counting of Cars with Deep Learning

ECCV 2016的文章,首先建立了一个从上到下照的车辆影像数据集(即鸟瞰视角),并提出ResCeption神经网络进行训练,进一步建立residual learning with Inception-style layers,进行车辆数目的计算。该方法为车辆数目的计算的一种新方式:通过定位和密度估计方法。对于新的场景或新的目标计数也同样适用。 文章主要关注3个任务点:(1)两类的分类问题(2)

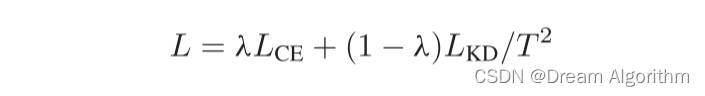

Class-Aware Self-Distillation for Remote SensingImage Scene Classification

这篇文章提出了一种新的蒸馏方式,由于遥感场景图像具有类间相似性和类内多样性的特点,这篇文章试图解决这个问题。通过三个共享权重的分支,同时输入三张图片,其中两张类别相同的图片,一张类别不同但地物特征相似的图片,用x1,x2,x3表示。这样就获得了三个输出,将相同类别的输出和相似类别的输出同时对x1的输出进行蒸馏。过程如下图所示: 蒸馏的目标为增大类内相似性,减小类间相似性,通过构建

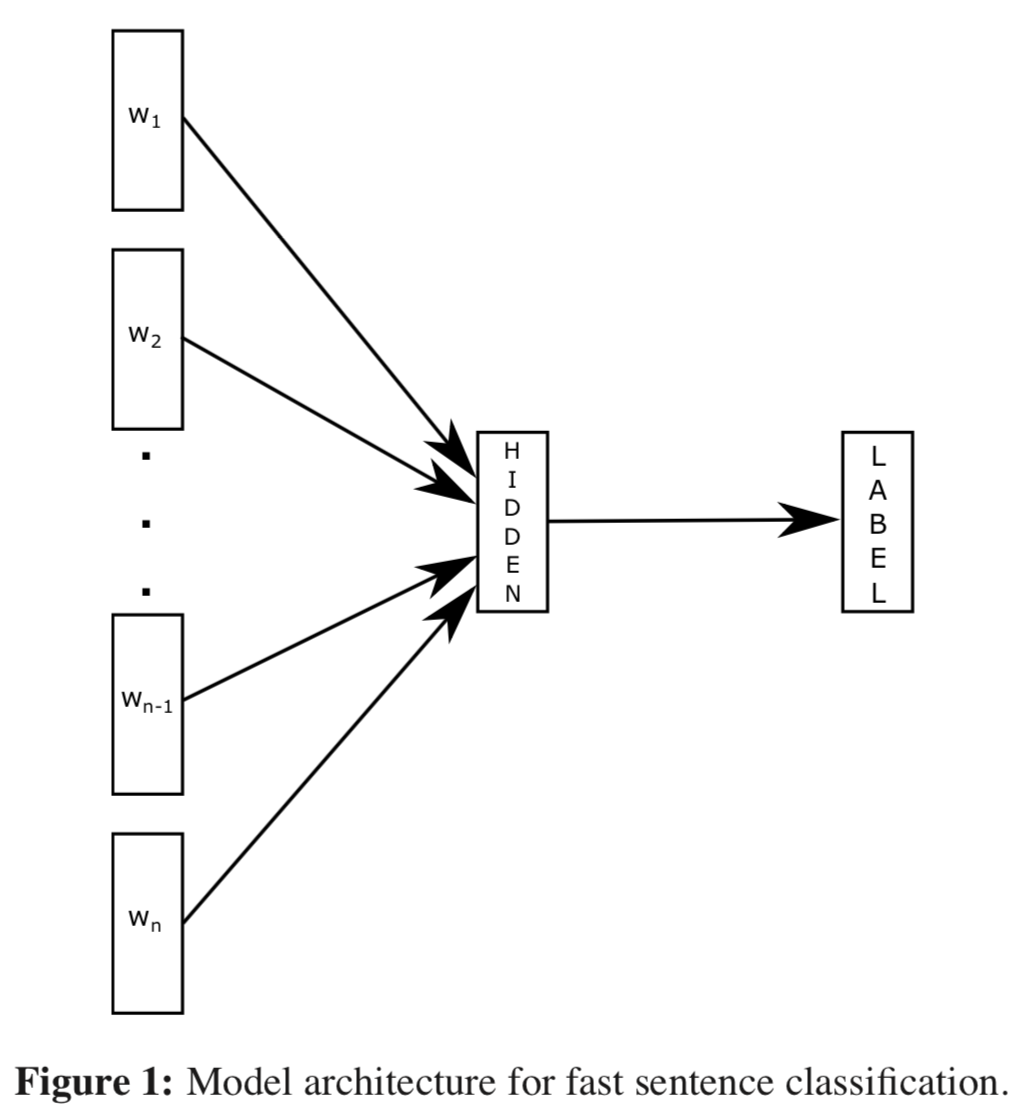

论文阅读:《Convolutional Neural Networks for Sentence Classification》

重磅专栏推荐: 《大模型AIGC》 《课程大纲》 《知识星球》 本专栏致力于探索和讨论当今最前沿的技术趋势和应用领域,包括但不限于ChatGPT和Stable Diffusion等。我们将深入研究大型模型的开发和应用,以及与之相关的人工智能生成内容(AIGC)技术。通过深入的技术解析和实践经验分享,旨在帮助读者更好地理解和应用这些领域的最新进展 论文地址:http://xueshu

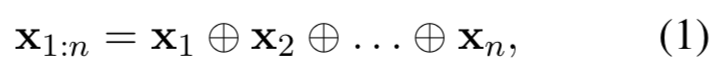

论文阅读:《Bag of Tricks for Efficient Text Classification》

重磅专栏推荐: 《大模型AIGC》 《课程大纲》 《知识星球》 本专栏致力于探索和讨论当今最前沿的技术趋势和应用领域,包括但不限于ChatGPT和Stable Diffusion等。我们将深入研究大型模型的开发和应用,以及与之相关的人工智能生成内容(AIGC)技术。通过深入的技术解析和实践经验分享,旨在帮助读者更好地理解和应用这些领域的最新进展 https://blog.csdn.

论文笔记|DOC: Deep Open Classification of Text Documents

作者:徐甘霖 单位:燕山大学 概述 关于文本分类(Text Classification)及开放领域文本分类(Open-set Text Classification)的介绍,请见5月4日的文章Overcoming the challenge for text classification in the open world,里面简单介绍了文本分类(包括开放领域文本分类)的概念及常用方法

论文笔记丨FewRel 2.0: Towards More Challenging Few-Shot Relation Classification

作者:凯 单位:燕山大学 code:https://github.com/thunlp/fewrel paper:https://www.aclweb.org/anthology/D19-1649.pdf FewRel 2.0: Towards More Challenging Few-Shot Relation Classification 问题介绍FewRel 2.0BE

[amanhardikar] - worm-classification

From: http://www.amanhardikar.com/mindmaps/worm-classification.png

[amanhardikar] - virus-classification

From: http://www.amanhardikar.com/mindmaps/virus-classification.png

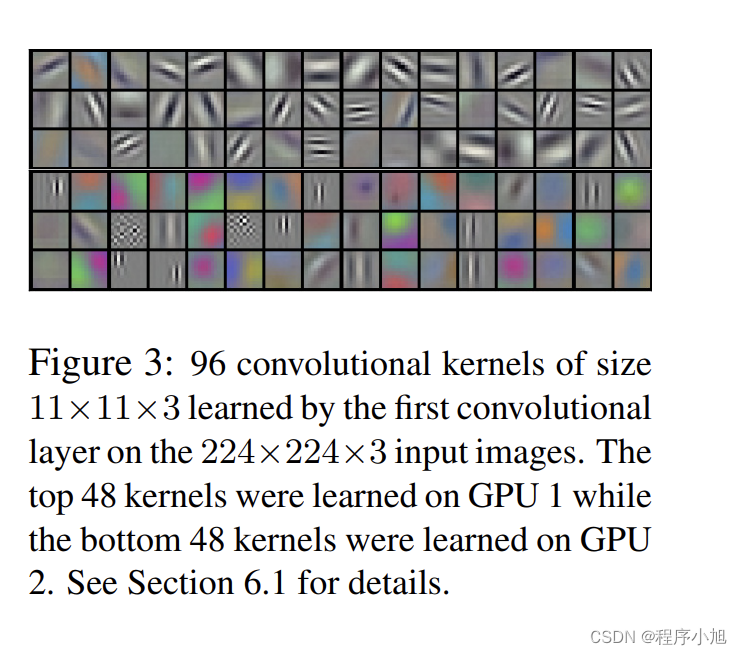

AlexNet论文解析—ImageNet Classification with Deep Convolutional Neural Networks

AlexNet论文解析—ImageNet Classification with Deep Convolutional Neural Networks 2012 研究背景 认识数据集:ImageNet的大规模图像识别挑战赛 LSVRC-2012:ImageNet Large Scale Visual Recoanition Challenge 类别训练数据测试数据图片格式Mnist1

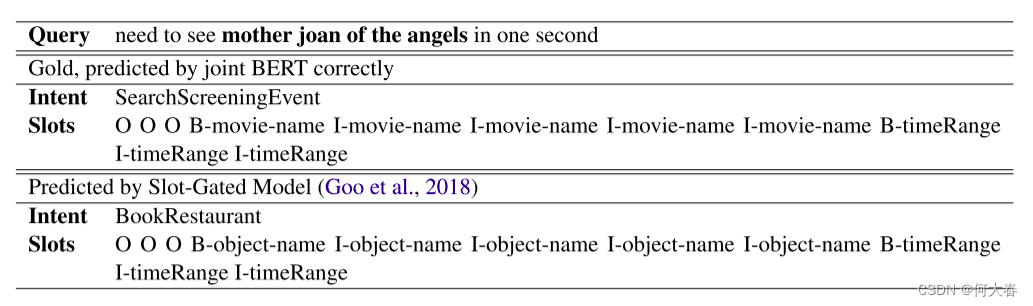

BERT for Joint Intent Classification and Slot Filling 论文阅读

BERT for Joint Intent Classification and Slot Filling 论文阅读 Abstract1 Introduction2 Related work3 Proposed Approach3.1 BERT3.2 Joint Intent Classification and Slot Filling3.3 Conditional Random Fiel

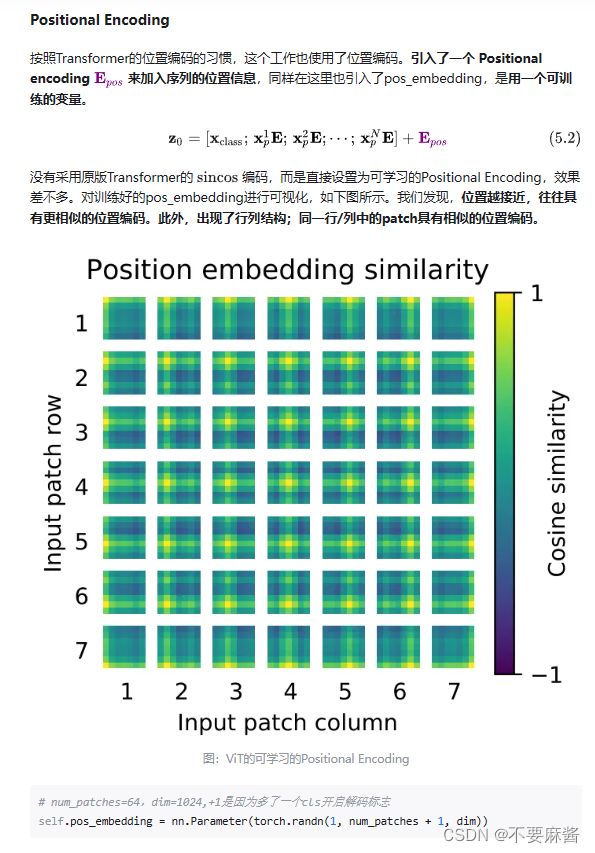

Transformer+Classification学习笔记

论文名称:An Image is Worth 16x16 Words:Transformers for Image Recognition at Scale [2112.11010] MPViT: Multi-Path Vision Transformer for Dense Prediction (arxiv.org) 参考博客与视频: Vision Transformer 超详细解读

ImageNet Classification with Deep Convolutional Neural Networks笔记(摘要版)

Contents 1.全部架构 2.降低过拟合 3.学习细节 4.结果 5.讨论 本笔记为论文的摘要版,详细数据和论文详解见: http://www.gageet.com/2014/09140.php 本文训练了一个深度卷积神经网络,来将ILSVRC-2010中1.2M的高分辨率图像数据分为1000类。测试结果,Top-1和Top-5的错误率分别为37.5%和17%,优于当时

#####好好好#####论文分享 | Learning Aligned-Spatial GCNs for Graph Classification

目前大部分GCN方法可以被归为两类:Spectral(基于频域)卷积和 Spatial(基于空域)卷积。前者主要基于 Spectral Graph Theory 将图信号变换到谱域与滤波器系数进行相乘再做逆变换[1][2],这种方法处理的图结构常常是固定大小的(节点个数固定)并且主要解决的是节点分类问题。然而现实中图数据的大小往往不固定,例如生物信息数据中的蛋白质结构、社交网络中的用户关系等,基于

[深度学习论文笔记][AAAI 18]Accelerated Training for Massive Classification via Dynamic Class Selection

[AAAI 18] Accelerated Training for Massive Classification via Dynamic Class Selection Xingcheng Zhang, Lei Yang, Junjie Yan, Dahua Lin from CUHK & SenseTime paper link Motivation 这篇文章研究当分类器分类个数非常

ImageNet Classification with Deep Convolutional Neural Network解读

ImageNet Classification with Deep Convolutional Neural Network 本文是Alex和Hinton参加ILSVRC2012比赛的卷积网络论文,本网络结构也是开启Imagenet数据集更大,更深CNN的开山之作,本文对CNN的一些改进成为以后CNN网络通用的结构;在一些报告中被称为Alex-net,之后在Imagenet上取得更

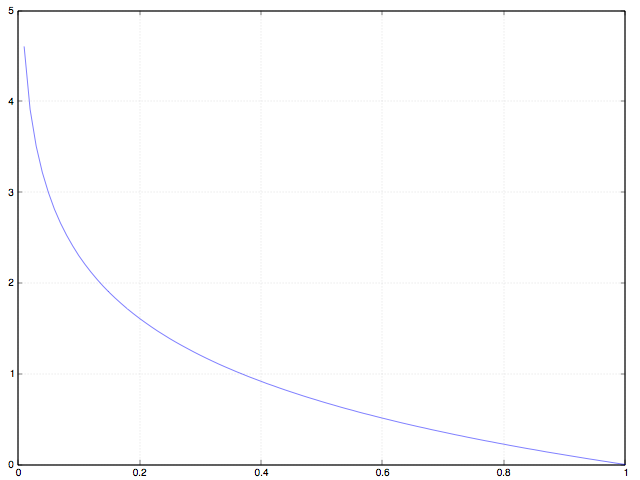

分类模型的 Loss 为什么使用 cross entropy 而不是 classification error 或 squared error

提纲: 分类模型 与 Loss 函数的定义, 为什么不能用 Classification Error, Cross Entropy 的效果对比, 为什么不用 Mean Squared Error, 定量理解 Cross Entropy, 总结, 参考资料。 交叉熵定义:http://blog.csdn.net/lanchunhui/article/details/50970625

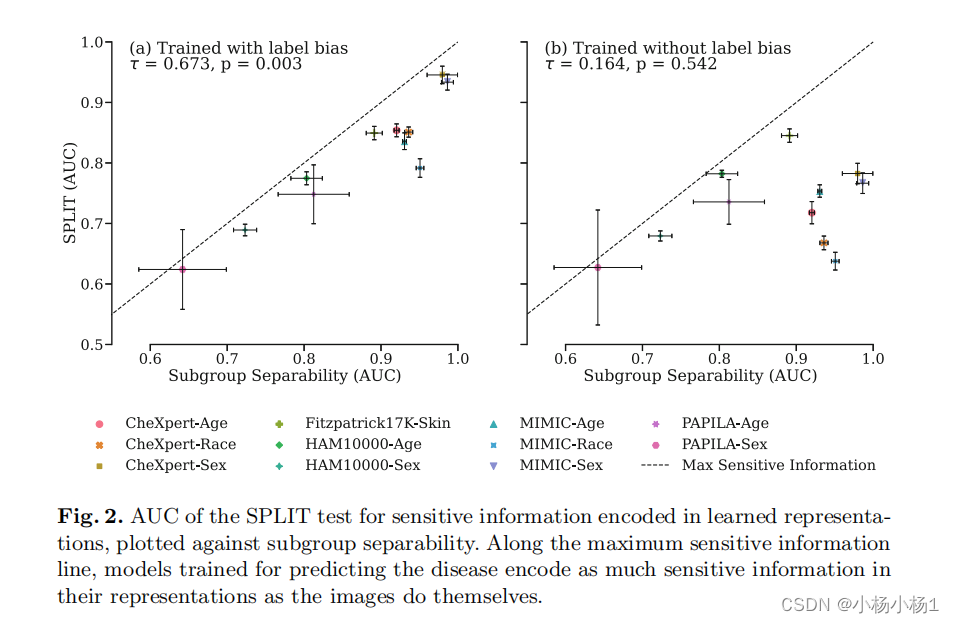

The Role of Subgroup Separability in Group-Fair Medical Image Classification

文章目录 The Role of Subgroup Separability in Group-Fair Medical Image Classification摘要方法实验结果 The Role of Subgroup Separability in Group-Fair Medical Image Classification 摘要 研究人员调查了深度分类器在性能上的差异

论文阅读笔记:A Closer Look at Few-shot Classification

论文:A Closer Look at Few-shot Classification / 近距离观察小样本分类问题 作者:Wei-Yu Chen,Yen-Cheng Liu & Zsolt Kira,Yu-Chiang Frank Wang,Jia-Bin Huang 发表刊物:ICLR 发表年度:2019 下载地址:https://arxiv.org/pdf/1904.04232.pd

DeepI2P: Image-to-Point Cloud Registration via Deep Classification

文章地址https://openaccess.thecvf.com/content/CVPR2021/papers/Li_DeepI2P_Image-to-Point_Cloud_Registration_via_Deep_Classification_CVPR_2021_paper.pdf 摘要: 本文提出了DeepI2P:一种新颖的方法,用于图像与点云之间的跨模态注册。给定一幅图像(

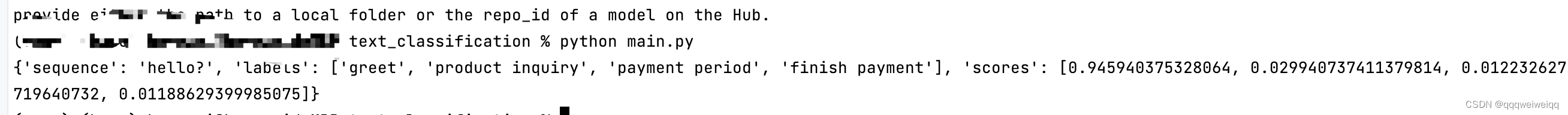

人机交互系统文本分类 text classification环节源码(E-commerce)

我把pre-trained model 下载到了本地 效果如下(到时候把代码中的sequence 和labels换成自己的text和分类就行了。): 源码见链接: https://download.csdn.net/download/qqqweiweiqq/89211553

![[amanhardikar] - worm-classification](https://img-blog.csdn.net/20150719131533832)

![[amanhardikar] - virus-classification](https://img-blog.csdn.net/20150719131409077)

![[深度学习论文笔记][AAAI 18]Accelerated Training for Massive Classification via Dynamic Class Selection](https://img-blog.csdn.net/2018052520261694?watermark/2/text/aHR0cHM6Ly9ibG9nLmNzZG4ubmV0L3UwMTAxNTg2NTk=/font/5a6L5L2T/fontsize/400/fill/I0JBQkFCMA==/dissolve/70)