surpassing专题

深度学习论文笔记(MSRA初始化与PReLU):Surpassing Human-Level Performance on ImageNet Classification

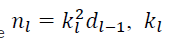

文章目录 主要工作PReLU激活函数PReLU定义PReLU中参数的反向传播 MSRA初始化目的前向传播假设推导 反向传播假设与推导 MSRA初始化为什么以方差作为分析工具 主要工作 一、提出PReLU激活函数 二、提出适合ReLU与PReLU激活函数的初始化方法MSRA,可有效抵抗梯度消失,训练深度网络 发现了网络的"退化"问题,2016年的时候提出了相应的解决方案——残差

Delving Deep into Rectifiers: Surpassing Human-Level Performance on ImageNet Classification

序:在ISVRC2015 on ImageNet2012 classification dataset 上,取得了4.94%的 top-5 test error,这是第一次超越了人的识别了率(5.1%). 文章提出了两个内容: (1) Parametric Rectified Linear Unit (PReLU) :使模型以接近0的额外计算代价和较小的过拟合风险训练模型。 (2) MSRA

[深度学习论文笔记][Weight Initialization] Delving deep into rectifiers: Surpassing human-level performance

He, Kaiming, et al. “Delving deep into rectifiers: Surpassing human-level performance on imagenet classification.” Proceedings of the IEEE International Conference on Computer Vision. 2015. [Citations

近日思索 以及 AlignedReID: Surpassing Human-Level Performance in Person Re-Identification 论文翻译笔记

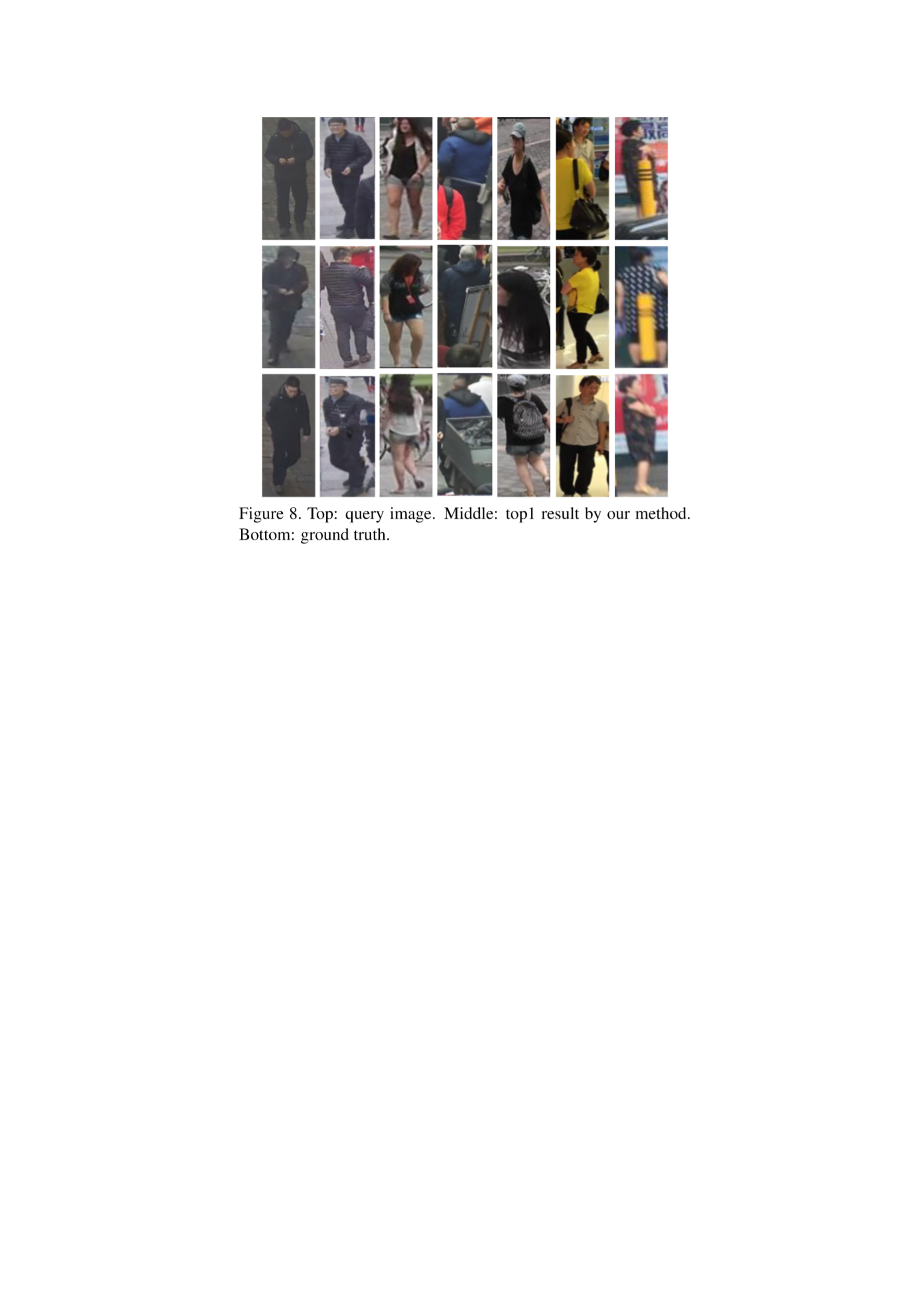

最近思考了基于UV展开的行人重识别方法,并没有实现很好的效果,我在想此方法是不是太过于理想化,理论上是可行但实际上并不适合,因为uv图的比较要将图片切分成4*6的小块再进行比较,而uv展开图的小图差异又不易比较,如果没有非常接近的图片则不会将他们视为相似。 若是没有充足的图片供填充完整的uv图,只有有限个图片则不能高效的进行重识别 于是想借鉴一下别人的方法,这篇论文号称是效果很好的一篇,学习学

(有源码)part-aligned系列论文:1711.AlignedReID- Surpassing Human-Level Performance in Person Re-Id 论文阅读

原 part-aligned系列论文:1711.AlignedReID- Surpassing Human-Level Performance in Person Re-Id 论文阅读 https://blog.csdn.net/xuluohongshang/article/details/79036440 xuluohongshang 阅读数:2032 <

[论文阅读]AlignedReID: Surpassing Human-Level Performance in Person Re-dentification

AlignedReID: Surpassing Human-Level Performance in Person Re-dentification Introduction 这是旷视科技的一篇论文,提出的AlignedReID算法在Market-1501和CHUK-03数据集上rank-1的准确率达到94.4%和97.8%,即使没有re-rank,也达到了91.8%和92.4%的精确率;并且

《Delving Deep into Rectifiers: Surpassing Human-Level Performance on ImageNet Classification》论文阅读笔记

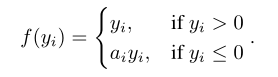

论文原文:http://arxiv.org/abs/1502.01852 论文主要讨论了以ReLU为激活函数的网络的缺陷并提出了改进的激活函数PReLU与新的Kaiming初始化方法 1. PReLU 前向传播 通道独立: f ( y i ) = max ( 0 , y i ) + a i min ( 0 , y i ) f\left(y_{i}\right)=\max \le

《AlignedReID:Surpassing Human-Level Performance in Person Re-Identification》理解

转载于:https://www.cnblogs.com/Thinker-pcw/p/8324000.html

关于PRelu:Delving Deep into Rectifiers: Surpassing Human-Level Performance on ImageNet Classification

前言 内容是经典激活函数PRelu的提出 内容 上图左为Relu,右图为PRelu,P相比传统Relu,在坐标系左边有数值。用公式解释: 当ai=0时,成为Relu;当ai是一个小且固定的数值,则变成Leaky Relu(ai=0.01),LRelu的motivation是为了防止零梯度,即坐标轴左侧有数值。但是在一些研究上,显示LRelu对于精度的影响微乎其微。 Prelu相比Rel

![[深度学习论文笔记][Weight Initialization] Delving deep into rectifiers: Surpassing human-level performance](https://img-blog.csdn.net/20160920172827657?watermark/2/text/aHR0cDovL2Jsb2cuY3Nkbi5uZXQv/font/5a6L5L2T/fontsize/400/fill/I0JBQkFCMA==/dissolve/70/gravity/Center)

![[论文阅读]AlignedReID: Surpassing Human-Level Performance in Person Re-dentification](http://ow5vsszoc.bkt.clouddn.com/paper/Alignedreidalignedreid4.jpg)