imagenet专题

线性代数|机器学习-P33卷积神经网络ImageNet和卷积规则

文章目录 1. ImageNet2. 卷积计算2.1 两个多项式卷积2.2 函数卷积2.3 循环卷积 3. 周期循环矩阵和非周期循环矩阵4. 循环卷积特征值4.1 卷积计算的分解4.2 运算量4.3 二维卷积公式 5. Kronecker Product 1. ImageNet ImageNet 的论文paper链接如下:详细请直接阅读相关论文即可 通过网盘分享的文件:image

[从零开始]使用ImageNet数据集实验

记录一下最近开始的ImageNet学习,论文中虽然提到了很多,也开源了训练代码,但是多数情况用自己的代码在相同的Condition就是难以复现,记录一点点目前的。 ImageNet,yyds 数据 数据下载源于官网 http://image-net.org/download,需要注册edu邮箱,一些参考: 下载imagenet2012数据集,以及label说明 下载下来的标签有不对应的

Scaling SGD Batch Size to 32K for ImageNet Training

为了充分利用GPU计算,加快训练速度,通常采取的方法是增大batch size.然而增大batch size的同时,又要保证精度不下降,目前的state of the art 方法是等比例与batch size增加学习率,并采Sqrt Scaling Rule,Linear Scaling Rule,Warmup Schem等策略来更新学来率. 在训练过程中,通过控制学习率,便可以在训练的时候采

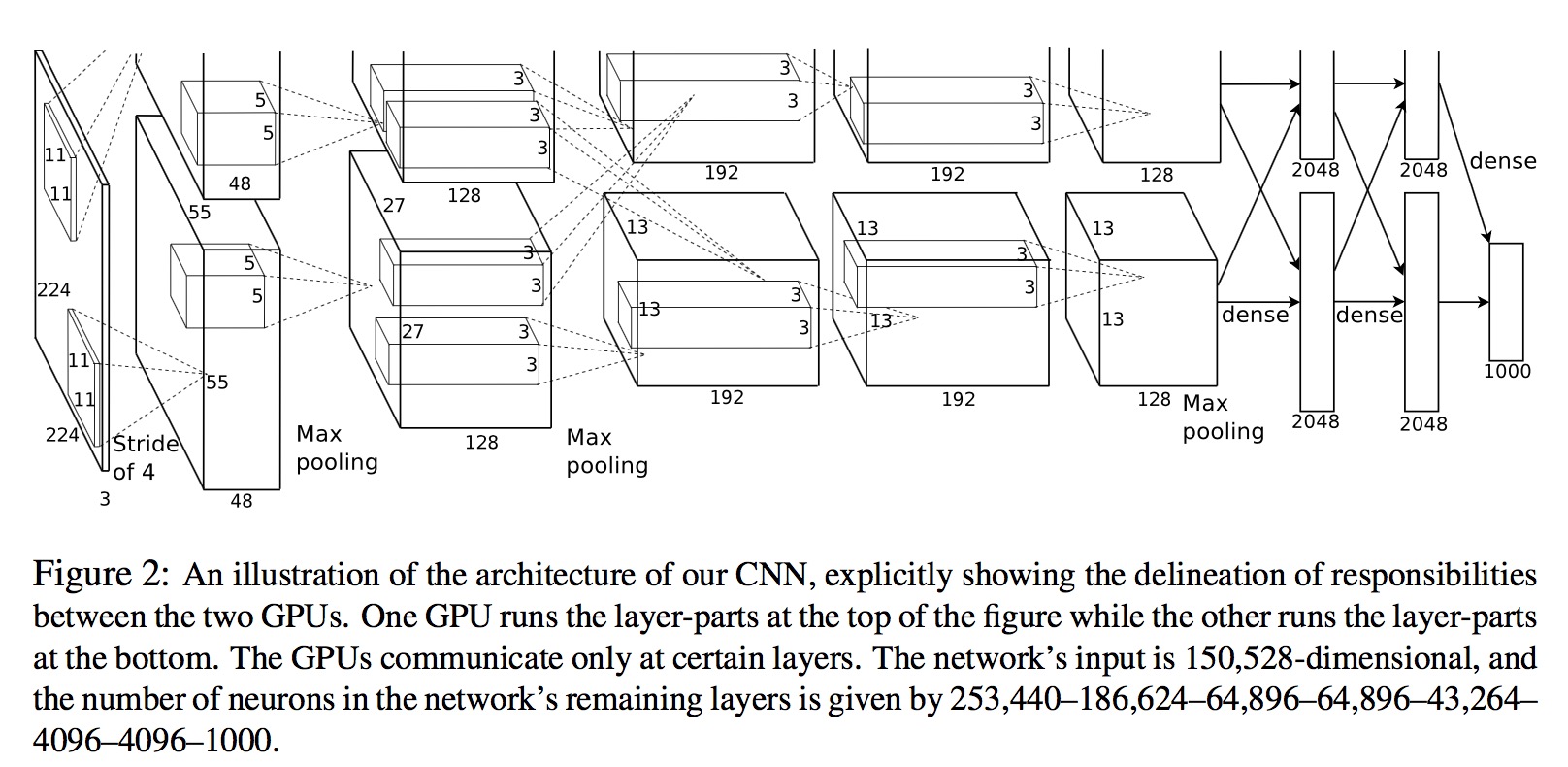

AlexNet论文解析—ImageNet Classification with Deep Convolutional Neural Networks

AlexNet论文解析—ImageNet Classification with Deep Convolutional Neural Networks 2012 研究背景 认识数据集:ImageNet的大规模图像识别挑战赛 LSVRC-2012:ImageNet Large Scale Visual Recoanition Challenge 类别训练数据测试数据图片格式Mnist1

处理Mini-ImageNet数据集,用于分类任务

一、Mini-ImageNet数据集介绍 ImageNet 1000类的数据太大了,全部下载大概有100GB左右。 2016年google DeepMind团队从ImagNet数据集中抽取的一小部分(大小约3GB)制作了Mini-ImageNet数据集,共有100个类别,每个类别有600张图片,共6w张(都是.jpg结尾的文件),而且图像的大小并不是固定的,作为小样本学习(Few-shot L

ImageNet Classification with Deep Convolutional Neural Networks笔记(摘要版)

Contents 1.全部架构 2.降低过拟合 3.学习细节 4.结果 5.讨论 本笔记为论文的摘要版,详细数据和论文详解见: http://www.gageet.com/2014/09140.php 本文训练了一个深度卷积神经网络,来将ILSVRC-2010中1.2M的高分辨率图像数据分为1000类。测试结果,Top-1和Top-5的错误率分别为37.5%和17%,优于当时

ImageNet的下载及解压简易版本

ImageNet下载 官方下载 https://www.cnblogs.com/devilmaycry812839668/p/15590629.html 百度网盘+迅雷下载 链接是个种子(只要下载12年版本的,不要全下载) https://pan.baidu.com/s/1MEjNh6evha2hcdrQXjNv8w?pwd=yzza 下载后解压 解压train文件夹 1.新建一个imag

18-Rethinking-ImageNet-Pre-training

what 在目标检测和实例分割两个领域,我们使用随机初始化方法训练的模型,在 COCO 数据集上取得了非常鲁棒的结果。其结果并不比使用了 ImageNet 预训练的方法差,即使那些方法使用了 MaskR-CNN 系列基准的超参数。在以下三种情况,得到的结果仍然没有降低: 仅使用 10% 的训练数据;使用更深和更宽的模型使用多个任务和指标。 ImageNet 预训练模型并非必须,ImageNe

ImageNet Classification with Deep Convolutional Neural Network解读

ImageNet Classification with Deep Convolutional Neural Network 本文是Alex和Hinton参加ILSVRC2012比赛的卷积网络论文,本网络结构也是开启Imagenet数据集更大,更深CNN的开山之作,本文对CNN的一些改进成为以后CNN网络通用的结构;在一些报告中被称为Alex-net,之后在Imagenet上取得更

imagenet 1000分类

n01440764 鱼 n01443537 鱼 n01484850 鱼 n01491361 鱼 n01494475 鱼 n01496331 鱼 n01498041 鱼 n01514668 鸡 n01514859 鸡 n01518878 鸵鸟 n01530575 鸟 n01531178 鸟 n01532829 鸟 n01534433 鸟 n01537544 鸟 n015

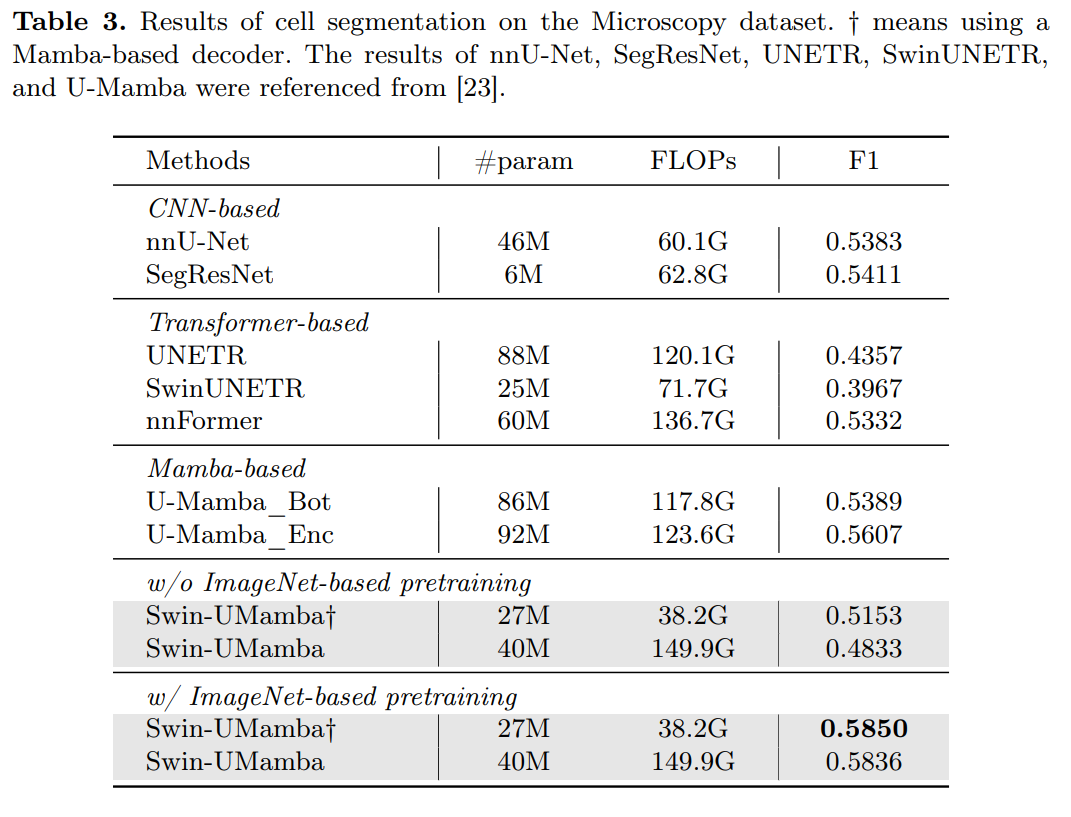

Swin-UMamba:结合基于ImageNet的预训练和基于Mamba的UNet模型

摘要 https://arxiv.org/pdf/2402.03302v1.pdf 准确的医学图像分割需要整合从局部特征到全局依赖的多尺度信息。然而,现有方法在建模长距离全局信息方面面临挑战,其中卷积神经网络(CNNs)受限于其局部感受野,而视觉转换器(ViTs)则受到其注意力机制高二次复杂度的困扰。最近,基于Mamba的模型因其在长序列建模中的出色能力而备受关注。多项研究表明,这些模型在各种任

ImageNet 2017夺冠架构SENetSENet

SENet 论文链接:https://arxiv.org/abs/1709.01507 代码地址:https://github.com/hujie-frank/SENet 1. 概述 此论文是由Momenta公司所作并发于2017CVPR,论文中的SENet赢得了ImageNet最后一届(ImageNet 2017)的图像识别冠军,论文的作者也很无私开源了其代码,并有caffe版本的实现。论

Android 10这波升级够猛,史上最大碳纳米管芯片问世,Facebook全面刷新ImageNet (2019/09/02)...

行 业 要 闻 Industry News ▲▲▲ 0 1 更像iOS了?Android 10够猛 这波升级来感受下 近日谷歌正式宣布将下一版Android命名为Android 10,并于今年秋季发布。安卓新系统不仅在代号上一改过去的“甜点”式命名传统,在标识上也发生了变化,那么这款Android 10在功能上做出了哪些升级呢? 1、手势导航:Android 10中的默认导航方式升级为手

YOLOv8独家改进:backbone改进 | 最新大卷积核CNN架构UniRepLKNet,ImageNet 88% | CVPR2024

💡💡💡本文独家改进:大核卷积一统多种模态!RepLK正统续作UniRepLKNet,代替YOLOv8 Backbone 改进结构图如下: 收录 YOLOv8原创自研 https://blog.csdn.net/m0_63774211/category_12511737.html?spm=1001.2014.3001.5482 💡💡💡全网独家首发创新(原创),适合p

YOLOv5独家改进:backbone改进 | 最新大卷积核CNN架构UniRepLKNet,ImageNet 88% | CVPR2024

💡💡💡本文独家改进:大核卷积一统多种模态!RepLK正统续作UniRepLKNet,代替YOLOv5 Backbone 改进结构图如下: 收录 YOLOv5原创自研 https://blog.csdn.net/m0_63774211/category_12511931.html 💡💡💡全网独家首发创新(原创),适合paper !!! 💡💡💡 2024年

18-Rethinking-ImageNet-Pre-training

what 在目标检测和实例分割两个领域,我们使用随机初始化方法训练的模型,在 COCO 数据集上取得了非常鲁棒的结果。其结果并不比使用了 ImageNet 预训练的方法差,即使那些方法使用了 MaskR-CNN 系列基准的超参数。在以下三种情况,得到的结果仍然没有降低: 仅使用 10% 的训练数据;使用更深和更宽的模型使用多个任务和指标。 ImageNet 预训练模型并非必须,ImageNe

Swin-UMamba:结合基于ImageNet的预训练和基于Mamba的UNet模型

摘要 https://arxiv.org/pdf/2402.03302v1.pdf 准确的医学图像分割需要整合从局部特征到全局依赖的多尺度信息。然而,现有方法在建模长距离全局信息方面面临挑战,其中卷积神经网络(CNNs)受限于其局部感受野,而视觉转换器(ViTs)则受到其注意力机制高二次复杂度的困扰。最近,基于Mamba的模型因其在长序列建模中的出色能力而备受关注。多项研究表明,这些模型在各种任

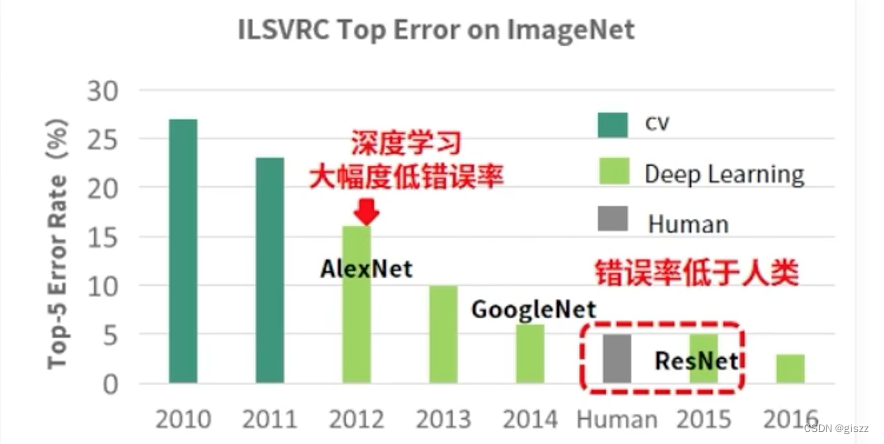

【大厂AI课学习笔记】1.4 算法的进步(4)关于李飞飞团队的ImageNet

第一个图像数据库是ImageNet,由斯坦福大学的计算机科学家李飞飞推出。ImageNet是一个大型的可视化数据库,旨在推动计算机视觉领域的研究。这个数据库包含了数以百万计的手工标记的图像,涵盖了数千个不同的类别。 基于ImageNet数据库,每年都会举办一场大规模的视觉识别挑战赛(ImageNet Large Scale Visual Recognition Challenge,简称ILSVR

UC伯克利博士尤洋回国创业,曾破ImageNet纪录!已获超千万融资

曾刷新ImageNet纪录的尤洋,回国创业了! 尤洋,何许人也? 他是LAMB优化器的提出者,曾成功将预训练一遍BERT的时间,从原本的三天三夜一举缩短到一个多小时。 作为一个通用的神经网络优化器,LAMB优化器无论是大批量还是小批量的网络都可以使用,也无需在学习率之外调试超参数。 据英伟达官方GitHub显示,LAMB比Adam优化器可以快出整整72倍。 微软的DeepSp

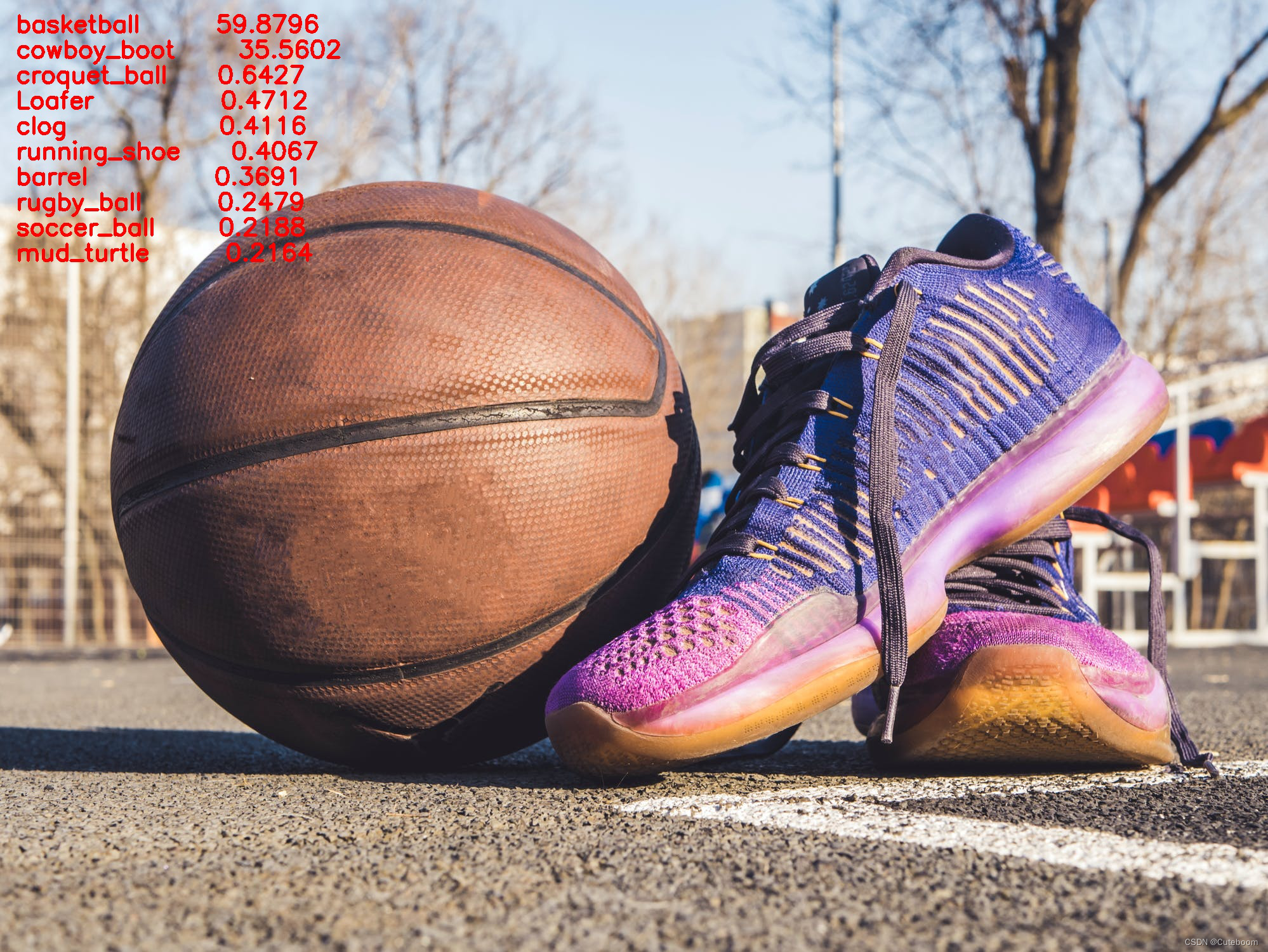

ImageNet预训练图像分类模型预测单张图像

导入基础工具包 import osimport cv2import pandas as pdimport numpy as npimport torchimport matplotlib.pyplot as plt%matplotlib inline 计算设备确定 # 有 GPU 就用 GPU,没有就用 CPUdevice = torch.device('cuda:0' if torc

NLP领域的ImageNet时代到来:词嵌入「已死」,语言模型当立

http://3g.163.com/all/article/DM995J240511AQHO.html 选自the Gradient 作者:Sebastian Ruder 机器之心编译 计算机视觉领域常使用在 ImageNet 上预训练的模型,它们可以进一步用于目标检测、语义分割等不同的 CV 任务。而在自然语言处理领域中,我们通常只会使用预训练词嵌入向量编码词汇间的关系,因此也就没有

ILSVRC竞赛详细介绍(ImageNet Large Scale Visual Recognition Challenge)

ILSVRC(ImageNet Large Scale Visual Recognition Challenge)是近年来机器视觉领域最受追捧也是最具权威的学术竞赛之一,代表了图像领域的最高水平。 ImageNet数据集是ILSVRC竞赛使用的是数据集,由斯坦福大学李飞飞教授主导,包含了超过1400万张全尺寸的有标记图片。ILSVRC比赛会每年从ImageNet数据集中抽出部分样本,以2012年

ImageNet Classification with Deep Convolutional 论文笔记

✅作者简介:人工智能专业本科在读,喜欢计算机与编程,写博客记录自己的学习历程。 🍎个人主页:小嗷犬的个人主页 🍊个人网站:小嗷犬的技术小站 🥭个人信条:为天地立心,为生民立命,为往圣继绝学,为万世开太平。 本文目录 标题和作者摘要创新点ReLU多 GPUDropout其他 网络结构输入层(Input layer)卷积层(C1)卷积层(C2)卷积层(C3)卷积层(C4)卷

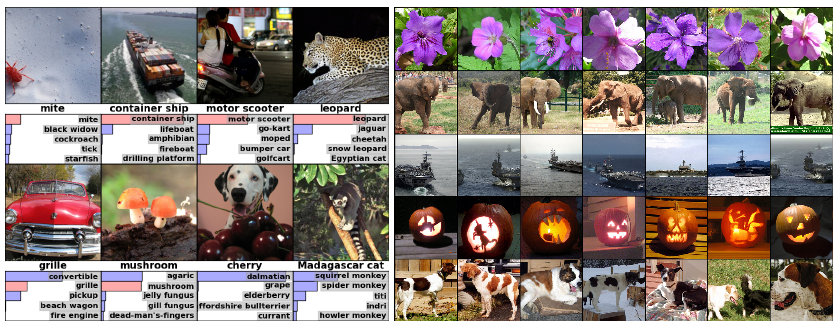

ImageNet Classification with Deep Convolutional Neural Networks(译文)

ImageNet Classification with Deep Convolutional Neural Networks Alex Krizhevsky, Ilya Sutskever, Geoffrey E. Hinton 摘要 我们训练了一个大型的深度卷积神经网络,来将在ImageNet LSVRC-2010大赛中的120万张高清图像分为1000个不同的类别。对测试数据,我们得到了to

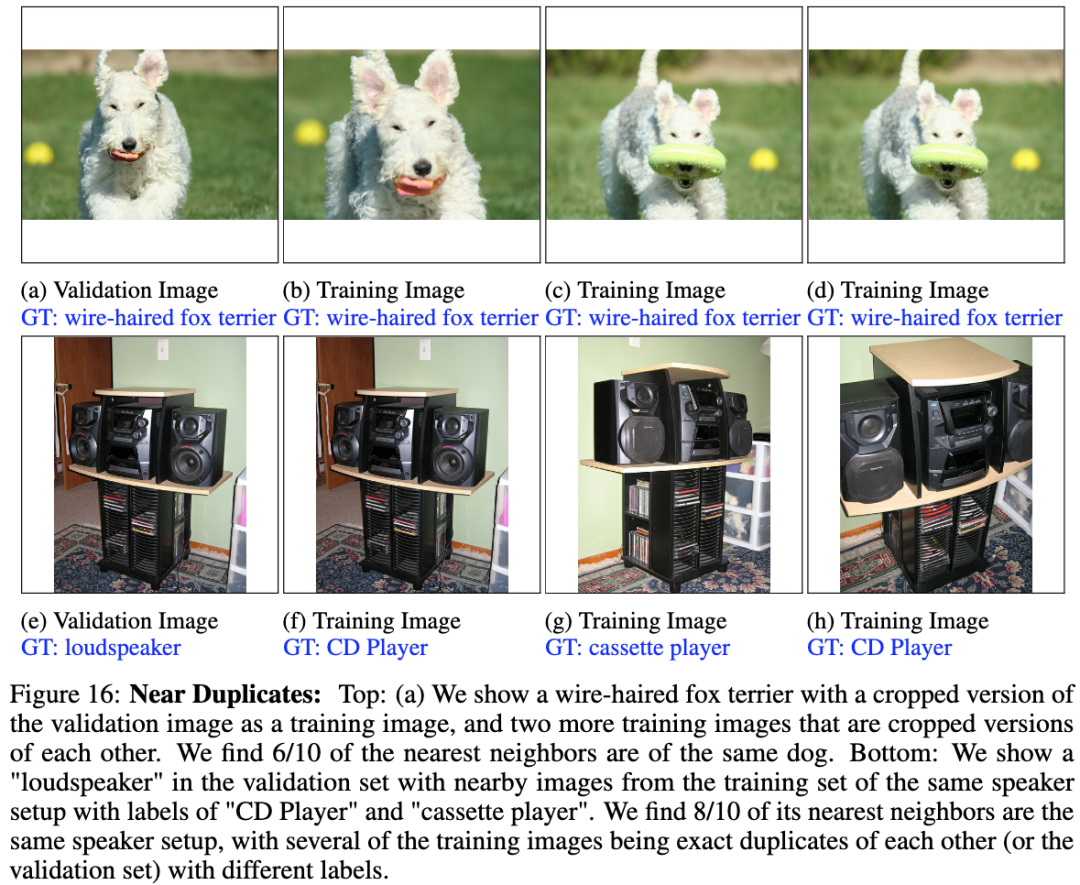

谷歌大脑团队:ImageNet错误数据分析

原文:Vasudevan V, Caine B, Gontijo-Lopes R, et al. When does dough become a bagel? Analyzing the remaining mistakes on ImageNet[J]. arXiv preprint arXiv:2205.04596, 2022. 源码:https://github.com/google-r

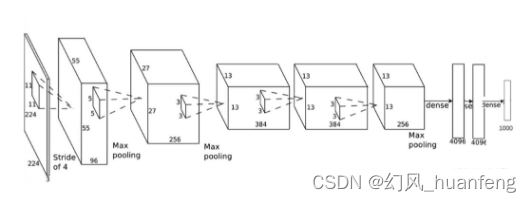

每天五分钟计算机视觉:ImageNet大赛的世界冠军AlexNet模型

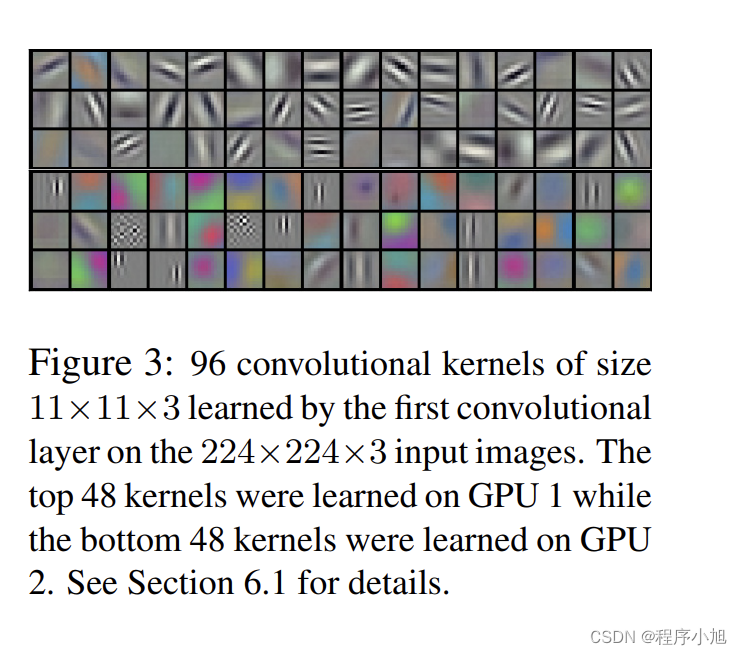

AlexNet模型 2012 Imagenet 比赛第一,Top5准确度超出第二10% ,它让人们认识到了深度学习技术的威力。比 LeNet更深,用多层小卷积层叠加替换大卷积层,就是说每一个卷积层的通道数小,不像LeNet一样每个卷积层的通道数很大。 AlexNet 一张227×227×3的图片作为输入,第一层我们使用 96 个11×11 的过滤器,步幅为 4,由于步幅是 4,因此尺

![[从零开始]使用ImageNet数据集实验](/front/images/it_default2.jpg)