prelu专题

深度学习-激活函数:饱和激活函数【Sigmoid、tanh】、非饱和激活函数【ReLU、Leaky ReLU、RReLU、PReLU、ELU、Maxout】

深度学习-激活函数:饱和激活函数【Sigmoid、tanh】、非饱和激活函数【ReLU、Leaky ReLU、RReLU、PReLU、ELU、Maxout】 一、激活函数的定义:二、激活函数的用途1、无激活函数的神经网络2、带激活函数的神经网络 三、饱和激活函数与非饱和激活函数1、饱和激活函数2、非饱和激活函数 四、激活函数的种类1、Sigmoid函数2、TanH函数3、ReLU(Recti

[记录]-cannot import name ‘prelu‘ from ‘lasagne.layers‘

问题:cannot import name 'prelu' from 'lasagne.layers' 现有版本:lasagne== 0.1,需要更新版本,直接pip installLasagne==0.2 目前还不行 需要去源码下载 命令: pip install --upgrade https://github.com/Theano/Theano/archive/master.zip

深度学习中常用的激活函数有sigmoid、tanh、ReLU、LeakyReLU、PReLU、GELU等。

深度学习中常用的激活函数 1. Sigmoid函数2. Tanh函数3. ReLU函数4. LeakyReLU函数5. PReLU函数6. ELU函数:7. GELU函数: 深度学习中常用的激活函数有sigmoid、tanh、ReLU、LeakyReLU、PReLU等。 1. Sigmoid函数 Sigmoid函数公式为 f ( x ) = 1 1 + e − x f(x)=

深度学习论文笔记(MSRA初始化与PReLU):Surpassing Human-Level Performance on ImageNet Classification

文章目录 主要工作PReLU激活函数PReLU定义PReLU中参数的反向传播 MSRA初始化目的前向传播假设推导 反向传播假设与推导 MSRA初始化为什么以方差作为分析工具 主要工作 一、提出PReLU激活函数 二、提出适合ReLU与PReLU激活函数的初始化方法MSRA,可有效抵抗梯度消失,训练深度网络 发现了网络的"退化"问题,2016年的时候提出了相应的解决方案——残差

关于PRelu:Delving Deep into Rectifiers: Surpassing Human-Level Performance on ImageNet Classification

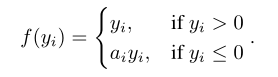

前言 内容是经典激活函数PRelu的提出 内容 上图左为Relu,右图为PRelu,P相比传统Relu,在坐标系左边有数值。用公式解释: 当ai=0时,成为Relu;当ai是一个小且固定的数值,则变成Leaky Relu(ai=0.01),LRelu的motivation是为了防止零梯度,即坐标轴左侧有数值。但是在一些研究上,显示LRelu对于精度的影响微乎其微。 Prelu相比Rel

![[记录]-cannot import name ‘prelu‘ from ‘lasagne.layers‘](/front/images/it_default.jpg)