本文主要是介绍Meta FAIR研究新成果:图像到文本、文本到音乐的生成模型,多标记预测模型以及AI生成语音检测技术,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

Meta AI研究实验室(FAIR)公开发布了多项新研究成果,包括图像到文本和文本到音乐的生成模型,多词预测模型,以及检测AI生成语音的技术。发布的成果体现了开放性、协作、卓越和规模化等核心原则。公开早期研究工作旨在激发迭代,推动AI负责任发展。

-

Meta Chameleon系列模型可将文本和图像作为输入,输出任意文本和图像组合。已发布7B和34B模型的关键组件。

-

发布多词预测预训练语言模型代码,可更高效训练语言模型。

-

发布JASCO文本到音乐生成模型,可接受各种条件输入如音调、拍子等,改进对生成音乐的控制。

-

发布AudioSeal,首个专为检测AI生成语音设计的音频水印技术,可实现对语音片段中的AI内容进行本地化检测。

-

发布PRISM数据集,记录1500名参与者与21个LLM的交流及反馈,用于探索反馈过程的方法、领域和目标。

-

发布GEO评估工具,用于评估文本到图像模型中的潜在地域差异;并探索了改进多样性的方法。

十多年来,Meta 的基础人工智能研究 (FAIR) 团队一直致力于通过开放研究推动人工智能的发展。随着该领域的创新继续快速发展,我们认为与全球人工智能社区的合作比以往任何时候都更加重要。保持开放的科学方法并与社区分享我们的工作有助于我们坚持我们的目标,即构建适合每个人并让世界更加紧密的人工智能系统。

今天,我们很高兴与全球社区分享一些最新的 FAIR 研究模型。我们公开发布了六项研究成果,重点关注我们工作的核心主题:创新、创造力、效率和责任。这些发布包括图像到文本和文本到音乐的生成模型、多标记预测模型以及用于检测 AI 生成的语音的技术。通过公开分享我们的早期研究工作,我们希望激发迭代并最终以负责任的方式帮助推动 AI 的发展。我们迫不及待地想看看社区使用这些最新版本构建了什么,并继续与开源社区进行重要的对话。

Meta Chameleon

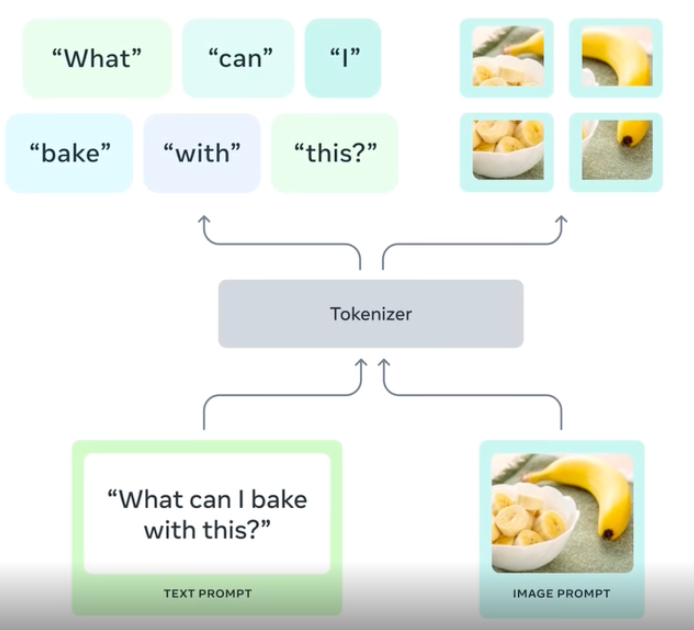

Meta Chameleon 是一个模型系列,它可以将文本和图像组合为输入,并以单一统一的架构输出任意文本和图像组合,用于编码和解码。

虽然大多数当前的后期融合模型使用基于扩散的学习,但 Meta Chameleon 对文本和图像使用标记化。这可以实现更统一的方法,并使模型更易于设计、维护和扩展。可能性无穷无尽 - 想象一下为图像生成创意标题或使用文本提示和图像的混合来创建一个全新的场景。

Multi-Token Prediction

大多数LLM都有一个简单的训练目标:预测下一个单词。虽然这种方法简单且可扩展,但效率也很低。与孩子们学习同等程度的语言流利程度相比,它需要的文本要多几个数量级。

今年4月,我们提出了一种新的方法,通过使用多令牌预测来构建更好更快的llm。使用这种方法,我们训练语言模型一次预测多个将来单词,而不是旧的一次预测一个单词的方法。这提高了模型能力和训练效率,同时允许更快的速度。本着负责任的开放科学精神,我们在非商业/仅限研究的许可下发布了预训练的代码完成模型。我们希望这能使研究界独立地研究我们的方法和训练模型的行为。

AudioSeal

生成式 AI 工具正在激励人们在社交媒体上与朋友、家人和关注者分享自己的创作。与所有 AI 创新一样,我们必须尽自己的一份力量来帮助确保负责任地使用这些工具。今天,我们发布了 AudioSeal,我们认为这是第一种专门为局部检测 AI 生成的语音而设计的音频水印技术,可以精确定位较长音频片段中的 AI 生成的片段。AudioSeal 通过专注于检测 AI 生成的内容而不是隐写术来改进传统的音频水印。与依赖复杂解码算法的传统方法不同,AudioSeal 的局部检测方法可以实现更快、更高效的检测。与以前的方法相比,这种设计将检测速度提高了 485 倍,使其非常适合大规模和实时应用。我们的方法在音频水印的稳健性和不可感知性方面实现了最先进的性能。

AudioSeal 是根据商业许可发布的。这只是我们为防止滥用生成式 AI 工具而分享的几条负责任的研究路线之一。我们在基础文本和语音翻译模型SeamlessM4T v2和Audiobox生成的语音样本中加入了类似的水印。我们在最近的版本中进一步详细介绍了针对图像、语音和文本模型的水印方法。

JASCO:Text-to-Music

生成式人工智能使人们能够以新的方式探索创造力,例如将文本提示转换为音乐片段。虽然现有的文本转音乐模型(如MusicGen)主要依靠文本输入来生成音乐,但我们的新模型“用于时间控制文本转音乐生成的元联合音频和符号条件”(JASCO)能够接受各种条件输入,例如特定的和弦或节拍,以改善对生成的音乐输出的控制。具体来说,我们将信息瓶颈层与时间模糊结合使用,以提取与特定控制相关的信息。这允许在同一个文本转音乐生成模型中同时结合符号和基于音频的条件。

结果表明,JASCO 在生成质量方面与评估基线相当,同时允许对生成的音乐进行更好、更灵活的控制。

PRISM数据集

从多元化的人群中获取反馈对于提高 LLM 水平至关重要,但研究界对反馈过程的方法、领域和目标一直存在疑问。我们与外部合作伙伴合作解决这些问题,支持发布 PRISM 数据集,该数据集映射了来自 75 个国家/地区的 1,500 名多元化参与者的社会人口统计数据和偏好。该数据集将每个人的偏好和细粒度反馈映射到与 21 位不同 LLM 的 8,011 次实时对话中。

Meta 为我们的外部合作伙伴编制 PRISM 数据集提供了建议,重点关注以主观和多元文化观点为中心的对话,这些对话可能存在人际和跨文化分歧。我们的论文通过对话多样性、偏好多样性和福利结果三个案例研究证明了 PRISM 的实用性,表明哪些人设定了一致规范很重要。虽然我们希望这将成为社区资源,但我们也希望它能够激发人们更广泛地参与人工智能开发,并促进更具包容性的技术设计方法。

这篇关于Meta FAIR研究新成果:图像到文本、文本到音乐的生成模型,多标记预测模型以及AI生成语音检测技术的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!