adam专题

【Keras】keras model.compile(loss='目标函数 ', optimizer='adam', metrics=['accuracy'])

讲解了各种loss https://www.cnblogs.com/smuxiaolei/p/8662177.html

SGD,Momentum,AdaGrad,RMSProp,Adam等优化算法发展历程

各种优化算法层出不穷,看的眼花缭乱,如果不能理清楚其中他们的关系及发展历程,必然会记得很混乱及模糊 最开始做神经网络的时候大家更新参数的时候都是把所有数据计算一遍,求所以数据的平均梯度再进行参数调节,后来觉得这样太慢了,干脆就计算一条数据就调节一次,这就叫随机梯度下降了(SGD),随机两字的由来是因为每条数据可能调节的方向都不一样,下降的过程会很震荡。 这都是两个极

Adam optimizer的原理

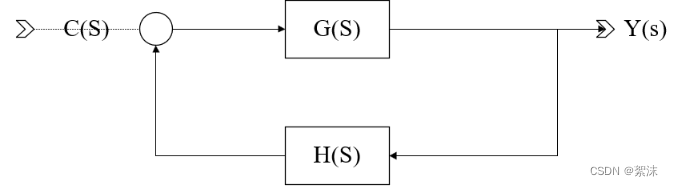

原文: https://builtin.com/machine-learning/adam-optimization 1. 原始SGD 2. 带冲量的SGD: vt: mementum(冲量) γ:momentum decay η:Learning rate 在之前保持的正确的方向上,加速收敛;冲出”坑“; 3. RMSProp E[gt^2]: 梯度平方的

用c++用4个凸函数(觉得啥好用用啥)去测试adam,rmsprop,adagrad算法的性能(谁先找到最优点)

为了测试 Adam、RMSProp 和 Adagrad 算法的性能,你可以使用四个凸函数进行实验。以下是一些常用的凸函数示例: Rosenbrock 函数: Booth 函数: Himmelblau 函数: Beale 函数: 你可以选择其中一个或多个函数来测试算法的性能。对于每个函数,你可以使用不同的初始点,并应用 Adam、RMSProp 和 Adagrad 算法来寻找最优

Quora 首席执行官亚当·德安杰洛 (Adam D’Angelo) 谈论了 AI、聊天机器人平台 Poe,以及 OpenAI 为什么不是竞争对手

每周跟踪AI热点新闻动向和震撼发展 想要探索生成式人工智能的前沿进展吗?订阅我们的简报,深入解析最新的技术突破、实际应用案例和未来的趋势。与全球数同行一同,从行业内部的深度分析和实用指南中受益。不要错过这个机会,成为AI领域的领跑者。点击订阅,与未来同行! 订阅:https://rengongzhineng.io/ 去年 11 月,亚当·德安杰洛 (Adam D'Angelo) 置身于科

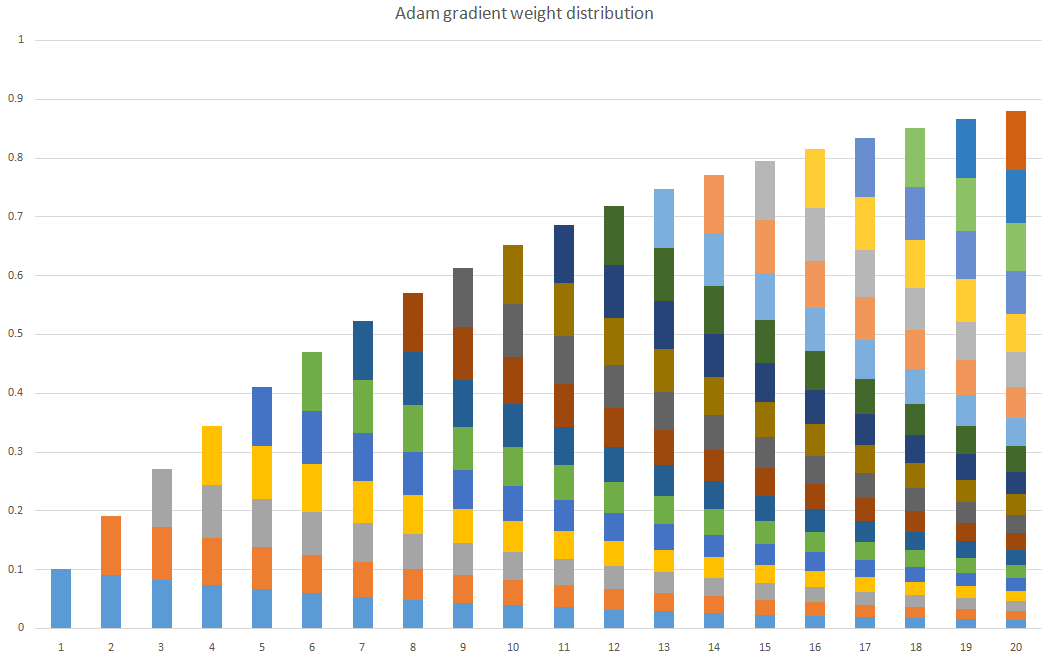

Pytorch常用的函数(八)常见优化器SGD,Adagrad,RMSprop,Adam,AdamW总结

Pytorch常用的函数(八)常见优化器SGD,Adagrad,RMSprop,Adam,AdamW总结 在深度学习中,优化器的目标是通过调整模型的参数,最小化(或最大化)一个损失函数。 优化器使用梯度下降等迭代方法来更新模型的参数,以使损失函数达到最优或接近最优。 如下图,优化算法可分为一阶算法和二阶算法,常用的是一阶算法,今天主要介绍下一阶优化相关的优化器。 1 SGD优化

[机器学习] 优化器Adam

参考:pytorch优化器详解:Adam_拿铁大侠的博客-CSDN博客_pytorch中adam优化器参数 从Momentum、RMSprop到Adam - 简书 理解滑动平均(exponential moving average) - wuliytTaotao - 博客园 目录 一、Adam

PyTorch的十个优化器(SGD,ASGD,Rprop,Adagrad,Adadelta,RMSprop,Adam(AMSGrad),Adamax,SparseAdam,LBFGS)

本文截取自《PyTorch 模型训练实用教程》,获取全文pdf请点击:https://github.com/tensor-yu/PyTorch_Tutorial 文章目录 1 torch.optim.SGD 2 torch.optim.ASGD 3 torch.optim.Rprop 4 torch.optim.Adagrad 5 torch.optim.Adadelta 6 torch.op

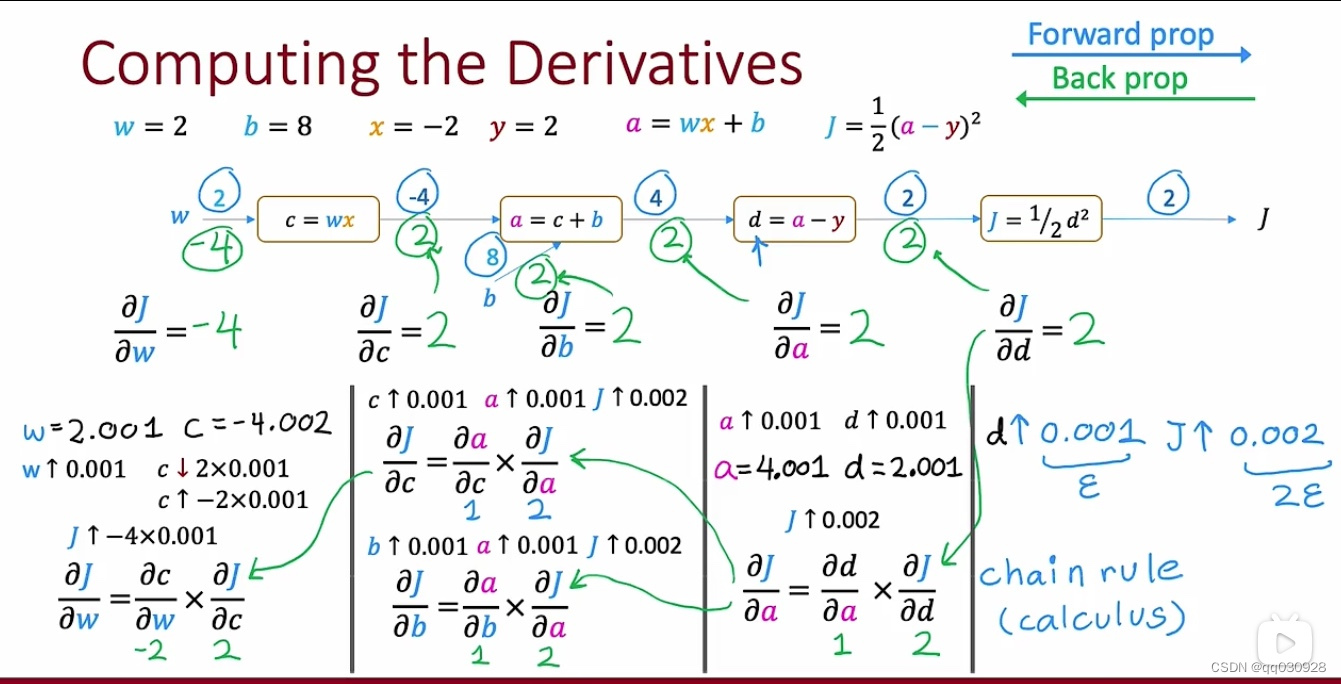

深度学习 Lecture 4 Adam算法、全连接层与卷积层的区别、图计算和反向传播

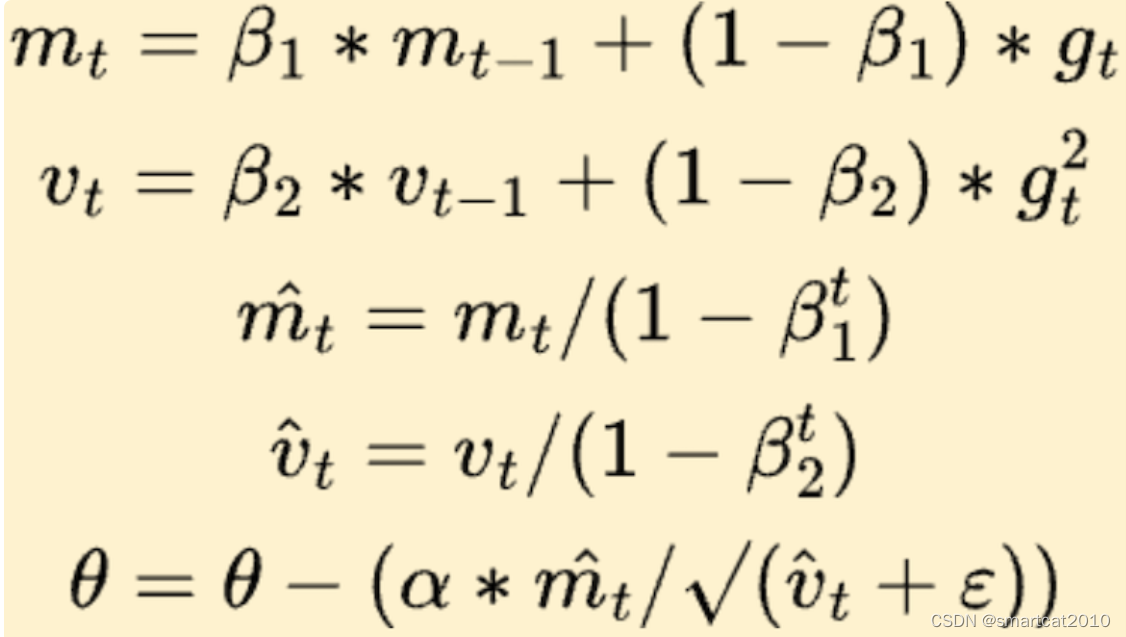

一、Adam算法(自适应矩估计) 全名:Adapative Moment Estimation 目的:最小化代价函数(和梯度下降一样) 本质:根据更新学习率后的情况自动更新学习率的值(可能是自动增大,也可能是自动变小) 它在全局不止有一个学习率,就是说每个式子的学习率都有可能有所不同。 优点:对学习率的选择更具有鲁棒性,通常比梯度下降还要快 注意:在代码中设置它的时候需要标注一个初始的

sgd Momentum Vanilla SGD RMSprop adam等优化算法在寻找 简单logistic分类中的 的应用

参考博文 (4条消息) sgd Momentum Vanilla SGD RMSprop adam等优化算法在寻找函数最值的应用_tcuuuqladvvmm454的博客-CSDN博客 在这里随机选择一些数据 生成两类 核心代码如下: def __init__(self, loss,

sgd Momentum Vanilla SGD RMSprop adam等优化算法在寻找函数最值的应用

1\sgd q=q-a*gt a是学习率 gt是函数的梯度 也就是沿着梯度的反方向得到下降最快的,最快能找到函数的最值 2 Momentum 然后q=q-mt 3 RMSprop 4 Adam Adam[6] 可以认为是 RMSprop 和 Momentum 的结合。和 RMSprop 对二阶动量使用指数移动平均类似,Adam 中对一阶动量也是用指

转载的 损失函数MSE L1 优化函数ADAM SGD 优化算法等

如有侵权,请联系删除! pytorch框架中损失函数与优化器介绍: 目录 1. 损失函数: 1.1 nn.L1Loss 1.2 nn.SmoothL1Loss 1.3 nn.MSELoss 1.4 nn.BCELoss 1.5 nn.CrossEntropyLoss 1.6 nn.NLLLoss 1.7 nn.NLLLoss2d 2.优化器Optim 2.1 使用 2

Adagrad求sqrt SGD Momentum Adagrad Adam AdamW RMSProp LAMB Lion 推导

随机梯度下降(Stochastic Gradient Descent)SGD 经典的梯度下降法每次对模型参数更新时,需要遍历所有的训练数据。随机梯度下降法用单个训练样本的损失来近似平均损失。 θ t + 1 = θ t − η g t ( 公式 1 ) \theta_{t+1} = \theta_{t}-\eta g_t (公式1) θt+1=θt−ηgt(公式1) 小批量梯度下降法(

torch.optim.SGD 和 torch.optim.Adam的区别?

目录 torch.optim.SGD优点缺点适合的场景 torch.optim.Adam优点缺点适合的场景 Adam优化器和SGD(随机梯度下降)优化器是深度学习中常用的两种优化算法,它们在优化模型参数方面有一些区别。 torch.optim.SGD SGD优化器是基于随机梯度下降的算法,它以每个样本的梯度为基准来更新模型的参数。 优点 计算简单,对大规模数据集可扩展性强

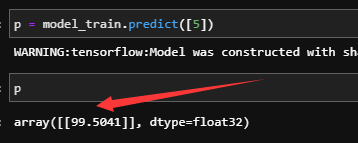

Pytorch-Adam算法解析

关注B站可以观看更多实战教学视频:肆十二-的个人空间-肆十二-个人主页-哔哩哔哩视频 (bilibili.com) Hi,兄弟们,这里是肆十二,今天我们来讨论一下深度学习中的Adam优化算法。 Adam算法解析 Adam算法是一种在深度学习中广泛使用的优化算法,它的名称来源于适应性矩估计(Adaptive Moment Estimation)。Adam算法结合了两种扩展式的随机梯度下降

自适应学习速率SGD优化方法比较(SGD,Adagrad,Adadelta,Adam,Adamax,Nadam)

深度学习最全优化方法总结比较(SGD,Adagrad,Adadelta,Adam,Adamax,Nadam) 前言 (标题不能再中二了)本文仅对一些常见的优化方法进行直观介绍和简单的比较,各种优化方法的详细内容及公式只好去认真啃论文了,在此我就不赘述了。 SGD 此处的SGD指mini-batch gradient descent,关于batch gradient desc

【深度学习系列】——梯度下降算法的可视化解释(动量,AdaGrad,RMSProp,Adam)!

这是深度学习系列的第二篇文章,欢迎关注原创公众号 【计算机视觉联盟】,第一时间阅读我的原创!回复 【西瓜书手推笔记】 还可获取我的机器学习纯手推笔记! 直达笔记地址:机器学习手推笔记(GitHub地址) 深度学习系列 【深度学习系列】——深度学习简介 笔记预览 在这篇文章中,由于有大量的资源可以解释梯度下降,因此,我想在视觉上引导您了解每种方法的工作原理。借助我构

深度学习记录--Adam optimization algorithm

Adam优化算法 momentum和RMSprop的结合 初始化参数: 先进行momentum过程: 然后进行RMSprop过程: 接着进行偏差修正: , , 最后更新权重: 超参数的设置 一般地,学习率需要经过多次调试之后才可得到 其他超参数一般设置为:

【深度学习系列】——梯度下降算法的可视化解释(动量,AdaGrad,RMSProp,Adam)!

这是深度学习系列的第二篇文章,欢迎关注原创公众号 【计算机视觉联盟】,第一时间阅读我的原创!回复 【西瓜书手推笔记】 还可获取我的机器学习纯手推笔记! 直达笔记地址:机器学习手推笔记(GitHub地址) 深度学习系列 【深度学习系列】——深度学习简介 笔记预览 在这篇文章中,由于有大量的资源可以解释梯度下降,因此,我想在视觉上引导您了解每种方法的工作原理。借助我构

深度学习笔记(六)——网络优化(2):参数更新优化器SGD、SGDM、AdaGrad、RMSProp、Adam

文中程序以Tensorflow-2.6.0为例 部分概念包含笔者个人理解,如有遗漏或错误,欢迎评论或私信指正。 截图和程序部分引用自北京大学机器学习公开课 在前面的博文中已经学习了构建神经网络的基础需求,搭建了一个简单的双层网络结构来实现数据的分类。并且了解了激活函数和损失函数在神经网络中发挥的重要用途,其中,激活函数优化了神经元的输出能力,损失函数优化了反向传播时参数更新的趋势。 我们知

tensorflow2中自定义损失、传递loss函数字典/compile(optimizer=Adam(lr = lr), loss= lambda y_true, y_pred: y_pred)理解

在阅读yolov3代码的时候有下面这样一样代码: model.compile(optimizer=Adam(lr = lr), loss={'yolo_loss': lambda y_true, y_pred: y_pred}),这行代码在网上有人进行解释过,但是都是看的云里雾里,一般使用compile的时候我们都是直接传递的一个函数对象,这里竟然传递的是一个字典,对此很是不解。 经过大量的

adam优化器和动量

原始的SGD 加上动量(惯性,每一次更新根据前面所有结果,使结果更快收敛) AdaGrad 与SGD的核心区别在于计算更新步长时,增加了分母:梯度平方累积和的平方根。此项能够累积各个参数 的历史梯度平方,频繁更新的梯度,则累积的分母项逐渐偏大,那么更新的步长(stepsize)相对就会变小,而稀疏的梯度,则导致累积的分母项中对应值比较小,那么更新的步长则相对比较大。 A

解决:ImportError: cannot import name ‘Adam‘ from ‘keras.optimizers‘

解决:ImportError: cannot import name ‘Adam‘ from ‘keras.optimizers‘ 背景 在使用之前的代码时,报错: from keras.optimizers import Adam ImportError: cannot import name ‘Adam’ 报错问题 from keras.optimizers import Ada

SGD-adam-adamw

title: SGD && Adam && Adamw的C语言实现以及对比总结 date: 2023-03-08 17:08:50 tags: SGD && Adam && Adamw的C语言实现以及对比总结 文章目录 title: SGD && Adam && Adamw的C语言实现以及对比总结 date: 2023-03-08 17:08:50 tags: SGD && Adam

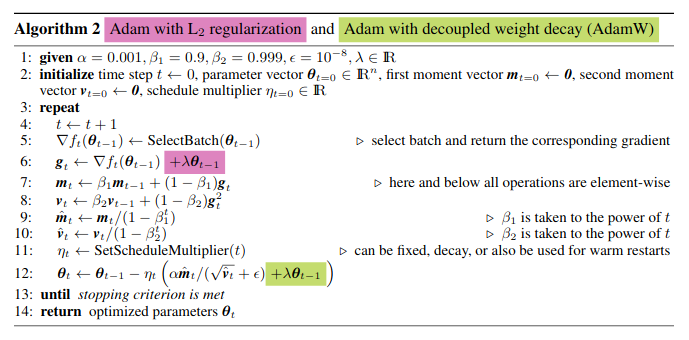

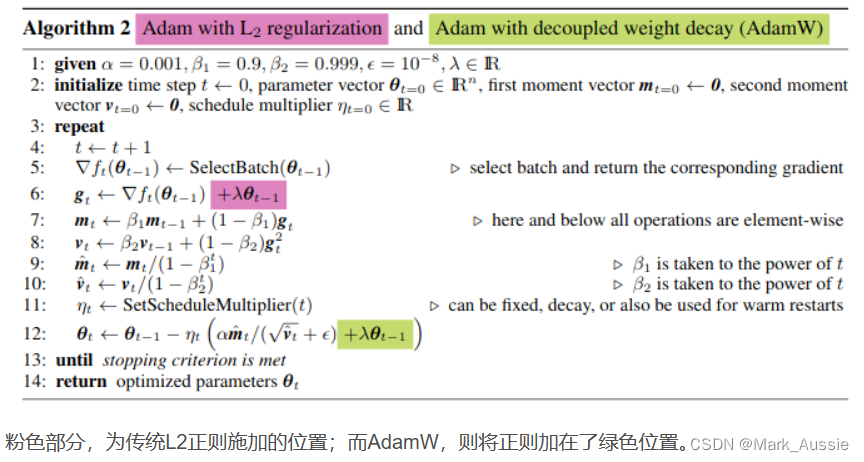

Adam和AdamW区别

AdamW 是 Adam 优化器加上 L2 正则,这样可限制参数值不可太大,之前的 L2 正则是直接加在损失函数上,Loss = Loss + 1/2 * λ ∑θ^2;Adamw 即 Adam + weight decate ,效果与 Adam + L2 正则化相同,但是计算效率更高,之前的 L2 正则化需要在 loss 中加入正则项再算梯度,反向传播,AdamW 直接将正则项的

![【Keras】keras model.compile(loss='目标函数 ', optimizer='adam', metrics=['accuracy'])](/front/images/it_default.jpg)