本文主要是介绍Adam和AdamW区别,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

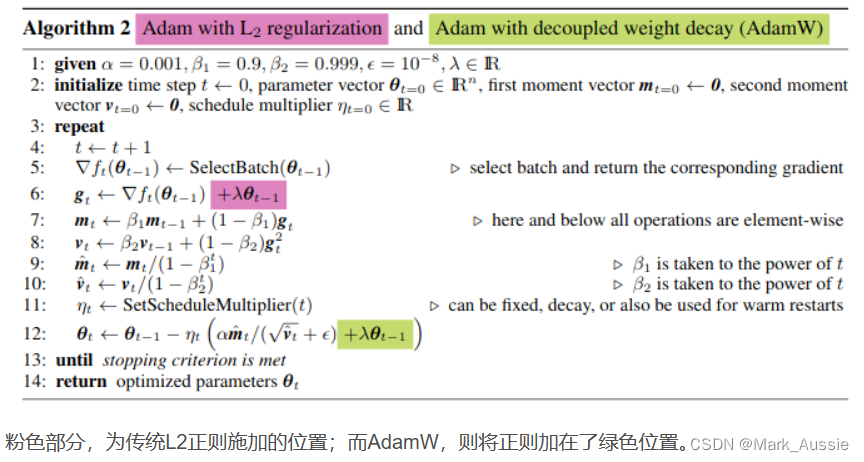

AdamW 是 Adam 优化器加上 L2 正则,这样可限制参数值不可太大,之前的 L2 正则是直接加在损失函数上,Loss = Loss + 1/2 * λ ∑θ^2;Adamw 即 Adam + weight decate ,效果与 Adam + L2 正则化相同,但是计算效率更高,之前的 L2 正则化需要在 loss 中加入正则项再算梯度,反向传播,AdamW 直接将正则项的梯度加入反向传播的公式中,减少在 loss 中加正则项这一步。

参考:

Adam与AdamW_adam和adamw_失之毫厘,差之千里的博客-CSDN博客

这篇关于Adam和AdamW区别的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!