强化专题

7. 深度强化学习:智能体的学习与决策

引言 深度强化学习结合了强化学习与深度学习的优势,通过智能体与环境的交互,使得智能体能够学习最优的决策策略。深度强化学习在自动驾驶、游戏AI、机器人控制等领域表现出色,推动了人工智能的快速发展。本篇博文将深入探讨深度强化学习的基本框架、经典算法(如DQN、策略梯度法),以及其在实际应用中的成功案例。 1. 强化学习的基本框架 强化学习是机器学习的一个分支,专注于智能体在与环境的交互过程中,学

强化网络安全:通过802.1X协议保障远程接入设备安全认证

随着远程办公和移动设备的普及,企业网络面临着前所未有的安全挑战。为了确保网络的安全性,同时提供无缝的用户体验,我们的 ASP 身份认证平台引入了先进的 802.1X 认证协议,确保只有经过认证的设备才能接入您的网络。本文档将详细介绍我们的平台如何通过 802.1X 协议实现高效、安全的远程接入认证。 产品亮点 1. 无缝集成 我们的 ASP 身份认证平台支持无缝集成到现有的网络基础设施中

强化学习和监督学习的一些区别

强化学习要求agent去探索环境,然后对状态进行evaluate,在每一个状态下agent可以选择多种action,每次选择的依据可以是贪婪或者softmax等,但是得到的reward是无法表明当前的选择是正确的还是错误的,得到的只是一个score,监督学习的labels可以给agent简洁明了的correct or wrong,并且在agent 在对环境充分的探索前即在每一种状态下选择的每个ac

强化学习深入学习(一):价值函数和贝尔曼方程

文章目录 0. 引言1. 回报(Return)2. 价值函数(Value Function)3. 贝尔曼期望方程(Bellman Expectation Equation)4. 贝尔曼最优方程(Bellman Optimality Equation)总结 0. 引言 强化学习(Reinforcement Learning, RL)是一种机器学习方法,通过与环境的交互来学习如何

数学建模强化宝典(10)多元线性回归模型

一、介绍 多元线性回归模型(Multiple Linear Regression Model)是一种用于分析多个自变量(解释变量、预测变量)与单个因变量(响应变量、被预测变量)之间线性关系的统计模型。这种模型假设因变量的变化可以通过自变量的线性组合来近似地表示,同时考虑了一个误差项来捕捉模型未能解释的变异性。 二、模型形式 多元线性回归模型的一般形式可以表示为: Y=β

如何通过Kimi强化论文写作中的数据分析?

在学术研究领域,数据分析是验证假设、发现新知识和撰写高质量论文的关键环节。Kimi,作为一款先进的人工智能助手,能够在整个论文写作过程中提供支持,从文献综述到数据分析,再到最终的论文修订。本文将详细介绍如何将Kimi的数据分析功能融入论文写作的各个阶段,以提高研究的准确性和论文的学术质量。 Kimi在论文写作中的作用 1. Kimi能够快速扫描和分析大量文献,提取关键信息,帮助研究者构建全面且

擅长领域python ,深度强化学习,人工智能,计算机等,可咨询

Python 深度学习 机器学,计算机视觉,自然语言处理,模型创新,算法改进,代码跑通,配置环境,可提供项目答疑和指导等服务,可做英文项目. 人工智能本硕接python代做,强化学习,深度学习,机器学习程序代写,环境调试,代码调通,模型优化,模型修改,数据处理等,项目主攻:Pytorch, Tensorflow, Yolo, Unet, DNN,CNN, GAN, Transformer,训练模

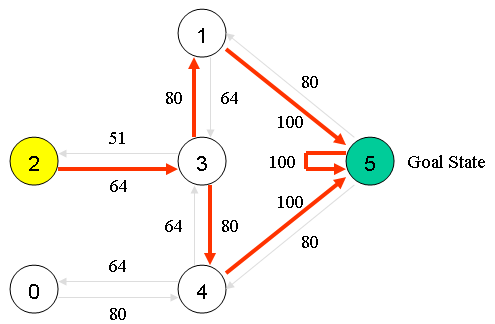

强化学习实践(二):Dynamic Programming(Value \ Policy Iteration)

强化学习实践(二):Dynamic Programming(Value \ Policy Iteration) 伪代码Value IterationPolicy IterationTruncated Policy Iteration 代码项目地址 伪代码 具体的理解可以看理论学习篇,以及代码中的注释,以及赵老师原著 Value Iteration Policy Itera

强化学习实践(一):Model Based 环境准备

强化学习实践(一):Model Based 环境准备 代码项目地址 代码 这里是Model Based的环境构建,原型是赵老师课上的Grid World import numpy as npfrom typing import Tuplefrom environment.utils import Utilsfrom environment.enums import Rewa

强化学习实操入门随笔

碎碎念:经过思考,打通底层逻辑,我认为未来ai的功能是在沟通领域代替人,未来人-人模式(媒介是死的语言,比如看古人留下的文字、聊天的暂时不在)会变成人-ai替身-人模式(符合本人想法的“预测个性化语言”)。由于沟通越来越虚拟化和低成本,以及各种模态(比如视频链接)的数字媒介比见面聊天效率更高,所以制作人的各种在虚拟数字空间的“替身”(模仿聊天、总结信息等秘书类事务)是很可能出现的重点问题。

强化学习-优化策略算法(DPO和PPO)

DPO(Direct Preference Optimization)和 PPO(Proximal Policy Optimization)虽然都是用于优化策略的算法,但它们在理论基础、优化目标和应用场景上存在显著区别。 优化目标 • PPO: • PPO 是一种基于策略梯度的优化算法,其目标是通过最大化累积奖励来优化策略。PPO 通过限制策略更新的幅度(剪切损失函数),确保训练过程中的策略更

数学建模强化宝典(6)0-1规划

前言 0-1规划是决策变量仅取值0或1的一类特殊的整数规划。这种规划的决策变量称为0-1变量或二进制变量,因为一个非负整数都可以用二进制记数法用若干个0-1变量表示。在处理经济管理和运筹学中的某些规划问题时,若决策变量采用0-1变量,可把本来需要分别各种情况加以讨论的问题统一在一个问题中讨论。以下是关于0-1规划的详细解析: 一、定义与特点 定义:0-1规划是整数规划的

深度强化学习算法(七)(附带MATLAB程序)

深度强化学习(Deep Reinforcement Learning, DRL)结合了深度学习和强化学习的优点,能够处理具有高维状态和动作空间的复杂任务。它的核心思想是利用深度神经网络来逼近强化学习中的策略函数和价值函数,从而提高学习能力和决策效率。 一、关键算法分类 1.1 深度 Q 网络(Deep Q-Network, DQN) 概念:将 Q 学习(一个值函数方法)与深度神经网络结合,用

强化学习与深度学习的结合

强化学习与深度学习的结合 目录 一、引言 二、强化学习基础 三、深度学习基础 四、强化学习与深度学习的结合实例 五、总结 一、引言 随着人工智能技术的不断发展,强化学习已经成为了计算机科学领域的一个重要分支。而深度学习作为一种强大的机器学习方法,已经在图像识别、语音识别等领域取得了显著的成果。本文将探讨强化学习与深度学习的结合,以及它们在实际应用中的优势和挑战。 二

文章复现,代码复现,深度学习,强化学习

文章复现,代码复现,深度学习,强化学习 机器学习,文章复现,代码复现,代码修改,模型预 测,机器学习模型预测,强化学习python 随机森林、随机森林回归、支持向量机svm,逻辑回 归,Xgboost等分类、回归建模分析,shap,偏依赖 图,特征选择,lasso特征选择等等#机器学习,文 章复现,代码复现,代码修改,模型预测,机器学习 模型预测,强化学习python 随机森林、随机森林回归、支持

[图解]强化自测题解析-总纲(一)01 这属于什么工作流

1 00:00:00,680 --> 00:00:05,350 今天我们开始来解析一些强化自测题 1 00:00:01,100 --> 00:00:03,980 因为现在强化自测题本身 2 00:00:05,010 --> 00:00:06,720 我们出得已经比较多了 3 00:00:07,700 --> 00:00:12,570 自测题是用来测试我们的开发人员 4 00:00:12,7

数学建模强化宝典(4)fminunc

一、介绍 fminunc 是 MATLAB 中用于求解无约束多变量非线性优化问题的函数。它尝试找到给定函数的最小值点,不需要用户提供函数的导数信息(尽管如果提供了导数信息,算法通常会更快更准确地收敛)。fminunc 使用的是拟牛顿法(Quasi-Newton methods),特别是 BFGS 算法,这是处理无约束优化问题的一种有效方法。 二、函数语法 fminunc 的基本语法

数学建模强化宝典(1)级比检验

前言 级比检验是灰色预测中一个重要的步骤,主要用于判断原始数据是否满足准指数规律,从而确定数据是否适合进行灰色预测分析。 一、级比检验的定义 级比检验是通过计算原始数据与其前一期数据的比值(即级比),并对级比进行统计分析(如计算平均值、方差等),来判断数据是否满足准指数规律的一种方法。在灰色预测中,特别是使用GM(1,1)模型时,级比检验是不可或缺的步骤。

数学建模强化宝典(2)linprog

一、介绍 linprog 是 MATLAB 中用于解决线性规划问题的函数。线性规划是一种优化方法,它尝试在满足一组线性等式或不等式约束的条件下,找到一个线性目标函数的最大值或最小值。linprog 函数适用于求解形如以下问题的线性规划问题: minimizecTx subject toAx≤b Aeqx=beq lb≤x≤ub 其中: c 是目标函数的系数向量。x 是优化变量向量。A

[ComfyUI]Flux:黑神话-水墨悟空,增强写实和水墨插画风格强化

大家好我是极客菌!!! ComfyUI是一款功能强大的AI图像编辑软件,以其便捷的操作和丰富的功能,深受广大艺术爱好者和专业人士的喜爱。而Flux,一款基于深度学习的图像生成模型,以其强大的图像生成能力和个性化风格迁移能力,在艺术创作领域掀起了一场革命。 水墨融合风格模型简介 今天介绍一款国产Flux LORA模型:水墨融合风格效果强化flux.1,这是一款专注于中国画水墨融合风格

SAT数学强化练习题及解析

关于SAT数学同学们应该定期进行模拟练习,全面的考题使学生了解所有的题型分布,大量的练习为学生不断提高解题技巧和速度提供了保障。下面我们来看一道SAT数学强化练习题。 Read the following SAT test question, then click on a button to select your answer. Note: Figure not drawn t

深度强化学习算法(五)(附带MATLAB程序)

深度强化学习(Deep Reinforcement Learning, DRL)结合了深度学习和强化学习的优点,能够处理具有高维状态和动作空间的复杂任务。它的核心思想是利用深度神经网络来逼近强化学习中的策略函数和价值函数,从而提高学习能力和决策效率。 一、关键算法分类 1.1 深度 Q 网络(Deep Q-Network, DQN) 概念:将 Q 学习(一个值函数方法)与深度神经网络结合,用

强化学习——码住一些博客

对强化学习算法的学习和理解 ICLR 2024 多智能体强化学习论文汇总 多智能体强化学习综述 如何选择深度强化学习算法?MuZero/SAC/PPO/TD3/DDPG/DQN/等(2021-04) 深度强化学习调参技巧:以D3QN、TD3、PPO、SAC算法为例 Reinforcement learning: decreasing loss without increasing reward

小琳AI课堂:DQN强化神经

大家好,这里是小琳AI课堂!今天我们来聊聊一个超级酷炫的算法——DQN(深度Q网络)!🤖 它可是深度学习和强化学习的完美结合,就像把两股超级英雄的力量合二为一,解决了那些高维输入空间的决策问题。这个算法是由DeepMind公司开发的,2015年一提出就震惊了整个AI界!🌟 先解释一下DQN是怎么工作的。🎨 DQN的基本原理: 强化学习背景:想象一下,有个小机器人(智能体)在一个充满挑战的环

强化学习第十章:Actor-Critic 方法

强化学习第十章:Actor-Critic 方法 什么叫Actor-Critic最简单的AC,QAC(Q Actor-Critic)优势函数的AC,A2C(Advantage Actor-Critic)异策略AC,Off-Policy AC确定性策略梯度,DPG总结参考资料 什么叫Actor-Critic 一句话,策略由动作来执行,执行者叫Actor,评价执行好坏的叫Critic(

![[图解]强化自测题解析-总纲(一)01 这属于什么工作流](https://i-blog.csdnimg.cn/direct/3eabf380012d48d8bcbbc994a2df4721.png)

![[ComfyUI]Flux:黑神话-水墨悟空,增强写实和水墨插画风格强化](https://img-blog.csdnimg.cn/direct/4a2d3a791f754642af3f0383c95ee9c7.png#pic_center)