phi专题

一键部署Phi 3.5 mini+vision!多模态阅读基准数据集MRR-Benchmark上线,含550个问答对

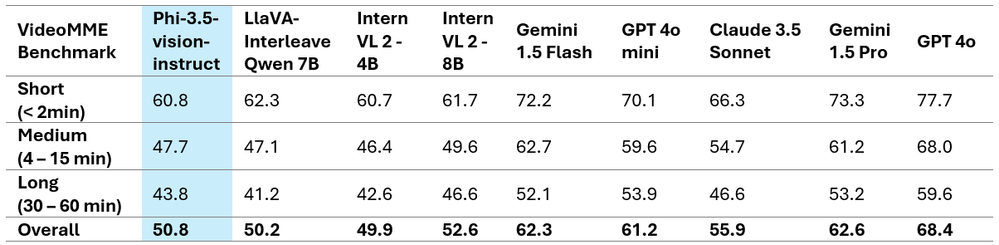

小模型又又又卷起来了!微软开源三连发!一口气发布了 Phi 3.5 针对不同任务的 3 个模型,并在多个基准上超越了其他同类模型。 其中 Phi-3.5-mini-instruct 专为内存或算力受限的设备推出,小参数也能展现出强大的推理能力,代码生成、多语言理解等任务信手拈来。而 Phi-3.5-vision-instruct 则是多模态领域的翘楚,能同时处理文本和视觉信息,图像理解、视频摘要

微软发布Phi-3.5 SLM,附免费申请试用

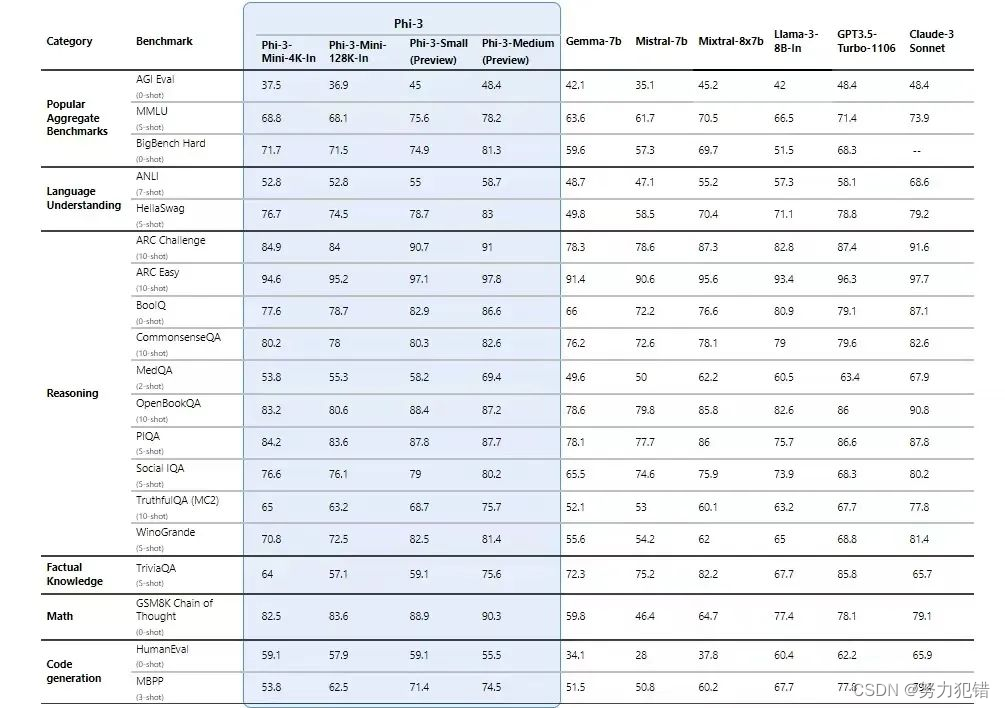

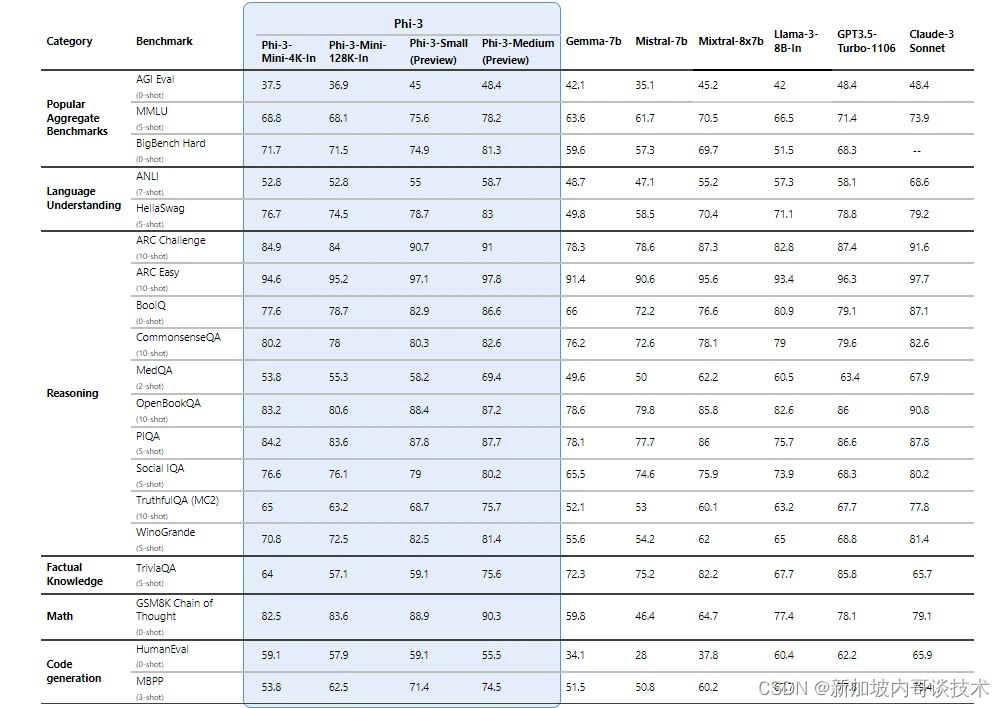

Phi-3 模型系列是Microsoft 小型语言模型 (SLM) 系列中的最新产品。 它们旨在具有高性能和高性价比,在语言、推理、编码和数学等各种基准测试中的表现均优于同类和更大规模的模型。Phi-3 模型的推出扩大了 Azure 客户的高质量模型选择范围,为他们编写和构建生成式 AI 应用程序时提供了更多实用的选择。 参考链接:微软 Azure AI 、Phi-3等免费试用申请 自 20

OpenCSG全网首发!Phi-3.5 Mini Instruct全参微调中文版

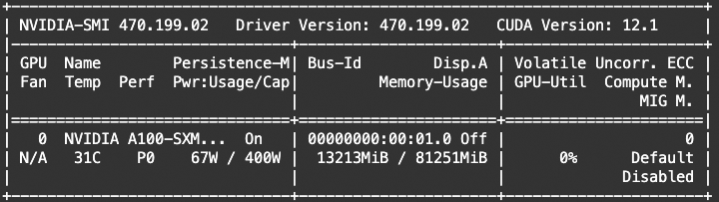

前沿科技速递🚀 🎉 震撼发布!OpenCSG正式推出全参数微调的Phi-3.5-mini-instruct中文版模型! 🔍 本次发布的Phi-3.5-mini-instruct中文版模型基于最新的Phi-3.5架构,经过全参数微调,专为中文场景优化而设计。我们采用了先进的训练技术和大规模数据集,确保模型在中文自然语言处理任务中的卓越表现。训练过程使用了多台NVIDIA A800显卡,显

微软发布 Phi-3.5 系列模型,涵盖端侧、多模态、MOE;字节 Seed-ASR:自动识别多语言丨 RTE 开发者日报

开发者朋友们大家好: 这里是 「RTE 开发者日报」 ,每天和大家一起看新闻、聊八卦。我们的社区编辑团队会整理分享 RTE(Real-Time Engagement) 领域内「有话题的 新闻 」、「有态度的 观点 」、「有意思的 数据 」、「有思考的 文章 」、「有看点的 会议 」,但内容仅代表编辑的个人观点,欢迎大家留言、跟帖、讨论。 本期编辑:@SSN,@鲍勃 01 有话题的新闻

微软发布功能强大的全新 Phi-3.5 机型,击败谷歌、OpenAI 等公司

微软并没有因为与 OpenAI 的合作而满足于其在人工智能领域的成功。 相反,这家因总部位于华盛顿州而被称为雷德蒙德(Redmond)的公司今天发布了其不断发展的语言/多模态人工智能 Phi 系列中的 3 个新模型。这三个模型分别针对基本/快速推理、更强大的推理和视觉(图像和视频分析)任务而设计。 这三个模型都允许开发者在Hugging Face上下载、使用和微调,并采用微软的MIT许可,允许

【转】【关于 A^x = A^(x % Phi(C) + Phi(C)) (mod C) 的若干证明】【指数循环节】

【关于 A^x = A^(x % Phi(C) + Phi(C)) (mod C) 的若干证明】【指数循环节】 以下内容全部原创,转载请注明作者 : AekdyCoin 以及本文地址 曾经看过如下一个公式: 以上的公式如果第一次见到,难免有不少疑惑: 为什么可以这么写?限制条件为什么是x >= Phi(C),这个公式为什么正确? 今天突发奇想,在纸上YY以后得到了以下证明

使用Ollama+OpenWebUI部署和使用Phi-3微软AI大模型完整指南

🏡作者主页: 点击! 🤖AI大模型部署与应用专栏:点击! ⏰️创作时间:2024年6月6日23点50分 🀄️文章质量:96分 欢迎来到Phi-3模型的奇妙世界!Phi-3是由微软 AI研究院开发的一系列小型语言模型,它们以小巧的体型、强大的性能和开源的特点,在自然语言处理领域掀起了革命性的浪潮。 本指南将带领您一步步地使用Ollama和OpenWebUI部署和使用

[HDCTF 2023]Normal_Rsa(e,phi不互素)

题目: from Crypto.Util.number import *m=bytes_to_long(b'xxxxxx')p=getPrime(256)q=getPrime(256)e=74n=p*qc=pow(m,e,n)print("p=",p)print("q=",q)print("c=",c)#p= 860535829173863434225671747640404

通过DirectML和ONNXRuntime运行Phi-3模型

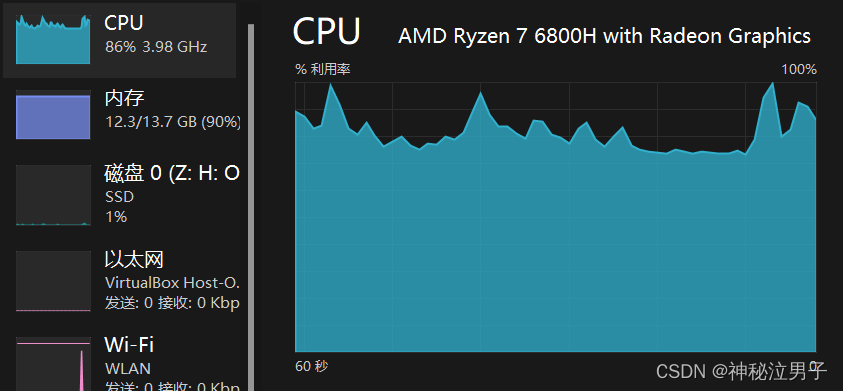

更多精彩内容,欢迎关注我的公众号“ONE生产力”! 上篇我们讲到通过Intel Core Ultra系列处理器内置的NPU加速运行Phi-3模型,有朋友评论说他没有Intel处理器是否有什么办法加速Phi-3模型。通常,使用GPU特别是NVIDA的GPU加速AI模型是最佳的方法,但这年头英伟达的显卡不是一般贵,很多朋友苦于囊中羞涩,还在使用核显中。今天,我们介绍一种使用核显通过DirectML和

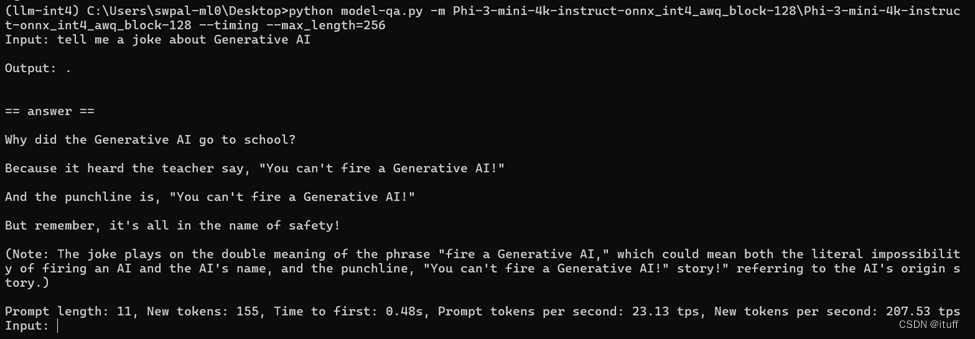

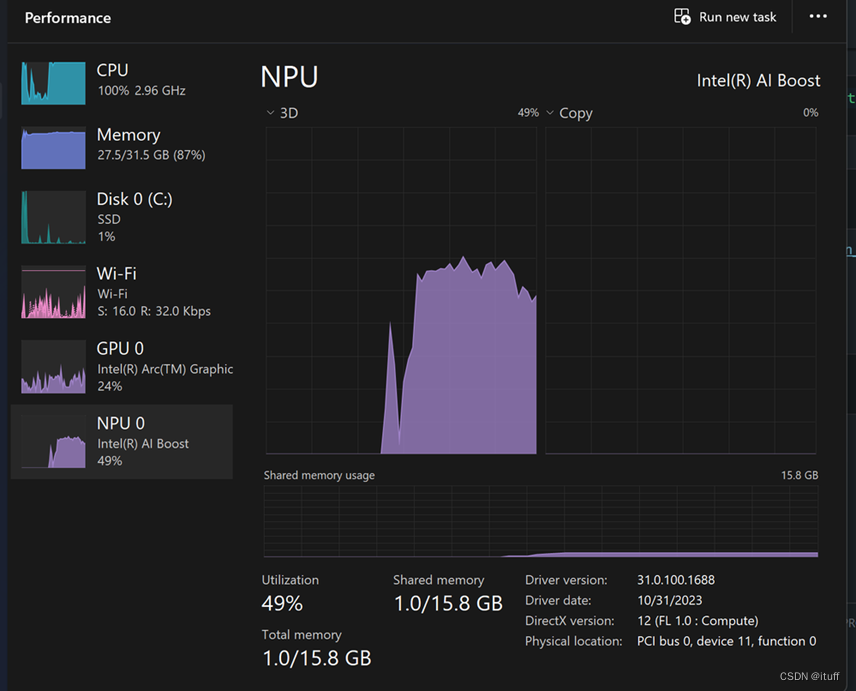

在“AI PC”中使用NPU运行 Phi-3-mini

欢迎关注我的公众号“ONE生产力”,获取更多AI、云计算资讯分享! 前段时间,我做了一系列微软Phi-3-mini小语言模型的教程,很多朋友参考教程进行了实践,其中有一个朋友反馈说模型token推理很慢,没有答道我说的可用程度。我询问了他的硬件配置,他说是才买的联想“AI PC”,配备了Intel Core Ultra 7处理器。这配置可比我用的7840HS强多了,但为何运行效果不佳呢?因为没有

微软开源多模态大模型Phi-3-vision,微调实战来了

节前,我们组织了一场算法岗技术&面试讨论会,邀请了一些互联网大厂朋友、今年参加社招和校招面试的同学。 针对大模型& AIGC 技术趋势、大模型& AIGC 落地项目经验分享、新手如何入门算法岗、该如何准备面试攻略、面试常考点等热门话题进行了深入的讨论。 总结链接如下: 《AIGC 面试宝典》(2024版) 正式发布! 喜欢记得点赞、收藏、关注。更多技术交流&面经学习,可以文末加入我们。

lightOj 1370 Bi-shoe and Phi-shoe

题意: 去买bamboo,bamboo的长度是 它的得分小的且与得分互素的数的个数, 如得分为9的bamboo, 小于9并与9互素的有1,2,4,5,7,8共6个,故它的长度为6;每位同学有个幸运数字,需要给每个同学买的bamboo的长度必须大于等于这个幸运数字,bamboo的价格一个单位长度为1xukha,求购买的最小的价格。 分析: 关于欧拉函数的题目。 首先先知道一个素数的欧拉函数的值等于这

本地使用 Ollama 驱动 Llama 3,Phi-3 构建智能代理(附代码)

本文介绍如何使用langchain中的ollama库实现低参数Llama 3,Phi-3模型实现本地函数调用及结构化文本输出。 函数调用介绍 函数调用的一个很好的参考是名为 “Gorilla” 的论文,该论文探讨了函数调用的概念,并提供了一个函数调用排行榜。通过这个排行榜,我们可以了解哪些模型擅长函数调用。 例如,我们可以看到 Llama 3 70 亿参数模型在排行榜中位列第七,而 8 亿参

Microsoft 推出 Phi-3 系列紧凑型语言模型

本心、输入输出、结果 文章目录 Microsoft 推出 Phi-3 系列紧凑型语言模型前言Phi-3 基础参数模型对比突破性训练技术降低人工智能安全风险 Microsoft 推出 Phi-3 系列紧凑型语言模型 编辑 | 简简单单 Online zuozuo 地址 | https://blog.csdn.net/qq_15071263 如果觉得本文对你有帮

Phi-3-mini-4k-instruct 的功能测试

Model card 介绍 Phi-3-Mini-4K-Instruct 是一个 3.8B 参数、轻量级、最先进的开放模型,使用 Phi-3 数据集进行训练,其中包括合成数据和经过过滤的公开可用网站数据,重点是 高品质和推理密集的属性。 该型号属于 Phi-3 系列,Mini 版本有 4K 和 128K 两种变体,这是它可以支持的上下文长度(以令牌为单位)。 该模型经历了训练后过程,其中结

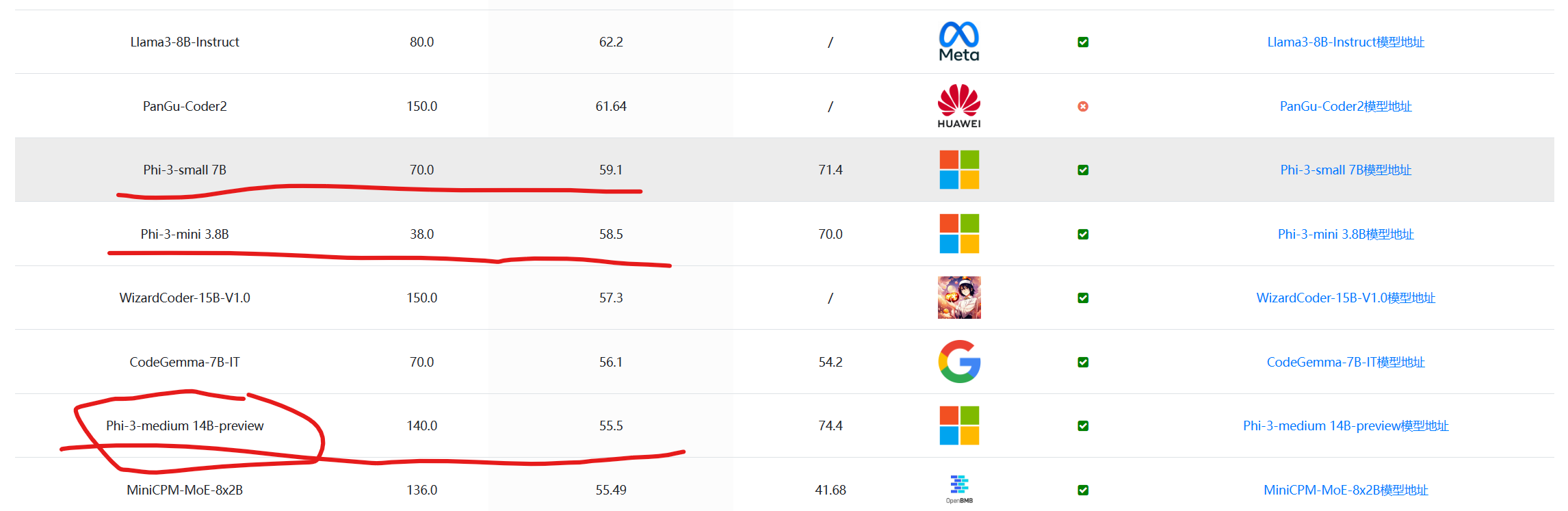

可以在手机端运行的大模型标杆:微软发布第三代Phi-3系列模型,评测结果超过同等参数规模水平,包含三个版本,最小38亿,最高140亿参数

本文原文来自DataLearnerAI官方网站: 可以在手机端运行的大模型标杆:微软发布第三代Phi-3系列模型,评测结果超过同等参数规模水平,包含三个版本,最小38亿,最高140亿参数 | 数据学习者官方网站(Datalearner)https://www.datalearner.com/blog/1051713851616894 Phi系列大语言模型是微软开源一个小规模参数的语言模型。

微软发布Phi-3 Mini,性能媲美GPT-3.5、Llama-3,可在手机端运行

前言 微软发布了最新版的Phi系列小型语言模型(SLM) - Phi-3。这个系列包括3个不同参数规模的版本:Phi-3 Mini (38亿参数)、Phi-3 Small (70亿参数)和Phi-3 Medium (140亿参数)。 Phi系列模型是微软研究团队开发的小规模参数语言模型。从第一代Phi-1到第二代Phi-2,参数规模都控制在30亿以内,但在各种评测中都取得了出色的成绩。第三代P

介绍Phi-3:微软重新定义小型语言模型(SLM)的可能性

每周跟踪AI热点新闻动向和震撼发展 想要探索生成式人工智能的前沿进展吗?订阅我们的简报,深入解析最新的技术突破、实际应用案例和未来的趋势。与全球数同行一同,从行业内部的深度分析和实用指南中受益。不要错过这个机会,成为AI领域的领跑者。点击订阅,与未来同行! 订阅:https://rengongzhineng.io/ 微软最近推出了名为Phi-3的开放式AI模型家族,这是一系列最具性价比的

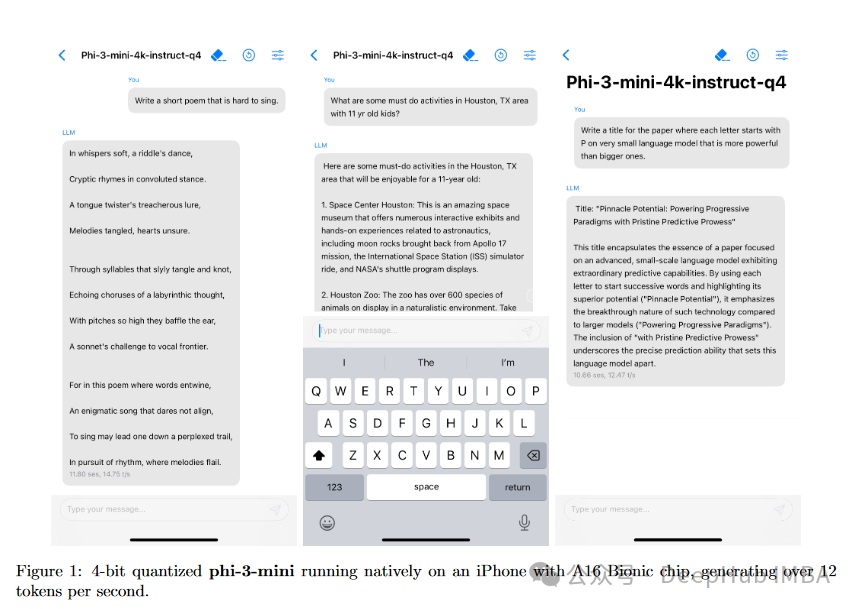

微软Phi-3,3.8亿参数能与Mixtral 8x7B和GPT-3.5相媲美,量化后还可直接在IPhone中运行

Phi-3系列 Phi-3是一系列先进的语言模型,专注于在保持足够紧凑以便在移动设备上部署的同时,实现高性能。Phi-3系列包括不同大小的模型: Phi-3-mini(38亿参数) - 该模型在3.3万亿个令牌上进行训练,设计得足够小,可以在现代智能手机上运行。尽管体积紧凑,它的性能却可与更大的模型如Mixtral 8x7B和GPT-3.5相媲美,例如在MMLU基准测试中达到69%,在MT-b

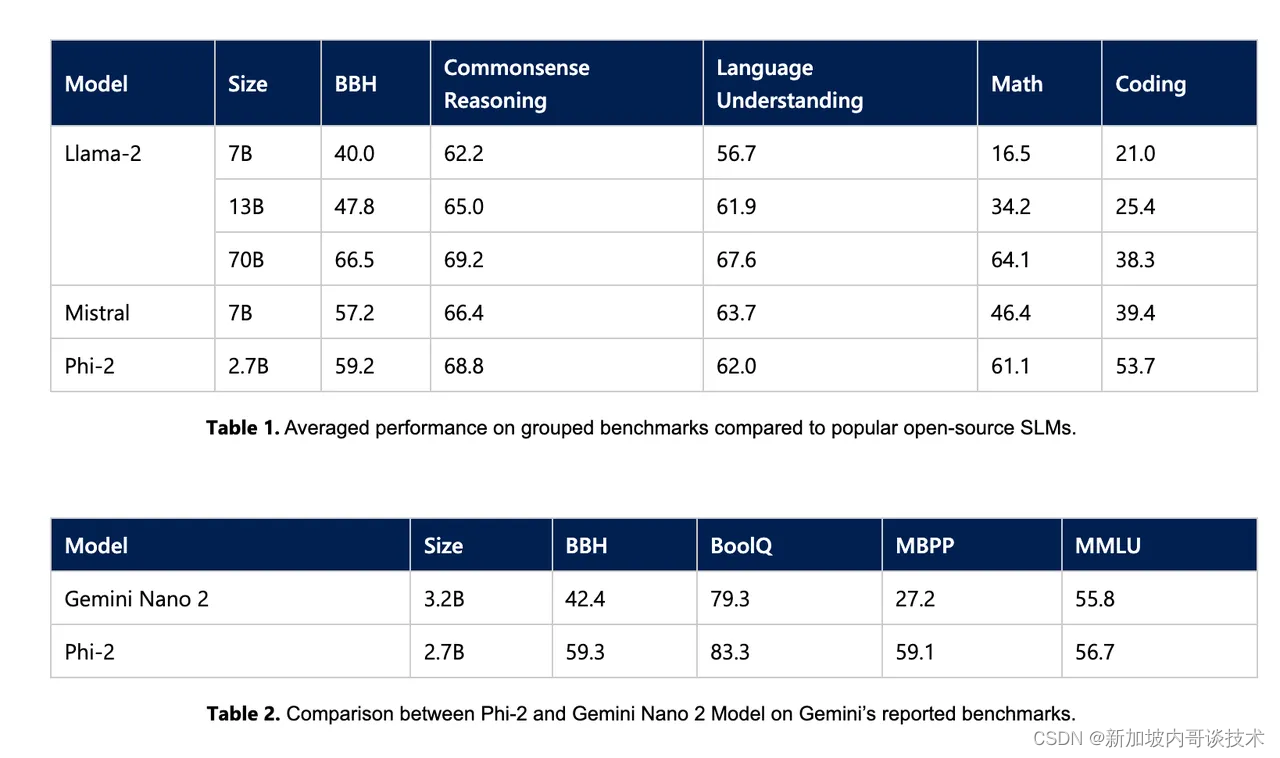

微软近日推出了Phi-2,这是一款小型语言模型,但其性能却十分强大

每周跟踪AI热点新闻动向和震撼发展 想要探索生成式人工智能的前沿进展吗?订阅我们的简报,深入解析最新的技术突破、实际应用案例和未来的趋势。与全球数同行一同,从行业内部的深度分析和实用指南中受益。不要错过这个机会,成为AI领域的领跑者。点击订阅,与未来同行! 订阅:https://rengongzhineng.io/ 来这里看看: https://huggingface.co/microsoft/

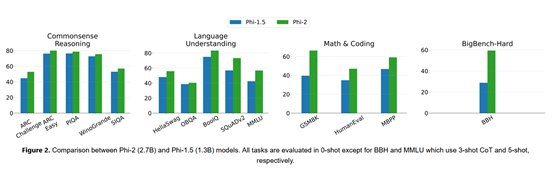

只有27亿参数,性能却高25倍!微软发布Phi-2

12月13日,微软在官方网站正式发布了,27亿参数的大语言模型—Phi-2。 Phi-2是基于微软的Phi-1.5开发而成,可自动生成文本/代码、总结文本、数学推理等功能。 虽然Phi-2的参数很小,性能却优于130亿参数的Llama-2和70亿参数的Mistral,以及谷歌最新发布的Gemini Nano 2。 值得一提的是,Phi-2没有进行过RLHF(人类反馈强化学习)和指令微调只是一

Pi, Phi(黄金比例) and Fibonacci(斐波纳契数)

info:https://www.goldennumber.net/pi-phi-fibonacci/ from: https://www.zhihu.com/question/28062458 golden mean:https://static1.squarespace.com/static/523a572be4b0bea71219be32/t/530d43a3e4b046c4d2bc85

![[HDCTF 2023]Normal_Rsa(e,phi不互素)](/front/images/it_default2.jpg)