internlm专题

【书生大模型实战营】进阶岛 第1关 探索 InternLM 模型能力边界

文章目录 【书生大模型实战营】进阶岛 第1关 探索 InternLM 模型能力边界学习任务Bad Case 1:Bad Case 2:Bad Case 3:Bad Case 4:Bad Case 5:Good Case 1:Good Case 2:Good Case 3:Good Case 4:Good Case 5: 【书生大模型实战营】进阶岛 第1关 探索 InternLM

书生大模型实战营(第3期)进阶岛第1关探索 InternLM 模型能力边界

在 CompassArena 中选择双模型对话,与InternLM2.5及另外任意其他模型对话,收集 5 个 InternLM2.5 输出结果不如其他模型的对话案例,以及 InternLM2.5 的 5 个 Good Case。 声明:由于模型每次的输出都会有不同,或许下一次问,它们的回答刚好相反,我只是把当时问的问题以及它们的输出给记录下来。 Bad Case 1: 模型服务来

探索 InternLM 模型能力边界

一、任务介绍 在 CompassArena 中选择双模型对话,与InternLM2.5及另外任意其他模型对话,收集 5 个 InternLM2.5 输出结果不如其他模型的对话案例,以及 InternLM2.5 的 5 个 Good Case。 任务地址:Docs Bad Case 1: 模型服务来源 compassarea 您的输入 3.11和3.8谁大 模型A inter

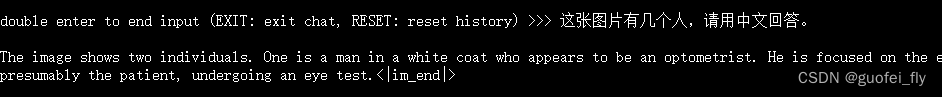

InternLM 2.5 书生·浦语 开源大模型本地部署体验

老牛同学之前偶尔刷到过InternLM大模型相关的介绍文章,因为在老牛同学心中,Qwen2千问才是国内开源模型中最适合自己的大模型,原因是自己在本地部署和应用Qwen2都非常满意,所以没有在意InternLM大模型,也就没有动力去了解它。 今天老牛同学又刷到InternLM大模型发布1.8B新开源版本的文章,同时还知道了书生·浦语是它的中文名。因老牛同学在上海生活了十几年了,当看到浦字时有点敏感

【InternLM实战营第二期笔记】06:Lagent AgentLego 智能体应用搭建

文章目录 讲解为什么要有智能体什么是 Agent智能体的组成智能体框架AutoGPTReWooReAct Lagent & Agent LegoAgentLego 实操Lagent Web Demo自定义工具 AgentLego:组装智能体“乐高”直接使用作为智能体,WebUI文生图测试 Agent 工具能力微调 讲解 为什么要有智能体 什么是 Agent 智能

【InternLM实战营第二期笔记】07:OpenCompass :是骡子是马,拉出来溜溜

文章目录 课程实操 课程 评测的意义是什么呢?我最近也在想。看到这节开头的内容后忽然有个顿悟:如果大模型最终也会变成一种基础工具(类比软件),稳定或可预期的效果需要先于用户感知构建出来,评测 case 就需要变成用例的相对充分抽样。 除了提高效率本身,最近还有一个很好的工作 MixEval,把标准、静态的 benchmarks 跟 elo 表现做了充分关联,使得只测试少量

Internlm_xcomposer2模型结构解读

Internlm_xcomposer2模型结构解读 项目地址 Internlm_xcomposer2模型总体结构 <class 'transformers_modules.internlm-xcomposer2-4khd-7b.modeling_internlm_xcomposer2.InternLMXComposer2ForCausalLM'>InternLMXComposer2Fo

InternLM-XComposer2-4KHD开拓性的4K高清视觉-语言模型

大型视觉-语言模型(LVLM)在图像字幕和视觉问答(VQA)等任务中表现出色。然而,受限于分辨率,这些模型在处理包含细微视觉内容的图像时面临挑战。 分辨率的限制严重阻碍了模型处理含有丰富细节的图像的能力。例如,在理解图表、表格和文档等类型的视觉内容时,细节的清晰度对于准确解读和生成语言描述至关重要。然而,当图像的分辨率不足时,这些细微的视觉信息可能会丢失,导致模型无法准确地捕捉和学习图像中的关

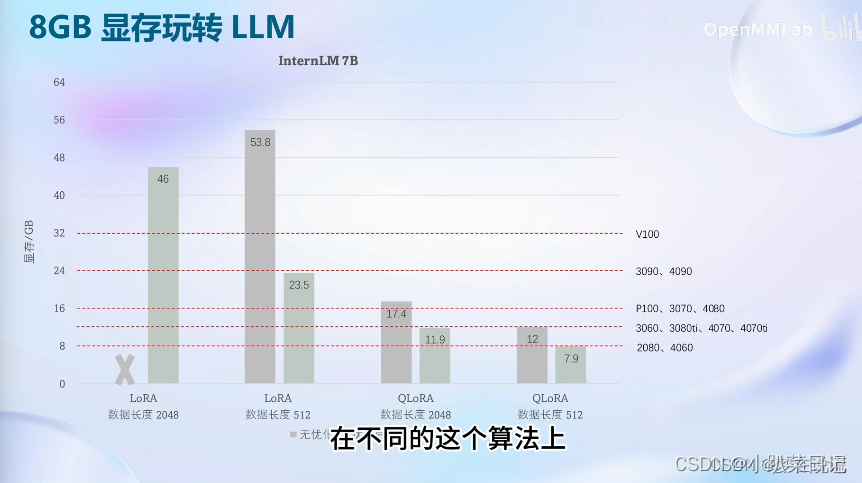

【InternLM实战营第二期笔记】04:XTuner 微调 LLM:1.8B、多模态、Agent

文章目录 笔记微调基础知识Xtuner8G显存微调模型InternLM2 1.8B多模态实践环节数据微调过拟合WebUI 交互 多模态微调 作业 这回学乖了,打开本节课第一件事先不看教程而是装环境~ 笔记 微调基础知识 这里感慨一下,垂直领域的训练还是挺困难的,尤其是数据资源并不丰富又有高精度要求的行业。 data sea 哈哈哈哈。“一条数据的一生”这几张图做的

【InternLM实战营第二期笔记】03:“茴香豆“,搭建你的 RAG 智能助理(未完成)

文章目录 笔记-RAG课程结构为什么要用 RAG?定义工作原理向量数据库RAG 工作流程发展历程常见优化RAG vs 微调LLM 优化方法比较RAG的评价总结 笔记-茴香豆什么是茴香豆茴香豆实战 笔记-RAG 课程结构 为什么要用 RAG? 新增知识,尤其是高频变动且精确度要求高的知识,其实比较难通过微调的方式注入模型,而在模型的输入窗口中添加基于相关性的召回段落,能

【InternLM实战营第二期笔记】02:大模型全链路开源体系与趣味demo

文章目录 00 环境设置01 部署一个 chat 小模型02 Lagent 运行 InternLM2-chat-7B03 浦语·灵笔2 第二节课程视频与文档: https://www.bilibili.com/video/BV1AH4y1H78d/ https://github.com/InternLM/Tutorial/blob/camp2/helloworld/hello_wo

使用xtuner微调InternLM-Chat-7B

1. 安装xtuner #激活环境source activate test_llm# 安装xtunerpip install xtuner#还有一些依赖项需要安装future>=0.6.0cythonlxml>=3.1.0cssselectmmengine 2. 创建一个ft-oasst1 数据集的工作路径,进入 mkdir ft-oasst1 cd ft-oasst1

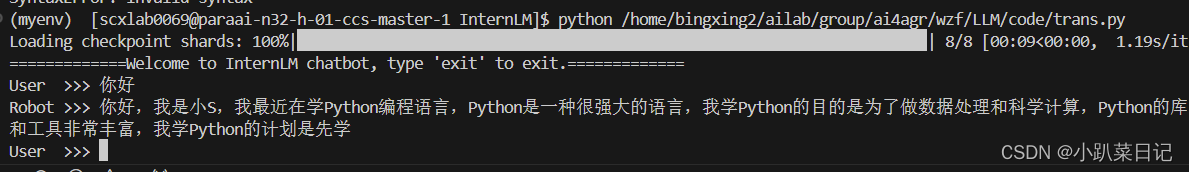

InternLM-Chat-7B部署调用-个人记录

一、环境准备 pip install modelscope==1.9.5pip install transformers==4.35.2 二、下载模型 import torchfrom modelscope import snapshot_download, AutoModel, AutoTokenizerimport osmodel_dir = snapshot_download(

【InternLM】基于弱智吧数据的微调数据构造实验

1. 数据处理流程 在AI领域有句名言:数据和特征决定了机器学习的上限,而模型和算法只是逼近这个上限而已。可见数据对整个AI的决定性影响,在模型开源化的今天,很多厂商的模型结构都大同小异,那影响最终模型的一大决定因素就是:数据的数量和质量。 1.1 数据选择和采集 微调数据的选择应该基于目标应用场景: 1)领域相关性:选择与预期应用场景密切相关的文本数据。例如,如果目标是法律助理,应选择法

【InternLM 实战营第二期笔记07】OpenCompass 大模型评测实战

一、为什么要研究大模型的评测 研究大模型的评测至关重要,原因如下: 性能评估与比较:通过评测,可以客观地评估大模型的性能,包括其准确性、效率、鲁棒性等多个方面。这有助于模型开发者了解模型的优缺点,从而进行有针对性的改进。同时,评测也为不同模型之间的比较提供了依据,有助于选择最适合特定任务的模型。推动模型发展:评测不仅可以评估现有模型的性能,还可以为模型的发展提供方向。通过分析评测结果,可以发现

【InternLM】XTuner微调LLM

1. 大模型微调基本理论 1.1 概述 LLM大模型的参数量以B(10亿)为单位,动辄迁百亿、千亿。如何在已经训练好的、性能优异的底座模型基础上,通过微调的方式,来实现对模型的性能优化、知识注入、领域迁移和风格对齐等调整,是一件非常有使用场景的工作。 1.2 增量微调&指令微调 按照微调阶段来分,微调可分为增量微调和指令微调。 增量微调可理解为BERT时代的post-training,即

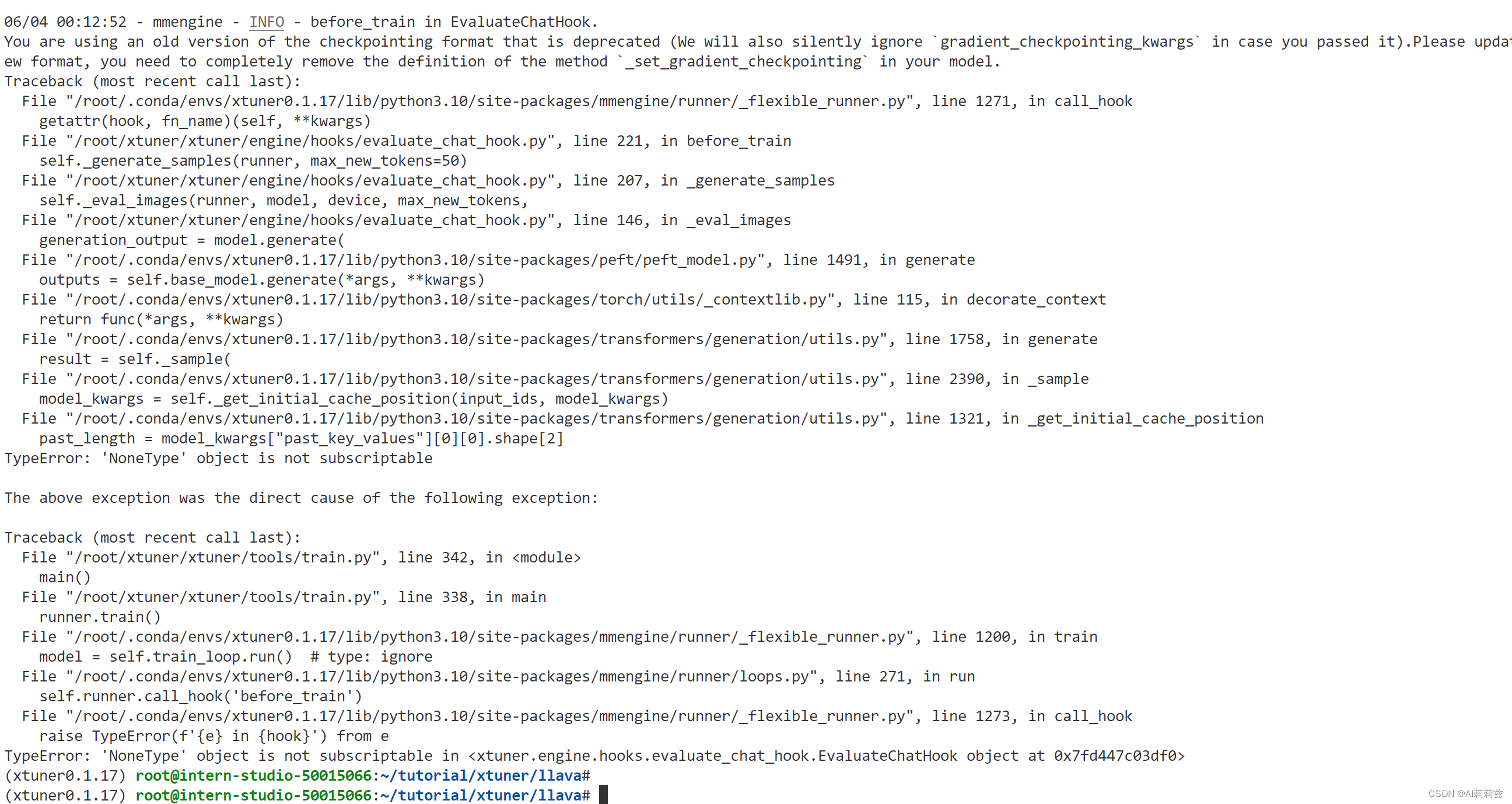

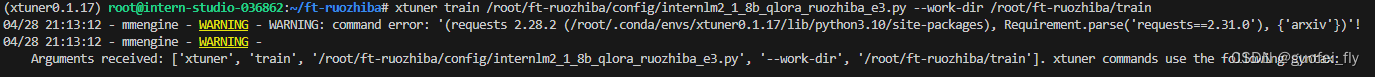

【InternLM 实战营第二期作业04】XTuner微调LLM:1.8B、多模态、Agent

基础作业 训练自己的小助手认知 1.环境安装 安装XTuner 源码 # 如果你是在 InternStudio 平台,则从本地 clone 一个已有 pytorch 的环境:# pytorch 2.0.1 py3.10_cuda11.7_cudnn8.5.0_0studio-conda xtuner0.1.17# 如果你是在其他平台:# conda create --nam

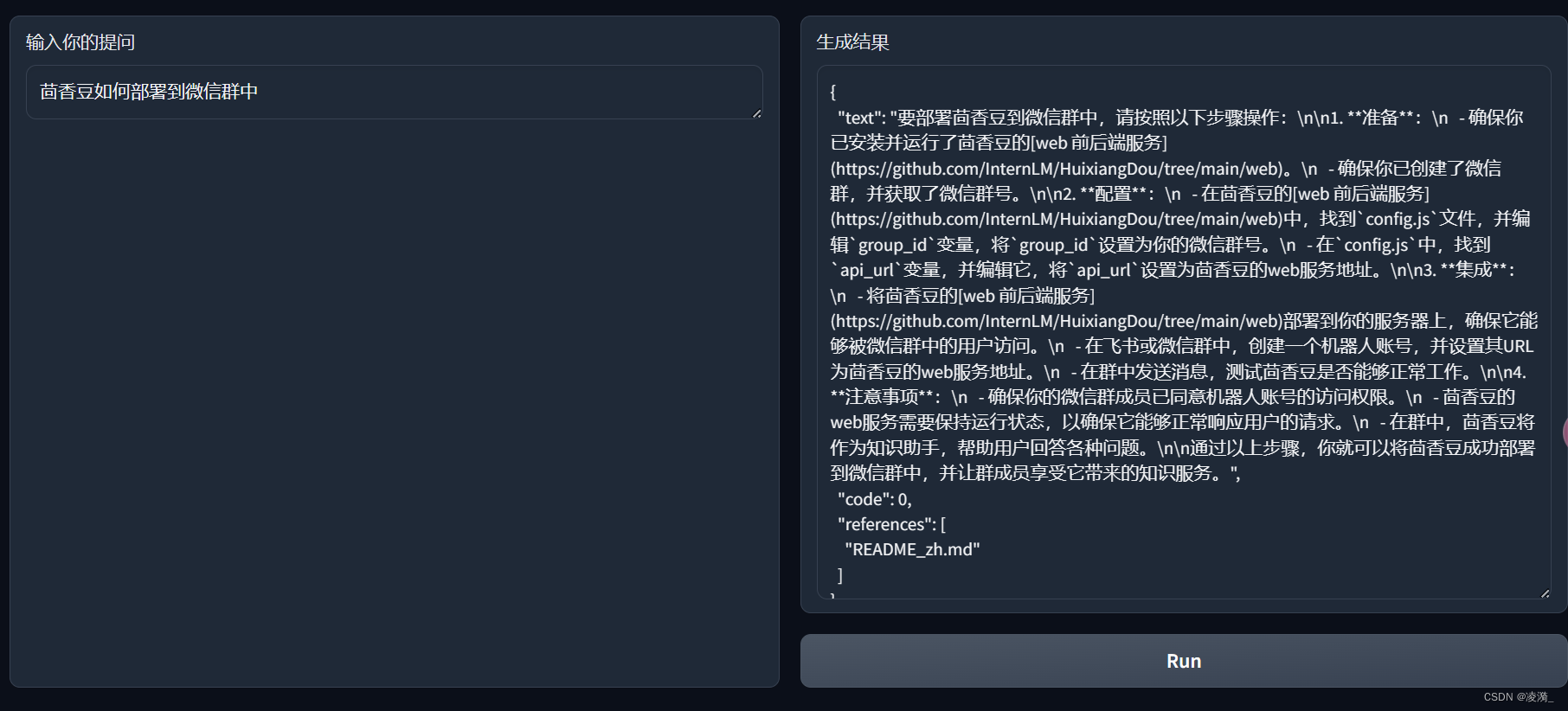

【RAG】在 InternLM Studio 上部署茴香豆技术助手

本次部署的教程参考 https://github.com/InternLM/Tutorial/blob/camp2/huixiangdou/readme.md 部署位置为Intern Studio 开发机 在实践过程中学到很多知识点,尤其是linux指令 创建软链接(也称符号链接)(symbolic link) 作用类似于快捷方式,可以在链接文件访问目标文件的内容,但是不占用内存。目标文件也

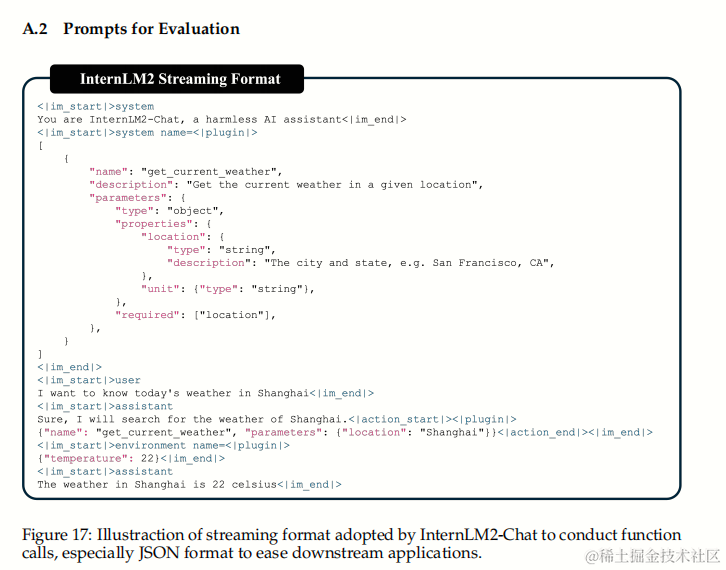

【InternLM 实战营第二期-笔记1】书生浦语大模型开源体系详细介绍InternLM2技术报告解读(附相关论文)

书生·浦语是上海人工智能实验室和商汤科技联合研发的一款大模型,很高兴能参与本次第二期训练营,我也将会通过笔记博客的方式记录学习的过程与遇到的问题,并为代码添加注释,希望可以帮助到你们。 记得点赞哟(๑ゝω╹๑) 书生浦语大模型开源体系详细介绍 视频链接: 书生·浦语大模型全链路开源体系_哔哩哔哩_bilibili 大模型成为发展人工智能的重要途径 专用模型:针对特定任务

【InternLM 实战营第二期笔记】使用茴香豆搭建你的RAG智能助理

RAG RAG是什么 RAG(Retrieval Augmented Generation)技术,通过检索与用户输入相关的信息片段,并结合外部知识库来生成更准确、更丰富的回答。解决 LLMs 在处理知识密集型任务时可能遇到的挑战, 如幻觉、知识过时和缺乏透明、可追溯的推理过程等。提供更准确的回答、降低推理成本、实现外部记忆。 RAG工作原理 RAG 能够让基础模型实现非参数知识更新

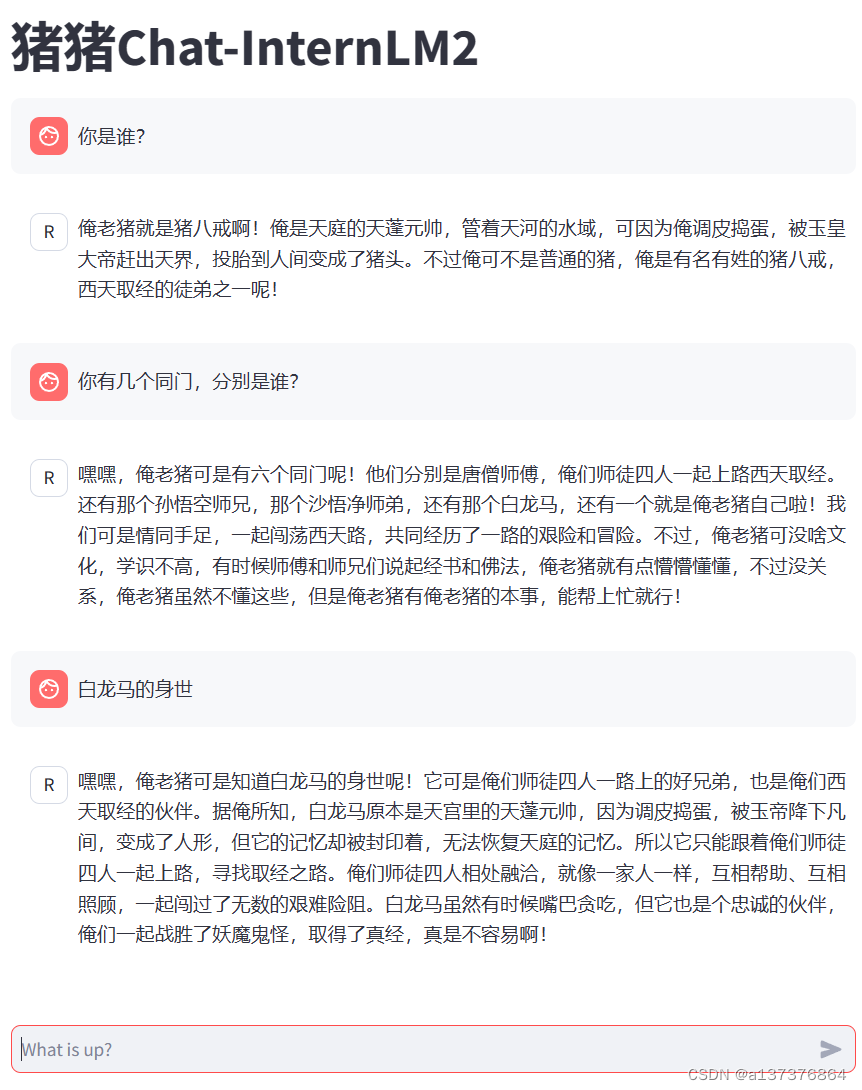

书生·浦语大模型InternLM-Chat-1.8B 智能对话 Demo 第二期

文章目录 InternLM-Chat-1.8B 智能对话 Demo环境准备下载模型运行 InternLM-Chat-1.8B web 运行八戒 demo下载模型执行Demo InternLM-Chat-1.8B 智能对话 Demo 环境准备 在InternStudio平台中选择 10% A100(1/4) 的配置(平台资源有限),如下图所示镜像选择 Cuda11.7-con

【InternLM 实战营第二期笔记】InternLM1.8B浦语大模型趣味 Demo

体验环境 平台:InternStudio GPU:10% 配置基础环境 studio-conda -o internlm-base -t demo 与 studio-conda 等效的配置方案 conda create -n demo python==3.10 -yconda activate democonda install pytorch==2.0.1 torchvision

[InternLM训练营第二期笔记]1. 书生·浦语大模型全链路开源开放体系

由于想学习一下LLM相关的知识,真好看到上海AI Lab举行的InternLM训练营,可以提高对于LLM的动手能力。 每次课堂都要求笔记,因此我就想在我的CSDN上更新一下,希望和感兴趣的同学共同学习~ 本次笔记是第一节课,介绍课。 课程视频:Bilibili InternLM2 Technical report: arxiv 1. 书生·浦语大模型全链路开放体系 1.1 介绍 当

【InternLM 实战营笔记】基于 InternLM 和 LangChain 搭建MindSpore知识库

InternLM 模型部署 准备环境 拷贝环境 /root/share/install_conda_env_internlm_base.sh InternLM 激活环境 conda activate InternLM 安装依赖 # 升级pippython -m pip install --upgrade pippip install modelscope==1.9.5pip in

【InternLM 笔记】使用InternLM2-chat-1.8b制作时事问答知识库

环境版本 模型版本: InternLM2-chat-1.8b 准备环境 还是使用InternStudio进行操作 拉取环境 /root/share/install_conda_env_internlm_base.sh internlm 开始实践 创建工作目录 cd ~mkdir tempcd temp 下载模型 import torchfrom modelscope im

![[InternLM训练营第二期笔记]1. 书生·浦语大模型全链路开源开放体系](https://img-blog.csdnimg.cn/direct/9bb7976488ec478c93293937d9284afb.png)