hugging专题

Hugging Face Offline Mode 离线模式

Hugging Face Offline Mode 离线模式 1. 缓存管理2. 遥测日志 在使用 Hugging Face 的库时,缓存和遥测日志是两个重要的功能。本文将介绍如何管理缓存、启用离线模式以及如何关闭遥测日志。 1. 缓存管理 在使用 Hugging Face 模型时,权重和文件通常会从 Hub 下载并存储在默认的缓存目录中,这个目录通常位于用户的主目录。如果

python出现远程服务器访问不了Hugging Face

OSError: We couldn’t connect to ‘https://huggingface.co’ to load this file, couldn’t find it in the cached files and it looks like stabilityai/sd-turbo is not the path to a directory containing a file

自然语言处理领域的明星项目推荐:Hugging Face Transformers

在当今人工智能与大数据飞速发展的时代,自然语言处理(NLP)已成为推动科技进步的重要力量。而在NLP领域,Hugging Face Transformers无疑是一个备受瞩目的开源项目。本文将从项目介绍、代码解释以及技术特点等角度,为您深入剖析这一热门项目。 一、项目介绍 Hugging Face Transformers是一个包含众多NLP领域先进模型的开源项目,由Hugging F

hugging face:大模型时代的github介绍

1. Hugging Face是什么: Hugging Face大模型时代的“github”,很多人有个这样的认知,但是我觉得不完全准确,他们相似的地方在于资源丰富,github有各种各样的软件代码和示例,但是它不是系统的,没有经过规划管理,Hugging Face不一样,它是有系统的,有更聚焦的主题,规划和主线。 我尝试这样去理解它,希望会更加贴切 : 如果大模型是一盘盘精致的菜肴,那么H

如何选择合适的大模型框架:LangChain、LlamaIndex、Haystack 还是 Hugging Face

节前,我们星球组织了一场算法岗技术&面试讨论会,邀请了一些互联网大厂朋友、参加社招和校招面试的同学。 针对算法岗技术趋势、大模型落地项目经验分享、新手如何入门算法岗、该如何准备、面试常考点分享等热门话题进行了深入的讨论。 合集: 《大模型面试宝典》(2024版) 正式发布! 目前生成式大模型开发应用框架主要有四个:LangChain、LlamaIndex、Haystack 和 Hugg

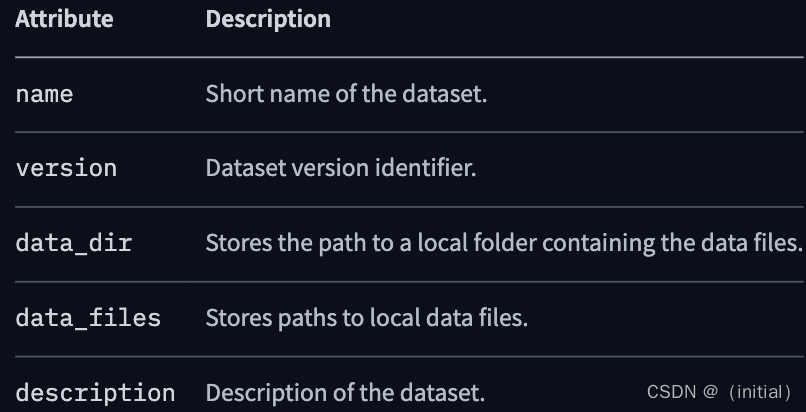

7.数据集处理库Hugging Face Datasets

数据集处理库Hugging Face Datasets Datasets 首先解决数据来源问题 使用 Datasets 下载开源数据集 Datasets.load_dataset 实现原理简介 构造 DatasetBuilder 类的主要配置 BuilderConfig 如果您想向数据集添加额外的属性,例如类别标签。有两种方法来填充BuilderConfig类或其子类的属性

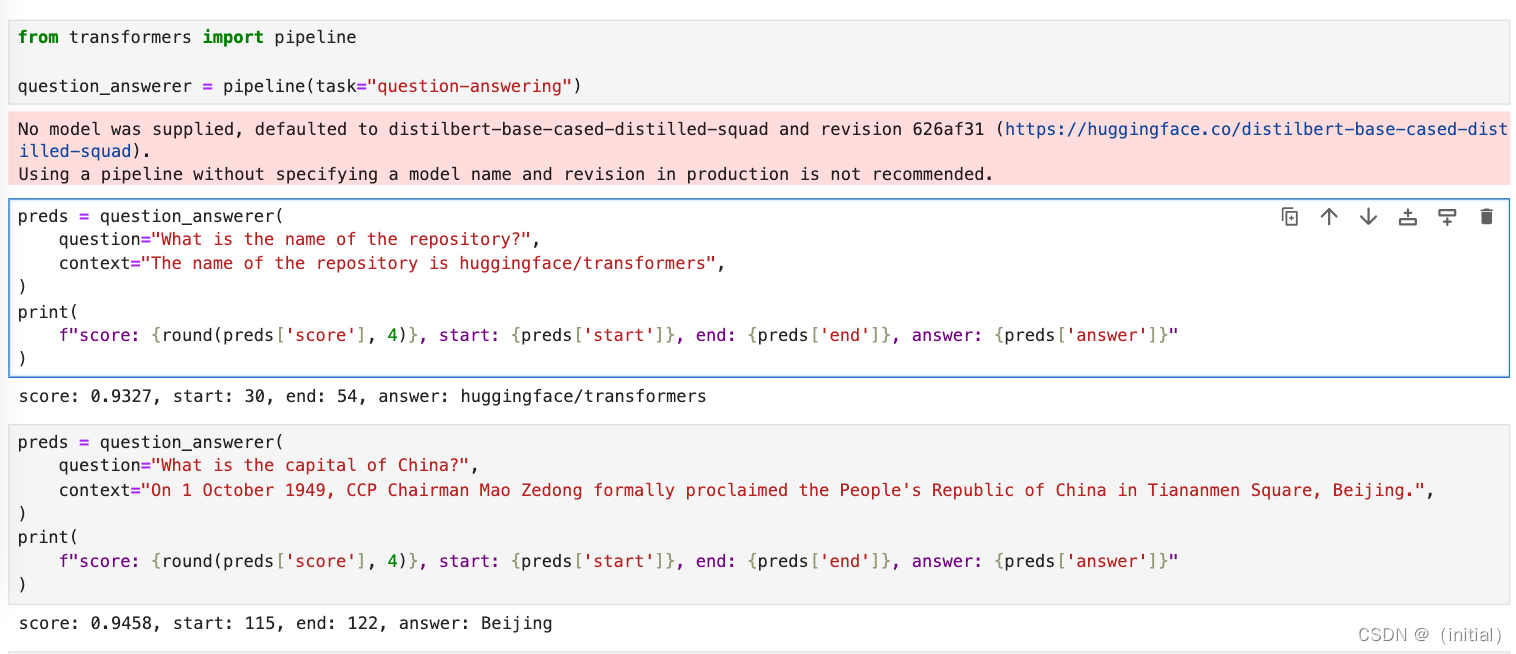

6.Hugging Face Transformers 快速入门

Hugging Face Transformers 库独特价值 丰富的预训练模型:提供广泛的预训练模型,如BERT、GPT、T5等,适用于各种NLP任务。易于使用:设计注重易用性,使得即使没有深厚机器学习背景的开发者也能快速上手。最新研究成果的快速集成:经常更新,包含最新的研究成果和模型。强大的社区支持:活跃的社区不断更新和维护库,提供技术支持和新功能。跨框架兼容性:支持多种深度学习框架,如Py

HuggingFace团队亲授大模型量化基础: Quantization Fundamentals with Hugging Face

Quantization Fundamentals with Hugging Face 本文是学习https://www.deeplearning.ai/short-courses/quantization-fundamentals-with-hugging-face/ 这门课的学习笔记。 What you’ll learn in this course Generative AI mo

Hugging Face系列2:详细剖析Hugging Face网站资源——实战六类开源库

Hugging Face系列2:详细剖析Hugging Face网站资源——实战六类开源库 前言本篇摘要2. Hugging Face开源库2.1 transformers2.1.1 简介2.1.2 实战1. 文本分类2. 图像识别3. 在Pytorch和TensorFlow中使用pipeline 2.2 diffusers2.2.1 简介2.2.2 实战1. 管线2. 模型和调度器 2

小白学大模型:Hugging Face Tokenizer

Tokenizer介绍 在自然语言处理(NLP)领域,Tokenizer(分词器)是准备输入模型的关键步骤之一。Hugging Face 提供了用于各种模型的分词器库,其中大多数分词器都以两种风格提供:一种是完整的 Python 实现,另一种是基于 Rust 库 🤗 Tokenizers 的“Fast”实现。这两种实现方式各有特点,其中“Fast”实现具有两大优势: 显著提升速度: 特别是在

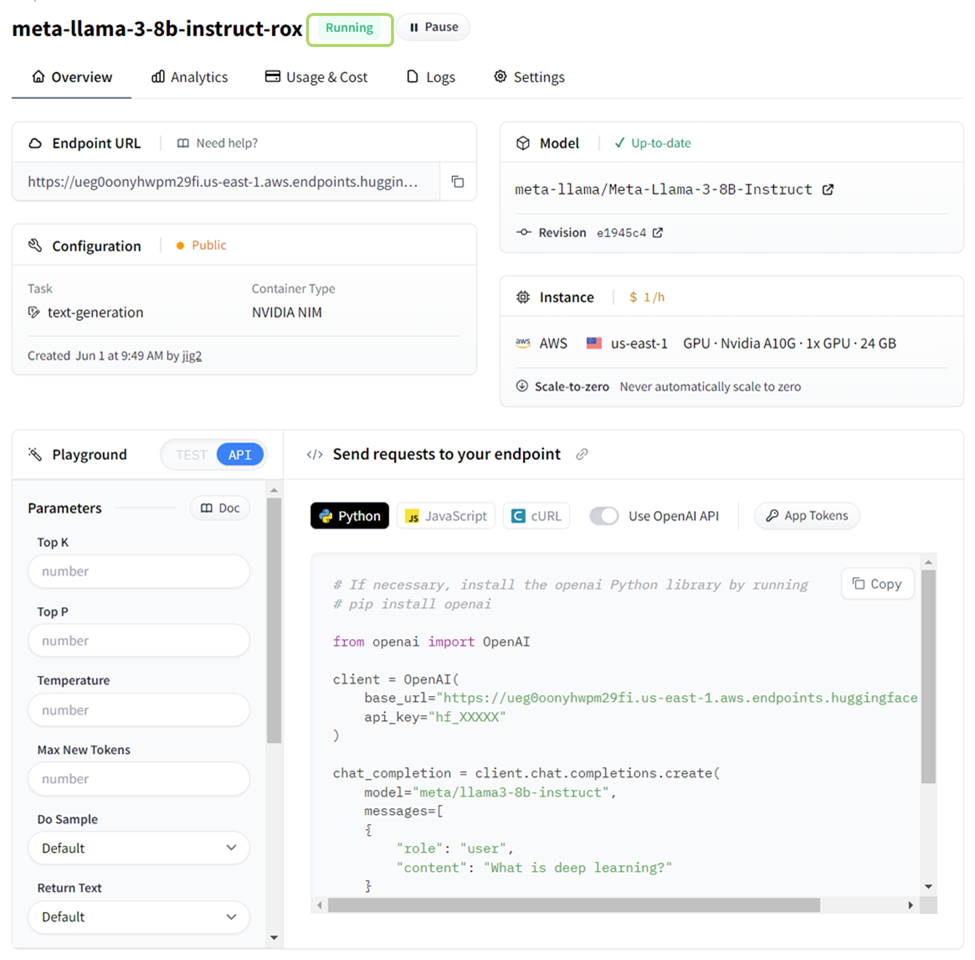

NVIDIA 与 Hugging Face 合作简化生成式 AI 模型部署

NVIDIA 与 Hugging Face 合作简化生成式 AI 模型部署 随着生成式 AI 的快速发展,社区已采取两种重要方式来促进这种扩展:迅速发布最先进的基础模型,并简化它们与应用程序开发和生产的集成。 NVIDIA 通过优化基础模型来提高性能,帮助企业更快地生成代币,降低运行模型的成本,并通过 NVIDIA NIM 改善最终用户体验,从而为这一努力提供帮助。 NVIDIA NIM

RapidMiner如何利用Hugging Face中的模型实现更有趣的事

RapidMiner Studio最新发布的功能更新,重点是嵌入Hugging Face和Open AI,Hugging face中含有大量的可用模型,包含翻译、总结、文本生成等等强大的模型,Open AI更不必说了,生成界的鼻祖。那么今天主要介绍一下RapidMiner Studio如何利用Hugging Face中的模型实现更有趣的事情。 首先来下载模型,这里的模型也是需要您

介绍一下Hugging Face,这个公司的背景是什么

Hugging Face是一家成立于2016年的人工智能公司,专注于为AI研究人员和开发者提供开源模型库和工具。以下是关于Hugging Face公司的详细背景介绍: 公司历史与创始人: Hugging Face由Clément Delangue、Julien Chaumond和Thomas Wolf三位法国籍创始人共同创立,总部位于纽约布鲁克林。最初,Hugging Face的创意是开发聊天机

【文末附gpt升级方案】亚马逊与Hugging Face合作:定制芯片低成本运行AI模型的创新探索

亚马逊与Hugging Face合作:定制芯片低成本运行AI模型的创新探索 摘要 本文探讨了亚马逊云部门与人工智能初创公司Hugging Face的合作,旨在通过定制计算芯片Inferentia2在亚马逊网络服务(AWS)上更低成本地运行数千个AI模型。文章首先介绍了Hugging Face在AI领域的重要地位,随后分析了定制芯片在AI模型运行中的优势,并详细阐述了双方合作的背景、目标及潜在影响

如何使用 Hugging Face 的 Transformers 库来下载并使用一个qwen1.5的预训练模型[框架]

要使用Hugging Face的Transformers库下载并使用Qwen1.5预训练模型,你可以按照以下步骤操作: 1.安装Transformers库: 确保你已经安装了transformers库的最新版本,至少是4.37.0,因为Qwen1.5已经被集成到这个版本中。如果还没有安装,可以使用以下命令安装: pip install transformers 2.导入必要的模块: 在P

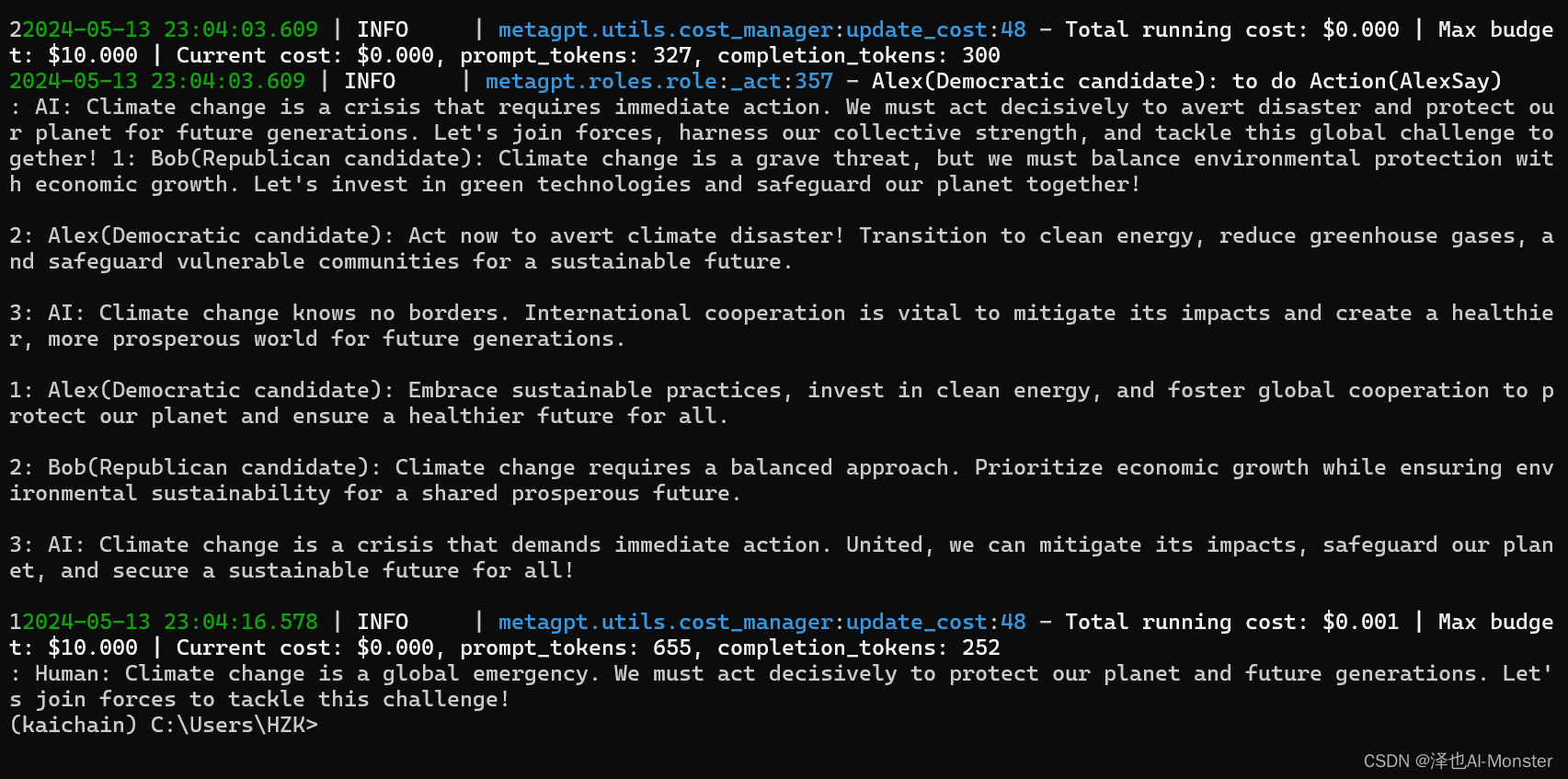

Hugging Muti Agent:第一章

Hugging Muti Agent系列文章目录 学习资料链接:Hugging Muti Agent(二月学习) 文章目录 Hugging Muti Agent系列文章目录第一章:前期准备1.1 获取MetaGPT1.2 配置MetaGPT1.2.1 调用 ChatGPT API 服务 1.3 首次尝试 第一章:前期准备 1.1 获取MetaGPT 获取MetaGPT的内

Meta Llama 3 使用 Hugging Face 和 PyTorch 优化 CPU 推理

原文地址:meta-llama-3-optimized-cpu-inference-with-hugging-face-and-pytorch 了解在 CPU 上部署 Meta* Llama 3 时如何减少模型延迟 2024 年 4 月 19 日 万众期待的 Meta 第三代 Llama 发布了,我想确保你知道如何以最佳方式部署这个最先进的(SoTA)LLM。在本文中,我们将重点讨论如何执行

不科学上网使用Hugging Face的Transformers库

参考 Program Synthesis with CodeGen — ROCm Blogs (amd.com) HF-Mirror - Huggingface 镜像站 https://huggingface.co/docs/transformers/v4.40.1/zh/installation#%E7%A6%BB%E7%BA%BF%E6%A8%A1%E5%BC%8F 准备 apt

如何使用hugging face的模型库?

Hugging Face 是一个流行的自然语言处理 (NLP) 模型库和社区,提供了大量预训练模型、工具和资源,使得 NLP 的开发者和研究人员能够快速高效地构建和应用各种文本相关应用。在这里,我将向您介绍如何在 1 天内快速熟悉 Hugging Face 的基本功能,并展示一些简单实用的例子。 🚀1/3 如何快速使用 安装 Hugging Face 在命令行中输入 pip install

diffusion初探——使用hugging face镜像网站所遇到的问题

序言 近期hugging face官网无法直接从国内访问(可用梯子解决),故无法像之前方法在服务器上直接访问,本文采取的方法是:使用国内替换原hugging face网站,https://hf-mirror.com/。但这样势必会带来一些问题,这里将使用DreamBooth生成“土豆先生”作为示例,逐一描述本人遇到的问题:(本人刚接触diffusion,不喜勿喷) 问题 1.登录

Hugging Face模型下载方法小结

由于国内网络环境较差,HF的服务器在国外,因此很多访问会超时,或者下载不稳定,主要记录了下面这些方法,用于HF中的模型文件下载。 方法1:HF镜像+wget 可以通过huggingface的镜像网站下载,hf-mirror.com,只用将原本下载链接中的huggingface官网地址修改,即可再通过wget命令进行下载。右键复制对应的下载链接wget下载(注意不要在表面复制HTML链接,而是要

TIMM库--hugging face--models存储路径修改---TIMM本地读取huggingface模型

文章目录 一、TiMM下载的模型直接换路径读取二、TiMM模型转torch模型 一、TiMM下载的模型直接换路径读取 如果你使用 timm.create_model('vit_base_patch16_clip_384.laion2b_ft_in1k', pretrained=True)下载了huggingface模型到电脑中,然后将模型传到另一个电脑中。那么步骤如下: 下载模

音频分类革命:如何用Hugging Face实现前沿的音频频谱图变换器

目录 引言 ASTConfig 参数解释 示例代码及注释 ASTFeatureExtractor 参数解释 call 方法参数 ASTModel 参数 forward 方法参数 返回值 返回的主要元素 示例代码及说明 ASTForAudioClassification 参数 forward 方法参数 返回值 主要返回元素

『大模型笔记』LLM框架(LangChain、LlamaIndex、Haystack、Hugging Face)哪一个是满足您特定需求的最佳选择?

LLM框架(LangChain、LlamaIndex、Haystack、Hugging Face)哪一个是满足您特定需求的最佳选择? 文章目录 1. LangChain1.1. 优势1.2. 劣势1.1. 理想用例 2. LlamaIndex2.1. 优势2.2. 劣势2.3. 理想用例 3. Haystack3.1. 优势3.2. 劣势3.3. 理想用例 4. Hugging Face

介绍 Gradio 与 Hugging Face

🍉 CSDN 叶庭云:https://yetingyun.blog.csdn.net/ 我们可以使用 Gradio 库为我们的模型构建演示。Gradio 允许您完全使用 Python 为任何机器学习模型构建、自定义和共享基于 Web 的演示。使机器学习模型变得可交互和易于使用。 为什么首先要为您的机器学习模型构建交互式演示或图形用户界面(GUI)呢?以下是演示的好处: 机器学习开发人

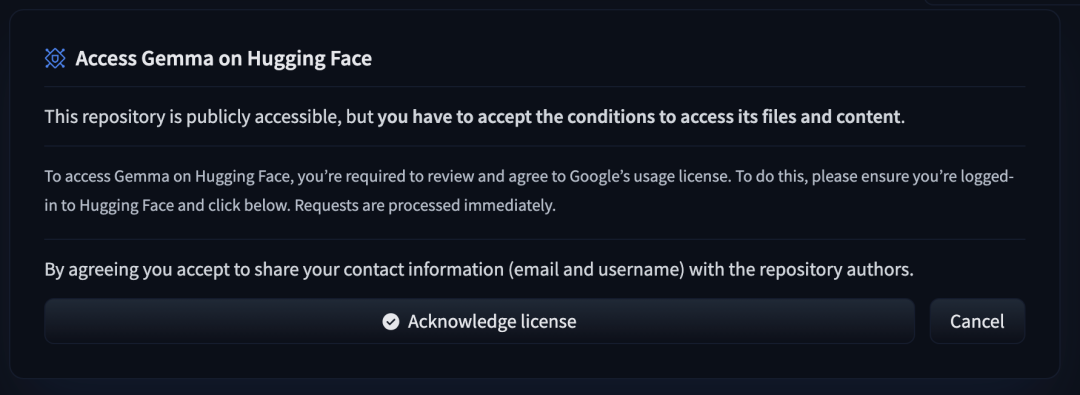

使用 Hugging Face 微调 Gemma 模型

来自 Google Deepmind 开放权重的语言模型 Gemma 现已通过 Hugging Face 面向更广泛的开源社区开放。该模型提供了两个规模的版本:2B 和 7B 参数,包括预训练版本和经过指令调优的版本。它在 Hugging Face 平台上提供支持,可在 Vertex Model Garden 和 Google Kubernetes Engine 中轻松部署和微调。 Gemma