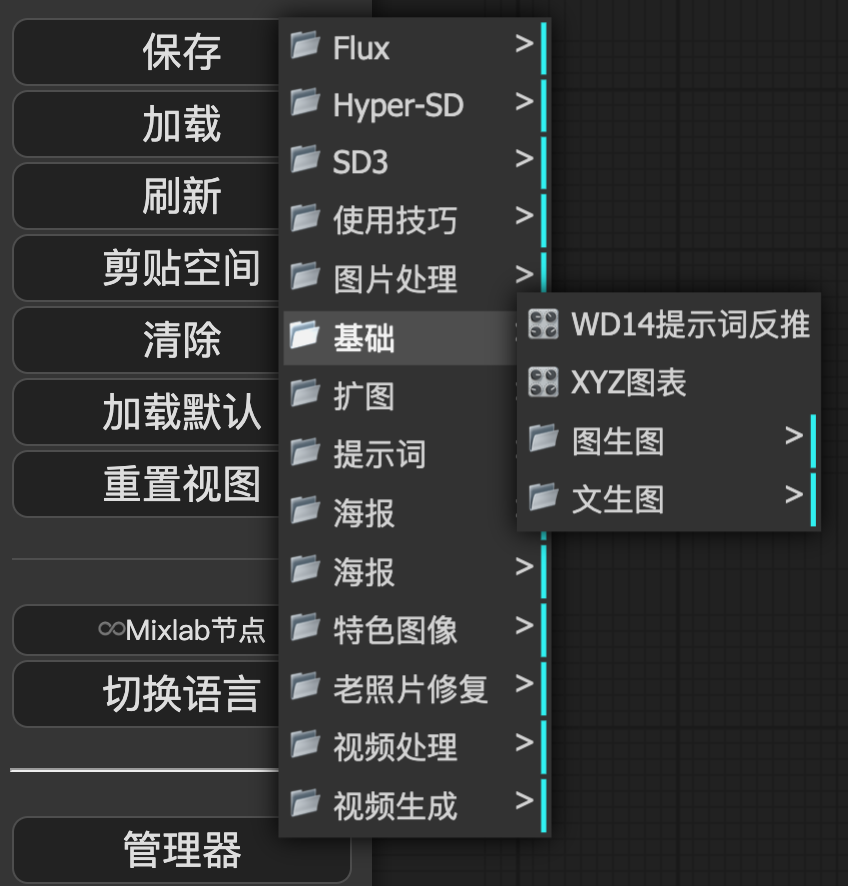

controlnet专题

Flux持续火爆,这些LoRA、ControlNet、工作流你值得拥有

大家好,我是每天分享AI应用的萤火君! Flux自发布以来,受到了广大AI绘画爱好者的一致好评,远远的将SD3甩在了脑后,其出图质量媲美Midjourney。而且Flux迭代迅速,接连发布了Flux.1的开发模型和个人模型,其Lora模型、ControlNet模型也迅速推出,社区创作热情高涨。 为了让大家对Flux有一个全面的认识,本文将介绍下Flux基础模型、LoRA模型,以及Control

效果超越ControlNet+IP-Adapter和FreeControl!Ctrl-X:可控文生图新框架(加州大学英伟达)

文章链接:https://arxiv.org/pdf/2406.07540 项目链接:https://genforce.github.io/ctrl-x/ 最近的可控生成方法,如FreeControl和Diffusion Self-guidance,为文本到图像(T2I)扩散模型带来了细粒度的空间和外观控制,而无需训练辅助模块。然而,这些方法针对每种类型的评分函数优化潜在embedd

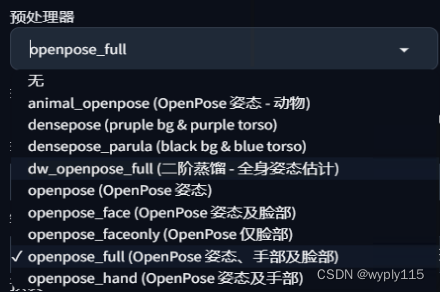

Stable Diffusion: ControlNet Openpose

上一文已经介绍了ControlNet的安装,点击右边的三角箭头。 拖放原始姿态图片。 勾选“启用”,“完美像素模式”,“允许预览” 控制类型选择“OpenPose(姿态)” 预处理器选“openpose_full”,会对原始姿态图片做整体分析 (也可以选“openpose_face”,“openpose_hand”等,就会有选择地分析识别,而忽略手部或脸部识别等) 模型部分会

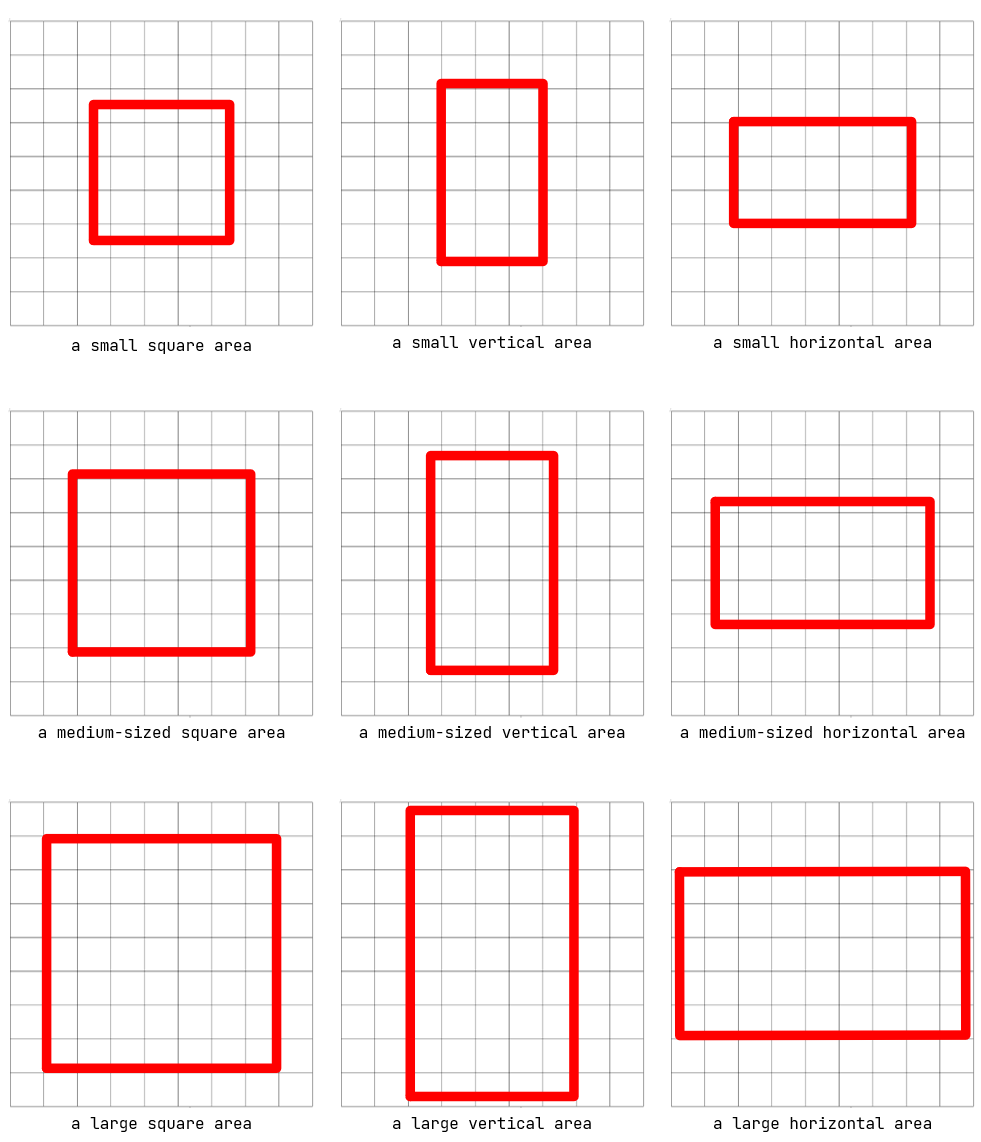

ControlNet作者新作Omost 一句话将LLM的编码能力转化为图像生成能力,秒变构图小作文,再也不用为不会写提示词担心了!

近日,ControlNet的作者推出了一个全新的项目—Omost。Omost是一个将LLM的编码能力转化为图像生成能力的项目。对现有图像模型的提示词理解有着巨大的帮助。通过很短的提示词,就可以生成非常详细并且空间表现很准确的图片。 完美解决新手小白不会写提示词的痛点。现在只需一句超简单的提示词说明意图,Agent就会自己开始“构图”。 这个名字Omost有两层含义: 每次使用 Om

Diffusers代码学习-多个ControlNet组合

可以根据不同的图像输入组合多个ControlNet条件来创建MultiControlNet。为了获得更好的结果,比较有利的做法是: 1. 有选择的进行遮罩,使其不重叠(例如,遮罩canny图像中姿势条件所在的区域) 2. 使用controlnetconditioning_scale参数进行实验,以确定分配给每个条件输入的权重 下面将结合Canny 边缘检测图像和人体姿态估计图像来生成新图像。

【第8章】如何利用ControlNet生成“可控画面”?(配置要求/一键安装/快速上手/生成第一张图)ComfyUI基础入门教程

这节我们来讲AI绘画领域中一个很重要的概念:ControlNet,看下如何让生成的画面更可控。 🎅什么是ControlNet? Stable Diffusion中的ControlNet是一种神经网络结构,它允许将额外的条件输入添加到预训练的图像扩散模型中,通过这种方式,ControlNet可以控制图像生成过程,使得生成的图像更加符合特定的条件或要求。 ControlNet通过接受不同类型的

Diffusers代码学习-ControlNet(Inpaint)

对于Inpaint,需要一个初始图像、一个蒙版图像和一个描述用什么替换蒙版的提示词。ControlNet模型允许添加另一个控制图片来调节模型。让我们用Inpaint蒙版来调整模型。这样,ControlNet可以使用修复掩模作为控件来引导模型在蒙版区域内生成图像。 # 以下代码为程序运行进行设置 import os os.environ["HF_ENDPOINT"] = "https://

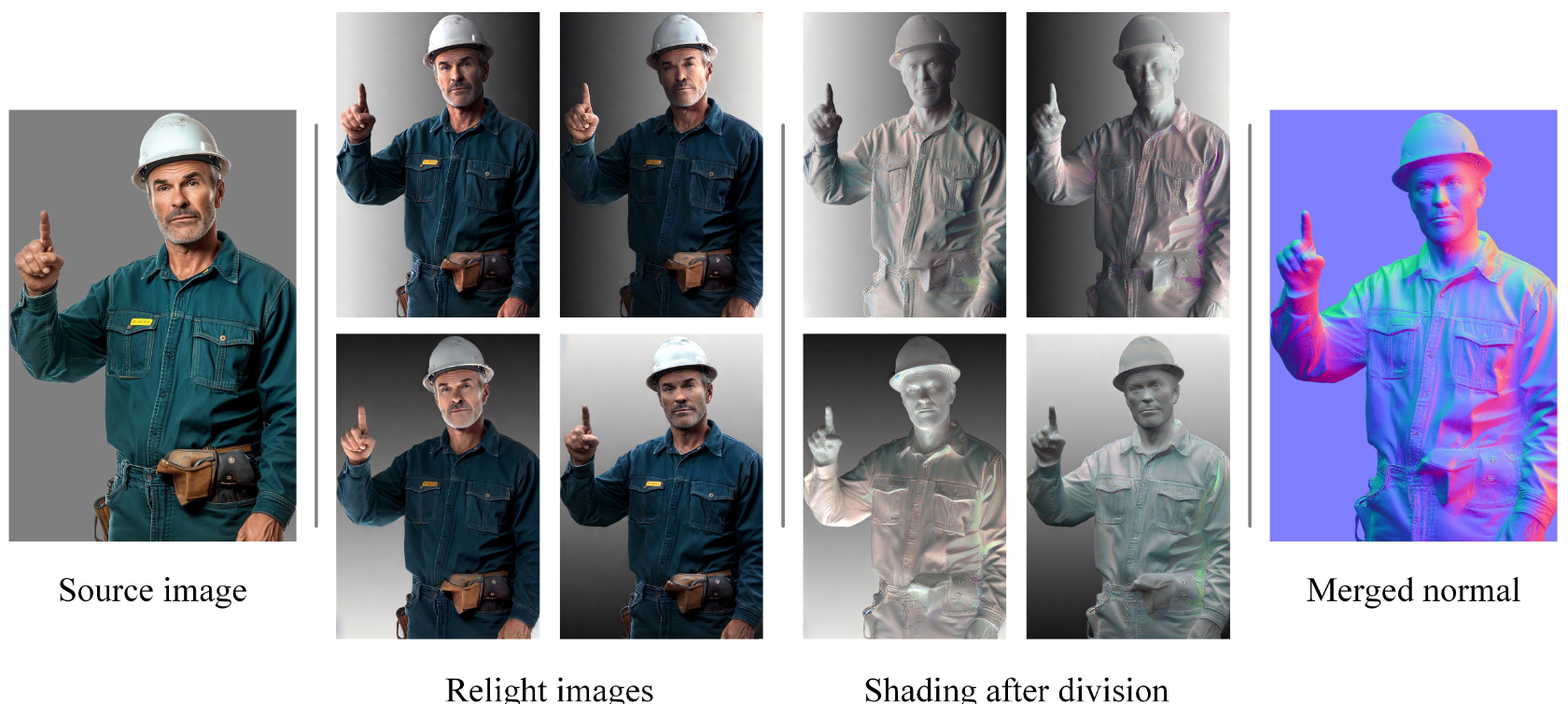

Controlnet作者放出新的大招 IC-Light,可以操控图像生成时的光照,对内容主体重新打光生成符合新背景环境光照的图片

IC-Light代表Impose Constant Light,是一个控制图像照明的项目。可以操控图像生成时的光照,对内容主体重新打光生成符合新背景环境光照的图片。这下商品图合成这种需要最大程度保持原有主体 ID 需求的最大的问题解决了。 目前,已经发布了两种类型的模型: 文本条件重新光照模型。从原图分离主体之后通过提示词生成符合光照要求的背景同时主体除了光照之外和原主体一致。 背景条件模

ControlNet 学习笔记

ControlNet根据一些额外的信息控制扩散生成走向 在作用原理上,ControlNet和LoRA是有许多相似之处的,定位都是对大扩散模型做微调的额外网络。 Annotator(预处理器):从图片中提取对ControlNet有用的额外信息 Diffusion:在ControlNet指导下生成图像作品 三、ControlNet五大模型 1.Openpose 2.De

controlnet的preprocessor类型

GitHub - huggingface/controlnet_auxContribute to huggingface/controlnet_aux development by creating an account on GitHub.https://github.com/huggingface/controlnet_aux/https://huggingface.co/lllyasviel

ControlNet官方资源链接【ControlNet论文原文】【持续更新中~】

ControlNet官方资源链接 ControlNet论文原文:https://arxiv.org/abs/2302.05543ControlNet官方GitHub:https://github.com/lllyasviel/ControlNetControlNet 1.1官方GitHub:https://github.com/lllyasviel/ControlNet-v1-1-nightly

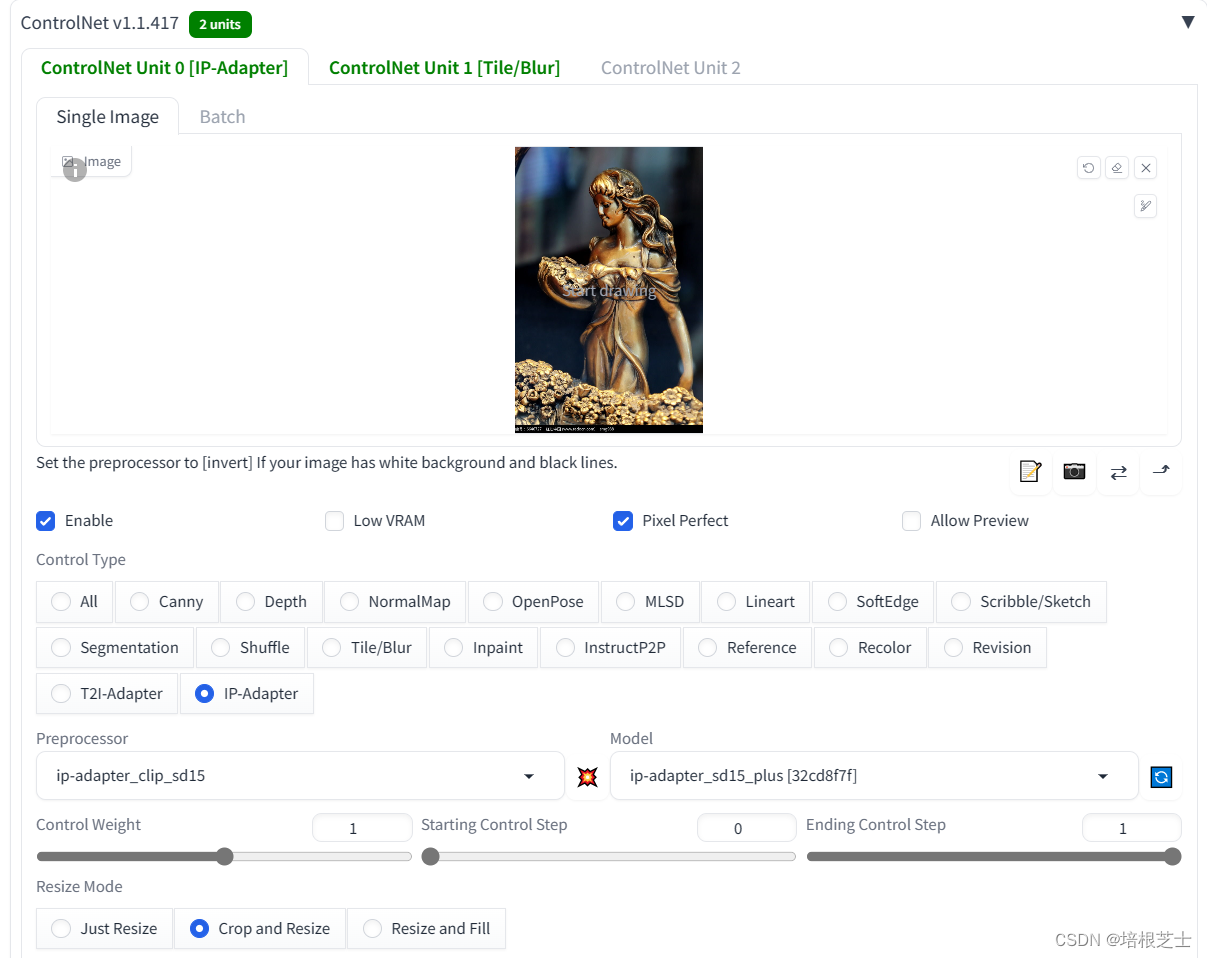

Stable Diffusion使用ControlNet:IP-Adapter实现图片风格迁移

IP-Adapter 全称是 Text Compatible Image Prompt Adapter for Text-to-Image Diffusion Models(文本到图像扩散模型的文本兼容图像提示适配器),是腾讯研究院出品的一个新的ControlNet模型,旨在使预训练的文本到图像扩散模型能够生成具有图像提示的图像。 IP-Adapter是一种有效的轻量级适配器,用于实现预训练文本

详细解读ControlNet作者最新力作:透明图层的生成模型LayerDiffusion

Diffusion models代码解读:入门与实战 前言:ControlNet的作者Lvmin Zhang的新作品LayerDiffusion,可以用于生成四通道带有透明图层的图片,这对于设计和落地是巨大的利好,因为业务场景下会有很多背景替换、人物替换的需求,从此告别抠图!这篇博客详细解读背后的原理,并解读代码和复现实验。 目录 贡献概述 方法详解 当前问题 整理

SDXL_webUI_controlnet使用depth_zoe错误解决

diffusers/controlnet-zoe-depth-sdxl-1.0 RuntimeError: Error(s) in loading state_dict for ZoeDepth:Unexpected key(s) in state_dict: 解决措施: Installing the right version of timm did the trick for me p

在stable diffusion中如何分辨lora、大模型、controlnet

LoRA (LowRank Adaptation) Stable Diffusion LoRA 是微软的研究人员为了解决大语言模型微调而开发的一项技术,它是一个多模态语言-图像模型,LORA 可以学习将其语言表征迁移到图像 modal 中从而获得跨模态语义一致的表示。LoRA 模型是 Stable-Diffusion 中的一个插件,仅需要少量的数据就可以进行训练的一种模型 LoRA

controlnet前向代码解析

ControlNet|使用教程 各模型算法说明以及使用解析 - openAI本本介绍了如何在Stable Diffusion中使用ControlNet生成高质量图片的方法,包括骨骼提取、边缘线处理、引导设置、语义分割、涂鸦等功能的详细介绍,帮助用户快速上手使用ControlNet。https://openai.wiki/controlnet-guide.htmlcldm:controlnet版本的

使用 Diffusers 实现 ControlNet 高速推理

自从 Stable Diffusion 风靡全球以来,人们一直在寻求如何更好地控制生成过程的方法。ControlNet 提供了一个简单的迁移学习方法,能够允许用户在很大程度上自定义生成过程。通过 ControlNet,用户可以轻松地使用多种空间语义条件信息 (例如深度图、分割图、涂鸦图、关键点等) 来控制生成过程。 具体来说,我们可以: 将卡通绘图转化为逼真的照片,同时保持极佳的布局连贯性。

【问题解决】| ControlNet训练为什么这么慢???关于模型量与显卡资源认知关系的建立

我觉得做深度学习相关的开发,要深刻认识到自己的显卡资源有多少,以及对应能做一些什么研究 比如今天的我就对这部分认识不深,终归还是实践代码少~缺乏经验 我觉得之后要多跑代码,多跑工程项目啊。 我今天做了一件什么事情 我企图在一张3080上训练5.3GB的ControlNet 我一开始没啥概念,反正就各种折腾好环境开始训练了,忽然发现,哦?为什么这么慢,慢的离大谱 1个epoch需要125

Photoshop抠图崩溃?试试ControlNet作者新作LayerDiffusion,一键生成透明背景图片!

以前制作透明背景的图片,我得花上好几个小时在Photoshop里面小心翼翼地抠图,稍微不注意就会抠坏,简直让人崩溃。 但是现在,有了LayerDiffusion,这些繁琐的步骤都可以省去了。 只需要输入一些简单的指令,它就能自动生成我想要的透明图片,简直是救星啊! LayerDiffusion是ControlNet作者的最新力作! 那么LayerDiffusion到底是怎么做到的呢?

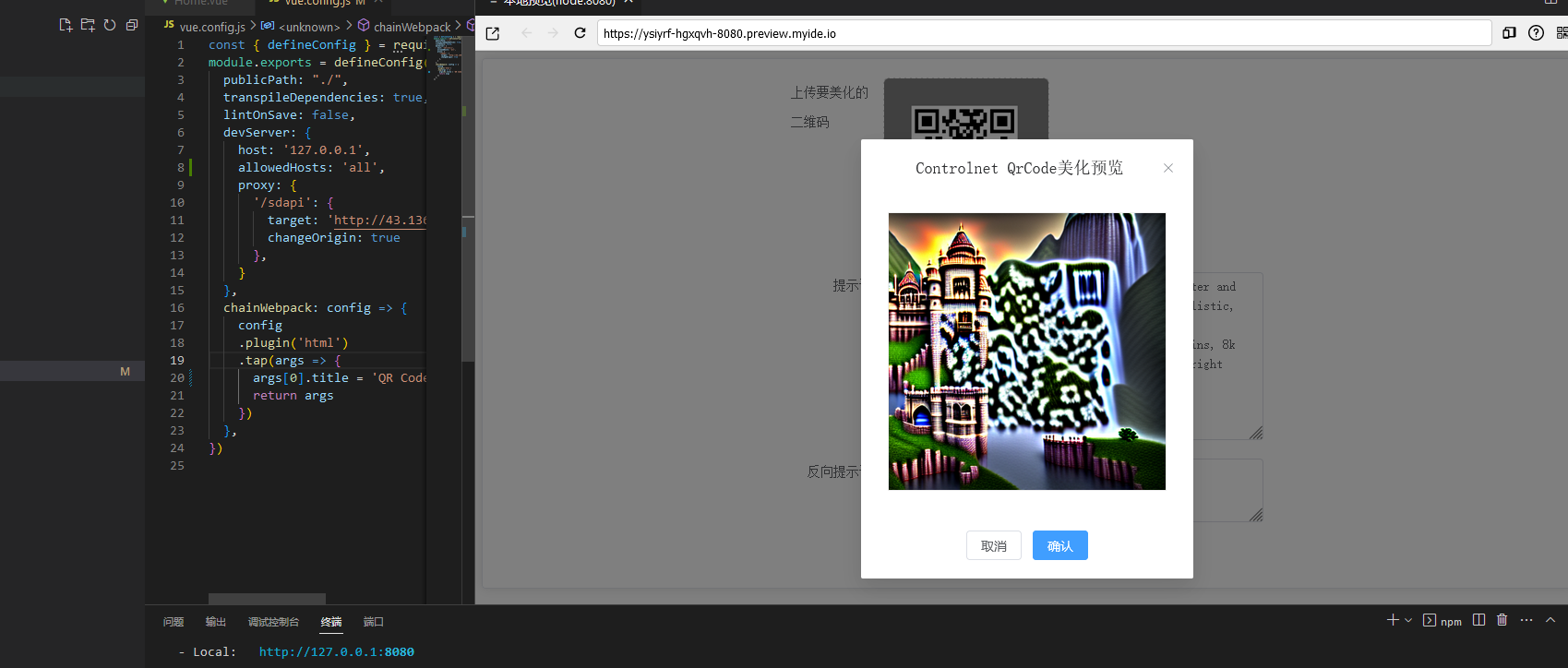

【腾讯云HAI域探秘】通过ControlNet实现二维码美化应用

文章目录 背景一、 前言二、 HAI 主要功能和应用场景三、HAI 实验前期准备3.1. 打开官网-申请资格3.2. 创建 SD实例3.3 ControlNet 介绍3.3 下载 QR Code Monster Model3.4 测试 QR Code Monster Model3.5 测试文生图 ControlNet API 四、构建二维码美化应用4.1. 项目中技术栈4.2. 通过gi

Stable Diffusion 绘画入门教程(webui)-ControlNet(Tile/Blur)

上篇文章介绍了y语义分割Seg,这篇文章介绍下Tile/Blur(增加/减少细节) Tile用于增加图片细节,一般用于高清修复,Blur用于减少图片细节(图片模糊),如下图,用Tile做修复:左边为原图(比较模糊),右边就是高清修复后的图(还是拿之前的小猫咪举例): 详细步骤,和前几篇依然一样: 文章目录 一、选大模型二、写提示词三、基础参数设置四、启用ControlNet

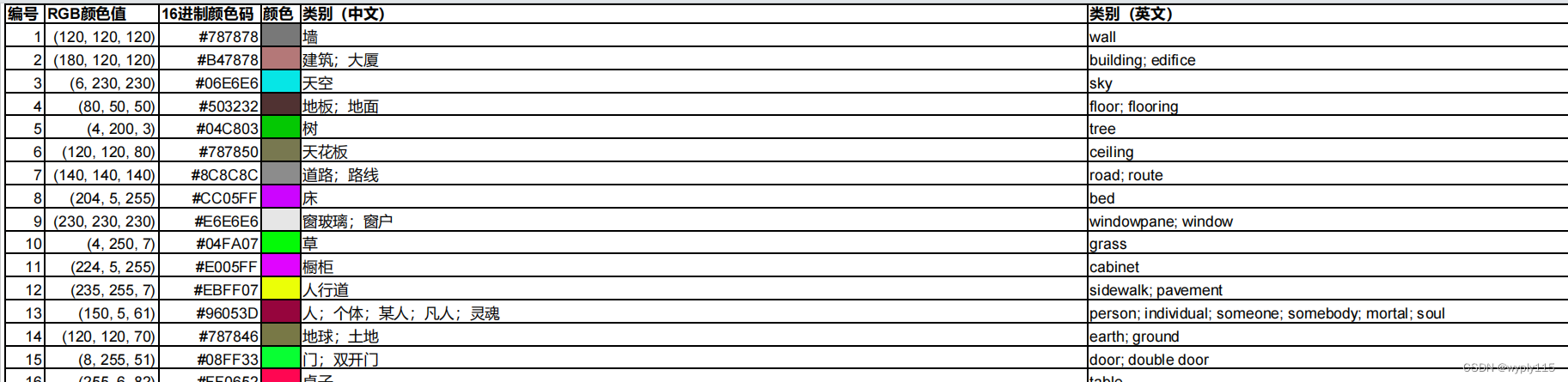

Stable Diffusion 绘画入门教程(webui)-ControlNet(Seg)

上篇文章介绍了深度Depth,这篇文章介绍下seg(Segmentation) 意思为语义分割, 通俗理解就是把图中的不同物体元素按类别不同,标为不同的颜色,不同的颜色代表不同的元素类别,如下图,左边为原图,右边就是语义分割后的预览图(还是拿之前的房子举例): 那么有什么玩法呢,如下图,我们可以保持图中物体类型不变,完全给他换一种风格: 详细步骤,和前几篇类似,不再赘述: 一、选大模

Stable Diffusion 绘画入门教程(webui)-ControlNet(线稿约束)

上篇文章介绍了openpose,本篇文章介绍下线稿约束,关于线稿约束有好几个处理器都属于此类型,但是有一些区别。 包含: 1、Canny(硬边缘):识别线条比较多比较细,一般用于更大程度得还原照片 2、MLSD(直线):这个只能识别直线,大部分用于建筑设计类居多 3、Lineart(线稿):相对Canny识别要少,但相对SoftEdge(软边缘)要多,一般用于真人和素描 4、SoftEdge

Stable Diffusion 绘画入门教程(webui)-ControlNet(姿态预处理器openpose)

本片文章接着上篇文章ControlNet介绍他的控制类型,本篇介绍的预处理器为openpose 预处理器:openpose 模型:control_v11p_sd15_openpose 没下载模型的看上篇文章去下载一下哦,不然用不了 文章目录 一、干什么用的二、详细用法1、选大模型2、写提示词3、基础参数设置4、启用controlNet 三、其他 一、干什么用的 这个处理

【AIGC】Stable Diffusion的ControlNet参数入门

Stable Diffusion 中的 ControlNet 是一种用于控制图像生成过程的技术,它可以指导模型生成特定风格、内容或属性的图像。下面是关于 ControlNet 的界面参数的详细解释: 低显存模式 是一种在深度学习任务中用于处理显存受限设备的技术。在这种模式下,模型会对输入图像进行一些调整或者采用一些技巧,以减少所需的显存占用,从而使模型能够在显存受限的设备上运行。

comfyui_controlnet_aux ‘cv2.gapi.wip.draw‘ has no attribute ‘Text‘

comfyui_controlnet_aux 引用时报错: import cv2 'cv2.gapi.wip.draw' has no attribute 'Text' 目录 方法1: 方法2: 方法1: 把comfyui_controlnet_aux改名为: aComfyUI_Controlnet_Aux 这个库调用排名第1个库就不报错了, 方法2: pip