本文主要是介绍Flux持续火爆,这些LoRA、ControlNet、工作流你值得拥有,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

大家好,我是每天分享AI应用的萤火君!

Flux自发布以来,受到了广大AI绘画爱好者的一致好评,远远的将SD3甩在了脑后,其出图质量媲美Midjourney。而且Flux迭代迅速,接连发布了Flux.1的开发模型和个人模型,其Lora模型、ControlNet模型也迅速推出,社区创作热情高涨。

为了让大家对Flux有一个全面的认识,本文将介绍下Flux基础模型、LoRA模型,以及ControlNet模型的使用方法。

因为Flux模型目前还不能在Stable Diffusion WebUI中使用,所以本文将以另一个常用的AI绘画工具 ComfyUI 为例进行讲解。同时为了方便大家测试,我在云环境也创建了一个ComfyUI的镜像,内置了Flux的模型和工作流,一键开启,不用费劲吧啦的部署。

Flux介绍

Flux是目前最大的AI绘画开源模型,有120亿个参数,原始文件有23GB那么大。听起来很吓人吧?但别担心,通过ComfyUI的支持,我们可以把模型压缩到12GB,并且它会自动检测显存来调整加载方式,这样我们在普通的消费级电脑上也能跑得动。

Flux 在视觉效果、提示的准确性、大小和比例的灵活性、排版和输出多样性方面,比Midjourney v6.0、DALL·E 3 (HD) 和 SD3-Ultra这些流行模型都要好。它可以在256到2048的宽分辨率范围内生成高质量、少冗余的图像,四肢表现也非常稳定。虽然对硬件有点要求,但效果真的很值。

Flux目前发布的 Flux.1 有三个版本,pro、dev和schnell。pro效果最好,但是闭源不开放;dev效果和pro差不多,虽然有商业使用的限制,但是可以免费测试(你懂的);schnell是个蒸馏模型,可以4步快速出图,效果虽然差点,但是也可以媲美Midjourney v6.0 和 DALL·E 3 (HD)。

使用云环境

云环境的地址:https://www.haoee.com/applicationMarket/applicationDetails?appId=27&IC=XLZLpI7Q

系统有一定的赠送额度,大家可以用几个小时,足够时间体验Flux了。

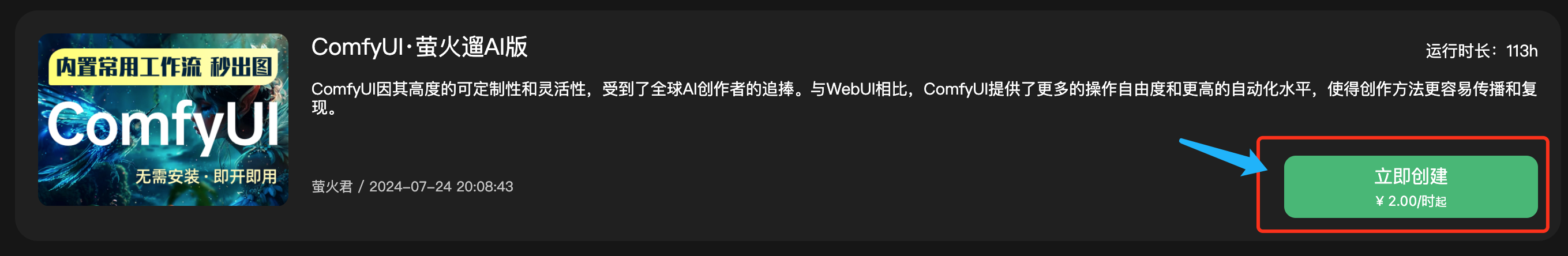

点击页面上的“立即创建”,即可开启 ComfyUI 应用,如下图所示:

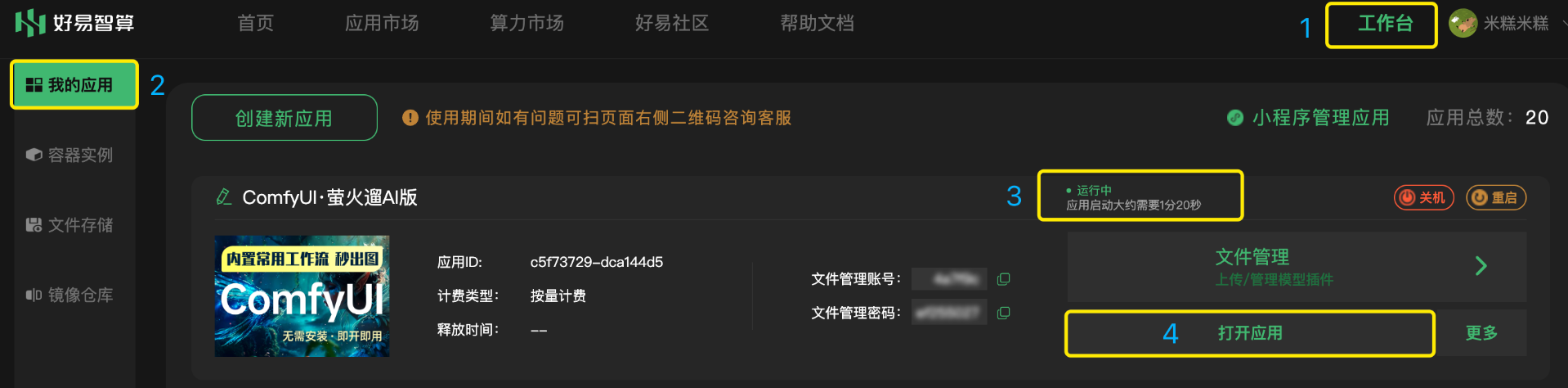

应用创建后会自动跳转至“工作台”。启动成功后,状态将显示为“运行中”,此时点击“打开应用”,即可在浏览器进入操作界面。本应用启动大约需要1-2分钟,如果打开页面显示空白,请刷新再尝试。

ComfyUI在浏览器中启动后,我们可以先通过设置切换到中文界面:

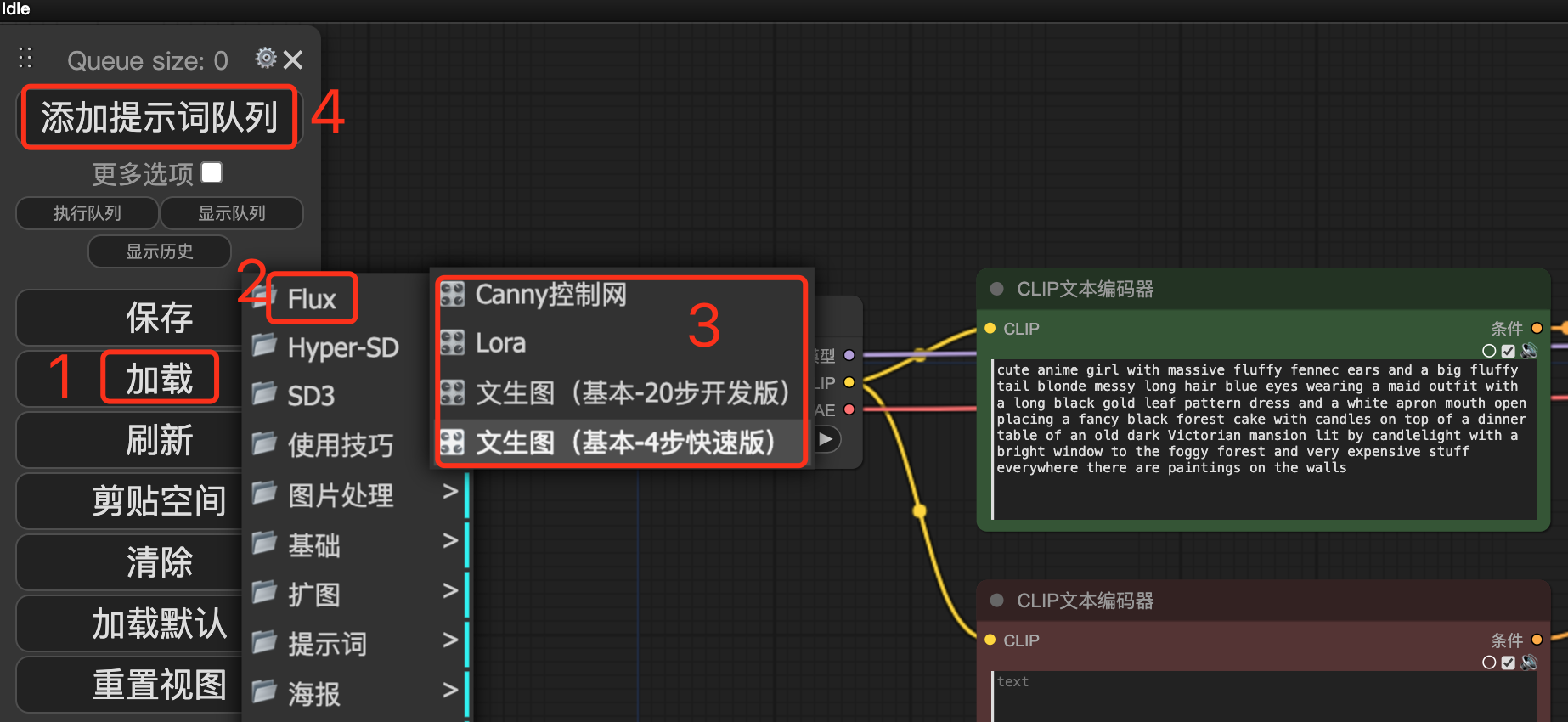

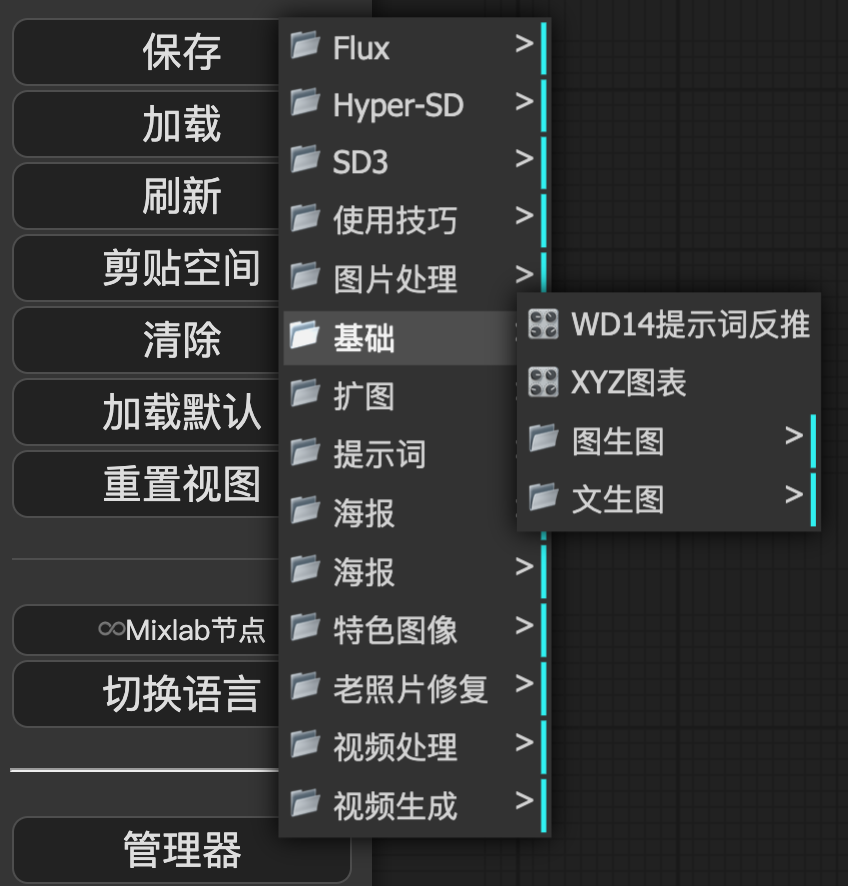

然后点击“加载”旁边的小箭头,选择一个“Flux”工作流,点击“添加提示词队列”,就可以开始愉快的生成了。

如果你懂一些技术,也可以通过手动启动镜像的方式来体验ComfyUI,镜像地址在这里:

https://bbs.haoee.com/postDetail/618

Flux基础模型的使用

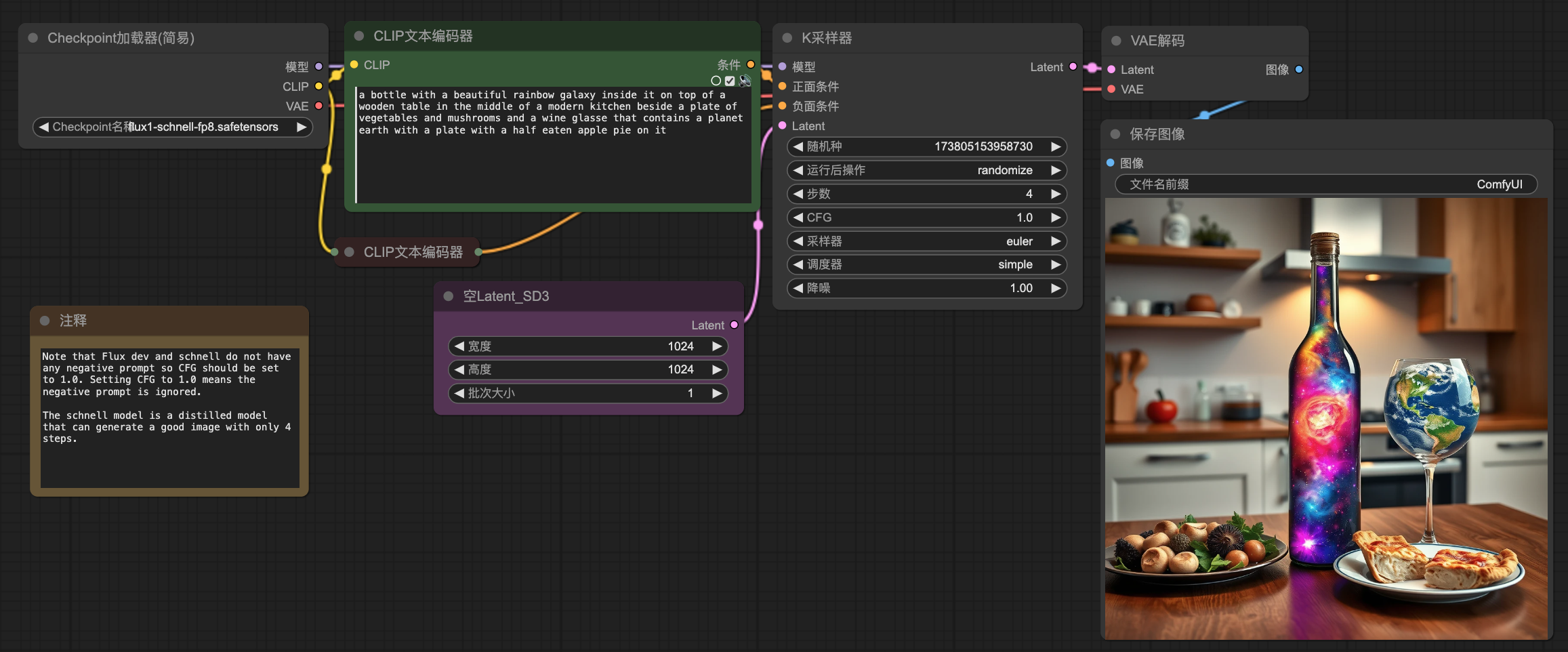

这里介绍两个基础模型的工作流:dev模型和schnell模型。

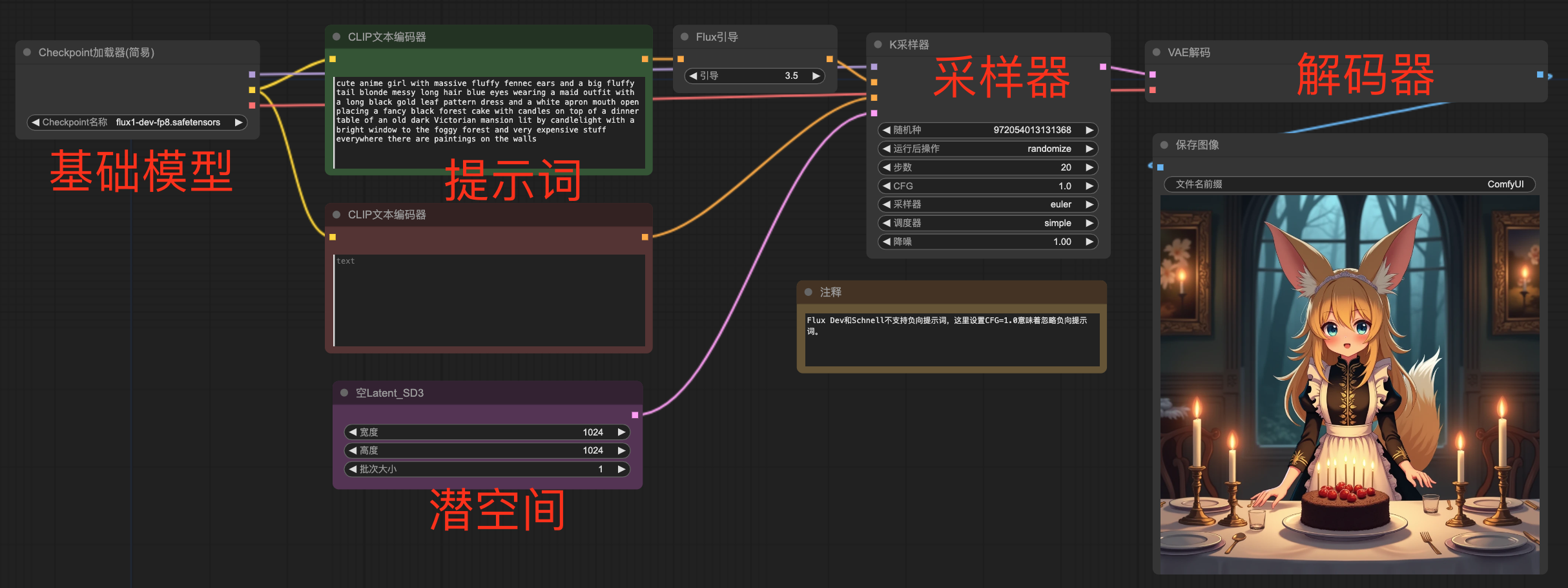

先看dev模型的工作流:Flux的工作流和其它SD模型的工作流没有太大的区别,都是:加载基础模型、编码提示词、定义潜在空间、采样器采样、解码器解码。

不太一样的就是这里增加了一个:Flux引导,Flux引导的目的是增强图片质量,生成训练时CFG为这个值的图像质量,但是不会降低生成速度;此时我们可以将CFG的值设置为1,用来提高生成速度,注意CFG的值不用太高,1-2.5即可;另外Flux.1还不能使用反向提示词。

再看schnell模型的使用:schnell 是个蒸馏模型,可以认为学习到了Flux原始模型的精华部分,这里不需要使用Flux引导,且只需要4步,图片的质量依旧很优秀。

另外这里用到的两个模型中都包含了提示词编码器CLIP和潜在空间解码器VAE,他们不用单独设置。

Flux LoRA模型的使用

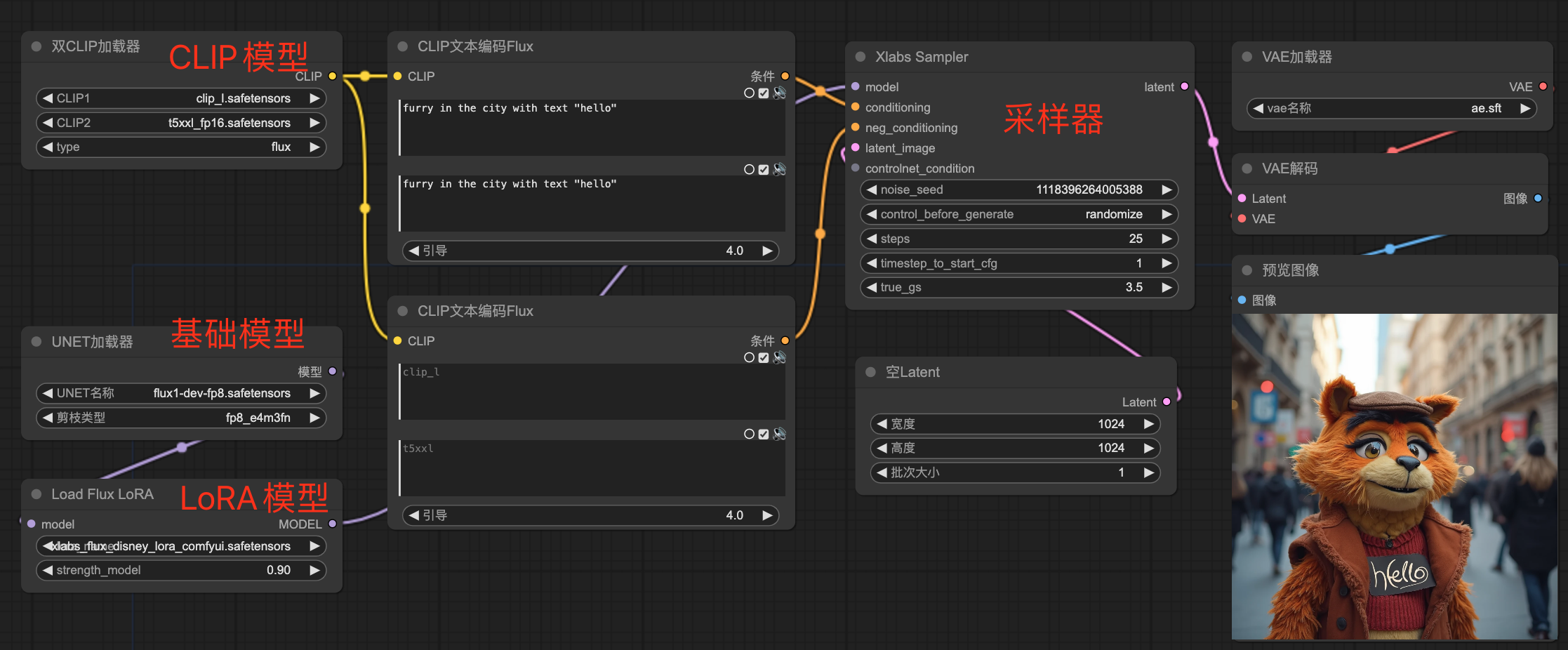

再看这个LoRA模型的工作流。

这里使用了双CLIP编码器,并单独加载了CLIP模型,SD3也使用了双CLIP编码,CLIP1可以看做是对标签类提示词的编码,CLIP2是对自然语言提示词的编码,这样编码对图片的质量比较好。另外我们还使用了“CLIP文本编码Flux”这个编码器,它自带Flux引导,就不用单独添加Flux引导节点了。

因为单独加载了CLIP模型,这里使用了UNET加载器来加载Flux的基础模型,加载LoRA也是使用的Flux专属节点,后边的采样器也是专为Flux量身定制的Xlabs Sampler。

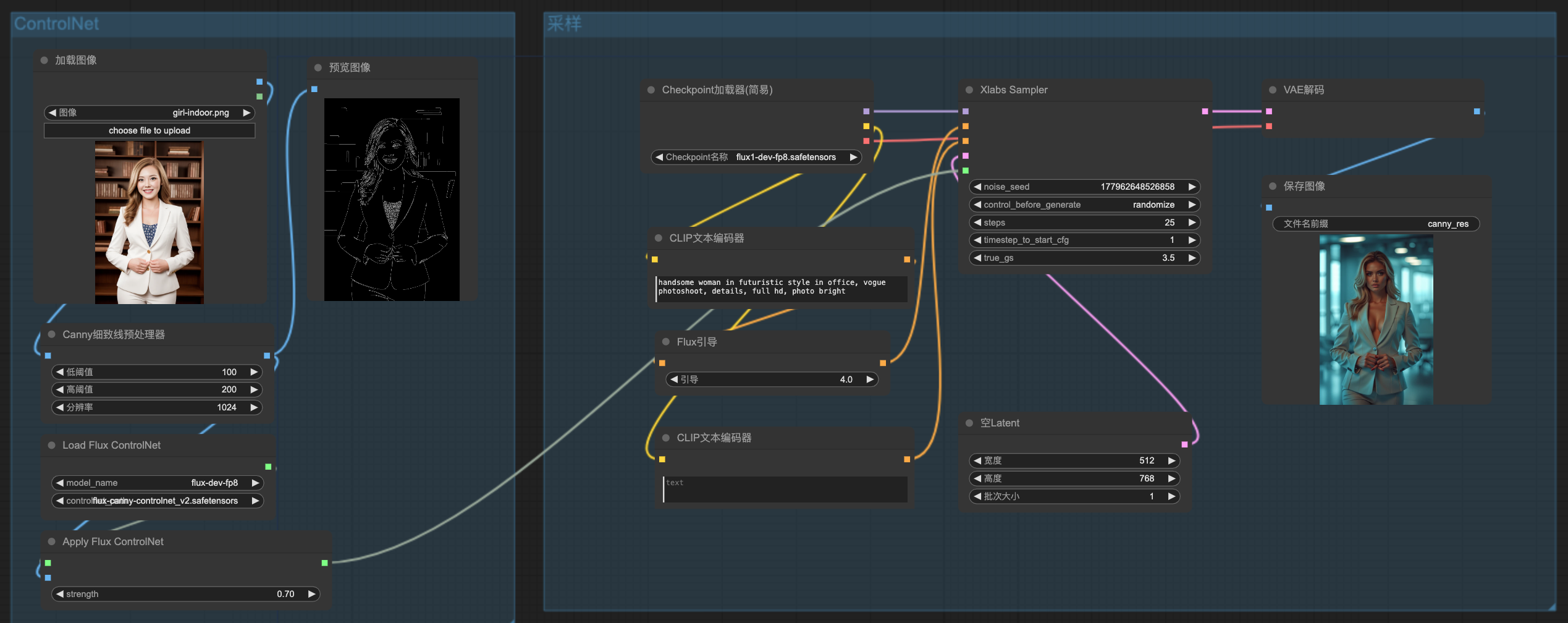

Flux ControlNet模型的使用

目前有三个适用于Flux的 ControlNet,分别是 Canny、Hed 和 Depth。这里以Canny为例:

工作流的左边是ControlNet的处理,右边是Flux采样部分的节点。

其中ControlNet的预处理器还是可以使用我们之前在SD1.5和SDXL使用的预处理器,但是加载和应用ControlNet模型要换成Flux专用的。

右侧的Flux采样使用的节点上边都介绍过了,这里就不废话了。有看不懂的地方,可以留言。

ControlNet模型正在快速迭代中,目前已经发布到了V3版本。

资源下载

以上工作流包括使用的模型,发消息“Flux”到公/众\号“萤火遛AI”即可下载。

为了方便大家入门,我整理了一批工作流,包括基本的文生图、图生图、ControlNet的使用、图片的处理、视频的处理等等,也可全部领取。

以上就是本文的主要内容,如有问题,欢迎留言。

用好 ComfyUI:

- 首先需要对 Stable Diffusion 的基本概念有清晰的理解,熟悉 ComfyUI 的基本使用方式;

- 然后需要在实践过程中不断尝试、不断加深理解,逐步掌握各类节点的能力和使用方法,提升综合运用各类节点进行创作的能力。

我将在后续文章中持续输出 ComfyUI 的相关知识和热门作品的工作流,帮助大家更快的掌握 Stable Diffusion,创作出满足自己需求的高质量作品,感兴趣的同学请及时关注。

这篇关于Flux持续火爆,这些LoRA、ControlNet、工作流你值得拥有的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!