本文主要是介绍[ICCV2023]RenderIH:用于3D交互手部姿态估计的大规模合成数据集,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

这篇论文的标题是《RenderIH: A Large-scale Synthetic Dataset for 3D Interacting Hand Pose Estimation》,作者是Lijun Li, Linrui Tian, Xindi Zhang, Qi Wang, Bang Zhang, Mengyuan Liu, 和 Chen Chen。他们来自阿里巴巴集团、上海人工智能实验室、北京大学机器感知重点实验室、佛罗里达中央大学计算机视觉研究中心。

摘要

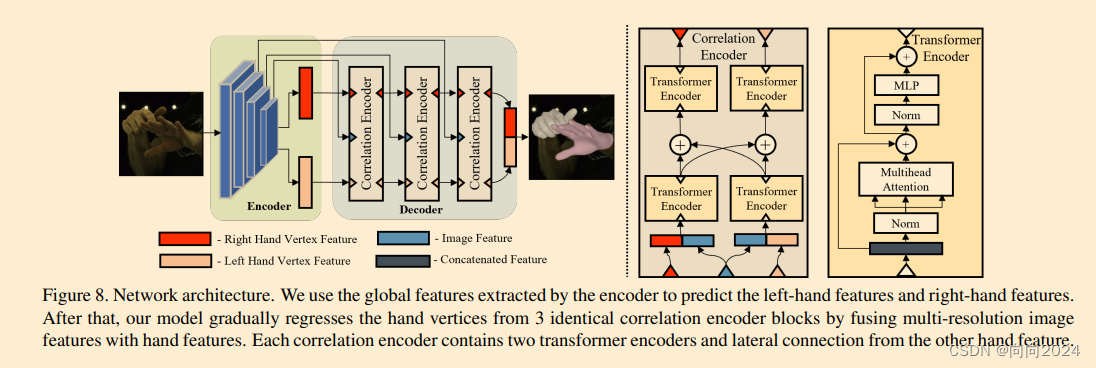

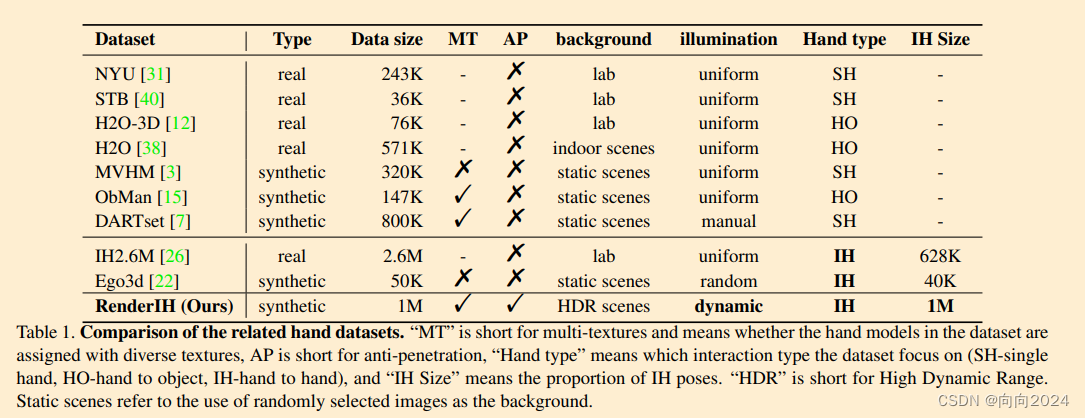

现有的交互手(IH)数据集在背景和纹理方面相对简单,手部关节由机器注释器标注,可能导致不准确,且姿态分布的多样性有限。然而,背景、姿态分布和纹理的可变性可以极大地影响泛化能力。因此,我们提出了一个大规模的合成数据集——RenderIH——用于具有准确和多样化姿态注释的交互手。数据集包含1M张具有不同背景、视角和手部纹理的照片真实感图像。为了生成自然和多样化的交互姿态,我们提出了一种新的姿态优化算法。此外,为了提高姿态估计的准确性,我们引入了一个基于变换器的手势估计网络TransHand,并验证了RenderIH在改进结果方面的有效性。我们的数据集是模型不可知的,可以提高任何手部姿态估计方法的准确性,与其他真实或合成数据集相比。实验表明,在我们合成数据上预训练可以显著降低误差,从6.76mm降低到5.79mm,我们的TransHand超越了当代方法。我们的数据集和代码可在以下链接获取:https://github.com/adwardlee/RenderIH。

主要贡献

- 提出了一种优化方法,用于生成有效和自然的手部交互姿态,这些姿态紧密耦合并避免相互穿透。

- 设计了高质量的图像合成系统,结合了丰富的纹理、背景和照明,确保了生成图像的多样性和现实性。

- 基于我们的数据生成系统,构建了一个大规模的高保真合成交互手数据集RenderIH,包含100万张合成图像和10万个交互手姿态。据我们所知,这是迄今为止最大和最高质量的合成交互数据集。

- 进行了广泛的实验来验证我们提出的RenderIH数据集的有效性。结果表明,借助我们的合成数据集,使用仅10%的真实数据就可以实现与在真实手部数据上训练的模型相当的准确性。我们还提出了一个基于变换器的网络,利用我们的数据集并取得了最先进的结果。

相关工作

论文回顾了现实手部数据集和合成手部数据集的相关研究,讨论了它们的挑战和局限性。

RenderIH数据集

RenderIH数据集的主要贡献是交互手姿态优化方法,可以生成有效和自然的手部姿态。在论文中,有效的姿态是指非穿透的手部且符合解剖约束。自然的姿态不仅符合解剖学,而且在日常活动中经常发生。我们均匀地结合了生成的姿态,包括各种手部纹理、高动态范围(HDR)背景和摄像机视角。所有收集的样本都是独立采样的,以创建尽可能多样化的图像。

方法

- 提出了一种新的手部姿态生成算法。

- 展示了如何渲染合成图像。

- 简要介绍了RenderIH数据集的一些统计信息。

实验

- 在IH2.6M数据集上进行了大部分实验。

- 实验设置、实现细节、评估指标和结果分析。

结论

本文提出了一个新的大规模合成数据集RenderIH,用于3D IH姿态估计。通过各种实验研究了RenderIH的有效性。通过使用全部合成手部图像和仅10%的真实手部图像,我们可以实现与在所有真实手部图像上训练的相同方法相当的精度。我们希望这个数据集能够成为开发不依赖真实数据并且能够适应各种场景的3D IH姿态估计模型的有意义的一步。

补充材料

补充材料包含了由于空间限制而无法包含在主要手稿中的额外信息。我们将首先提供有关数据集的更多详细信息。然后,我们将简要讨论我们方法中的姿

这篇关于[ICCV2023]RenderIH:用于3D交互手部姿态估计的大规模合成数据集的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!