手部专题

pico手柄和人物模型手部旋转同步,实现手柄控制手臂手部位置移动、手部旋转和手指的操作了

这里的主要内容就是下述代码; // 获取左手控制器的旋转(四元数表示)Quaternion aRotationQuaternion = leftHandController.rotation;// 计算旋转差值(四元数表示)Quaternion rotationDifference = Quaternion.Euler(0, -90, -90);// 应用差值到左手控制器的旋转并获取新的四元数

搜维尔科技:Manus VR高精度手部动作捕捉数据手套为人形机器人、人工智能和人机交互赋能

Manus Quantum数据手套能够提供实时端到端的手部动作数据流与高精度数据集,助力人形机器人实现快速发展。 Quantum量子数据手套采用毫米级精度的磁性指尖跟踪传感器,融入尖端的EMF磁性定位追踪技术,无漂移,能提供高度准确且可靠的手指动作捕捉数据,为人形机器人、人工智能和机器学习赋能。 Manus是一家专注于开发高精度创新型人机交互设备的高科技公司,致力于手指跟踪技术的研究与开发,旨

AI小白福音来啦~Flux文生图,支持手部细节,直出精美图像,让你瞬间变高手!

国产AI绘画软件在近年来发展迅速,其中千鹿设计助手的“Flux 文生图”插件受到了用户的关注。根据搜索结果,Flux文生图插件以其强大的功能和易用性,为设计师提供了便捷的服务。以下是关于Flux文生图插件的测评和使用指南: 工具准备:要使用Flux文生图,首先需要访问千鹿设计助手的官网下载并安装软件,并使用邀请码EmGaur:完成注册。 插件安装:安装完成后,可以通过快捷键Alt+空格呼出搜

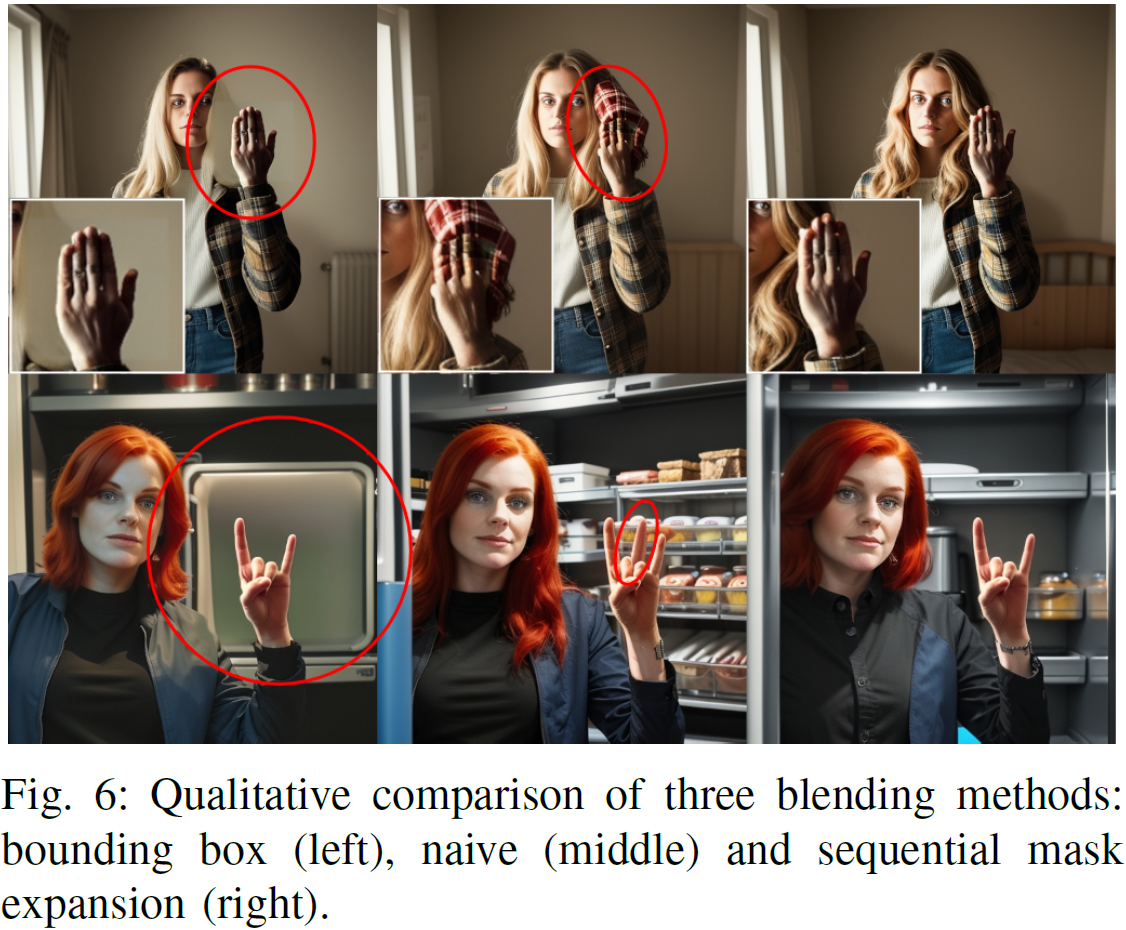

AI绘画遇手部瑕疵?修复教程在这里!最简单的AI修手教程

众所周知,AI生成的手指经常会出问题,比如生成多个手指,麻花手指,或者是以不可思议角度扭曲的手指。 这里提供一个简单的,基于批量抽卡(批量生成)的修手方案,简单到只有2步,循环到自己彻底满意为止。 先来看看效果! 怎么样?看起来还不错吧! 下面来看看怎么操作! 第一步,涂抹! 图生图,局部重绘,将不满意的手指部分涂抹覆盖! 这一步要注意的是尽量保留完整的手指,哪怕稍微有些瑕疵也不

告别手抖尴尬!教你轻松缓解手部震颤的小秘诀!

在我们的日常生活中,手抖这个现象可能并不罕见。不论是因为紧张、疲劳还是某些健康问题,手抖都会给我们的生活带来诸多不便。今天,就让我们一起探讨如何缓解手部震颤,让你告别手抖的尴尬! 一、手抖的成因及影响 手抖,医学上称为震颤,是指手部不自主地、有节律地颤动。手抖的成因多种多样,包括生理性手抖(如紧张、疲劳、寒冷等)和病理性手抖(如帕金森病、甲状腺功能亢进等)。手抖不仅影响我们的日常生活,如写

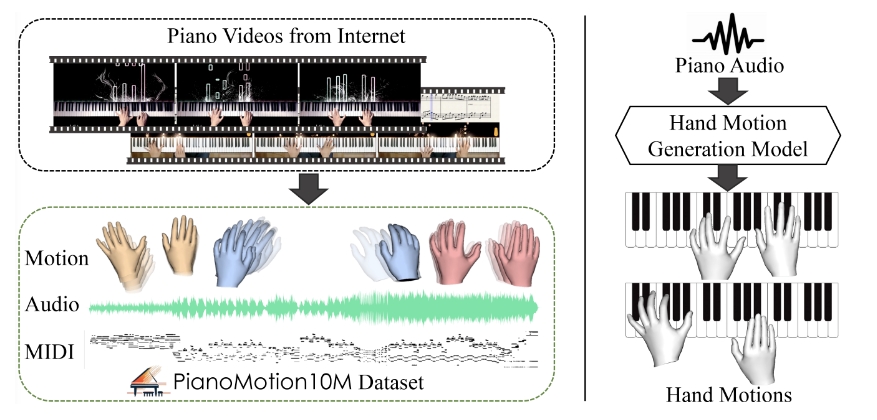

开源的代码语言模型DeepSeek-Coder-V2;Runway推出Gen-3;多层架构整合多个大语言模型;大规模钢琴手部动作数据集和基准

✨ 1: DeepSeek-Coder-V2 开源的多专家代码语言模型,支持338种编程语言。 DeepSeek-Coder-V2 是一个开源的代码语言模型,专为代码生成、代码补全、代码修复以及数学推理等任务而设计。该模型通过在大量高质量的多源语料库上进一步训练,显著提升了其在代码生成和数学推理方面的能力,同时在一般语言任务中的表现也保持在同等水平。DeepSeek-Coder-V2

UnityXR Interaction Toolkit 如何使用XRHand手部识别

前言 Unity的XR Interaction Toolkit是一个强大的框架,允许开发者快速构建沉浸式的VR和AR体验。随着虚拟现实技术的发展,手部追踪成为了提升用户交互体验的关键技术之一。 本文将介绍如何在Unity中使用XR Interaction Toolkit实现手部识别功能。 准备工作 在开始之前,请确保你的Unity项目已经正确设置了XR Interaction Toolki

sd手部异常的修复和重绘

助教老师: 用多个controlnet模型来生成 分别是openpose depth softedge,你可以试试,这样出的图手部也还不错 再加上正向和负向的手部提示词 三个同时启用 比用openpose editor直接调整的效果更好 对电脑性能要求会高些 或者也可以试下controlnet的hand-refiner预处理器 手部异常的修复和重绘目前仍然是AI绘图的一个经典问题,现在有的方式

极市平台 | 手部动作识别相关开源数据集汇总

本文来源公众号“极市平台”,仅用于学术分享,侵权删,干货满满。 原文链接:手部动作识别相关开源数据集汇总 极市导读 本文汇总了手部动作识别相关的数据集资源,均附有下载链接。 1 撒哈拉LMC手语数据库 数据集下载地址:https://www.cvmart.net/dataSets/detail/961 Sahand LMC 手语数据库由 32 个类别组成,包括 24 个美国字母(J

[ICCV2023]RenderIH:用于3D交互手部姿态估计的大规模合成数据集

这篇论文的标题是《RenderIH: A Large-scale Synthetic Dataset for 3D Interacting Hand Pose Estimation》,作者是Lijun Li, Linrui Tian, Xindi Zhang, Qi Wang, Bang Zhang, Mengyuan Liu, 和 Chen Chen。他们来自阿里巴巴集团、上海人工智能实验室、北

mediapipe人体姿态检测(全方位探索手部、面部识别、姿势识别与物体检测及自拍分割技术)

引言 本文将聚焦于MediaPipe对人体姿态检测的全面支持,包括手部、面部识别、全身姿势识别、物体检测以及自拍分割五大关键技术。通过深入了解这些功能,读者将能更好地运用MediaPipe在各种应用中实现精准的人体动作捕捉与分析。 一、手部关键点检测 MediaPipe的手部关键点检测模块(`mediapipe.solutions.hands`)能够实时识别和追踪双手的21个关键点,包括

(2024,手部生成,关键点热图,修复和外画,SD)Giving a Hand to DM:改进条件人类图像生成的两阶段方法

Giving a Hand to Diffusion Models: a Two-Stage Approach to Improving Conditional Human Image Generation 公和众和号:EDPJ(进 Q 交流群:922230617 或加 VX:CV_EDPJ 进 V 交流群) 目录 0. 摘要 2. 相关工作 3. 方法 B. 多任务手部生成

AI新工具(20240327) 自动生成带有精确躯干和手部动作的主播风格视频;新型AI搜索thinkany.ai;小米发布图像生成技术SDXS

✨ 1: Make-Your-Anchor 自动生成带有精确躯干和手部动作的主播风格视频 Make-Your-Anchor是一种革新性的系统,它允许用户仅使用一个人为期一分钟的视频片段进行训练,进而自动生成带有精确躯干和手部动作的主播风格视频。这样的系统特别适合于需要产生个性化视频内容的场景,例如虚拟新闻播报、在线教育或个人娱乐。下面是 Make-Your-Anchor 功能的通俗总结

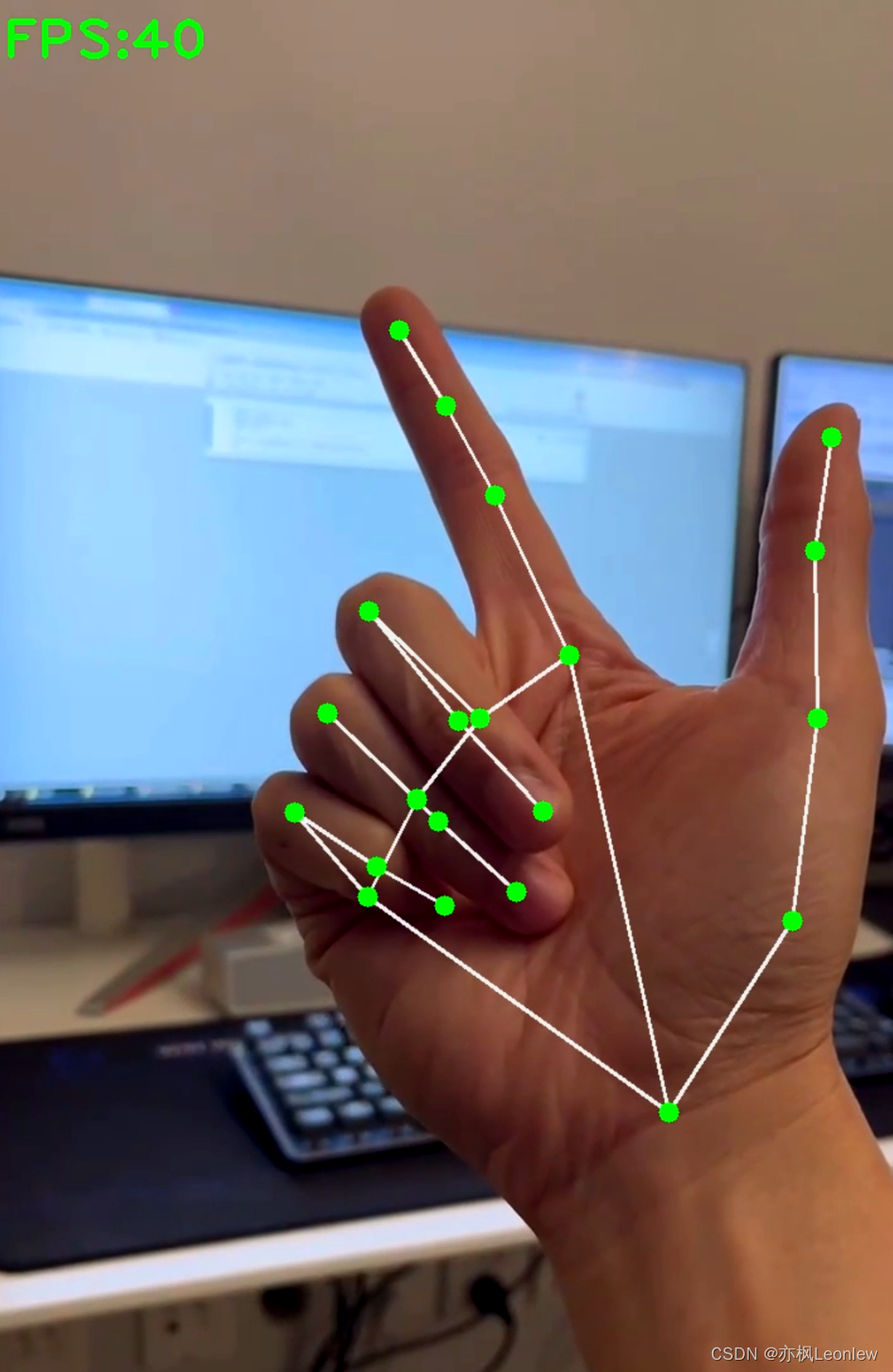

手部关键点抓取及手部追踪

当我们可以追踪手部关键点的时候我们就可以进行一些手语的识别或者手势含义方面的应用,本文讲采用opencv以及mediapipe两个模组对首部关键点进行编码。 这是我们要采集的21个点。当我们把这21个点找出来之后,我们就可以大概知道手部动作了。 首先引进这两个个模组 然后我们需要引入我们的摄像头,用opencv来调取。然后接下来就要用到mediapipe这个模组,

Python Opencv实践 - 手部跟踪

使用mediapipe库做手部的实时跟踪,关于mediapipe的介绍,请自行百度。 mediapipe做手部检测的资料,可以参考这里: MediaPipe Hands: On-device Real-time Hand Tracking 论文阅读笔记 - 知乎论文地址: https://arxiv.org/abs/2006.10214v1Demo地址:http

目标检测YOLO实战应用案例100讲-【目标检测】基于深度学习的手部增强现实技术(续)

目录 2.2.3相机畸变矫正原理 3 自上而下的多目标姿态估计神经网络 3.1基于Yolo X的手掌检测

stable diffusion学习笔记 手部修复

图片手部修复原理 某张图片在生成后,仅有手部表现不符合预期(多指,畸形等)。这种情况下我们通常使用【局部重绘】的方式对该图片的手部进行【图生图】操作,重新绘制手部区域。 但是仅采用重绘的方式也很难保证生成的手没有问题。因此这里我们采用【contorlNet】进行辅助,定向生成某种手部的形状。 Depth Library depth library是stable diffusion里的一

基于oneAPI实现工业级手部骨架姿态识别

【oneAPI DevSummit & OpenVINODevCon联合黑客松】 随着制造与工业领域的发展,对于更高效、智能、安全的生产方式需求的日益增长。同这次大赛,带给我们的新的灵感和技术支持。于是我们基于英特尔oneAPI基础工具套件。开发了一款基于手部骨架姿态识别的现实交互系统,利用oneAPI中的并行计算框架,Intel Threading Building Blocks (TBB)

基于yolov2深度学习网络的视频手部检测算法matlab仿真

目录 1.算法运行效果图预览 2.算法运行软件版本 3.部分核心程序 4.算法理论概述 5.算法完整程序工程 1.算法运行效果图预览 输入mp4格式的视频文件进行测试,视频格式为1080p@30. 2.算法运行软件版本 matlab2022a 3.部分核心程序 ............................................

手部骨骼跟踪能力,打造控制虚拟世界的手势密码

AR作为一项增强现实技术,带来了虚拟数字世界与现实世界的深度融合,这种虚实融合,不仅能应用于虚拟汽车展示、虚拟室内设计等视觉交互场景,更可通过动作交互控制虚拟世界场景,实现无边界的人机互动。 比如人们在拍摄短视频时,可以不接触屏幕,仅通过做出特定手势来控制特效切换;也可以在拍照时通过手势识别控制快门拍摄;还可以实现试用美甲款式、戒指试戴等。以上AR应用场景需做到精确的手部识别,这就要用到AR E

高通将在MWC推出骁龙835 VR一体机方案,整合Leap Motion手部追踪

[] http://www.leiphone.com/news/201702/PuicWloTkIoZzG6n.html 骁龙 820 一体机参考设计 MWC 2017 即将于 2 月 27 日开幕,根据外媒 UploadVR 报道,高通将在 MWC 上推出新的骁龙 835 VR 一体机方案。该方案将配备 2560×1440 AMOLED 屏幕,6DoF 追踪,眼球追踪,注视点渲

Python Opencv实践 - 手部跟踪

使用mediapipe库做手部的实时跟踪,关于mediapipe的介绍,请自行百度。 mediapipe做手部检测的资料,可以参考这里: MediaPipe Hands: On-device Real-time Hand Tracking 论文阅读笔记 - 知乎论文地址: https://arxiv.org/abs/2006.10214v1Demo地址:http

【1】MediaPipe手部识别示例代码

上回说到,mediapipe如何安装,这回我们来看看mediapipe是如何识别手的位置和返回坐标的。 首先我们调用mediapipe库 import mediapipe as mpimport cv2import numpy as np 之后我们使用此代码进行识别 mp_drawing = mp.solutions.drawing_utilsmp_drawing_styles =

手势识别4:C/C++实现手部检测和手势识别(含源码下载)

手势识别4:C/C++实现手部检测和手势识别(含源码下载) 目录 手势识别4:C/C++实现手部检测和手势识别(含源码下载) 1. 前言 2. 手势识别模型(YOLOv5) (1)手势识别模型训练 (2)将Pytorch模型转换ONNX模型 (3)将ONNX模型转换为TNN模型 3. 手势识别模型C++部署 (1)项目结构 (2)配置开发环境(OpenCV+OpenCL+bas

tensorflow包_使用 MediaPipe 和 TensorFlow.js 在浏览器中追踪面部和手部

来源:TensorFlow 本文约2626字,建议阅读5分钟 本文介绍用于追踪面部和手部关键特征点的两个新包:Facemesh 和 Handpose。 近日我们发布了两个新包:Facemesh 和 Handpose,分别用于追踪面部和手部关键特征点。此次发布的包是 Google Research MediaPipe 和 TensorFlow.js 团队的合力之作。 在浏览器中试用实时演示版

![[ICCV2023]RenderIH:用于3D交互手部姿态估计的大规模合成数据集](https://img-blog.csdnimg.cn/direct/0911444a512445cabc03582074ab85cc.png)