本文主要是介绍手部骨骼跟踪能力,打造控制虚拟世界的手势密码,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

AR作为一项增强现实技术,带来了虚拟数字世界与现实世界的深度融合,这种虚实融合,不仅能应用于虚拟汽车展示、虚拟室内设计等视觉交互场景,更可通过动作交互控制虚拟世界场景,实现无边界的人机互动。

比如人们在拍摄短视频时,可以不接触屏幕,仅通过做出特定手势来控制特效切换;也可以在拍照时通过手势识别控制快门拍摄;还可以实现试用美甲款式、戒指试戴等。以上AR应用场景需做到精确的手部识别,这就要用到AR Engine的手部骨骼跟踪能力。

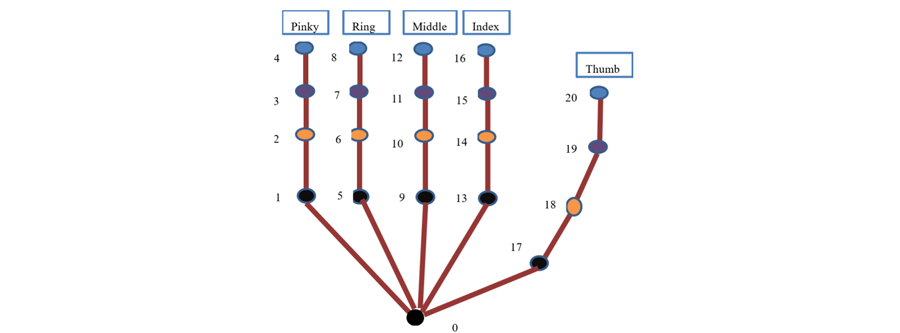

手部骨骼跟踪能力可识别和跟踪21个手部关节点的位置和姿态,并输出手指端点、手掌朝向、手部骨骼等手部高级特征,形成手部骨骼模型。当图像中出现多只手时,只反馈最清晰置信度最高的手的识别结果和坐标信息,目前仅支持可获取深度信息的指定华为机型。

通过手部骨骼识别能力,可将虚拟物体叠加到更为精确的手部位置,例如手指尖、手掌心等;利用手部骨骼,可驱动虚拟手做出更为丰富和精细的操控动作,能够为AR应用提供增强的交互功能,便于拓展更多新奇的玩法。

手部骨骼定义图

应用场景

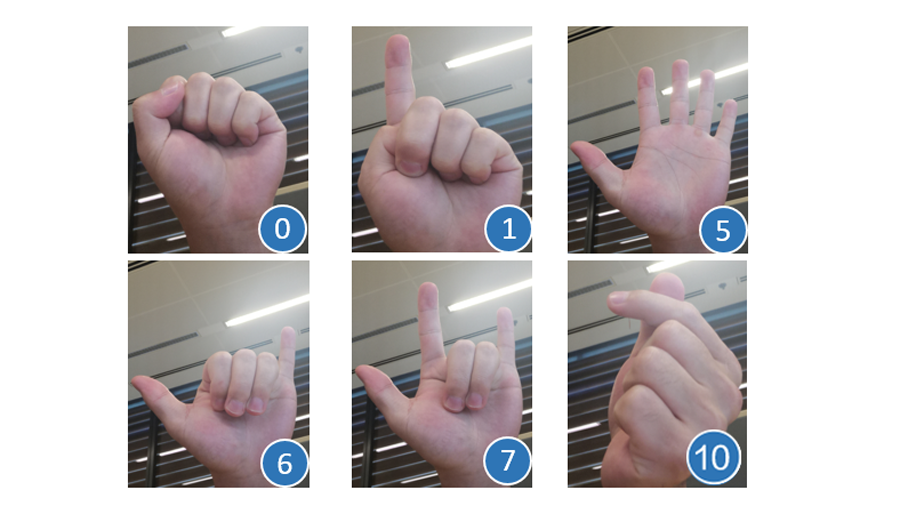

一、简单的手语翻译

手部骨骼跟踪能力可以形成简单的手语理解。在对手部骨骼关键点进行提取的基础上,根据关键点的变化预测手部姿态,可以将弯曲、竖直等手指状态集映射到一组预定义的手势,比如食指直直伸出就代表计数手势“1”,通过此类算法推导出的手势动作,就是形成手语理解的基础,可应用于手语的识别和翻译。

二、构建非接触式操作界面

科幻电影中常常会出现人物隔空操作电脑界面的场景,而此类功能基于手部骨骼跟踪能力也可以实现。

通过摄像头对手部骨骼的识别跟踪,可精确定位指尖等关键节点信息,从而实现对虚拟对象的物理交互。比如使用手指按下虚拟按钮或其他UI元素;捏住虚拟对象并释放菜单项;拉伸较大对象上的小目标等物理控制;甚至用手重新调整对象大小或将其存储在虚拟口袋中等等。

该功能可应用于医疗行业的机械控制、机车界面控制等。

三、短视频直播互动

AR Engine的手部骨骼跟踪能力也可以在短视频传播过程中增添一些手部特效,比如当用户在拍摄短视频或直播时做出比耶、点赞、比心等指定手部动作时,可识别用户手势并叠加相应的特效或贴纸,实现手势触发特效、手部特效跟踪等效果,丰富视频直播过程中的交互体验。

除此之外,手部骨骼跟踪能力还可应用于影视动画制作、儿童教学、医学康复、智能家居控制等领域。

在AR技术快速发展的今天,基于手势识别的人机交互已逐渐成为热点,如何实现自然的、符合人类习惯的手势识别,是人机交互接口中的一个重要组成部分,作为手势识别的一项基础能力,手部骨骼跟踪也凸显出了在该领域的重要地位。华为AR Engine希望该能力能够帮助开发者们激发出更广泛的研究方向和更具创新力的实际应用。

了解更多详情>>

访问华为开发者联盟官网

获取开发指导文档

华为移动服务开源仓库地址:GitHub、Gitee

关注我们,第一时间了解 HMS Core 最新技术资讯~

这篇关于手部骨骼跟踪能力,打造控制虚拟世界的手势密码的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!