本文主要是介绍Adversarial Complementary Learning for Weakly Supervised Object Localization模型解析(基于对抗互补学习的弱监督目标定位),希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

GitHub - junkwhinger/adversarial_complementary_learning

1.背景:

学习仅使用图像级监督来定位感兴趣的对象的深度模型非常困难

早先处理方式:

根据预先训练的卷积分类网络生成类的定位图,通过用一个全局平均池化层和一个全连接层来替换分类网络的最后几层(AlexNet和VGG-16),从而聚合最后一个卷积层的特征用来生成CAM.

存在的问题:

- 在图像分类时过度依赖那些对分类有帮助的明显的特征

- 不能在图像中密集地定位目标物体的积分区域.

这两个问题主要是由于分类网络倾向于从最具辨别力的部分识别模式以进行识别,这不可避免地导致第二个问题。 例如,给定包含猫的图像,网络可以通过识别头部来识别它,而不管诸如身体和腿部的其余部分。

解决方法及弊端:

方法1:对抗性擦除(Adversarial erasing (AE))方法来发现整体对象区域,对抗擦除,学习到部分特征,我把这个部分擦除掉,再训练一个新的网络,从而使用多个网络学习到全部特征。但这种方式网络太多;

方法2:.随机遮挡图像的一部分,强行让网络学习完整的特征。但这种随机的方式,不能保证每次能学习到新的特征。

2.本文提出的方法:

对抗互补学习(ACoL),以便在弱监督下自动定位语义兴趣的整体对象.

本文证明了

- location map可以通过选择最后一个卷积层的class-specific feature maps直接获得,从而提供了一个简单的方式识别目标区域.

- 本文采用两个平行的分类器来获得object-location.

ACoL的演示过程:

- 先训练A分类,然后找出对应类别的feature map.

- 在训练B的过程中把这A部分的feature map擦除,因此B可以再学到该类别的其他区域.

- 然后再把B的特征图拿去擦除A,让A去学习B的补集,这样循环互补.最后,将两个分支的目标定位图进行融合,得到完整的目标区域。

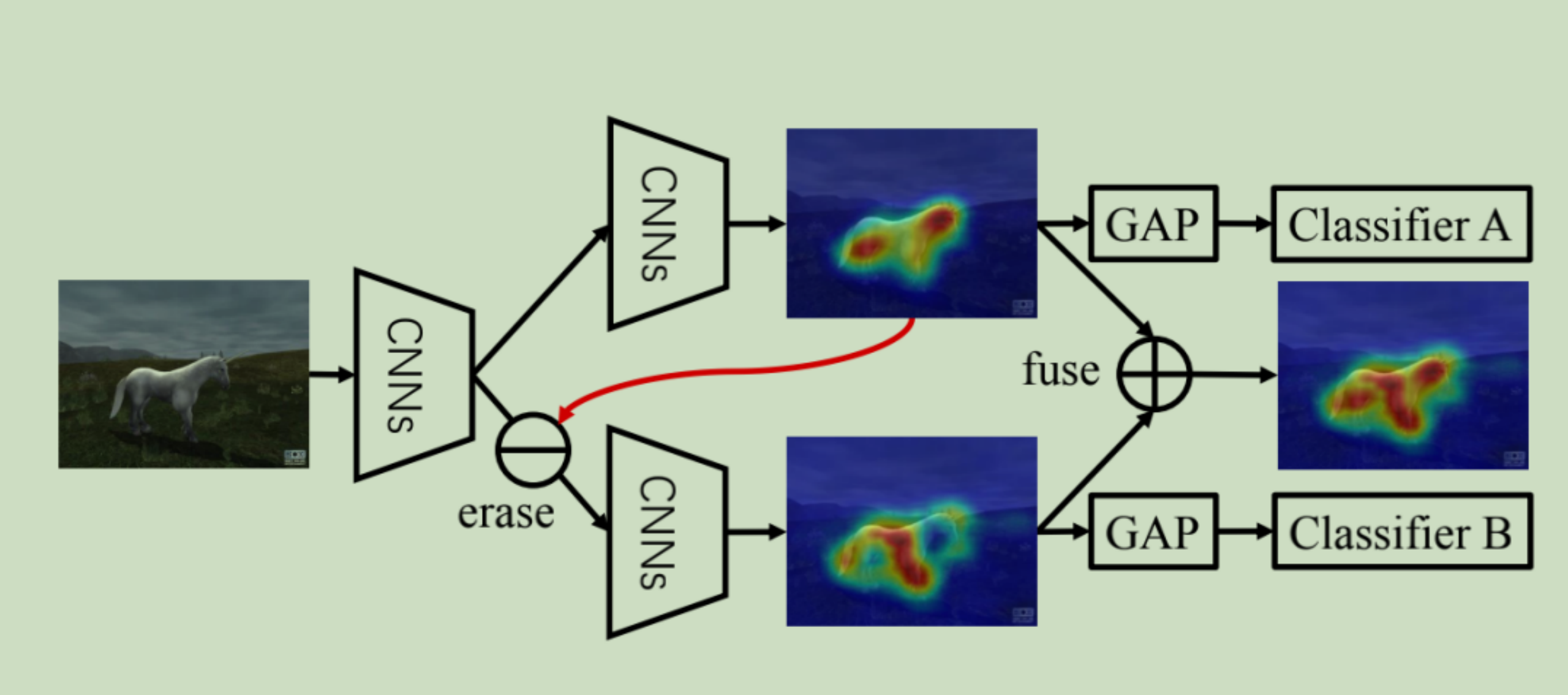

如图所示:

图片输入到CNN网络,提取到特征图(公共特征层)后将输入两个CNN分支(我认为这张图画的不是很严谨,因为三个CNN从代码里面看并不是同一个网络.)

提取出的特征进入第一个分支后会检测出某些内容,如图检测出了马的头和尾巴.

之后再把已经定位到的位置(头和尾巴)擦除(erase),再将新的特征图输入第二个CNN分支.因为擦除操作所以无法检测出头和尾巴,因此在第二个分支中检测到了前腿.

最终通过将两个分支融合得到了完整的定位图.

ACoL与AE相比的优势:

-

将两个分类器整合成一个网络,而AE独立地训练三个网络来进行对抗性擦除;

-

AE需要不断迭代的产生map,他必须forward network多次,但是本文只用一次

-

AE采用CAM来产生localisation map图,因此需要分为两步,本文只用一步, 参考Learning Deep Features for Discriminative Localization.

3.ACoL结构:

提出的ACoL共有三个组成部分

- Backbone:一个全卷积网络用来特征提取.可以是VGG;ResNet etc(这里用的是Resnet). 用来检测特征(mid-level feature map).因为前面不会把特征提取的很详细.

- ClassifierA

- ClassifierB

def forward(self, inputs, labels):x = self.backbone(inputs) #middle level future mapscls_output = []cams = []for idx, cls in enumerate(self.cls_recipe): #pp模型 #[p,p] 1,poutput = self.classifiers[idx](x).squeeze(-1).squeeze(-1) ##将middle level特征图分别传进两个分支cls_output.append(output)cam = self.generate_cam(idx, x, labels)

#[0.9,0.91,0.80] [F,T,F] [0,1.0] (热力图中红色的部分是1)

#[0.9,0,0.8] (擦除操作:用0替代1)cams.append(cam)if idx < len(self.cls_recipe) - 1:mask = (cam > self.deltas[idx]).unsqueeze(1).byte() #deltas的值设置为0.9x = x.masked_fill(mask, value=0) #擦除. else:v_cls_output = torch.stack(cls_output) #将两个分支得到的结果融合v_cams = torch.stack(cams) #热力图叠加return v_cls_output, v_cams

这篇关于Adversarial Complementary Learning for Weakly Supervised Object Localization模型解析(基于对抗互补学习的弱监督目标定位)的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!