本文主要是介绍基于语音信号MFCC特征提取和GRNN神经网络的人员身份检测算法matlab仿真,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

目录

1.算法运行效果图预览

2.算法运行软件版本

3.部分核心程序

4.算法理论概述

4.1 MFCC特征提取

4.2 GRNN神经网络概述

5.算法完整程序工程

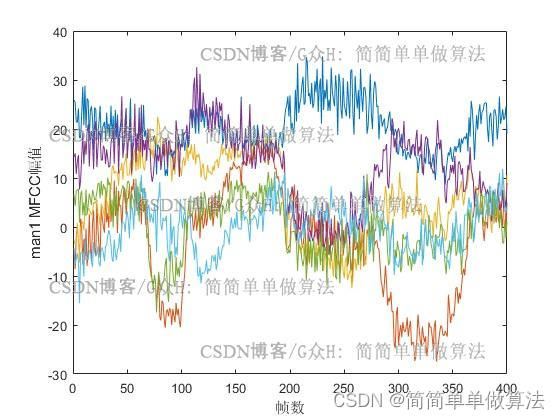

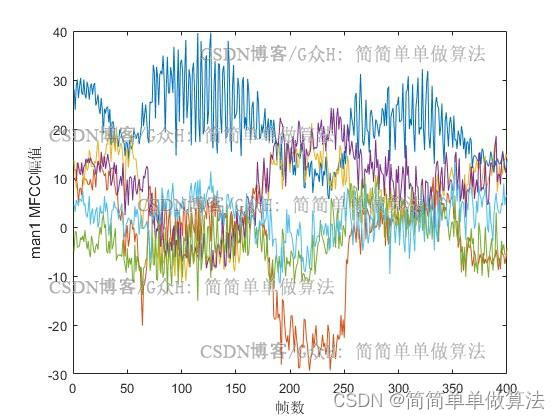

1.算法运行效果图预览

2.算法运行软件版本

MATLAB2022a

3.部分核心程序

........................................................................

P = [Dat1_wav1;Dat1_wav2;Dat2_wav1;Dat2_wav2;Dat3_wav1;Dat3_wav2;Dat4_wav1;Dat4_wav2];

T = [ones(800,1);2*ones(800,1);3*ones(800,1);4*ones(800,1)];%GRNN训练

net=newgrnn(P',T',0.00001);%测试

test = Dat4_wav3;y = net(test');

y2 = mode(y);if y2==1disp('man1');

end

if y2==2disp('man2');

end

if y2==3disp('man3');

end

if y2==4disp('man14');

end

144

4.算法理论概述

基于语音信号的MFCC特征提取和GRNN(Gated Recurrent Neural Networks)神经网络的人员身份检测算法,是一种结合了传统信号处理技术和深度学习的先进方法,用于识别和验证说话人的身份。这种方法利用了语音信号的时序特性,通过Mel频率倒谱系数(Mel Frequency Cepstral Coefficients, MFCC)进行特征提取,随后利用GRNN网络的序列建模能力,学习和区分不同说话人的声音特征,从而实现高效的身份检测。

4.1 MFCC特征提取

MFCC是语音信号处理中常用的一种特征表示方法,它基于人耳的听觉感知特性,将音频信号转换成一组系数,这些系数能较好地反映语音的频谱特性。MFCC的提取过程主要包括以下几个步骤:

-

预加重:对原始语音信号进行预加重处理,增强高频信息,公式为:y[n]=x[n]−αx[n−1],其中α是一个预加重因子,通常取0.97或0.95。

-

分帧:将预加重后的信号分割成固定长度的帧,每一帧覆盖一定的时间窗口。

-

加窗函数:每一帧数据乘以窗函数(如汉明窗)以减少帧边缘效应。

-

傅里叶变换:对加窗后的每一帧信号进行快速傅里叶变换(FFT)。

-

滤波器组:将频率域信号通过一组梅尔滤波器,滤波器中心频率按梅尔刻度分布,覆盖人耳的听觉范围。

-

倒谱:计算每个滤波器组输出的能量,并取对数,再进行离散余弦变换(IDCT),得到MFCC。

4.2 GRNN神经网络概述

广义回归神经网络(GRNN Generalized Regression Neural Network)是美国学者 Don-ald F. Specht在1991年提出的,它是径向基神经网络的一种。GRNN具有很强的非线性映射能力和柔性网络结构以及高度的容错性和鲁棒性,适用于解决非线性问题。GRNN 在逼近能力和学习速度上较RBF网络有更强的优势,网络最后收敛于样本量积聚较多的优化回归面,并且在样本数据较少时,预测效果也较好。此外,网络还可以处理不稳定的数据。因此,GRNN 在信号过程、结构分析、教育产业,能源、食品科学、控制决策系统、药物设计、金融领域、生物工程等各个领域得到了广泛的应用。

5.算法完整程序工程

OOOOO

OOO

O

这篇关于基于语音信号MFCC特征提取和GRNN神经网络的人员身份检测算法matlab仿真的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!