超分专题

超分之最近邻插值、线性插值、双线性插值、双三次插值原理

文章目录 插值与图像插值不同的插值方法最近邻域插值(Nearest Neighbor Interpolation)线性插值 (Linear Interpolation)双线性插值 (Bilinear Interpolation)双三次插值 (Bicubic Interpolation) 插值与图像插值 插值:利用已知数据去预测位置数据。图像插值:给定一个像素点,根据它周围像素

超分 supir 使用笔记

目录 两个模型 10个G open_clip安装: 方法2: pip install open_clip_torch 两个模型 10个G SUPIR-v0Q SUPIR-v0F SUPIR-v0Q: Baidu Netdisk, Google Drive Default training settings with paper. High generalization an

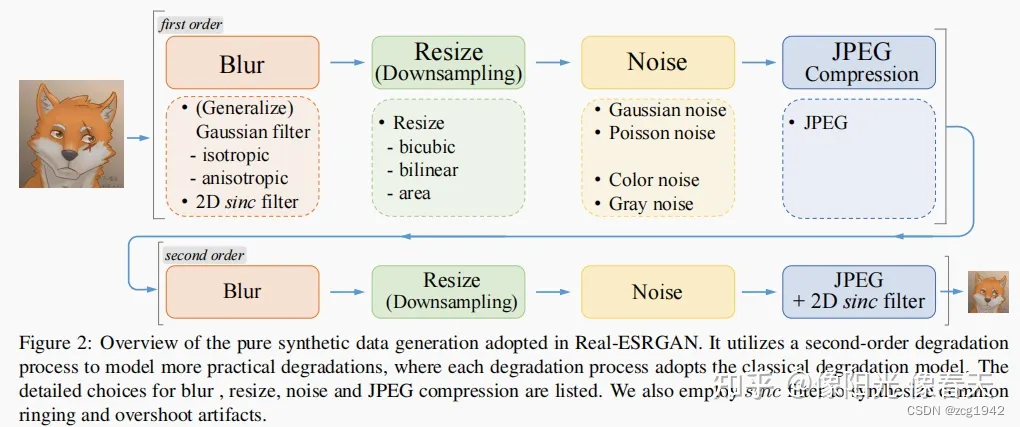

超分 Real-ESRGAN 使用笔记

效果图 目录 依赖项: 视频推理入口: 图片推理入口文件: RealESRGAN_x4plus 12g显存不够 RealESRGAN_x4plus_anime_6B 的效果 树枝之间产生了蒙版 RealESRNet_x4plus 有点模糊 2022年开源的 GitHub - xinntao/Real-ESRGAN: Real-ESRGAN aims at devel

超分中的GAN总结:常用的判别器类型和GAN loss类型

1. 概述 在真实数据超分任务上,从SRGAN开始,Loss函数基本是Pixel loss + GAN loss + Perceptual loss的组合。 与生成任务不同,对于超分这种复原任务,如果只使用Gan loss或者GAN loss的权重比较大的话,效果就比较差。 SRGAN成功的两个关键点:1. 引入了感知损失函数(Perceptual Loss),它是让生成图像产生细节的关键,

ComfyUI-APISR 动漫的超分模型

本文参考 https://github.com/ZHO-ZHO-ZHO/ComfyUI-APISR/tree/main 介绍 APISR:专门用于动漫的超分模型,包含 2x 和 4x 双模型,速度飞快,效果很好。 APISR 模型加载 | 🔎APISR ModelLoader 支持 2 种官方模型:2x_APISR_RRDB_GAN_generator 和 4x_APISR_GRL

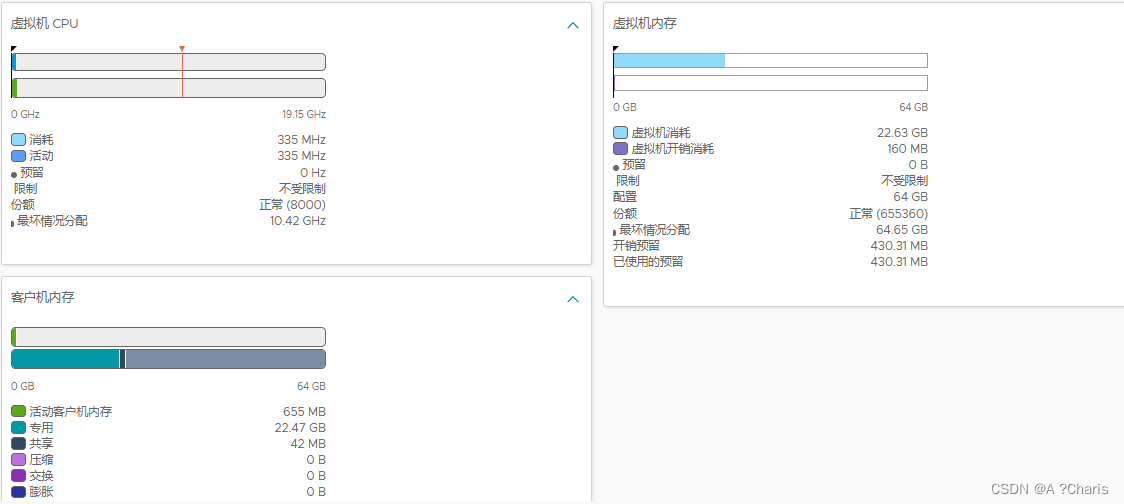

VMware-计算超分解释

一、如图 二、官网解释 虚拟机CPU或内存 消耗(Consumed):表示虚拟机实际使用的资源量。这包括CPU、内存、磁盘等资源的实际使用量。消耗量是实际分配给虚拟机的资源数量,而不仅仅是它们被配置的数量。 活动(Active):表示正在使用的资源量。活动资源是指在特定时间段内实际被虚拟机使用的资源量。与消耗不同,活动资源是指当前正在被虚拟机使用的资源,而不是总体的资源消耗。 预留(

【图像超分】论文精读:Deep Convolution Networks for Compression Artifacts Reduction(ARCNN)

第一次来请先看这篇文章:【超分辨率(Super-Resolution)】关于【超分辨率重建】专栏的相关说明,包含专栏简介、专栏亮点、适配人群、相关说明、阅读顺序、超分理解、实现流程、研究方向、论文代码数据集汇总等) 文章目录 前言Abstract1. IntroductionII. RELATED WORKIII. METHODOLOGYA. Review of SRCNNB. Convo

【视频超分】《Understanding Deformable Alignment in Video Super-Resolution》 2020

摘要: 形变卷积,最开始被用来匹配物体的几何变形,最近在对齐多帧图像上表现出优良的性能,逐渐被用在视频超分任务里面。尽管展现出优良的性能,形变卷积做对齐的内在机制依然不明确。在本文中,我们仔细探究了形变对齐和经典的基于光流对齐的联系。我们展示了形变对齐可以被分解为空间warping和卷积的组合。这种分解显示了形变对齐和光流对齐在公式上的共性,但是在偏移多样性上有关键差异。我们进一步通过实验证明在形

【真实世界图像超分】《Frequency Consistent Adaptation for Real World Super Resolution》2012 Nanjing University

摘要:最近的基于深度学习的超分方法在已知退化核图像上已经展现出卓越的性能。但是这些方法往往在真实世界场景下表现不尽如人意,因为作为训练样本的LR图像通常来自于理想退化核(bicubic下采样),它们不同于真实源图像域。训练样本的LR图像和真实源图像的领域差异在频率密度上被明显观察到。这一点启示我们显示地缩小由不正确的退化造成的领域差异。我们设计了一个频率一致性模块,确保在真实世界场景应用已经存在的

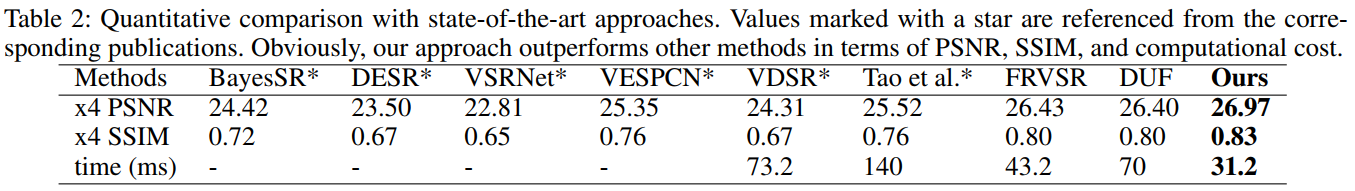

【视频超分】《Frame and Feature-Context Video Super-Resolution》Fudan University 2019

摘要:对于视频超分任务,当前的SOTA方法要么通过处理一个滑动窗口中的低分辨率(LR)视频帧产生高分辨率(HR)视频帧,要么递归地利用之前输出的HR视频帧超分子序列帧。这些方法的主要缺点是:(1)虽然独立产生每一个视频帧可能获得高质量的HR视频帧,但是它会产生不满意的闪烁结果。(2)虽然递归利用之前的评估HR视频帧在短时间段的信息流中获得时间连续性较好的结果,但是它会产生明显的晃动和锯齿状异常。在

【视频超分】《BasicVSR: The Search for Essential Components in Video Super-Resolution and Beyond》CUHK 2012

摘要:相比图像超分任务,视频超分网络会设计更多模块,因为它多了一个时空维度。因此复杂的设计结构在视频超分网络中是常见的。本文希望解开其中的要点,重新思考指导视频超分网络设计的基础模块,比如网络传播、对齐、聚合和上采样。通过重新设计已有的模块,本文提出了一个简洁的视频超分网络设计框架(BasicVSR),实验显示本文的方法优于SOTA的视频超分方法。另外,本文在BasicVSR框架的基础上提出了Ic

【图像超分】论文精读:CAMixerSR: Only Details Need More “Attention“

第一次来请先看这篇文章:【超分辨率(Super-Resolution)】关于【超分辨率重建】专栏的相关说明,包含专栏简介、专栏亮点、适配人群、相关说明、阅读顺序、超分理解、实现流程、研究方向、论文代码数据集汇总等) 文章目录 前言Abstract1. Introduction2. Related Work3. Method3.1. Content-Aware Mixing3.2. Netw

【图像超分】论文精读:Deep Unfolding Network for Image Super-Resolution(USRNet)

第一次来请先看这篇文章:【超分辨率(Super-Resolution)】关于【超分辨率重建】专栏的相关说明,包含专栏简介、专栏亮点、适配人群、相关说明、阅读顺序、超分理解、实现流程、研究方向、论文代码数据集汇总等) 文章目录 前言Abstract1. Introduction2. Related work2.1. Degradation models2.2. Flexible SISR m

【图像超分】论文精读:Single Image Super-Resolution via a Holistic Attention Network(HAN)

第一次来请先看这篇文章:【超分辨率(Super-Resolution)】关于【超分辨率重建】专栏的相关说明,包含专栏简介、专栏亮点、适配人群、相关说明、阅读顺序、超分理解、实现流程、研究方向、论文代码数据集汇总等) 文章目录 前言Abstract1. Introduction2 Related Work3 Holistic Attention Network (HAN) for SR3.1

使用GAN做图像超分——SRGAN,ESRGAN

在GAN出现之前,使用的更多是MSE,PSNR,SSIM来衡量图像相似度,同时也使用他们作为损失函数。 但是这些引以为傲的指标,有时候也不是那么靠谱: MSE对于大的误差更敏感,所以结果就是会倾向于收敛到期望附近,表现为丢失高频信息。同时根据实验,MSE的收敛效果也差于L1: 但是只使用L1也有问题,现在通常的做法是多种损失混合使用,比如MS-SSIM+L1,还有基于DCT的loss

【超分代码合集】SwinIR、StableSR、PASD、CCSR 常见超分模型的推理时间对比

从 Awesome-diffusion-model-for-image-processing 合集 [ 1 ] ^{[1]} [1] 以及 NTIRE 2023 Challenge on Efficient Super-Resolution (CVPR Workshop) [ 2 , 3 ] ^{[2,3]} [2,3] 的超分部分,选取了 4 个 star 数量较高的几个项目进行测试对比。

超分之SwinIR官方代码解读

文章目录 一、解读SwinIR模型文件:network_swinir.py1. 带有相对为位置偏置的(W-MSA)2. STL(Swin Transformer)3. RSTB(Residual Swin Transformer Block)4. SwinIR(主框架网络) 二、解读SwinIR测试主文件:main_test_swinir.py 一、解读SwinIR模型文件:ne

基于CNN多阶段图像超分+去噪(超级简单版)

这是之前的一项工作,非常简单,简单的复现了两个算法,然后把它们串起来了。 可执行的程序链接:CSDN; Github 我们分成两部分进行讲解: 1. 图像去噪 1.1 基本思路 图像的去噪工作基于很普通的CNN去噪,效果很差。 为了去除椒盐噪声并且提升暗图像的亮度,从以下方面入手: 1)针对椒盐噪声,使用了小核(3×3)中值滤波 2)针对图像亮度太低,梯度难以获取,使用直方图均

【图像超分】论文复现:Pytorch实现FSRCNN,包含详细实验流程和与SRCNN的比较

文章目录 前言1. FSRCNN网络结构2. 训练FSRCNN3. FSRCNN模型测试4. 训练好的FSRCNN模型超分自己的图像 前言 论文地址:Accelerating the Super-Resolution Convolutional Neural Network 论文精读: 请配合上述论文精读文章使用,效果更佳! 代码地址: 不想理解原理,希望直接跑通然

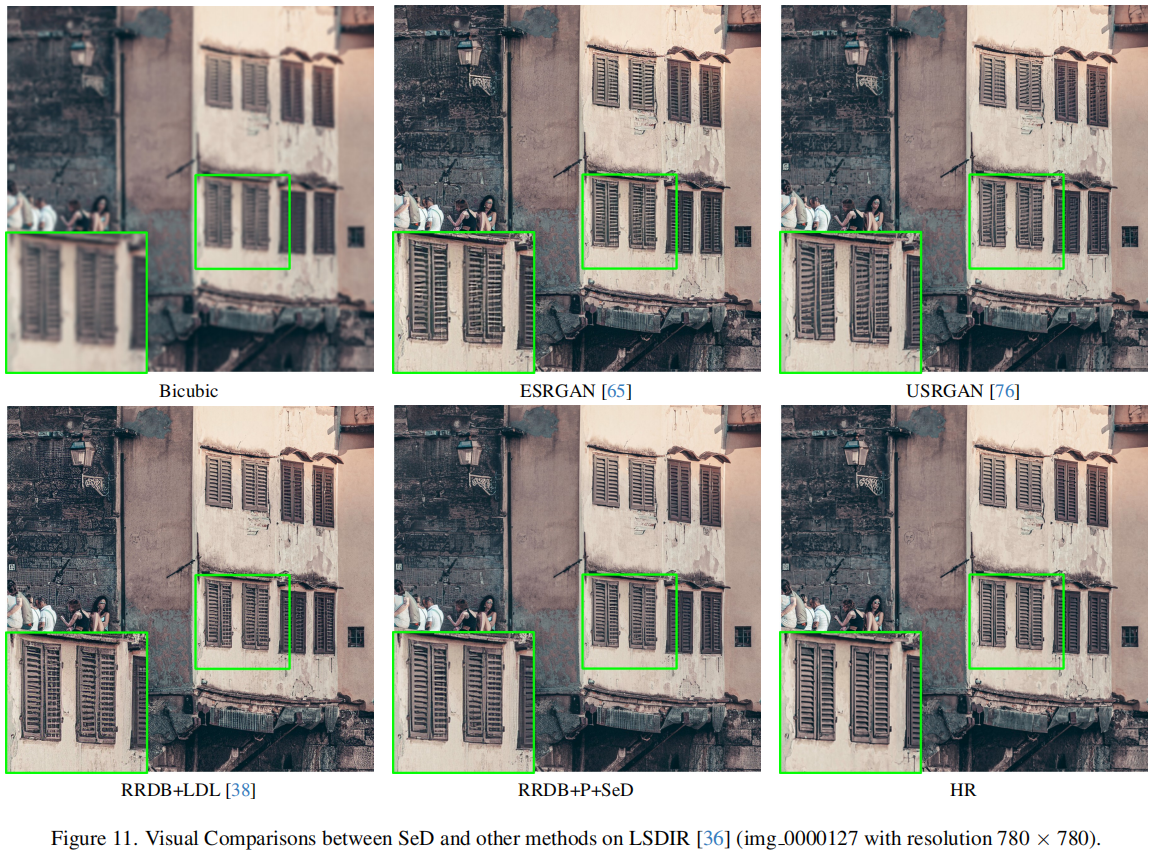

CVPR2024 进一步提升超分重建质量,中科大提出用于图像超分的语义感知判别器SeD,即将开源

本文首发: AIWalker,欢迎关注~ https://arxiv.org/abs/2402.19387 https://github.com/lbc12345/SeD 本文概述 生成对抗网络(GAN)已被广泛用于恢复图像超分辨率(SR)任务中的生动纹理。判别器使 SR 网络能够以对抗性训练的方式学习现实世界高质量图像的分布。然而,这种分布学习过于粗粒度,容易受到虚拟纹理的

python 利用超分提高监控分辨率

在Python中利用深度学习技术进行视频监控流的超分辨率(Super-Resolution, SR)处理,以提高监控画面的分辨率,通常涉及以下几个步骤: 获取视频流: 使用OpenCV等库连接到摄像头或读取视频文件,获取原始低分辨率帧。 import cv2cap = cv2.VideoCapture(0) # 连接到默认摄像头# 或者加载视频文件# cap = cv2.Video

中科星图GVE(AI案例)——AI影像进行超分案例

简介 超分辨率图像处理是一种通过增加图像的空间分辨率来提高图像质量的技术。传统的超分辨率算法主要基于插值和滤波方法,然而这些方法往往无法准确恢复丢失的高频细节,导致图像出现模糊或失真。近年来,基于人工智能的超分辨率算法得到了广泛的关注和研究。下面将介绍AI影像进行超分的具体细节。 AI影像超分辨率是一种基于深度学习的超分辨率算法,其核心是通过训练一个深度学习模型来实现图像的超分辨率重建。与传统

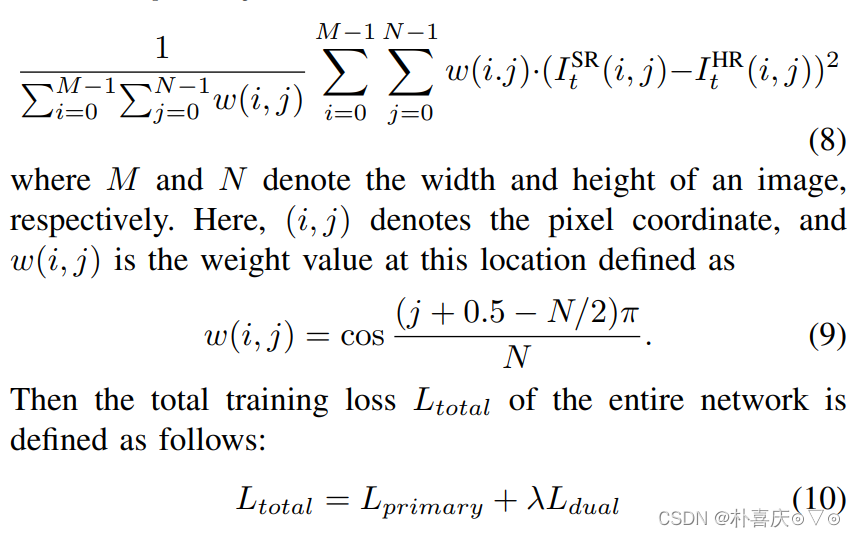

360全景超分学习记录

360 Panorama SR 鱼眼镜头成像原理一些名词相关论文360 Panorama SR using Deep Convolutional NetworksAbstract A single frame and multi-frame joint network for 360-degree panorama video SRAbstract具体网络结构 鱼眼镜头成像

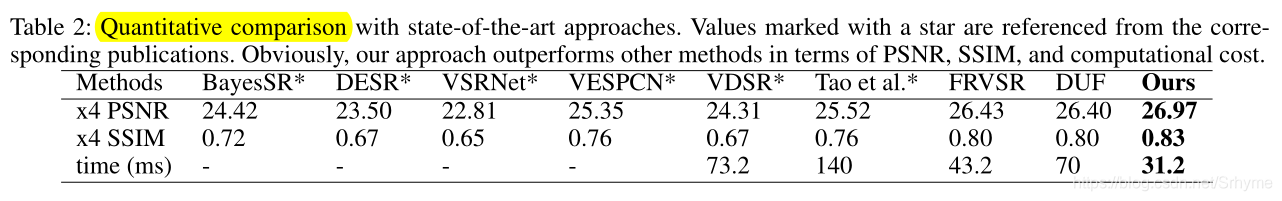

视频超分:FFCVSR(Frame and Feature-Context Video Super-Resolution)

论文:帧和特征上下文的视频超分辨率 文章检索出处:AAAI 2019 摘要 对于视频超分辨率,当前的方法要么是以滑动窗口的方式去处理多个相邻帧,要么是利用先前估计的HR帧来超分下一帧。这些方法的主要缺点是:1)单独生成每个输出帧可以获得高质量的HR帧,但是会导致令人不满意的伪影;2)组合先前生成的HR帧可以产生时间上一致的结果,但是,由于之前的超分误差不断累积到后续帧中,会造成明显的抖动

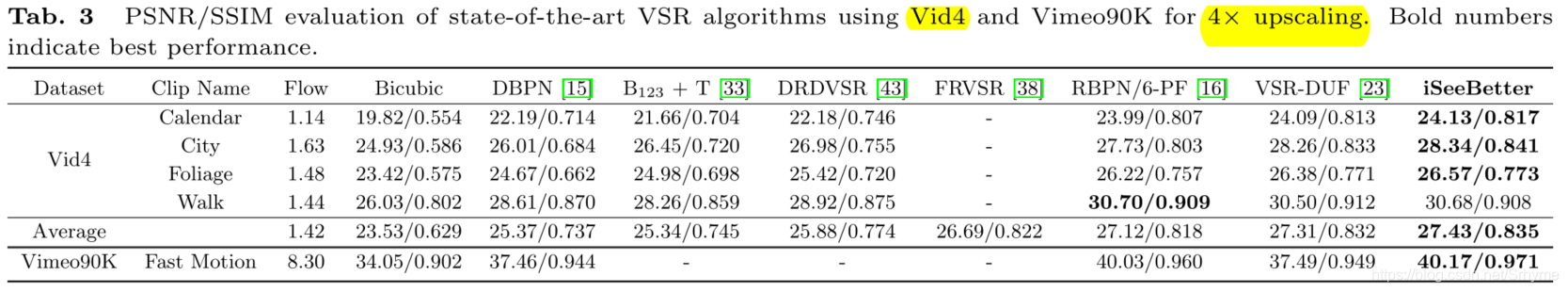

即插即用,视频超分中的涨点神器:iSeeBetter

CNN让超分结果更真实,GAN让超分结果更丰满,所以CNN+GAN=GOOD!添加一个鉴别器组件就能使结果增加0.32dB,即插即用,涨点神器!是否在其他的CNN架构上也可行,还需实验验证。 论文:iSeeBetter:使用递归生成反投影网络的时空视频超分 代码:https://github.com/amanchadha/iSeeBetter 看点 CNN在大尺度上的超分往往缺乏