耗时专题

linux上查看java最耗时的线程信息

找到JAVA进程pid ps -ef|grep java或则jps -mlv 找进行下耗时的线程TID 使用top -Hp pid可以查看某个进程的线程信息 -H 显示线程信息,-p指定pid top -Hp 10906 查看最耗时的 TID即线程id printf "%x\n" [tid] 转成16进制 java中的线程类相关信息 jstack 线程ID 可以查看某个线程的堆栈情况,特别对于h

gui显示白色框架,但不显示内容,gui中耗时操作

gui中耗时操作应该放在一个线程中执行,如果直接在gui中执行耗时操作,gui会只显示白色框架,但不显示内容,而且点着无反应。 如下,

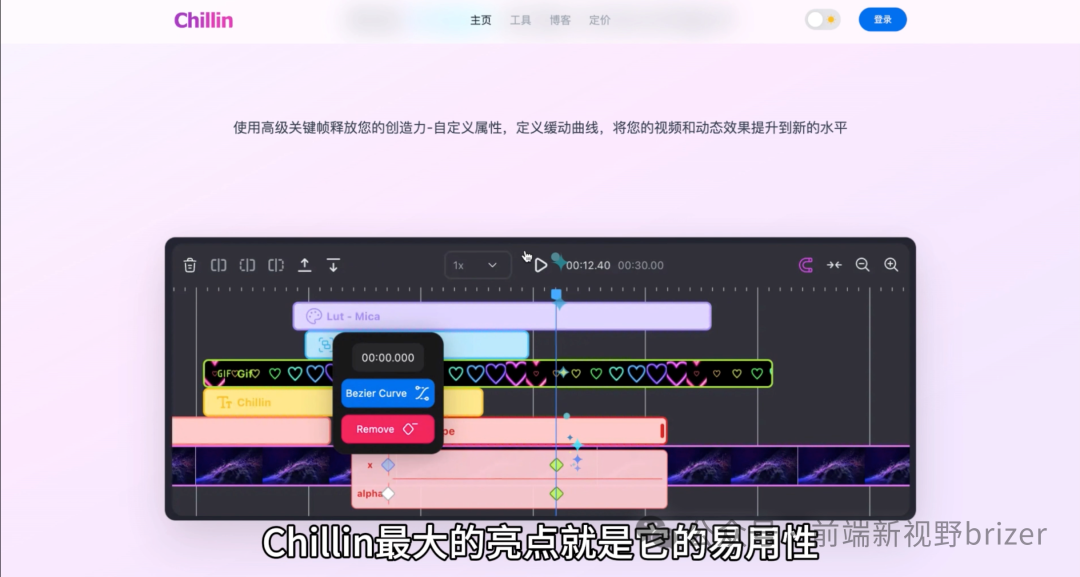

谁说短视频制作耗时?Chillin 让你在浏览器里就分分钟完成AI新生代视频

谁说短视频制作耗时?Chillin 让你在浏览器里就分分钟搞定AI新生代视频 当你准备创造惊艳的视频和动画时,Chillin 是一个不可忽视的工具。这款 AI 驱动的编辑器让视频和动画的创作变得前所未有的简单和高效。本文将为你介绍 Chillin 的功能亮点,以及它如何帮助你快速上手,轻松实现创意。 软件简介 Chillin 是一个结合了非线性视频编辑和矢量运动功能的在线编辑器,它就像

耗时3天,上亿数据如何做到秒级查询?

点击上方“朱小厮的博客”,选择“设为星标” 后台回复"书",获取 来源:sohu.gg/jIp59N 最近在忙着优化集团公司的一个报表。优化完成后,报表查询速度由从半小时以上(甚至查不出)到秒查的质变。从修改 SQL 查询语句逻辑到决定创建存储过程实现,花了我 3 天多的时间,在此总结一下,希望对朋友们有帮助。 数据背景 首先项目是西门子中国在我司实施部署的 MES 项目,由于项目是在产线上运

这样统计代码执行耗时,才足够优雅!

点击上方“朱小厮的博客”,选择“设为星标” 后台回复"书",获取 后台回复“k8s”,可领取k8s资料 一、前言 代码耗时统计在日常开发中算是一个十分常见的需求,特别是在需要找出代码性能瓶颈时。 可能也是受限于 Java 的语言特性,总觉得代码写起来不够优雅,大量的耗时统计代码,干扰了业务逻辑。特别是开发功能的时候,有个感受就是刚刚开发完代码很清爽优雅,结果加了一大堆辅助代码后,整个代码就变得

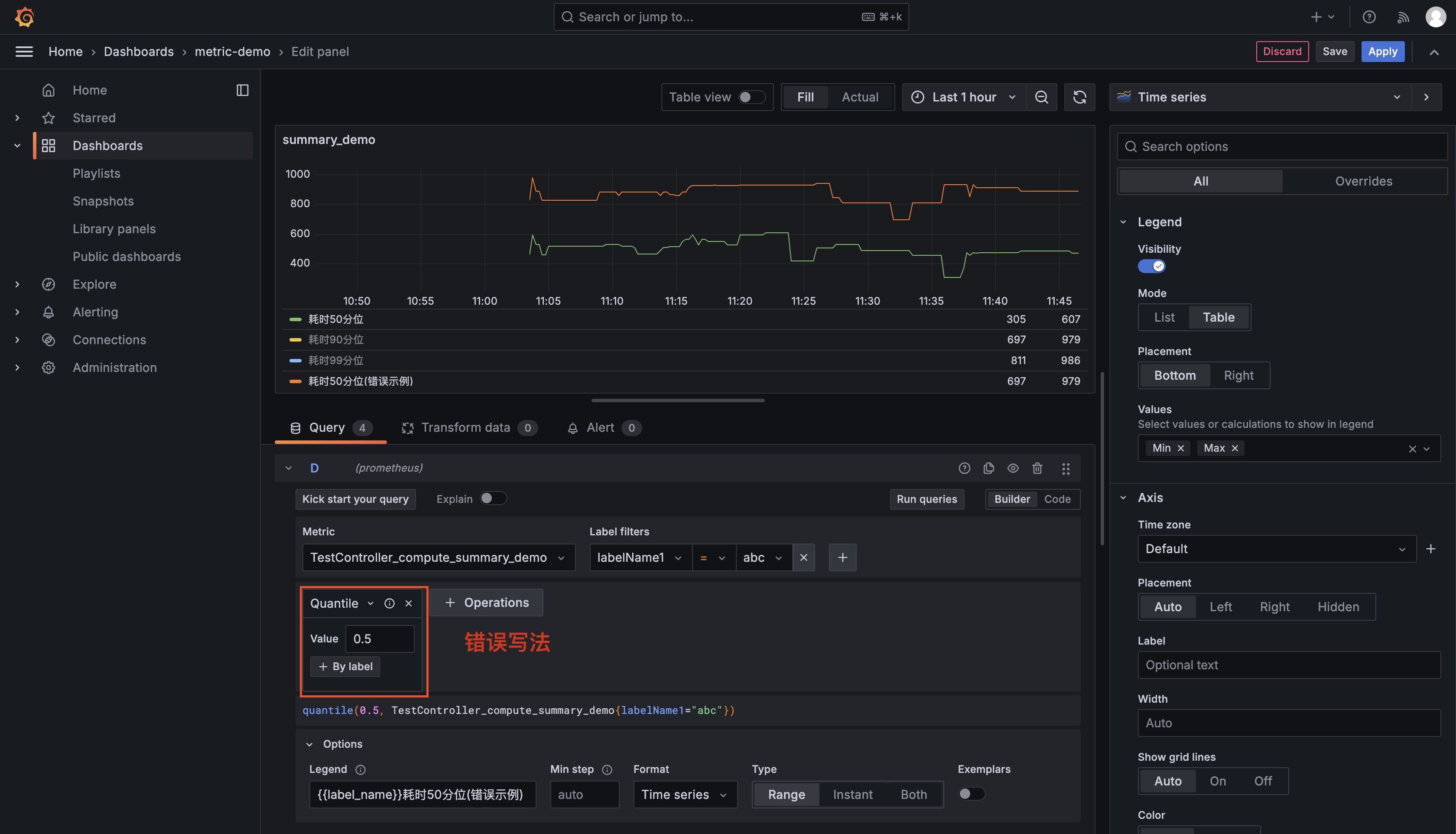

spring boot 项目 prometheus 自定义指标收集区分应用环境集群实例ip,使用 grafana 查询--方法耗时分位数指标

spring boot 项目 prometheus 自定义指标收集 auth @author JellyfishMIX - github / blog.jellyfishmix.comLICENSE LICENSE-2.0 说明 网上有很多 promehteus 和 grafana 配置,本文不再重复,只介绍自定义部分。目前只介绍了分位数指标的收集和查询,常用于方法耗时的指标监控。 自定

AI基础 -- 练手之预测耗时方案

预测耗时的方案 1. 初始化权重 计算初始权重 w w w: w = a 2 − a 1 1 w = \frac{a2 - a1}{1} w=1a2−a1 2. 预测值 使用权重和实际值 a 2 a2 a2 来计算预测值 y 3 y3 y3: y 3 = w ⋅ 1 + a 2 y3 = w \cdot 1 + a2 y3=w⋅1+a2 3. 损失函数 计算预测值 y 3

简易记录下python与java、C计算斐波那契数耗时

简单比较了下python与java、C计算的耗时,忽略了编译器优化,javac和gcc都采用默认参数。python耗时比较大,比后两者长了两个数量级级别。java表现出来优于C,应该是编译优化的结果。python计算,耗时三十余秒 简易代码: import timedef fibonacci(n):if n <= 1:return nelse:return fibonacci(n-1) + f

[Qt5] 使用QtConcurrent::run在异步线程中执行耗时函数

📢博客主页:https://loewen.blog.csdn.net📢欢迎点赞 👍 收藏 ⭐留言 📝 如有错误敬请指正!📢本文由 丶布布原创,首发于 CSDN,转载注明出处🙉📢现在的付出,都会是一种沉淀,只为让你成为更好的人✨ 文章预览: 一. QtConcurrent::run异步线程操作 一. QtConcurrent::run异步线程操作

Elasticsearch向量检索(KNN)千万级耗时长问题分析与优化方案

最终效果 本文分享,ES千万级向量检索耗时分钟级的慢查询分析方法,并分享优化方案。通过借助内存加速,把查询延迟从分钟级降低到毫秒级别。 方案缺点是对服务器内存有比较大的依赖! 主要问题:剔除knn插件,此插件在做ANN检索时,构建查询语句耗时长。 1.背景 1.1 资源背景 es.8.8版本 2个es节点 ; 堆内存31g; 服务器内存资源充足(100+); HDD磁盘 该优化是在

App应用冷启动耗时排查

1 查看冷启动耗时 adb shell am start -S -W com.gerry.lifecycle/com.gerry.lifecycle.MainActivity 发现冷启动耗时居然要6s多,下面开始排查 2 生成trace文件 // Application中开始trace记录override fun attachBaseContext(base: Context?) {

WPF 一个执行耗时任务,页面更新等待时间的例子

xaml页面,一个按钮,一个lable,lable用来更新等待的时间。点击按钮,每过1秒,label的数值+1,直到任务结束。 <Window x:Class="WpfApp2.MainWindow"xmlns="http://schemas.microsoft.com/winfx/2006/xaml/presentation"xmlns:x="http://schemas.microsoft.

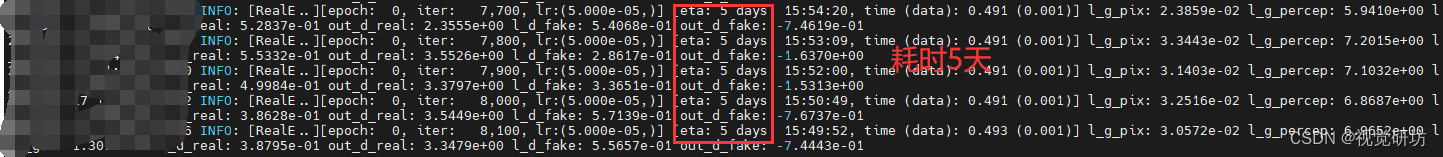

深度学习训练——batch_size参数设置过大反而训练更耗时的原因分析

💪 专业从事且热爱图像处理,图像处理专栏更新如下👇: 📝《图像去噪》 📝《超分辨率重建》 📝《语义分割》 📝《风格迁移》 📝《目标检测》 📝《暗光增强》 📝《模型优化》 📝《模型实战部署》 在深度学习训练过程中,batch_size 对训练时间的影响并不是线性的,有时增大 batch_size 反而会导致训练时间变长。 目录 一、例子1.1 较大batch_s

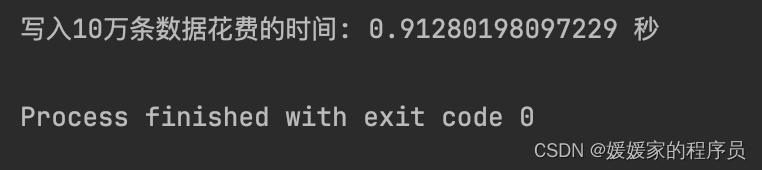

MongoDB——写入耗时

mongodb写入10万条数据的耗时差不多是1s import timeimport pymongofrom pymongo import MongoClient# 连接到MongoDBclient = MongoClient('mongodb://localhost:27017/')db = client['test_db']collection = db['test_collect

java:netty执行耗时任务的思考

netty执行耗时任务时要放在【eventLoop().execute(runnable)】里面。 示例代码: @Overrideprotected void channelRead0(ChannelHandlerContext ctx, ByteBuf msg) {CharSequence charSequence1 = msg.readCharSequence(msg.readableBy

Java优雅统计耗时【工具类】

任务耗时如何优雅的打印,看完本文你就明白了!~ import cn.hutool.core.date.StopWatch;import cn.hutool.core.lang.Console;/*** 优雅打印出任务耗时*/public class Main {public static void main(String[] args) throws Exception{StopWatch

在Gradle 插件中统计并打印 Task 任务耗时

在Gradle 插件中统计并打印 Task 任务耗时 我们在使用 Gradle 构建任务时,有时想统计每个任务的耗时情况,以此发现每个任务的运行时间,以及是否存在可优化空间。 使用 Listener 进行监听 Gradle 提供了很多构建生命周期钩子函数。 1. 我们可以用 TaskExecutionListener 来监听整个构建过程中 task 的执行: public inter

为什么使用Java8中的并行流运算耗时变长了?

写在文章开头 近期对迭代的功能进行压测检查,发现某些使用并发技术的线程任务耗时非常漫长,结合监控排查定位到的并行流使用上的不恰当,遂以此文分享一下笔者发现的问题。 Hi,我是 sharkChili ,是个不断在硬核技术上作死的 java coder ,是 CSDN的博客专家 ,也是开源项目 Java Guide 的维护者之一,熟悉 Java 也会一点 Go ,偶尔也会在 C源码 边缘徘徊。

MFC 处理耗时操作的一种办法

原理就是将耗时的操作分布完成. 即处理一步以后,马上处理程序中的消息。并且把启动和停止操作放到一个函数中间。 void ProcessMessages() { CWinApp* pApp = AfxGetApp(); MSG msg; while ( PeekMessage ( &msg, NULL, 0, 0, PM_NOREMOVE )) pApp->PumpMessage(); }

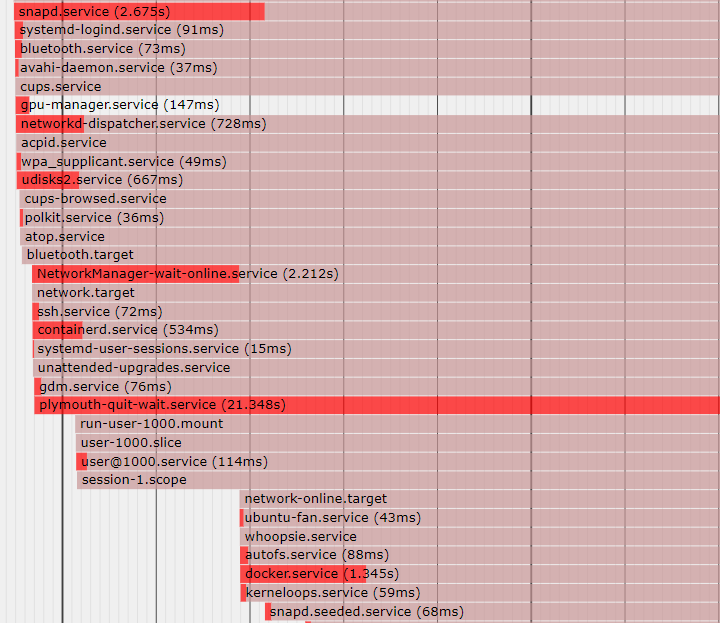

练习实践-linux启动耗时分析

练习实践-启动耗时整体概览,具体服务的启动细节 参考来源: B站up主林哥讲运维:一分钟学会:可视化查看系统启动时的性能 如何使用Linux命令查看系统的启动进程(linux查看启动进程) 解决ubuntu开机变慢;删除耗时启动项 (调查研究)通过参考来源中内容的对比,发现视频中介绍的将启动过程导出为svg图片的方式,还需要在浏览器打开,然后分析,没有 直接通过命令systemd-analyz

Python代码cProfile耗时分析及可视化

Python: cProfile 食用方法 import cProfile# 直接把分析结果打印到控制台# loading为需要监测的函数,arg为其参数cProfile.run("loading(arg)")# 把分析结果保存到文件中cProfile.run("loading(arg)", filename="result.out")# 增加排序方式cProfile.run("lo

Spark-StructuredStreaming checkpointLocation分析、优化耗时

目录 1 问题描述2 分析 checkpointLocation 配置 2.1 checkpointLocation 在源码调用链2.2 MetadataLog(元数据日志接口) 3 分析 checkpointLocation 目录内容 3.1 offsets 目录3.2 commitLog 目录3.3 metadata 目录3.4 sources 目录3.5 sinks 目录 4 解决方案 4

opencv 一些函数的耗时计算

Release 模式 -------------------------------------------------- smooth gaussian : 2 cvtColor CV_BGR2Lab : 3 get_psnr : 16 convertTo CV_8U: 6 absdiff: 2 threshold: 0 dilate 20: 3 fill_hole : 3 bitwise_x

优化耗时业务:异步线程在微服务中的应用

大家好,我是程序员大猩猩。 大家都知道,在我们实际开发过程中,我们经常会遇到一些耗时的业务和逻辑,比如说要上传什么大文件,又或者是大文件的数据处理。我们不能一个接口上等着这些耗时任务完成之后了,再返回,那用户体验度会大打折扣的。 这时候,我们最基本的操作就是使用多线程处理或者是异步线程处理。这里我们说一下异步线程处理。 那么我们来说一下,微服务中如何使用异步线程呢? 一、使用 @Async

Service个人笔记4 --IntentService处理耗时任务

本文章中的代码来自 《疯狂Android讲义》 Service可以后台处理一些简单的任务,但是不建议使用Service处理耗时任务。 原因: 1.Service 不会专门启动一条单独的进程,Service与它所在的应用位于同一个进程中。 (Service开启不会启动新线程) 2.Service 本身也不是一条新的线程(Service本身不是新线程) 对于第一个问题,有两种解决方案

为什么建立数据库连接耗时?究竟耗时多久?

数据库连接从连接池中取这已经是大家的共识了,因为频繁的建立或者关闭连接代价太大,那么代价究竟有多大? 我们先准备一个简单的数据库连接代码段 public static void main(String[] args) throws ClassNotFoundException, SQLException, InterruptedException {Class.forName("com.