神经元专题

基于 Python 的 LIF 模型:探索神经元同步与小世界网络

在神经科学中,理解神经元之间的同步行为对解释大脑的功能非常重要。而泄漏积分发放(Leaky Integrate-and-Fire, LIF)模型作为一种经典的神经元模型,广泛应用于模拟神经元的膜电位变化以及脉冲发放。本篇博客将带你通过Python代码,模拟一个基于小世界网络的神经元群体,探索不同重连概率 ppp 对神经元同步性的影响。 LIF 模型的基本原理 LIF 模型基于以下膜电位

深度学习 —— 1.单一神经元

深度学习初级课程 1.单一神经元2.深度神经网络3.随机梯度下降法4.过拟合和欠拟合5.剪枝、批量标准化6.二分类 前言 本套课程仍为 kaggle 课程《Intro to Deep Learning》,仍按之前《机器学习》系列课程模式进行。前一系列《Keras入门教程》内容,与本系列有部分重复内容,但重点在于快速入门深度学习中的keras 使用,即从代码入手,快速掌握代码的使用,

【机器学习】机器学习中的人工神经元模型有哪些?

线性神经元 线性神经元(Linear Neuron)是一种基本的人工神经元模型,特点是其输出是输入的线性组合。线性神经元是神经网络中最简单的一种形式,适用于处理线性关系的问题。数学模型如下, y = w ⋅ x + b = ∑ i = 1 n w i x i + b y = \mathbf{w} \cdot \mathbf{x} + b = \sum_{i=1}^n w_i x_i + b y

【复旦邱锡鹏教授《神经网络与深度学习公开课》笔记】神经元和人工神经网络

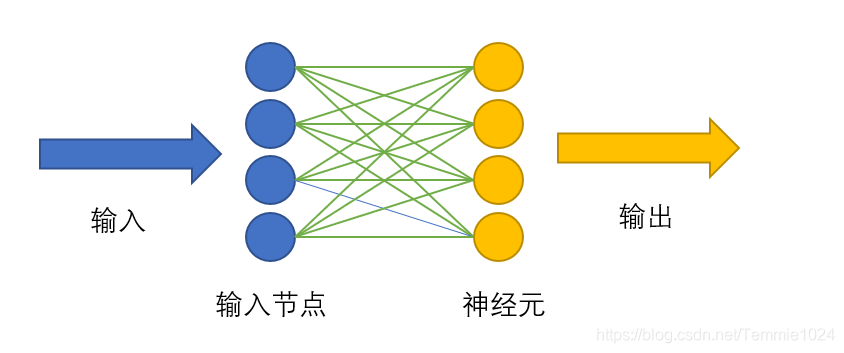

神经元 生物神经元: 平时处于抑制状态,当接受信息量达到一定程度后进入兴奋状态。 人工神经元: 一个人工神经元大致有两个步骤: 一是收集信息,如上图中 x 1 , ⋯ , x d x_1,\cdots,x_d x1,⋯,xd表示神经元可以接受的外界信号,对这些信号进行加权汇总(不同外界信号对神经元作用的权重不同,即 w 1 , ⋯ , w d w_1,\cdots,w_d w1,

人脑神经元与AI神经网络的奥秘

神经元是赋予我们思考力的生物学奇迹。大脑中藏着近千亿个这样的神经元,它们通过错综复杂的连接形成了我们的神经系统。每个神经元由细胞体、树突和轴突构成,这些部分使得神经元能够接收、处理和传递信息。 在人工智能领域,神经网络其实是模仿生物神经元工作方式的算法模型,但在具体实现上还是有不小的差异。 一、结构和连接方式 人脑中的神经元具有极为复杂的结构,每个神经元能与

# 探索深度学习的基础:神经元模型

文章目录 前言神经元模型的基本概念简单代码示例:实现一个基本神经元从单个神经元到深度学习网络结论 前言 深度学习的进展在很大程度上得益于神经元模型的发展。这些模型,受到人脑神经元启发,形成了深度神经网络的基础。本文将对深度学习中的神经元模型进行探索,从其基本概念入手,逐步深入到如何组合这些基本构建块来构建复杂的深度学习模型。同时,我们将通过简单的代码示例来展示神经元模型

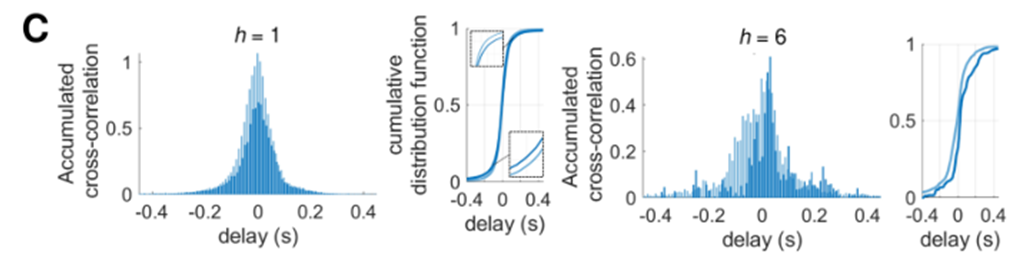

【精读Yamamoto】方向性连接如何丰富神经网络的功能复杂度 | 体外神经元培养实验 | 脉冲神经元模型(SNN) | 状态转移模型

探索大脑的微观世界:方向性连接如何丰富神经网络的功能复杂度 在神经科学领域,理解大脑如何通过其复杂的网络结构实现高级功能一直是一个核心议题。最近,一项由Nobuaki Monma和Hideaki Yamamoto博士领导的研究为我们提供了新的视角,他们通过创新的结合生物神经元培养皿实验和计算仿真模型,揭示了在生物神经网络中引入方向性连接如何显著影响网络的动态行为和功能性复杂度。 这次介绍

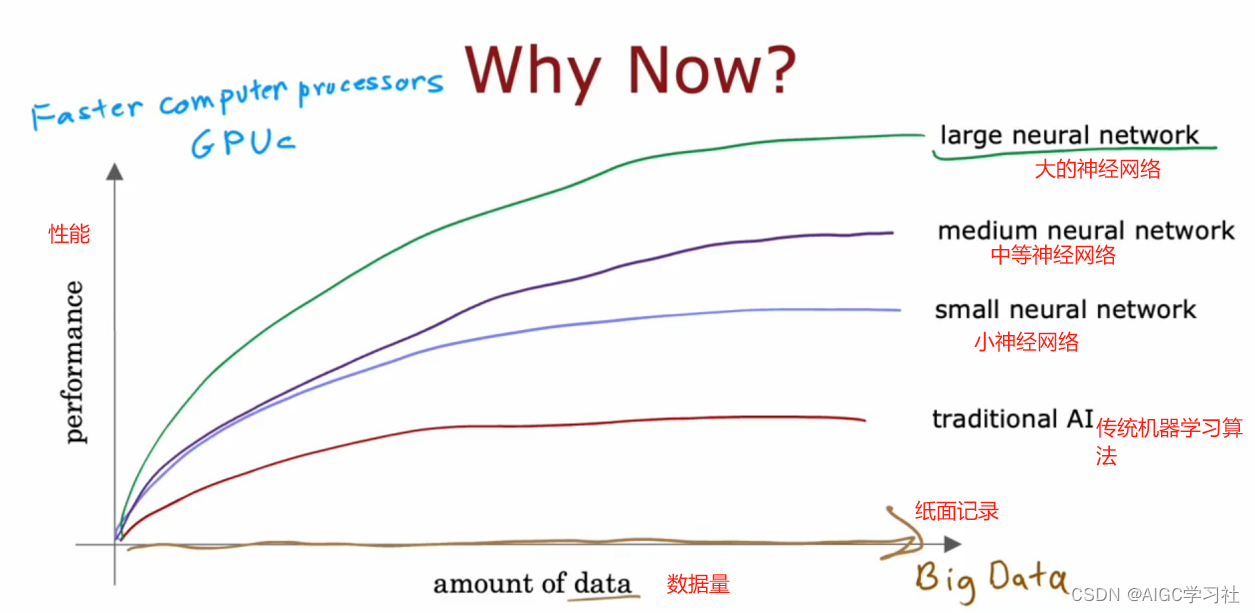

吴恩达2022机器学习专项课程C2(高级学习算法)W1(神经网络):2.1神经元与大脑

目录 神经网络1.初始动机*2.发展历史3.深度学习*4.应用历程 生物神经元1.基本功能2.神经元的互动方式3.信号传递与思维形成4.神经网络的形成 生物神经元简化1.生物神经元的结构2.信号传递过程3.生物学术语与人工神经网络 人工神经元*1.模型简化2.人工神经网络的构建3.计算和输入 人工神经元vs生物神经元1.人脑知识的局限性2.深度学习的研究方向* 神经网络兴起的原因*1.历史背

机器学习算法原理之人工神经元和单层神经网络

http://python.jobbole.com/81278/ 本文将简单介绍机器学习的历史和基本概念。我们会看看第一个用算法描述的神经网络和适用于自适应线性神经元的梯度下降算法,这些知识不仅介绍了机器学习原理,还是后续文章中现代多层神经网络的基础。 如果你想看一下代码运行的实际效果,可到https://github.com/rasbt/pattern_classification查看I

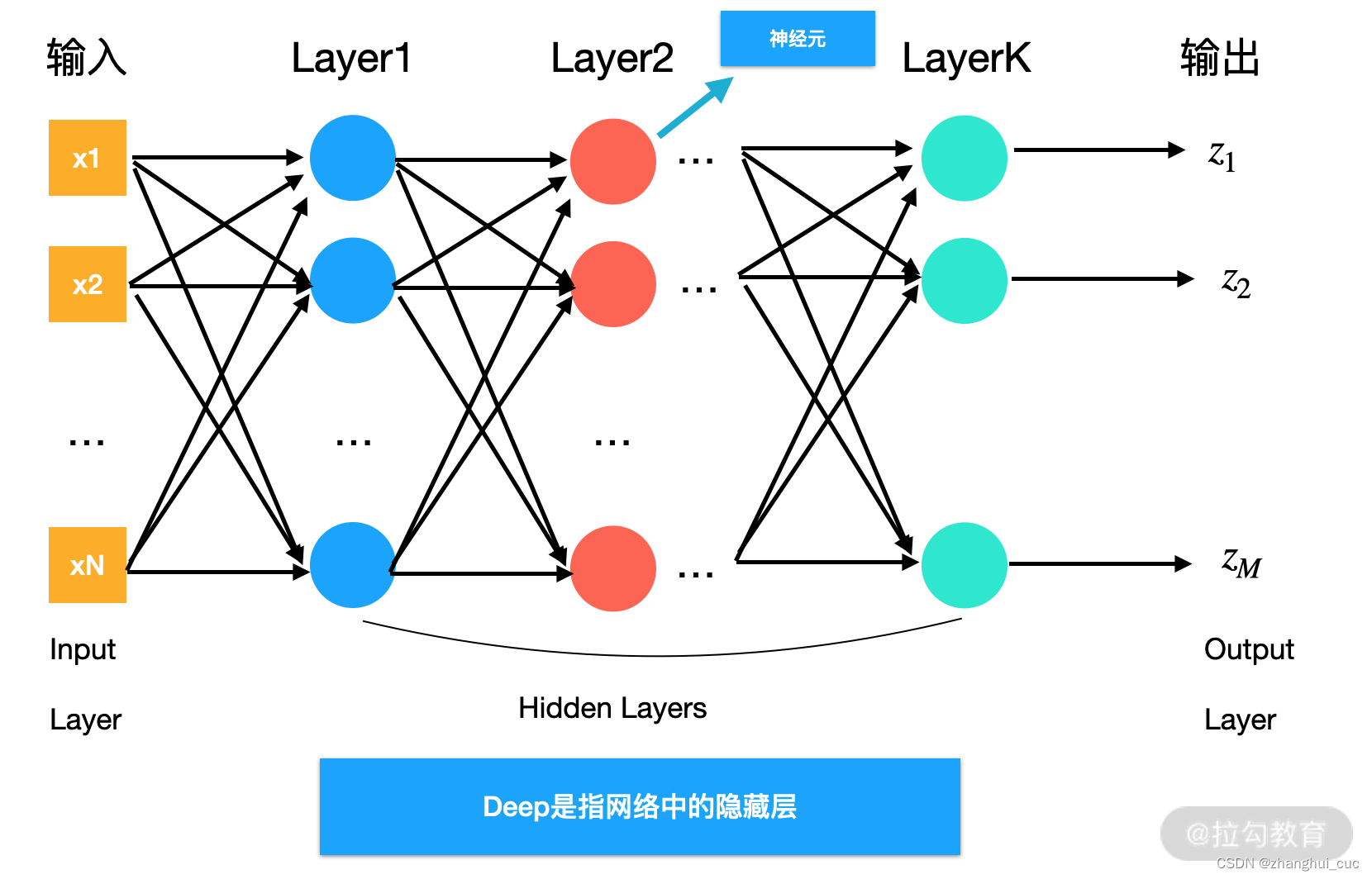

【机器学习300问】72、神经网络的隐藏层数量和各层神经元节点数如何影响模型的表现?

评估深度学习的模型的性能依旧可以用偏差和方差来衡量。它们反映了模型在预测过程中与理想情况的偏离程度,以及模型对数据扰动的敏感性。我们简单回顾一下什么是模型的偏差和方差? 一、深度学习模型的偏差和方差 偏差:衡量模型预测结果的期望值与真实值之间的差异;方差:度量模型预测结果的变动性或离散程度; 如果模型在训练集上都表现得很差,就说模型高偏差(High Bias),此时模型欠

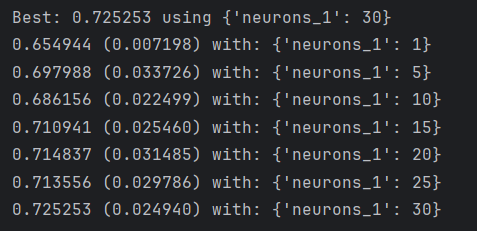

【Python深度学习系列】网格搜索选择神经网络超参数:隐含层神经元数量(案例+源码)

这是我的第259篇原创文章。 一、引言 在深度学习中,超参数是指在训练模型时需要手动设置的参数,它们通常不能通过训练数据自动学习得到。超参数的选择对于模型的性能至关重要,因此在进行深度学习实验时,超参数调优通常是一个重要的步骤。常见的超参数包括: model.add() neurons(隐含层神经元数量) init_mode(初始权值) activation(激活函数)

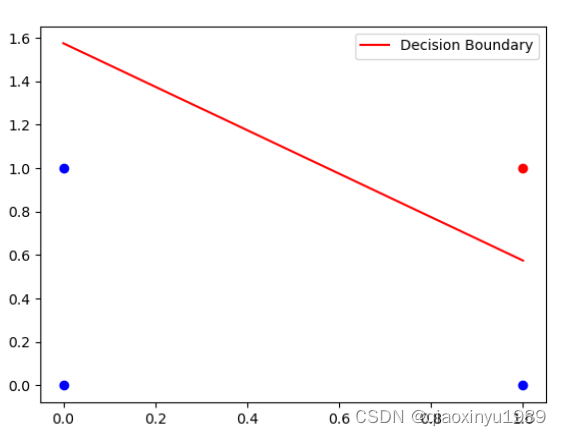

独家 | 初学者的问题:在神经网络中应使用多少隐藏层/神经元?(附实例)

作者:Ahmed Gad 翻译:蒋雨畅 校对:李海明 本文约2400字,建议阅读8分钟。 本文将通过两个简单的例子,讲解确定所需隐藏层和神经元数量的方法,帮助初学者构建神经网络。 人工神经网络(ANNs)初学者可能会问这样的问题: 该用多少个隐藏层?每个隐藏层中有多少个隐藏的神经元?使用隐藏层/神经元的目的是什么?增加隐藏层/神经元的数量总能带来更好的结果吗? 很高兴我们可以回答这些问题

relu神经元死亡的一种角度解释

最近在阅读 Airbnb 的论文 Applying Deep Learning to Airbnb Search。阅读的过程中,我发现作者在谈及特征归一化的必要性时,有如下表述: Feeding values that are outside the usual range of features can cause large gradients to back propagate. Thi

神经元、神经网络和线性判别

参考《机械工业出版社的matlab》与《机器学习与机器学习算法视角》 Hebb法则 Hebb法则认为突触链接强度的变化与两个相连神经元激活的相关性成正比。如果两个神经元始终同时激活,那么他们之间连接的强度会变大。反之,如果两个神经元从不同时激活,它们之间的连接就会消失。是经典的条件发射(铃声与狗分泌唾液的实验)。当神经元同时被激活时,他们之间的连接会被增强,这种效应也被称为长时程增强效应和神经

超级干货 | 从神经元到CNN、RNN、GAN…神经网络看本文绝对够了

在深度学习十分火热的今天,不时会涌现出各种新型的人工神经网络,想要实时了解这些新型神经网络的架构还真是不容易。光是知道各式各样的神经网络模型缩写(如:DCIGN、BiLSTM、DCGAN……还有哪些?),就已经让人招架不住了。 因此,这里整理出一份清单来梳理所有这些架构。其中大部分是人工神经网络,也有一些完全不同的怪物。尽管所有这些架构都各不相同、功能独特,当我在画它们的节点图时……其中潜在的关

神经形态计算的新方法:人造神经元计算速度超过人脑

来源:科学网 【新智元导读】一种以神经元为模型的超导计算芯片,能比人脑更高效快速地加工处理信息。近日刊登于《科学进展》的新成果,或许将成为科学家们开发先进计算设备来设计模仿生物系统的一项主要基准。尽管在其商用之前还存在许多障碍,但这项研究为更多自然机器学习软件打开了一扇大门。 当下,人工智能软件越来越多地开始模仿人类大脑。而诸如谷歌公司的自动图像分类和语言学习程序等算法也能够

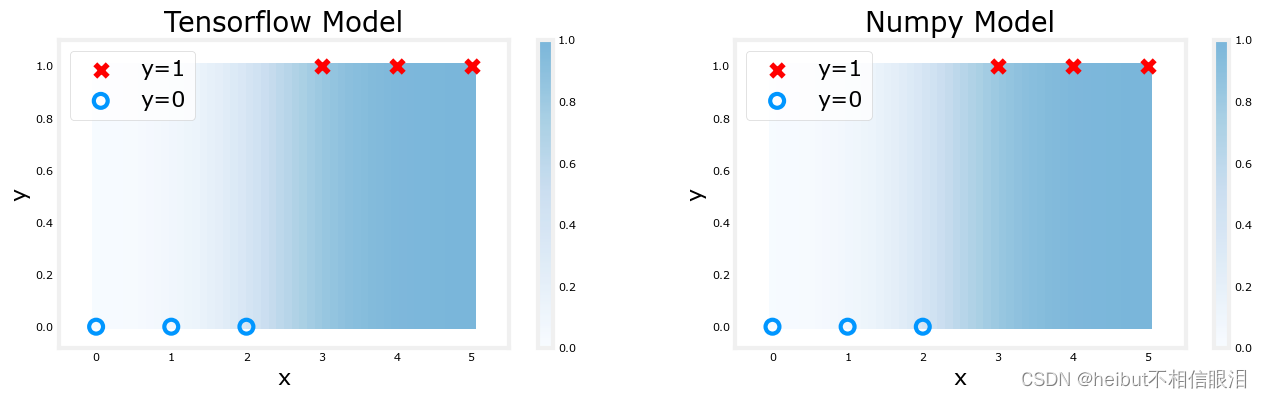

吴恩达机器学习-可选实验室:神经元和层(Neurons and Layers)

文章目录 可选实验室:神经元和层包无激活神经元-回归/线性模型Sigmoid激活的神经元祝贺 可选实验室:神经元和层 实验室将探索神经元和层的内部工作原理,特别是将课程1中掌握的模型,即回归/线性模型和逻辑斯蒂模型,与之进行对比。本实验室将介绍Tensorflow并演示这些模型是如何在该框架中实现的。 包 Tensorflow和Keras Tensorflow是谷歌开发的

从零开始:神经网络(1)——神经元和梯度下降

声明:本文章是根据网上资料,加上自己整理和理解而成,仅为记录自己学习的点点滴滴。可能有错误,欢迎大家指正。 一. 神经网络 1. 神经网络的发展 先了解一下神经网络发展的历程。从单层神经网络(感知器)开始,到包含一个隐藏层的两层神经网络,再到多层的深度神经网络,一共有三次兴起过程。详见下图。 随着神经网络的发展,其表示性能越来越强。从单层神经网络,到两层

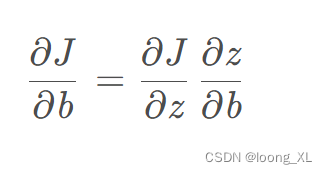

神经网络 梯度与神经元参数w、b关系;梯度与导数关系

参考:https://blog.csdn.net/weixin_44259490/article/details/90295146 概念 梯度与w的关系可以用梯度下降公式来表示:w=w−α ∂ c o s t ∂ w \frac{\partial cost}{\partial w} ∂w∂cost,其中w表示网络的权重, ∂ c o s t ∂ w \frac{\partial cost}{

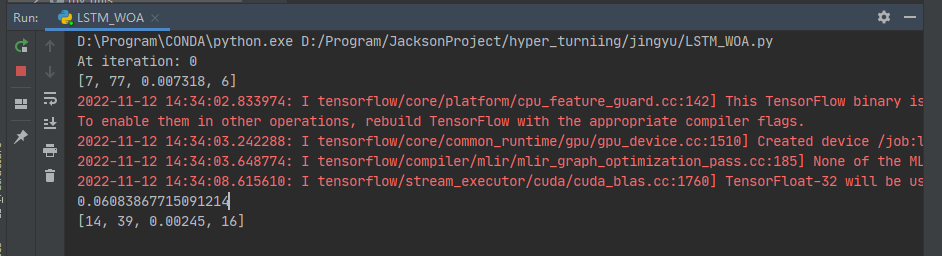

鲸鱼算法优化LSTM超参数-神经元个数-dropout-batch_size

1、摘要 本文主要讲解:使用鲸鱼算法优化LSTM超参数-神经元个数-dropout-batch_size 主要思路: 鲸鱼算法 Parameters : 迭代次数、鲸鱼的维度、鲸鱼的数量, 参数的上限,参数的下限LSTM Parameters 神经网络第一层神经元个数、神经网络第二层神经元个数、dropout比率、batch_size开始搜索:初始化所鲸鱼的位置、迭代寻优、返回超出搜索空间边界

机器学习——自适应线性神经元

将计算的结果与输入的正确结果进行比较,error>0时根据计算的结果动态调整wi 激活函数:数据和神经元参数相乘后求和的结果。 怎样动态调整参数wi? 采用 渐进下降的数值算法不断缩短计算结果与实际结果的距离。 和方差函数图像: 对w求偏导得到曲线在某一点的切线,若且线的斜率是正的,则w增大时,J(W)值增大。w减小时,J(W)减小。所以当切线斜率为正值时,应减小wi,使J(

LSTM中隐层神经元的传播机制

相较于RNN,LSTM只是改变了隐含层中神经元在不同时刻的传播机制 将隐层某个神经元看成一个cell, 这个cell有3个输入,上一个时刻的隐层某神经元的保留状态 Ct−1 C_{t-1},上一个时刻的隐层某神经元输出的传递信息 ht−1 h_{t-1}, 当前时刻的样本 Xt X_t, 该cell由3个gate(forget, input, output)控制。 一、通过忘记门决定从ce

深度学习入门笔记(二)神经元的结构

神经网络的基本单元是神经元,本节我们介绍神经元的结构。 2.1 神经元 一个神经元是由下面 5 部分组成的: 输入:x1,x2,…,xk。权重:w1,w2,…,wk。权重的个数与神经元输入的个数相同。偏移项:可省略。激活函数:一般都会有,根据实际问题也是可以省略的。输出。 2.2 激活函数 激活函数有很多种,不同的激活函数适用于不同的问题。二分类问题我们一般采用 Sigmoid 函数,

效率达CPU一万倍、内含800万神经元:英特尔发布神经形态芯片超算

效率达CPU一万倍、内含800万神经元:英特尔发布神经形态芯片超算 人类大脑由 860 亿个互相连接的神经元组成,英特尔最近推出的类脑芯片系统 Pohoiki Beach 向「模拟大脑」这一目标前进了一大步,这是一个拥有 800 万人工神经元的计算机系统。据英特尔介绍,其组成芯片在 AI 任务中的速度是传统 CPU 的一千倍,能耗效率是一万倍。 英特尔还表示,类脑芯片越扩展效率越高,这是传