池化层专题

Convolutional layers/Pooling layers/Dense Layer 卷积层/池化层/稠密层

Convolutional layers/Pooling layers/Dense Layer 卷积层/池化层/稠密层 Convolutional layers 卷积层 Convolutional layers, which apply a specified number of convolution filters to the image. For each subregion, the

【小白深度学习入门】【2】池化层详解:工作原理、维度计算、池化类型

《博主简介》 小伙伴们好,我是阿旭。专注于人工智能、AIGC、python、计算机视觉相关分享研究。 👍感谢小伙伴们点赞、关注! 《------往期经典推荐------》 一、AI应用软件开发实战专栏【链接】 项目名称项目名称1.【人脸识别与管理系统开发】2.【车牌识别与自动收费管理系统开发】3.【手势识别系统开发】4.【人脸面部活体检测系统开发】5.【图片风格快速迁移软件开发】6

深度学习入门:卷积神经网络 | CNN概述,图像基础知识,卷积层,池化层(超详解!!!)

目录 🍔 前言 🍔 图像基础知识 1. 像素和通道的理解 2. 小节 🍔 卷积层 1. 卷积计算 2. Padding 3. Stride 4. 多通道卷积计算 5. 多卷积核卷积计算 6. 特征图大小 7. PyTorch 卷积层 API 7. 小节 🍔 池化层 1. 池化层计算编辑 2. Stride 3. Padding 4. 多通道池化计算

神经网络学习-池化层

池化层方法 池化一般是用来对卷积层进行降维 空洞卷积,通过在卷积核的元素之间插入“空洞”(即零),可以在不增加参数量和计算量的情况下扩大卷积核的感受野。这对于捕捉图像中的多尺度信息特别有用。 池化的默认步长是池化核的大小 channels 表示数据的通道数。对于不同类型的数据,通道的含义可能会有所不同。在图像处理中,通常表示颜色通道,比如 RGB 图像有三个通道(红、绿、蓝),灰度图像只有

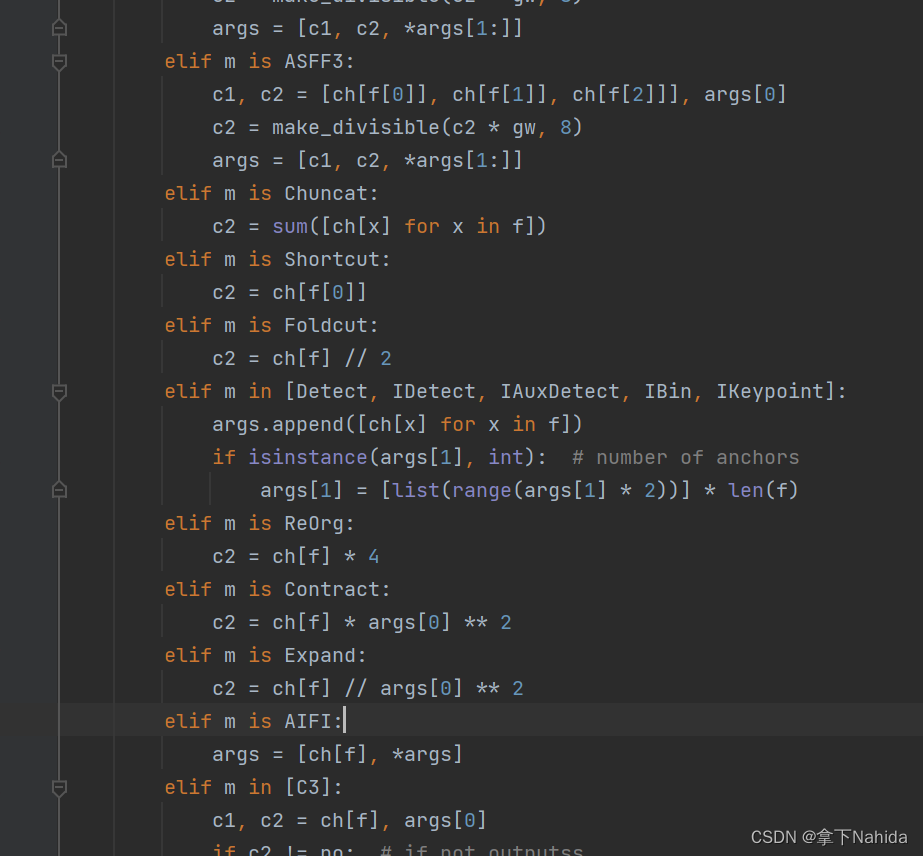

【YOLOv5/v7改进系列】改进池化层为RT-DETR的AIFI

一、导言 Real-Time DEtection TRansformer(RT-DETR),是一种实时端到端目标检测器,克服了Non-Maximum Suppression(NMS)对速度和准确性的影响。通过设计高效的混合编码器和不确定性最小化查询选择,RT-DETR在保持准确性的同时提高了速度,实现了实时检测的要求。实验结果表明,RT-DETR在COCO数据集上达到了53.1%的平均精度(

keras池化层调参笔记

今天在调参的过程中,在调maxpooling时,发现了一个小技巧,假如对于一个维度为(None,20,500)的query_conv进行池化操作。 如果代码为 pool_query = MaxPooling1D(pool_size=20)(query_conv) 那么最终pool_query的最终维度为(None,1,500) 但是如果代码为 pool_query=MaxPooling

卷积神经网络基础卷积层和池化层学习#####好好好

卷积神经网络(CNN)由输入层、卷积层、激活函数、池化层、全连接层组成,即INPUT-CONV-RELU-POOL-FC (1)卷积层:用它来进行特征提取,如下: 输入图像是32*32*3,3是它的深度(即R、G、B),卷积层是一个5*5*3的filter(感受野),这里注意:感受野的深度必须和输入图像的深度相同。通过一个filter与输入图像的卷积可以得到一个28*28*1的特征图,上图

卷积层、池化层和全连接层的作用分别是什么

卷积层(Convolutional Layer)、池化层(Pooling Layer)和全连接层(Fully Connected Layer)是神经网络中常见的三种层类型,它们各自在神经网络中扮演着不同的作用: 卷积层: 特征提取:卷积层通过卷积操作学习提取输入数据的特征,这些特征可以是边缘、纹理或更高级的特征,有助于捕获数据的局部结构信息。参数共享:卷积层中的卷积核在整个输入数据上共享参数,

CNN中难点分析--对卷积层(Convolution)与池化层(Pooling)的理解

传统机器学习通过特征工程提取特征,作为Input参数进行输入,从而拟合一个相对合适的w参数,而CNN利用卷积层感知局部特征,然后更高层次对局部进行综合操作,从而得到全局信息,池化层层提取主要特征,从而自动提取特征。 1、池化层的理解 pooling池化的作用则体现在降采样:保留显著特征、降低特征维度,增大kernel的感受野。另外一点值得注意:pooling也可以提供一些旋转不变性。 池化

卷积神经网络-池化层

卷积神经网络-池化层 池化层(Pooling Layer)是深度学习神经网络中的一个重要组成部分,通常用于减少特征图的空间尺寸,从而降低模型复杂度和计算量,同时还能增强模型的不变性和鲁棒性。 池化操作通常在卷积神经网络(CNN)的卷积层之后使用,其主要目的有两个: 降维: 通过减少特征图的空间尺寸,可以减少模型的参数数量和计算量,从而加速模型的训练和推理过程。 特征不变性:

caffe基础-03池化层的配置

caffe基础-03池化层的配置 layer {name: "pool1"type: "Pooling"bottom: "conv1"top: "pool1"pooling_param {pool: MAX #池化方法,默认为MAX。目前可用的方法有MAX, AVEkernel_size: 3 #池化的核大小stride: 2 #池化的步长,默认为1。一般我们设置为2,即不重叠。}}

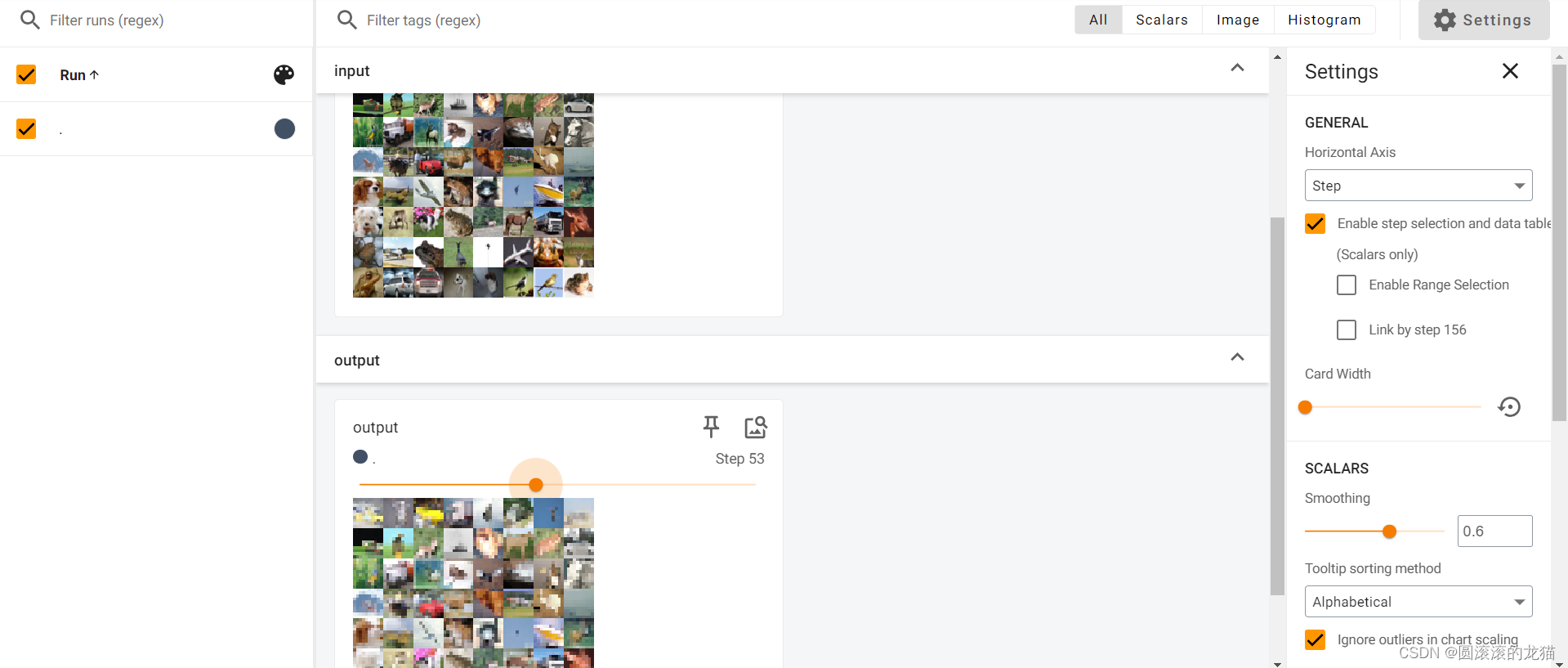

Pytorch学习 day08(最大池化层、非线性激活层、正则化层、循环层、Transformer层、线性层、Dropout层)

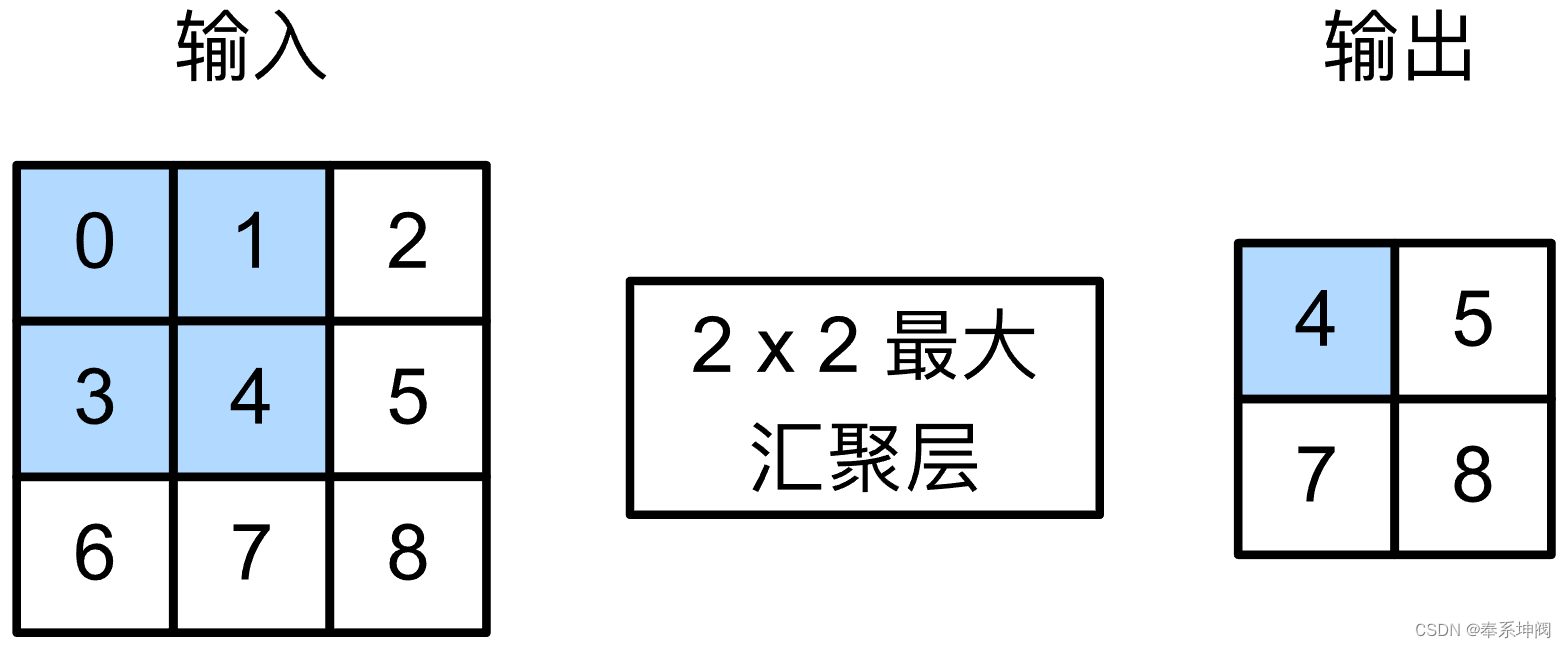

最大池化层 最大池化,也叫上采样,是池化核在输入图像上不断移动,并取对应区域中的最大值,目的是:在保留输入特征的同时,减小输入数据量,加快训练。参数设置如下: kernel_size:池化核的高宽(整数或元组),整数时表示高宽都为该整数,元组时表示分别在水平和垂直方向上的长度。stride:池化核每次移动的步长(整数或元组),整数时表示在水平和垂直方向上使用相同的步长。元组时分别表示在水平和垂直

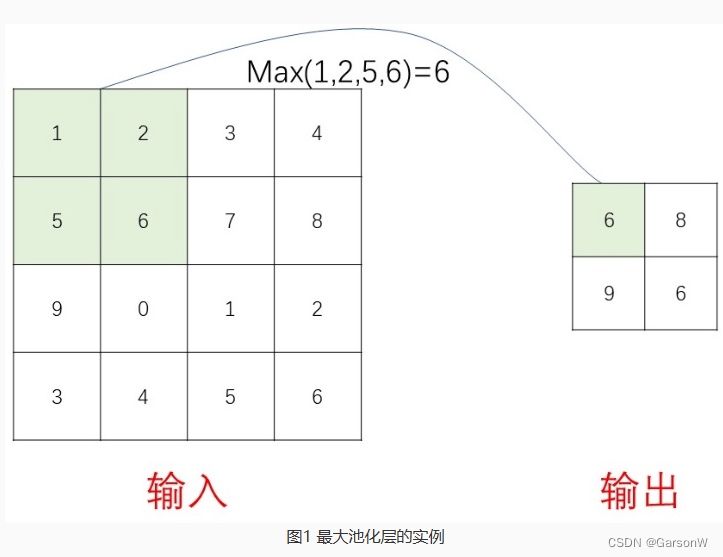

CNN | 05池化层

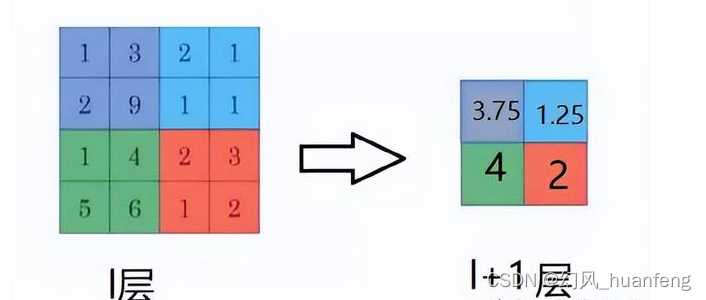

5 池化层 5.1 常用池化方法 池化 pooling,又称为下采样,downstream sampling or sub-sampling。 池化方法分为两种,一种是最大值池化 Max Pooling,一种是平均值池化 Mean/Average Pooling。如图17-32所示。 图17-32 池化 最大值池化,是取当前池化视野中所有元素的最大值,输出到下一层特征图中。平均值池化

Keras--池化层

MaxPooling1D # keras.layers.MaxPooling1D(pool_size=2, strides=None, padding='valid') #缩小比例的因数# strides如果是 None,那么默认值是 pool_size。 MaxPooling2D 对于空域数据的最大池化。 keras.layers.MaxPooling2D(pool_size=(2,

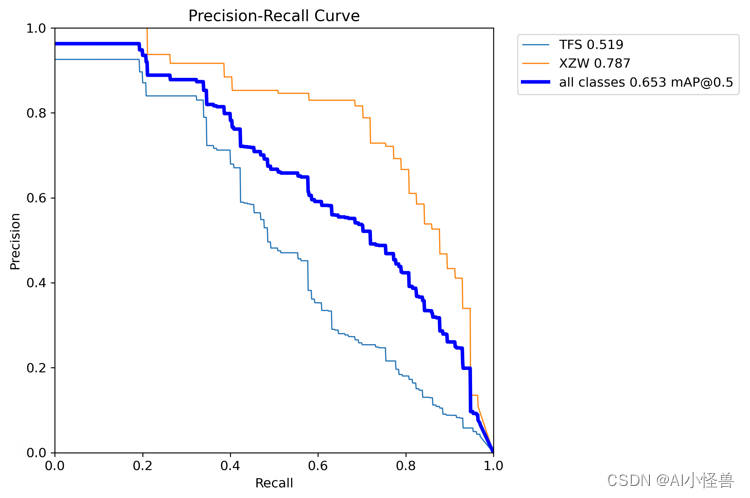

基于YOLOv8的工业油污缺陷检测,多种优化方法---SPPF创新结构,重新设计全局平均池化层和全局最大池化层(三)

💡💡💡本文主要内容:详细介绍了工业油污缺陷检测整个过程,从数据集到训练模型到结果可视化分析,以及如何优化提升检测性能。 💡💡💡加入SPPF_improve mAP@0.5由原始的0.648提升至0.699 1.工业油污数据集介绍 三星油污缺陷类别:头发丝和小黑点,["TFS","XZW"] 数据集大小:660张 数据集地址:https://download.csdn

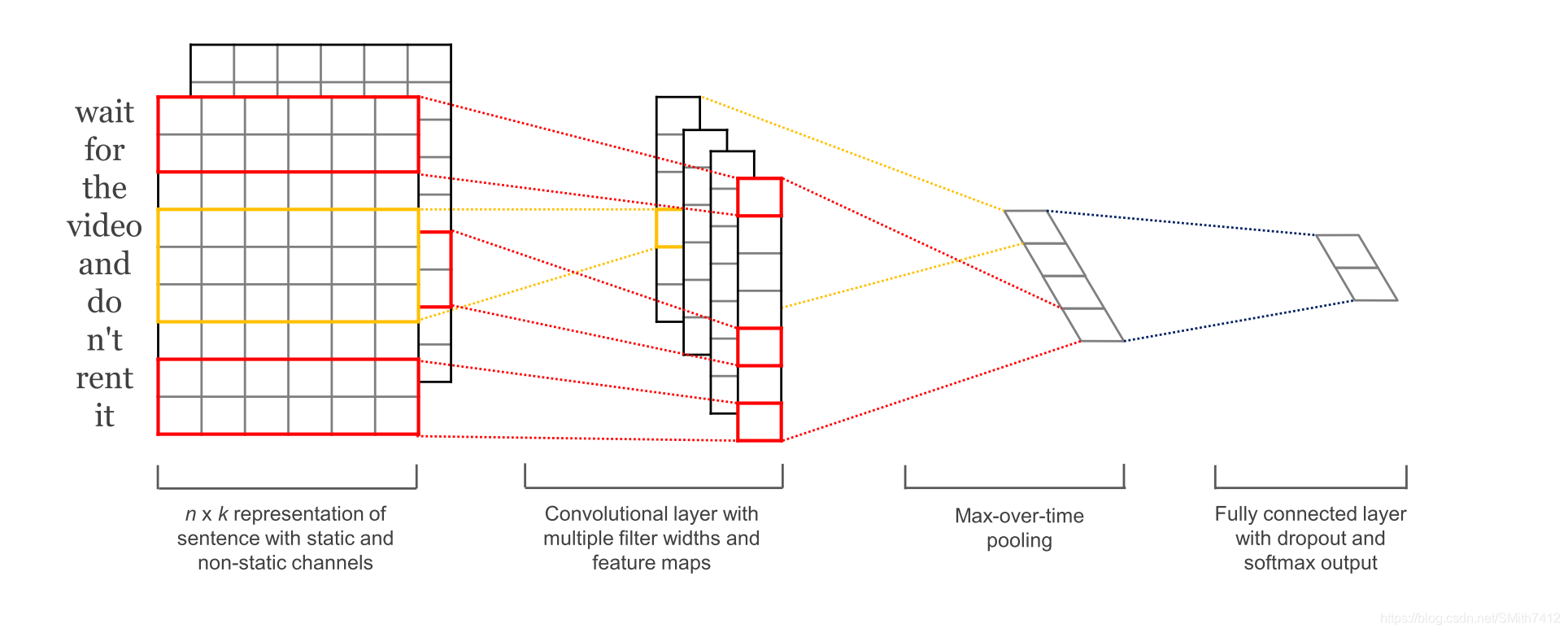

对卷积神经网络、池化层、反卷积以及Text-CNN原理的理解

今天,我们来讨论一下卷积,以及卷积神经网络,这里边具体怎么运算的,请看下面分析: 首先选取知乎上对卷积物理意义解答排名最靠前的回答。 然后再来看分析卷积神经网络 1、卷积 来自知乎的优秀回答! 不推荐用“反转/翻转/反褶/对称”等解释卷积。好好的信号为什么要翻转?导致学生难以理解卷积的物理意义。 这个其实非常简单的概念,国内的大多数教材却没有讲透。 卷积是分析数学中一种重要的运算。设: f

PyTorch 各种池化层函数全览与用法演示

目录 torch.nn.functional子模块Pooling层详解 avg_pool1d 用法与用途 参数 注意事项 示例代码 avg_pool2d 用法与用途 参数 注意事项 示例代码 avg_pool3d 用法与用途 参数 注意事项 示例代码 max_pool1d 用法与用途 参数 注意事项 示例代码 max_pool2d 用法与用途 参数

全局平均池化层(GLP)

一、全局平均池化 全局平均池化层(GAP)在2013年的《Network In Network》(NIN)中首次提出,于是便风靡各种卷积神经网络。为什么它这么受欢迎呢? 一般情况下,卷积层用于提取二维数据如图片、视频等的特征,针对于具体任务(分类、回归、图像分割)等,卷积层后续会用到不同类型的网络,拿分类问题举例,最简单的方式就是将卷积网络提取出的特征(feature map)输入到sof

池化层解析:简单易懂理解 PyTorch 中的核心组件

目录 torch.nn详解 nn.MaxPool1d nn.MaxPool2d nn.MaxPool3d nn.MaxUnpool1d nn.MaxUnpool2d nn.MaxUnpool3d nn.AvgPool1d nn.AvgPool2d nn.AvgPool3d nn.FractionalMaxPool2d nn.FractionalMaxPool3d nn.L

池化层的downsampling翻译成下采样。降采样咋样?

都说是下采样,翻译成降采样不香吗? 上采样(up-sampling),叫过采样不好么? 不就是采样的数据量和采样率的差距么。

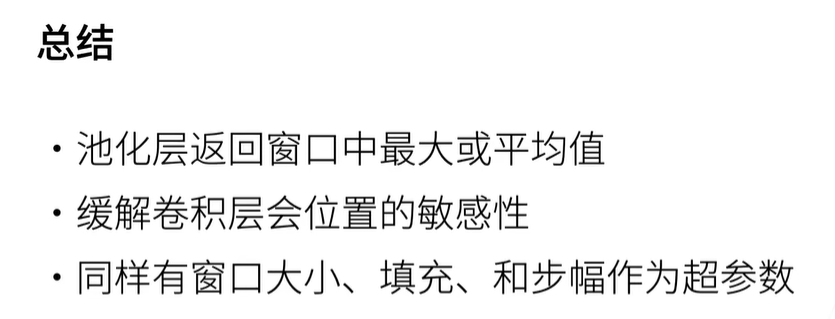

池化层(pooling)

目录 一、池化层 1、最大池化层 2、平均池化层 3、总结 二、代码实现 1、最大池化与平均池化 2、填充和步幅(padding和strides) 3、多个通道 4、总结 一、池化层 1、最大池化层 2、平均池化层 3、总结 池化层返回窗口中最大或平均值环节卷积层对位置的敏感性同样有窗口大小、填充和步幅作为超参数 二、代码实现

池化层(pooling)

目录 一、池化层 1、最大池化层 2、平均池化层 3、总结 二、代码实现 1、最大池化与平均池化 2、填充和步幅(padding和strides) 3、多个通道 4、总结 一、池化层 1、最大池化层 2、平均池化层 3、总结 池化层返回窗口中最大或平均值环节卷积层对位置的敏感性同样有窗口大小、填充和步幅作为超参数 二、代码实现

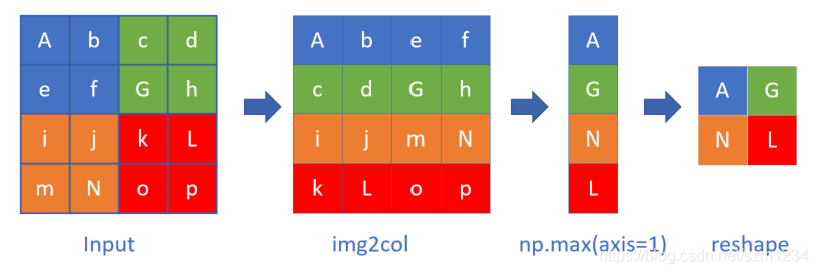

CS231n作业笔记2.6:卷积层以及池化层的实现

CS231n简介 详见 CS231n课程笔记1:Introduction。 本文都是作者自己的思考,正确性未经过验证,欢迎指教。 作业笔记 就是简单实现一下卷积层以及池化层,唯一的难点在于确定索引值,稍微注意一下就好。 1. 卷积层 1.1. 前向传播 使用np.pad做填充。 N, C, H, W = x.shapeF, C, HH, WW = w.shapestride =

关于卷积神经网络的池化层(pooling)

了解池化层 池化层又称“下采样层”或“子采样层”,池化层可以大大降低特征的维度,减少计算量,同时可以避免过拟合问题。 顾名思义,最大池化层就是从输入的矩阵中某一范围内,选择最大的元素进行保留;平均池化层就是将输入的矩阵中某一范围内的数求平均值,再进行保留;最小池化层是从输入的矩阵中某一范围内,选择最小的元素进行保留。 这里需要注意的一点是,池化层对每个输入

每天五分钟计算机视觉:池化层的反向传播

本文重点 卷积神经网络(Convolutional Neural Network,CNN)作为一种强大的深度学习模型,在计算机视觉任务中取得了巨大成功。其中,池化层(Pooling Layer)在卷积层之后起到了信息压缩和特征提取的作用。然而,池化层的反向传播一直以来都是一个相对复杂和深奥的问题。本文将详细解释卷积网络池化层反向传播的实现原理,并探讨其在信息压缩方面的奥秘。 池化层的反向传播

深度学习池化层的作用

目录 一、概述 二、池化分类 1、Max Pooling:最大池化 2、Average Pooling:平均池化 三、池化作用 1.、invariance(不变性), 2、降维度 3、增大感受野 4、获得定长输出。 5、防止过拟合或有可能会带来欠拟合。 6、减小计算量和内存消耗 7、非线性和鲁棒性 8、聚合特征 9、下采样(downsamping) 一、概述