前向专题

用einsum实现MultiHeadAttention前向传播

einsum教程网站Einstein Summation in Numpy | Olexa Bilaniuk's IFT6266H16 Course Blog 编写训练模型 import tensorflow as tfclass Model(tf.keras.Model):def __init__(self, num_heads, model_dim):super().__init__

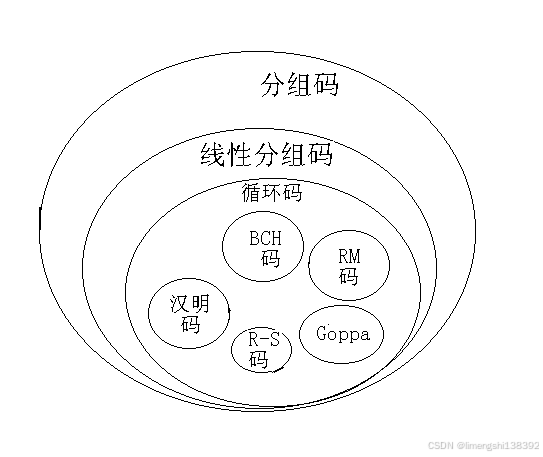

通信工程学习:什么是FEC前向纠错

FEC:前向纠错 FEC(Forward Error Correction,前向纠错)是一种增加数据通信可信度的技术,广泛应用于计算机网络、无线通信、卫星通信等多种数据传输场景中。其基本原理和特点可以归纳如下: 一、FEC前向纠错的基本原理 FEC技术通过在发送端对原始数据添加冗余信息(即纠错码),使得接收端在接收到数据后,即使部分数据在传输过程中发生错误

前向保密(Forward Secrecy,也称为完美前向保密,Perfect Forward Secrecy,PFS)

前向保密(Forward Secrecy,也称为完美前向保密,Perfect Forward Secrecy,PFS)是一种加密通信协议的属性,它确保即使在未来某个时间点上长期使用的私钥(如服务器的私钥)被泄露,攻击者也无法解密之前已经捕获并记录的加密通信内容。这意味着每次通信会话都使用一个独立的、临时的会话密钥进行加密,即使主私钥被泄露,之前的通信记录也仍然保持安全。 工作原理 前向保密通常

GNN-2008:Original GNN【消息传递(前向传播):聚合函数+更新函数+输出函数】【核心:不动点理论】【梯度优化:用Almeida-Pineda算法,而不是用BPTT(反向传播)算法】

GNN-2008:Original GNN【消息传递(前向传播):聚合函数+更新函数+输出函数】【核心:不动点理论】【梯度优化:用Almeida-Pineda算法,而不是用BPTT(反向传播)算法】 《原始论文:A new model for learning in graph domains-2005》 《原始论文:The Graph Neural Network Model-2008》 一

BP神经网络学习内容分享:前向传播与后向传播

在深度学习和神经网络领域,BP(Backpropagation,反向传播)神经网络是一种非常基础且广泛应用的网络结构。它通过前向传播进行预测,并通过反向传播算法调整网络权重以优化预测结果。本文将详细介绍BP神经网络的前向传播和反向传播过程,并展示一个简单的BP神经网络实现。 一、前向传播过程 1.基本概念 前向传播是神经网络中信息从输入层经过隐藏

前向纠错码的地板效应

前向纠错码(FEC,Forward Error Correction)的地板效应,主要指的是在某些情况下,即使信噪比(SNR)显著提高,比特错误率(BER)或帧错误率(FER)的下降速度却变得非常缓慢,甚至趋于一个非零的常数水平,这个现象就被形象地称为“地板效应”。以下是关于前向纠错码地板效应的几个关键点: 1. 地板效应的定义与表现 定义:地板效应是指在高信噪比区域,FEC的纠错性能不再随信

PSMNet:Pyramid Stereo Matching Network学习测试笔记04-特征提取部分前向传播

写在前面的话: 2019年9月21日18:56:48好久没回来更新博客了。因为在实习中,实习的新问题一大堆,并且实习的工作内容整理了也是发在公司内网wiki,外面是不可能发的(专业,有节操)。周末再做做毕业论文相关的工作。 写在前面的话2: 2019年09月28日18:02:55补充说明:CSDN博客发布版权更新,如果您看了博客并且用到PSMNet相关东西,请注明引用原作者的文章: @inpr

caffe - - 在windows上实施 前向

caffe-window搭建自己的小项目例子 手头有一个实际的视觉检测的项目,用的是caffe来分类,于是需要用caffe新建自己的项目的例子。在网上找了好久都没有找到合适的,于是自己开始弄。 1 首先是配置caffe的VC++目录中的include和库文件。配置include lib dll都是坑,而且还分debug和release两个版本。添加输入项目需要

02 TensorFlow 2.0:前向传播之张量实战

你是前世未止的心跳 你是来生胸前的记号 未见分晓 怎么把你忘掉 《千年》 内容覆盖: convert to tensorreshape

feedforwardnet,前向神经网络

前向神经网络,feedforward neural network。 语法是 feedforwardnet(hiddenSizes,trainFcn) hiddenSizes Row vector of one or more hidden layer sizes (default=10) trainFcn Training function(defa

【darknet】源码阅读理解(三)——CNN前向传播

这里以Code,原理相结合的方式 1. darknet中CNN关键代码 1. int m = l.n/l.groups; // 输出通道int k = l.size*l.size*l.c/l.groups; // img2col后图像矩阵的行数int n = l.out_w*l.out_h;

从零开始理解AdaBoost算法:前向分布算法(四)【数学推导】

理解 AdaBoost 算法的原理 在理解 AdaBoost 算法原理的过程中,两个关键问题需要注意: 权重是如何由分类误差决定的。如何调整前一轮错误和正确的样本的权值。 优化问题 AdaBoost 解决的是二分类问题,数据集表示为: T = { ( x 1 , y 1 ) , ( x 2 , y 2 ) , … , ( x N , y N ) } T = \{(x_1, y_1), (

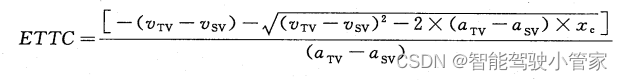

车辆前向碰撞预警系统性能要求和测试规程

前言 本文整理《GB/T 33577-2017 智能运输系统-车辆前向碰撞预警系统性能要求和测试规程》国标文件关键信息,FCW系统性能和测试右给深层次的认识。 术语和定义 车辆前向碰撞预警系统 forward vehicle collision warning system自车 subject vehicle(SV)目标车辆 target vehicle (TV)车头时距 time head

头文件相互包含 前向声明

目录 ClassA.h ClassA.cpp ClassB.h ClassB.cpp error: C2143: 语法错误: 缺少“;”(在“*”的前面) 当两个类需要相互访问对方的成员或方法时,通常意味着它们之间存在某种依赖关系。这种依赖关系可能源于类的设计或功能需求。以下是一个简单的例子,展示了当两个类需要相互访问对方成员或方法时,如何使用包含对方头文件的方式来解决循环包

【TensorFlow深度学习】前向传播实战:从理论到代码实现

前向传播实战:从理论到代码实现 1. 前向传播理论基础1.1 激活函数1.2 损失函数 2. 构建神经网络2.1 导入TensorFlow2.2 定义网络参数2.3 初始化权重和偏置2.4 实现前向传播 3. 损失函数和梯度计算3.1 定义损失函数3.2 计算梯度 4. 参数更新和训练过程4.1 选择优化器4.2 更新参数4.3 训练循环 5. 结果评估5.1 模型预测5.2 计算准确率 6

Pytorch实用教程:pytorch使用模型时并没有调用forward函数,那么前向运算是如何执行的呢?

在 PyTorch 中,尽管我们定义了 forward 方法来指定模型的前向传播逻辑,实际上我们通常不直接调用这个方法。相反,我们通过调用模型对象本身来触发前向传播,这背后的机制涉及到了 Python 的 __call__ 方法。 __call__ 方法的作用 在 PyTorch 的 nn.Module 类中,有一个 __call__ 方法被定义。当你对一个继承自 nn.Module 的实例(

前向一体化、后向一体化、纵向一体化的含义

一.前向一体化 前向一体化就是企业通过收购或兼并若干商业企业,或者拥有和控制其分销系统,实行产销一体化。 前向一体化是指获得分销商或零售商的所有权或加强对它们的控制,也就是指企业根据市场的需要和生产技术的可能条件,利用自己的优势,把成品进行深加工的战略。在生产过程中,物流从顺方向移动,称为前向一体化,采用这种战略,是为获得原有成品深加工的高附加价值。一般是把相关的前向企业合并起来

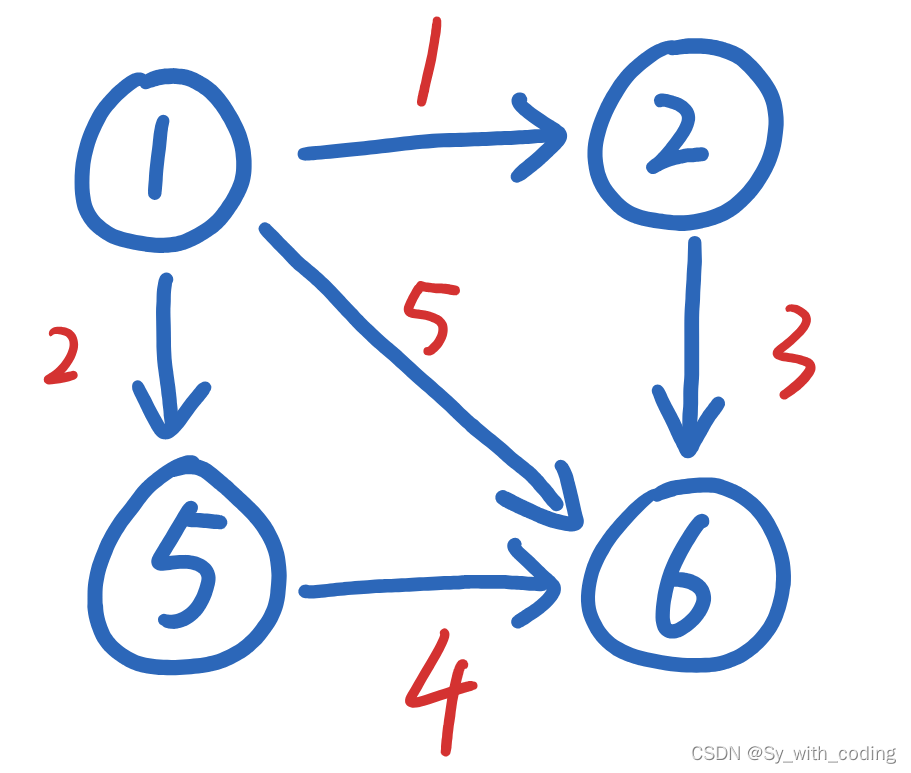

【图论】详解链式前向星存图法+遍历法

细说链式前向星存图法 首先要明白,链式前向星的原理是利用存边来进行模拟图。 推荐左神的视频–建图、链式前向星、拓扑排序 比方说有这样一张图,我们用链式前向星来进行模拟时,可以将每一条边都进行编号,其中,红色的数字就是对每一条边的编号,蓝色的数字表示每一个结点编号。 准备三个数组head[], next[], to[] 数组名称下标含义值的含义head结点值结点指向的边next边

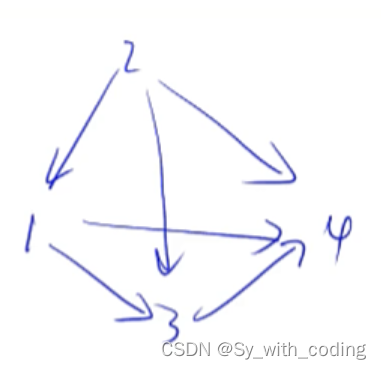

【图论】图的存储--链式前向星存图法以及深度优先遍历图

图的存储 介绍 无向图-就是一种特殊的有向图-> 只用考虑有向图的存储即可 有向图 邻接矩阵邻接表 邻接表 存储结构: (为每一个点开了一个单链表,存储这个点可以到达哪个点) 1:3->4->null2:1->4->null3:4->null4:null 插入一条新的边 比如要插一条边:2->3 先找到 2 对应的单链表然后将 3 插入到单链表里面去(一般

深度学习神经网络 卷积神经网络 第一节,构建前向传播函数(一)

因为敲卷积神经网络的代码确实浪费了不少时间,这里我详细地把代码进行解释。 只导入一个模块: import tensorflow as tf 提前先把变量定义好:这个卷积层是先输入28*28维的图像,图像的通道数是1。第一个卷积核的大小是5,卷积核数量是32.第二个卷积核的大小是5,数量是64。第三层是全连接层的。 # 设定神经网络的超参数# 定义神经网络可以接收的图片的尺寸和通道数IM

深度学习神经网络 MNIST手写数据辨识 1 前向传播和反向传播

首先是前向传播的程序。为了更清晰我们分段讲解。 第一部分导入模块,并设置输入节点为28*28,输出节点为10(0到9共10个数字),第一层的节点为500(随便设的) import tensorflow as tfINPUT_NODE = 784OUTPUT_NODE = 10LAYER1_NODE = 500 然后是生成单个层次网络的结构,判断损失函数是否加入正则 #定义神经网络的输

controlnet前向代码解析

ControlNet|使用教程 各模型算法说明以及使用解析 - openAI本本介绍了如何在Stable Diffusion中使用ControlNet生成高质量图片的方法,包括骨骼提取、边缘线处理、引导设置、语义分割、涂鸦等功能的详细介绍,帮助用户快速上手使用ControlNet。https://openai.wiki/controlnet-guide.htmlcldm:controlnet版本的

隐马尔可夫模型(HMM) |前向算法 |一个简单的例子说清计算过程 |一般步骤总结

如是我闻: 本文通过一个简单的例子来详细说明隐马尔可夫模型(HMM)的前向算法 我们求解的问题类型是:给定模型及观测序列计算其出现的概率。 隐马尔可夫模型由三个主要部分组成: 隐藏状态集合观测状态集合以及三个概率矩阵(状态转移概率矩阵、观测概率矩阵、和初始状态概率向量) 1. 示例说明 假设有一个简化的天气模型,其中隐藏状态是“晴朗”(Sunny)和“雨天”(Rainy),观测状态是“干

全连接神经网络算法原理(激活函数、前向传播、梯度下降法、损失函数、反向传播)

文章目录 前言1、全连接神经网络的整体结构:全连接神经网络模型是由输入层、隐藏层、输出层所组成,全连接神经网络结构如下图所示:全连接神经网络的每一层都是由一个一个的神经元所组成的,因此只要搞清楚神经元的本质就可以搞清楚全连接神经网络了。如图下所示,这是一个全连接神经网络神经元的模型图: 2、激活函数2.1、Sigmoid函数2.2、Tanh函数2.3、ReLU函数2.4、Leaky ReLU